DeepMind hat es wieder getan.

Nach der Lösung einer grundlegenden Herausforderung in der Biologie—Proteinstruktur vorhersagen-und Entwirrung der Mathematik der Knotentheorie, zielt es auf einen grundlegenden Rechenprozess ab, der in Tausende von alltäglichen Anwendungen eingebettet ist. Vom Parsen von Bildern bis zu Wetter modellieren oder sogar das Innenleben künstlicher neuronaler Netze untersuchen, könnte die KI theoretisch Berechnungen in einer Reihe von Bereichen beschleunigen, die Effizienz steigern und gleichzeitig den Energieverbrauch und die Kosten senken.

Aber beeindruckender ist wie Sie haben es geschafft. Der rekordbrechende Algorithmus namens AlphaTensor ist ein Spin-off von AlphaZero, das bekanntermaßen menschliche Spieler im Schach und Go besiegte.

„Algorithmen werden seit Tausenden von Jahren in allen Zivilisationen der Welt verwendet, um grundlegende Operationen durchzuführen.“ schrieb Co-Autoren Dr. Matej Balog und Alhussein Fawzi bei DeepMind. „Allerdings ist die Entdeckung von Algorithmen eine große Herausforderung.“

AlphaTensor bahnt sich den Weg in eine neue Welt, in der KI Programme entwirft, die alles übertreffen, was Menschen entwickeln, und gleichzeitig sein eigenes maschinelles „Gehirn“ verbessert.

„Diese Arbeit betritt Neuland, indem sie KI für ein Optimierungsproblem verwendet, an dem Menschen seit Jahrzehnten arbeiten. Die gefundenen Lösungen können sofort entwickelt werden, um die Rechenlaufzeiten zu verbessern“, sagte Dr. Federico Levi, leitender Redakteur bei Natur, Die veröffentlicht die Studium.

Geben Sie die Matrixmultiplikation ein

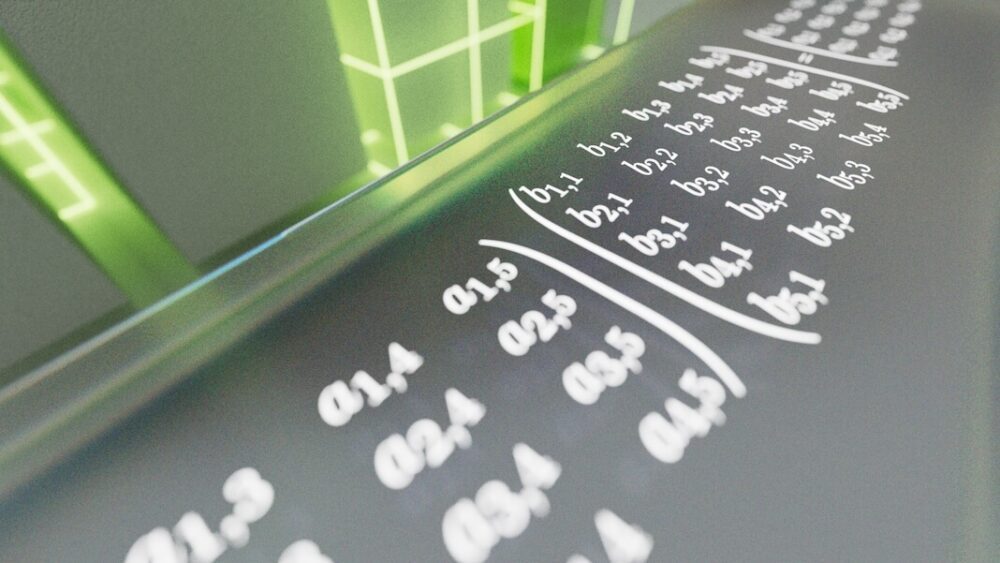

Das Problem, mit dem AlphaTensor konfrontiert ist, ist die Matrixmultiplikation. Wenn Sie sich plötzlich Reihen und Spalten mit grünen Zahlen vorstellen, die über Ihren Bildschirm rollen, sind Sie nicht allein. Grob gesagt ist eine Matrix so etwas – ein Zahlenraster, das Daten Ihrer Wahl digital darstellt. Dies können Pixel in einem Bild, die Frequenzen eines Soundclips oder das Aussehen und die Aktionen von Charakteren in Videospielen sein.

Die Matrixmultiplikation nimmt zwei Zahlengitter und multipliziert sie miteinander. Es ist eine Berechnung, die oft in der High School gelehrt wird, aber auch für Computersysteme von entscheidender Bedeutung ist. Hier werden Zahlenreihen in einer Matrix mit Spalten in einer anderen multipliziert. Die Ergebnisse erzeugen ein Ergebnis, z. B. einen Befehl zum Vergrößern oder Neigen der Ansicht einer Videospielszene. Obwohl diese Berechnungen unter der Haube ablaufen, ist jeder, der ein Telefon oder einen Computer verwendet, jeden Tag auf seine Ergebnisse angewiesen.

Sie können sehen, wie das Problem extrem schwierig werden kann, extrem schnell. Das Multiplizieren großer Matrizen ist unglaublich energie- und zeitintensiv. Jedes Zahlenpaar muss einzeln multipliziert werden, um eine neue Matrix zu konstruieren. Wenn die Matrizen wachsen, wird das Problem schnell unlösbar – noch mehr als die Vorhersage der besten Schach- oder Go-Züge. Einige Experten schätzen, dass es sie gibt mehr Wege Matrixmultiplikation zu lösen als die Anzahl der Atome im Universum.

Bereits 1969 zeigte Volker Strassen, ein deutscher Mathematiker, dass es Möglichkeiten gibt, Abstriche zu machen, indem er eine Runde der XNUMX-mal-XNUMX-Matrixmultiplikation von kürzte insgesamt acht bis sieben. Es mag nicht beeindruckend klingen, aber Strassens Methode zeigte, dass es möglich ist, lang gehegte Operationsstandards – also Algorithmen – für die Matrixmultiplikation zu übertreffen. Sein Ansatz, der Strassen-Algorithmus, gilt seit über 50 Jahren als der effizienteste Ansatz.

Was aber, wenn es noch effizientere Methoden gibt? „Niemand kennt den besten Algorithmus, um ihn zu lösen“, sagt Dr. François Le Gall von der Nagoya University in Japan, der nicht an der Arbeit beteiligt war, sagte MIT Technology Review. „Das ist eines der größten offenen Probleme der Informatik.“

KI-Jagd-Algorithmen

Wenn die menschliche Intuition ins Stocken gerät, warum nicht einen mechanischen Verstand anzapfen?

In der neuen Studie verwandelte das DeepMind-Team die Matrixmultiplikation in ein Spiel. Ähnlich wie sein Vorgänger AlphaZero verwendet AlphaTensor Deep Reinforcement Learning, eine maschinelle Lernmethode, die von der Art und Weise inspiriert ist, wie biologische Gehirne lernen. Hier interagiert ein KI-Agent (häufig ein künstliches neuronales Netz) mit seiner Umgebung, um ein mehrstufiges Problem zu lösen. Wenn es erfolgreich ist, erhält es eine „Belohnung“ – das heißt, die Netzwerkparameter der KI werden aktualisiert, sodass es in Zukunft wahrscheinlicher ist, dass es wieder erfolgreich ist.

Es ist, als würde man lernen, einen Pfannkuchen zu wenden. Anfangs fallen viele auf den Boden, aber schließlich lernen Ihre neuronalen Netzwerke die Arm- und Handbewegungen für einen perfekten Salto.

Das Trainingsgelände für AlphaTensor ist eine Art 3D-Brettspiel. Es ist im Wesentlichen ein Ein-Spieler-Puzzle, das ungefähr Sudoku ähnelt. Die KI muss Zahlenraster in möglichst wenigen Schritten multiplizieren und dabei aus einer Vielzahl zulässiger Züge auswählen – über eine Billion davon.

Diese zulässigen Bewegungen wurden sorgfältig in AlphaTensor entworfen. Bei einer Pressekonferenz erklärte Co-Autor Dr. Hussain Fawzi: „Die Formulierung des Raums der algorithmischen Entdeckung ist sehr kompliziert … noch schwieriger ist die Frage, wie wir uns in diesem Raum bewegen können.“

Mit anderen Worten, wie können wir angesichts einer verblüffenden Auswahl an Optionen diese eingrenzen, um unsere Chancen zu verbessern, die Nadel im Heuhaufen zu finden? Und wie können wir am besten strategisch vorgehen, um zur Nadel zu gelangen, ohne den ganzen Heuhaufen zu durchwühlen?

Ein Trick, den das Team in AlphaTensor eingebaut hat, ist eine Methode namens Baumsuche. Anstatt bildlich gesprochen den Heuhaufen wahllos zu durchwühlen, lotet die KI hier „Wege“ aus, die zu einem besseren Ergebnis führen könnten. Die zwischenzeitlichen Erkenntnisse helfen der KI dann, ihren nächsten Schritt zu planen, um die Erfolgschancen zu erhöhen. Das Team zeigte auch die Algorithmusbeispiele erfolgreicher Spiele, wie zum Beispiel einem Kind die Eröffnungszüge des Schachs beizubringen. Als die KI schließlich wertvolle Züge entdeckte, erlaubte das Team ihr, diese Operationen für ein maßgeschneidertes Lernen auf der Suche nach einem besseren Ergebnis neu zu ordnen.

Neue Wege gehen

AlphaTensor spielte gut. In einer Reihe von Tests forderte das Team die KI heraus, die effektivsten Lösungen für Matrizen bis zu fünf mal fünf zu finden – also mit jeweils fünf Zahlen in einer Reihe oder Spalte.

Der Algorithmus entdeckte den ursprünglichen Hack von Strassen schnell wieder, übertraf dann aber alle zuvor vom menschlichen Verstand erdachten Lösungen. AlphaTensor testete die KI mit verschiedenen Matrizengrößen und fand effizientere Lösungen für über 70. „Tatsächlich entdeckt AlphaTensor normalerweise Tausende von Algorithmen für jede Matrizengröße“, sagte das Team. „Es ist umwerfend.“

In einem Fall reduzierte die KI bei der Multiplikation einer Fünf-mal-fünf-Matrix mit einer Vier-mal-fünf-Matrix den bisherigen Rekord von 80 einzelnen Multiplikationen auf nur 76. Sie glänzte auch bei größeren Matrizen und reduzierte die Anzahl der für zwei erforderlichen Berechnungen elf-mal-elf-Matrizen von 919 bis 896.

Mit dem Proof-of-Concept in der Hand wandte sich das Team der praktischen Anwendung zu. Computerchips sind oft darauf ausgelegt, verschiedene Berechnungen zu optimieren – zum Beispiel GPUs für Grafiken oder KI-Chips für maschinelles Lernen– und die Abstimmung eines Algorithmus mit der am besten geeigneten Hardware erhöht die Effizienz.

Hier verwendete das Team AlphaTensor, um Algorithmen für zwei beliebte Chips im maschinellen Lernen zu finden: die NVIDIA V100-GPU und Google TPU. Insgesamt steigerten die von KI entwickelten Algorithmen die Rechengeschwindigkeit um bis zu 20 Prozent.

Ob die KI auch Smartphones, Laptops oder andere Alltagsgeräte beschleunigen kann, ist schwer zu sagen. „Diese Entwicklung wäre jedoch sehr spannend, wenn sie in der Praxis genutzt werden könnte“, sagte Dr. Virginia Williams vom MIT. „Eine Leistungssteigerung würde viele Anwendungen verbessern.“

Der Verstand einer KI

Obwohl AlphaTensor den neuesten menschlichen Rekord für die Matrixmultiplikation schlägt, kann das DeepMind-Team noch nicht erklären, warum.

„Durch das Spielen dieser Spiele hat es diese erstaunliche Intuition bekommen“, sagte DeepMind-Wissenschaftler und Co-Autor Dr. Pushmeet Kohli bei einer Pressekonferenz.

Sich entwickelnde Algorithmen müssen auch nicht Mensch gegen Maschine sein.

Während AlphaTensor ein Sprungbrett in Richtung schnellerer Algorithmen ist, könnte es noch schnellere geben. „Da es seine Suche auf Algorithmen einer bestimmten Form beschränken muss, könnte es andere Arten von Algorithmen übersehen, die möglicherweise effizienter sind“, schrieben Balog und Fawzi.

Vielleicht würde ein noch faszinierenderer Weg menschliche und maschinelle Intuition kombinieren. „Es wäre schön herauszufinden, ob diese neue Methode tatsächlich alle vorherigen zusammenfasst oder ob man sie kombinieren und etwas noch Besseres erhalten kann.“ sagte Williams. Andere Experten stimmen zu. Mit einer Fülle von Algorithmen, die ihnen zur Verfügung stehen, können Wissenschaftler damit beginnen, sie nach Hinweisen darauf zu sezieren, was die Lösungen von AlphaTensor zum Ticken gebracht hat, und den Weg für den nächsten Durchbruch ebnen.

Bildnachweis: DeepMind