Whisper ist ein ASR-Modell (Automatic Speech Recognition), das mithilfe von 680,000 Stunden überwachter Daten aus dem Internet trainiert wurde und eine Reihe von Sprachen und Aufgaben umfasst. Eine seiner Einschränkungen ist die geringe Leistung bei Sprachen mit geringen Ressourcen wie der Marathi-Sprache und den dravidischen Sprachen, die durch Feinabstimmung behoben werden können. Die Feinabstimmung eines Whisper-Modells ist jedoch sowohl im Hinblick auf die Rechenressourcen als auch auf den Speicherbedarf zu einer erheblichen Herausforderung geworden. Fünf bis zehn Durchläufe der vollständigen Feinabstimmung für Whisper-Modelle erfordern etwa 100 Stunden A100-GPU (40 GB SXM4) (variiert je nach Modellgröße und Modellparametern), und jeder feinabgestimmte Prüfpunkt erfordert etwa 7 GB Speicherplatz. Diese Kombination aus hohem Rechen- und Speicherbedarf kann insbesondere in Umgebungen mit begrenzten Ressourcen erhebliche Hürden darstellen und es oft außerordentlich schwierig machen, aussagekräftige Ergebnisse zu erzielen.

Low-Rank-Adaption, auch bekannt als LoRAverfolgt einen einzigartigen Ansatz zur Modellfeinabstimmung. Es hält die vorab trainierten Modellgewichte in einem statischen Zustand und führt trainierbare Rangzerlegungsmatrizen in jede Schicht der Transformer-Struktur ein. Diese Methode kann die Anzahl der trainierbaren Parameter, die für nachgelagerte Aufgaben benötigt werden, um das 10,000-fache verringern und den GPU-Speicherbedarf um das Dreifache reduzieren. In Bezug auf die Modellqualität hat sich gezeigt, dass LoRA die Leistung herkömmlicher Feinabstimmungsmethoden erreicht oder sogar übertrifft, obwohl mit weniger trainierbaren Parametern gearbeitet wird (siehe Ergebnisse des Originals). LoRA-Papier). Es bietet auch den Vorteil eines erhöhten Trainingsdurchsatzes. im Gegensatz zu den Adapter Methoden führt LoRA nicht zu zusätzlicher Latenz während der Inferenz, wodurch die Effizienz des Modells während der Bereitstellungsphase erhalten bleibt. Die Feinabstimmung von Whisper mithilfe von LoRA hat vielversprechende Ergebnisse gezeigt. Nehmen Sie zum Beispiel Whisper-Large-v2: Das Ausführen von 3 Epochen mit einem 12-stündigen gemeinsamen Sprachdatensatz auf einer 8-GB-Speicher-GPU dauert 6–8 Stunden, was fünfmal schneller ist als die vollständige Feinabstimmung bei vergleichbarer Leistung.

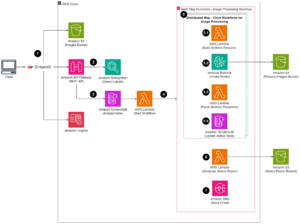

Amazon Sage Maker ist eine ideale Plattform, um die LoRA-Feinabstimmung von Whisper zu implementieren. Mit Amazon SageMaker können Sie Modelle für maschinelles Lernen für jeden Anwendungsfall mit vollständig verwalteter Infrastruktur, Tools und Workflows erstellen, trainieren und bereitstellen. Zu den weiteren Vorteilen des Modelltrainings können niedrigere Trainingskosten mit Managed Spot Training, verteilte Trainingsbibliotheken zur Aufteilung von Modellen und Trainingsdatensätzen auf AWS-GPU-Instanzen usw. gehören mehr. Die trainierten SageMaker-Modelle können problemlos zur Inferenz direkt auf SageMaker eingesetzt werden. In diesem Beitrag präsentieren wir eine Schritt-für-Schritt-Anleitung zur Implementierung der LoRA-Feinabstimmung in SageMaker. Der zu dieser Implementierung gehörige Quellcode ist auf zu finden GitHub.

Bereiten Sie den Datensatz für die Feinabstimmung vor

Für die Feinabstimmungsaufgabe verwenden wir die ressourcenarme Sprache Marathi. Verwendung der Hugging Face-Datensätze In der Bibliothek können Sie den Common Voice-Datensatz herunterladen und in Trainings- und Testdatensätze aufteilen. Siehe den folgenden Code:

Für das Whisper-Spracherkennungsmodell sind Audioeingaben erforderlich 16-kHz-Mono-16-Bit-WAV-Dateien mit Vorzeichen. Da der Common Voice-Datensatz eine Abtastrate von 48 KB hat, müssen Sie die Audiodateien zunächst herunterskalieren. Anschließend müssen Sie den Feature-Extraktor von Whisper auf das Audio anwenden, um Log-Mel-Spektrogramm-Features zu extrahieren, und den Tokenizer von Whisper auf die eingerahmten Features anwenden, um jeden Satz im Transkript in eine Token-ID umzuwandeln. Siehe den folgenden Code:

Nachdem Sie alle Trainingsbeispiele verarbeitet haben, laden Sie die verarbeiteten Daten auf Amazon S3 hoch, damit Sie sie bei der Verwendung der verarbeiteten Trainingsdaten in der Feinabstimmungsphase verwenden können FastFile So mounten Sie die S3-Datei direkt, anstatt sie auf die lokale Festplatte zu kopieren:

Trainiere das Modell

Zur Demonstration verwenden wir whisper-large-v2 als vorab trainiertes Modell (whisper v3 ist jetzt verfügbar), das über die Hugging Face-Transformer-Bibliothek importiert werden kann. Sie können verwenden 8-Bit-Quantisierung um die Trainingseffizienz weiter zu verbessern. Die 8-Bit-Quantisierung bietet eine Speicheroptimierung durch Rundung von Gleitkommazahlen auf 8-Bit-Ganzzahlen. Es handelt sich um eine häufig verwendete Technik zur Modellkomprimierung, um die Einsparungen durch reduzierten Speicher zu erzielen, ohne die Präzision bei der Inferenz zu stark zu beeinträchtigen.

Um das vorab trainierte Modell im quantisierten 8-Bit-Format zu laden, fügen wir beim Instanziieren des Modells einfach das Argument „load_in_8bit=True“ hinzu, wie im folgenden Code gezeigt. Dadurch werden die auf 8 Bit quantisierten Modellgewichte geladen, wodurch der Speicherbedarf reduziert wird.

Wir verwenden die LoRA-Implementierung von Hugging Face's peft Paket. Die Feinabstimmung eines Modells mithilfe von LoRA erfolgt in vier Schritten:

- Instanziieren Sie ein Basismodell (wie wir es im letzten Schritt getan haben).

- Erstellen Sie eine Konfiguration (

LoraConfig), wo LoRA-spezifische Parameter definiert sind. - Wickeln Sie das Basismodell mit ein

get_peft_model()um eine trainierbare zu bekommenPeftModel. - Trainiere die

PeftModelals Basismodell.

Siehe folgenden Code:

Um a SageMaker-Schulung Job, wir bringen unseren eigenen Docker-Container mit. Sie können das Docker-Image herunterladen von GitHub, wo ffmpeg4 und git-lfs zusammen mit anderen Python-Anforderungen gepackt sind. Weitere Informationen zum Anpassen Ihres eigenen Docker-Containers für die Arbeit mit SageMaker finden Sie unter Anpassung Ihres eigenen Trainingscontainers. Dann können Sie den Hugging Face Estimator verwenden und einen SageMaker-Schulungsauftrag starten:

Die Implementierung von LoRA ermöglichte es uns, die große Feinabstimmungsaufgabe „Whisper“ auf einer einzelnen GPU-Instanz (z. B. ml.g5.2xlarge) auszuführen. Im Vergleich dazu erfordert die vollständige Feinabstimmungsaufgabe Whisper Large mehrere GPUs (z. B. ml.p4d.24xlarge) und eine viel längere Trainingszeit. Genauer gesagt hat unser Experiment gezeigt, dass die vollständige Feinabstimmungsaufgabe im Vergleich zum LoRA-Ansatz 24-mal mehr GPU-Stunden erfordert.

Bewerten Sie die Modellleistung

Um die Leistung des fein abgestimmten Whisper-Modells zu bewerten, berechnen wir die Wortfehlerrate (WER) anhand eines durchgehaltenen Testsatzes. WER misst den Unterschied zwischen dem vorhergesagten Transkript und dem Ground-Truth-Transkript. Ein niedrigerer WER weist auf eine bessere Leistung hin. Sie können das folgende Skript für das vorab trainierte Modell und das fein abgestimmte Modell ausführen und deren WER-Unterschiede vergleichen:

Zusammenfassung

In diesem Beitrag haben wir die Feinabstimmung von Whisper demonstriert, einem hochmodernen Spracherkennungsmodell. Insbesondere haben wir PEFT LoRA von Hugging Face verwendet und die 8-Bit-Quantisierung für ein effizientes Training aktiviert. Wir haben auch gezeigt, wie der Trainingsjob auf SageMaker ausgeführt wird.

Obwohl dies ein wichtiger erster Schritt ist, gibt es mehrere Möglichkeiten, wie Sie auf dieser Arbeit aufbauen können, um das Flüstermodell weiter zu verbessern. Erwägen Sie in Zukunft die Verwendung des verteilten SageMaker-Trainings, um das Training auf einen viel größeren Datensatz zu skalieren. Dadurch kann das Modell auf vielfältigeren und umfassenderen Daten trainiert werden, wodurch die Genauigkeit verbessert wird. Sie können auch die Latenz bei der Bereitstellung des Whisper-Modells optimieren, um eine Spracherkennung in Echtzeit zu ermöglichen. Darüber hinaus könnten Sie die Arbeit erweitern, um längere Audiotranskriptionen zu verarbeiten, was Änderungen an der Modellarchitektur und den Trainingsschemata erfordert.

Wissen

Die Autoren danken Paras Mehra, John Sol und Evandro Franco für ihr aufschlussreiches Feedback und die Rezension des Beitrags.

Über die Autoren

Juni Shi ist Senior Solutions Architect bei Amazon Web Services (AWS). Seine aktuellen Schwerpunkte sind KI/ML-Infrastruktur und -Anwendungen. Er verfügt über mehr als ein Jahrzehnt Erfahrung in der FinTech-Branche als Softwareentwickler.

Juni Shi ist Senior Solutions Architect bei Amazon Web Services (AWS). Seine aktuellen Schwerpunkte sind KI/ML-Infrastruktur und -Anwendungen. Er verfügt über mehr als ein Jahrzehnt Erfahrung in der FinTech-Branche als Softwareentwickler.

Dr. Changsha Ma ist KI/ML-Spezialist bei AWS. Sie ist Technologin mit einem Doktortitel in Informatik, einem Master-Abschluss in Pädagogischer Psychologie und jahrelanger Erfahrung in Datenwissenschaft und unabhängiger Beratung im Bereich KI/ML. Ihre Leidenschaft gilt der Erforschung methodischer Ansätze für maschinelle und menschliche Intelligenz. Außerhalb der Arbeit geht sie gerne wandern, kocht, geht auf Nahrungssuche und verbringt Zeit mit Freunden und Familien.

Dr. Changsha Ma ist KI/ML-Spezialist bei AWS. Sie ist Technologin mit einem Doktortitel in Informatik, einem Master-Abschluss in Pädagogischer Psychologie und jahrelanger Erfahrung in Datenwissenschaft und unabhängiger Beratung im Bereich KI/ML. Ihre Leidenschaft gilt der Erforschung methodischer Ansätze für maschinelle und menschliche Intelligenz. Außerhalb der Arbeit geht sie gerne wandern, kocht, geht auf Nahrungssuche und verbringt Zeit mit Freunden und Familien.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/fine-tune-whisper-models-on-amazon-sagemaker-with-lora/

- :hast

- :Ist

- :Wo

- 000

- 1

- 10

- 100

- 13

- 15%

- 17

- 24

- 25

- 26%

- 40

- 7

- 8

- 97

- a

- Über Uns

- Genauigkeit

- Erreichen

- über

- automatisch

- Anpassung

- hinzufügen

- Zusätzliche

- zusätzlich

- gegen

- AI / ML

- Alle

- erlauben

- ebenfalls

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon Web Services (AWS)

- amp

- an

- und

- jedem

- Anwendungen

- Bewerbung

- Ansatz

- Ansätze

- ca.

- Architektur

- SIND

- Bereiche

- Argument

- Feld

- AS

- damit verbundenen

- At

- Audio-

- Autoren

- Auto

- automatische

- verfügbar

- AWS

- Base

- basierend

- BE

- weil

- werden

- war

- Nutzen

- Vorteile

- Besser

- zwischen

- beide

- bringen

- bauen

- by

- Berechnen

- CAN

- Häuser

- challenges

- Änderungen

- Code

- Kombination

- gemeinsam

- häufig

- vergleichbar

- vergleichen

- verglichen

- Vergleich

- umfassend

- rechnerisch

- Berechnen

- Computer

- Computerwissenschaften

- Konfiguration

- Geht davon

- erheblich

- Consulting

- Container

- verkaufen

- Kopieren

- Kosten

- könnte

- Strom

- technische Daten

- Datenaufbereitung

- Datenwissenschaft

- Datensätze

- Jahrzehnte

- verringern

- definiert

- Grad

- des Restaurants

- Anforderungen

- Synergie

- einsetzen

- Einsatz

- Einsatz

- Trotz

- DID

- Unterschied

- schwer

- Direkt

- verteilt

- verteiltes Training

- Docker

- Tut nicht

- herunterladen

- im

- jeder

- leicht

- Bildungswesen

- Effizienz

- effizient

- ermöglichen

- freigegeben

- ermöglicht

- umfassend

- Ingenieur

- Umgebungen

- Epoche

- Fehler

- insbesondere

- bewerten

- Sogar

- Beispiel

- überschreiten

- außergewöhnlich

- Erweitern Sie die Funktionalität der

- ERFAHRUNGEN

- Experiment

- erweitern

- Extrakt

- Gesicht

- Familien

- beschleunigt

- Merkmal

- Eigenschaften

- Feedback

- Weniger

- Reichen Sie das

- Mappen

- FinTech

- Vorname

- fünf

- schweben

- Setzen Sie mit Achtsamkeit

- Folgende

- Nahrung,

- Fußabdruck

- Aussichten für

- Format

- vorwärts

- gefunden

- vier

- Freunde

- für

- voller

- voll

- Funktion

- weiter

- bekommen

- gehen

- GPU

- GPUs

- Dankbarkeit

- Boden

- Guide

- Griff

- Haben

- he

- GUTE

- seine

- STUNDEN

- Ultraschall

- Hilfe

- aber

- HTML

- HTTPS

- human

- menschliche Intelligenz

- Jagd

- Hürden

- ID

- ideal

- ids

- Image

- implementieren

- Implementierung

- importieren

- wichtig

- zu unterstützen,

- Verbesserung

- in

- das

- hat

- unabhängig

- zeigt

- Energiegewinnung

- Infrastruktur

- Varianten des Eingangssignals:

- Eingänge

- aufschlussreiche

- Instanz

- beantragen müssen

- Intelligenz

- in

- einführen

- Stellt vor

- IT

- SEINE

- Job

- Peter

- jpg

- bekannt

- Label

- Etiketten

- Sprache

- Sprachen

- grosse

- größer

- Nachname

- Latency

- Schicht

- LERNEN

- lernen

- Bibliotheken

- Bibliothek

- Einschränkungen

- Limitiert

- Belastung

- aus einer regionalen

- länger

- liebt

- senken

- Maschine

- Maschinelles Lernen

- Aufrechterhaltung

- unterhält

- Making

- verwaltet

- Karte

- Meister

- Spiel

- sinnvoll

- Maßnahmen

- Memory

- Methode

- Methoden

- Metrisch

- ML

- Modell

- für

- mehr

- MOUNT

- mr

- viel

- mehrere

- erfordert

- Need

- erforderlich

- Andere

- jetzt an

- Anzahl

- Nvidia

- of

- Angebote

- vorgenommen,

- on

- EINEM

- die

- Optimierung

- Optimieren

- Optionen

- or

- Original

- Andere

- UNSERE

- aussen

- übrig

- besitzen

- Paket

- verpackt

- Parameter

- besondere

- leidenschaftlich

- Leistung

- Phase

- phd

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Pose

- Post

- Präzision

- vorhergesagt

- Vorbereitung

- Gegenwart

- Verarbeitet

- aussichtsreich

- Psychologie

- Python

- Qualität

- Angebot

- Rang

- Bewerten

- Echtzeit

- Anerkennung

- Veteran

- Reduziert

- Reduzierung

- siehe

- Anforderung

- Voraussetzungen:

- erfordert

- Downloads

- Die Ergebnisse

- Rückkehr

- Überprüfen

- Runden

- Führen Sie

- läuft

- s

- opfern

- sagemaker

- Ersparnisse

- Skalieren

- Regelungen

- Wissenschaft

- Skript

- sehen

- Senior

- Satz

- Lösungen

- Dienst

- kompensieren

- mehrere

- sie

- gezeigt

- unterzeichnet

- signifikant

- einfach

- Single

- Größen

- So

- Software

- Software IngenieurIn

- SOL

- Lösungen

- Quelle

- Quellcode

- Raumfahrt

- Spezialist

- speziell

- Rede

- Spracherkennung

- Ausgabe

- gespalten

- Spot

- Stufe

- Anfang

- Bundesstaat

- State-of-the-art

- statisch

- Schritt

- Shritte

- Lagerung

- Struktur

- so

- Nehmen

- nimmt

- Target

- Aufgabe

- und Aufgaben

- Technik

- Technologe

- zehn

- AGB

- Test

- Testen

- Text

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Quelle

- ihr

- dann

- Dort.

- damit

- fehlen uns die Worte.

- Durch

- Durchsatz

- Zeit

- mal

- zu

- gemeinsam

- Zeichen

- auch

- Werkzeuge

- Fackel

- traditionell

- Training

- trainiert

- Ausbildung

- Abschrift

- Transformator

- Transformer

- Wahrheit

- einzigartiges

- nicht wie

- us

- -

- Anwendungsfall

- benutzt

- Verwendung von

- vielfältig

- Stimme

- Wege

- we

- Netz

- Web-Services

- wann

- welche

- Flüstern

- werden wir

- mit

- ohne

- Word

- Arbeiten

- Workflows

- Jahr

- Du

- Ihr

- Zephyrnet