In der dynamischen Welt des Streamings weiter Amazon MusikJede Suche nach einem Song, einem Podcast oder einer Playlist birgt eine Geschichte, eine Stimmung oder eine Flut von Emotionen, die darauf warten, enthüllt zu werden. Diese Suchen dienen als Tor zu neuen Entdeckungen, geschätzten Erfahrungen und bleibenden Erinnerungen. In der Suchleiste geht es nicht nur darum, ein Lied zu finden; Es geht um die Millionen aktiver Nutzer, die ihre persönliche Reise in die reiche und vielfältige Welt beginnen, die Amazon Music zu bieten hat.

Um ein erstklassiges Kundenerlebnis zu bieten und die Musik, nach der Benutzer suchen, sofort zu finden, ist eine Plattform erforderlich, die sowohl intelligent als auch reaktionsfähig ist. Amazon Music nutzt dazu die Kraft der KI. Allerdings ist es in Spitzenverkehrszeiten schwierig, das Kundenerlebnis zu optimieren und gleichzeitig die Kosten für Schulung und Inferenz von KI-Modellen zu verwalten, die die Funktionen der Suchleiste unterstützen, wie z. B. Rechtschreibprüfung in Echtzeit und Vektorsuche.

Amazon Sage Maker bietet eine End-to-End-Reihe von Diensten, die es Amazon Music ermöglichen, mit minimalem Aufwand in der AWS Cloud zu erstellen, zu trainieren und bereitzustellen. Indem SageMaker sich um die undifferenzierte Schwerarbeit kümmert, können Sie sich auf die Arbeit an Ihren Modellen für maschinelles Lernen (ML) konzentrieren und müssen sich nicht um Dinge wie die Infrastruktur kümmern. Als Teil des Modells der geteilten Verantwortung stellt SageMaker sicher, dass die von ihnen bereitgestellten Dienste zuverlässig, leistungsstark und skalierbar sind, während Sie sicherstellen, dass die Anwendung der ML-Modelle die von SageMaker bereitgestellten Funktionen optimal nutzt.

In diesem Beitrag gehen wir durch den Weg, den Amazon Music unternommen hat, um Leistung und Kosten mithilfe von SageMaker und NVIDIA Triton Inference Server und TensorRT zu optimieren. Wir zeigen Ihnen ausführlich, wie diese scheinbar einfache, aber komplizierte Suchleiste funktioniert und sorgen für eine ununterbrochene Reise in das Universum von Amazon Music mit kaum bis gar keinen frustrierenden Tippfehlerverzögerungen und relevanten Echtzeit-Suchergebnissen.

Amazon SageMaker und NVIDIA: Bereitstellung schneller und genauer Vektorsuch- und Rechtschreibprüfungsfunktionen

Amazon Music bietet eine riesige Bibliothek mit über 100 Millionen Songs und Millionen Podcast-Episoden. Allerdings kann es eine Herausforderung sein, den richtigen Song oder Podcast zu finden, insbesondere wenn Sie den genauen Titel, Interpreten oder Albumnamen nicht kennen oder die Suchanfrage sehr weit gefasst ist, wie zum Beispiel „Nachrichten-Podcasts“.

Amazon Music hat einen zweigleisigen Ansatz gewählt, um den Such- und Abrufprozess zu verbessern. Der erste Schritt besteht in der Einführung der Vektorsuche (auch bekannt als einbettungsbasierter Abruf), einer ML-Technik, die Benutzern dabei helfen kann, mithilfe der Semantik des Inhalts den relevantesten Inhalt zu finden, nach dem sie suchen. Der zweite Schritt umfasst die Einführung eines Transformer-basierten Rechtschreibkorrekturmodells in den Suchstapel. Dies kann besonders bei der Suche nach Musik hilfreich sein, da Benutzer möglicherweise nicht immer die genaue Schreibweise eines Songtitels oder Künstlernamens kennen. Mithilfe der Rechtschreibkorrektur können Nutzer die gesuchte Musik auch dann finden, wenn ihnen bei ihrer Suchanfrage ein Rechtschreibfehler unterläuft.

Die Einführung von Transformer-Modellen in einer Such- und Abrufpipeline (in der Abfrageeinbettungsgenerierung, die für die Vektorsuche benötigt wird, und des generativen Seq2Seq-Transformermodells in der Rechtschreibkorrektur) kann zu einer erheblichen Erhöhung der Gesamtlatenz führen und sich negativ auf das Kundenerlebnis auswirken. Daher war es für uns oberste Priorität, die Echtzeit-Inferenzlatenz für Vektorsuch- und Rechtschreibkorrekturmodelle zu optimieren.

Amazon Music und NVIDIA haben sich zusammengetan, um das bestmögliche Kundenerlebnis in die Suchleiste zu bringen, indem sie SageMaker nutzen, um sowohl schnelle und genaue Rechtschreibprüfungsfunktionen als auch semantische Suchvorschläge in Echtzeit mithilfe vektorsuchbasierter Techniken zu implementieren. Die Lösung umfasst die Verwendung von SageMaker-Hosting mit G5-Instanzen, die NVIDIA A10G Tensor Core-GPUs, den von SageMaker unterstützten NVIDIA Triton Inference Server Container und den verwenden NVIDIA TensorRT Modellformat. Durch die Reduzierung der Inferenzlatenz des Rechtschreibprüfungsmodells auf 25 Millisekunden bei Spitzenverkehr und die Reduzierung der Latenz bei der Generierung der Einbettung von Suchanfragen um durchschnittlich 63 % und der Kosten um 73 % im Vergleich zur CPU-basierten Inferenz hat Amazon Music die Leistung der Suchleiste gesteigert.

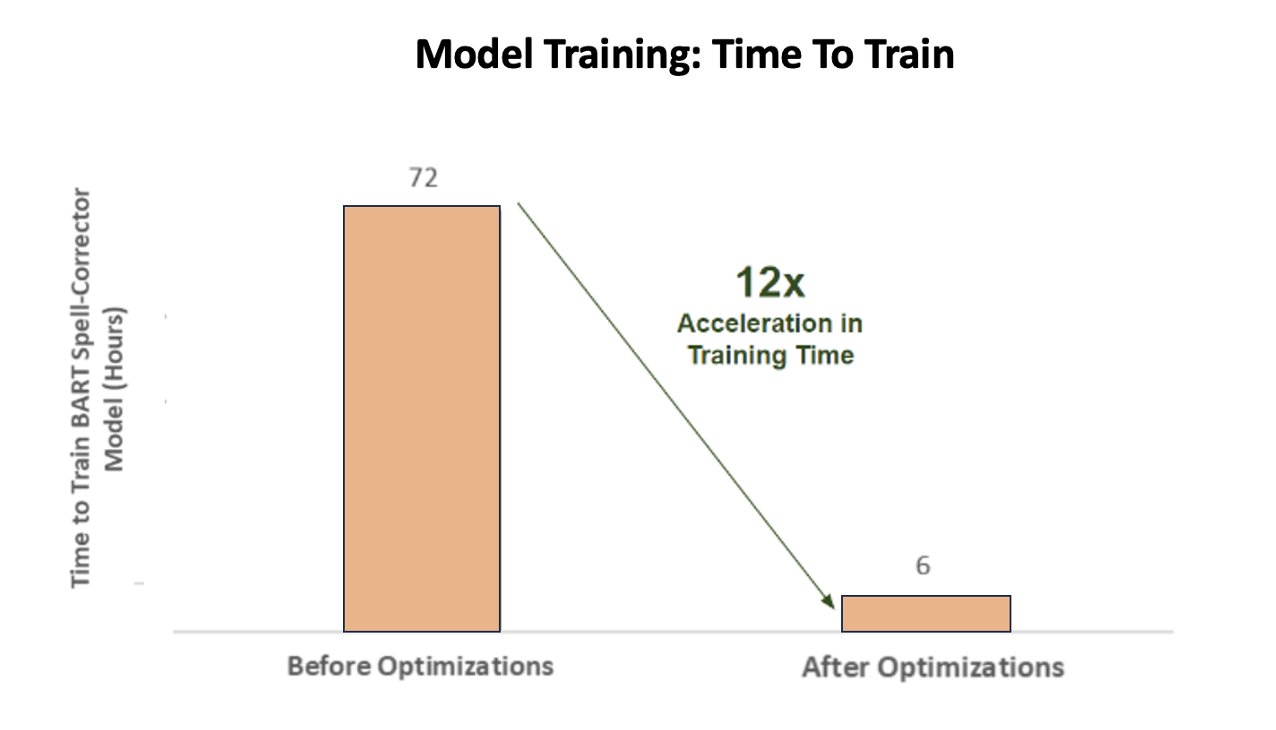

Darüber hinaus erreichte Amazon Music beim Training des KI-Modells, um genaue Ergebnisse zu liefern, eine satte 12-fache Beschleunigung der Trainingszeit für sein BART-Sequenz-zu-Sequenz-Rechtschreibkorrektur-Transformator-Modell und sparte durch die Optimierung der GPU-Auslastung sowohl Zeit als auch Geld.

Amazon Music hat sich mit NVIDIA zusammengetan, um dem Kundensucherlebnis Priorität einzuräumen und eine Suchleiste mit gut optimierten Rechtschreibprüfungs- und Vektorsuchfunktionen zu erstellen. In den folgenden Abschnitten erzählen wir mehr darüber, wie diese Optimierungen orchestriert wurden.

Optimierung des Trainings mit NVIDIA Tensor Core GPUs

Der Zugriff auf eine NVIDIA Tensor Core-GPU für das Training großer Sprachmodelle reicht nicht aus, um ihr wahres Potenzial auszuschöpfen. Während des Trainings müssen wichtige Optimierungsschritte durchgeführt werden, um die GPU-Auslastung vollständig zu maximieren. Eine nicht ausreichend ausgelastete GPU führt jedoch zweifellos zu einer ineffizienten Ressourcennutzung, längeren Schulungszeiten und höheren Betriebskosten.

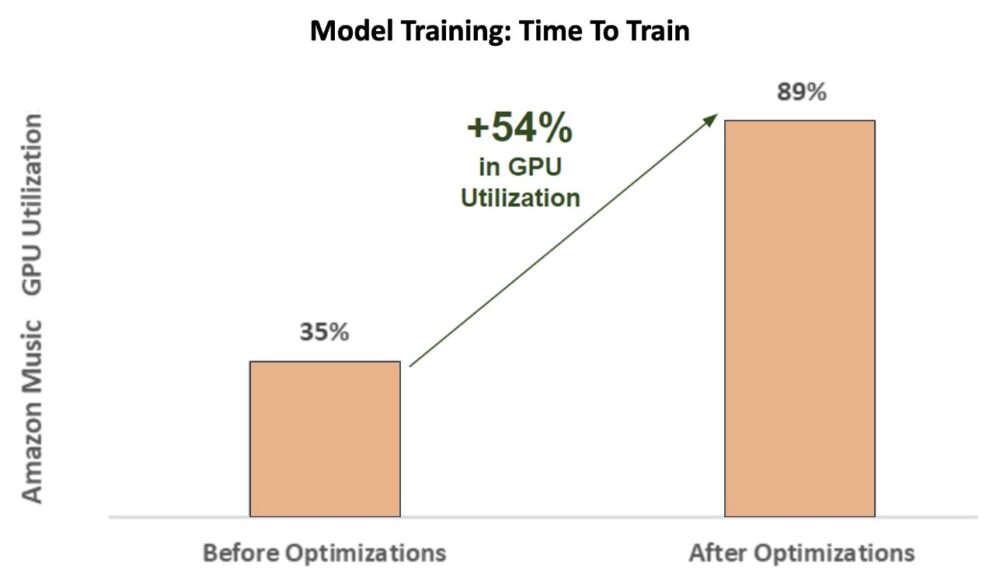

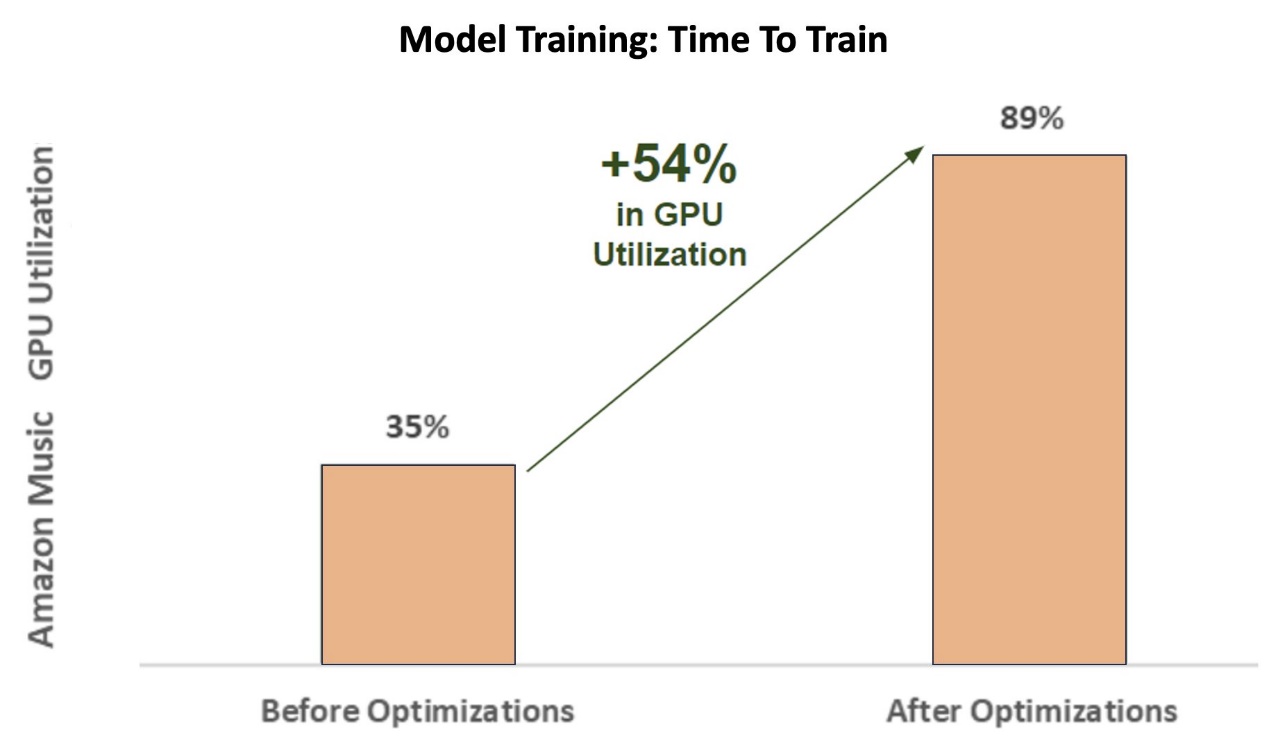

In den ersten Phasen des Trainings wird der Rechtschreibkorrektor BART (Bart-Basis) Transformer-Modell auf einer SageMaker ml.p3.24xlarge-Instanz (8 NVIDIA V100 Tensor Core GPUs) betrug die GPU-Auslastung von Amazon Music etwa 35 %. Um die Vorteile des NVIDIA GPU-beschleunigten Trainings zu maximieren, unterstützten die Lösungsarchitekten von AWS und NVIDIA Amazon Music bei der Identifizierung von Optimierungsbereichen, insbesondere im Hinblick auf die Batch-Größe und die Präzisionsparameter. Diese beiden entscheidenden Parameter beeinflussen die Effizienz, Geschwindigkeit und Genauigkeit des Trainings von Deep-Learning-Modellen.

Die daraus resultierenden Optimierungen führten zu einer neuen und verbesserten V100-GPU-Auslastung, die konstant bei etwa 89 % liegt, wodurch sich die Schulungszeit von Amazon Music drastisch von 3 Tagen auf 5–6 Stunden verkürzte. Durch Ändern der Stapelgröße von 32 auf 256 und Verwenden von Optimierungstechniken wie Ausführen automatisches gemischtes Präzisionstraining Anstatt nur die FP32-Präzision zu verwenden, konnte Amazon Music sowohl Zeit als auch Geld sparen.

Das folgende Diagramm veranschaulicht den Anstieg der GPU-Auslastung um 54 Prozentpunkte nach Optimierungen.

Die folgende Abbildung veranschaulicht die Beschleunigung der Trainingszeit.

Diese Erhöhung der Batchgröße ermöglichte es der NVIDIA-GPU, deutlich mehr Daten gleichzeitig auf mehreren Tensor-Kernen zu verarbeiten, was zu einer beschleunigten Trainingszeit führte. Es ist jedoch wichtig, beim Speicher ein ausgewogenes Verhältnis zu wahren, da größere Batchgrößen mehr Speicher erfordern. Sowohl die Erhöhung der Stapelgröße als auch der Einsatz gemischter Präzision können entscheidend sein, um die Leistung von NVIDIA Tensor Core-GPUs freizusetzen.

Nachdem das Modell auf Konvergenz trainiert wurde, war es an der Zeit, es für die Inferenzbereitstellung in der Suchleiste von Amazon Music zu optimieren.

Rechtschreibkorrektur: Inferenzierung des BART-Modells

Mit Hilfe von SageMaker G5-Instanzen und NVIDIA Triton Inference Server (einer Open-Source-Inferenzbereitstellungssoftware) sowie NVIDIA TensorRT, einem SDK für leistungsstarke Deep-Learning-Inferenz, das einen Inferenzoptimierer und eine Laufzeit umfasst, begrenzt Amazon Music seine Rechtschreibprüfung BART (Bart-Basis) modellieren die Server-Inferenzlatenz bei Spitzenverkehr auf nur 25 Millisekunden. Dazu gehören Gemeinkosten wie Lastausgleich, Vorverarbeitung, Modellinferenz und Nachverarbeitungszeiten.

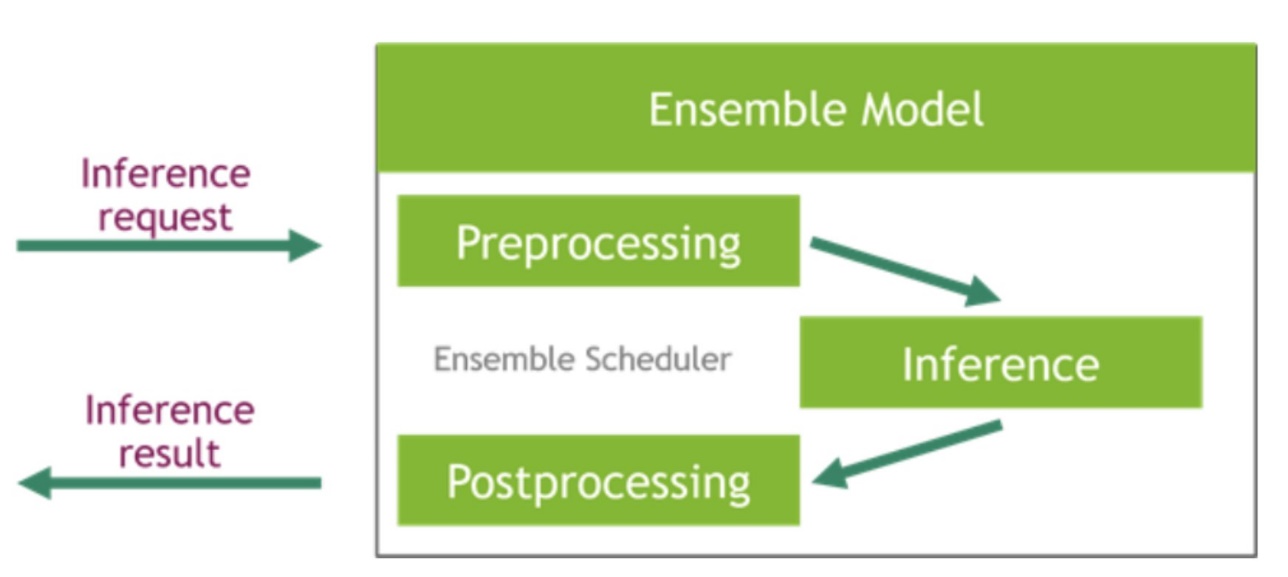

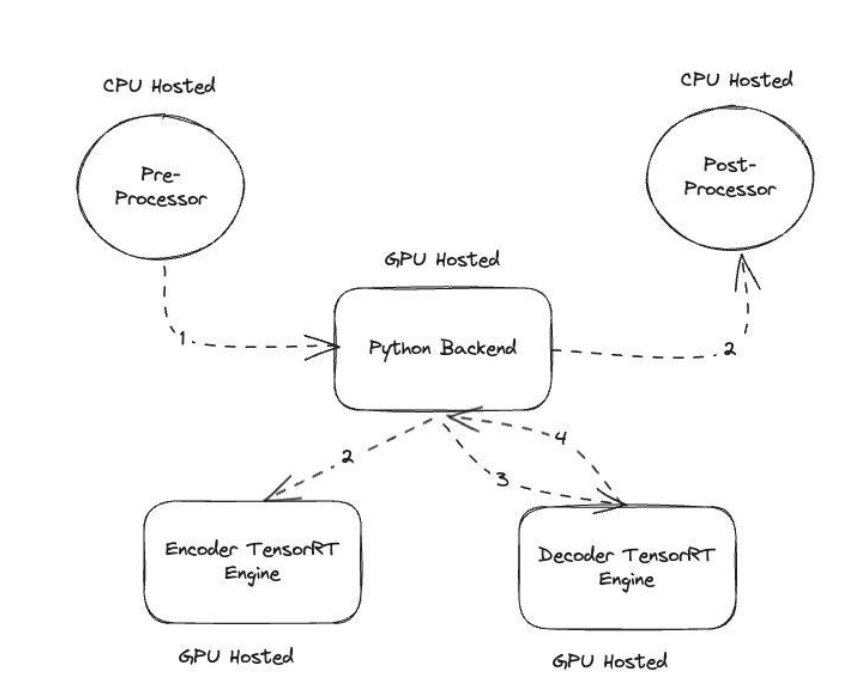

NVIDIA Triton Inference Server bietet zwei verschiedene Arten von Backends: eines zum Hosten von Modellen auf der GPU und ein Python-Backend, in das Sie Ihren eigenen benutzerdefinierten Code einbringen können, der in Vor- und Nachverarbeitungsschritten verwendet werden kann. Die folgende Abbildung veranschaulicht dies Modell-Ensemble-Schema.

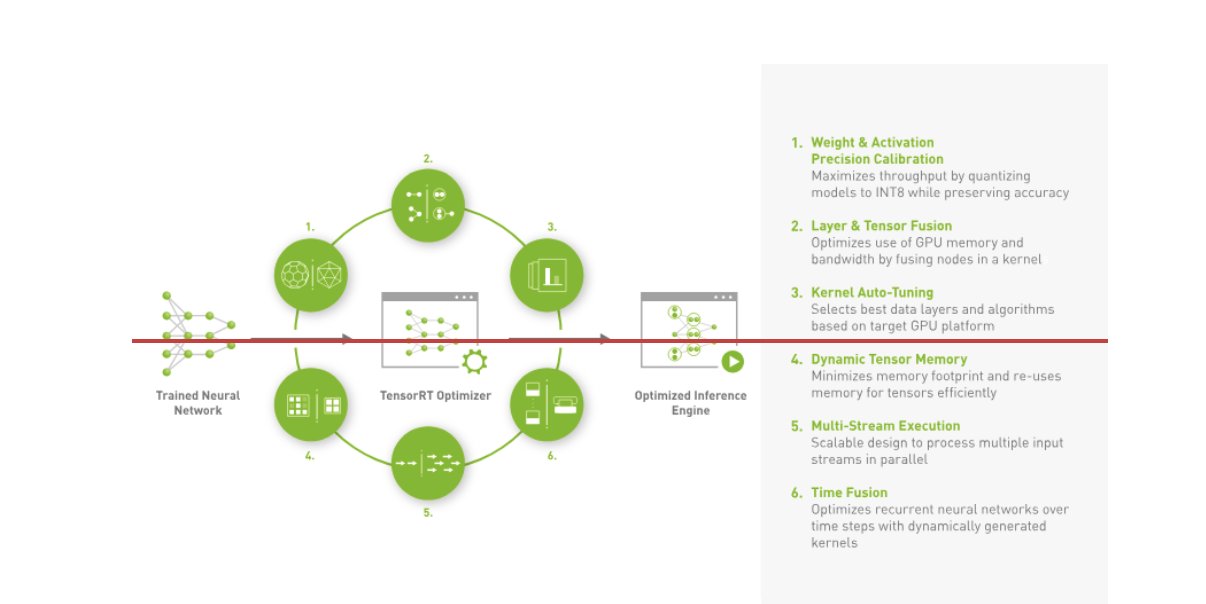

Amazon Music hat seinen BART entwickelt Inferenzpipeline indem sowohl Vorverarbeitungsschritte (Text-Tokenisierung) als auch Nachverarbeitungsschritte (Tokens zu Text) auf CPUs ausgeführt werden, während der Modellausführungsschritt weiter ausgeführt wird NVIDIA A10G Tensor Core GPUs. Ein Python-Backend befindet sich in der Mitte der Vor- und Nachverarbeitungsschritte und ist für die Kommunikation mit den TensorRT-konvertierten BART-Modellen sowie den Encoder-/Decoder-Netzwerken verantwortlich. TensorRT steigert die Inferenzleistung durch Präzisionskalibrierung, Layer- und Tensorfusion, Kernel-Auto-Tuning, dynamischen Tensorspeicher, Multi-Stream-Ausführung und Zeitfusion.

Die folgende Abbildung veranschaulicht das übergeordnete Design der Schlüsselmodule, aus denen die Inferenzpipeline des BART-Modells für die Rechtschreibkorrektur besteht.

Vektorsuche: Abfrageeinbettung zur Erzeugung eines Satzes, BERT-Modellinferenz

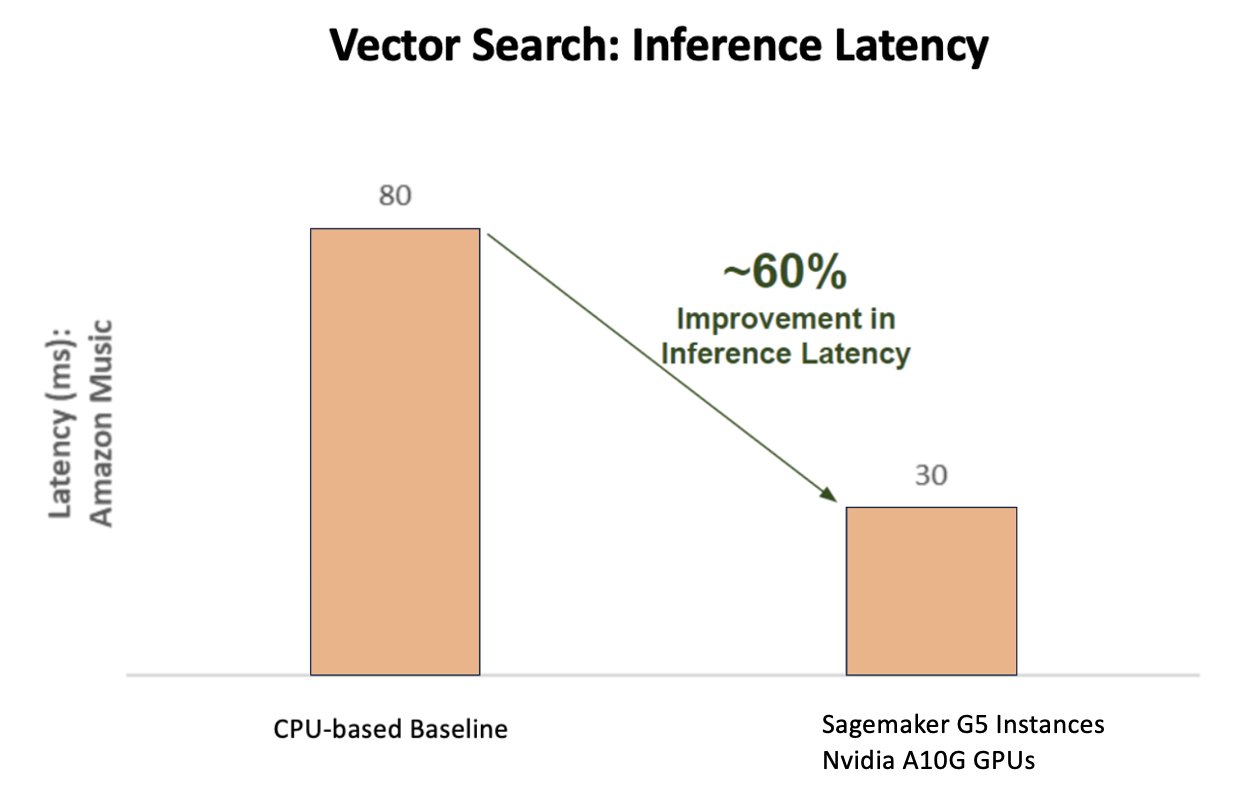

Das folgende Diagramm zeigt die 60-prozentige Verbesserung der Latenz (für p90 800–900 TPS) bei Verwendung der NVIDIA AI Inference Platform im Vergleich zu einer CPU-basierten Basislinie.

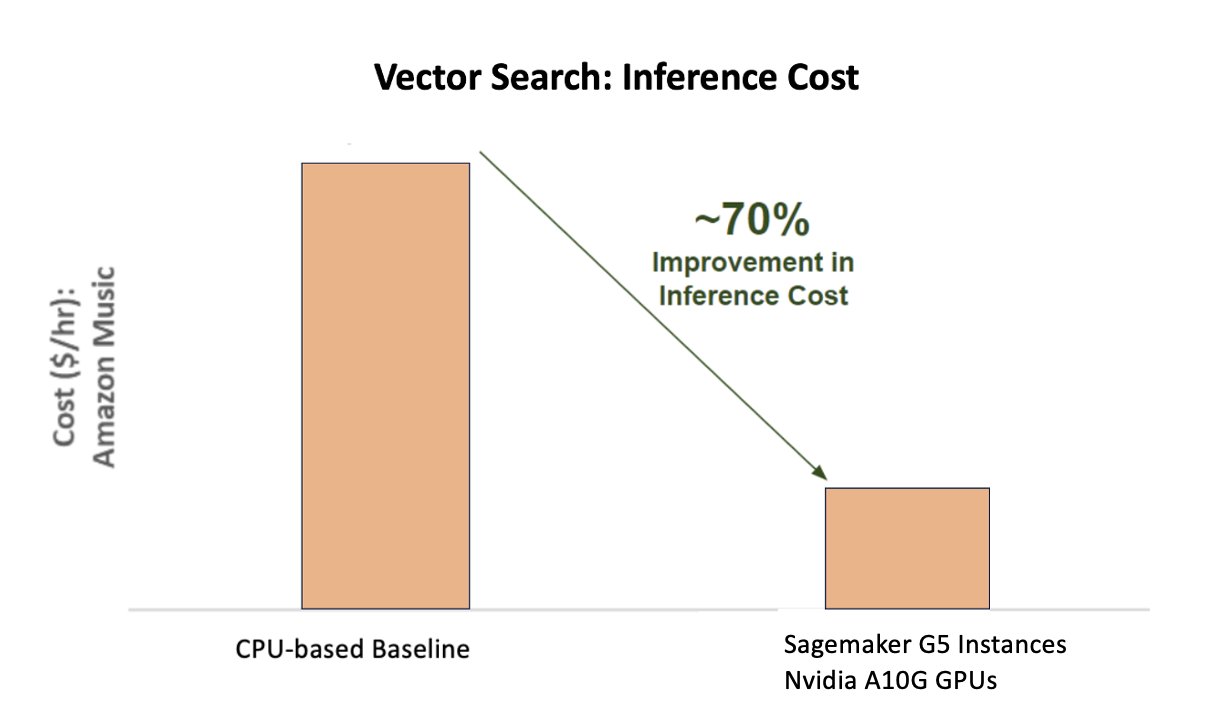

Das folgende Diagramm zeigt eine Kostensenkung von 70 % bei Verwendung der NVIDIA AI Inference Platform im Vergleich zu einer CPU-basierten Basislinie.

Die folgende Abbildung zeigt ein SDK für leistungsstarke Deep-Learning-Inferenz. Es umfasst einen Deep-Learning-Inferenzoptimierer und eine Laufzeit, die eine geringe Latenz und einen hohen Durchsatz für Inferenzanwendungen bietet.

Um diese Ergebnisse zu erzielen, experimentierte Amazon Music mit mehreren verschiedenen Triton-Bereitstellungsparametern Triton-Modellanalysator, ein Tool, das dabei hilft, die beste NVIDIA Triton-Modellkonfiguration zu finden, um effiziente Inferenz bereitzustellen. Um die Modellinferenz zu optimieren, bietet Triton Funktionen wie dynamisches Batching und gleichzeitige Modellausführung und verfügt über Framework-Unterstützung für andere Flexibilitätsfunktionen. Die dynamische Stapelverarbeitung sammelt Rückschlussanfragen und gruppiert sie nahtlos in Kohorten, um den Durchsatz zu maximieren und gleichzeitig Echtzeit-Antworten für Amazon Music-Benutzer sicherzustellen. Die Fähigkeit zur gleichzeitigen Modellausführung verbessert die Inferenzleistung weiter, indem mehrere Kopien des Modells auf derselben GPU gehostet werden. Schließlich durch die Nutzung Triton-ModellanalysatorAmazon Music konnte die dynamischen Stapelverarbeitungs- und Modell-Parallelitäts-Inferenz-Hosting-Parameter sorgfältig optimieren, um optimale Einstellungen zu finden, die die Inferenzleistung mithilfe von simuliertem Datenverkehr maximieren.

Zusammenfassung

Durch die Optimierung der Konfigurationen mit Triton Inference Server und TensorRT auf SageMaker konnte Amazon Music hervorragende Ergebnisse sowohl für Trainings- als auch für Inferenz-Pipelines erzielen. Die SageMaker-Plattform ist die offene End-to-End-Plattform für Produktions-KI und bietet eine schnelle Wertschöpfung sowie die Vielseitigkeit, alle wichtigen KI-Anwendungsfälle sowohl in der Hardware als auch in der Software zu unterstützen. Durch die Optimierung der V100-GPU-Auslastung für das Training und den Wechsel von CPUs zu G5-Instanzen mithilfe von NVIDIA A10G Tensor Core-GPUs sowie durch die Verwendung optimierter NVIDIA-Software wie Triton Inference Server und TensorRT können Unternehmen wie Amazon Music Zeit und Geld sparen und gleichzeitig die Leistung in beiden Bereichen steigern Schulung und Schlussfolgerung, was sich direkt in einem besseren Kundenerlebnis und niedrigeren Betriebskosten niederschlägt.

SageMaker übernimmt die undifferenzierte Schwerarbeit für ML-Training und -Hosting und ermöglicht es Amazon Music, zuverlässige, skalierbare ML-Operationen sowohl für Hardware als auch für Software bereitzustellen.

Wir empfehlen Ihnen, zu überprüfen, ob Ihre Workloads mit SageMaker optimiert sind, indem Sie stets Ihre Hardware- und Softwareauswahl bewerten, um zu sehen, ob es Möglichkeiten gibt, eine bessere Leistung bei geringeren Kosten zu erzielen.

Weitere Informationen zu NVIDIA AI in AWS finden Sie hier:

Über die Autoren

Siddharth Sharma ist ein technischer Leiter für maschinelles Lernen im Wissenschafts- und Modellierungsteam von Amazon Music. Er ist auf Such-, Retrieval-, Ranking- und NLP-bezogene Modellierungsprobleme spezialisiert. Siddharth verfügt über umfassende Erfahrung in der Arbeit an groß angelegten maschinellen Lernproblemen, die latenzempfindlich sind, z. B. Ads Targeting, Multi Modal Retrieval, Search Query Understanding usw. Vor seiner Tätigkeit bei Amazon Music arbeitete Siddharth bei Unternehmen wie Meta, Walmart Labs und Rakuten zu E-Commerce-zentrierten ML-Problemen. Siddharth verbrachte den ersten Teil seiner Karriere damit, mit Ad-Tech-Startups aus der Bay Area zusammenzuarbeiten.

Siddharth Sharma ist ein technischer Leiter für maschinelles Lernen im Wissenschafts- und Modellierungsteam von Amazon Music. Er ist auf Such-, Retrieval-, Ranking- und NLP-bezogene Modellierungsprobleme spezialisiert. Siddharth verfügt über umfassende Erfahrung in der Arbeit an groß angelegten maschinellen Lernproblemen, die latenzempfindlich sind, z. B. Ads Targeting, Multi Modal Retrieval, Search Query Understanding usw. Vor seiner Tätigkeit bei Amazon Music arbeitete Siddharth bei Unternehmen wie Meta, Walmart Labs und Rakuten zu E-Commerce-zentrierten ML-Problemen. Siddharth verbrachte den ersten Teil seiner Karriere damit, mit Ad-Tech-Startups aus der Bay Area zusammenzuarbeiten.

Tarun Sharma ist ein Software Development Manager, der die Amazon Music Search Relevance leitet. Sein Team aus Wissenschaftlern und ML-Ingenieuren ist dafür verantwortlich, den Kunden von Amazon Music kontextrelevante und personalisierte Suchergebnisse bereitzustellen.

Tarun Sharma ist ein Software Development Manager, der die Amazon Music Search Relevance leitet. Sein Team aus Wissenschaftlern und ML-Ingenieuren ist dafür verantwortlich, den Kunden von Amazon Music kontextrelevante und personalisierte Suchergebnisse bereitzustellen.

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

Kshitiz Gupta ist Lösungsarchitekt bei NVIDIA. Es macht ihm Spaß, Cloud-Kunden über die GPU-KI-Technologien von NVIDIA aufzuklären und sie bei der Beschleunigung ihrer Anwendungen für maschinelles Lernen und Deep Learning zu unterstützen. Außerhalb der Arbeit geht er gerne laufen, wandern und Wildtiere beobachten.

Kshitiz Gupta ist Lösungsarchitekt bei NVIDIA. Es macht ihm Spaß, Cloud-Kunden über die GPU-KI-Technologien von NVIDIA aufzuklären und sie bei der Beschleunigung ihrer Anwendungen für maschinelles Lernen und Deep Learning zu unterstützen. Außerhalb der Arbeit geht er gerne laufen, wandern und Wildtiere beobachten.

Jiahong Liu ist Solution Architect im Cloud Service Provider-Team bei NVIDIA. Er unterstützt Kunden bei der Einführung von Lösungen für maschinelles Lernen und KI, die NVIDIA Accelerated Computing nutzen, um ihre Trainings- und Inferenzherausforderungen zu bewältigen. In seiner Freizeit beschäftigt er sich gerne mit Origami, DIY-Projekten und spielt Basketball.

Jiahong Liu ist Solution Architect im Cloud Service Provider-Team bei NVIDIA. Er unterstützt Kunden bei der Einführung von Lösungen für maschinelles Lernen und KI, die NVIDIA Accelerated Computing nutzen, um ihre Trainings- und Inferenzherausforderungen zu bewältigen. In seiner Freizeit beschäftigt er sich gerne mit Origami, DIY-Projekten und spielt Basketball.

Tugrul Konuk ist Senior Solution Architect bei NVIDIA und auf groß angelegte Schulungen, multimodales Deep Learning und leistungsstarkes wissenschaftliches Rechnen spezialisiert. Vor seiner Zeit bei NVIDIA arbeitete er in der Energiebranche und konzentrierte sich auf die Entwicklung von Algorithmen für die rechnergestützte Bildgebung. Im Rahmen seiner Doktorarbeit beschäftigte er sich mit physikbasiertem Deep Learning für numerische Simulationen im großen Maßstab. In seiner Freizeit liest er gerne, spielt Gitarre und Klavier.

Tugrul Konuk ist Senior Solution Architect bei NVIDIA und auf groß angelegte Schulungen, multimodales Deep Learning und leistungsstarkes wissenschaftliches Rechnen spezialisiert. Vor seiner Zeit bei NVIDIA arbeitete er in der Energiebranche und konzentrierte sich auf die Entwicklung von Algorithmen für die rechnergestützte Bildgebung. Im Rahmen seiner Doktorarbeit beschäftigte er sich mit physikbasiertem Deep Learning für numerische Simulationen im großen Maßstab. In seiner Freizeit liest er gerne, spielt Gitarre und Klavier.

Rohil Bhargava ist Produktmarketingmanager bei NVIDIA und konzentriert sich auf die Bereitstellung von NVIDIA-Anwendungsframeworks und SDKs auf bestimmten CSP-Plattformen.

Rohil Bhargava ist Produktmarketingmanager bei NVIDIA und konzentriert sich auf die Bereitstellung von NVIDIA-Anwendungsframeworks und SDKs auf bestimmten CSP-Plattformen.

Eliuth Triana Isaza ist Developer Relations Manager bei NVIDIA und befähigt die KI-MLOps, DevOps, Wissenschaftler und AWS-Technikexperten von Amazon, den NVIDIA-Computing-Stack zur Beschleunigung und Optimierung von Generative AI Foundation-Modellen zu beherrschen, die von Datenkuration, GPU-Training, Modellinferenz und Produktionsbereitstellung auf AWS-GPU-Instanzen reichen . Darüber hinaus ist Eliuth ein leidenschaftlicher Mountainbiker, Skifahrer, Tennis- und Pokerspieler.

Eliuth Triana Isaza ist Developer Relations Manager bei NVIDIA und befähigt die KI-MLOps, DevOps, Wissenschaftler und AWS-Technikexperten von Amazon, den NVIDIA-Computing-Stack zur Beschleunigung und Optimierung von Generative AI Foundation-Modellen zu beherrschen, die von Datenkuration, GPU-Training, Modellinferenz und Produktionsbereitstellung auf AWS-GPU-Instanzen reichen . Darüber hinaus ist Eliuth ein leidenschaftlicher Mountainbiker, Skifahrer, Tennis- und Pokerspieler.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Fähig

- Über Uns

- beschleunigt

- beschleunigend

- Beschleunigung

- Zugang

- erreichen

- Genauigkeit

- genau

- Erreichen

- erreicht

- über

- aktiv

- Zusatz

- Adresse

- Die Annahme

- Siehe Werbung

- beeinflussen

- Nach der

- AI

- KI-Modelle

- KI-Anwendungsfälle

- Album

- Algorithmen

- Alle

- erlauben

- erlaubt

- Zulassen

- erlaubt

- ebenfalls

- immer

- Amazon

- Amazon Web Services

- Amazon.com

- an

- und

- Anwendung

- Anwendungen

- Ansatz

- Architekten

- SIND

- Bereich

- Bereiche

- um

- Künstler

- AS

- Unterstützung

- Vorlagen

- At

- durchschnittlich

- AWS

- Backend

- Balance

- Balancing

- Bar

- basierend

- Baseline

- Basketball

- Bucht

- BE

- wurde

- weil

- Vorteile

- BESTE

- Besser

- Stärkung

- Boosts

- beide

- bringen

- breit

- bauen

- erbaut

- by

- CAN

- Fähigkeiten

- capability

- Erfassung

- österreichische Unternehmen

- Karriere

- vorsichtig

- Fälle

- Herausforderungen

- herausfordernd

- Chart

- aus der Ferne überprüfen

- geschätzt

- Entscheidungen

- Kunden

- Cloud

- Code

- COM

- wie die

- Kommunizieren

- Unternehmen

- verglichen

- rechnerisch

- Computing

- Wettbewerber

- Konfiguration

- Container

- Inhalt

- Konvergenz

- Kernbereich

- Kosten

- Kosten

- Handwerk

- kritischem

- wichtig

- CSP

- curation

- Original

- Kunde

- Customer Experience

- Kunden

- technische Daten

- Datum

- Tage

- verringert

- tief

- tiefe Lernen

- Verzögerungen

- Übergeben

- liefern

- liefert

- Demand

- einsetzen

- Bereitstellen

- Einsatz

- Design

- Entwickler:in / Unternehmen

- Entwicklung

- Entwicklung

- anders

- schwer

- Direkt

- tauchen

- verschieden

- Diy

- Nicht

- drastisch

- im

- dynamisch

- e

- e-commerce

- Früh

- Erziehung

- Effizienz

- effizient

- Anstrengung

- erhöhten

- Einbettung

- Emotionen

- anstellen

- Empowerment

- freigegeben

- ermutigen

- End-to-End

- Energie

- Ingenieure

- Verbessert

- genug

- Gewährleistung

- insbesondere

- etc

- Auswerten

- Sogar

- Jedes

- Ausführung

- ERFAHRUNGEN

- Erfahrungen

- Experten

- FAST

- Eigenschaften

- Abbildung

- Endlich

- Finden Sie

- Suche nach

- Vorname

- Flexibilität

- Flut

- Setzen Sie mit Achtsamkeit

- konzentriert

- Fokussierung

- Folgende

- Aussichten für

- Format

- Foundation

- Unser Ansatz

- Gerüste

- für

- enorm frustrierend

- voll

- Funktionsumfang

- weiter

- Verschmelzung

- Tor

- Generation

- generativ

- Generative KI

- GPU

- GPUs

- Griffe

- passieren

- Hardware

- Haben

- he

- schwer

- schweres Heben

- Hilfe

- hilfreich

- hilft

- GUTE

- High-Level

- Hohe Leistungsfähigkeit

- ihm

- seine

- hält

- Hosting

- STUNDEN

- Ultraschall

- aber

- HTML

- HTTPS

- Identifizierung

- if

- zeigt

- Imaging

- implementieren

- wichtig

- zu unterstützen,

- verbessert

- Verbesserung

- in

- Dazu gehören

- Erhöhung

- hat

- zunehmend

- Energiegewinnung

- ineffizient

- beeinflussen

- Infrastruktur

- Anfangs-

- Instanz

- sofort

- beantragen müssen

- Interesse

- in

- einführen

- Einführung

- IT

- SEINE

- Reise

- jpg

- nur

- Wesentliche

- Art

- Wissen

- bekannt

- Labs

- Sprache

- grosse

- großflächig

- größer

- dauerhaft

- Latency

- neueste

- Schicht

- führen

- führenden

- LERNEN

- lernen

- Hebelwirkung

- Bibliothek

- Facelift

- Gefällt mir

- Grenzen

- Belastung

- suchen

- Sneaker

- senken

- Maschine

- Maschinelles Lernen

- halten

- Dur

- um

- MACHT

- Manager

- flächendeckende Gesundheitsprogramme

- Marketing

- Master

- Maximieren

- Kann..

- Memories

- Memory

- Meta

- Mitte

- Million

- Millionen

- Millisekunden

- minimal

- Fehler

- gemischt

- ML

- MLOps

- Modell

- Modellieren

- für

- Module

- Geld

- mehr

- vor allem warme

- Mountain

- Multi

- mehrere

- Musik

- sollen

- Name

- erforderlich

- negativ

- Netzwerke

- Neu

- Nlp

- Nvidia

- of

- bieten

- Angebote

- on

- EINEM

- einzige

- XNUMXh geöffnet

- Open-Source-

- die

- Betriebs-

- Einkauf & Prozesse

- optimal

- Optimierung

- Optimieren

- optimiert

- Optimierung

- or

- orchestriert

- Auftrag

- Andere

- aussen

- hervorragend

- übrig

- Gesamt-

- besitzen

- Parameter

- Teil

- besondere

- besonders

- Partnerschaft

- leidenschaftlich

- Haupt

- Prozentsatz

- Leistung

- persönliche

- Personalisiert

- phd

- Pipeline

- Plattform

- Plattformen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Spieler

- spielend

- Podcast

- Podcasts

- Points

- Poker

- möglich

- Post

- Potenzial

- Werkzeuge

- angetriebene

- Präzision

- Vor

- Priorität einräumen

- Prioritätsliste

- Probleme

- Prozessdefinierung

- Produkt

- Produktion

- Projekte

- die

- Versorger

- bietet

- Bereitstellung

- Python

- Direkt

- Rangliste

- Lesebrillen

- Echtzeit

- Reduzierung

- siehe

- bezogene

- Verhältnis

- Relevanz

- relevant

- zuverlässig

- Zugriffe

- erfordert

- Downloads

- Antworten

- Verantwortung

- für ihren Verlust verantwortlich.

- ansprechbar

- was zu

- Die Ergebnisse

- Reiches

- Recht

- Laufen

- läuft

- Laufzeit

- sagemaker

- gleich

- Speichern

- Einsparung

- skalierbaren

- Skalieren

- Wissenschaft

- wissenschaftlich

- Wissenschaftler

- Sdk

- SDKS

- nahtlos

- Suche

- Suchbegriffe

- Suche

- Zweite

- Abschnitte

- sehen

- auf der Suche nach

- scheinbar

- Semantik

- Senior

- empfindlich

- Satz

- brauchen

- Server

- Dienstanbieter

- Lösungen

- Dienst

- kompensieren

- Einstellungen

- mehrere

- Teilen

- von Locals geführtes

- Konzerte

- signifikant

- bedeutend

- Einfacher

- sitzt

- Größe

- Größen

- smart

- Software

- Software-Entwicklung

- Lösung

- Lösungen

- Lied

- Quelle

- überspannend

- spezialisiert

- spezialisieren

- spezifisch

- Geschwindigkeit

- BUCHSTABIEREN

- Rechtschreibung

- verbrachte

- Stapel

- Beginnen Sie

- Startups

- bleiben

- stetig

- Schritt

- Shritte

- Geschichte

- Streaming

- so

- Oberteil

- Support

- Unterstützte

- sicher

- gemacht

- Einnahme

- Targeting

- Team

- Tech

- Technische

- Technik

- Techniken

- Technologies

- Technologie

- Text

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Dort.

- deswegen

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Durch

- Durchsatz

- Zeit

- mal

- Titel

- zu

- gemeinsam

- Tokenisierung

- Tokens

- nahm

- Werkzeug

- Top

- tps

- der Verkehr

- Training

- trainiert

- Ausbildung

- Transformator

- Trends

- Triton

- was immer dies auch sein sollte.

- XNUMX

- Verständnis

- zweifellos

- Universum

- Entriegelung

- enthüllt

- us

- -

- benutzt

- Nutzer

- verwendet

- Verwendung von

- Verwendung

- Wert

- riesig

- Vielseitigkeit

- sehr

- Warten

- Spaziergang

- Walmart

- wurde

- beobachten

- Wege

- we

- Netz

- Web-Services

- GUT

- waren

- wann

- während

- während

- werden wir

- mit

- Arbeiten

- gearbeitet

- arbeiten,

- Werk

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- Sorgen

- noch

- ergab

- Du

- Ihr

- Zephyrnet