Neuere große Sprachmodelle (LLMs) haben enorme Fortschritte beim Verstehen natürlicher Sprache ermöglicht. Sie neigen jedoch dazu, selbstbewusste, aber unsinnige Erklärungen zu generieren, was ein erhebliches Hindernis für den Aufbau von Vertrauen bei den Benutzern darstellt. In diesem Beitrag zeigen wir, wie Sie menschliches Feedback zu den falschen Argumentationsketten für Multi-Hop-Argumentation integrieren können, um die Leistung bei diesen Aufgaben zu verbessern. Anstatt die Argumentationsketten von Grund auf neu zu sammeln, indem wir Menschen befragen, lernen wir stattdessen aus reichhaltigem menschlichem Feedback zu modellgenerierten Argumentationsketten unter Verwendung der Aufforderungsfähigkeiten der LLMs. Wir sammeln zwei solcher Datensätze mit menschlichem Feedback in Form von (Korrektur, Erklärung, Fehlertyp) für StrategyQA- und Sports Understanding-Datensätze und evaluieren mehrere gängige Algorithmen, um aus solchem Feedback zu lernen. Unsere vorgeschlagenen Methoden verhalten sich konkurrenzfähig zur Eingabeaufforderung der Gedankenkette unter Verwendung des Basis-Flan-T5, und unsere ist besser darin, die Korrektheit ihrer eigenen Antwort zu beurteilen.

Lösungsüberblick

Mit dem Aufkommen großer Sprachmodelle hat das Gebiet enorme Fortschritte bei verschiedenen Benchmarks für die Verarbeitung natürlicher Sprache (NLP) erlebt. Unter ihnen war der Fortschritt bei relativ einfacheren Aufgaben wie der Beantwortung von kurzen Kontext- oder Sachfragen im Vergleich zu schwierigeren Aufgaben, die eine Argumentation erfordern, wie die Beantwortung von Multi-Hop-Fragen, bemerkenswert. Die Leistung bestimmter Aufgaben unter Verwendung von LLMs kann in kleineren Maßstäben dem zufälligen Raten ähneln, verbessert sich jedoch in größeren Maßstäben erheblich. Trotzdem haben die Aufforderungsfähigkeiten von LLMs das Potenzial, einige relevante Fakten bereitzustellen, die zur Beantwortung der Frage erforderlich sind.

Diese Modelle erzeugen jedoch möglicherweise nicht zuverlässig korrekte Argumentationsketten oder Erklärungen. Diese zuversichtlichen, aber unsinnigen Erklärungen sind noch häufiger, wenn LLMs mit Reinforcement Learning from Human Feedback (RLHF) trainiert werden, wo Belohnungshacking auftreten kann.

Dadurch motiviert, versuchen wir, die folgende Forschungsfrage anzugehen: Können wir die Argumentation von LLMs verbessern, indem wir aus menschlichem Feedback zu modellgenerierten Argumentationsketten lernen? Die folgende Abbildung gibt einen Überblick über unseren Ansatz: Wir veranlassen das Modell zunächst, Argumentationsketten für Multi-Hop-Fragen zu generieren, sammeln dann verschiedenes menschliches Feedback zu diesen Ketten zur Diagnose und schlagen Trainingsalgorithmen vor, um aus den gesammelten Daten zu lernen.

Wir sammeln vielfältiges menschliches Feedback zu zwei Multi-Hop-Argumentationsdatensätzen, StrategyQA und Sports Understanding von BigBench. Für jede Frage und modellgenerierte Argumentationskette erfassen wir die richtige Argumentationskette, die Art des Fehlers in der modellgenerierten Argumentationskette und eine Beschreibung (in natürlicher Sprache) darüber, warum dieser Fehler in der bereitgestellten Argumentationskette dargestellt wird. Der endgültige Datensatz enthält Feedback für 1,565 Proben von StrategyQA und 796 Beispiele für Sports Understanding.

Wir schlagen mehrere Trainingsalgorithmen vor, um aus dem gesammelten Feedback zu lernen. Zuerst schlagen wir eine Variante der Selbstkonsistenz in der Gedankenkettenaufforderung vor, indem wir eine gewichtete Variante davon betrachten, die aus dem Feedback gelernt werden kann. Zweitens schlagen wir eine iterative Verfeinerung vor, bei der wir die modellgenerierte Argumentationskette iterativ verfeinern, bis sie korrekt ist. Wir demonstrieren empirisch an den beiden Datensätzen, dass die Feinabstimmung eines LLM, nämlich Flan-T5 unter Verwendung der vorgeschlagenen Algorithmen, vergleichbar mit der In-Context-Lernbaseline abschneidet. Noch wichtiger ist, dass wir zeigen, dass das fein abgestimmte Modell im Vergleich zum Flan-T5-Basismodell besser beurteilen kann, ob seine eigene Antwort richtig ist.

Datenerhebung

In diesem Abschnitt beschreiben wir die Details des von uns gesammelten Feedbacks und das während der Datenerfassung befolgte Anmerkungsprotokoll. Wir haben Feedback für Modellgenerationen basierend auf zwei logischen Datensätzen gesammelt: StrategyQA und Sports Understanding von BigBench. Wir haben GPT-J verwendet, um die Antwort für StrategyQA und Flan-T5 zu generieren, um die Antwort für den Sports Understanding-Datensatz zu generieren. In jedem Fall wurde das Modell mit k Kontextbeispielen aufgefordert, die Frage, Antwort und Erklärung enthielten, gefolgt von der Testfrage.

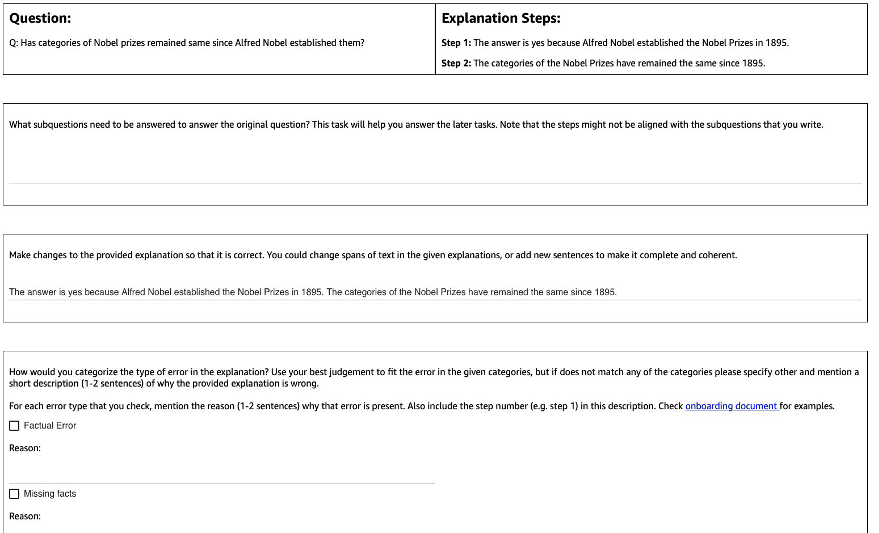

Die folgende Abbildung zeigt die von uns verwendete Schnittstelle. Kommentatoren erhalten die Frage, die vom Modell generierte Antwort und die in Schritte aufgeteilte Erklärung.

Für jede Frage haben wir das folgende Feedback gesammelt:

- Unterfragen – Die Kommentatoren zerlegen die ursprüngliche Frage in einfachere Unterfragen, die zur Beantwortung der ursprünglichen Frage erforderlich sind. Diese Aufgabe wurde nach einem Pilotprojekt hinzugefügt, bei dem wir festgestellt haben, dass das Hinzufügen dieser Aufgabe dazu beiträgt, die Kommentatoren vorzubereiten und die Qualität der restlichen Aufgaben zu verbessern.

- Korrektur – Kommentatoren erhalten ein Freiform-Textfeld, das mit der vom Modell generierten Antwort und Erklärung vorausgefüllt ist, und werden gebeten, es zu bearbeiten, um die richtige Antwort und Erklärung zu erhalten.

- Fehlertyp – Unter den häufigsten Fehlertypen, die wir in den Modellgenerationen gefunden haben (Faktischer Fehler, fehlende Fakten, irrelevante Fakten und logische Inkonsistenz), wurden die Kommentatoren gebeten, einen oder mehrere der Fehlertypen auszuwählen, die auf die gegebene Antwort und Erklärung zutreffen.

- Fehlerbeschreibung – Die Kommentatoren wurden angewiesen, die Fehler nicht nur zu klassifizieren, sondern auch eine umfassende Begründung für ihre Kategorisierung anzugeben, einschließlich der genauen Angabe des genauen Schritts, an dem der Fehler aufgetreten ist, und wie er sich auf die gegebene Antwort und Erklärung bezieht.

Wir verwendeten Amazon SageMaker Ground Truth Plus in unserer Datensammlung. Die Datenerhebung erfolgte über mehrere Runden. Zuerst führten wir zwei kleine Pilotprojekte mit 30 bzw. 200 Beispielen durch, danach erhielt das Kommentatorenteam detailliertes Feedback zur Kommentierung. Anschließend führten wir die Datenerhebung über zwei Chargen für StrategyQA und über eine Charge für Sports Understanding durch und gaben durchgehend regelmäßiges Feedback – insgesamt 10 Kommentatoren arbeiteten über einen Zeitraum von fast einem Monat an der Aufgabe.

Wir haben Feedback zu insgesamt 1,565 Beispielen für StrategyQA und 796 Beispiele für Sports Understanding gesammelt. Die folgende Tabelle zeigt den Prozentsatz der Beispiele, die bei der Modellgenerierung fehlerfrei waren, und den Anteil der Beispiele, die einen bestimmten Fehlertyp enthielten. Es ist erwähnenswert, dass einige Beispiele mehr als einen Fehlertyp haben können.

| Fehlertyp | StrategieQA | Sport verstehen |

| Andere | 17.6% | 31.28% |

| Sachlicher Fehler | 27.6% | 38.1% |

| Fehlende Fakten | 50.4% | 46.1% |

| Irrelevante Fakten | 14.6% | 3.9% |

| Logische Inkonsistenz | 11.2% | 5.2% |

Lernalgorithmen

Für jede Frage q, und modellgenerierte Antwort und Erklärung mhaben wir folgendes Feedback gesammelt: richtige Antwort und Erklärung c, Art des vorhandenen Fehlers in m (bezeichnet durch t) und Fehlerbeschreibung d, wie im vorherigen Abschnitt beschrieben.

Wir haben die folgenden Methoden verwendet:

- Multitasking-Lernen – Eine einfache Grundlage, um aus den verschiedenen verfügbaren Rückmeldungen zu lernen, besteht darin, jede von ihnen als separate Aufgabe zu behandeln. Genauer gesagt stimmen wir Flan-T5 (Text zu Text) mit dem Ziel ab maximieren p(c|q) + p(t|q, m) + p(d|q, m). Für jeden Begriff in der Zielsetzung verwenden wir eine separate Anweisung, die für die Aufgabe geeignet ist (z. B. „Prognose Fehler in der gegebenen Antwort“). Wir konvertieren auch die kategoriale Variable t in einen natürlichsprachlichen Satz. Während der Inferenz verwenden wir die Anweisung für den Begriff p(c|q) („Sage die richtige Antwort für die gegebene Frage voraus“), um die Antwort auf die Testfrage zu generieren.

- Gewichtete Selbstkonsistenz – Motiviert durch den Erfolg der Selbstkonsistenz in der Gedankenkettenaufforderung schlagen wir eine gewichtete Variante davon vor. Anstatt jede Stichprobenerklärung aus dem Modell als richtig zu behandeln und das aggregierte Votum zu berücksichtigen, prüfen wir stattdessen zuerst, ob die Erklärung richtig ist, und aggregieren dann entsprechend. Wir verfeinern zunächst Flan-T5 mit dem gleichen Ziel wie beim Multitasking-Lernen. Während der Inferenz eine Testfrage gegeben q, proben wir mehrere mögliche Antworten mit der Anweisung for p(c|q)): a1, a2, .., an. Für jede Stichprobenantwort ai, verwenden wir die Anweisung für den Begriff p(t|q,m) („Fehler in der gegebenen Antwort vorhersagen“), um festzustellen, ob sie Fehler enthält ti = argmax p(t|q, a_i). Jede Antwort ai wird eine Gewichtung von 1 zugewiesen, wenn sie korrekt ist, andernfalls wird ihr eine Gewichtung kleiner als 1 zugewiesen (einstellbarer Hyperparameter). Die endgültige Antwort wird durch Berücksichtigung einer gewichteten Abstimmung über alle Antworten erhalten a1 zu an.

- Iterative Verfeinerung – Bei den zuvor vorgeschlagenen Methoden generiert das Modell direkt die richtige Antwort c Bedingt durch die Frage q. Hier schlagen wir vor, die vom Modell generierte Antwort zu verfeinern m um die richtige Antwort auf eine gegebene Frage zu erhalten. Genauer gesagt verfeinern wir zunächst Flan-T5 (Text zu Text mit dem Ziel) mit p(t; c|q, m) maximieren, Wobei ; bezeichnet die Verkettung (Fehlertyp t gefolgt von der richtigen Antwort c). Eine Möglichkeit, dieses Ziel zu sehen, besteht darin, dass das Modell zuerst darauf trainiert wird, den Fehler in einer gegebenen Generation zu identifizieren m, und diesen Fehler dann zu entfernen, um die richtige Antwort zu erhalten c. Während der Inferenz können wir das Modell iterativ verwenden, bis es die richtige Antwort generiert – bei einer gegebenen Testfrage qerhalten wir zunächst die initiale Modellgeneration m (mit vortrainiertem Flan-T5). Wir generieren dann iterativ den Fehlertyp ti und mögliche richtige Antwort ci bis ti = kein Fehler (in der Praxis legen wir eine maximale Anzahl von Iterationen für einen Hyperparameter fest), in diesem Fall lautet die endgültige richtige Antwort ci-1 (erhalten von p(ti ; ci | q, ci-1)).

Die Ergebnisse

Für beide Datensätze vergleichen wir alle vorgeschlagenen Lernalgorithmen mit der kontextbezogenen Lernbaseline. Alle Modelle werden auf dem Entwicklungsset von StrategyQA und Sports Understanding evaluiert. Die folgende Tabelle zeigt die Ergebnisse.

| Versandart | StrategieQA | Sport verstehen |

| Flan-T5 4-Shot Chain-of-Thought In-Context Learning | 67.39 ± 2.6% | 58.5% |

| Multitasking-Lernen | 66.22 ± 0.7% | 54.3 ± 2.1% |

| Gewichtete Selbstkonsistenz | 61.13 ± 1.5% | 51.3 ± 1.9% |

| Iterative Verfeinerung | 61.85 ± 3.3% | 57.0 ± 2.5% |

Wie beobachtet, funktionieren einige Methoden vergleichbar mit der In-Context-Learning-Baseline (Multitasking für StrategyQA und iterative Verfeinerung für Sports Understanding), was das Potenzial zeigt, kontinuierliches Feedback von Menschen zu Modellergebnissen zu sammeln und dieses zur Verbesserung von Sprachmodellen zu verwenden. Dies unterscheidet sich von neueren Arbeiten wie RLHF, wo das Feedback auf kategorisch und normalerweise binär beschränkt ist.

Wie in der folgenden Tabelle gezeigt, untersuchen wir, wie Modelle, die mit menschlichem Feedback zu Denkfehlern angepasst wurden, dazu beitragen können, die Kalibrierung oder das Bewusstsein für sicher falsche Erklärungen zu verbessern. Dies wird ausgewertet, indem das Modell aufgefordert wird, vorherzusagen, ob seine Generierung Fehler enthält.

| Versandart | Error Correction | StrategieQA |

| Flan-T5 4-Shot Chain-of-Thought In-Context Learning | Nein | 30.17% |

| Feinabgestimmtes Multitasking-Modell | Ja | 73.98% |

Genauer gesagt veranlassen wir das Sprachmodell mit seiner eigenen generierten Antwort- und Argumentationskette (für die wir Feedback gesammelt haben) und fordern es dann erneut auf, den Fehler in der Generierung vorherzusagen. Wir verwenden die entsprechende Anweisung für die Aufgabe („Erkenne Fehler in der Antwort“). Das Modell wird korrekt bewertet, wenn es „kein Fehler“ oder „richtig“ in der Generierung vorhersagt, wenn die Annotatoren das Beispiel als fehlerfrei gekennzeichnet haben, oder wenn es einen der Fehlertypen in der Generierung vorhersagt (zusammen mit „falsch“ oder „ falsch“), wenn die Kommentatoren es als fehlerhaft bezeichneten. Beachten Sie, dass wir nicht die Fähigkeit des Modells auswerten, den Fehlertyp korrekt zu identifizieren, sondern ob ein Fehler vorhanden ist. Die Bewertung erfolgt anhand eines Satzes von 173 zusätzlichen Beispielen aus dem StrategyQA-Entwicklerset, die gesammelt wurden und die während der Feinabstimmung nicht angezeigt werden. Davon sind vier Beispiele für die Eingabeaufforderung des Sprachmodells reserviert (erste Zeile in der vorhergehenden Tabelle).

Beachten Sie, dass wir das 0-Shot-Baseline-Ergebnis nicht zeigen, da das Modell keine nützlichen Antworten generieren kann. Wir beobachten, dass die Verwendung von menschlichem Feedback zur Fehlerkorrektur in Argumentationsketten die Vorhersage des Modells verbessern kann, ob es Fehler macht oder nicht, was das Bewusstsein oder die Kalibrierung der falschen Erklärungen verbessern kann.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie Datensätze mit menschlichem Feedback mit feinkörniger Fehlerkorrektur kuratiert werden können, was eine alternative Möglichkeit darstellt, die logischen Fähigkeiten von LLMs zu verbessern. Experimentelle Ergebnisse bestätigen, dass menschliches Feedback zu Denkfehlern die Leistung und Kalibrierung bei anspruchsvollen Multi-Hop-Fragen verbessern kann.

Wenn Sie nach menschlichem Feedback suchen, um Ihre großen Sprachmodelle zu verbessern, besuchen Sie Amazon SageMaker-Datenkennzeichnung und die Ground Truth Plus-Konsole.

Über die Autoren

Erran Li ist Manager für angewandte Wissenschaft bei humain-in-the-loop services, AWS AI, Amazon. Seine Forschungsinteressen sind 3D Deep Learning und Vision and Language Representation Learning. Zuvor war er Senior Scientist bei Alexa AI, Head of Machine Learning bei Scale AI und Chief Scientist bei Pony.ai. Davor war er im Wahrnehmungsteam von Uber ATG und im Machine-Learning-Plattformteam von Uber und arbeitete an maschinellem Lernen für autonomes Fahren, maschinellen Lernsystemen und strategischen Initiativen der KI. Er begann seine Karriere bei Bell Labs und war außerordentlicher Professor an der Columbia University. Er unterrichtete Tutorials bei ICML'17 und ICCV'19 und organisierte mehrere Workshops bei NeurIPS, ICML, CVPR, ICCV zu maschinellem Lernen für autonomes Fahren, 3D-Vision und Robotik, maschinellen Lernsystemen und kontradiktorischem maschinellem Lernen. Er hat an der Cornell University in Informatik promoviert. Er ist ACM Fellow und IEEE Fellow.

Erran Li ist Manager für angewandte Wissenschaft bei humain-in-the-loop services, AWS AI, Amazon. Seine Forschungsinteressen sind 3D Deep Learning und Vision and Language Representation Learning. Zuvor war er Senior Scientist bei Alexa AI, Head of Machine Learning bei Scale AI und Chief Scientist bei Pony.ai. Davor war er im Wahrnehmungsteam von Uber ATG und im Machine-Learning-Plattformteam von Uber und arbeitete an maschinellem Lernen für autonomes Fahren, maschinellen Lernsystemen und strategischen Initiativen der KI. Er begann seine Karriere bei Bell Labs und war außerordentlicher Professor an der Columbia University. Er unterrichtete Tutorials bei ICML'17 und ICCV'19 und organisierte mehrere Workshops bei NeurIPS, ICML, CVPR, ICCV zu maschinellem Lernen für autonomes Fahren, 3D-Vision und Robotik, maschinellen Lernsystemen und kontradiktorischem maschinellem Lernen. Er hat an der Cornell University in Informatik promoviert. Er ist ACM Fellow und IEEE Fellow.

Nitish Joshi war Praktikantin für angewandte Wissenschaften bei AWS AI, Amazon. Er ist Doktorand in Informatik am Courant Institute of Mathematical Sciences der New York University, beraten von Prof. He He. Er arbeitet an Machine Learning und Natural Language Processing und war Mitglied der Forschungsgruppe Machine Learning for Language (ML2). Er interessierte sich allgemein für robustes Sprachverständnis: sowohl für den Aufbau von Modellen, die gegenüber Verteilungsverschiebungen robust sind (z. B. durch Human-in-the-Loop-Datenerweiterung), als auch für die Entwicklung besserer Methoden zur Bewertung/Messung der Robustheit von Modellen. Er war auch neugierig auf die jüngsten Entwicklungen im kontextbezogenen Lernen und auf das Verständnis, wie es funktioniert.

Nitish Joshi war Praktikantin für angewandte Wissenschaften bei AWS AI, Amazon. Er ist Doktorand in Informatik am Courant Institute of Mathematical Sciences der New York University, beraten von Prof. He He. Er arbeitet an Machine Learning und Natural Language Processing und war Mitglied der Forschungsgruppe Machine Learning for Language (ML2). Er interessierte sich allgemein für robustes Sprachverständnis: sowohl für den Aufbau von Modellen, die gegenüber Verteilungsverschiebungen robust sind (z. B. durch Human-in-the-Loop-Datenerweiterung), als auch für die Entwicklung besserer Methoden zur Bewertung/Messung der Robustheit von Modellen. Er war auch neugierig auf die jüngsten Entwicklungen im kontextbezogenen Lernen und auf das Verständnis, wie es funktioniert.

Kumar Chellapilla ist General Manager und Director bei Amazon Web Services und leitet die Entwicklung von ML/AI-Services wie Human-in-Loop-Systemen, AI DevOps, Geospatial ML und ADAS/Autonomous Vehicle Development. Vor AWS war Kumar Director of Engineering bei Uber ATG und Lyft Level 5 und leitete Teams, die maschinelles Lernen nutzten, um Selbstfahrfähigkeiten wie Wahrnehmung und Kartierung zu entwickeln. Er arbeitete auch an der Anwendung von Techniken des maschinellen Lernens zur Verbesserung von Such-, Empfehlungs- und Werbeprodukten bei LinkedIn, Twitter, Bing und Microsoft Research.

Kumar Chellapilla ist General Manager und Director bei Amazon Web Services und leitet die Entwicklung von ML/AI-Services wie Human-in-Loop-Systemen, AI DevOps, Geospatial ML und ADAS/Autonomous Vehicle Development. Vor AWS war Kumar Director of Engineering bei Uber ATG und Lyft Level 5 und leitete Teams, die maschinelles Lernen nutzten, um Selbstfahrfähigkeiten wie Wahrnehmung und Kartierung zu entwickeln. Er arbeitete auch an der Anwendung von Techniken des maschinellen Lernens zur Verbesserung von Such-, Empfehlungs- und Werbeprodukten bei LinkedIn, Twitter, Bing und Microsoft Research.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :hast

- :Ist

- :nicht

- :Wo

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- Fähigkeiten

- Fähigkeit

- Über Uns

- entsprechend

- ACM

- hinzugefügt

- Hinzufügen

- Zusätzliche

- Adresse

- widersprüchlich

- Marketings

- Verbunden

- Nach der

- aufs Neue

- AI

- Alexa

- Algorithmen

- Alle

- entlang

- ebenfalls

- Alternative

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- unter

- an

- und

- beantworten

- Antworten

- jedem

- angewandt

- Bewerbung

- Anwendung

- Ansatz

- angemessen

- SIND

- AS

- zugewiesen

- At

- Autonom

- verfügbar

- Bewusstsein

- AWS

- Base

- basierend

- Baseline

- BE

- weil

- war

- Bevor

- Bell

- Benchmarks

- Besser

- Bing

- beide

- Box

- allgemein

- Building

- Gebäudemodelle

- aber

- by

- CAN

- Fähigkeiten

- Karriere

- Häuser

- sicher

- Kette

- Ketten

- herausfordernd

- Chef

- klassifizieren

- Menu

- sammeln

- Das Sammeln

- Sammlung

- COLUMBIA

- gemeinsam

- vergleichbar

- vergleichen

- verglichen

- umfassend

- Computer

- Computerwissenschaften

- durchgeführt

- zuversichtlich

- zuversichtlich

- Geht davon

- Berücksichtigung

- Konsul (Console)

- enthält

- Kontext

- verkaufen

- Cornell

- Korrekturen

- bestätigen

- neugierig

- technische Daten

- Datensätze

- tief

- tiefe Lernen

- zeigen

- zeigt

- beschreiben

- beschrieben

- Beschreibung

- Entwerfen

- Trotz

- Detail

- detailliert

- Details

- Entwickler

- entwickeln

- Entwicklung

- Entwicklungen

- anders

- Direkt

- Direktor

- Verteilung

- verschieden

- do

- erledigt

- Nicht

- Fahren

- im

- e

- jeder

- freigegeben

- Entwicklung

- Fehler

- Fehler

- Festlegung

- bewerten

- Bewerten

- Auswertung

- Sogar

- Beispiel

- Beispiele

- Erklärung

- Feedback

- Kerl

- Feld

- Abbildung

- Finale

- Vorname

- gefolgt

- Folgende

- Aussichten für

- unten stehende Formular

- gefunden

- vier

- für

- Sammlung

- Allgemeines

- erzeugen

- erzeugt

- erzeugt

- Erzeugung

- Generation

- Generationen

- Geodaten-ML

- ABSICHT

- gegeben

- Unterstützung

- Boden

- Gruppe an

- Hacking

- Haben

- mit

- he

- ganzer

- Hilfe

- hilft

- hier

- seine

- Ultraschall

- Hilfe

- aber

- HTTPS

- human

- Humans

- identifizieren

- IEEE

- if

- zeigt

- zu unterstützen,

- in

- Einschließlich

- integrieren

- Anfangs-

- Initiativen

- beantragen müssen

- Institut

- interessiert

- Interessen

- Schnittstelle

- in

- untersuchen

- IT

- Iterationen

- SEINE

- jpg

- Labs

- Sprache

- grosse

- größer

- umwandeln

- LERNEN

- gelernt

- lernen

- geführt

- Niveau

- Limitiert

- LLM

- logisch

- suchen

- Lyft

- Maschine

- Maschinelles Lernen

- MACHT

- Manager

- Mapping

- mathematisch

- maximal

- Kann..

- Methoden

- Microsoft

- Kommt demnächst...

- Fehler

- Fehler

- ML

- ml2

- Modell

- für

- Monat

- mehr

- vor allem warme

- motiviert

- mehrere

- nämlich

- Natürliche

- Verarbeitung natürlicher Sprache

- Neu

- New York

- Nlp

- nicht

- Anzahl

- Ziel

- beobachten

- Hindernis

- erhalten

- erhalten

- aufgetreten

- of

- on

- EINEM

- laufend

- einzige

- Ausbruch

- or

- Original

- Andernfalls

- UNSERE

- übrig

- Überblick

- besitzen

- Prozentsatz

- Wahrnehmung

- Ausführen

- Leistung

- führt

- Zeit

- periodisch

- wählen

- Pilot

- Ort

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- erfahren

- Posen

- möglich

- Post

- Potenzial

- Praxis

- vorhersagen

- Prognose

- sagt voraus,

- Danach

- Gegenwart

- vorgeführt

- vorherrschend

- früher

- vorher

- Vor

- Verarbeitung

- Produkte

- Professor

- Fortschritt

- Anteil

- bietet

- vorgeschlage

- Protokoll

- die

- vorausgesetzt

- bietet

- Qualität

- Frage

- Fragen

- zufällig

- lieber

- kürzlich

- Empfehlungen

- verfeinern

- verhältnismäßig

- relevant

- entfernen

- Darstellung

- erfordern

- falls angefordert

- Forschungsprojekte

- reserviert

- beziehungsweise

- REST

- Folge

- Die Ergebnisse

- Belohnen

- Reiches

- Robotik

- robust

- Robustheit

- Runde

- REIHE

- sagemaker

- gleich

- Skalieren

- Skala ai

- Waage

- Wissenschaft

- WISSENSCHAFTEN

- Wissenschaftler

- Suche

- Zweite

- Abschnitt

- gesehen

- SELF

- selbstfahrend

- Senior

- Satz

- getrennte

- Lösungen

- kompensieren

- mehrere

- Schichten

- Short

- erklären

- gezeigt

- Konzerte

- signifikant

- bedeutend

- ähnlich

- Einfacher

- klein

- kleinere

- einige

- spezifisch

- speziell

- gespalten

- Sports

- begonnen

- Schritt

- Shritte

- Strategisch

- Schüler und Studenten

- Erfolg

- so

- Systeme und Techniken

- Tabelle

- Aufgabe

- und Aufgaben

- Team

- Teams

- Techniken

- Test

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- dann

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- Durch

- zu

- Gesamt

- trainiert

- Ausbildung

- behandeln

- Bearbeitung

- enorm

- Vertrauen

- Wahrheit

- Tutorials

- XNUMX

- tippe

- Typen

- Uber

- Verständnis

- Universität

- -

- benutzt

- Nutzer

- Verwendung von

- gewöhnlich

- Variante

- verschiedene

- Fahrzeug

- Anzeigen

- Seh-

- Besuchen Sie

- Abstimmung

- wurde

- Weg..

- Wege

- we

- Netz

- Web-Services

- Gewicht

- waren

- wann

- ob

- welche

- warum

- werden wir

- mit

- Arbeiten

- gearbeitet

- arbeiten,

- Werk

- Workshops

- wert

- Falsch

- York

- Ihr

- Zephyrnet