Sehverlust kommt in verschiedenen Formen vor. Für einige ist es von Geburt an, für andere ist es ein langsamer Rückgang im Laufe der Zeit, der mit vielen Verfallsdaten einhergeht: Der Tag, an dem Sie keine Bilder sehen, sich selbst oder die Gesichter geliebter Menschen nicht mehr erkennen oder sogar Ihre E-Mails lesen können. In unserem vorherigen Blogpost Ermöglichen Sie Sehbehinderten das Hören von Dokumenten mit Amazon Textract und Amazon Polly, wir haben Ihnen unsere Text-to-Speech-Anwendung namens gezeigt „Lesen Sie für mich“. Die Barrierefreiheit hat große Fortschritte gemacht, aber was ist mit Bildern?

Auf der AWS re:Invent-Konferenz 2022 in Las Vegas haben wir demonstriert „Beschreibe für mich“ auf der AWS Builders' Fair, einer Website, die Sehbehinderten hilft, Bilder durch Bildunterschriften, Gesichtserkennung und Text-to-Speech zu verstehen, eine Technologie, die wir als „Image to Speech“ bezeichnen. Durch den Einsatz mehrerer KI/ML-Dienste generiert „Describe For Me“ eine Bildunterschrift für ein Eingabebild und liest diese mit klarer, natürlich klingender Stimme in verschiedenen Sprachen und Dialekten vor.

In diesem Blogbeitrag führen wir Sie durch die Lösungsarchitektur hinter „Describe For Me“ und die Designüberlegungen unserer Lösung.

Die Lösung im Überblick

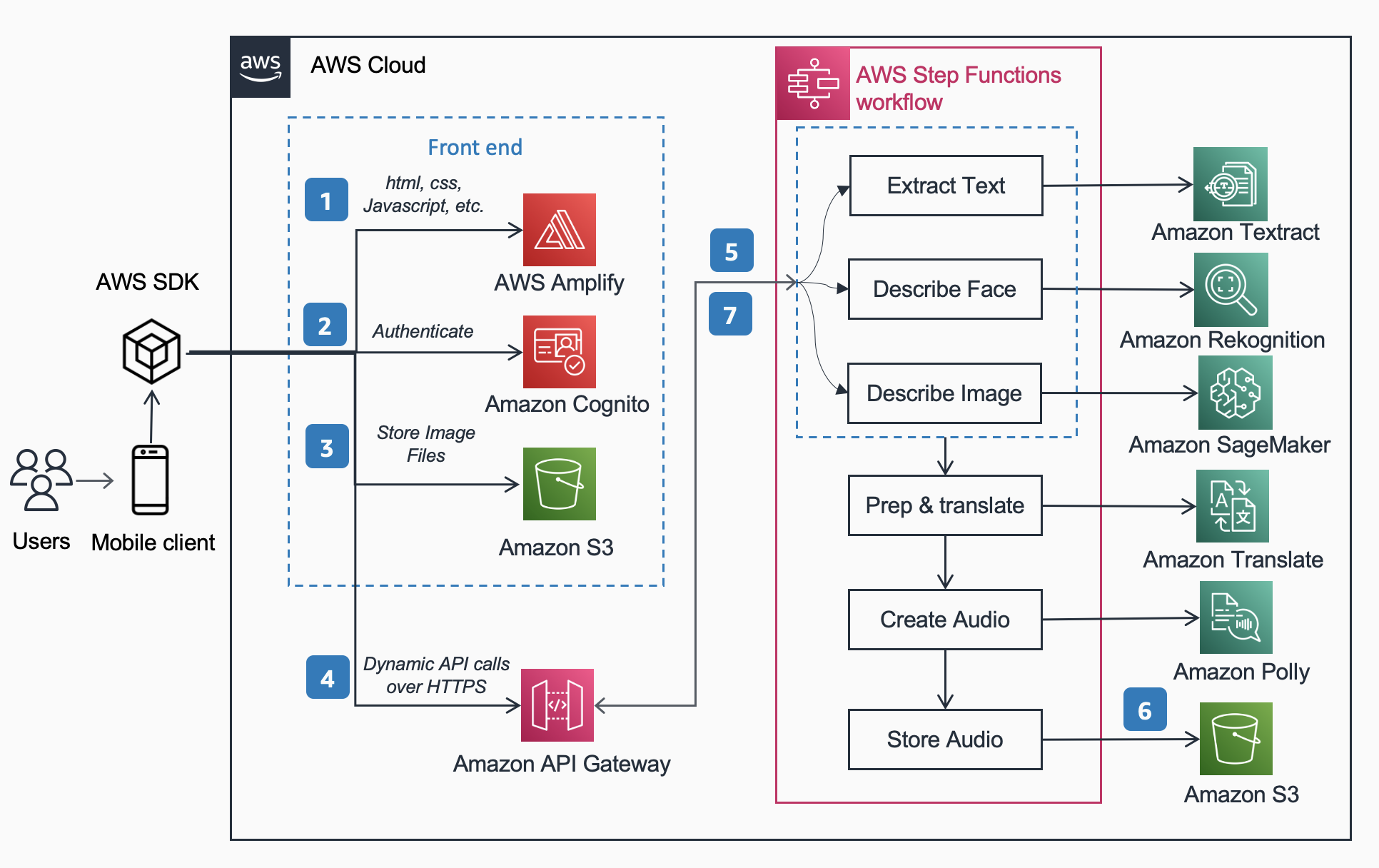

Die folgende Referenzarchitektur zeigt den Arbeitsablauf eines Benutzers, der mit einem Telefon ein Bild aufnimmt und eine MP3-Datei mit Bildunterschriften abspielt.

Der Workflow umfasst die folgenden Schritte:

- AWS verstärken verteilt die DescribeForMe-Web-App, bestehend aus HTML, JavaScript und CSS, an die mobilen Geräte der Endbenutzer.

- Das Amazon Cognito Der Identitätspool gewährt temporären Zugriff auf Amazon S3 Eimer.

- Der Benutzer lädt eine Bilddatei hoch Amazon S3 Eimer verwenden AWS-SDK über die Web-App.

- Die DescribeForMe-Webanwendung ruft die Back-End-KI-Dienste auf, indem sie die sendet Amazon S3 Objekt Geben Sie die Nutzlast ein Amazon API-Gateway

- Amazon API-Gateway instanziiert an AWS Step-Funktionen Arbeitsablauf. Die State Machine orchestriert die Dienste für künstliche Intelligenz/maschinelles Lernen (KI/ML). Amazon-Anerkennung, Amazon Sage Maker, Amazontext, Amazon Translate, und Amazonas Polly Verwendung von AWS-Lambda Funktionen.

- Das AWS Step-Funktionen Der Workflow erstellt eine Audiodatei als Ausgabe und speichert sie in Amazon S3 im MP3-Format.

- Eine vorsignierte URL mit dem Speicherort der Audiodatei Amazon S3 wird über an den Browser des Benutzers zurückgesendet Amazon API-Gateway. Das Mobilgerät des Benutzers spielt die Audiodatei unter Verwendung der vorsignierten URL ab.

Lösungsdurchgang

In diesem Abschnitt konzentrieren wir uns auf die Designüberlegungen, die unsere Wahl begründet haben

- Parallelverarbeitung innerhalb eines AWS Step-Funktionen Arbeitsablauf.

- Einheitliches Sequenz-zu-Sequenz-vorab trainiertes maschinelles Lernmodell OFA (One For All) von Gesicht umarmen zu Amazon Sage Maker für Bildunterschrift

- Amazon-Anerkennung zur Gesichtserkennung

Für einen detaillierteren Überblick darüber, warum wir uns für eine Serverless-Architektur, einen synchronen Workflow, einen Express-Step-Functions-Workflow und eine Headless-Architektur entschieden haben und welche Vorteile sich daraus ergeben, lesen Sie bitte unseren vorherigen Blogbeitrag Ermöglichen Sie Sehbehinderten das Hören von Dokumenten mit Amazon Textract und Amazon Polly.

Parallelverarbeitung

Durch die parallele Verarbeitung innerhalb des Step Functions-Workflows konnte die Rechenzeit um bis zu 48 % reduziert werden. Sobald der Benutzer das Bild in den S3-Bucket hochlädt, instanziiert Amazon API Gateway einen AWS Step Functions-Workflow. Anschließend verarbeiten die folgenden drei Lambda-Funktionen das Bild im Step Functions-Workflow parallel.

- Die erste aufgerufene Lambda-Funktion

describe_imageanalysiert das Bild mit dem OFA_IMAGE_CAPTION-Modell gehostet auf einem SageMaker-Echtzeit-Endpunkt, um Bildunterschriften bereitzustellen. - Die zweite aufgerufene Lambda-Funktion

describe_facesPrüft zunächst mithilfe von Amazon Rekognition, ob Gesichter vorhanden sind API zum Erkennen von Gesichtern, und wenn „true“, ruft es die Compare Faces API auf. Der Grund dafür ist, dass „Compare Faces“ einen Fehler auslöst, wenn im Bild keine Gesichter gefunden werden. Außerdem ist es schneller, zuerst „Gesichter erkennen“ aufzurufen, als einfach „Gesichter vergleichen“ auszuführen und Fehler zu behandeln, sodass die Verarbeitungszeit bei Bildern ohne Gesichter kürzer ist. - Die dritte aufgerufene Lambda-Funktion

extract_textverarbeitet Text-to-Speech mithilfe von Amazon Textract und Amazon Comprehend.

Es bietet sich an, die Lambda-Funktionen nacheinander auszuführen, der schnellere und effizientere Weg hierfür ist jedoch die Parallelverarbeitung. Die folgende Tabelle zeigt die eingesparte Rechenzeit für drei Beispielbilder.

| Bild | Personen | Sequentielle Zeit | Parallele Zeit | Zeitersparnis (%) | Bildunterschrift |

|

0 | 1869ms | 1702ms | 8% | Eine getigerte Katze rollte sich in einem flauschigen weißen Bett zusammen. |

|

1 | 4277ms | 2197ms | 48% | Eine Frau in grüner Bluse und schwarzer Strickjacke lächelt in die Kamera. Ich erkenne eine Person: Kanbo. |

|

4 | 6603ms | 3904ms | 40% | Menschen stehen vor den Amazonas-Kugeln. Ich erkenne drei Personen: Kanbo, Jack und Ayman. |

Bildunterschrift

Hugging Face ist eine Open-Source-Community und Datenwissenschaftsplattform, die es Benutzern ermöglicht, Modelle für maschinelles Lernen zu teilen, zu erstellen, zu trainieren und bereitzustellen. Nachdem wir die im Hugging Face-Modellhub verfügbaren Modelle untersucht hatten, entschieden wir uns für die Verwendung von OFA-Modell denn wie von den Autoren beschrieben, handelt es sich um „ein aufgaben- und modalitätsunabhängiges Framework, das die Aufgabenumfassendheit unterstützt“.

OFA ist ein Schritt in Richtung „One For All“, da es sich um ein einheitliches multimodales vorab trainiertes Modell handelt, das effektiv auf eine Reihe nachgelagerter Aufgaben übertragen werden kann. Während das OFA-Modell viele Aufgaben unterstützt, einschließlich visueller Erdung, Sprachverständnis und Bilderzeugung, haben wir das verwendet OFA-Modell für Bildunterschriften im Describe For Me-Projekt, um den Bild-zu-Text-Teil der Anwendung auszuführen. Schauen Sie sich das offizielle Repository von OFA (ICML 2022) an. Krepppapier um mehr über die vereinheitlichenden Architekturen, Aufgaben und Modalitäten von OFA durch ein einfaches Sequence-to-Sequence-Lern-Framework zu erfahren.

Um OFA in unsere Anwendung zu integrieren, haben wir das Repo von Hugging Face geklont und das Modell in einen Container verpackt, um es auf einem SageMaker-Endpunkt bereitzustellen. Der Notizbuch in diesem Repo ist eine hervorragende Anleitung zum Bereitstellen des großen OFA-Modells in einem Jupyter-Notebook in SageMaker. Nach der Containerisierung Ihres Inferenzskripts kann das Modell wie im SageMaker beschrieben hinter einem SageMaker-Endpunkt bereitgestellt werden Dokumentation. Sobald das Modell bereitgestellt ist, erstellen Sie einen HTTPS-Endpunkt, der in die Lambda-Funktion „describe_image“ integriert werden kann, die das Bild analysiert, um die Bildunterschrift zu erstellen. Wir haben das OFA-Minimodell eingesetzt, weil es ein kleineres Modell ist und bei ähnlicher Leistung in kürzerer Zeit bereitgestellt werden kann.

Beispiele für Bild-zu-Sprache-Inhalte, die von „Describe For Me“ generiert wurden, sind unten aufgeführt:

Die Aurora Borealis oder Nordlichter füllen den Nachthimmel über der Silhouette eines Hauses.

Ein Hund schläft auf einer roten Decke auf einem Hartholzboden, neben einem offenen Koffer voller Spielzeug.

Eine getigerte Katze rollte sich in einem flauschigen weißen Bett zusammen.

Gesichtserkennung

Amazon Rekognition Image bietet die Gesichter erkennen Operation, die nach wichtigen Gesichtsmerkmalen wie Augen, Nase und Mund sucht, um Gesichter in einem Eingabebild zu erkennen. In unserer Lösung nutzen wir diese Funktionalität, um alle Personen im Eingabebild zu erkennen. Wenn eine Person erkannt wird, verwenden wir dann die Gesichter vergleichen Operation zum Vergleichen des Gesichts im Eingabebild mit den Gesichtern, mit denen „Describe For Me“ trainiert wurde, und zum Beschreiben der Person mit Namen. Wir haben uns aufgrund der hohen Genauigkeit und der einfachen Integration in unsere Anwendung mit den sofort einsatzbereiten Funktionen für Rekognition zur Gesichtserkennung entschieden.

Eine Gruppe von Menschen posiert in einem Raum für ein Foto. Ich erkenne 4 Personen: Jack, Kanbo, Alak und Trac. Im Bild wurde auch Text gefunden. Es lautet: AWS re: Invent

Mögliche Anwendungsfälle

Alternative Textgenerierung für Webbilder

Alle Bilder auf einer Website müssen einen alternativen Text haben, damit Screenreader sie für Sehbehinderte vorlesen können. Es eignet sich auch gut für die Suchmaschinenoptimierung (SEO). Das Erstellen von alternativen Bildunterschriften kann zeitaufwändig sein, da ein Texter die Aufgabe hat, diese in einem Designdokument bereitzustellen. Die Describe For Me API könnte automatisch Alternativtext für Bilder generieren. Es könnte auch als Browser-Plugin verwendet werden, um auf jeder Website automatisch Bildunterschriften zu Bildern hinzuzufügen, denen Alt-Text fehlt.

Audiobeschreibung für Video

Audiodeskription bietet eine Erzählspur für Videoinhalte, um Sehbehinderten das Mitverfolgen von Filmen zu erleichtern. Da Bildunterschriften robuster und genauer werden, könnte ein Arbeitsablauf möglich sein, der die Erstellung einer Audiospur auf der Grundlage von Beschreibungen für wichtige Teile einer Szene beinhaltet. Amazon Rekognition kann bereits Szenenwechsel, Logos und Abspannsequenzen sowie die Erkennung von Prominenten erkennen. Eine zukünftige Version von „describe“ würde die Automatisierung dieser Schlüsselfunktion für Filme und Videos ermöglichen.

Zusammenfassung

In diesem Beitrag haben wir besprochen, wie man AWS-Dienste, einschließlich KI und serverlose Dienste, nutzen kann, um Sehbehinderten das Sehen von Bildern zu erleichtern. Sie können mehr über das Describe For Me-Projekt erfahren und es nutzen, indem Sie hier klicken beschreibenforme.com. Erfahren Sie mehr über die einzigartigen Funktionen von Amazon Sage Maker, Amazon-Anerkennung und für AWS-Partnerschaft mit Hugging Face.

Haftungsausschluss für Drittanbieter-ML-Modelle als Orientierungshilfe

Diese Anleitung dient nur zu Informationszwecken. Sie sollten dennoch Ihre eigene unabhängige Bewertung durchführen und Maßnahmen ergreifen, um sicherzustellen, dass Sie Ihre eigenen spezifischen Qualitätskontrollpraktiken und -standards sowie die lokalen Regeln, Gesetze, Vorschriften, Lizenzen und Nutzungsbedingungen einhalten, die für Sie, Ihre Inhalte usw. gelten das in dieser Anleitung genannte maschinelle Lernmodell eines Drittanbieters. AWS hat keine Kontrolle oder Autorität über das in dieser Anleitung erwähnte Modell für maschinelles Lernen von Drittanbietern und gibt keine Zusicherungen oder Gewährleistungen dafür, dass das Modell für maschinelles Lernen von Drittanbietern sicher, virenfrei, betriebsbereit oder mit Ihrer Produktionsumgebung kompatibel ist und Standards. AWS gibt keine Zusicherungen, Gewährleistungen oder Garantien dafür, dass die Informationen in dieser Anleitung zu einem bestimmten Ergebnis oder Ergebnis führen werden.

Über die Autoren

Jack Marchetti ist Senior Solutions Architect bei AWS und konzentriert sich darauf, Kunden bei der Modernisierung und Implementierung serverloser, ereignisgesteuerter Architekturen zu unterstützen. Jack ist offiziell blind und lebt mit seiner Frau Erin und seiner Katze Minou in Chicago. Er ist außerdem Drehbuchautor und Regisseur mit einem Schwerpunkt auf Weihnachtsfilmen und Horrorfilmen. Sehen Sie sich Jacks Filmografie bei ihm an IMDb-Seite.

Jack Marchetti ist Senior Solutions Architect bei AWS und konzentriert sich darauf, Kunden bei der Modernisierung und Implementierung serverloser, ereignisgesteuerter Architekturen zu unterstützen. Jack ist offiziell blind und lebt mit seiner Frau Erin und seiner Katze Minou in Chicago. Er ist außerdem Drehbuchautor und Regisseur mit einem Schwerpunkt auf Weihnachtsfilmen und Horrorfilmen. Sehen Sie sich Jacks Filmografie bei ihm an IMDb-Seite.

Alak Eswaradass ist Senior Solutions Architect bei AWS mit Sitz in Chicago, Illinois. Ihre Leidenschaft besteht darin, Kunden beim Entwerfen von Cloud-Architekturen mithilfe von AWS-Services zu unterstützen, um geschäftliche Herausforderungen zu lösen. Alak ist begeistert davon, SageMaker zur Lösung verschiedener ML-Anwendungsfälle für AWS-Kunden einzusetzen. Wenn sie nicht arbeitet, verbringt Alak gerne Zeit mit ihren Töchtern und erkundet mit ihren Hunden die Natur.

Alak Eswaradass ist Senior Solutions Architect bei AWS mit Sitz in Chicago, Illinois. Ihre Leidenschaft besteht darin, Kunden beim Entwerfen von Cloud-Architekturen mithilfe von AWS-Services zu unterstützen, um geschäftliche Herausforderungen zu lösen. Alak ist begeistert davon, SageMaker zur Lösung verschiedener ML-Anwendungsfälle für AWS-Kunden einzusetzen. Wenn sie nicht arbeitet, verbringt Alak gerne Zeit mit ihren Töchtern und erkundet mit ihren Hunden die Natur.

Kandyce Bohannon ist ein Senior Solutions Architect mit Sitz in Minneapolis, MN. In dieser Rolle arbeitet Kandyce als technischer Berater für AWS-Kunden bei der Modernisierung von Technologiestrategien, insbesondere im Zusammenhang mit Daten und DevOps, um Best Practices in AWS zu implementieren. Darüber hinaus engagiert sich Kandyce leidenschaftlich dafür, zukünftige Generationen von Technologen zu betreuen und Frauen im Technologiebereich durch das AWS She Builds Tech Skills-Programm zu präsentieren.

Kandyce Bohannon ist ein Senior Solutions Architect mit Sitz in Minneapolis, MN. In dieser Rolle arbeitet Kandyce als technischer Berater für AWS-Kunden bei der Modernisierung von Technologiestrategien, insbesondere im Zusammenhang mit Daten und DevOps, um Best Practices in AWS zu implementieren. Darüber hinaus engagiert sich Kandyce leidenschaftlich dafür, zukünftige Generationen von Technologen zu betreuen und Frauen im Technologiebereich durch das AWS She Builds Tech Skills-Programm zu präsentieren.

Trac Do ist Lösungsarchitekt bei AWS. In seiner Rolle arbeitet Trac mit Unternehmenskunden zusammen, um deren Cloud-Migrationen und Initiativen zur Anwendungsmodernisierung zu unterstützen. Seine Leidenschaft besteht darin, die Herausforderungen der Kunden kennenzulernen und sie mithilfe von AWS-Services mit robusten und skalierbaren Lösungen zu lösen. Trac lebt derzeit mit seiner Frau und seinen drei Söhnen in Chicago. Er ist ein großer Luftfahrtenthusiast und ist dabei, seine Privatpilotenlizenz zu erwerben.

Trac Do ist Lösungsarchitekt bei AWS. In seiner Rolle arbeitet Trac mit Unternehmenskunden zusammen, um deren Cloud-Migrationen und Initiativen zur Anwendungsmodernisierung zu unterstützen. Seine Leidenschaft besteht darin, die Herausforderungen der Kunden kennenzulernen und sie mithilfe von AWS-Services mit robusten und skalierbaren Lösungen zu lösen. Trac lebt derzeit mit seiner Frau und seinen drei Söhnen in Chicago. Er ist ein großer Luftfahrtenthusiast und ist dabei, seine Privatpilotenlizenz zu erwerben.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Kaufen und verkaufen Sie Anteile an PRE-IPO-Unternehmen mit PREIPO®. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/introducing-an-image-to-speech-generative-ai-application-using-amazon-sagemaker-and-hugging-face/

- :hast

- :Ist

- :nicht

- $UP

- 100

- 2022

- 7

- a

- Über Uns

- oben

- Zugang

- Genauigkeit

- genau

- Erreichen

- hinzufügen

- zusätzlich

- Berater

- Nach der

- AI

- KI-Dienste

- AI / ML

- Hilfe

- Alle

- erlauben

- erlaubt

- entlang

- bereits

- ebenfalls

- Alternative

- Amazon

- Amazon API-Gateway

- Amazon verstehen

- Amazon-Anerkennung

- Amazon Sage Maker

- Amazontext

- Amazon Web Services

- an

- Analysen

- und

- jedem

- Bienen

- App

- Anwendung

- Bewerbung

- Architektur

- SIND

- künstlich

- künstliche Intelligenz

- AS

- Bewertung

- At

- Audio-

- Aurora

- Autorität

- Autoren

- Im Prinzip so, wie Sie es von Google Maps kennen.

- automatisieren

- verfügbar

- Luftfahrt

- AWS

- AWS Step-Funktionen

- Zurück

- Backend

- basierend

- BE

- weil

- wird

- war

- hinter

- unten

- Vorteile

- BESTE

- Best Practices

- Big

- Schwarz

- Blog

- Box

- Browser

- bauen

- baut

- Geschäft

- aber

- by

- namens

- Aufruf

- Aufrufe

- Kamera

- CAN

- Fähigkeiten

- Bildunterschriften

- Fälle

- CAT

- Berühmtheit

- Herausforderungen

- Änderungen

- aus der Ferne überprüfen

- Schecks

- Chicago

- wählten

- Weihnachten

- klar

- Cloud

- wie die

- kommt

- community

- vergleichen

- kompatibel

- Abschluss

- begreifen

- Berechnen

- Konferenz

- Überlegungen

- Bestehend

- Inhalt

- Smartgeräte App

- Steuerung

- könnte

- erstellen

- schafft

- Erstellen

- Schaffung

- Kredit

- CSS

- Zur Zeit

- Kunden

- technische Daten

- Datenwissenschaft

- Datum

- Tag

- Synergie

- einsetzen

- Einsatz

- beschreiben

- beschrieben

- Beschreibung

- Design

- detailliert

- erkannt

- Entdeckung

- Gerät

- Geräte

- Direktor

- diskutiert

- do

- Dokument

- Unterlagen

- die

- Hund

- Dabei

- effektiv

- effizient

- Ende

- Endpunkt

- Motor

- gewährleisten

- Unternehmen

- Enthusiast

- begeistert

- Arbeitsumfeld

- Fehler

- Fehler

- insbesondere

- Sogar

- Ausgezeichnet

- Ablauf

- Möglichkeiten sondieren

- express

- Augenfarbe

- Gesicht

- Gesichter

- Gesichts-

- Gesichtserkennung

- Messe

- beschleunigt

- Merkmal

- Eigenschaften

- Reichen Sie das

- füllen

- gefüllt

- Vorname

- Boden

- Setzen Sie mit Achtsamkeit

- konzentriert

- folgen

- Folgende

- Aussichten für

- Format

- Formen

- gefunden

- Unser Ansatz

- für

- Materials des

- Funktion

- Funktionalität

- Funktionen

- Zukunft

- Tor

- erzeugen

- erzeugt

- erzeugt

- Generation

- Generationen

- generativ

- Generative KI

- gut

- für Balkonkraftwerke Reduzierung

- Grün

- Gruppe an

- Garantien

- die Vermittlung von Kompetenzen,

- Guide

- Griffe

- Handling

- Haben

- he

- hören

- Hilfe

- Unternehmen

- hilft

- hier (auf dänisch)

- GUTE

- seine

- Horror

- gehostet

- Häuser

- Ultraschall

- Hilfe

- HTML

- HTTPS

- Nabe

- i

- if

- Illinois

- Image

- Bilder

- implementieren

- in

- Dazu gehören

- Einschließlich

- unabhängig

- Information

- Informational

- Initiativen

- Varianten des Eingangssignals:

- integrieren

- integriert

- Intelligenz

- in

- Einführung

- ruft auf

- Beteiligung

- IT

- Jack

- JavaScript

- jpg

- Wesentliche

- Sprache

- Sprachen

- grosse

- LAS

- Las Vegas

- Gesetze

- LERNEN

- lernen

- Hebelwirkung

- Lizenz

- Lizenzen

- Leben

- aus einer regionalen

- Standorte

- Lang

- SIEHT AUS

- Verlust

- geliebt wird

- Maschine

- Maschinelles Lernen

- um

- viele

- Maßnahmen

- Mentoring

- Kommt demnächst...

- ML

- Mobil

- Mobilgerät

- mobile Geräte

- Modell

- für

- modernisieren

- mehr

- effizienter

- Mund

- Filme

- mehrere

- Name

- weiter

- Nacht-

- nicht

- Nase

- Notizbuch

- Anzahl

- of

- offiziell

- on

- einmal

- EINEM

- Einsen

- einzige

- XNUMXh geöffnet

- Open-Source-

- Betrieb

- Betriebs-

- Optimierung

- or

- Anders

- UNSERE

- Ergebnis

- im Freien

- Möglichkeiten für das Ausgangssignal:

- übrig

- Überblick

- besitzen

- Parallel

- besondere

- Partnerschaft

- Teile

- Party

- leidenschaftlich

- Personen

- Ausführen

- Leistung

- Zeit

- person

- Telefon

- ein Bild

- Fotos

- Pilot

- Plattform

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- spielt

- Bitte

- Plugin

- Pool

- Teil

- möglich

- Post

- Praktiken

- früher

- primär

- privat

- Prozessdefinierung

- Verarbeitung

- Produktion

- Programm

- Projekt

- die

- bietet

- Bereitstellung

- Zwecke

- Qualität

- RE

- Lesen Sie mehr

- Leser

- bereit

- Echtzeit

- Grund

- Anerkennung

- erkennen

- Rot

- Reduziert

- Vorschriften

- bezogene

- Quelle

- falls angefordert

- Folge

- robust

- Rollen

- Zimmer

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Laufen

- sagemaker

- Ersparnisse

- skalierbaren

- Szene

- Wissenschaft

- Bildschirm

- Bildschirmlesegeräte

- Sdk

- Suche

- Suchmaschine

- Zweite

- Abschnitt

- Verbindung

- sehen

- Sendung

- Senior

- geschickt

- seo

- Serverlos

- Lösungen

- Teilen

- sie

- sollte

- präsentiert

- zeigte

- gezeigt

- Konzerte

- ähnlich

- Einfacher

- einfach

- am Standort

- Fähigkeiten

- Sky

- langsam

- kleinere

- So

- Lösung

- Lösungen

- LÖSEN

- Auflösung

- einige

- sprechen

- spezifisch

- Rede

- Ausgabe

- Normen

- Bundesstaat

- Schritt

- Shritte

- Immer noch

- gelagert

- Läden

- Strategien

- so

- geeignet

- Support

- Unterstützt

- Tabby

- Tabelle

- Nehmen

- Einnahme

- Aufgabe

- und Aufgaben

- Tech

- Technische

- Technologen

- Technologie

- vorübergehend

- AGB

- Text-to-Speech

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Der Staat

- ihr

- Sie

- dann

- Dort.

- vom Nutzer definierten

- Dritte

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- nach drei

- Durch

- Zeit

- zu

- gegenüber

- verfolgen sind

- Training

- trainiert

- privaten Transfer

- was immer dies auch sein sollte.

- verstehen

- Verständnis

- einheitlich

- einzigartiges

- auf

- URL

- -

- benutzt

- Mitglied

- Nutzer

- Verwendung von

- seit

- Verwendung

- Vielfalt

- verschiedene

- VEGAS

- Version

- Video

- Videos

- Anzeigen

- Stimme

- wurde

- Weg..

- we

- Netz

- Web-Services

- Webseite

- GUT

- Was

- wann

- welche

- während

- Weiß

- warum

- Frau

- werden wir

- mit

- .

- ohne

- Frau

- Damen

- Frauen in der Technik

- arbeiten,

- Werk

- würde

- Du

- Ihr

- sich selbst

- Zephyrnet