Amazon Sage Maker erleichtert die Bereitstellung von Modellen für maschinelles Lernen (ML) für Echtzeitinferenzen und bietet eine breite Auswahl an ML-Instanzen, die CPUs und Beschleuniger umfassen, z AWS-Inferenz. Als vollständig verwalteter Service können Sie Ihre Modellbereitstellungen skalieren, Inferenzkosten minimieren und Ihre Modelle in der Produktion effektiver verwalten, bei geringerem Betriebsaufwand. Ein SageMaker-Echtzeit-Inferenzendpunkt besteht aus einem HTTPS-Endpunkt und ML-Instanzen, die für hohe Verfügbarkeit über mehrere Availability Zones hinweg bereitgestellt werden. SageMaker Automatische Skalierung der Anwendung kann die Anzahl der für ein Modell bereitgestellten ML-Instanzen als Reaktion auf Änderungen in der Arbeitslast dynamisch anpassen. Der Endpunkt verteilt eingehende Anfragen mithilfe eines Round-Robin-Algorithmus gleichmäßig an ML-Instanzen.

Wenn auf Instanzen bereitgestellte ML-Modelle API-Aufrufe von einer großen Anzahl von Clients empfangen, kann eine zufällige Verteilung von Anforderungen sehr gut funktionieren, wenn Ihre Anforderungen und Antworten nicht sehr unterschiedlich sind. Aber in Systemen mit generativen KI-Workloads können Anfragen und Antworten äußerst unterschiedlich sein. In diesen Fällen ist es oft wünschenswert, den Lastausgleich unter Berücksichtigung der Kapazität und Auslastung der Instanz statt eines zufälligen Lastausgleichs vorzunehmen.

In diesem Beitrag besprechen wir die SageMaker-Least-Outstanding-Requests-(LOR)-Routing-Strategie und wie sie die Latenz für bestimmte Arten von Echtzeit-Inferenz-Workloads minimieren kann, indem sie die Kapazität und Auslastung von ML-Instanzen berücksichtigt. Wir sprechen über die Vorteile gegenüber dem Standard-Routing-Mechanismus und darüber, wie Sie LOR für Ihre Modellbereitstellungen aktivieren können. Abschließend präsentieren wir eine vergleichende Analyse der Latenzverbesserungen mit LOR gegenüber der Standard-Routing-Strategie des zufälligen Routings.

SageMaker LOR-Strategie

Standardmäßig verfügen SageMaker-Endpunkte über eine zufällige Routing-Strategie. SageMaker unterstützt jetzt eine LOR-Strategie, die es SageMaker ermöglicht, Anfragen optimal an die Instanz weiterzuleiten, die für die Bearbeitung dieser Anfrage am besten geeignet ist. SageMaker macht dies möglich, indem es die Auslastung der Instanzen hinter Ihrem Endpunkt und die Modelle oder Inferenzkomponenten überwacht, die auf jeder Instanz bereitgestellt werden.

Das folgende interaktive Diagramm zeigt die Standard-Routing-Richtlinie, bei der an die Modellendpunkte eingehende Anforderungen nach dem Zufallsprinzip an die ML-Instanzen weitergeleitet werden.

Das folgende interaktive Diagramm zeigt die Routing-Strategie, bei der SageMaker die Anfrage an die Instanz weiterleitet, die die geringste Anzahl ausstehender Anfragen hat.

Im Allgemeinen funktioniert das LOR-Routing gut für Basismodelle oder generative KI-Modelle, wenn Ihr Modell innerhalb von Hunderten von Millisekunden bis Minuten reagiert. Wenn Ihre Modellantwort eine geringere Latenz aufweist (bis zu Hunderten von Millisekunden), profitieren Sie möglicherweise stärker von der zufälligen Weiterleitung. Unabhängig davon empfehlen wir Ihnen, den besten Routing-Algorithmus für Ihre Workloads zu testen und zu ermitteln.

So legen Sie SageMaker-Routing-Strategien fest

Mit SageMaker können Sie jetzt festlegen RoutingStrategy Parameter beim Erstellen des EndpointConfiguration für Endpunkte. Der Unterschied RoutingStrategy Von SageMaker unterstützte Werte sind:

LEAST_OUTSTANDING_REQUESTSRANDOM

Das Folgende ist eine Beispielbereitstellung eines Modells auf einem Inferenzendpunkt, für den LOR aktiviert ist:

- Erstellen Sie die Endpunktkonfiguration durch Einstellung

RoutingStrategyasLEAST_OUTSTANDING_REQUESTS: - Erstellen Sie den Endpunkt mithilfe der Endpunktkonfiguration (keine Änderung):

Leistungsergebnisse

Wir haben ein Leistungsbenchmarking durchgeführt, um die End-to-End-Inferenzlatenz und den Durchsatz des zu messen Codegen2-7B Modell, das auf ml.g5.24xl-Instanzen mit Standard-Routing und Smart-Routing-Endpunkten gehostet wird. Das CodeGen2-Modell gehört zur Familie der autoregressiven Sprachmodelle und generiert ausführbaren Code, wenn englische Eingabeaufforderungen gegeben werden.

In unserer Analyse haben wir die Anzahl der ml.g5.24xl-Instanzen hinter jedem Endpunkt für jeden Testlauf erhöht, da die Anzahl der gleichzeitigen Benutzer zunahm, wie in der folgenden Tabelle dargestellt.

| Test | Anzahl gleichzeitiger Benutzer | Anzahl der Instanzen |

| 1 | 4 | 1 |

| 2 | 20 | 5 |

| 3 | 40 | 10 |

| 4 | 60 | 15 |

| 5 | 80 | 20 |

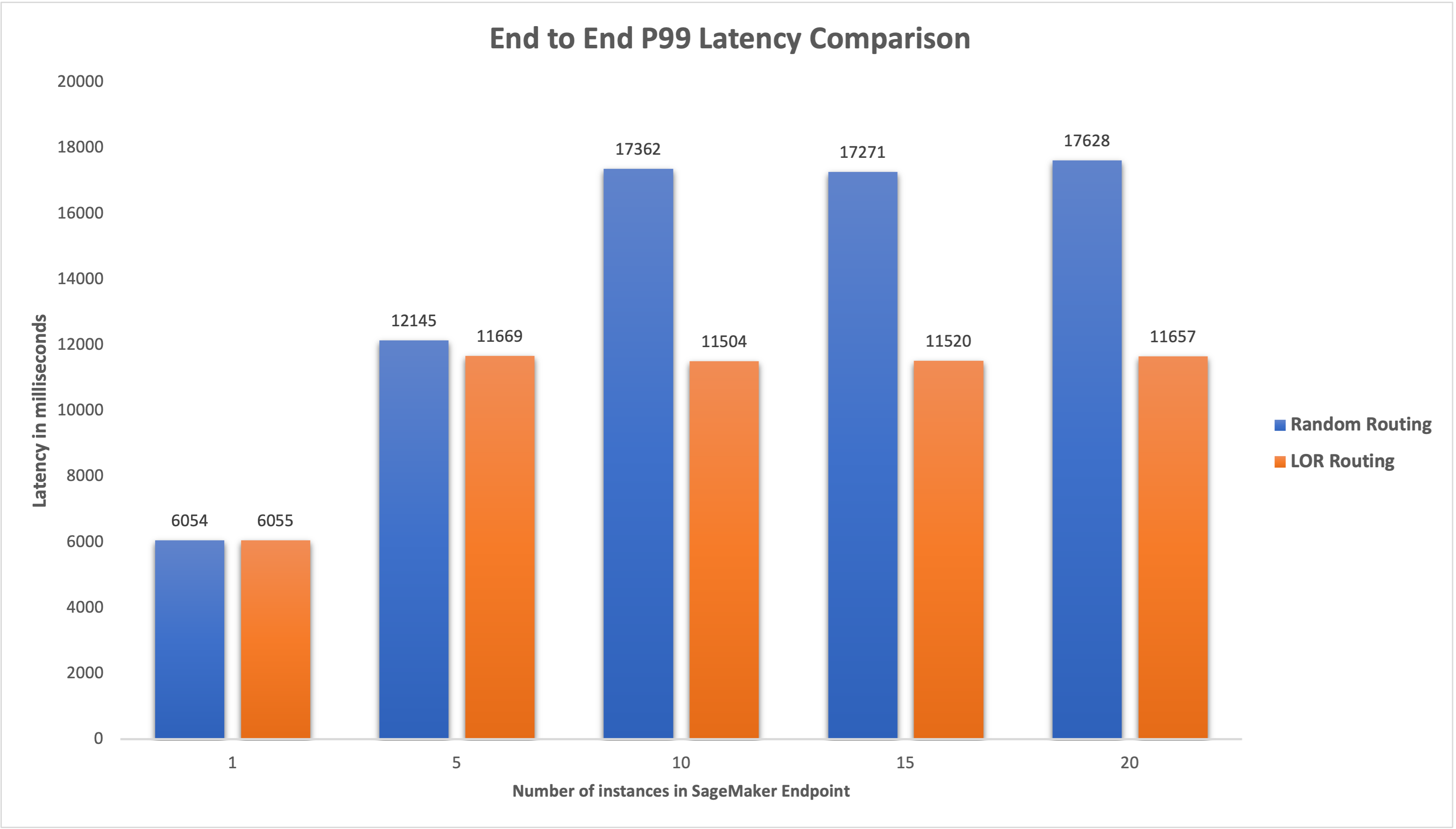

Wir haben die End-to-End-P99-Latenz für beide Endpunkte gemessen und eine Verbesserung der Latenz um 4–33 % beobachtet, als die Anzahl der Instanzen von 5 auf 20 erhöht wurde, wie in der folgenden Grafik dargestellt.

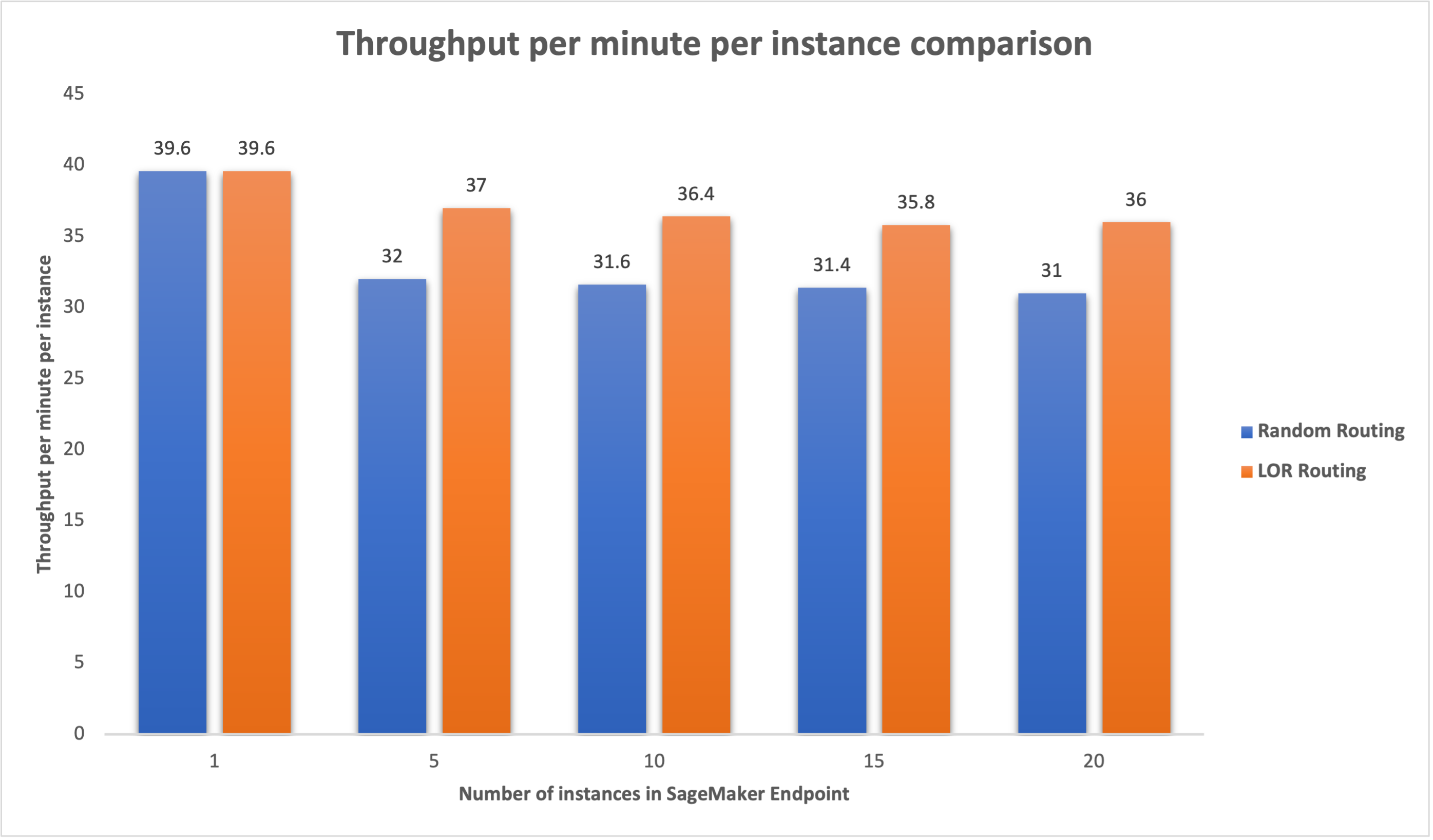

Ebenso beobachteten wir eine Verbesserung des Durchsatzes pro Minute und Instanz um 15–16 %, wenn die Anzahl der Instanzen von 5 auf 20 erhöht wurde.

Dies zeigt, dass intelligentes Routing die Verkehrsverteilung zwischen den Endpunkten verbessern kann, was zu Verbesserungen der End-to-End-Latenz und des Gesamtdurchsatzes führt.

Zusammenfassung

In diesem Beitrag haben wir die Routing-Strategien von SageMaker und die neue Option zum Aktivieren des LOR-Routings erläutert. Wir haben erklärt, wie Sie LOR aktivieren und wie es Ihren Modellbereitstellungen zugute kommen kann. Unsere Leistungstests zeigten Latenz- und Durchsatzverbesserungen während der Echtzeit-Inferenzierung. Weitere Informationen zu den Routing-Funktionen von SageMaker finden Sie unter Dokumentation. Wir empfehlen Ihnen, Ihre Inferenz-Workloads zu bewerten und festzustellen, ob Sie mit der Routing-Strategie optimal konfiguriert sind.

Über die Autoren

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

James Park ist Lösungsarchitekt bei Amazon Web Services. Er arbeitet mit Amazon.com zusammen, um Technologielösungen auf AWS zu entwerfen, zu erstellen und bereitzustellen, und hat ein besonderes Interesse an KI und maschinellem Lernen. In seiner Freizeit erkundet er gerne neue Kulturen, neue Erfahrungen und bleibt über die neuesten Technologietrends auf dem Laufenden. Sie finden ihn auf LinkedIn.

Venugopal Pai ist Lösungsarchitekt bei AWS. Er lebt in Bengaluru, Indien, und hilft Digital-Native-Kunden bei der Skalierung und Optimierung ihrer Anwendungen auf AWS.

Venugopal Pai ist Lösungsarchitekt bei AWS. Er lebt in Bengaluru, Indien, und hilft Digital-Native-Kunden bei der Skalierung und Optimierung ihrer Anwendungen auf AWS.

David Nienda ist Senior Software Development Engineer im Amazon SageMaker-Team und arbeitet derzeit an der Verbesserung von Arbeitsabläufen für maschinelles Lernen in der Produktion sowie an der Einführung neuer Inferenzfunktionen. In seiner Freizeit versucht er, mit seinen Kindern Schritt zu halten.

David Nienda ist Senior Software Development Engineer im Amazon SageMaker-Team und arbeitet derzeit an der Verbesserung von Arbeitsabläufen für maschinelles Lernen in der Produktion sowie an der Einführung neuer Inferenzfunktionen. In seiner Freizeit versucht er, mit seinen Kindern Schritt zu halten.

Deepti Ragha ist Software Development Engineer im Amazon SageMaker-Team. Ihre aktuelle Arbeit konzentriert sich auf das Erstellen von Funktionen zum effizienten Hosten von Modellen für maschinelles Lernen. In ihrer Freizeit reist sie gerne, wandert und züchtet Pflanzen.

Deepti Ragha ist Software Development Engineer im Amazon SageMaker-Team. Ihre aktuelle Arbeit konzentriert sich auf das Erstellen von Funktionen zum effizienten Hosten von Modellen für maschinelles Lernen. In ihrer Freizeit reist sie gerne, wandert und züchtet Pflanzen.

Alan Tan ist Senior Product Manager bei SageMaker und leitet die Bemühungen zur Inferenz großer Modelle. Er setzt sich leidenschaftlich für die Anwendung von maschinellem Lernen im Bereich Analytics ein. Außerhalb der Arbeit genießt er die Natur.

Alan Tan ist Senior Product Manager bei SageMaker und leitet die Bemühungen zur Inferenz großer Modelle. Er setzt sich leidenschaftlich für die Anwendung von maschinellem Lernen im Bereich Analytics ein. Außerhalb der Arbeit genießt er die Natur.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

Dhawal Patel ist Principal Machine Learning Architect bei AWS. Er hat mit Organisationen von großen Unternehmen bis hin zu mittelständischen Startups an Problemen im Zusammenhang mit verteiltem Computing und künstlicher Intelligenz gearbeitet. Er konzentriert sich auf Deep Learning, einschließlich NLP- und Computer Vision-Domänen. Er hilft Kunden, hochleistungsfähige Modellinferenz auf SageMaker zu erreichen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/minimize-real-time-inference-latency-by-using-amazon-sagemaker-routing-strategies/

- :hast

- :Ist

- :nicht

- :Wo

- $UP

- 1

- 100

- 125

- 150

- 17

- 1870

- 20

- 7

- 9

- a

- Fähig

- Über Uns

- Beschleuniger

- Erreichen

- über

- AI

- KI-Modelle

- Alan

- Algorithmus

- erlaubt

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- unter

- an

- Analyse

- Analytik

- und

- Bienen

- Anwendungen

- Anwendung

- SIND

- Bereich

- künstlich

- künstliche Intelligenz

- AS

- At

- Auto

- Verfügbarkeit

- AWS

- Balance

- Balancing

- BE

- hinter

- gehört

- Benchmarking

- Nutzen

- Vorteile

- BESTE

- beide

- breit

- bauen

- Building

- Last

- aber

- by

- Aufrufe

- CAN

- Kapazität

- Fälle

- sicher

- Übernehmen

- Änderungen

- Kunden

- Code

- COM

- Kommen

- Komponenten

- Computer

- Computer Vision

- Computing

- Wettbewerber

- Konfiguration

- konfiguriert

- Berücksichtigung

- Berücksichtigung

- besteht

- Kosten

- Erstellen

- Strom

- Zur Zeit

- Kunden

- Datum

- tief

- tiefe Lernen

- Standard

- einsetzen

- Einsatz

- Einsatz

- Implementierungen

- Design

- Bestimmen

- Entwicklung

- anders

- diskutieren

- verteilt

- Verteiltes rechnen

- Verteilung

- Domains

- im

- dynamisch

- jeder

- effektiv

- effizient

- Bemühungen

- ermöglichen

- freigegeben

- ermutigen

- End-to-End

- Endpunkt

- Ingenieur

- Englisch

- Unternehmen

- bewerten

- Beispiel

- Erfahrungen

- erklärt

- äußerst

- Familie

- Eigenschaften

- Endlich

- Finden Sie

- konzentriert

- Folgende

- Aussichten für

- Gründen

- für

- voll

- Allgemeines

- erzeugt

- generativ

- Generative KI

- gif

- gegeben

- Graph

- persönlichem Wachstum

- Haben

- he

- hilft

- hier (auf dänisch)

- GUTE

- ihm

- seine

- Gastgeber

- gehostet

- Ultraschall

- Hilfe

- HTML

- HTTPS

- hunderte

- identifizieren

- if

- zeigt

- zu unterstützen,

- Verbesserung

- Verbesserungen

- Verbesserung

- in

- Einschließlich

- Eingehende

- hat

- Indien

- Instanz

- Intelligenz

- interaktive

- Interesse

- in

- IT

- SEINE

- jpg

- Behalten

- Kinder

- Sprache

- grosse

- Große Unternehmen

- Latency

- neueste

- Start

- führenden

- LERNEN

- lernen

- am wenigsten

- Leben

- Belastung

- Los

- senken

- Maschine

- Maschinelles Lernen

- MACHT

- verwalten

- verwaltet

- Manager

- Weise

- Kann..

- messen

- Mechanismus

- Millisekunden

- Minute

- Minuten

- ML

- Modell

- für

- Überwachung

- mehr

- mehrere

- Neu

- Nlp

- nicht

- jetzt an

- Anzahl

- of

- Angebote

- vorgenommen,

- on

- Betriebs-

- Optimieren

- Option

- or

- Organisationen

- UNSERE

- im Freien

- aussen

- hervorragend

- übrig

- Gesamt-

- Parameter

- besondere

- leidenschaftlich

- für

- Leistung

- Pflanzen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Datenschutzrichtlinien

- möglich

- Post

- Gegenwart

- Principal

- Probleme

- Produkt

- Produkt-Manager

- Produktion

- Eingabeaufforderungen

- zufällig

- Bereich

- lieber

- Echtzeit

- erhalten

- empfehlen

- Reduziert

- siehe

- Ungeachtet

- bezogene

- Anforderung

- Zugriffe

- Antwort

- Antworten

- Straße

- Routing

- Führen Sie

- sagemaker

- Skalieren

- auf der Suche nach

- Auswahl

- Senior

- brauchen

- Lösungen

- kompensieren

- Einstellung

- sie

- zeigte

- gezeigt

- Konzerte

- smart

- Software

- Software-Entwicklung

- Lösungen

- überspannend

- Startups

- bleiben

- einfach

- Strategien

- Strategie

- so

- Unterstützte

- Unterstützt

- Systeme und Techniken

- Tabelle

- Einnahme

- Reden

- Team

- Technologie

- Test

- Tests

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Die Gegend

- ihr

- Dort.

- Diese

- fehlen uns die Worte.

- Durchsatz

- Zeit

- zu

- der Verkehr

- Reise

- Trends

- Typen

- Nutzer

- Verwendung von

- Werte

- Variable

- sehr

- Seh-

- we

- Netz

- Web-Services

- GUT

- waren

- wann

- welche

- während

- werden wir

- mit

- Arbeiten

- gearbeitet

- Workflows

- arbeiten,

- Werk

- Du

- Ihr

- Zephyrnet

- Zonen