Ja. Ich spreche von den KI-Anwendungen – unseren unzähligen KI-Anwendungen und den kommenden, die den Menschen zuflüstern, was zu tun ist…. wie es geht … aber nicht über die Flüsterer, die mit den KI-Chatbots interagieren.

Laut IDC Prognosen zufolge könnte der globale KI-Markt bis 500 über 2024 Milliarden US-Dollar erreichen – ein Anstieg von mehr als 50 % gegenüber 2021. Dies deutet darauf hin, dass wir von Geschäftsexperimenten zu der Annahme übergegangen sind, dass dies ein integraler Bestandteil der Unternehmensstrategie für alle Größen ist. Es ist ein notwendiges Werkzeug, um Daten in Erkenntnisse umzuwandeln, um Maßnahmen auf der Grundlage besserer Entscheidungen auszulösen. Niemand diskutiert die Vorteile von KI, um das Geschäftsrisiko zu verringern und den ROI durch Innovation zu steigern. Aber wie immer gibt es ein … ABER … die unvoreingenommene KI ist leichter gesagt als getan.

Diese KI-Modelle sind für das Unternehmen von entscheidender Bedeutung und müssen zuverlässig, transparent und nachvollziehbar funktionieren. Andernfalls hat ein Scheitern in diesem Fall schwerwiegende Folgen, die sich auf den Cashflow eines Unternehmens auswirken und sogar zu rechtlichen Problemen führen können. Der einzige Weg, dies zu vermeiden, ist Automatisierung und Transparenz, um eine Frage zu beantworten: „Können Sie beweisen, dass diese KI-Anwendung/Workload ethisch vertretbar ist?“. Aka … wie regierst du? Und können Sie beweisen, dass es kontinuierlich regiert wird?

Hier mögen Unternehmen IBM haben in KI-Governance investiert, um den Gesamtprozess der Leitung, Verwaltung und Überwachung der KI-Aktivitäten der Organisation zu orchestrieren. Die Hauptaufgabe besteht darin, sicherzustellen, dass alle Geschäftsbereiche proaktiv bleiben und den Governance-Rahmen in die Initiativen einfließen lassen, um die Fähigkeit zur Einhaltung ethischer Grundsätze und Vorschriften zu stärken. Insbesondere regulierte Branchen wie Banken und Finanzdienstleister sind gesetzlich verpflichtet, den Nachweis zu erbringen, um die Aufsichtsbehörden zufriedenzustellen.

Der Einfluss von KI wächst im Finanzdienstleistungssektor aufgrund des enormen Drucks der digitalen Transformation exponentiell. Wie gesagt, leichter gesagt als getan, denn:

1. KI-Apps souverän operationalisieren:

In einigen Fällen werden Modelle ohne Klarheit und Katalogisierung erstellt; Unnötig zu sagen, dass die Überwachung mittendrin verschwindet, um den End-to-End-Lebenszyklus zu verfolgen. Während Banken mit Legacy-Anwendungen zu kämpfen haben, wurde die Automatisierung der Prozesse zur Schaffung von Transparenz und Erklärbarkeit schwieriger und damit wiederum zu einer Black Box. Niemand weiß, warum/wie Entscheidungen getroffen wurden. Die neuen Apps, die mit Legacy-Apps vermischt sind, kommen nie ans Tageslicht, obwohl sie aufgrund der Qualität und der unbemerkten Risiken mit einem enormen ROI verbunden sind.

Das bringt uns zu unserem zweiten Punkt – dem Management des Reputationsrisikos

2. Verwalten Sie das Reputationsrisiko zusammen mit dem Gesamtrisiko

ich habe gefragt #chatGPT und #Barde – Wer ist Padma Chukka? #ChatGPT weigerte sich zu antworten, auch wenn ich die Frage auf mehrere Arten geändert hatte. Trotzdem hat Bard mir eine detaillierte Antwort gegeben, einschließlich meines LinkedIn-Profils … aber die Daten stammen von verschiedenen Websites, auf denen mein altes Profil noch als Teil des Sprecher-Bios existiert. Von diesem Zeitpunkt an muss ich den Barden noch öffnen. So schnell war ich abgeschaltet, alias – Reputationsrisiko. Angenommen, ich kann einen einfachen Chatbot ausschalten, wenn ich feststelle, dass die Daten möglicherweise inkonsistent sind. Wie könnte ich mich nicht vergewissern, bevor ich mich für den Kauf einer KI-infundierten Anwendung entscheide, um kritische Geschäfte zu tätigen? Das Reputationsrisiko ist ein wesentlicher Faktor, den Unternehmen manchmal vergessen. Wenn man das Reputationsrisiko quantifiziert, sieht man die enormen Auswirkungen auf das Geschäft, wenn man nicht proaktiv handelt.

Um die Komplexität zu erhöhen, ist der dritte …

3. Wie kann ein Unternehmen auf sich ändernde KI-Vorschriften reagieren?

Um das Reputationsrisiko zu vermeiden, sollte ein erfolgreiches und verantwortungsbewusstes KI-Team alle lokalen und globalen Vorschriften kennen und sofort wie ein Tick-Tack-Video fallen. Und die Nichteinhaltung kann eine Organisation letztendlich Millionen von Dollar an Bußgeldern im Zusammenhang mit der Arbeit wie dem vorgeschlagenen EU-KI-Gesetz kosten. Es können bis zu 30 Millionen Euro oder 6 % des weltweiten Umsatzes des Unternehmens sein – AUTSCH.

Nun, am Anfang muss nicht alles rosig sein … solange wir wissen, wie man eine beängstigende in eine rosige Situation verwandelt.

Kein Wunder … es sind immer Menschen, Prozesse und Technologien. Erstellen Sie also zunächst ein funktionsübergreifendes Leitungsgremium, um die Initiativen auf der Grundlage der Ziele zu erziehen, zu leiten und zu überwachen. Benchmarken Sie dann aktuelle KI-Technologien und -Prozesse, verstehen Sie die Lücken und beheben Sie sie, um sie zukunftssicher zu machen. Greifen Sie dann auf eine Reihe automatisierter Governance-Workflows zurück, die den Compliance-Anforderungen entsprechen. Richten Sie schließlich ein Überwachungssystem ein, um Eigentümer zu warnen, wenn sich der akzeptable Schwellenwert nähert. Aus technologischer Sicht erfordert eine gut konzipierte, gut ausgeführte und gut vernetzte KI mehrere Bausteine. Und stellen Sie sicher, dass es einige oder alle Funktionen hat:

· Datenintegrität über verschiedene Bereitstellungen hinweg

· Verwenden Sie offene, flexible vorhandene Tools, die der KI-Governance entsprechen

· Stellen Sie sicher, dass Sie Self-Service-Zugriff mit Datenschutzkontrollen anbieten – eine Möglichkeit zur Nachverfolgung

· Entwerfen Sie unter Berücksichtigung von Automatisierung und KI-Governance

· Kann durch einen anpassbaren Workflow für mehrere Interessengruppen verbunden und angepasst werden

Sobald wir die App von gruselig zu rosig überarbeitet haben … dann ist die nächste Frage, wie Sie beweisen …

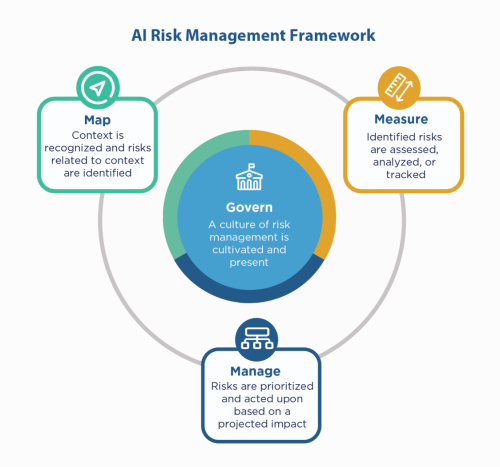

Greifen Sie zunächst auf die KI-Prinzipien des Unternehmens zurück – bauen Sie mit ihnen auf, und dennoch müssen Sie immer noch „zeigen“, dass Sie konform sind, insbesondere in regulierten Umgebungen wie Finanzdienstleistungen. Da sich Finanzdienstleister bei NIST 800-53 beschweren müssen, könnten sie sich das ansehen NIST AI Risk Management Framework (AI RMF). NIST schlug die Kontrollen in vier Familien vor – Regieren, Kartieren, Messen und Verwalten. Verwenden Sie dies als Leitfaktor und testen Sie die Anwendungen, um die Lücken zu identifizieren, die behoben und überwacht werden müssen.

IBM kann Ihre Modelle validieren, bevor Sie sie in Produktion nehmen, und kann auf Fairness, Qualität und Drift überwacht werden. Es kann auch Dokumentation bereitstellen, die das Verhalten und die Vorhersagen des Modells erklärt, um die Anforderungen von Aufsichtsbehörden und Wirtschaftsprüfern zu erfüllen. Diese Erklärungen können Transparenz schaffen und den Prüfungsaufwand lindern sowie die Transparenz und die Fähigkeit zur Bestimmung möglicher Risiken erhöhen.

Hören Sie sich das KI-Geflüster vertrauensvoll an!

#Finanzdienstleistungen #verantwortlichai #ethisch #NISTAIRMF

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :Ist

- $UP

- 2021

- 2024

- 7

- a

- Fähigkeit

- Über Uns

- akzeptabel

- Zugang

- Rechenschaftspflicht

- über

- Handlung

- Action

- Aktivitäten

- haften

- AI

- KI-Gesetz

- KI-Governance

- Auch bekannt als:

- Aufmerksam

- Alle

- immer

- und

- beantworten

- App

- Anwendung

- Anwendungen

- Apps

- SIND

- um

- AS

- damit verbundenen

- At

- Prüfung

- Abschlussprüfer

- Automatisiert

- automatisieren

- Automation

- Zurück

- Bankinggg

- Banken

- basierend

- BE

- weil

- Bevor

- Sein

- Benchmark

- Vorteile

- Besser

- Milliarde

- Schwarz

- Blockiert

- Körper

- Box

- Brings

- bauen

- Building

- erbaut

- Geschäft

- Kaufe

- by

- CAN

- Fähigkeiten

- Häuser

- Fälle

- Bargeld

- Cash-Flow-

- Ändern

- Chatbot

- Chatbots

- Clarity

- Schließen

- Unternehmen

- Unternehmen

- Komplexität

- Compliance

- konform

- Leiten

- zuversichtlich

- Vernetz Dich

- Folgen

- ständig

- Steuerung

- Kosten

- könnte

- erstellen

- kritischem

- Strom

- anpassbare

- Zyklus

- technische Daten

- Debattieren

- Entscheiden

- Entscheidungen

- verringern

- Design

- detailliert

- Bestimmen

- digital

- Digitale Transformation

- dire

- Direkt

- Regie bei

- verschieden

- Dokumentation

- Dollar

- Abwurf

- einfacher

- erziehen

- End-to-End

- gewährleisten

- Unternehmen

- Umgebungen

- insbesondere

- essential

- ethisch

- EU

- Euro

- Sogar

- Jedes

- alles

- Beweis

- vorhandenen

- existiert

- Erläuterung

- exponentiell

- Scheitern

- Fairness

- Fallen

- Familien

- Endlich

- Revolution

- Finanzdienstleistungen

- Ende

- Finextra

- Vorname

- flexibel

- Fluss

- Aussichten für

- Unser Ansatz

- für

- von 2021

- Zukunft

- ABSICHT

- Global

- Governance

- persönlichem Wachstum

- Haben

- Ultraschall

- Hilfe

- HTTPS

- riesig

- Humans

- i

- identifizieren

- Impact der HXNUMXO Observatorien

- in

- Einschließlich

- Erhöhung

- zeigt

- Branchen

- beeinflussen

- Initiativen

- Innovation

- Einblicke

- Integral

- Integrität

- interagieren

- investiert

- IT

- SEINE

- Job

- Wissen

- Legacy

- Rechtlich

- rechtliche Angelegenheiten

- Lebensdauer

- Gefällt mir

- Line

- aus einer regionalen

- Lang

- aussehen

- gemacht

- um

- verwalten

- Management

- flächendeckende Gesundheitsprogramme

- Karte

- Markt

- Angelegenheiten

- Kann..

- messen

- Triff

- könnte

- Million

- Millionen

- Modell

- für

- Moment

- Überwachen

- überwacht

- Überwachung

- mehr

- mehrere

- notwendig,

- Need

- Unnötig

- Neu

- weiter

- nist

- of

- bieten

- Alt

- on

- EINEM

- XNUMXh geöffnet

- betreiben

- Organisation

- Andernfalls

- Gesamt-

- Besitzer

- Schmerzen

- Teil

- Personen

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- möglich

- Prognosen

- Druck

- primär

- Grundsätze

- Datenschutz

- Proaktives Handeln

- Prozessdefinierung

- anpassen

- Produktion

- Profil

- Beweis

- vorgeschlage

- Belegen

- die

- setzen

- Qualität

- Frage

- schnell

- erreichen

- realisieren

- geregelt

- regulierte Branchen

- Rechtliches

- Vorschriften

- Regulators

- Ruf

- falls angefordert

- Voraussetzungen:

- erfordert

- Reagieren

- für ihren Verlust verantwortlich.

- Folge

- Einnahmen

- Risiko

- Risikomanagement

- Risiken

- ROI

- Rosig

- s

- Said

- Zweite

- Bibliotheken

- Selbstbedienung

- Lösungen

- kompensieren

- sollte

- erklären

- Seite

- Einfacher

- da

- Seiten

- Situation

- Größen

- So

- einige

- Spark

- Speaker

- Stakeholder

- bleiben

- Immer noch

- Strategie

- Stärke

- Der Stress

- Struggling

- erfolgreich

- System

- sprechen

- Team

- Technologie

- Test

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Sie

- Diese

- Dritte

- Schwelle

- Durch

- zu

- Werkzeug

- Werkzeuge

- verfolgen sind

- Transformation

- Transparenz

- enorm

- WENDE

- Turned

- Letztlich

- verstehen

- Bereiche

- anstehende

- us

- -

- BESTÄTIGEN

- verschiedene

- Video

- Sichtbarkeit

- Weg..

- Wege

- Was

- während

- WHO

- mit

- ohne

- Arbeiten

- Workflows

- Du

- Ihr

- Zephyrnet