Viele Anwendungen, die für die Wartung von Industrieanlagen, die Handelsüberwachung, das Flottenmanagement und die Routenoptimierung gedacht sind, werden mit Open-Source-Cassandra-APIs und -Treibern erstellt, um Daten mit hoher Geschwindigkeit und geringer Latenz zu verarbeiten. Die Verwaltung von Cassandra-Tabellen selbst kann zeitaufwändig und teuer sein. Amazon Keyspaces (für Apache Cassandra) können Sie Cassandra-Tabellen in der AWS Cloud einrichten, sichern und skalieren, ohne zusätzliche Infrastruktur verwalten zu müssen.

In diesem Beitrag führen wir Sie durch die AWS-Services im Zusammenhang mit dem Training von Modellen für maschinelles Lernen (ML) unter Verwendung von Amazon Keyspaces auf hohem Niveau und bieten Schritt-für-Schritt-Anweisungen zum Erfassen von Daten aus Amazon Keyspaces Amazon Sage Maker und Trainieren eines Modells, das für einen bestimmten Anwendungsfall der Kundensegmentierung verwendet werden kann.

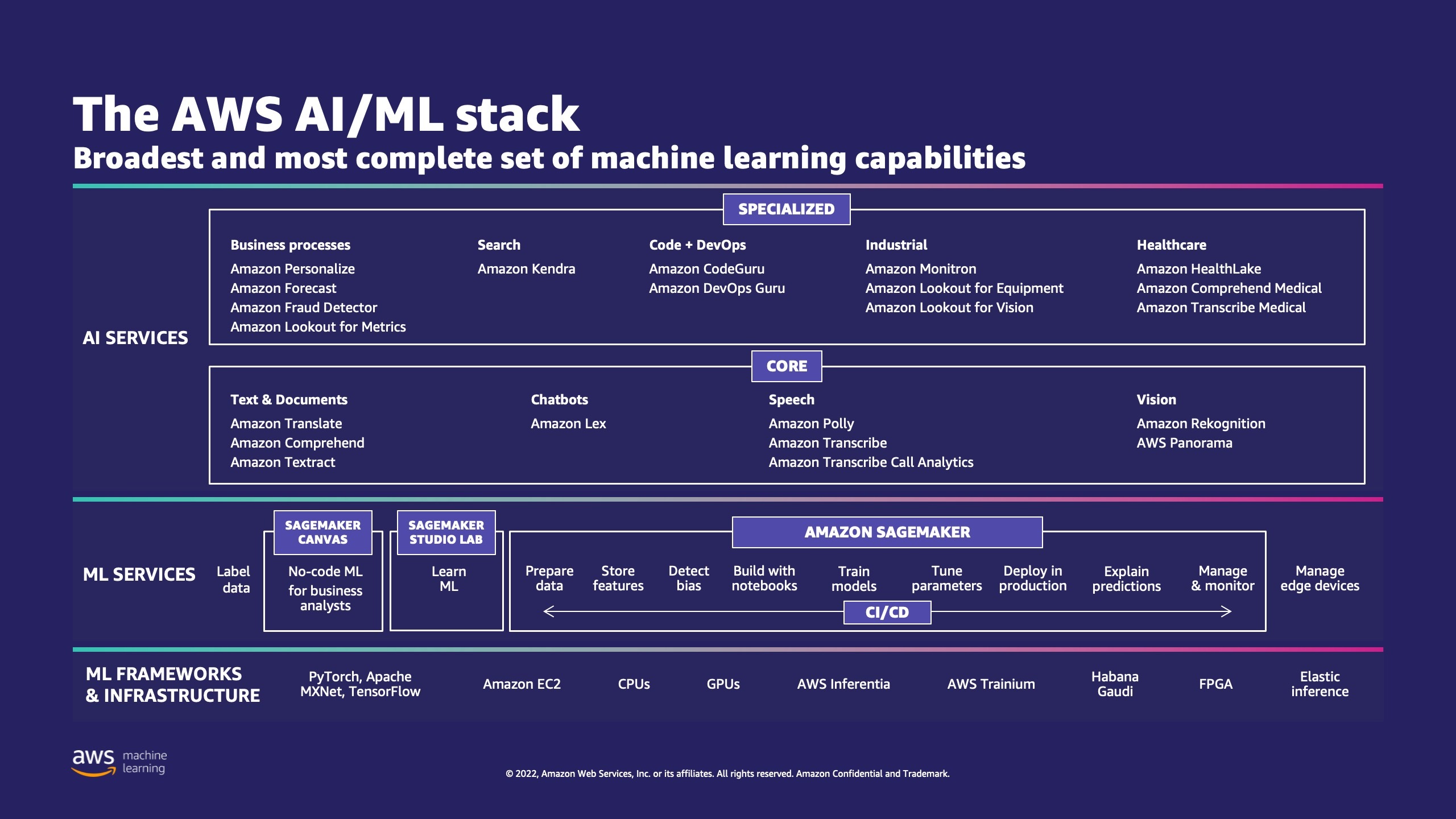

AWS bietet mehrere Services, die Unternehmen bei der Implementierung von ML-Prozessen in der Cloud unterstützen.

AWS ML Stack hat drei Schichten. In der mittleren Schicht ist SageMaker, das Entwicklern, Data Scientists und ML-Ingenieuren die Möglichkeit bietet, ML-Modelle in großem Maßstab zu erstellen, zu trainieren und bereitzustellen. Es beseitigt die Komplexität aus jedem Schritt des ML-Workflows, sodass Sie Ihre ML-Anwendungsfälle einfacher bereitstellen können. Dies umfasst alles von vorausschauender Wartung bis hin zu Computer Vision zur Vorhersage des Kundenverhaltens. Kunden erreichen mit SageMaker eine bis zu 10-fache Steigerung der Produktivität von Datenwissenschaftlern.

Apache Cassandra ist eine beliebte Wahl für leselastige Anwendungsfälle mit unstrukturierten oder halbstrukturierten Daten. Beispielsweise schätzt ein beliebtes Lebensmittellieferunternehmen die Lieferzeit, und ein Einzelhandelskunde könnte häufig darauf bestehen, Produktkataloginformationen in der Apache Cassandra-Datenbank zu verwenden. Amazon-Schlüsselräume ist ein skalierbarer, hochverfügbarer und verwalteter serverloser Apache Cassandra-kompatibler Datenbankdienst. Sie müssen keine Server bereitstellen, patchen oder verwalten, und Sie müssen keine Software installieren, warten oder betreiben. Tabellen können automatisch hoch- und herunterskaliert werden, und Sie zahlen nur für die Ressourcen, die Sie verwenden. Mit Amazon Keyspaces können Sie Ihre Cassandra-Workloads auf AWS mit demselben Cassandra-Anwendungscode und denselben Entwicklertools ausführen, die Sie heute verwenden.

SageMaker bietet eine Reihe von eingebaute Algorithmen um Datenwissenschaftlern und ML-Praktikern dabei zu helfen, schnell mit dem Training und der Bereitstellung von ML-Modellen zu beginnen. In diesem Beitrag zeigen wir Ihnen, wie ein Einzelhandelskunde die Kundenkaufhistorie in der Keyspaces-Datenbank verwenden und verschiedene Kundensegmente für Marketingkampagnen ansprechen kann.

K-Mittel ist ein unüberwachter Lernalgorithmus. Es versucht, diskrete Gruppierungen innerhalb von Daten zu finden, bei denen Mitglieder einer Gruppe einander so ähnlich wie möglich und sich so unterschiedlich wie möglich von Mitgliedern anderer Gruppen sind. Sie definieren die Attribute, die der Algorithmus verwenden soll, um die Ähnlichkeit zu bestimmen. SageMaker verwendet eine modifizierte Version des k-Means-Clustering-Algorithmus im Webmaßstab. Im Vergleich zur ursprünglichen Version des Algorithmus ist die von SageMaker verwendete Version genauer. Wie der ursprüngliche Algorithmus skaliert er jedoch auf riesige Datensätze und bietet Verbesserungen bei der Trainingszeit.

Lösungsüberblick

Die Anweisungen gehen davon aus, dass Sie SageMaker Studio verwenden würden, um den Code auszuführen. Der zugehörige Code wurde am geteilt AWS-Beispiel-GitHub. Wenn Sie den Anweisungen im Labor folgen, können Sie Folgendes tun:

- Installieren Sie die erforderlichen Abhängigkeiten.

- Verbinden Sie sich mit Amazon Keyspaces, erstellen Sie eine Tabelle und nehmen Sie Beispieldaten auf.

- Erstellen Sie ein ML-Klassifizierungsmodell mit den Daten in Amazon Keyspaces.

- Untersuchen Sie Modellergebnisse.

- Bereinigen Sie neu erstellte Ressourcen.

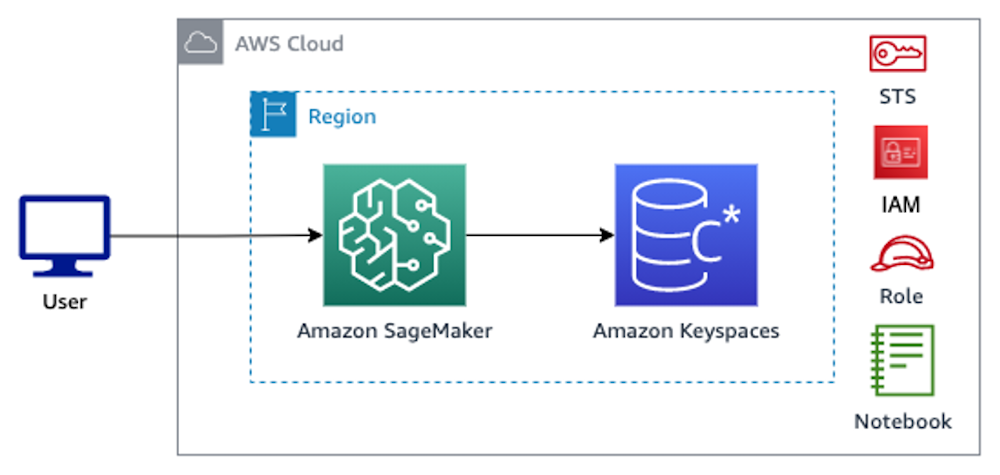

Sobald Sie fertig sind, haben Sie SageMaker mit Amazon Keyspaces integriert, um ML-Modelle zu trainieren, wie in der folgenden Abbildung gezeigt.

Jetzt können Sie dem folgen Schritt für Schritt Anweisungen in diesem Beitrag, um mit SageMaker in Amazon Keyspaces gespeicherte Rohdaten und die so abgerufenen Daten für die ML-Verarbeitung aufzunehmen.

Voraussetzungen:

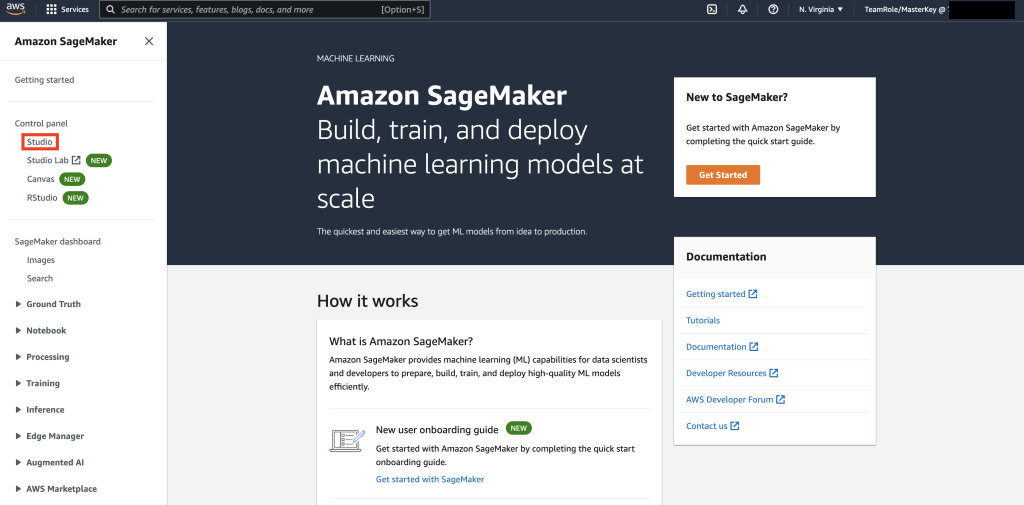

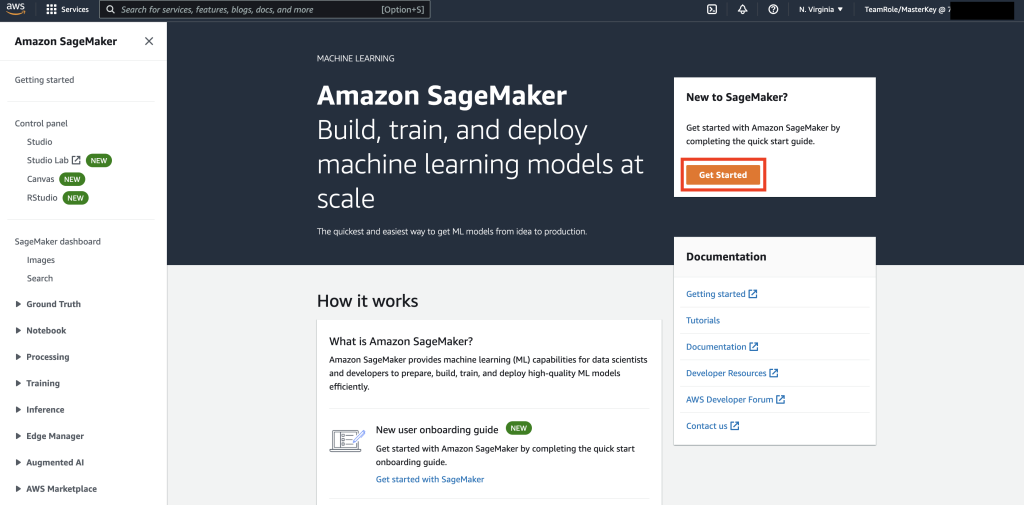

Navigieren Sie zunächst zu SageMaker.

Wählen Sie als Nächstes, wenn Sie SageMaker zum ersten Mal verwenden Loslegen .

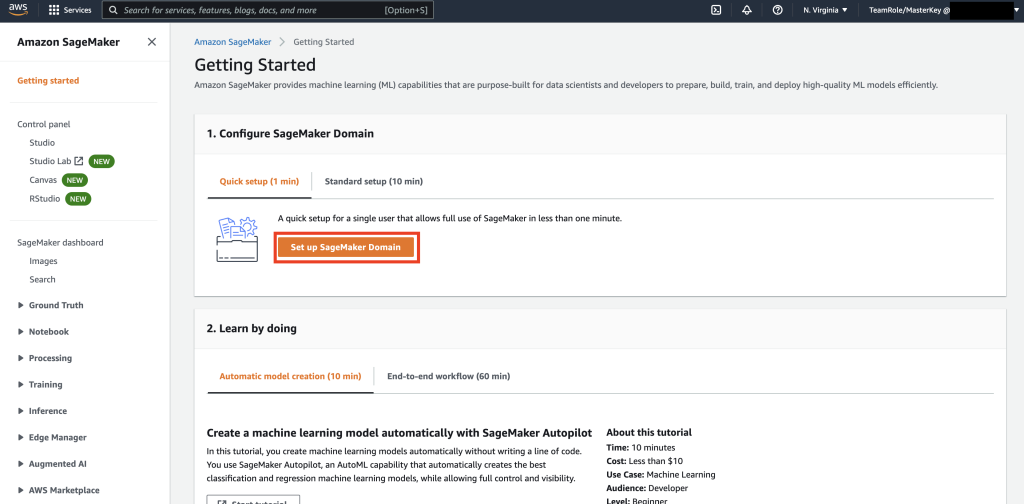

Als nächstes wählen Sie Richten Sie die SageMaker-Domäne ein.

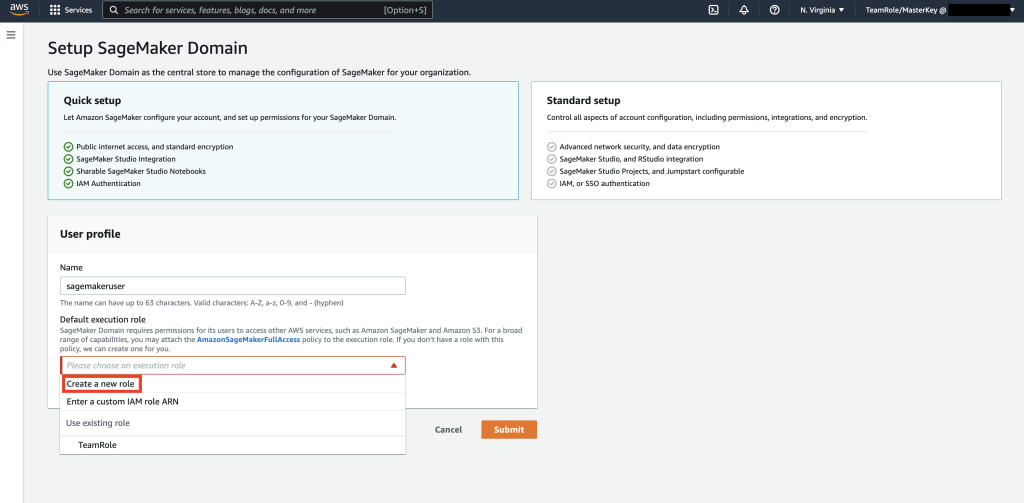

Als nächstes erstellen Sie ein neues Benutzerprofil mit Name – sagemakeruser, und wählen Sie Neue Rolle erstellen der Standardausführungsrolle Unterabschnitt.

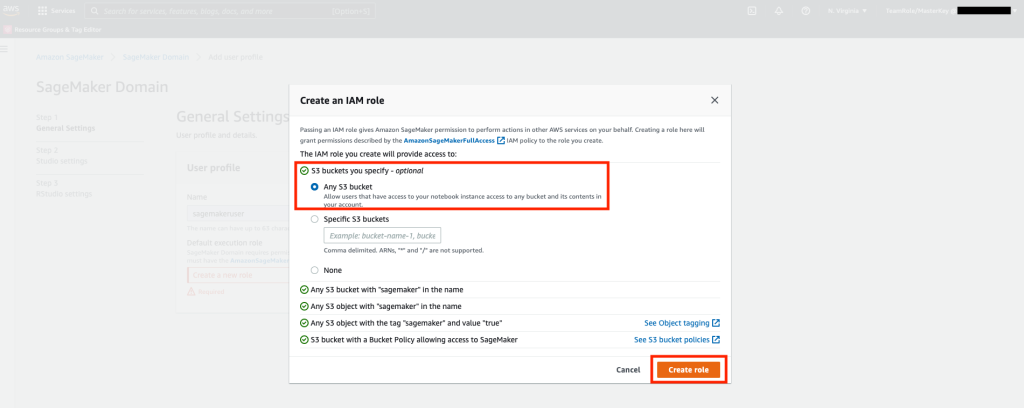

Wählen Sie als Nächstes auf dem angezeigten Bildschirm eine beliebige aus Einfacher Amazon-Speicherdienst (Amazon S3) Bucket und wählen Sie Rolle erstellen aus.

Diese Rolle wird in den folgenden Schritten verwendet, um SageMaker den Zugriff auf die Keyspaces-Tabelle mit temporären Anmeldeinformationen aus der Rolle zu ermöglichen. Dadurch entfällt die Notwendigkeit, einen Benutzernamen und ein Passwort im Notebook zu speichern.

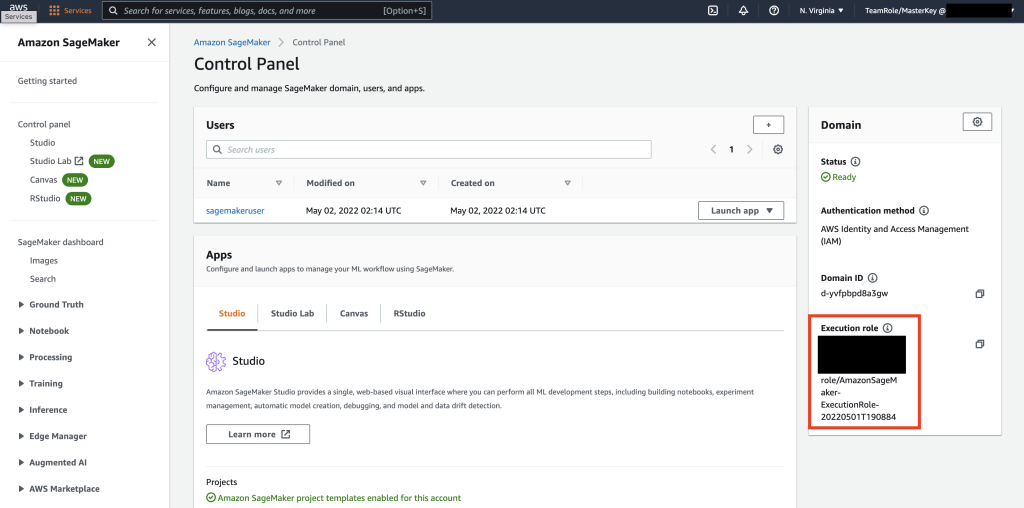

Rufen Sie als Nächstes die Rolle ab, die der zugeordnet ist sagemakeruser die im vorherigen Schritt aus dem Zusammenfassungsabschnitt erstellt wurde.

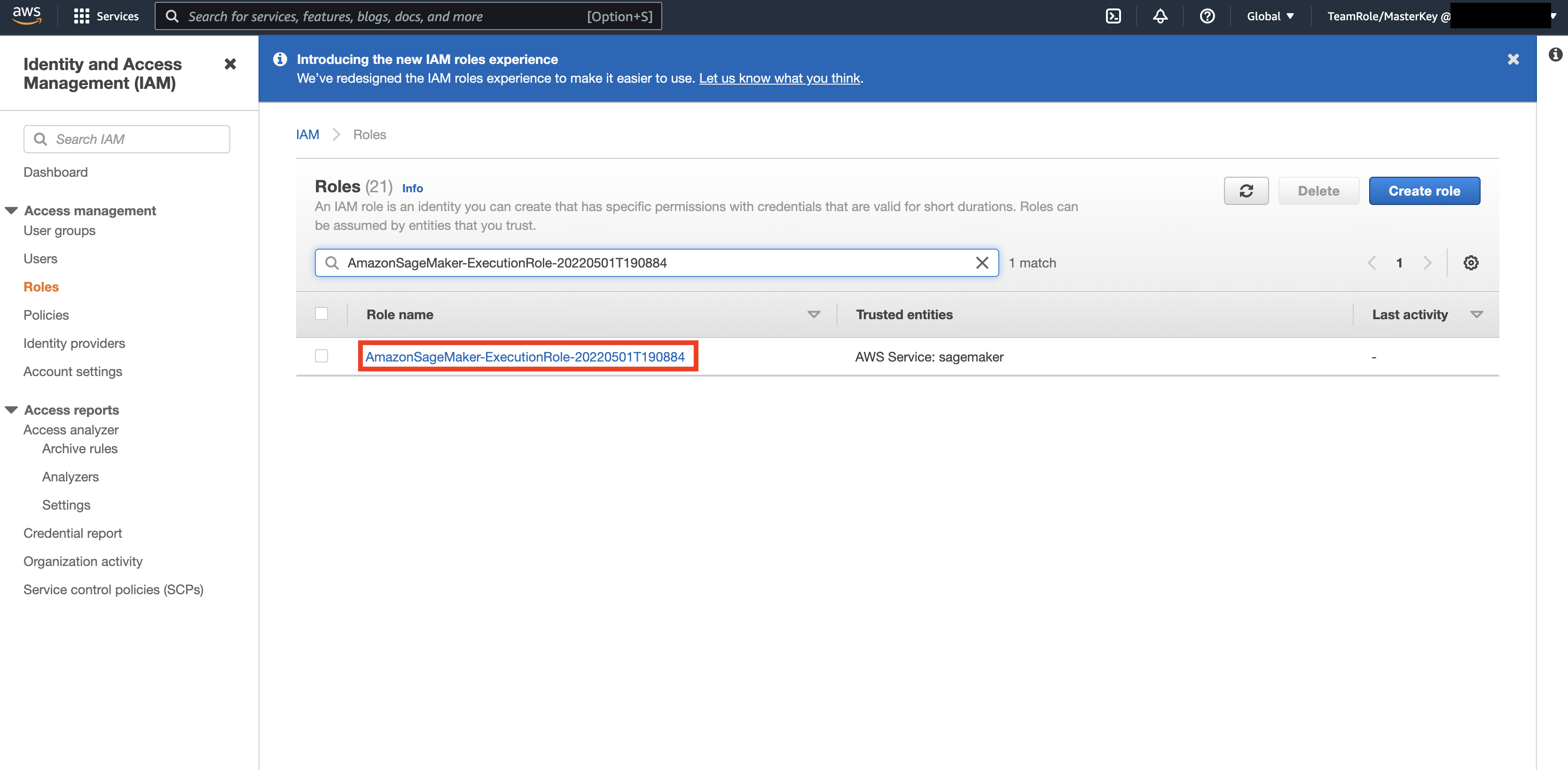

Navigieren Sie dann zum AWS-Konsole und schau nach oben AWS Identity and Access Management (IAM). Navigieren Sie in IAM zu Rollen. Suchen Sie in Rollen nach der im vorherigen Schritt identifizierten Ausführungsrolle.

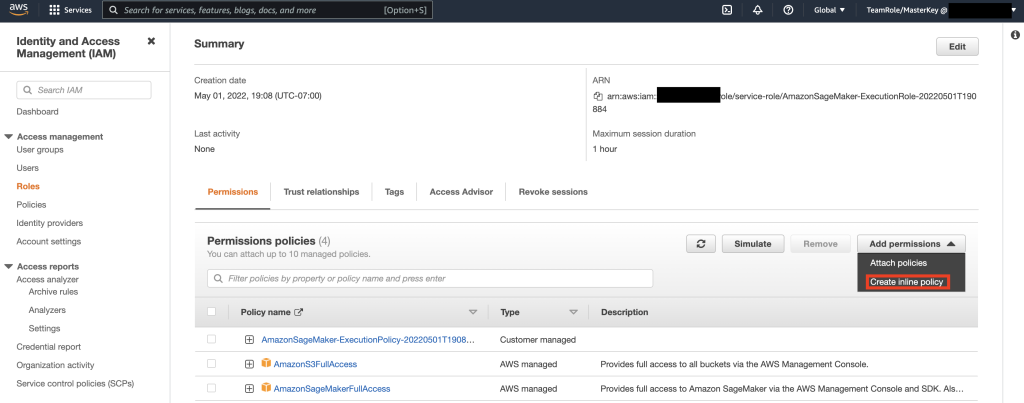

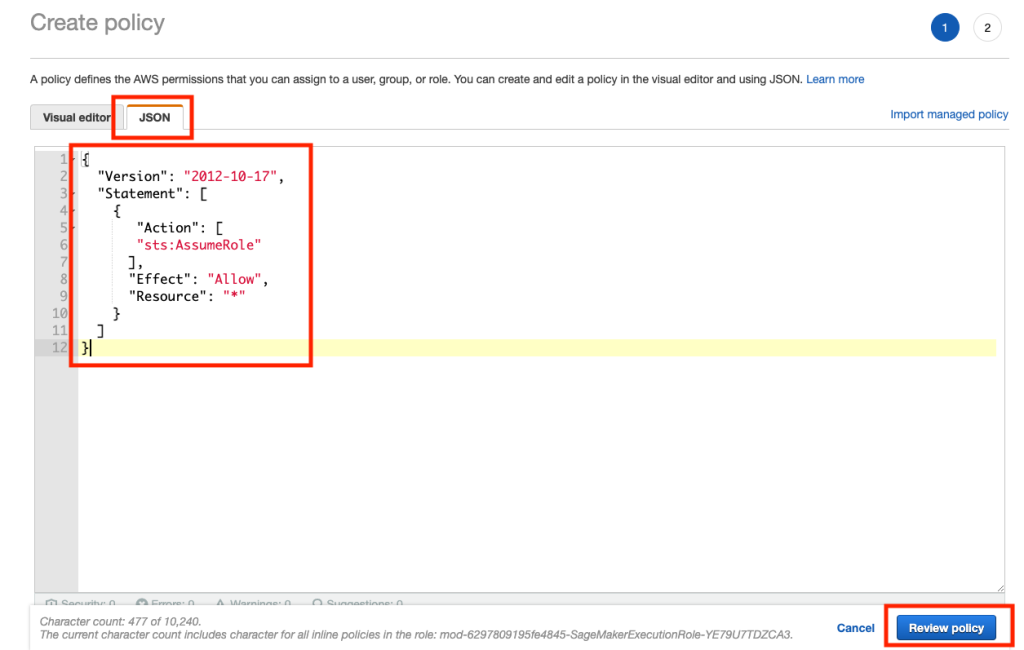

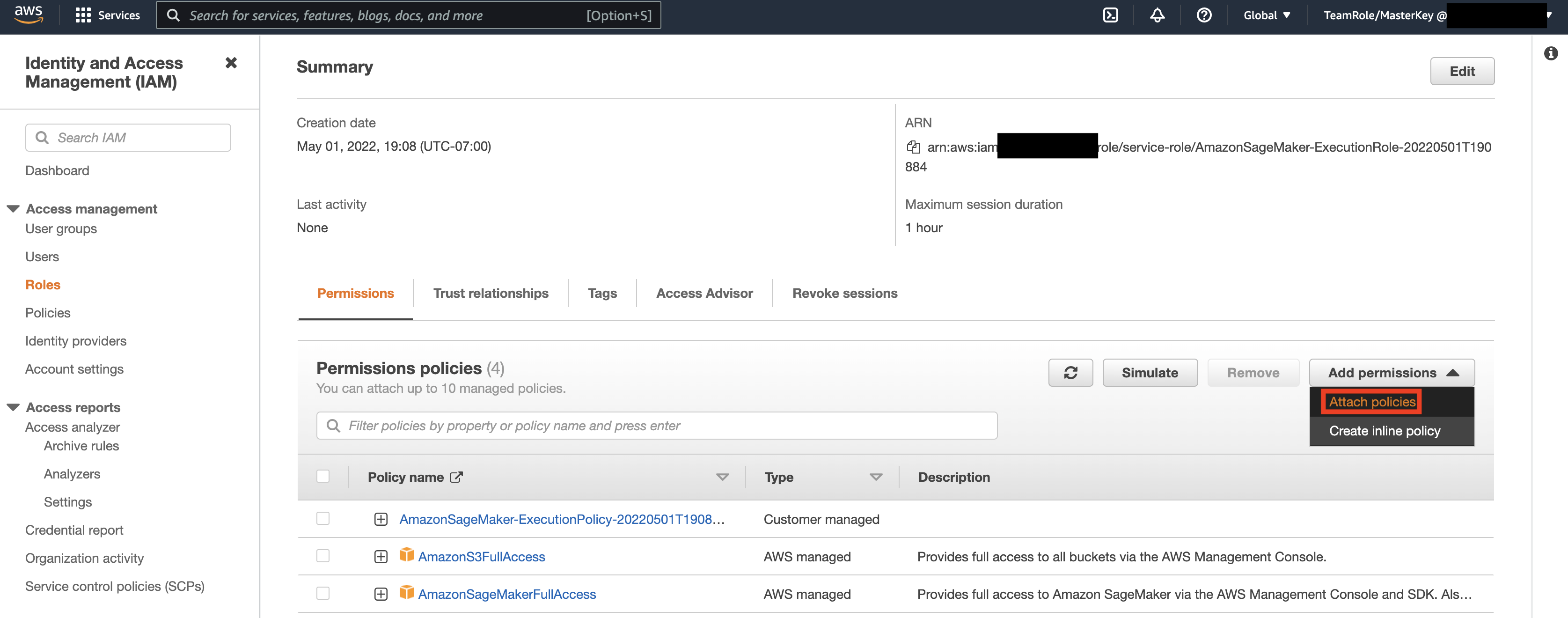

Wählen Sie als Nächstes die im vorherigen Schritt identifizierte Rolle und dann Berechtigungen hinzufügen aus. Wählen Sie in der angezeigten Dropdown-Liste Inline-Richtlinie erstellen aus. Mit SageMaker können Sie eine granulare Zugriffsebene bereitstellen, die einschränkt, welche Aktionen ein Benutzer/eine Anwendung je nach Geschäftsanforderungen ausführen kann.

Wählen Sie dann die Registerkarte „JSON“ aus und kopieren Sie die Richtlinie aus dem Abschnitt „Hinweis“ von Github Seite. Diese Richtlinie ermöglicht es dem SageMaker-Notebook, eine Verbindung zu Keyspaces herzustellen und Daten zur weiteren Verarbeitung abzurufen.

Wählen Sie dann erneut Berechtigungen hinzufügen und aus der Dropdown-Liste und dann Richtlinie anhängen aus.

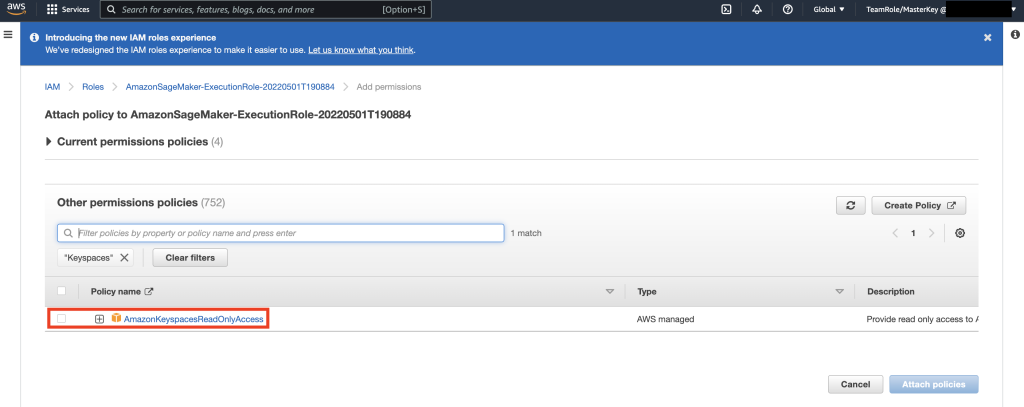

Suchen Sie nach der AmazonKeyspacesFullAccess-Richtlinie, aktivieren Sie das Kontrollkästchen neben dem übereinstimmenden Ergebnis und wählen Sie Richtlinien anhängen aus.

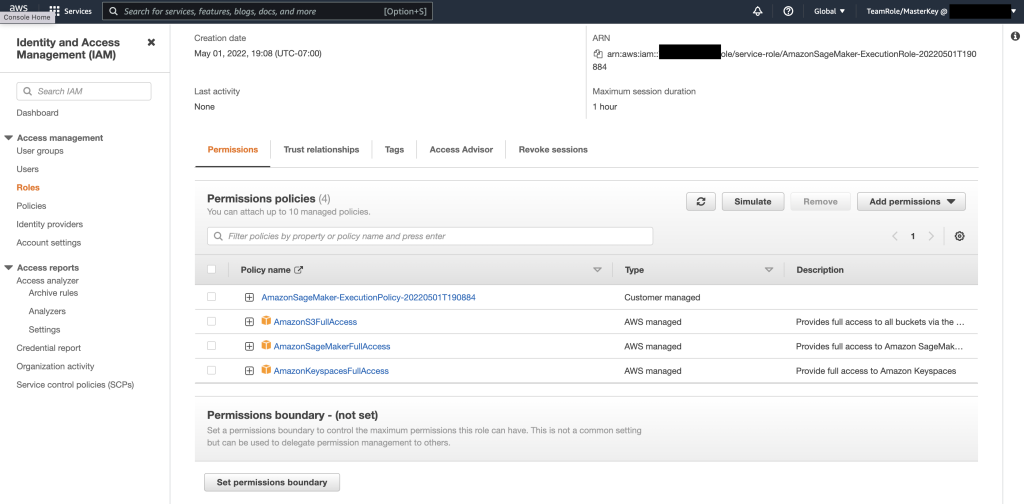

Stellen Sie sicher, dass der Abschnitt Berechtigungsrichtlinien enthält AmazonS3FullAccess, AmazonSageMakerFullAccess, AmazonKeyspacesFullAccess, sowie die neu hinzugefügte Inline-Richtlinie.

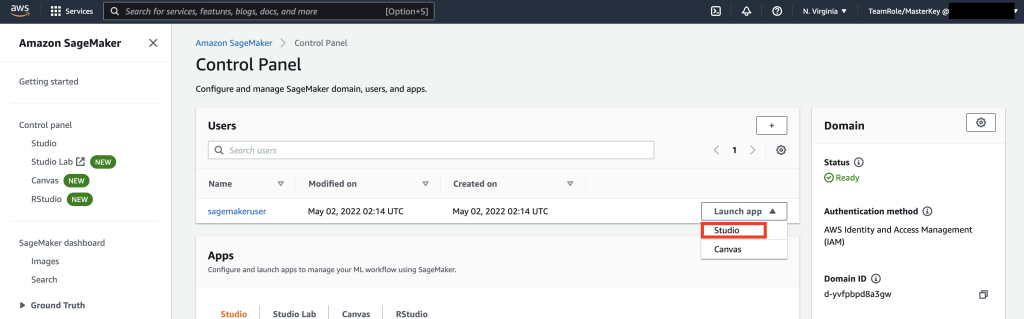

Navigieren Sie als Nächstes mithilfe der AWS-Konsole zu SageMaker Studio und wählen Sie SageMaker Studio aus. Wählen Sie dort App starten und dann Studio.

Notebook-Komplettlösung

Die bevorzugte Methode zum Herstellen einer Verbindung mit Keyspaces von SageMaker Notebook ist die Verwendung von AWS Signature Version 4-Prozess (SigV4) basierend Temporäre Anmeldeinformationen zur Authentifizierung. In diesem Szenario müssen wir KEINE Schlüsselraum-Anmeldeinformationen generieren oder speichern und können die Anmeldeinformationen zur Authentifizierung mit dem SigV4-Plugin verwenden. Temporäre Sicherheitsberechtigungsnachweise bestehen aus einer Zugriffsschlüssel-ID und einem geheimen Zugriffsschlüssel. Sie enthalten jedoch auch ein Sicherheitstoken, das angibt, wann die Anmeldeinformationen ablaufen. In diesem Beitrag erstellen wir eine IAM-Rolle und generieren temporäre Sicherheitsanmeldeinformationen.

Zuerst installieren wir einen Treiber (cassandra-sigv4). Dieser Treiber ermöglicht Ihnen das Hinzufügen von Authentifizierungsinformationen zu Ihren API-Anforderungen mithilfe des AWS Signature Version 4-Prozesses (SigV4). Mit dem Plug-in können Sie Benutzern und Anwendungen kurzfristige Anmeldeinformationen für den Zugriff auf Amazon Keyspaces (für Apache Cassandra) mithilfe von IAM-Benutzern und -Rollen bereitstellen. Anschließend importieren Sie ein erforderliches Zertifikat zusammen mit zusätzlichen Paketabhängigkeiten. Am Ende erlauben Sie dem Notebook, die Rolle zu übernehmen, mit Keyspaces zu kommunizieren.

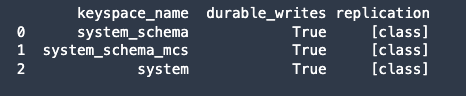

Stellen Sie als Nächstes eine Verbindung zu Amazon Keyspaces her und lesen Sie Systemdaten aus Keyspaces in Pandas DataFrame, um die Verbindung zu validieren.

Als nächstes bereiten Sie die Daten für das Training auf dem Rohdatensatz vor. Verwenden Sie in dem mit diesem Beitrag verknüpften Python-Notebook einen Einzelhandelsdatensatz, der von heruntergeladen wurde hier, und verarbeiten Sie es. Angesichts des Datensatzes besteht unser Geschäftsziel darin, die Kunden mithilfe einer bestimmten Metrik namens RFM zu gruppieren. Das RFM-Modell basiert auf drei quantitativen Faktoren:

- Aktualität: Wie lange ein Kunde einen Kauf getätigt hat.

- Häufigkeit: Wie oft ein Kunde einen Kauf tätigt.

- Geldwert: Wie viel Geld ein Kunde für Einkäufe ausgibt.

Die RFM-Analyse stuft einen Kunden in jeder dieser drei Kategorien numerisch ein, im Allgemeinen auf einer Skala von 1 bis 5 (je höher die Zahl, desto besser das Ergebnis). Der „beste“ Kunde erhält in jeder Kategorie eine Höchstpunktzahl. Wir verwenden die quantilbasierte Diskretisierungsfunktion von Pandas (qcut). Es hilft bei der Diskretisierung von Werten in gleich große Buckets basierend auf oder basierend auf Stichprobenquantilen.

In diesem Beispiel verwenden wir CQL, um Datensätze aus der Keyspace-Tabelle zu lesen. In einigen ML-Anwendungsfällen müssen Sie möglicherweise dieselben Daten mehrmals aus derselben Keyspaces-Tabelle lesen. In diesem Fall empfehlen wir Ihnen, Ihre Daten in einem Amazon S3-Bucket zu speichern, um zusätzliche Kosten zu vermeiden kostens Lesen von Amazon Keyspaces. Abhängig von Ihrem Szenario können Sie auch verwenden Amazon EMR zu Ingest eine sehr große Amazon S3-Datei in SageMaker.

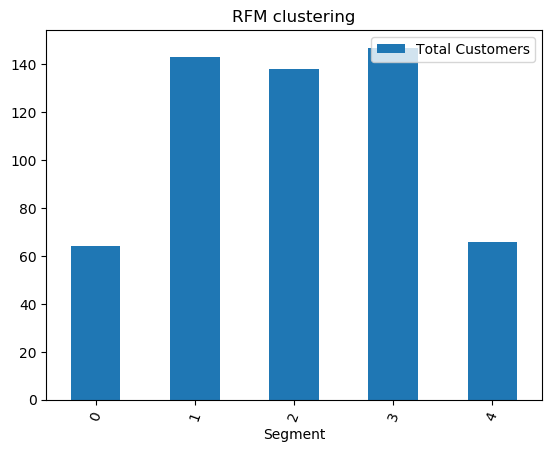

Als nächstes trainieren wir ein ML-Modell mit dem KMeans-Algorithmus und stellen sicher, dass die Cluster erstellt werden. In diesem speziellen Szenario würden Sie sehen, dass die erstellten Cluster gedruckt werden, was zeigt, dass die Kunden im Rohdatensatz basierend auf verschiedenen Attributen im Datensatz gruppiert wurden. Diese Clusterinformationen können für gezielte Marketingkampagnen verwendet werden.

(Optional) Als Nächstes speichern wir die vom ML-Modell identifizierten Kundensegmente für gezieltes Marketing wieder in einer Amazon Keyspaces-Tabelle. Ein Batch-Job könnte diese Daten lesen und gezielte Kampagnen für Kunden in bestimmten Segmenten durchführen.

Endlich haben wir die Ressourcen bereinigen während dieses Tutorials erstellt, um zusätzliche Kosten zu vermeiden.

Es kann einige Sekunden bis zu einer Minute dauern, bis der Schlüsselraum und die Tabellen gelöscht sind. Wenn Sie einen Schlüsselraum löschen, werden der Schlüsselraum und alle seine Tabellen gelöscht und es fallen keine Gebühren mehr an.

Zusammenfassung

Dieser Beitrag hat Ihnen gezeigt, wie Sie Kundendaten aus Amazon Keyspaces in SageMaker aufnehmen und ein Clustering-Modell trainieren, mit dem Sie Kunden segmentieren können. Sie können diese Informationen für gezieltes Marketing verwenden und so Ihre Geschäftskennzahlen erheblich verbessern. Weitere Informationen zu Amazon Keyspaces finden Sie in den folgenden Ressourcen:

- Trainieren Sie Modelle für maschinelles Lernen mit Amazon Keyspaces als Datenquelle (SageMaker-Notizbuch)

- Stellen Sie über IntelliJ-, PyCharm- oder DataGrip-IDEs von Ihrem Desktop aus eine Verbindung zu Amazon Keyspaces her

- CQL-Sprachreferenz für Amazon Keyspaces (für Apache Cassandra)

- So richten Sie den Befehlszeilenzugriff auf Amazon Keyspaces (für Apache Cassandra) mithilfe des Docker-Images des neuen Entwickler-Toolkits ein

- Identitäts- und Zugriffsverwaltung für Amazon Keyspaces (für Apache Cassandra)

- Verbinden mit Amazon Keyspaces von SageMaker mit dienstspezifische Anmeldeinformationen

- Aktualität, Häufigkeit, Geldwert (RFM)

- Kaggle-Code-Referenz

Über die Autoren

Wadim Ljachowitsch ist Senior Solutions Architect bei AWS in der San Francisco Bay Area und hilft Kunden bei der Migration zu AWS. Er arbeitet mit Organisationen zusammen, die von großen Unternehmen bis hin zu kleinen Startups reichen, um ihre Innovationen zu unterstützen. Er hilft Kunden auch dabei, skalierbare, sichere und kostengünstige Lösungen auf AWS zu entwickeln.

Wadim Ljachowitsch ist Senior Solutions Architect bei AWS in der San Francisco Bay Area und hilft Kunden bei der Migration zu AWS. Er arbeitet mit Organisationen zusammen, die von großen Unternehmen bis hin zu kleinen Startups reichen, um ihre Innovationen zu unterstützen. Er hilft Kunden auch dabei, skalierbare, sichere und kostengünstige Lösungen auf AWS zu entwickeln.

Teil Patel ist Lösungsarchitekt bei AWS in der San Francisco Bay Area. Parth leitet Kunden an, ihren Weg in die Cloud zu beschleunigen und hilft ihnen, die AWS Cloud erfolgreich einzuführen. Er konzentriert sich auf ML und Anwendungsmodernisierung.

Teil Patel ist Lösungsarchitekt bei AWS in der San Francisco Bay Area. Parth leitet Kunden an, ihren Weg in die Cloud zu beschleunigen und hilft ihnen, die AWS Cloud erfolgreich einzuführen. Er konzentriert sich auf ML und Anwendungsmodernisierung.

Ram Pathangi ist Lösungsarchitekt bei AWS in der San Francisco Bay Area. Er hat Kunden in den Branchen Landwirtschaft, Versicherungen, Banken, Einzelhandel, Gesundheitswesen und Biowissenschaften, Gastgewerbe und Hi-Tech dabei geholfen, ihr Geschäft erfolgreich in der AWS-Cloud zu führen. Er ist spezialisiert auf Datenbanken, Analytics und ML.

Ram Pathangi ist Lösungsarchitekt bei AWS in der San Francisco Bay Area. Er hat Kunden in den Branchen Landwirtschaft, Versicherungen, Banken, Einzelhandel, Gesundheitswesen und Biowissenschaften, Gastgewerbe und Hi-Tech dabei geholfen, ihr Geschäft erfolgreich in der AWS-Cloud zu führen. Er ist spezialisiert auf Datenbanken, Analytics und ML.

- Coinsmart. Europas beste Bitcoin- und Krypto-Börse.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. DEN FREIEN ZUGANG.

- CryptoHawk. Altcoin-Radar. Kostenlose Testphase.

- Quelle: https://aws.amazon.com/blogs/machine-learning/train-machine-learning-models-using-amazon-keyspaces-as-a-data-source/

- '

- "

- &

- 10

- 100

- 9

- Fähigkeit

- Über uns

- beschleunigen

- Zugang

- genau

- Erreichen

- Aktionen

- Zusätzliche

- Landwirtschaft

- voraus

- Algorithmus

- Alle

- Amazon

- Analyse

- Analytik

- Ein anderer

- Bienen

- APIs

- App

- Anwendung

- Anwendungen

- Bereich

- Aufmerksamkeit

- Attribute

- Authentifizierung

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- AWS

- Bankinggg

- Bucht

- Blog

- Grenze

- bauen

- Geschäft

- Unternehmen

- rufen Sie uns an!

- Kampagnen

- österreichische Unternehmen

- Fälle

- Kategorie

- Bescheinigung

- Gebühren

- Wahl

- Einstufung

- Cloud

- Code

- verglichen

- Computer

- Vernetz Dich

- Verbindung

- Konsul (Console)

- kostengünstiger

- könnte

- Land

- erstellen

- erstellt

- Referenzen

- Kunde

- Kunden

- technische Daten

- Datensatz

- Datenbase

- Datenbanken

- liefert

- Lieferanten

- Abhängig

- einsetzen

- Bereitstellen

- Desktop

- Bestimmen

- Entwickler:in / Unternehmen

- Entwickler

- anders

- Docker

- nach unten

- Fahrer

- Drop

- im

- leicht

- Ingenieure

- Unternehmen

- Ausrüstung

- Schätzungen

- Beispiel

- Ausführung

- Faktoren

- Vorname

- erstes Mal

- FLOTTE

- konzentriert

- folgen

- Folgende

- Nahrung,

- Francisco cisco~~POS=HEADCOMP

- Funktion

- weiter

- allgemein

- erzeugen

- bekommen

- GitHub

- sehr

- Gruppe an

- Gruppen

- Anleitungen

- Gesundheit

- Gesundheitspflege

- Hilfe

- Unternehmen

- High

- höher

- hoch

- Geschichte

- Ultraschall

- Hilfe

- aber

- HTTPS

- Identitätsschutz

- Image

- implementieren

- Verbesserung

- Verbesserung

- das

- Dazu gehören

- Index

- industriell

- Information

- Infrastruktur

- Innovationen

- installieren

- Versicherung

- integriert

- IT

- Job

- Reise

- Wesentliche

- Labor

- Sprache

- grosse

- starten

- Schicht

- LERNEN

- lernen

- Niveau

- Biowissenschaften

- aussehen

- treu

- Maschine

- Maschinelles Lernen

- gemacht

- halten

- MACHT

- verwalten

- verwaltet

- Management

- flächendeckende Gesundheitsprogramme

- Marketing

- massiv

- Abstimmung

- Mitglieder

- ML

- Modell

- für

- Geld

- Geld

- Überwachung

- mehr

- vor allem warme

- mehrere

- notwendig,

- Notizbuch

- Anzahl

- betreiben

- Optimierung

- Organisationen

- Andere

- Paket

- besondere

- Passwort

- Patch

- AUFMERKSAMKEIT

- Plugin

- Politik durchzulesen

- Datenschutzrichtlinien

- Beliebt

- möglich

- Potenzial

- vorhersagen

- Danach

- früher

- Preis

- primär

- Prozessdefinierung

- anpassen

- Verarbeitung

- Produkt

- PRODUKTIVITÄT

- Profil

- aussichtsreich

- die

- bietet

- Kauf

- Einkäufe

- quantitativ

- schnell

- Bereich

- Roh

- Lesebrillen

- erhalten

- kürzlich

- empfehlen

- Aufzeichnungen

- Zugriffe

- falls angefordert

- Voraussetzungen:

- Downloads

- Die Ergebnisse

- Einzelhandel

- Überprüfen

- Risiko

- Rollen

- Straße

- Führen Sie

- San

- San Francisco

- SC

- skalierbaren

- Skalieren

- WISSENSCHAFTEN

- Wissenschaftler

- Bildschirm

- Suche

- Sekunden

- Verbindung

- Sicherheitdienst

- Sicherheitstoken

- Segment

- Segmentierung

- Segmente

- Serverlos

- Leistungen

- kompensieren

- von Locals geführtes

- kurzfristig

- gezeigt

- ähnlich

- Einfacher

- schlafen

- klein

- So

- Software

- solide

- Lösungen

- einige

- spezialisiert

- Stapel

- begonnen

- Startups

- Lagerung

- speichern

- Studio Adressen

- Erfolgreich

- Support

- System

- Systeme und Techniken

- Reden

- Target

- gezielt

- vorübergehend

- Das

- Durch

- Zeit

- mal

- heute

- gemeinsam

- Zeichen

- Toolkit

- Werkzeuge

- Top

- Handel

- Ausbildung

- -

- Anwendungsfälle

- Nutzer

- Wert

- verschiedene

- Version

- Vertikalen

- Seh-

- Was

- .

- ohne

- arbeiten,

- würde

- Ihr