Da sich Modelle für maschinelles Lernen (ML) verbessert haben, haben Data Scientists, ML-Ingenieure und Forscher ihre Aufmerksamkeit stärker auf die Definition und Verbesserung der Datenqualität verlagert. Dies hat zur Entstehung eines datenzentrierten Ansatzes für ML und verschiedener Techniken zur Verbesserung der Modellleistung durch Fokussierung auf Datenanforderungen geführt. Durch die Anwendung dieser Techniken können ML-Praktiker die Datenmenge reduzieren, die zum Trainieren eines ML-Modells erforderlich ist.

Als Teil dieses Ansatzes sind fortgeschrittene Techniken zur Auswahl von Datenteilmengen aufgetaucht, um das Training zu beschleunigen, indem die Menge der Eingabedaten reduziert wird. Dieser Prozess basiert auf der automatischen Auswahl einer bestimmten Anzahl von Punkten, die sich der Verteilung eines größeren Datensatzes annähern, und deren Verwendung für das Training. Die Anwendung dieser Art von Technik reduziert die zum Trainieren eines ML-Modells erforderliche Zeit.

In diesem Beitrag beschreiben wir die Anwendung datenzentrischer KI-Prinzipien mit Amazon Sagemaker Ground Truth, wie Techniken zur Auswahl von Datenteilmengen mithilfe von implementiert werden KABEL Repository an Amazon Sage Maker wie man die Datenmenge reduziert, die zum Trainieren eines anfänglichen Modells erforderlich ist, und wie man Experimente mit diesem Ansatz durchführt Amazon SageMaker-Experimente.

Ein datenzentrierter Ansatz für maschinelles Lernen

Bevor Sie sich mit fortgeschritteneren datenzentrischen Techniken wie der Auswahl von Datenteilmengen befassen, können Sie Ihre Datensätze auf vielfältige Weise verbessern, indem Sie eine Reihe zugrunde liegender Prinzipien auf Ihren Datenkennzeichnungsprozess anwenden. Dazu unterstützt Ground Truth verschiedene Mechanismen zur Verbesserung der Etikettenkonsistenz und Datenqualität.

Die Beschriftungskonsistenz ist wichtig, um die Modellleistung zu verbessern. Ohne sie können Modelle keine Entscheidungsgrenze erzeugen, die jeden Punkt trennt, der zu unterschiedlichen Klassen gehört. Eine Möglichkeit, Konsistenz sicherzustellen, ist die Verwendung von Annotationskonsolidierung in Ground Truth, wodurch Sie ein bestimmtes Beispiel mehreren Labelerstellern bereitstellen und das bereitgestellte aggregierte Label als Grundwahrheit für dieses Beispiel verwenden können. Abweichungen im Etikett werden anhand des von Ground Truth generierten Konfidenzwerts gemessen. Wenn es Abweichungen bei den Etiketten gibt, sollten Sie nachsehen, ob es Unklarheiten in den Etikettieranweisungen für Ihre Etikettierer gibt, die entfernt werden können. Dieser Ansatz mildert die Auswirkungen der Voreingenommenheit einzelner Etikettierer, was von zentraler Bedeutung ist, um Etiketten konsistenter zu machen.

Eine weitere Möglichkeit, die Modellleistung durch Konzentration auf Daten zu verbessern, besteht darin, Methoden zur Analyse von Fehlern in Beschriftungen zu entwickeln, sobald diese auftreten, um die wichtigste Teilmenge von Daten zu identifizieren, die verbessert werden können. Sie können dies für Ihren Trainingsdatensatz mit einer Kombination aus manuellem Aufwand tun, indem Sie in beschriftete Beispiele eintauchen und die verwenden Amazon CloudWatch Protokolle und Metriken, die von Ground Truth-Kennzeichnungsaufträgen generiert werden. Es ist auch wichtig, sich die Fehler anzusehen, die das Modell zum Zeitpunkt der Inferenz macht, um die nächste Iteration der Beschriftung für unseren Datensatz voranzutreiben. Zusätzlich zu diesen Mechanismen Amazon SageMaker klären ermöglicht es Datenwissenschaftlern und ML-Ingenieuren, Algorithmen wie auszuführen KernelSHAP um es ihnen zu ermöglichen, Vorhersagen ihres Modells zu interpretieren. Wie bereits erwähnt, kann eine tiefere Erklärung der Vorhersagen des Modells auf den anfänglichen Kennzeichnungsprozess zurückgeführt werden, um ihn zu verbessern.

Schließlich können Sie erwägen, verrauschte oder übermäßig redundante Beispiele wegzuwerfen. Auf diese Weise können Sie die Trainingszeit verkürzen, indem Sie Beispiele entfernen, die nicht zur Verbesserung der Modellleistung beitragen. Die manuelle Identifizierung einer nützlichen Teilmenge eines gegebenen Datensatzes ist jedoch schwierig und zeitaufwändig. Die Anwendung der in diesem Beitrag beschriebenen Techniken zur Auswahl von Datenteilmengen ermöglicht es Ihnen, diesen Prozess entlang etablierter Frameworks zu automatisieren.

Anwendungsfall

Wie bereits erwähnt, konzentriert sich die datenzentrierte KI eher auf die Verbesserung der Modelleingabe als auf die Architektur des Modells selbst. Nachdem Sie diese Prinzipien während der Datenbeschriftung oder Featureentwicklung angewendet haben, können Sie sich weiterhin auf die Modelleingabe konzentrieren, indem Sie die Auswahl von Datenteilmengen zur Trainingszeit anwenden.

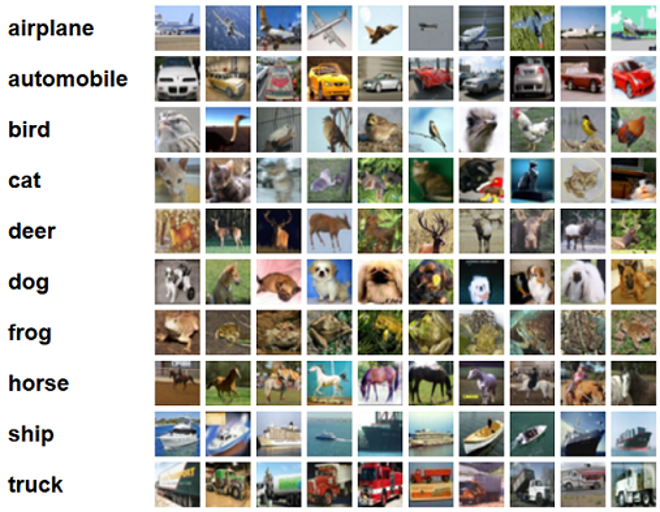

Für diesen Beitrag wenden wir die verallgemeinerungsbasierte Datenteilmengenauswahl für effizientes und robustes Lernen an (GLISTER), die eine von vielen im CORDS-Repository implementierten Techniken zur Auswahl von Datenuntermengen ist, zum Trainingsalgorithmus von a ResNet-18 Modell, um die Zeit zu minimieren, die zum Trainieren eines Modells zum Klassifizieren benötigt wird CIFAR-10 Bilder. Im Folgenden finden Sie einige Beispielbilder mit ihren jeweiligen Beschriftungen aus dem CIFAR-10-Datensatz.

ResNet-18 wird häufig für Klassifizierungsaufgaben verwendet. Es ist ein 18-schichtiges Deep Convolutional Neural Network. Der CIFAR-10-Datensatz wird häufig verwendet, um die Gültigkeit verschiedener Techniken und Ansätze in ML zu bewerten. Es besteht aus 60,000 32×32-Farbbildern, die in 10 Klassen beschriftet sind.

In den folgenden Abschnitten zeigen wir, wie GLISTER Sie bei der Beantwortung der folgenden Frage bis zu einem gewissen Grad unterstützen kann:

Wie viel Prozent eines bestimmten Datensatzes können wir verwenden und trotzdem eine gute Modellleistung während des Trainings erzielen?

Wenn Sie GLISTER auf Ihren Trainingsalgorithmus anwenden, wird Bruch als Hyperparameter in Ihren Trainingsalgorithmus eingeführt. Dies stellt den Prozentsatz des angegebenen Datensatzes dar, den Sie verwenden möchten. Wie bei jedem Hyperparameter erfordert das Finden des Werts, der das beste Ergebnis für Ihr Modell und Ihre Daten liefert, eine Feinabstimmung. Wir gehen in diesem Beitrag nicht näher auf das Hyperparameter-Tuning ein. Weitere Informationen finden Sie unter Optimieren Sie Hyperparameter mit Amazon SageMaker Automatic Model Tuning.

Wir führen mehrere Tests mit SageMaker-Experimenten durch, um die Auswirkungen des Ansatzes zu messen. Die Ergebnisse variieren je nach Ausgangsdatensatz, daher ist es wichtig, den Ansatz anhand unserer Daten bei unterschiedlichen Teilmengengrößen zu testen.

Obwohl wir die Verwendung von GLISTER auf Bildern besprechen, können Sie es auch auf Trainingsalgorithmen anwenden, die mit strukturierten oder tabellarischen Daten arbeiten.

Auswahl von Datenteilmengen

Der Zweck der Datenteilmengenauswahl besteht darin, den Trainingsprozess zu beschleunigen und gleichzeitig die Auswirkungen auf die Genauigkeit zu minimieren und die Robustheit des Modells zu erhöhen. Genauer gesagt wählt GLISTER-ONLINE beim Lernen des Modells eine Teilmenge aus, indem es versucht, die Log-Wahrscheinlichkeit dieser Teilmenge der Trainingsdaten auf der von Ihnen angegebenen Validierungsmenge zu maximieren. Die Optimierung der Datenteilmengenauswahl auf diese Weise mildert das Rauschen und das Klassenungleichgewicht, das häufig in realen Datensätzen zu finden ist, und ermöglicht die Anpassung der Teilmengenauswahlstrategie, wenn das Modell lernt.

Die anfängliche GLISTER-Papier beschreibt einen Kompromiss zwischen Beschleunigung und Genauigkeit bei verschiedenen Größen von Datenteilmengen, wie unter Verwendung von a LeNet Modell:

| Teilmengengröße | Speedup | Genauigkeit |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

Um das Modell zu trainieren, führen wir a SageMaker-Ausbildungsjob Verwenden eines benutzerdefinierten Trainingsskripts. Auch unseren Bilddatensatz haben wir bereits auf hochgeladen Amazon Simple Storage-Service (Amazon S3). Wie bei jedem SageMaker-Trainingsjob müssen wir eine definieren Estimator Objekt. Der PyTorch-Schätzer aus der sagemaker.pytorch -Paket können wir unser eigenes Trainingsskript in einem verwalteten PyTorch-Container ausführen. Der inputs Variable, die an den Schätzer übergeben wird .fit -Funktion enthält ein Wörterbuch des S3-Speicherorts des Trainings- und Validierungsdatasets.

Das train.py -Skript wird ausgeführt, wenn ein Trainingsjob gestartet wird. In diesem Skript importieren wir das ResNet-18-Modell aus der CORDS-Bibliothek und übergeben ihm die Anzahl der Klassen in unserem Datensatz wie folgt:

Dann verwenden wir die gen_dataset Funktion von CORDS zum Erstellen von Trainings-, Validierungs- und Testdatensätzen:

Aus jedem Datensatz erstellen wir einen äquivalenten PyTorch-Dataloader:

Schließlich verwenden wir diese Dataloader, um eine zu erstellen GLISTERDataLoader aus der CORDS-Bibliothek. Es verwendet eine Implementierung der GLISTER-ONLINE-Auswahlstrategie, die eine Teilmengenauswahl anwendet, wenn wir das Modell während des Trainings aktualisieren, wie zuvor in diesem Beitrag besprochen.

Um das Objekt zu erstellen, übergeben wir die Auswahlstrategie-spezifischen Argumente als a DotMap Objekt zusammen mit dem train_loader, validation_loader und logger:

Das GLISTERDataLoader kann jetzt als regulärer Dataloader auf eine Trainingsschleife angewendet werden. Es wählt Datenteilmengen für den nächsten Trainingsstapel aus, während das Modell basierend auf dem Verlust dieses Modells lernt. Wie in der vorangehenden Tabelle gezeigt, ermöglicht uns das Hinzufügen einer Datenteilmengen-Auswahlstrategie, die Trainingszeit erheblich zu verkürzen, sogar mit dem zusätzlichen Schritt der Datenteilmengen-Auswahl, ohne Kompromisse bei der Genauigkeit einzugehen.

Datenwissenschaftler und ML-Ingenieure müssen häufig die Gültigkeit eines Ansatzes bewerten, indem sie ihn mit einer Basislinie vergleichen. Wie das geht, zeigen wir im nächsten Abschnitt.

Experiment-Tracking

Sie können SageMaker-Experimente verwenden, um die Gültigkeit des Ansatzes zur Auswahl von Datenteilmengen zu messen. Weitere Informationen finden Sie unter Amazon SageMaker-Experimente der nächsten Generation – Organisieren, verfolgen und vergleichen Sie Ihre Schulungen zum maschinellen Lernen im großen Maßstab.

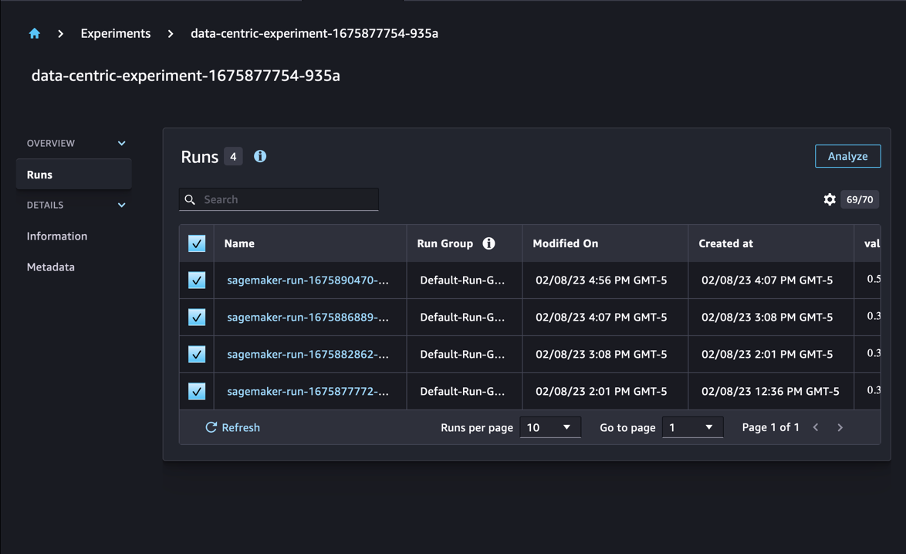

In unserem Fall führen wir vier Experimente durch: eine Basislinie ohne Anwendung der Datenteilmengenauswahl und drei weitere mit abweichenden fraction Parameter, die die Größe der Teilmenge im Verhältnis zum Gesamtdatensatz darstellen. Natürlich mit einem kleineren fraction -Parameter sollte zu verkürzten Trainingszeiten führen, aber auch zu einer geringeren Modellgenauigkeit.

Für diesen Posten wird jeder Trainingslauf als dargestellt Run in SageMaker-Experimenten. Die Läufe, die sich auf unser Experiment beziehen, sind alle unter einem zusammengefasst Experiment Objekt. Läufe können beim Erstellen an ein gemeinsames Experiment angehängt werden Estimator mit dem SDK. Siehe folgenden Code:

Als Teil Ihres benutzerdefinierten Trainingsskripts können Sie Laufmetriken sammeln, indem Sie verwenden load_run:

Dann können Sie unter Verwendung des von der vorherigen Operation zurückgegebenen Ausführungsobjekts Datenpunkte pro Epoche durch Aufrufen sammeln run.log_metric(name, value, step) und Bereitstellen des Metriknamens, -werts und der aktuellen Epochennummer.

Um die Gültigkeit unseres Ansatzes zu messen, erfassen wir Metriken, die dem Trainingsverlust, der Trainingsgenauigkeit, dem Validierungsverlust, der Validierungsgenauigkeit und der Zeit bis zum Abschluss einer Epoche entsprechen. Dann, nachdem wir die Trainingsjobs ausgeführt haben, können wir das tun Überprüfen Sie die Ergebnisse unseres Experiments in Amazon SageMaker-Studio oder über das SageMaker Experiments SDK.

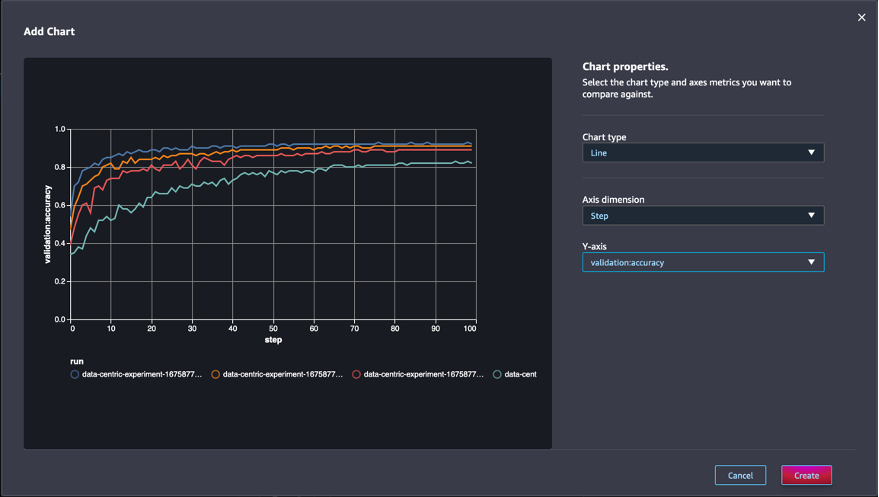

Um Validierungsgenauigkeiten in Studio anzuzeigen, wählen Sie Analysieren auf dem Versuch Läuft

Fügen Sie ein Diagramm hinzu, legen Sie die Diagrammeigenschaften fest und wählen Sie aus Erstellen. Wie im folgenden Screenshot gezeigt, sehen Sie ein Diagramm der Validierungsgenauigkeiten in jeder Epoche für alle Läufe.

Mit dem SDK können Sie auch experimentbezogene Informationen als Pandas-Datenrahmen abrufen:

Optional können die Trainingsjobs sortiert werden. Zum Beispiel könnten wir hinzufügen "metrics.validation:accuracy.max" als der Wert des sort_by Parameter übergeben an ExperimentAnalytics um das nach Validierungsgenauigkeit geordnete Ergebnis zurückzugeben.

Wie erwartet zeigen unsere Experimente, dass die Anwendung von GLISTER und der Datenteilmengenauswahl auf den Trainingsalgorithmus die Trainingszeit reduziert. Beim Ausführen unseres Baseline-Trainingsalgorithmus liegt die mittlere Zeit zum Abschließen einer einzelnen Epoche bei etwa 27 Sekunden. Im Gegensatz dazu führt die Anwendung von GLISTER zur Auswahl einer Teilmenge, die 50 %, 30 % und 10 % des Gesamtdatensatzes entspricht, zu einer Zeitdauer von etwa 13, 8.5 bzw. 2.75 Sekunden zum Abschließen einer Epoche auf ml.p3.2xlarge-Instanzen .

Wir beobachten auch einen vergleichsweise geringen Einfluss auf die Validierungsgenauigkeit, insbesondere bei Verwendung von Datenteilmengen von 50 %. Nach dem Training für 100 Epochen erzeugt die Basislinie eine Validierungsgenauigkeit von 92.72 %. Im Gegensatz dazu führt die Anwendung von GLISTER zur Auswahl einer Teilmenge, die 50 %, 30 % und 10 % des Gesamtdatensatzes entspricht, zu Validierungsgenauigkeiten von 91.42 %, 89.76 % bzw. 82.82 %.

Zusammenfassung

SageMaker Ground Truth und SageMaker Experiments ermöglichen einen datenzentrierten Ansatz für maschinelles Lernen, indem Datenwissenschaftler und ML-Ingenieure konsistentere Datensätze erstellen und die Auswirkungen fortschrittlicherer Techniken verfolgen können, wenn sie diese in der Modellerstellungsphase implementieren. Durch die Implementierung eines datenzentrierten ML-Ansatzes können Sie die für Ihr Modell erforderliche Datenmenge reduzieren und seine Robustheit verbessern.

Probieren Sie es aus und teilen Sie uns Ihre Meinung in den Kommentaren mit.

Über die Autoren

Nikolaus Bernier ist Lösungsarchitekt und Teil des kanadischen Teams für den öffentlichen Sektor bei AWS. Er führt derzeit einen Master-Abschluss mit einem Forschungsgebiet in Deep Learning durch und besitzt fünf AWS-Zertifizierungen, darunter die ML Specialty Certification. Nicolas ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, ihr Wissen über AWS zu vertiefen, indem er mit ihnen zusammenarbeitet, um ihre geschäftlichen Herausforderungen in technische Lösungen umzusetzen.

Nikolaus Bernier ist Lösungsarchitekt und Teil des kanadischen Teams für den öffentlichen Sektor bei AWS. Er führt derzeit einen Master-Abschluss mit einem Forschungsgebiet in Deep Learning durch und besitzt fünf AWS-Zertifizierungen, darunter die ML Specialty Certification. Nicolas ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, ihr Wissen über AWS zu vertiefen, indem er mit ihnen zusammenarbeitet, um ihre geschäftlichen Herausforderungen in technische Lösungen umzusetzen.

Givanildo Alves ist ein Prototyping-Architekt im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, der Kunden hilft, Innovationen zu entwickeln und zu beschleunigen, indem er die Kunst des Möglichen auf AWS zeigt, nachdem er bereits mehrere Prototypen rund um künstliche Intelligenz implementiert hat. Er blickt auf eine lange Karriere im Software Engineering zurück und arbeitete zuvor als Software Development Engineer bei Amazon.com.br.

Givanildo Alves ist ein Prototyping-Architekt im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, der Kunden hilft, Innovationen zu entwickeln und zu beschleunigen, indem er die Kunst des Möglichen auf AWS zeigt, nachdem er bereits mehrere Prototypen rund um künstliche Intelligenz implementiert hat. Er blickt auf eine lange Karriere im Software Engineering zurück und arbeitete zuvor als Software Development Engineer bei Amazon.com.br.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :Ist

- $UP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- Über uns

- beschleunigen

- Genauigkeit

- Erreichen

- über

- automatisch

- Zusatz

- Zusätzliche

- advanced

- Nach der

- gegen

- AI

- Algorithmus

- Algorithmen

- Alle

- Zulassen

- erlaubt

- bereits

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Amazon.com

- Mehrdeutigkeit

- Betrag

- Analytik

- analysieren

- und

- beantworten

- angewandt

- Jetzt bewerben

- Anwendung

- Ansatz

- Ansätze

- Architektur

- SIND

- Bereich

- Argumente

- um

- Kunst

- künstlich

- künstliche Intelligenz

- AS

- At

- versuchen

- Aufmerksamkeit

- automatisieren

- automatische

- Im Prinzip so, wie Sie es von Google Maps kennen.

- AWS

- Zurück

- basierend

- Baseline

- BE

- BESTE

- vorspannen

- Building

- Geschäft

- by

- Aufruf

- CAN

- kanadischen

- Karriere

- Häuser

- Hauptgeschäftsstelle

- Zertifizierung

- Zertifizierungen

- Herausforderungen

- Chart

- Auswählen

- Klasse

- Unterricht

- Einstufung

- klassifizieren

- Kunden

- Cloud

- Code

- sammeln

- Farbe

- COM

- Kombination

- wie die

- Bemerkungen

- gemeinsam

- verhältnismäßig

- vergleichen

- Vergleich

- abschließen

- zusammengesetzt

- Leitung

- Vertrauen

- Geht davon

- konsistent

- Festigung

- Container

- enthält

- fortsetzen

- Kontrast

- beitragen

- Dazugehörigen

- könnte

- erstellen

- Erstellen

- Strom

- Zur Zeit

- Original

- Kunden

- technische Daten

- Datenpunkte

- Datensätze

- Entscheidung

- tief

- tiefe Lernen

- Vertiefen

- tiefer

- Definition

- Grad

- zeigen

- weisen nach, dass

- Abhängig

- Tiefe

- beschreiben

- beschrieben

- Entwicklung

- Entwicklung

- anders

- verschieden

- schwer

- diskutieren

- diskutiert

- Verteilung

- Divergenz

- Dabei

- Nicht

- Antrieb

- im

- jeder

- Früher

- Effekten

- effizient

- Bemühungen

- Entstehung

- ermöglichen

- Ingenieur

- Entwicklung

- Ingenieure

- gewährleisten

- Epoche

- Epochen

- Äquivalent

- Fehler

- insbesondere

- etablierten

- bewerten

- Sogar

- Jedes

- Beispiel

- Beispiele

- erwartet

- Experiment

- Erklärung

- Merkmal

- Suche nach

- Setzen Sie mit Achtsamkeit

- konzentriert

- Fokussierung

- gefolgt

- Folgende

- folgt

- Aussichten für

- gefunden

- Fraktion

- Gerüste

- für

- Funktion

- erzeugt

- Generation

- gegeben

- Go

- gut

- Boden

- Haben

- mit

- Hilfe

- Unternehmen

- hält

- Ultraschall

- Hilfe

- aber

- HTML

- http

- HTTPS

- Hyperparameter-Tuning

- identifizieren

- Identifizierung

- Image

- Bilder

- Unausgewogenheit

- Impact der HXNUMXO Observatorien

- implementieren

- Implementierung

- umgesetzt

- Umsetzung

- importieren

- wichtig

- zu unterstützen,

- verbessert

- Verbesserung

- in

- Einschließlich

- zunehmend

- Krankengymnastik

- Information

- Anfangs-

- wir innovieren

- Varianten des Eingangssignals:

- Instanz

- Anleitung

- Intelligenz

- einführen

- IT

- Iteration

- SEINE

- selbst

- Job

- Jobs

- Wissen

- Wissen

- Label

- Beschriftung

- Etiketten

- größer

- ins Leben gerufen

- lernen

- geführt

- Bibliothek

- Gefällt mir

- Liste

- wenig

- Standorte

- Lang

- aussehen

- Verlust

- Maschine

- Maschinelles Lernen

- gemacht

- MACHT

- Making

- verwaltet

- manuell

- manuell

- viele

- Meister

- max

- Maximieren

- messen

- erwähnt

- Methoden

- Metrisch

- Metrik

- minimal

- minimieren

- ML

- Modell

- für

- mehr

- vor allem warme

- mehrere

- Name

- Need

- Netzwerk

- neuronale Netzwerk

- weiter

- Nicolas

- Lärm

- Anzahl

- Objekt

- beobachten

- of

- on

- EINEM

- Betrieb

- Optimierung

- Anders

- Gesamt-

- besitzen

- Paket

- Seite

- Pandas

- Parameter

- Parameter

- Teil

- Bestanden

- leidenschaftlich

- Prozentsatz

- Ausführen

- Leistung

- Phase

- Plato

- Datenintelligenz von Plato

- PlatoData

- Points

- Punkte

- möglich

- Post

- Prognosen

- früher

- vorher

- Grundsätze

- Prozessdefinierung

- produziert

- immobilien

- Prototypen

- Prototyping

- vorausgesetzt

- Öffentlichkeit

- Zweck

- Pytorch

- Qualität

- Menge

- Frage

- lieber

- realen Welt

- Veteran

- Reduziert

- reduziert

- Reduzierung

- Region

- regulär

- bezogene

- Entfernt

- Entfernen

- Quelle

- vertreten

- representiert

- falls angefordert

- Voraussetzungen:

- erfordert

- Forschungsprojekte

- Forscher

- diejenigen

- Folge

- Die Ergebnisse

- Rückkehr

- robust

- Robustheit

- Führen Sie

- Laufen

- sagemaker

- Wissenschaftler

- Sdk

- Sekunden

- Abschnitt

- Abschnitte

- Bibliotheken

- Auswahl

- Auswahl

- brauchen

- Dienstleistungen

- Sitzung

- kompensieren

- mehrere

- sollte

- erklären

- gezeigt

- bedeutend

- Einfacher

- Single

- Größe

- Größen

- kleinere

- So

- Software

- Software-Entwicklung

- Softwareentwicklung

- Lösungen

- einige

- Quelle

- Spezialprodukte

- spezifisch

- speziell

- Geschwindigkeit

- Schritt

- Immer noch

- Lagerung

- Strategie

- strukturierte

- Studio Adressen

- Zuführung

- Unterstützt

- Tabelle

- nimmt

- und Aufgaben

- Team

- Technische

- Techniken

- Test

- Tests

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- nach drei

- Durch

- Zeit

- mal

- zu

- Fackel

- toronto

- verfolgen sind

- Training

- Ausbildung

- Schulungen

- Übersetzen

- für

- zugrunde liegen,

- Aktualisierung

- hochgeladen

- us

- -

- Bestätigung

- Wert

- verschiedene

- Anzeigen

- Weg..

- Wege

- Netz

- Web-Services

- GUT

- Was

- welche

- während

- werden wir

- mit

- .

- ohne

- gearbeitet

- arbeiten,

- Du

- Ihr

- Zephyrnet