Πρόσφατα μεγάλα γλωσσικά μοντέλα (LLM) επέτρεψαν τεράστια πρόοδο στην κατανόηση φυσικής γλώσσας. Ωστόσο, είναι επιρρεπείς στη δημιουργία σίγουρων αλλά παράλογων εξηγήσεων, γεγονός που αποτελεί σημαντικό εμπόδιο για την εδραίωση εμπιστοσύνης με τους χρήστες. Σε αυτήν την ανάρτηση, δείχνουμε πώς να ενσωματώνουμε την ανθρώπινη ανατροφοδότηση σχετικά με τις λανθασμένες αλυσίδες συλλογισμού για τη συλλογιστική πολλαπλών βημάτων για τη βελτίωση της απόδοσης σε αυτές τις εργασίες. Αντί να συλλέγουμε τις αλυσίδες συλλογισμού από το μηδέν ρωτώντας τους ανθρώπους, αντίθετα μαθαίνουμε από την πλούσια ανθρώπινη ανατροφοδότηση σχετικά με αλυσίδες συλλογισμού που δημιουργούνται από μοντέλα χρησιμοποιώντας τις ικανότητες προτροπής των LLM. Συλλέγουμε δύο τέτοια σύνολα δεδομένων ανθρώπινης ανατροφοδότησης με τη μορφή (διόρθωση, επεξήγηση, τύπος σφάλματος) για σύνολα δεδομένων StrategyQA και Sports Understanding και αξιολογούμε αρκετούς κοινούς αλγόριθμους για να μάθουμε από τέτοια σχόλια. Οι προτεινόμενες μέθοδοί μας αποδίδουν ανταγωνιστικά σε σχέση με την προτροπή αλυσίδας σκέψης χρησιμοποιώντας τη βάση Flan-T5 και η δική μας είναι καλύτερη στο να κρίνει την ορθότητα της δικής της απάντησης.

Επισκόπηση λύσεων

Με την έναρξη των μεγάλων γλωσσικών μοντέλων, το πεδίο έχει σημειώσει τεράστια πρόοδο σε διάφορα σημεία αναφοράς επεξεργασίας φυσικής γλώσσας (NLP). Μεταξύ αυτών, η πρόοδος ήταν εντυπωσιακή σε σχετικά απλούστερες εργασίες, όπως η σύντομη απάντηση σε συμφραζόμενα ή πραγματικές ερωτήσεις, σε σύγκριση με πιο δύσκολες εργασίες που απαιτούν συλλογισμό, όπως η απάντηση σε ερωτήσεις πολλαπλών βημάτων. Η απόδοση ορισμένων εργασιών που χρησιμοποιούν LLM μπορεί να είναι παρόμοια με την τυχαία εικασία σε μικρότερες κλίμακες, αλλά βελτιώνεται σημαντικά σε μεγαλύτερες κλίμακες. Παρόλα αυτά, οι προτρεπτικές ικανότητες των LLM έχουν τη δυνατότητα να παρέχουν ορισμένα σχετικά στοιχεία που απαιτούνται για την απάντηση στην ερώτηση.

Ωστόσο, αυτά τα μοντέλα ενδέχεται να μην δημιουργούν αξιόπιστες αλυσίδες συλλογισμού ή επεξηγήσεις. Αυτές οι σίγουρες αλλά παράλογες εξηγήσεις είναι ακόμη πιο διαδεδομένες όταν οι LLM εκπαιδεύονται χρησιμοποιώντας την Ενισχυτική Μάθηση από την Ανθρώπινη Ανατροφοδότηση (RLHF), όπου μπορεί να συμβεί hacking ανταμοιβής.

Παρακινούμενοι από αυτό, προσπαθούμε να απαντήσουμε στο ακόλουθο ερευνητικό ερώτημα: μπορούμε να βελτιώσουμε τη συλλογιστική των LLM μαθαίνοντας από την ανθρώπινη ανατροφοδότηση σε αλυσίδες συλλογισμού που δημιουργούνται από μοντέλα; Το παρακάτω σχήμα παρέχει μια επισκόπηση της προσέγγισής μας: πρώτα ζητάμε από το μοντέλο να δημιουργήσει αλυσίδες συλλογισμού για ερωτήσεις πολλαπλών λυμάτων, στη συνέχεια συλλέγουμε ποικίλα ανθρώπινα σχόλια για αυτές τις αλυσίδες για διάγνωση και προτείνουμε αλγόριθμους εκπαίδευσης για να μάθουμε από τα δεδομένα που συλλέγονται.

Συλλέγουμε ποικίλα ανθρώπινα σχόλια για δύο σύνολα δεδομένων συλλογισμού πολλαπλών λυμάτων, το StrategyQA και το Sports Understanding από το BigBench. Για κάθε ερώτηση και συλλογιστική αλυσίδα που δημιουργείται από το μοντέλο, συλλέγουμε τη σωστή αλυσίδα συλλογισμού, τον τύπο του σφάλματος στην αλυσίδα συλλογιστικής που δημιουργείται από το μοντέλο και μια περιγραφή (σε φυσική γλώσσα) του γιατί αυτό το σφάλμα παρουσιάζεται στην παρεχόμενη συλλογιστική αλυσίδα. Το τελικό σύνολο δεδομένων περιέχει σχόλια για 1,565 δείγματα από το StrategyQA και 796 παραδείγματα για Sports Understanding.

Προτείνουμε πολλαπλούς αλγόριθμους εκπαίδευσης για να μάθουμε από τα συλλεγόμενα σχόλια. Πρώτον, προτείνουμε μια παραλλαγή αυτοσυνέπειας στην προτροπή της αλυσίδας σκέψης εξετάζοντας μια σταθμισμένη παραλλαγή της που μπορεί να μαθευτεί από την ανατροφοδότηση. Δεύτερον, προτείνουμε επαναληπτική βελτίωση, όπου βελτιώνουμε επαναληπτικά την αλυσίδα συλλογισμού που δημιουργείται από το μοντέλο μέχρι να είναι σωστή. Αποδεικνύουμε εμπειρικά στα δύο σύνολα δεδομένων ότι η τελειοποίηση ενός LLM, δηλαδή του Flan-T5 χρησιμοποιώντας τους προτεινόμενους αλγόριθμους, αποδίδει συγκρίσιμα με τη βασική γραμμή μάθησης εντός πλαισίου. Το πιο σημαντικό, δείχνουμε ότι το βελτιστοποιημένο μοντέλο είναι καλύτερο να κρίνει αν η δική του απάντηση είναι σωστή σε σύγκριση με το βασικό μοντέλο Flan-T5.

Συλλογή δεδομένων

Σε αυτήν την ενότητα, περιγράφουμε τις λεπτομέρειες των σχολίων που συλλέξαμε και το πρωτόκολλο σχολιασμού που ακολουθήθηκε κατά τη συλλογή δεδομένων. Συλλέξαμε σχόλια για γενιές μοντέλων με βάση δύο σύνολα δεδομένων που βασίζονται σε συλλογισμούς: StrategyQA και Sports Understanding από το BigBench. Χρησιμοποιήσαμε το GPT-J για να δημιουργήσουμε την απάντηση για το StrategyQA και το Flan-T5 για να δημιουργήσουμε την απάντηση για το σύνολο δεδομένων Sports Understanding. Σε κάθε περίπτωση, το μοντέλο ζητήθηκε με k παραδείγματα εντός του πλαισίου που περιείχαν ερώτηση, απάντηση και επεξήγηση, ακολουθούμενα από την ερώτηση δοκιμής.

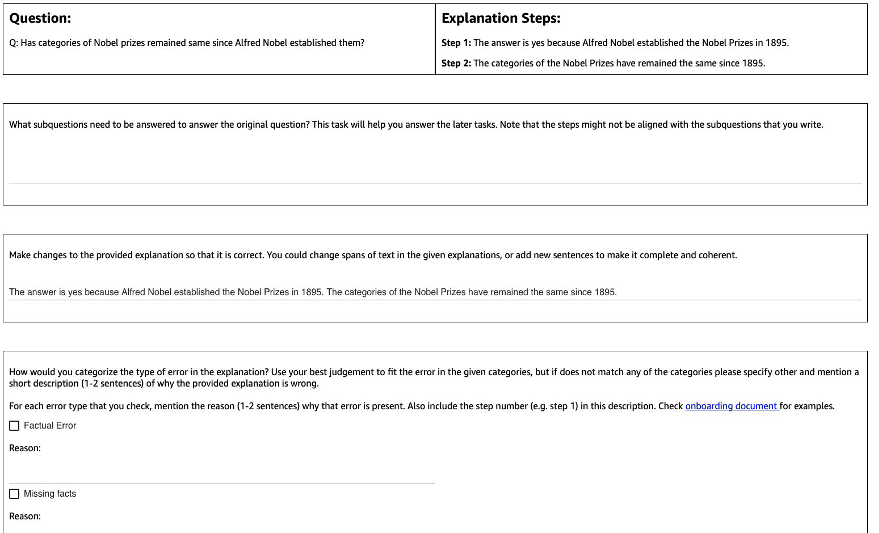

Το παρακάτω σχήμα δείχνει τη διεπαφή που χρησιμοποιήσαμε. Στους σχολιαστές δίνεται η ερώτηση, η απάντηση που δημιουργείται από το μοντέλο και η εξήγηση χωρίζεται σε βήματα.

Για κάθε ερώτηση, συλλέξαμε τα ακόλουθα σχόλια:

- Υποερωτήματα – Οι σχολιαστές αποσυνθέτουν την αρχική ερώτηση σε απλούστερες υποερωτήσεις που απαιτούνται για την απάντηση στην αρχική ερώτηση. Αυτή η εργασία προστέθηκε μετά από ένα πιλοτικό όπου διαπιστώσαμε ότι η προσθήκη αυτής της εργασίας βοηθά στην προετοιμασία των σχολιαστών και στη βελτίωση της ποιότητας των υπόλοιπων εργασιών.

- Διόρθωση – Στους σχολιαστές παρέχεται ένα πλαίσιο κειμένου ελεύθερης μορφής, προσυμπληρωμένο με την απάντηση και την επεξήγηση που δημιουργήθηκε από το μοντέλο και ζητείται να το επεξεργαστούν για να λάβουν τη σωστή απάντηση και επεξήγηση.

- Τύπος σφάλματος – Μεταξύ των πιο συνηθισμένων τύπων σφαλμάτων που βρήκαμε στις γενιές μοντέλων (Πραγματικό σφάλμα, Στοιχεία που λείπουν, Άσχετα γεγονότα και Λογική Ασυνέπεια), ζητήθηκε από τους σχολιαστές να επιλέξουν έναν ή περισσότερους από τους τύπους σφαλμάτων που ισχύουν για τη δεδομένη απάντηση και εξήγηση.

- Περιγραφή σφάλματος – Οι σχολιαστές έλαβαν οδηγίες όχι μόνο να ταξινομούν τα λάθη αλλά και να παρέχουν μια ολοκληρωμένη αιτιολόγηση για την κατηγοριοποίησή τους, συμπεριλαμβανομένης της επισήμανσης του ακριβούς βήματος όπου συνέβη το λάθος και του τρόπου εφαρμογής του στην απάντηση και την εξήγηση που παρέχεται.

Συνηθίζαμε Amazon SageMaker Ground Truth Plus στη συλλογή δεδομένων μας. Η συλλογή δεδομένων πραγματοποιήθηκε σε πολλούς γύρους. Πραγματοποιήσαμε αρχικά δύο μικρά πιλοτικά 30 παραδειγμάτων και 200 παραδειγμάτων, αντίστοιχα, μετά τα οποία δόθηκε στην ομάδα σχολιαστής λεπτομερής ανατροφοδότηση σχετικά με τον σχολιασμό. Στη συνέχεια, πραγματοποιήσαμε τη συλλογή δεδομένων σε δύο παρτίδες για το StrategyQA και πάνω από μία παρτίδα για το Sports Understanding, δίνοντας περιοδικά σχόλια καθ' όλη τη διάρκεια—συνολικά 10 σχολιαστές εργάστηκαν για την εργασία σε μια περίοδο σχεδόν 1 μήνα.

Συγκεντρώσαμε σχόλια για συνολικά 1,565 παραδείγματα για το StrategyQA και 796 παραδείγματα για το Sports Understanding. Ο παρακάτω πίνακας απεικονίζει το ποσοστό των παραδειγμάτων που ήταν χωρίς σφάλματα στη δημιουργία του μοντέλου και το ποσοστό των παραδειγμάτων που περιείχαν έναν συγκεκριμένο τύπο σφάλματος. Αξίζει να σημειωθεί ότι ορισμένα παραδείγματα μπορεί να έχουν περισσότερους από έναν τύπους σφαλμάτων.

| Τύπος σφάλματος | StrategyQA | Αθλητική Κατανόηση |

| Ν/Α | 17.6% | 31.28% |

| Πραγματικό σφάλμα | 27.6% | 38.1% |

| Γεγονότα που λείπουν | 50.4% | 46.1% |

| Άσχετα Γεγονότα | 14.6% | 3.9% |

| Λογική ασυνέπεια | 11.2% | 5.2% |

Αλγόριθμοι μάθησης

Για κάθε ερώτηση q, και απάντηση και εξήγηση που δημιουργείται από το μοντέλο m, συλλέξαμε τα ακόλουθα σχόλια: σωστή απάντηση και επεξήγηση c, τύπος σφάλματος που υπάρχει σε m (υποδηλώνεται με t), και περιγραφή σφάλματος d, όπως περιγράφεται στην προηγούμενη ενότητα.

Χρησιμοποιήσαμε τις ακόλουθες μεθόδους:

- Εκμάθηση πολλαπλών εργασιών – Μια απλή βασική γραμμή για να μάθετε από τα ποικίλα διαθέσιμα σχόλια είναι να αντιμετωπίζετε καθένα από αυτά ως ξεχωριστή εργασία. Πιο συγκεκριμένα, βελτιστοποιούμε το Flan-T5 (κείμενο σε κείμενο) με τον στόχο μεγιστοποίηση p(c|q) + p(t|q, m) + p(d|q, m). Για κάθε όρο του στόχου, χρησιμοποιούμε μια ξεχωριστή οδηγία κατάλληλη για την εργασία (για παράδειγμα, «Πρόβλεψη σφάλματος στη δοθείσα απάντηση»). Μετατρέπουμε επίσης την κατηγορική μεταβλητή t σε μια πρόταση φυσικής γλώσσας. Κατά την εξαγωγή συμπερασμάτων, χρησιμοποιούμε την οδηγία για τον όρο p(c|q) ("Προβλέψτε τη σωστή απάντηση για τη δεδομένη ερώτηση") για να δημιουργήσετε την απάντηση για την ερώτηση του τεστ.

- Σταθμισμένη αυτοσυνέπεια – Με κίνητρο την επιτυχία της αυτοσυνέπειας στην προτροπή της αλυσίδας σκέψης, προτείνουμε μια σταθμισμένη παραλλαγή της. Αντί να αντιμετωπίζουμε κάθε δειγματοληπτική εξήγηση από το μοντέλο ως σωστή και να λαμβάνουμε υπόψη τη συγκεντρωτική ψήφο, αντ' αυτού εξετάζουμε πρώτα εάν η εξήγηση είναι σωστή και στη συνέχεια συγκεντρώνουμε ανάλογα. Πρώτα βελτιστοποιούμε το Flan-T5 με τον ίδιο στόχο όπως και στην εκμάθηση πολλαπλών εργασιών. Κατά την εξαγωγή συμπερασμάτων, δόθηκε μια δοκιμαστική ερώτηση q, δειγματίζουμε πολλαπλές πιθανές απαντήσεις με την οδηγία για p(c|q)): a1, a2, .., an. Για κάθε δειγματοληπτική απάντηση ai, χρησιμοποιούμε την οδηγία για τον όρο p(t|q, m) ("Προβλέψτε το σφάλμα στη δοθείσα απάντηση") για να προσδιορίσετε εάν περιέχει σφάλμα ti = argmax p(t|q, a_i). Κάθε απάντηση ai του εκχωρείται βάρος 1 εάν είναι σωστό, διαφορετικά του εκχωρείται βάρος μικρότερο από 1 (συντονίσιμη υπερπαράμετρος). Η τελική απάντηση λαμβάνεται λαμβάνοντας υπόψη μια σταθμισμένη ψήφο σε όλες τις απαντήσεις a1 προς την an.

- Επαναληπτική βελτίωση – Στις προηγούμενες προτεινόμενες μεθόδους, το μοντέλο παράγει άμεσα τη σωστή απάντηση c εξαρτάται από την ερώτηση q. Εδώ προτείνουμε να βελτιώσουμε την απάντηση που δημιουργείται από το μοντέλο m για να λάβετε τη σωστή απάντηση σε μια δεδομένη ερώτηση. Πιο συγκεκριμένα, πρώτα βελτιστοποιούμε το Flan-T5 (κείμενο σε κείμενο με τον στόχο) με μεγιστοποίηση p(t; c|q, m), Όπου ; υποδηλώνει τη συνένωση (τύπος σφάλματος t ακολουθούμενη από τη σωστή απάντηση c). Ένας τρόπος για να δείτε αυτόν τον στόχο είναι ότι το μοντέλο εκπαιδεύεται πρώτα για να αναγνωρίζει το σφάλμα σε δεδομένη γενιά m, και στη συνέχεια να αφαιρέσετε αυτό το σφάλμα για να λάβετε τη σωστή απάντηση c. Κατά τη διάρκεια της εξαγωγής συμπερασμάτων, μπορούμε να χρησιμοποιήσουμε το μοντέλο επαναληπτικά έως ότου δημιουργήσει τη σωστή απάντηση — δίνοντας μια δοκιμαστική ερώτηση q, λαμβάνουμε πρώτα την αρχική γενιά του μοντέλου m (χρησιμοποιώντας προεκπαιδευμένο Flan-T5). Στη συνέχεια, δημιουργούμε επαναληπτικά τον τύπο σφάλματος ti και πιθανή σωστή απάντηση ci μέχρι ti = κανένα λάθος (στην πράξη, ορίζουμε έναν μέγιστο αριθμό επαναλήψεων σε μια υπερπαράμετρο), οπότε η τελική σωστή απάντηση θα είναι ci-1 (προέρχεται από p(ti ; ci | q, ci-1)).

Αποτελέσματα

Και για τα δύο σύνολα δεδομένων, συγκρίνουμε όλους τους προτεινόμενους αλγόριθμους μάθησης με τη βασική γραμμή μάθησης εντός πλαισίου. Όλα τα μοντέλα αξιολογούνται στο σύνολο προγραμματιστών StrategyQA και Sports Understanding. Ο παρακάτω πίνακας δείχνει τα αποτελέσματα.

| Μέθοδος | StrategyQA | Αθλητική Κατανόηση |

| Flan-T5 4-shot Chain-of-Thought In-Context Learning | 67.39 ± 2.6% | 58.5% |

| Εκμάθηση πολλαπλών εργασιών | 66.22 ± 0.7% | 54.3 ± 2.1% |

| Σταθμισμένη αυτοσυνέπεια | 61.13 ± 1.5% | 51.3 ± 1.9% |

| Επαναληπτική βελτίωση | 61.85 ± 3.3% | 57.0 ± 2.5% |

Όπως παρατηρήθηκε, ορισμένες μέθοδοι αποδίδουν συγκρίσιμες με τη βασική γραμμή μάθησης εντός πλαισίου (πολλαπλές εργασίες για StrategyQA και επαναληπτική βελτίωση για Sports Understanding), γεγονός που καταδεικνύει τη δυνατότητα συλλογής συνεχούς ανατροφοδότησης από ανθρώπους σχετικά με τα αποτελέσματα μοντέλων και χρήσης αυτών για τη βελτίωση των γλωσσικών μοντέλων. Αυτό διαφέρει από πρόσφατες εργασίες όπως το RLHF, όπου η ανατροφοδότηση περιορίζεται σε κατηγορικές και συνήθως δυαδικές.

Όπως φαίνεται στον παρακάτω πίνακα, διερευνούμε πώς τα μοντέλα προσαρμοσμένα με την ανθρώπινη ανατροφοδότηση σχετικά με λάθη συλλογιστικής μπορούν να βοηθήσουν στη βελτίωση της βαθμονόμησης ή της επίγνωσης των λανθασμένων εξηγήσεων με αυτοπεποίθηση. Αυτό αξιολογείται ζητώντας από το μοντέλο να προβλέψει εάν η δημιουργία του περιέχει σφάλματα.

| Μέθοδος | Διόρθωση λάθους | StrategyQA |

| Flan-T5 4-shot Chain-of-Thought In-Context Learning | Οχι | 30.17% |

| Προσαρμοσμένο μοντέλο πολλαπλών εργασιών | Ναι | 73.98% |

Πιο αναλυτικά, προτρέπουμε το μοντέλο γλώσσας με τη δική του δημιουργημένη αλυσίδα απαντήσεων και συλλογισμών (για την οποία συλλέξαμε ανατροφοδότηση) και, στη συνέχεια, το ζητάμε ξανά να προβλέψει το σφάλμα στη δημιουργία. Χρησιμοποιούμε την κατάλληλη οδηγία για την εργασία («Εντοπισμός σφάλματος στην απάντηση»). Το μοντέλο βαθμολογείται σωστά εάν προβλέπει "κανένα σφάλμα" ή "σωστό" στη δημιουργία, εάν οι σχολιαστές επισήμαναν το παράδειγμα ως χωρίς σφάλμα ή εάν προβλέπει οποιονδήποτε από τους τύπους σφαλμάτων στη γενιά (μαζί με "λανθασμένο" ή " λάθος») όταν οι σχολιαστές το χαρακτήρισαν ότι έχει σφάλμα. Σημειώστε ότι δεν αξιολογούμε την ικανότητα του μοντέλου να προσδιορίζει σωστά τον τύπο σφάλματος, αλλά μάλλον εάν υπάρχει σφάλμα. Η αξιολόγηση πραγματοποιείται σε ένα σύνολο 173 πρόσθετων παραδειγμάτων από το σύνολο προγραμματιστών StrategyQA που συλλέχθηκαν, τα οποία δεν εμφανίζονται κατά τη λεπτομέρεια. Τέσσερα παραδείγματα από αυτά προορίζονται για την προτροπή του μοντέλου γλώσσας (πρώτη σειρά στον προηγούμενο πίνακα).

Σημειώστε ότι δεν εμφανίζουμε το βασικό αποτέλεσμα 0-shot επειδή το μοντέλο δεν μπορεί να δημιουργήσει χρήσιμες απαντήσεις. Παρατηρούμε ότι η χρήση ανθρώπινης ανατροφοδότησης για διόρθωση σφαλμάτων στις αλυσίδες συλλογισμού μπορεί να βελτιώσει την πρόβλεψη του μοντέλου για το εάν κάνει σφάλματα ή όχι, κάτι που μπορεί να βελτιώσει την επίγνωση ή τη βαθμονόμηση των λανθασμένων εξηγήσεων.

Συμπέρασμα

Σε αυτήν την ανάρτηση, δείξαμε πώς να επιμελούμε σύνολα δεδομένων ανθρώπινης ανατροφοδότησης με λεπτομερείς διορθώσεις σφαλμάτων, που είναι ένας εναλλακτικός τρόπος βελτίωσης των συλλογιστικών ικανοτήτων των LLM. Τα πειραματικά αποτελέσματα επιβεβαιώνουν ότι η ανθρώπινη ανατροφοδότηση σχετικά με σφάλματα συλλογισμού μπορεί να βελτιώσει την απόδοση και τη βαθμονόμηση σε δύσκολες ερωτήσεις πολλαπλών βημάτων.

Αν αναζητάτε ανθρώπινη ανατροφοδότηση για να βελτιώσετε τα μεγάλα γλωσσικά μοντέλα σας, επισκεφτείτε το Ετικέτα δεδομένων Amazon SageMaker και την κονσόλα Ground Truth Plus.

Σχετικά με τους Συγγραφείς

Έρραν Λι είναι ο διευθυντής εφαρμοσμένης επιστήμης στις υπηρεσίες humain-in-the-loop, AWS AI, Amazon. Τα ερευνητικά του ενδιαφέροντα είναι η τρισδιάστατη βαθιά μάθηση και η εκμάθηση όρασης και γλωσσικής αναπαράστασης. Προηγουμένως ήταν ανώτερος επιστήμονας στην Alexa AI, επικεφαλής μηχανικής μάθησης στο Scale AI και επικεφαλής επιστήμονας στο Pony.ai. Πριν από αυτό, ήταν με την ομάδα αντίληψης στο Uber ATG και την ομάδα της πλατφόρμας μηχανικής μάθησης στην Uber που εργαζόταν στη μηχανική μάθηση για αυτόνομη οδήγηση, συστήματα μηχανικής μάθησης και στρατηγικές πρωτοβουλίες AI. Ξεκίνησε την καριέρα του στο Bell Labs και ήταν επίκουρος καθηγητής στο Πανεπιστήμιο Columbia. Δίδαξε μαζί σεμινάρια στα ICML'3 και ICCV'17 και συνδιοργάνωσε πολλά εργαστήρια στα NeurIPS, ICML, CVPR, ICCV σχετικά με τη μηχανική μάθηση για αυτόνομη οδήγηση, την τρισδιάστατη όραση και τη ρομποτική, τα συστήματα μηχανικής μάθησης και την αντίπαλη μηχανική μάθηση. Έχει διδακτορικό στην επιστήμη των υπολογιστών στο Πανεπιστήμιο Cornell. Είναι ACM Fellow και IEEE Fellow.

Έρραν Λι είναι ο διευθυντής εφαρμοσμένης επιστήμης στις υπηρεσίες humain-in-the-loop, AWS AI, Amazon. Τα ερευνητικά του ενδιαφέροντα είναι η τρισδιάστατη βαθιά μάθηση και η εκμάθηση όρασης και γλωσσικής αναπαράστασης. Προηγουμένως ήταν ανώτερος επιστήμονας στην Alexa AI, επικεφαλής μηχανικής μάθησης στο Scale AI και επικεφαλής επιστήμονας στο Pony.ai. Πριν από αυτό, ήταν με την ομάδα αντίληψης στο Uber ATG και την ομάδα της πλατφόρμας μηχανικής μάθησης στην Uber που εργαζόταν στη μηχανική μάθηση για αυτόνομη οδήγηση, συστήματα μηχανικής μάθησης και στρατηγικές πρωτοβουλίες AI. Ξεκίνησε την καριέρα του στο Bell Labs και ήταν επίκουρος καθηγητής στο Πανεπιστήμιο Columbia. Δίδαξε μαζί σεμινάρια στα ICML'3 και ICCV'17 και συνδιοργάνωσε πολλά εργαστήρια στα NeurIPS, ICML, CVPR, ICCV σχετικά με τη μηχανική μάθηση για αυτόνομη οδήγηση, την τρισδιάστατη όραση και τη ρομποτική, τα συστήματα μηχανικής μάθησης και την αντίπαλη μηχανική μάθηση. Έχει διδακτορικό στην επιστήμη των υπολογιστών στο Πανεπιστήμιο Cornell. Είναι ACM Fellow και IEEE Fellow.

Nitish Joshi ήταν ασκούμενος στην εφαρμοσμένη επιστήμη στο AWS AI, Amazon. Είναι διδάκτορας στην επιστήμη των υπολογιστών στο Ινστιτούτο Μαθηματικών Επιστημών Courant του Πανεπιστημίου της Νέας Υόρκης με συμβουλή του καθηγητή He He. Εργάζεται στη Μηχανική Μάθηση και στην Επεξεργασία Φυσικής Γλώσσας και συνδέθηκε με την ερευνητική ομάδα Machine Learning for Language (ML2). Ενδιαφερόταν γενικά για την ισχυρή κατανόηση της γλώσσας: τόσο για τη δημιουργία μοντέλων που είναι ανθεκτικά στις μετατοπίσεις της διανομής (π.χ. μέσω της αύξησης δεδομένων από τον άνθρωπο στον βρόχο) όσο και για το σχεδιασμό καλύτερων τρόπων αξιολόγησης/μέτρησης της ευρωστίας των μοντέλων. Ήταν επίσης περίεργος για τις πρόσφατες εξελίξεις στη μάθηση εντός πλαισίου και στην κατανόηση του πώς λειτουργεί.

Nitish Joshi ήταν ασκούμενος στην εφαρμοσμένη επιστήμη στο AWS AI, Amazon. Είναι διδάκτορας στην επιστήμη των υπολογιστών στο Ινστιτούτο Μαθηματικών Επιστημών Courant του Πανεπιστημίου της Νέας Υόρκης με συμβουλή του καθηγητή He He. Εργάζεται στη Μηχανική Μάθηση και στην Επεξεργασία Φυσικής Γλώσσας και συνδέθηκε με την ερευνητική ομάδα Machine Learning for Language (ML2). Ενδιαφερόταν γενικά για την ισχυρή κατανόηση της γλώσσας: τόσο για τη δημιουργία μοντέλων που είναι ανθεκτικά στις μετατοπίσεις της διανομής (π.χ. μέσω της αύξησης δεδομένων από τον άνθρωπο στον βρόχο) όσο και για το σχεδιασμό καλύτερων τρόπων αξιολόγησης/μέτρησης της ευρωστίας των μοντέλων. Ήταν επίσης περίεργος για τις πρόσφατες εξελίξεις στη μάθηση εντός πλαισίου και στην κατανόηση του πώς λειτουργεί.

Kumar Chellapilla είναι Γενικός Διευθυντής και Διευθυντής στο Amazon Web Services και ηγείται της ανάπτυξης Υπηρεσιών ML/AI, όπως συστήματα ανθρώπινου βρόχου, AI DevOps, Geospatial ML και ADAS/Autonomous Vehicle development. Πριν από το AWS, ο Kumar ήταν Διευθυντής Μηχανικής στο Uber ATG και στο Lyft Level 5 και οδήγησε ομάδες που χρησιμοποιούσαν μηχανική μάθηση για να αναπτύξουν δυνατότητες αυτοοδήγησης, όπως αντίληψη και χαρτογράφηση. Εργάστηκε επίσης στην εφαρμογή τεχνικών μηχανικής εκμάθησης για τη βελτίωση της αναζήτησης, των προτάσεων και των προϊόντων διαφήμισης στο LinkedIn, το Twitter, το Bing και τη Microsoft Research.

Kumar Chellapilla είναι Γενικός Διευθυντής και Διευθυντής στο Amazon Web Services και ηγείται της ανάπτυξης Υπηρεσιών ML/AI, όπως συστήματα ανθρώπινου βρόχου, AI DevOps, Geospatial ML και ADAS/Autonomous Vehicle development. Πριν από το AWS, ο Kumar ήταν Διευθυντής Μηχανικής στο Uber ATG και στο Lyft Level 5 και οδήγησε ομάδες που χρησιμοποιούσαν μηχανική μάθηση για να αναπτύξουν δυνατότητες αυτοοδήγησης, όπως αντίληψη και χαρτογράφηση. Εργάστηκε επίσης στην εφαρμογή τεχνικών μηχανικής εκμάθησης για τη βελτίωση της αναζήτησης, των προτάσεων και των προϊόντων διαφήμισης στο LinkedIn, το Twitter, το Bing και τη Microsoft Research.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoAiStream. Web3 Data Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- Minting the Future με την Adryenn Ashley. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/improve-multi-hop-reasoning-in-llms-by-learning-from-rich-human-feedback/

- :έχει

- :είναι

- :δεν

- :που

- 1

- 10

- 100

- 13

- 200

- 22

- 30

- 39

- 3d

- 7

- a

- ικανότητες

- ικανότητα

- Σχετικα

- αναλόγως

- ACM

- προστιθέμενη

- προσθήκη

- Πρόσθετος

- διεύθυνση

- αντιφατική

- Διαφήμιση

- Συνδεδεμένος

- Μετά το

- πάλι

- AI

- Alexa

- αλγόριθμοι

- Όλα

- κατά μήκος

- Επίσης

- εναλλακτική λύση

- Amazon

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- μεταξύ των

- an

- και

- απάντηση

- απαντήσεις

- κάθε

- εφαρμοσμένος

- Εφαρμογή

- εφαρμόζοντας

- πλησιάζω

- κατάλληλος

- ΕΙΝΑΙ

- AS

- ανατεθεί

- At

- αυτονόμος

- διαθέσιμος

- επίγνωση

- AWS

- βάση

- βασίζονται

- Baseline

- BE

- επειδή

- ήταν

- πριν

- Κουδούνι

- αναφοράς

- Καλύτερα

- Bing

- και οι δύο

- Κουτί

- γενικά

- Κτίριο

- μοντέλα κτιρίων

- αλλά

- by

- CAN

- δυνατότητες

- Σταδιοδρομία

- περίπτωση

- ορισμένες

- αλυσίδα

- αλυσίδες

- πρόκληση

- αρχηγός

- Ταξινόμηση

- Κλεισιμο

- συλλέγουν

- Συλλέγοντας

- συλλογή

- COLUMBIA

- Κοινός

- συγκρίσιμος

- συγκρίνουν

- σύγκριση

- περιεκτικός

- υπολογιστή

- Πληροφορική

- διενεργούνται

- βέβαιος

- με σιγουριά

- Εξετάστε

- θεωρώντας

- πρόξενος

- Περιέχει

- συμφραζόμενα

- μετατρέψετε

- cornell

- Διορθώσεις

- ενισχύω

- περίεργος

- ημερομηνία

- σύνολα δεδομένων

- βαθύς

- βαθιά μάθηση

- αποδεικνύουν

- καταδεικνύει

- περιγράφουν

- περιγράφεται

- περιγραφή

- σχέδιο

- Παρά

- λεπτομέρεια

- λεπτομερής

- καθέκαστα

- Dev

- ανάπτυξη

- Ανάπτυξη

- εξελίξεις

- διαφορετικές

- κατευθείαν

- Διευθυντής

- διανομή

- διάφορα

- do

- γίνεται

- Μην

- οδήγηση

- κατά την διάρκεια

- e

- κάθε

- ενεργοποιημένη

- Μηχανική

- σφάλμα

- λάθη

- δημιουργία

- αξιολογήσει

- αξιολόγηση

- εκτίμηση

- Even

- παράδειγμα

- παραδείγματα

- εξήγηση

- ανατροφοδότηση

- σύντροφος

- πεδίο

- Εικόνα

- τελικός

- Όνομα

- ακολουθείται

- Εξής

- Για

- μορφή

- Βρέθηκαν

- τέσσερα

- από

- συγκέντρωση

- General

- παράγουν

- παράγεται

- δημιουργεί

- παραγωγής

- γενεά

- γενεών

- Γεωχωρική ML

- Δώστε

- δεδομένου

- Δίνοντας

- Έδαφος

- Group

- hacking

- Έχω

- που έχει

- he

- κεφάλι

- βοήθεια

- βοηθά

- εδώ

- του

- Πως

- Πώς να

- Ωστόσο

- HTTPS

- ανθρώπινος

- Οι άνθρωποι

- προσδιορίσει

- IEEE

- if

- απεικονίζει

- βελτίωση

- in

- Συμπεριλαμβανομένου

- ενσωματώνω

- αρχικός

- πρωτοβουλίες

- αντί

- Ινστιτούτο

- ενδιαφερόμενος

- συμφέροντα

- περιβάλλον λειτουργίας

- σε

- διερευνήσει

- IT

- επαναλήψεις

- ΤΟΥ

- jpg

- Labs

- Γλώσσα

- large

- μεγαλύτερος

- Οδηγεί

- ΜΑΘΑΊΝΩ

- μάθει

- μάθηση

- Led

- Επίπεδο

- Περιωρισμένος

- LLM

- λογικός

- κοιτάζοντας

- Lyft

- μηχανή

- μάθηση μηχανής

- ΚΑΝΕΙ

- διευθυντής

- χαρτης

- μαθηματικός

- ανώτατο όριο

- Ενδέχεται..

- μέθοδοι

- Microsoft

- Λείπει

- λάθος

- λάθη

- ML

- ml2

- μοντέλο

- μοντέλα

- Μηνας

- περισσότερο

- πλέον

- κίνητρα

- πολλαπλούς

- και συγκεκριμένα

- Φυσικό

- Επεξεργασία φυσικής γλώσσας

- Νέα

- Νέα Υόρκη

- nlp

- Όχι.

- αριθμός

- σκοπός

- παρατηρούμε

- εμπόδιο

- αποκτήσει

- λαμβάνεται

- συνέβη

- of

- on

- ONE

- συνεχή

- αποκλειστικά

- επίθεση

- or

- πρωτότυπο

- αλλιώς

- δικός μας

- έξω

- επί

- επισκόπηση

- δική

- ποσοστό

- αντίληψη

- Εκτελέστε

- επίδοση

- εκτελεί

- περίοδος

- περιοδικός

- επιλέξτε

- πιλότος

- Μέρος

- πλατφόρμες

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- συν

- θέτει

- δυνατός

- Θέση

- δυναμικού

- πρακτική

- προβλέψει

- πρόβλεψη

- Προβλέπει

- Προετοιμάστε

- παρόν

- παρουσιάζονται

- επικρατών

- προηγούμενος

- προηγουμένως

- Πριν

- μεταποίηση

- Προϊόντα

- Δάσκαλος

- Πρόοδος

- ποσοστό

- προτείνω

- προτείνεται

- πρωτόκολλο

- παρέχουν

- παρέχεται

- παρέχει

- ποιότητα

- ερώτηση

- Ερωτήσεις

- τυχαίος

- μάλλον

- πρόσφατος

- συστάσεις

- τελειοποίηση

- σχετικά

- αφαιρέστε

- αντιπροσώπευση

- απαιτούν

- απαιτείται

- έρευνα

- επιφυλάχθηκε

- αντίστοιχα

- ΠΕΡΙΦΕΡΕΙΑ

- αποτέλεσμα

- Αποτελέσματα

- Ανταμοιβή

- Πλούσιος

- ρομποτική

- εύρωστος

- ευρωστία

- γύρους

- ΣΕΙΡΑ

- σοφός

- ίδιο

- Κλίμακα

- κλίμακα αι

- Ζυγός

- Επιστήμη

- ΕΠΙΣΤΗΜΕΣ

- Επιστήμονας

- Αναζήτηση

- Δεύτερος

- Τμήμα

- δει

- ΕΑΥΤΟΣ

- αυτο-οδήγηση

- αρχαιότερος

- ποινή

- ξεχωριστό

- Υπηρεσίες

- σειρά

- διάφοροι

- Βάρδιες

- Κοντά

- δείχνουν

- παρουσιάζεται

- Δείχνει

- σημαντικός

- σημαντικά

- παρόμοιες

- Απλούς

- small

- μικρότερος

- μερικοί

- συγκεκριμένες

- ειδικά

- διαίρεση

- Αθλητισμός

- ξεκίνησε

- Βήμα

- Βήματα

- Στρατηγική

- Φοιτητής

- επιτυχία

- τέτοιος

- συστήματα

- τραπέζι

- Έργο

- εργασίες

- ομάδες

- τεχνικές

- δοκιμή

- από

- ότι

- Η

- τους

- Τους

- τότε

- Αυτοί

- αυτοί

- αυτό

- εκείνοι

- Μέσω

- προς την

- Σύνολο

- εκπαιδευμένο

- Εκπαίδευση

- θεραπεία

- θεραπεία

- καταπληκτικός

- Εμπιστευθείτε

- Αλήθεια

- tutorials

- Τουίτερ

- δύο

- τύπος

- τύποι

- Uber

- κατανόηση

- πανεπιστήμιο

- χρήση

- μεταχειρισμένος

- Χρήστες

- χρησιμοποιώντας

- συνήθως

- Παραλλαγή

- διάφορα

- όχημα

- Δες

- όραμα

- Επίσκεψη

- Ψηφίστε

- ήταν

- Τρόπος..

- τρόπους

- we

- ιστός

- διαδικτυακές υπηρεσίες

- βάρος

- ήταν

- πότε

- αν

- Ποιό

- WHY

- θα

- με

- Εργασία

- εργάστηκαν

- εργαζόμενος

- λειτουργεί

- Σεμινάρια

- αξία

- Λανθασμένος

- Υόρκη

- Σας

- zephyrnet