Σήμερα, είμαστε ενθουσιασμένοι που ανακοινώνουμε τη δυνατότητα να τελειοποιήσουμε τα μοντέλα Llama 2 από τη Meta χρησιμοποιώντας Amazon SageMaker JumpStart. Η οικογένεια Llama 2 μεγάλων γλωσσικών μοντέλων (LLMs) είναι μια συλλογή προεκπαιδευμένων και βελτιστοποιημένων μοντέλων δημιουργίας κειμένου που κυμαίνονται σε κλίμακα από 7 δισεκατομμύρια έως 70 δισεκατομμύρια παραμέτρους. Τα τελειοποιημένα LLM, που ονομάζονται Llama-2-chat, είναι βελτιστοποιημένα για περιπτώσεις χρήσης διαλόγου. Μπορείτε εύκολα να δοκιμάσετε αυτά τα μοντέλα και να τα χρησιμοποιήσετε με το SageMaker JumpStart, το οποίο είναι ένας κόμβος μηχανικής εκμάθησης (ML) που παρέχει πρόσβαση σε αλγόριθμους, μοντέλα και λύσεις ML, ώστε να μπορείτε να ξεκινήσετε γρήγορα με την ML. Τώρα μπορείτε επίσης να ρυθμίσετε 7 δισεκατομμύρια, 13 δισεκατομμύρια και 70 δισεκατομμύρια παραμέτρους μοντέλα δημιουργίας κειμένου Llama 2 στο SageMaker JumpStart χρησιμοποιώντας το Στούντιο Amazon SageMaker UI με μερικά κλικ ή χρησιμοποιώντας το SageMaker Python SDK.

Τα γενετικά μοντέλα θεμελίωσης τεχνητής νοημοσύνης βρίσκονται στο επίκεντρο των περισσότερων ερευνών και υποθέσεων χρήσης ML και τεχνητής νοημοσύνης για περισσότερο από ένα χρόνο τώρα. Αυτά τα βασικά μοντέλα αποδίδουν πολύ καλά με παραγωγικές εργασίες, όπως δημιουργία κειμένου, σύνοψη, απάντηση ερωτήσεων, δημιουργία εικόνων και βίντεο και πολλά άλλα, λόγω του μεγάλου μεγέθους τους και επίσης επειδή εκπαιδεύονται σε πολλά μεγάλα σύνολα δεδομένων και εκατοντάδες εργασίες. Παρά τις μεγάλες δυνατότητες γενίκευσης αυτών των μοντέλων, υπάρχουν συχνά περιπτώσεις χρήσης που έχουν πολύ συγκεκριμένα δεδομένα τομέα (όπως υγειονομική περίθαλψη ή χρηματοοικονομικές υπηρεσίες), εξαιτίας των οποίων αυτά τα μοντέλα ενδέχεται να μην είναι σε θέση να παρέχουν καλά αποτελέσματα για αυτές τις περιπτώσεις χρήσης. Αυτό έχει ως αποτέλεσμα την ανάγκη περαιτέρω λεπτομέρειας αυτών των μοντέλων τεχνητής νοημοσύνης που δημιουργούνται σε σχέση με τα δεδομένα για συγκεκριμένη περίπτωση χρήσης και δεδομένα για συγκεκριμένο τομέα.

Σε αυτήν την ανάρτηση, περιγράφουμε πώς να τελειοποιήσετε τα προεκπαιδευμένα μοντέλα δημιουργίας κειμένου Llama 2 μέσω του SageMaker JumpStart.

Τι είναι το Llama 2

Το Llama 2 είναι ένα μοντέλο γλώσσας αυτόματης παλινδρόμησης που χρησιμοποιεί μια βελτιστοποιημένη αρχιτεκτονική μετασχηματιστή. Το Llama 2 προορίζεται για εμπορική και ερευνητική χρήση στα αγγλικά. Διατίθεται σε μια σειρά μεγεθών παραμέτρων—7 δισεκατομμύρια, 13 δισεκατομμύρια και 70 δισεκατομμύρια—καθώς και σε προεκπαιδευμένες και βελτιωμένες παραλλαγές. Σύμφωνα με το Meta, οι συντονισμένες εκδόσεις χρησιμοποιούν εποπτευόμενη λεπτομέρεια (SFT) και ενισχυτική μάθηση με ανθρώπινη ανάδραση (RLHF) για να ευθυγραμμιστούν με τις ανθρώπινες προτιμήσεις για εξυπηρετικότητα και ασφάλεια. Το Llama 2 ήταν προεκπαιδευμένο σε 2 τρισεκατομμύρια μάρκες δεδομένων από δημόσια διαθέσιμες πηγές. Τα συντονισμένα μοντέλα προορίζονται για συνομιλία τύπου βοηθού, ενώ τα προεκπαιδευμένα μοντέλα μπορούν να προσαρμοστούν για μια ποικιλία εργασιών δημιουργίας φυσικής γλώσσας. Ανεξάρτητα από την έκδοση του μοντέλου που χρησιμοποιεί ένας προγραμματιστής, το οδηγός υπεύθυνης χρήσης από το Meta μπορεί να βοηθήσει στην καθοδήγηση πρόσθετων λεπτομερειών που μπορεί να είναι απαραίτητες για την προσαρμογή και τη βελτιστοποίηση των μοντέλων με κατάλληλους μετριασμούς ασφαλείας.

Επί του παρόντος, το Llama 2 είναι διαθέσιμο στις ακόλουθες περιοχές:

- Ανάπτυξη προεκπαιδευμένου μοντέλου διαθέσιμο:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Βελτιστοποιήστε και αναπτύξτε το βελτιστοποιημένο μοντέλο:

“us-east-1”,“us-west-2”,“eu-west-1”

Τι είναι το SageMaker JumpStart

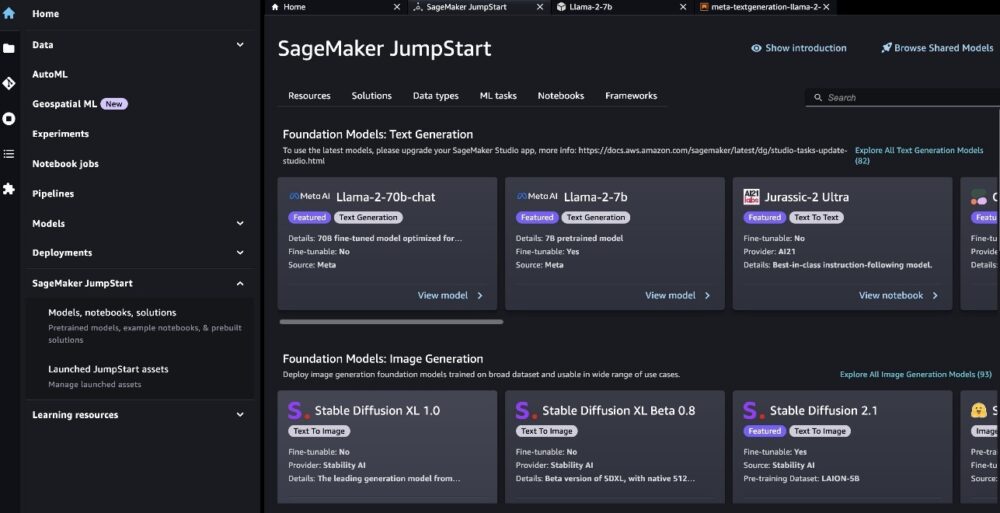

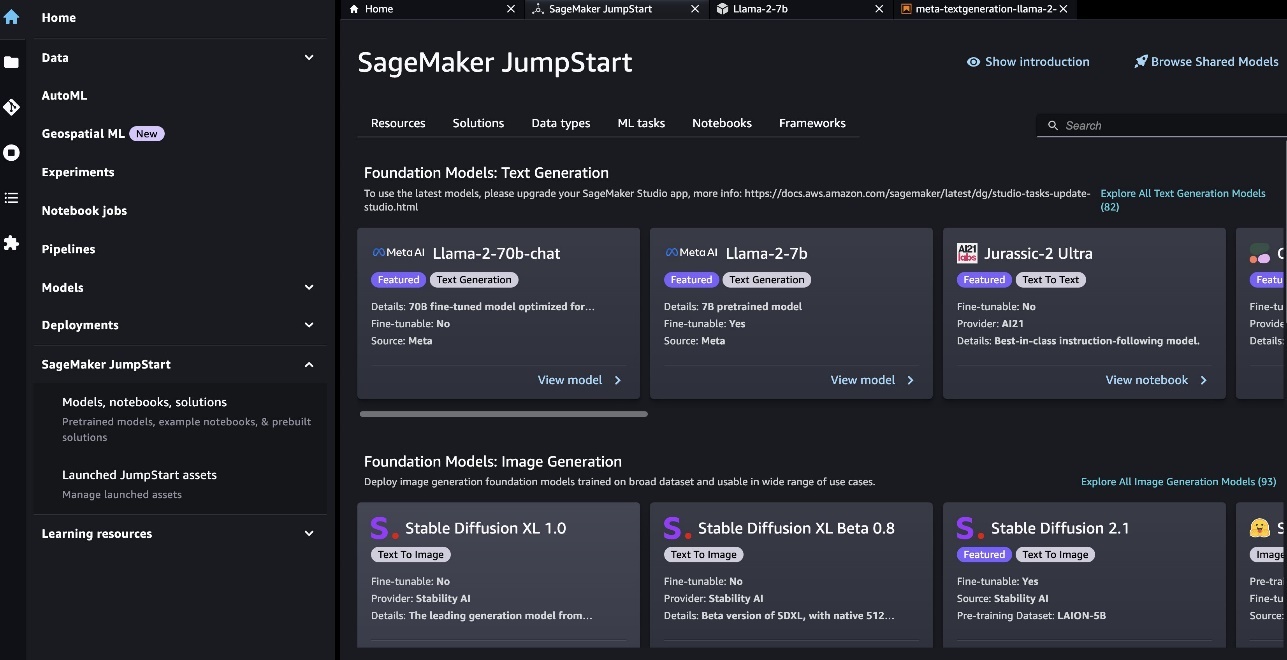

Με το SageMaker JumpStart, οι επαγγελματίες ML μπορούν να επιλέξουν από μια ευρεία γκάμα διαθέσιμων στο κοινό μοντέλων βάσης. Οι επαγγελματίες ML μπορούν να αναπτύξουν μοντέλα θεμελίωσης σε αποκλειστική χρήση Amazon Sage Maker στιγμιότυπα από ένα απομονωμένο περιβάλλον δικτύου και προσαρμόστε μοντέλα χρησιμοποιώντας το SageMaker για εκπαίδευση και ανάπτυξη μοντέλων. Τώρα μπορείτε να ανακαλύψετε και να αναπτύξετε το Llama 2 με μερικά κλικ στο SageMaker Studio ή μέσω προγραμματισμού μέσω του SageMaker Python SDK, επιτρέποντάς σας να αντλήσετε στοιχεία ελέγχου απόδοσης μοντέλου και MLOps με λειτουργίες του SageMaker, όπως π.χ. Αγωγοί Amazon SageMaker, Debugger Amazon SageMaker, ή αρχεία καταγραφής κοντέινερ. Το μοντέλο αναπτύσσεται σε ένα ασφαλές περιβάλλον AWS και υπό τους ελέγχους VPC σας, συμβάλλοντας στη διασφάλιση της ασφάλειας των δεδομένων. Επιπλέον, μπορείτε να ρυθμίσετε τα προεκπαιδευμένα μοντέλα δημιουργίας κειμένου Llama2 7B, 13B και 70B μέσω του SageMaker JumpStart.

Βελτιώστε τα μοντέλα Llama2

Μπορείτε να ρυθμίσετε τα μοντέλα χρησιμοποιώντας είτε το SageMaker Studio UI είτε το SageMaker Python SDK. Συζητάμε και τις δύο μεθόδους σε αυτή την ενότητα.

Βελτιστοποίηση χωρίς κώδικα μέσω της διεπαφής χρήστη του SageMaker Studio

Στο SageMaker Studio, μπορείτε να αποκτήσετε πρόσβαση στα μοντέλα Llama 2 μέσω του SageMaker JumpStart στο Μοντέλα, σημειωματάρια και λύσεις, όπως φαίνεται στο παρακάτω στιγμιότυπο οθόνης.

Εάν δεν βλέπετε μοντέλα Llama 2, ενημερώστε την έκδοση του SageMaker Studio τερματίζοντας και επανεκκινώντας. Για περισσότερες πληροφορίες σχετικά με τις ενημερώσεις έκδοσης, ανατρέξτε στο Τερματισμός και ενημέρωση εφαρμογών Studio.

Μπορείτε επίσης να βρείτε άλλες τέσσερις παραλλαγές μοντέλων επιλέγοντας Εξερευνήστε όλα τα μοντέλα δημιουργίας κειμένου ή αναζήτηση για λάμα στο πλαίσιο αναζήτησης.

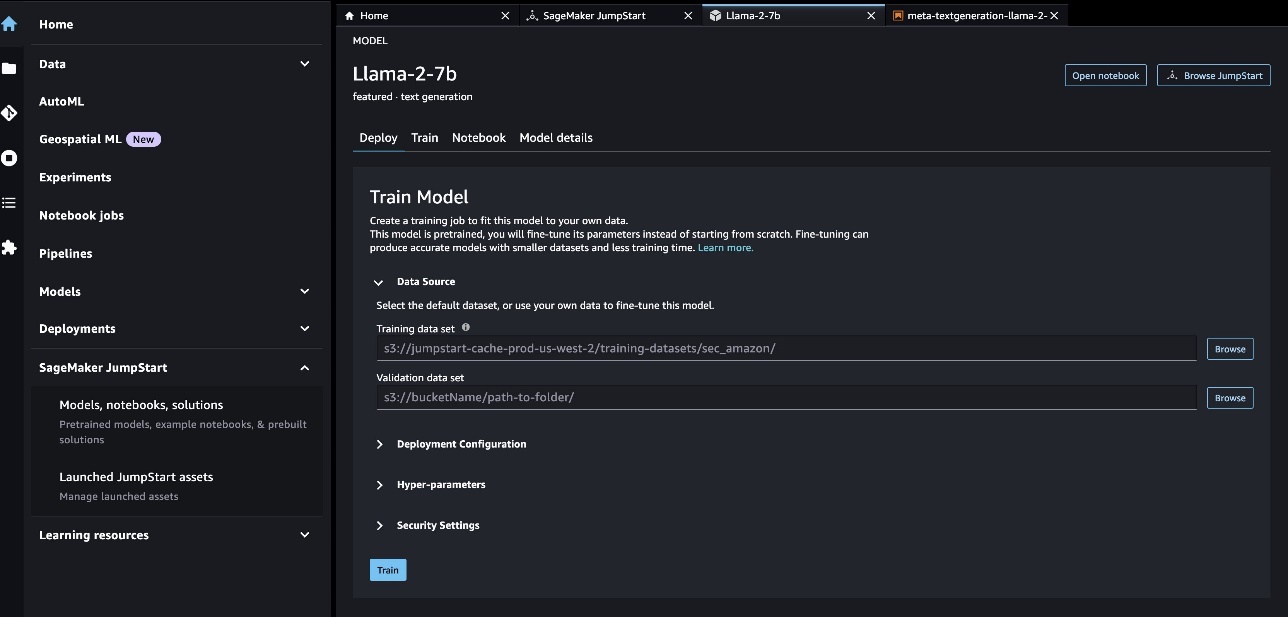

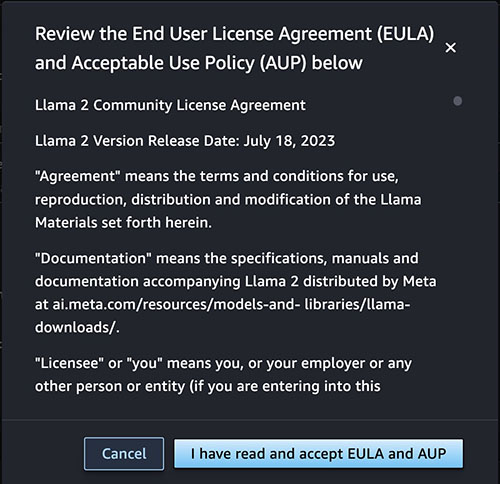

Σε αυτή τη σελίδα, μπορείτε να υποδείξετε το Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) κάδος που περιέχει τα σύνολα δεδομένων εκπαίδευσης και επικύρωσης για τελειοποίηση. Επιπλέον, μπορείτε να διαμορφώσετε τις ρυθμίσεις παραμέτρων ανάπτυξης, τις υπερπαραμέτρους και τις ρυθμίσεις ασφαλείας για μικροσυντονισμό. Στη συνέχεια, μπορείτε να επιλέξετε Τρένο για να ξεκινήσετε την εργασία εκπαίδευσης σε μια παρουσία του SageMaker ML. Το προηγούμενο στιγμιότυπο οθόνης δείχνει τη σελίδα λεπτομέρειας για το μοντέλο Llama-2 7B. Ωστόσο, μπορείτε να ρυθμίσετε τα μοντέλα δημιουργίας κειμένου 13B και 70B Llama 2 χρησιμοποιώντας τις αντίστοιχες σελίδες μοντέλων τους με παρόμοιο τρόπο. Για να χρησιμοποιήσετε μοντέλα Llama 2, πρέπει να αποδεχτείτε την Άδεια Χρήσης Τελικού Χρήστη (EULA). Θα εμφανιστεί όταν το επιλέξετε Τρένο, όπως φαίνεται στο παρακάτω στιγμιότυπο οθόνης. Επιλέγω Έχω διαβάσει και αποδέχομαι EULA και AUP για να ξεκινήσετε τη δουλειά μικρορύθμισης.

Αναπτύξτε το μοντέλο

Αφού τελειοποιήσετε το μοντέλο, μπορείτε να το αναπτύξετε χρησιμοποιώντας τη σελίδα μοντέλου στο SageMaker JumpStart. Η επιλογή ανάπτυξης του μικροσυντονισμένου μοντέλου θα εμφανιστεί όταν ολοκληρωθεί η μικροσυντονισμός, όπως φαίνεται στο παρακάτω στιγμιότυπο οθόνης.

Βελτιστοποιήστε μέσω του SageMaker Python SDK

Μπορείτε επίσης να ρυθμίσετε τα μοντέλα Llama 2 χρησιμοποιώντας το SageMaker Python SDK. Το παρακάτω είναι ένα δείγμα κώδικα για να ρυθμίσετε με ακρίβεια το Llama 2 7B στο σύνολο δεδομένων σας:

Μπορείτε να αναπτύξετε το τελειοποιημένο μοντέλο απευθείας από τον εκτιμητή:

Μπορείτε επίσης να βρείτε τον κωδικό στο Βελτιστοποιήστε τα μοντέλα LLaMA 2 στο SageMaker JumpStart. Περιλαμβάνει προετοιμασία δεδομένων, εκπαίδευση στο προσαρμοσμένο σύνολο δεδομένων σας και ανάπτυξη του βελτιστοποιημένου μοντέλου. Δείχνει τη λεπτομερή ρύθμιση σε ένα υποσύνολο του συνόλου δεδομένων Dolly με παραδείγματα από την εργασία σύνοψης. Ακολουθεί το παράδειγμα εισαγωγής με απαντήσεις από λεπτομέρεια και μη λεπτομέρεια μαζί με την απόκριση αληθούς βάσης:

Εισαγωγή στο μοντέλο:

Απόκριση βασικής αλήθειας:

Απάντηση από το μη προσαρμοσμένο μοντέλο:

Απάντηση από το τελειοποιημένο μοντέλο:

Για συγκριτική αξιολόγηση απόδοσης διαφορετικών μοντέλων στο σύνολο δεδομένων Dolly και Dialogsum, ανατρέξτε στο Συγκριτική αξιολόγηση απόδοσης ενότητα στο παράρτημα στο τέλος αυτής της ανάρτησης.

Τεχνική μικρορύθμισης

Τα μοντέλα γλώσσας όπως το Llama έχουν μέγεθος μεγαλύτερο από 10 GB ή ακόμα και 100 GB. Η τελειοποίηση τέτοιων μεγάλων μοντέλων απαιτεί περιπτώσεις με σημαντικά υψηλή μνήμη CUDA. Επιπλέον, η εκπαίδευση αυτών των μοντέλων μπορεί να είναι πολύ αργή λόγω του μεγέθους του μοντέλου. Επομένως, για αποτελεσματική μικρορύθμιση, χρησιμοποιούμε τις ακόλουθες βελτιστοποιήσεις:

- Προσαρμογή χαμηλής κατάταξης (LoRA) – Αυτός είναι ένας τύπος παραμέτρου αποδοτικής μικρορύθμισης (PEFT) για αποτελεσματική μικρορύθμιση μεγάλων μοντέλων. Σε αυτό, παγώνουμε ολόκληρο το μοντέλο και προσθέτουμε μόνο ένα μικρό σύνολο ρυθμιζόμενων παραμέτρων ή επιπέδων στο μοντέλο. Για παράδειγμα, αντί να εκπαιδεύσουμε και τις 7 δισεκατομμύρια παραμέτρους για το Llama 2 7B, μπορούμε να ρυθμίσουμε με ακρίβεια λιγότερο από το 1% των παραμέτρων. Αυτό βοηθά στη σημαντική μείωση της απαίτησης μνήμης, επειδή χρειάζεται να αποθηκεύουμε μόνο διαβαθμίσεις, καταστάσεις βελτιστοποίησης και άλλες πληροφορίες που σχετίζονται με την εκπαίδευση μόνο για το 1% των παραμέτρων. Επιπλέον, αυτό βοηθά στη μείωση του χρόνου προπόνησης καθώς και του κόστους. Για περισσότερες λεπτομέρειες σχετικά με αυτήν τη μέθοδο, ανατρέξτε στο LoRA: Προσαρμογή χαμηλού βαθμού μεγάλων γλωσσικών μοντέλων.

- Κβαντισμός Int8 – Ακόμη και με βελτιστοποιήσεις όπως το LoRA, μοντέλα όπως το Llama 70B εξακολουθούν να είναι πολύ μεγάλα για εκπαίδευση. Για να μειώσουμε το αποτύπωμα μνήμης κατά τη διάρκεια της προπόνησης, μπορούμε να χρησιμοποιήσουμε την κβαντοποίηση Int8 κατά τη διάρκεια της προπόνησης. Η κβαντοποίηση τυπικά μειώνει την ακρίβεια των τύπων δεδομένων κινητής υποδιαστολής. Αν και αυτό μειώνει τη μνήμη που απαιτείται για την αποθήκευση βαρών μοντέλων, υποβαθμίζει την απόδοση λόγω απώλειας πληροφοριών. Η κβαντοποίηση Int8 χρησιμοποιεί μόνο το ένα τέταρτο της ακρίβειας, αλλά δεν επιφέρει υποβάθμιση της απόδοσης επειδή δεν ρίχνει απλώς τα bits. Στρογγυλοποιεί τα δεδομένα από τον έναν τύπο στον άλλο. Για να μάθετε σχετικά με την κβαντοποίηση Int8, ανατρέξτε στο LLM.int8(): Πολλαπλασιασμός Matrix 8-bit για μετασχηματιστές σε κλίμακα.

- Πλήρως σπασμένα δεδομένα παράλληλα (FSDP) – Αυτός είναι ένας τύπος αλγόριθμου εκπαίδευσης παράλληλων δεδομένων που κατακερματίζει τις παραμέτρους του μοντέλου σε παράλληλους εργαζόμενους δεδομένων και μπορεί προαιρετικά να μεταφορτώσει μέρος του υπολογισμού της εκπαίδευσης στις CPU. Παρόλο που οι παράμετροι είναι κατανεμημένες σε διαφορετικές GPU, ο υπολογισμός κάθε μικροπαρτίδας είναι τοπικός για τον εργαζόμενο GPU. Κατακερματίζει τις παραμέτρους πιο ομοιόμορφα και επιτυγχάνει βελτιστοποιημένη απόδοση μέσω αλληλοεπικάλυψης επικοινωνίας και υπολογισμού κατά τη διάρκεια της προπόνησης.

Ο παρακάτω πίνακας συγκρίνει διαφορετικές μεθόδους με τα τρία μοντέλα Llama 2.

| , | Προεπιλεγμένος τύπος παρουσίας | Υποστηριζόμενοι τύποι παρουσιών με προεπιλεγμένη διαμόρφωση | Προεπιλεγμένη ρύθμιση | LORA + FSDP | LORA + Χωρίς FSDP | Int8 Quantization + LORA + No FSDP |

| Λάμα 2 7Β | ml.g5.12xμεγάλο | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ναι | Ναι | Ναι |

| Λάμα 2 13Β | ml.g5.12xμεγάλο | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Ναι | Ναι | Ναι |

| Λάμα 2 70Β | ml.g5.48xμεγάλο | ml.g5.48xμεγάλο | INT8 + LORA + ΟΧΙ FSDP | Οχι | Οχι | Ναι |

Σημειώστε ότι η τελειοποίηση των μοντέλων Llama βασίζεται σε σενάρια που παρέχονται από τα ακόλουθα GitHub repo.

Μορφή δεδομένων εκπαίδευσης

Το SageMaker JumpStart υποστηρίζει επί του παρόντος σύνολα δεδομένων τόσο σε μορφή προσαρμογής τομέα όσο και σε μορφή συντονισμού εντολών. Σε αυτήν την ενότητα, καθορίζουμε ένα παράδειγμα συνόλου δεδομένων και στις δύο μορφές. Για περισσότερες λεπτομέρειες, ανατρέξτε στο Μορφοποίηση συνόλου δεδομένων ενότητα στο παράρτημα.

Μορφή προσαρμογής τομέα

Το μοντέλο παραγωγής κειμένου Llama 2 μπορεί να ρυθμιστεί με ακρίβεια σε οποιοδήποτε σύνολο δεδομένων συγκεκριμένου τομέα. Αφού τελειοποιηθεί στο σύνολο δεδομένων για συγκεκριμένο τομέα, το μοντέλο αναμένεται να δημιουργήσει κείμενο για συγκεκριμένο τομέα και να λύσει διάφορες εργασίες NLP σε αυτόν τον συγκεκριμένο τομέα με προτροπή λίγων λήψεων. Με αυτό το σύνολο δεδομένων, η είσοδος αποτελείται από ένα αρχείο CSV, JSON ή TXT. Για παράδειγμα, τα δεδομένα εισόδου μπορεί να είναι αρχεία SEC της Amazon ως αρχείο κειμένου:

Μορφή συντονισμού οδηγιών

Στη λεπτομέρεια εντολών, το μοντέλο ρυθμίζεται με ακρίβεια για ένα σύνολο εργασιών επεξεργασίας φυσικής γλώσσας (NLP) που περιγράφονται χρησιμοποιώντας οδηγίες. Αυτό βοηθά στη βελτίωση της απόδοσης του μοντέλου για μη εμφανείς εργασίες με προτροπές μηδενικής λήψης. Στη μορφή συνόλου δεδομένων συντονισμού εντολών, καθορίζετε το template.json αρχείο που περιγράφει τις μορφές εισόδου και εξόδου. Για παράδειγμα, κάθε γραμμή στο αρχείο train.jsonl μοιάζει με το εξής:

Το πρόσθετο αρχείο template.json μοιάζει με το εξής:

Υποστηριζόμενες υπερπαράμετροι για προπόνηση

Η λεπτομέρεια του Llama 2 υποστηρίζει έναν αριθμό υπερπαραμέτρων, καθεμία από τις οποίες μπορεί να επηρεάσει την απαίτηση μνήμης, την ταχύτητα προπόνησης και την απόδοση του βελτιωμένου μοντέλου:

- εποχή – Ο αριθμός των περασμάτων που πραγματοποιεί ο αλγόριθμος μικρορύθμισης μέσω του συνόλου δεδομένων εκπαίδευσης. Πρέπει να είναι ακέραιος αριθμός μεγαλύτερος από 1. Η προεπιλογή είναι 5.

- βαθμός μάθησης – Ο ρυθμός με τον οποίο ενημερώνονται τα βάρη του μοντέλου μετά την επεξεργασία κάθε παρτίδας παραδειγμάτων εκπαίδευσης. Πρέπει να είναι θετικός float μεγαλύτερος από 0. Η προεπιλογή είναι 1e-4.

- instruction_tuned – Είτε θα εκπαιδεύσετε-εκπαιδεύσετε το μοντέλο είτε όχι. Πρέπει να είναι '

True' ή 'False'. Η προεπιλογή είναι 'False'. - ανά_συσκευή_train_batch_size – Το μέγεθος παρτίδας ανά πυρήνα/CPU GPU για εκπαίδευση. Πρέπει να είναι θετικός ακέραιος αριθμός. Η προεπιλογή είναι 4.

- ανά_συσκευή_eval_batch_size – Το μέγεθος παρτίδας ανά πυρήνα/CPU GPU για αξιολόγηση. Πρέπει να είναι θετικός ακέραιος αριθμός. Η προεπιλογή είναι 1.

- max_train_samples – Για σκοπούς εντοπισμού σφαλμάτων ή ταχύτερη εκπαίδευση, περικόψτε τον αριθμό των παραδειγμάτων εκπαίδευσης σε αυτήν την τιμή. Η τιμή -1 σημαίνει τη χρήση όλων των δειγμάτων εκπαίδευσης. Πρέπει να είναι θετικός ακέραιος ή -1. Η προεπιλογή είναι -1.

- max_val_samples – Για σκοπούς εντοπισμού σφαλμάτων ή ταχύτερη εκπαίδευση, περικόψτε τον αριθμό των παραδειγμάτων επικύρωσης σε αυτήν την τιμή. Η τιμή -1 σημαίνει τη χρήση όλων των δειγμάτων επικύρωσης. Πρέπει να είναι θετικός ακέραιος ή -1. Η προεπιλογή είναι -1.

- max_input_length – Μέγιστο συνολικό μήκος ακολουθίας εισαγωγής μετά τη διαγραφή. Ακολουθίες μεγαλύτερες από αυτό θα περικοπούν. Αν -1,

max_input_lengthέχει οριστεί στο ελάχιστο 1024 και το μέγιστο μήκος μοντέλου που ορίζεται από το tokenizer. Εάν οριστεί σε θετική τιμή,max_input_lengthορίζεται στο ελάχιστο της παρεχόμενης τιμής και τοmodel_max_lengthπου ορίζεται από το tokenizer. Πρέπει να είναι θετικός ακέραιος ή -1. Η προεπιλογή είναι -1. - αναλογία_διαχωρισμού_επικύρωσης – Εάν υπάρχει κανάλι επικύρωσης

none, ο λόγος επικύρωσης αμαξοστοιχίας διαχωρισμού από τα δεδομένα αμαξοστοιχίας πρέπει να είναι μεταξύ 0–1. Η προεπιλογή είναι 0.2. - train_data_split_seed – Εάν δεν υπάρχουν δεδομένα επικύρωσης, αυτό διορθώνει τον τυχαίο διαχωρισμό των δεδομένων εκπαίδευσης εισόδου σε δεδομένα εκπαίδευσης και επικύρωσης που χρησιμοποιούνται από τον αλγόριθμο. Πρέπει να είναι ακέραιος. Η προεπιλογή είναι 0.

- preprocessing_num_workers – Ο αριθμός των διεργασιών που θα χρησιμοποιηθούν για την προεπεξεργασία. Αν

None, η κύρια διαδικασία χρησιμοποιείται για την προεπεξεργασία. Η προεπιλογή είναιNone. - lora_r – Lora R. Πρέπει να είναι θετικός ακέραιος αριθμός. Η προεπιλογή είναι 8.

- lora_alpha – Λώρα Άλφα. Πρέπει να είναι θετικός ακέραιος αριθμός. Η προεπιλογή είναι 32

- lora_dropout – Lora Dropout. πρέπει να είναι θετική διακύμανση μεταξύ 0 και 1. Η προεπιλογή είναι 0.05.

- int8_quantization - Αν

True, το μοντέλο είναι φορτωμένο με ακρίβεια 8-bit για εκπαίδευση. Η προεπιλογή για τα 7B και 13B είναιFalse. Η προεπιλογή για 70Β είναιTrue. - enable_fsdp - Αν

True, η εκπαίδευση χρησιμοποιεί FSDP. Η προεπιλογή για τα 7B και 13B είναιTrue. Η προεπιλογή για 70Β είναιFalse. Σημειώστε ότιint8_quantizationδεν υποστηρίζεται με FSDP.

Τύποι παρουσιών και συμβατές υπερπαράμετροι

Η απαίτηση μνήμης κατά τη μικρορύθμιση μπορεί να ποικίλλει ανάλογα με διάφορους παράγοντες:

- Τύπος μοντέλου – Το μοντέλο 7B έχει τη λιγότερη απαίτηση μνήμης GPU και το 70B έχει τη μεγαλύτερη απαίτηση μνήμης

- Μέγιστο μήκος εισόδου – Μια υψηλότερη τιμή του μήκους εισόδου οδηγεί σε επεξεργασία περισσότερων διακριτικών κάθε φορά και ως εκ τούτου απαιτεί περισσότερη μνήμη CUDA

- Μέγεθος παρτίδας – Ένα μεγαλύτερο μέγεθος παρτίδας απαιτεί μεγαλύτερη μνήμη CUDA και επομένως απαιτεί μεγαλύτερους τύπους παρουσιών

- Κβαντισμός Int8 – Εάν χρησιμοποιείτε κβαντισμό Int8, το μοντέλο φορτώνεται σε χαμηλή ακρίβεια και επομένως απαιτεί λιγότερη μνήμη CUDA

Για να σας βοηθήσουμε να ξεκινήσετε, παρέχουμε ένα σύνολο συνδυασμών διαφορετικών τύπων παρουσιών, υπερπαραμέτρων και τύπων μοντέλων που μπορούν να τελειοποιηθούν με επιτυχία. Μπορείτε να επιλέξετε μια διαμόρφωση σύμφωνα με τις απαιτήσεις σας και τη διαθεσιμότητα των τύπων παρουσιών. Βελτιώνουμε και τα τρία μοντέλα σε μια ποικιλία ρυθμίσεων με τρεις εποχές σε ένα υποσύνολο του συνόλου δεδομένων Dolly με συνοπτικά παραδείγματα.

Μοντέλο 7Β

Ο παρακάτω πίνακας συνοψίζει τις επιλογές λεπτομέρειας στο μοντέλο 7B.

| Τύπος συμβολής | Max Input Len | Μέγεθος παρτίδας ανά συσκευή | Κβαντισμός Int8 | Ενεργοποίηση FSDP | Χρόνος που απαιτείται (λεπτά) |

| ml.g4dn.12xlarge | 1024 | 8 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 166 |

| ml.g4dn.12xlarge | 2048 | 2 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 178 |

| ml.g4dn.12xlarge | 1024 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 120 |

| ml.g4dn.12xlarge | 2048 | 2 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 143 |

| ml.g5.2xμεγάλο | 1024 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 61 |

| ml.g5.2xμεγάλο | 2048 | 2 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 68 |

| ml.g5.2xμεγάλο | 1024 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 43 |

| ml.g5.2xμεγάλο | 2048 | 2 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 49 |

| ml.g5.4xμεγάλο | 1024 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 39 |

| ml.g5.4xμεγάλο | 2048 | 2 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 50 |

| ml.g5.12xμεγάλο | 1024 | 16 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 57 |

| ml.g5.12xμεγάλο | 2048 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 64 |

| ml.g5.12xμεγάλο | 1024 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 26 |

| ml.g5.12xμεγάλο | 2048 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 23 |

| ml.g5.48xμεγάλο | 1024 | 16 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 59 |

| ml.g5.48xμεγάλο | 2048 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 67 |

| ml.g5.48xμεγάλο | 1024 | 8 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 22 |

| ml.g5.48xμεγάλο | 2048 | 4 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 21 |

13B

Ο παρακάτω πίνακας συνοψίζει τις επιλογές λεπτομέρειας στο μοντέλο 13B.

| Τύπος συμβολής | Max Input Len | Μέγεθος παρτίδας ανά συσκευή | Κβαντισμός Int8 | Ενεργοποίηση FSDP | Χρόνος που απαιτείται (λεπτά) |

| ml.g4dn.12xlarge | 1024 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 283 |

| ml.g4dn.12xlarge | 2048 | 2 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 328 |

| ml.g5.12xμεγάλο | 1024 | 8 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 92 |

| ml.g5.12xμεγάλο | 2048 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 104 |

| ml.g5.48xμεγάλο | 1024 | 8 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 95 |

| ml.g5.48xμεγάλο | 2048 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 107 |

| ml.g5.48xμεγάλο | 1024 | 8 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 35 |

| ml.g5.48xμεγάλο | 2048 | 2 | ΨΕΥΔΗΣ | ΑΛΗΘΙΝΗ | 41 |

70B

Ο παρακάτω πίνακας συνοψίζει τις επιλογές λεπτομέρειας στο μοντέλο 70B.

| Τύπος συμβολής | Max Input Len | Μέγεθος παρτίδας ανά συσκευή | Κβαντισμός Int8 | Ενεργοποίηση FSDP | Χρόνος που απαιτείται (λεπτά) |

| ml.g5.48xμεγάλο | 1024 | 4 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 396 |

| ml.g5.48xμεγάλο | 2048 | 1 | ΑΛΗΘΙΝΗ | ΨΕΥΔΗΣ | 454 |

Συστάσεις σχετικά με τους τύπους και τις υπερπαραμέτρους παραστάσεων

Όταν προσαρμόζετε την ακρίβεια του μοντέλου, λάβετε υπόψη τα εξής:

- Μεγαλύτερα μοντέλα όπως το 70B παρέχουν καλύτερη απόδοση από το 7B

- Η απόδοση χωρίς κβαντισμό Int8 είναι καλύτερη από την απόδοση με κβαντισμό INT8

Σημειώστε τις ακόλουθες απαιτήσεις χρόνου εκπαίδευσης και μνήμης CUDA:

- Ρύθμιση

int8_quantization=Trueμειώνει τις απαιτήσεις μνήμης και οδηγεί σε ταχύτερη προπόνηση. - Μείωση

per_device_train_batch_sizeκαιmax_input_lengthμειώνει την απαίτηση μνήμης και επομένως μπορεί να εκτελεστεί σε μικρότερες περιπτώσεις. Ωστόσο, η ρύθμιση πολύ χαμηλών τιμών μπορεί να αυξήσει τον χρόνο προπόνησης. - Εάν δεν χρησιμοποιείτε κβαντισμό Int8 (

int8_quantization=False), χρησιμοποιήστε το FSDP (enable_fsdp=True) για ταχύτερη και αποτελεσματική προπόνηση.

Όταν επιλέγετε τον τύπο του στιγμιότυπου, λάβετε υπόψη τα εξής:

- Οι παρουσίες G5 παρέχουν την πιο αποτελεσματική εκπαίδευση μεταξύ των υποστηριζόμενων τύπων παρουσιών. Επομένως, εάν έχετε διαθέσιμες παρουσίες G5, θα πρέπει να τις χρησιμοποιήσετε.

- Ο χρόνος εκπαίδευσης εξαρτάται σε μεγάλο βαθμό από τον αριθμό των GPU και τη διαθέσιμη μνήμη CUDA. Επομένως, η εκπαίδευση σε περιπτώσεις με τον ίδιο αριθμό GPU (για παράδειγμα, ml.g5.2xlarge και ml.g5.4xlarge) είναι περίπου η ίδια. Επομένως, μπορείτε να χρησιμοποιήσετε το φθηνότερο παράδειγμα για προπόνηση (ml.g5.2xlarge).

- Όταν χρησιμοποιείτε παρουσίες p3, η εκπαίδευση θα γίνεται με ακρίβεια 32 bit επειδή το bfloat16 δεν υποστηρίζεται σε αυτές τις περιπτώσεις. Επομένως, η εργασία εκπαίδευσης θα καταναλώσει διπλάσια ποσότητα μνήμης CUDA κατά την προπόνηση σε περιπτώσεις p3 σε σύγκριση με περιπτώσεις g5.

Για να μάθετε σχετικά με το κόστος της εκπαίδευσης ανά περίπτωση, ανατρέξτε στο Περιπτώσεις Amazon EC2 G5.

Εάν το σύνολο δεδομένων είναι σε μορφή συντονισμού εντολών και οι ακολουθίες εισαγωγής+ολοκλήρωσης είναι μικρές (όπως 50–100 λέξεις), τότε μια υψηλή τιμή max_input_length οδηγεί σε πολύ κακή απόδοση. Η προεπιλεγμένη τιμή αυτής της παραμέτρου είναι -1, η οποία αντιστοιχεί στο max_input_length του 2048 για μοντέλα Llama. Επομένως, συνιστούμε εάν το σύνολο δεδομένων σας περιέχει μικρά δείγματα, να χρησιμοποιήσετε μια μικρή τιμή για max_input_length (όπως 200–400).

Τέλος, λόγω της μεγάλης ζήτησης των παρουσιών G5, ενδέχεται να αντιμετωπίσετε τη μη διαθεσιμότητα αυτών των παρουσιών στην περιοχή σας με το σφάλμα “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Εάν αντιμετωπίσετε αυτό το σφάλμα, δοκιμάστε ξανά την εργασία εκπαίδευσης ή δοκιμάστε μια διαφορετική περιοχή.

Ζητήματα κατά τη μικρορύθμιση πολύ μεγάλων μοντέλων

Σε αυτήν την ενότητα, συζητάμε δύο ζητήματα κατά τη λεπτομέρεια ρύθμισης πολύ μεγάλων μοντέλων.

Απενεργοποιήστε τη συμπίεση εξόδου

Από προεπιλογή, η έξοδος μιας εργασίας εκπαίδευσης είναι ένα εκπαιδευμένο μοντέλο που συμπιέζεται σε μορφή .tar.gz πριν μεταφορτωθεί στο Amazon S3. Ωστόσο, λόγω του μεγάλου μεγέθους του μοντέλου, αυτό το βήμα μπορεί να διαρκέσει πολύ. Για παράδειγμα, η συμπίεση και η μεταφόρτωση του μοντέλου 70B μπορεί να διαρκέσει περισσότερες από 4 ώρες. Για να αποφύγετε αυτό το ζήτημα, μπορείτε να χρησιμοποιήσετε τη δυνατότητα απενεργοποίησης συμπίεσης εξόδου που υποστηρίζεται από την εκπαιδευτική πλατφόρμα SageMaker. Σε αυτήν την περίπτωση, το μοντέλο μεταφορτώνεται χωρίς συμπίεση, η οποία χρησιμοποιείται περαιτέρω για ανάπτυξη:

Ζήτημα χρονικού ορίου λήξης πυρήνα του SageMaker Studio

Λόγω του μεγέθους του μοντέλου Llama 70B, η εργασία εκπαίδευσης μπορεί να διαρκέσει αρκετές ώρες και ο πυρήνας του SageMaker Studio μπορεί να πεθάνει κατά τη φάση της εκπαίδευσης. Ωστόσο, κατά τη διάρκεια αυτής της περιόδου, η εκπαίδευση συνεχίζεται στο SageMaker. Εάν συμβεί αυτό, μπορείτε ακόμα να αναπτύξετε το τελικό σημείο χρησιμοποιώντας το όνομα εργασίας εκπαίδευσης με τον ακόλουθο κώδικα:

Για να βρείτε το όνομα της εργασίας εκπαίδευσης, μεταβείτε στην κονσόλα SageMaker και κάτω Εκπαίδευση στο παράθυρο πλοήγησης, επιλέξτε Εργασίες κατάρτισης. Προσδιορίστε το όνομα εργασίας εκπαίδευσης και αντικαταστήστε το στον προηγούμενο κωδικό.

Συμπέρασμα

Σε αυτήν την ανάρτηση, συζητήσαμε τη βελτίωση των μοντέλων Llama 2 της Meta χρησιμοποιώντας το SageMaker JumpStart. Δείξαμε ότι μπορείτε να χρησιμοποιήσετε την κονσόλα SageMaker JumpStart στο SageMaker Studio ή το SageMaker Python SDK για να τελειοποιήσετε και να αναπτύξετε αυτά τα μοντέλα. Συζητήσαμε επίσης την τεχνική μικρορύθμισης, τους τύπους παρουσιών και τις υποστηριζόμενες υπερπαραμέτρους. Επιπλέον, περιγράψαμε συστάσεις για βελτιστοποιημένη εκπαίδευση με βάση διάφορες δοκιμές που πραγματοποιήσαμε. Τα αποτελέσματα για τη λεπτομερή ρύθμιση των τριών μοντέλων σε δύο σύνολα δεδομένων εμφανίζονται στο παράρτημα στο τέλος αυτής της ανάρτησης. Όπως μπορούμε να δούμε από αυτά τα αποτελέσματα, η τελειοποίηση βελτιώνει τη σύνοψη σε σύγκριση με τα μοντέλα που δεν έχουν συντονιστεί με ακρίβεια. Ως επόμενο βήμα, μπορείτε να δοκιμάσετε να ρυθμίσετε αυτά τα μοντέλα στο δικό σας σύνολο δεδομένων χρησιμοποιώντας τον κώδικα που παρέχεται στο αποθετήριο GitHub για να δοκιμάσετε και να αξιολογήσετε τα αποτελέσματα για τις περιπτώσεις χρήσης σας.

Οι συγγραφείς θα ήθελαν να αναγνωρίσουν τις τεχνικές συνεισφορές των Christopher Whitten, Xin Huang, Kyle Ulrich, Sifei Li, Amy You, Adam Kozdrowicz, Evan Kravitz, Benjamin Crabtree, Haotian An, Manan Shah, Tony Cruz, Ernev Sharma, Jonathan Guinegagne και Κέρδισε.

Σχετικά με τους Συγγραφείς

Δρ Vivek Madan είναι Εφαρμοσμένος Επιστήμονας με την ομάδα Amazon SageMaker JumpStart. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Ιλινόις στο Urbana-Champaign και ήταν μεταδιδακτορικός ερευνητής στο Georgia Tech. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στο σχεδιασμό αλγορίθμων και έχει δημοσιεύσει εργασίες σε συνέδρια EMNLP, ICLR, COLT, FOCS και SODA.

Δρ Vivek Madan είναι Εφαρμοσμένος Επιστήμονας με την ομάδα Amazon SageMaker JumpStart. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Ιλινόις στο Urbana-Champaign και ήταν μεταδιδακτορικός ερευνητής στο Georgia Tech. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στο σχεδιασμό αλγορίθμων και έχει δημοσιεύσει εργασίες σε συνέδρια EMNLP, ICLR, COLT, FOCS και SODA.

Δρ Φαρούκ Σαμπίρ είναι Ανώτερος Αρχιτέκτονας Λύσεων Ειδικός Τεχνητής Νοημοσύνης και Μηχανικής Μάθησης στο AWS. Είναι κάτοχος διδακτορικού και μεταπτυχιακού τίτλου στον Ηλεκτρολόγο Μηχανικό από το Πανεπιστήμιο του Τέξας στο Ώστιν και μεταπτυχιακό στην Επιστήμη Υπολογιστών από το Ινστιτούτο Τεχνολογίας της Τζόρτζια. Έχει πάνω από 15 χρόνια εργασιακή εμπειρία και επίσης του αρέσει να διδάσκει και να καθοδηγεί φοιτητές. Στην AWS, βοηθά τους πελάτες να διαμορφώσουν και να λύσουν τα επιχειρηματικά τους προβλήματα στην επιστήμη δεδομένων, τη μηχανική μάθηση, την όραση υπολογιστών, την τεχνητή νοημοσύνη, την αριθμητική βελτιστοποίηση και τους σχετικούς τομείς. Με έδρα το Ντάλας του Τέξας, αυτός και η οικογένειά του λατρεύουν να ταξιδεύουν και να κάνουν μακρινά οδικά ταξίδια.

Δρ Φαρούκ Σαμπίρ είναι Ανώτερος Αρχιτέκτονας Λύσεων Ειδικός Τεχνητής Νοημοσύνης και Μηχανικής Μάθησης στο AWS. Είναι κάτοχος διδακτορικού και μεταπτυχιακού τίτλου στον Ηλεκτρολόγο Μηχανικό από το Πανεπιστήμιο του Τέξας στο Ώστιν και μεταπτυχιακό στην Επιστήμη Υπολογιστών από το Ινστιτούτο Τεχνολογίας της Τζόρτζια. Έχει πάνω από 15 χρόνια εργασιακή εμπειρία και επίσης του αρέσει να διδάσκει και να καθοδηγεί φοιτητές. Στην AWS, βοηθά τους πελάτες να διαμορφώσουν και να λύσουν τα επιχειρηματικά τους προβλήματα στην επιστήμη δεδομένων, τη μηχανική μάθηση, την όραση υπολογιστών, την τεχνητή νοημοσύνη, την αριθμητική βελτιστοποίηση και τους σχετικούς τομείς. Με έδρα το Ντάλας του Τέξας, αυτός και η οικογένειά του λατρεύουν να ταξιδεύουν και να κάνουν μακρινά οδικά ταξίδια.

Δρ Ashish Khetan είναι Senior Applied Scientist με το Amazon SageMaker JumpStart και βοηθά στην ανάπτυξη αλγορίθμων μηχανικής μάθησης. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Illinois Urbana-Champaign. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στα στατιστικά συμπεράσματα και έχει δημοσιεύσει πολλές εργασίες σε συνέδρια NeurIPS, ICML, ICLR, JMLR, ACL και EMNLP.

Δρ Ashish Khetan είναι Senior Applied Scientist με το Amazon SageMaker JumpStart και βοηθά στην ανάπτυξη αλγορίθμων μηχανικής μάθησης. Πήρε το διδακτορικό του από το Πανεπιστήμιο του Illinois Urbana-Champaign. Είναι ενεργός ερευνητής στη μηχανική μάθηση και στα στατιστικά συμπεράσματα και έχει δημοσιεύσει πολλές εργασίες σε συνέδρια NeurIPS, ICML, ICLR, JMLR, ACL και EMNLP.

Παράρτημα

Αυτό το παράρτημα παρέχει πρόσθετες πληροφορίες σχετικά με τη συγκριτική αξιολόγηση απόδοσης και τη μορφοποίηση δεδομένων.

Συγκριτική αξιολόγηση απόδοσης

Σε αυτήν την ενότητα, παρέχουμε αποτελέσματα για τη λεπτομερή ρύθμιση των τριών μοντέλων Llama 2 (7B, 13B και 70B) σε δύο διαφορετικά σύνολα δεδομένων: Κουκλίτσα και Διάλογος. Για το σύνολο δεδομένων Dolly, το καθήκον μας είναι να συνοψίσουμε μια παράγραφο κειμένου, ενώ για το Dialogsum, προσαρμόζουμε το μοντέλο για να συνοψίσουμε μια συζήτηση μεταξύ δύο ατόμων. Στους πίνακες που ακολουθούν, δείχνουμε τα δεδομένα εισόδου στο μοντέλο (προτροπή και οδηγίες), τη βασική αλήθεια (σύνοψη), την απόκριση από το προεκπαιδευμένο μοντέλο Llama 2 και την απόκριση από το βελτιωμένο μοντέλο Llama 2 για καθένα από τα τρία Llama 2 μοντέλα. Δείχνουμε αποτελέσματα συμπερασμάτων για πέντε σημεία δεδομένων. Μπορείτε να παρατηρήσετε από τους παρακάτω πίνακες ότι οι περιλήψεις βελτιώνονται και για τα δύο σύνολα δεδομένων όταν βελτιστοποιούμε τα μοντέλα.

- Αποτελέσματα για τη βελτίωση του μοντέλου δημιουργίας κειμένου Llama 2 7B στο σύνολο δεδομένων Dolly:

| Είσοδοι | Βασική αλήθεια | Απάντηση από το μη προσαρμοσμένο μοντέλο | Απάντηση από το Fine-Tuned Model |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Instruction:nWhere is Allauchnn### Input:nAllauch (Γαλλική προφορά: ; Οξιτανικά: Alaug) είναι μια γαλλική κοινότητα που βρίσκεται ανατολικά της Μασσαλίας στο διαμέρισμα Bouches-du-Rhône στην περιοχή Provence-Alpes-Côte d'Azur της Γαλλίας.nnΟι κάτοικοι της κοινότητας είναι γνωστοί ως Allaudiens ή Allaudiennes στα γαλλικά.nnnn### Απάντηση:n | Το Allauch είναι μια γαλλική κοινότητα που βρίσκεται ανατολικά της Μασσαλίας στο διαμέρισμα Bouches-du-Rhône στην περιοχή Provence-Alpes-Côte d'Azur της Γαλλίας.nnΟι κάτοικοι της κοινότητας είναι γνωστοί ως Allaudiens ή Allaudiennes στα γαλλικά. | Το Allauch είναι μια πόλη που βρίσκεται 28 χλμ ανατολικά της Μασσαλίας στο διαμέρισμα Bouches-du-Rhône στην περιοχή Provence-Alpes-Côte d'Azur της Γαλλίας. Θεωρείται ένα από τα πιο όμορφα χωριά της Γαλλίας. Η πόλη περιβάλλεται από λόφους και αμπελώνες και έχει πληθυσμό περίπου 6,000 κατοίκους. Αναφέρθηκε για πρώτη φορά το 1006 και έχει πλούσιο | Η κοινότητα βρίσκεται σε ένα βραχώδες οροπέδιο που ονομάζεται Massif du Gélas, που βρίσκεται ανατολικά της Μασσαλίας. Έχει όμορφη θέα στη Μασσαλία και τις ακτές της. Το Allauch είναι τώρα μια καλά ανεπτυγμένη κοινότητα με το δικό της δημαρχείο και μια σειρά από καταστήματα, μπαρ και εστιατόρια. Λόγω της θέσης του μεταξύ της Μασσαλίας και των Αλπυλών, έχει διατηρήσει πολλά φυσικά χαρακτηριστικά της περιοχής, συμπεριλαμβανομένου του ορεινού όγκου Glandes, γνωστό και ως «Δ |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που να ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΤι είναι ένα θηλαστικό που γεννά αυγά;nn### Εισαγωγή:nΟ πλατύποδας (Ornithorhynchus anatinus), που μερικές φορές αναφέρεται ως πλατύποδας με λυγμούς πάπιας, είναι ένα ημιυδρόβιο αυγό -ωοτόκο θηλαστικό ενδημικό στην ανατολική Αυστραλία, συμπεριλαμβανομένης της Τασμανίας. Ο πλατύποδας είναι ο μοναδικός ζωντανός εκπρόσωπος ή μονοτυπική ταξινόμηση της οικογένειας του (Ornithorhynchidae) και του γένους του (Ornithorhynchus), αν και ορισμένα σχετικά είδη εμφανίζονται στο αρχείο απολιθωμάτων.nnnn### Απάντηση:n | Ο πλατύποδας με ράμφους πάπιας είναι ένα θηλαστικό που γεννά αυγά που βρίσκεται στην ανατολική Αυστραλία. Είναι ο μοναδικός ζωντανός εκπρόσωπος στο γένος του Ornithorhynchus. | n Έκανα αρκετή έρευνα για την ερώτησή σου. Διάβασα όλες τις πληροφορίες που παρείχατε στη δεύτερη παράγραφο σας. Διάβασα επίσης λίγο για τον πλατύποδα, συμπεριλαμβανομένης αυτής της σελίδας (https://phys.org/news/2019-04-australia-platypus-predator-species.html). Νομίζω ότι βρήκα κάποιες απαντήσεις στην ερώτησή σου. Ρωτάτε αν ο πλατύπους είναι θηλαστικό που γεννά αυγά ή αν | Ένα θηλαστικό που γεννά αυγά, σαν πλατύπους |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠότε πέθανε ο Φέλιξ Λούνα;nn### Εισαγωγή:nΟ Φελίξ Σέζαρ Λούνα (30 Σεπτεμβρίου 1925 – 5 Νοεμβρίου 2009) ήταν Αργεντινός συγγραφέας, στιχουργός και ιστορικός.nnnn# ## Απάντηση:n | Ο Φέλιξ Λούνα πέθανε στις 5 Νοεμβρίου 2009 | Ο Félix César Luna (30 Σεπτεμβρίου 1925 – 5 Νοεμβρίου 2009) ήταν Αργεντινός Πότε πέθανε η Λούνα;nnn### Εξήγηση:nΑπαντάμε στην ερώτηση με την ημερομηνία γέννησης της εισαγωγής και την ημερομηνία θανάτου.nnn### Λύση: 1102n | Ο Félix Luna πέθανε στις 5 Νοεμβρίου 2009.nn |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΚαταγράψτε μερικά σημαντικά σημεία σχετικά με την οπτική ψευδαίσθηση από το δεδομένο απόσπασμα.nn### Είσοδος:nΣτην οπτική αντίληψη, μια οπτική ψευδαίσθηση (ονομάζεται επίσης οπτική ψευδαίσθηση ) είναι μια ψευδαίσθηση που προκαλείται από το οπτικό σύστημα και χαρακτηρίζεται από μια οπτική αντίληψη που αναμφισβήτητα φαίνεται να διαφέρει από την πραγματικότητα. Οι ψευδαισθήσεις έρχονται σε μεγάλη ποικιλία. Η κατηγοριοποίησή τους είναι δύσκολη, επειδή η υποκείμενη αιτία συχνά δεν είναι ξεκάθαρη, αλλά η αναταξινόμηση που προτείνεται από τον Richard Gregory είναι χρήσιμη ως προσανατολισμός. Σύμφωνα με αυτό, υπάρχουν τρεις κύριες τάξεις: σωματικές, φυσιολογικές και γνωστικές ψευδαισθήσεις, και σε κάθε τάξη υπάρχουν τέσσερα είδη: nΑσαφίες, παραμορφώσεις, παράδοξα και μυθοπλασίες. Ένα κλασικό παράδειγμα φυσικής παραμόρφωσης θα ήταν η φαινομενική κάμψη ενός ραβδιού μισοβυθισμένου στο νερό. Ένα παράδειγμα για ένα φυσιολογικό παράδοξο δεν είναι το επακόλουθο της κίνησης (όπου, παρά την κίνηση, η θέση παραμένει αμετάβλητη). Ένα παράδειγμα για την ανφυσιολογική μυθοπλασία είναι μια μετα-εικόνα. Τρεις τυπικές γνωστικές παραμορφώσεις είναι η ψευδαίσθηση Ponzo, Poggendorff, και Müller-Lyer. Οι φυσικές ψευδαισθήσεις προκαλούνται από το φυσικό περιβάλλον, π.χ. από τις οπτικές ιδιότητες του νερού. Φυσιολογικές ψευδαισθήσεις προκύπτουν στο μάτι ή στην οπτική οδό, π.χ. από τις επιδράσεις υπερβολικής διέγερσης ενός συγκεκριμένου τύπου υποδοχέα. Οι γνωστικές οπτικές ψευδαισθήσεις είναι αποτέλεσμα ασυνείδητων και είναι ίσως αυτές που είναι πιο γνωστές.nnnn### Απάντηση:n | 1. Η οπτική ψευδαίσθηση προκαλείται από το οπτικό σύστημα και χαρακτηρίζεται από μια οπτική αντίληψη που φαίνεται να μην είναι διαφορετική από την πραγματικότητα.n2. Σύμφωνα με τον Richard Gregory, μια ταξινόμηση που προτείνεται από αυτόν είναι χρήσιμη ως προσανατολισμός που, υπάρχουν τρεις κύριες κατηγορίες: φυσικές, φυσιολογικές και γνωστικές ψευδαισθήσεις, και σε κάθε τάξη υπάρχουν τέσσερα είδη: Αμφισημίες, παραμορφώσεις, παράδοξα και μυθοπλασίες.n3. Ένα παράδειγμα φυσικής παραμόρφωσης θα ήταν η φαινομενική κάμψη ενός ραβδιού μισοβυθισμένου στο νερό. Ένα παράδειγμα για ένα φυσιολογικό παράδοξο είναι το επακόλουθο της κίνησης (όπου, παρά την κίνηση, η θέση παραμένει αμετάβλητη). n4. Ένα παράδειγμα για μια φυσιολογική μυθοπλασία είναι μια μετα-εικόνα5. Τρεις γνωστικές παραμορφώσεις είναι η ψευδαίσθηση Ponzo, Poggendorff και Müller-Lyer.n6. Οι φυσικές ψευδαισθήσεις προκαλούνται από το φυσικό περιβάλλον, π.χ. από τις οπτικές ιδιότητες του νερού. Οι φυσιολογικές ψευδαισθήσεις προκύπτουν στο μάτι ή στην οπτική οδό.n7. Η πιο ευρέως γνωστή ψευδαίσθηση είναι οι οπτικές ψευδαισθήσεις που είναι το αποτέλεσμα ασυνείδητων συμπερασμάτων. | Η οπτική ψευδαίσθηση που αναφέρεται στο απόσπασμα είναι η ψευδαίσθηση κίνηση του ραβδιού που είναι μερικώς βυθισμένο στο νερό.nn## 50.n### Οδηγία:nΓράψτε ένα επιχείρημα για να υποστηρίξετε ή να αντικρούσετε τον ισχυρισμό:nΌλοι οι μαθητές στο εργαστήριό μας έχουν ο ίδιος μέσος όρος IQ.nn### Εισαγωγή:nΠολλοί μαθητές στο πείραμα έχουν τον ίδιο μέσο όρο IQ και πιστεύω ότι είναι το 10% με το υψηλότερο | Οι οπτικές ψευδαισθήσεις κάνουν χρήση των φυσιολογικών και ψυχολογικών περιορισμών που σχετίζονται με τον τρόπο με τον οποίο ερμηνεύουμε και ανταποκρινόμαστε σε οπτικά ερεθίσματα, τόσο ερεθίσματα στον κόσμο γύρω μας όσο και οπτικά ερεθίσματα που παράγονται εσωτερικά. Παρέχουν ένα κοινό ερέθισμα στα δύο συστήματα (φυσικό και ψυχολογικό/αντιληπτικό) που μας επιτρέπουν να συγκρίνουμε και τα δύο και να κατανοήσουμε τον τρόπο που λειτουργεί το καθένα. Υπάρχει μια ποικιλία διαφορετικών μορφών οπτικών ψευδαισθήσεων, που περιλαμβάνουν ψυχολογικές, |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΣυνοψίστε το δίλημμα του καινοτόμου σε λίγες προτάσειςnn### Input:nΠεριγράφει πώς μεγάλες κατεστημένες εταιρείες χάνουν μερίδιο αγοράς ακούγοντας τους πελάτες τους και παρέχοντας αυτό που φαίνεται να είναι το υψηλότερο -αξία προϊόντων, αλλά οι νέες εταιρείες που εξυπηρετούν πελάτες χαμηλής αξίας με κακώς αναπτυγμένη τεχνολογία μπορούν να βελτιώσουν αυτή την τεχνολογία σταδιακά μέχρι να είναι αρκετά καλήnnnn### Απάντηση:n | Το δίλημμα του καινοτόμου: Όταν οι νέες τεχνολογίες προκαλούν αποτυχία μεγάλων εταιρειών, που δημοσιεύτηκε για πρώτη φορά το 1997, είναι το πιο γνωστό έργο του καθηγητή και επιχειρηματία του Χάρβαρντ Κλέιτον Κρίστενσεν. Επεκτείνεται στην έννοια των διασπαστικών τεχνολογιών, έναν όρο που επινόησε σε ένα άρθρο του 1995 «Disruptive Technologies: Catching the Wave». Περιγράφει πώς μεγάλες κατεστημένες εταιρείες χάνουν μερίδιο αγοράς ακούγοντας τους πελάτες τους και παρέχοντας προϊόντα που φαίνεται να είναι τα υψηλότερης αξίας, αλλά οι νέες εταιρείες που εξυπηρετούν πελάτες χαμηλής αξίας με ανεπαρκώς ανεπτυγμένη τεχνολογία μπορούν να βελτιώσουν αυτή την τεχνολογία σταδιακά μέχρι να είναι αρκετά καλή να πάρει γρήγορα μερίδιο αγοράς από την καθιερωμένη επιχείρηση. Ο Christensen συνιστά στις μεγάλες εταιρείες να διατηρούν μικρά, ευκίνητα τμήματα που προσπαθούν να αναπαράγουν αυτό το φαινόμενο εσωτερικά για να αποφύγουν να παρασυρθούν και να ξεπεραστούν από τους ανταγωνιστές startup. | Γεια σου, n Συγγνώμη για την καθυστερημένη απάντηση!! Ήμουν σε διακοπές την περασμένη εβδομάδα :)nnThe Innovator's Dilemma από τον Clayton Christensen εξηγεί ότι «το δίλημμα του καινοτόμου είναι ότι η επιδίωξη μιας εταιρείας για διαρκή κέρδη εισάγοντας ή βελτιώνοντας τα προϊόντα της για να παρέχει μεγαλύτερη αξία στους υπάρχοντες πελάτες θα έχει ως αποτέλεσμα οι ίδιοι πελάτες να εγκαταλείψουν το εταιρεία να αγοράσει καινοτομίες που προσφέρουν τουλάχιστον κάποια αξία | Το The Innovator's Dilemma είναι ένα βιβλίο που εξηγεί πώς οι μεγάλες κατεστημένες εταιρείες χάνουν μερίδιο αγοράς ακούγοντας τους πελάτες τους και παρέχοντας προϊόντα που φαίνεται να είναι τα υψηλότερης αξίας, αλλά οι νέες εταιρείες που εξυπηρετούν πελάτες χαμηλής αξίας με κακώς αναπτυγμένη τεχνολογία μπορούν να βελτιώσουν αυτή την τεχνολογία σταδιακά μέχρι να είναι αρκετά καλό nn |

- Αποτελέσματα για τη βελτίωση του μοντέλου δημιουργίας κειμένου Llama 2 13B στο σύνολο δεδομένων Dolly:

| Είσοδοι | Βασική αλήθεια | Απάντηση από το μη προσαρμοσμένο μοντέλο | Απάντηση από το Fine-Tuned Model |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠοιος είναι ο επόμενος προπονητής στην Μπάγερν Μονάχου που θα αναλάβει τη σκυτάλη από τον Julian Nagelsmann;nn### Εισαγωγή:nΕποχή Nagelsmann (2021–2023)nΥπό τον νέο προπονητή Julian Nagelsmann, Η Μπάγερν ολοκλήρωσε τον άθλο της κατάκτησης 10 συνεχόμενων τίτλων της Μπουντεσλίγκα μετά τη νίκη με 3-1 στο Der Klassiker. Ωστόσο, η ομάδα έχασε απροσδόκητα από τη Βιγιαρεάλ στα προημιτελικά του Τσάμπιονς Λιγκ, βγαίνοντας σε εκείνη τη φάση για δεύτερη συνεχόμενη χρονιά. Στις 24 Μαρτίου 2023, ο Nagelsmann έμεινε ελεύθερος από την Bayern και αντικαταστάθηκε από τον Thomas Tuchel, ο οποίος έλαβε συμβόλαιο μέχρι τις 30 Ιουνίου 2025.nnnn### Απάντηση:n | Ο Thomas Tuchel αντικατέστησε τον Julian Nagelsmann τον Μάρτιο του 2023 και τώρα είναι ο νέος προπονητής στην FC Bayern Munich, ενώ προηγουμένως ήταν προπονητής στην Chelsea. | nn"`pythonn{n "instruction": "Ποιος είναι ο επόμενος προπονητής στην Fc Bayern München που θα αναλάβει τον Julian Nagelsmann;", n "action": "next coach of FC Bayern", n "context":{n " Εποχή Nagelsmann (2021–2023)”: n ” Με τον νέο προπονητή Julian Nagelsmann, η Μπάγερν ολοκλήρωσε τον άθλο της κατάκτησης 10 συνεχόμενων τίτλων Bundesliga | Ο επόμενος προπονητής στην Μπάγερν Μονάχου θα είναι ο Τόμας Τούχελ. Ο Tuchel θα αναλάβει τον Julian Nagelsmann μετά την αποχώρηση του Nagelsmann από την ομάδα στις 24 Μαρτίου 2023.nn |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που να ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠείτε μου για τη ζωή του Adolphe Cohnnn### Εισαγωγή:nΟ Adolphe Cohn (29 Μαΐου 1851–1930) ήταν Γαλλοαμερικανός εκπαιδευτικός, γεννημένος στο Παρίσι. Αποφοίτησε από το Πανεπιστήμιο του Παρισιού το 1868 και σπούδασε νομικά, ιστορική κριτική και φιλολογία σε διάφορα ιδρύματα τριτοβάθμιας εκπαίδευσης στο Παρίσι, λαμβάνοντας τα πτυχία LL.B. το 1873. Μαθητής της École des Chartes, η διατριβή του ονομαζόταν Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires και πήρε το δίπλωμα του «igraphivisteepalé» το 1874. Κατά την έναρξη του Γαλλο-πρωσικού πολέμου το 1870, κατατάχθηκε και υπηρέτησε στον γαλλικό στρατό καθ' όλη τη διάρκεια του αγώνα. République française, που επιμελήθηκε τότε ο Léon Gambetta, τον οποίο είχε γνωρίσει στη Γαλλία και του οποίου τις πολιτικές απόψεις είχε υιοθετήσει. Τον Μάρτιο του 13, ο Cohn διορίστηκε δάσκαλος Γαλλικών στο Κολέγιο Κολούμπια και αμέσως μετά έγινε εκπαιδευτής. Με λαϊκή ψηφοφορία των Γάλλων κατοίκων της Νέας Υόρκης επιλέχθηκε να εκφωνήσει τον επικήδειο λόγο στην Gambetta το 1875 στο Tammany Hall, και το 1876 κλήθηκε από το Cambridge της Μασαχουσέτης για παρόμοιο σκοπό, μετά το θάνατο του Victor Hugo.nnnn ### Απάντηση:n | Ο Adolphe Cohn (29 Μαΐου 1851 – 1930) ήταν Γαλλοαμερικανός εκπαιδευτικός, γεννημένος στο Παρίσι. Αποφοίτησε από το Πανεπιστήμιο του Παρισιού το 1868 και σπούδασε νομικά, ιστορική κριτική και φιλολογία σε διάφορα ιδρύματα τριτοβάθμιας εκπαίδευσης στο Παρίσι, λαμβάνοντας τα πτυχία LL.B. το 1873. nnΜαθητής της École des Chartes, η διατριβή του ονομαζόταν Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions «extraordinaires» και πήρε το δίπλωμα του archiveographepal. το 1874. Κατά την έναρξη του Γαλλο-πρωσικού πολέμου το 1870, κατατάχθηκε και υπηρέτησε στον γαλλικό στρατό καθ' όλη τη διάρκεια του αγώνα. République française, που επιμελήθηκε τότε ο Léon Gambetta, τον οποίο είχε γνωρίσει στη Γαλλία και του οποίου τις πολιτικές απόψεις είχε υιοθετήσει. Τον Μάρτιο του 13, ο Cohn διορίστηκε δάσκαλος Γαλλικών στο Κολέγιο Κολούμπια και αμέσως μετά έγινε εκπαιδευτής. Με λαϊκή ψηφοφορία των Γάλλων κατοίκων της Νέας Υόρκης επιλέχθηκε να εκφωνήσει τον επικήδειο λόγο στη Γκαμπέτα το 1875 στο Tammany Hall και το 1876 κλήθηκε από το Κέμπριτζ της Μασαχουσέτης για παρόμοιο σκοπό, μετά το θάνατο του Βίκτορ Ουγκώ. | nAdolphe Cohn (29 Μαΐου 1851 – 1930) ήταν Γαλλοαμερικανός εκπαιδευτικός, γεννημένος στο Παρίσι. Αποφοίτησε από το Πανεπιστήμιο του Παρισιού το 1868 και σπούδασε νομικά, ιστορική κριτική και φιλολογία σε διάφορα ιδρύματα τριτοβάθμιας εκπαίδευσης στο Παρίσι, λαμβάνοντας τα πτυχία LL.B. το 1873. Μαθητής του Ε | Ο Adolphe Cohn ήταν Γαλλοαμερικανός εκπαιδευτικός που γεννήθηκε στο Παρίσι στις 29 Μαΐου 1851. Σπούδασε στο Πανεπιστήμιο του Παρισιού και απέκτησε πτυχίο νομικής το 1873. Εργάστηκε επίσης στην École des Chartes και απέκτησε το πτυχίο του "αρχειοθέτη παλαιογραφία" στο 1874. Με την έναρξη του Γαλλο-Πρωσικού Πολέμου, εντάχθηκε στον γαλλικό στρατό και τους υπηρέτησε για το σύνολο. |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠώς άλλαξε το κοινό-στόχος της McDonald's με την πάροδο του χρόνου;nn### Εισαγωγή:nΤα εστιατόρια γρήγορου φαγητού συχνά στοχεύουν μέρος της διαφήμισής τους απευθείας στον νεανικό πληθυσμό. Τα McDonald's Happy Meals, τα οποία περιλαμβάνουν ένα παιχνίδι που συχνά συνδέεται με μια νέα οικογενειακή ταινία, είναι ένα σημαντικό παράδειγμα. Ο Ronald McDonald, μια διαφημιστική μασκότ κλόουν που παρουσιάστηκε το 1963 και σχεδιάστηκε για να ελκύει τα μικρά παιδιά, είναι μια άλλη. Επιπλέον, το 1987 τα McDonald's ενσωμάτωσαν ένα Play Place στα εστιατόριά τους για περαιτέρω διαφήμιση στα παιδιά, κάνοντας τα εστιατόριά τους ένα πιο ελκυστικό περιβάλλον για τα παιδιά. Επιπλέον, από το 1996 έως το 2006, η Disney ήταν αποκλειστικός συνεργάτης των McDonald's, συνδέοντας τα προϊόντα τους μεταξύ τους. Ανακοίνωσαν το τέλος αυτής της συμφωνίας τον Μάιο του 2006, με ορισμένες αναφορές να λένε ότι η Disney ανησυχούσε για την παιδική παχυσαρκία. Εκτός από τη Disney, η McDonald's συνεργάζεται επίσης με τη Nintendo από το 1985, όταν πρωτοπαρουσιάστηκε το Nintendo Entertainment System. Το 1987, τα McDonald's δημιούργησαν επίσης μια περιοχή παιχνιδιού Nintendo στα εστιατόριά τους, όπου τα παιδιά μπορούσαν να παίξουν στις κονσόλες της Nintendo περιμένοντας το φαγητό τους. Κατά τη διάρκεια του 2007, η McDonald's άρχισε να παρέχει WiFi από τις κονσόλες της Nintendo. δίνοντας στα παιδιά τη δυνατότητα να παίζουν όπου κι αν βρίσκονταν. Με ένα κοινό-στόχο παιδιών που κυκλοφορούν αυτές τις νέες ταινίες και ενσωματώνουν παιχνίδια, χρησιμοποιεί τα παιδιά για να προσεγγίσουν τις τσέπες των γονιών τους λόγω της μεγάλης επένδυσής τους.nnnn### Απάντηση:n | Τα McDonald's στόχευαν με συνέπεια τη διαφήμισή τους απευθείας στον νεανικό πληθυσμό.nnΞεκινώντας το 1963, παρουσίασαν τον Ronald McDonald, μια διαφημιστική μασκότ κλόουν που σχεδιάστηκε για να ελκύει τα μικρά παιδιά. Με τα χρόνια, η McDonald's συνεργάστηκε με πολλές εταιρείες που έχουν προϊόντα που απευθύνονται σε παιδιά, όπως η Nintendo και η Disney. | Τα εστιατόρια γρήγορου φαγητού στόχευαν πάντα τον νεανικό πληθυσμό. Τα χαρούμενα γεύματα είναι επίσης ένας τεράστιος παράγοντας όσον αφορά τη διαφήμιση στους νέους. Μια νέα εταιρεία με μια σχετικά στενή οπτική για τον κόσμο, η McDonald's το έκανε | Από την κυκλοφορία του, η McDonald's στόχευσε το κοινό της σε μικρά παιδιά και εφήβους με τα εστιατόρια γρήγορου φαγητού και τα προϊόντα διατροφής προσανατολισμένα προς τα παιδιά, καθώς και τη διαφήμισή της, η οποία έχει στοχεύσει σε μεγάλο βαθμό τη νεολαία. Ενώ τα παιδιά οδηγούνται στα McDonalds από τους γονείς τους, το εστιατόριο είναι στην ουσία μια γονική διαφήμιση για τα παιδιά τους: Τα McDonalds απευθύνονται στα παιδιά με τα εστιατόρια με τα έντονα χρώματα και τα παιχνίδια που βρίσκονται στο φαγητό τους που απευθύνονται σε |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΤι είναι το Anandapuram mandalnn### Εισαγωγή:nΤο μαντάλ του Anandapuram είναι ένα από τα 46 μαντάλ στην περιοχή Visakhapatnam της ινδικής πολιτείας Andhra Pradesh. Υπάγεται στη διαχείριση του τμήματος εσόδων της Visakhapatnam και τα κεντρικά γραφεία βρίσκονται στο Anandapuram. Το μαντάλ Anandapuram οριοθετείται από το μαντάλ Bheemunipatnam στα ανατολικά, την Chinagadila στα νότια, το Padmanabham στα βόρεια και το Kothavalasa στα δυτικά.nnnn### Απάντηση:n | Το Anandapuram mandal είναι ένα από τα 46 μαντάλ στην περιοχή Visakhapatnam της ινδικής πολιτείας Andhra Pradesh. Υπάγεται στη διαχείριση του τμήματος εσόδων της Visakhapatnam και τα κεντρικά γραφεία βρίσκονται στο Anandapuram. | nnnn | Το Anandapuram mandal είναι ένα από τα 46 μαντάλ στην περιοχή Visakhapatnam της ινδικής πολιτείας Andhra Pradesh. Υπάγεται στη διαχείριση του τμήματος εσόδων της Visakhapatnam και τα κεντρικά γραφεία βρίσκονται στο Anandapuram. Το μαντάλ Anandapuram οριοθετείται από το μαντάλ Bheemunipatnam στα ανατολικά, την Chinagadila στο νότο, το Padmanabham στα βόρεια και το Koth |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΤι συνέβη στο Woodstocknn### Εισαγωγή:nΤο Woodstock Music and Art Fair, που συνήθως αναφέρεται ως Woodstock, ήταν ένα μουσικό φεστιβάλ που πραγματοποιήθηκε από 15–18 Αυγούστου 1969, στις Το γαλακτοκομικό αγρόκτημα Max Yasgur στο Bethel, Νέα Υόρκη, Ηνωμένες Πολιτείες, 40 μίλια (65 χλμ.) νοτιοδυτικά της πόλης Woodstock. Ονομάστηκε ως "A Aquarian Exposition: 3 Days of Peace & Music" και εναλλακτικά αναφέρεται ως Woodstock Rock Festival, προσέλκυσε ένα κοινό με περισσότερους από 400,000 παρευρισκόμενους. Τριάντα δύο πράξεις πραγματοποιήθηκαν σε εξωτερικούς χώρους παρά τη σποραδική βροχή. Ήταν ένα από τα μεγαλύτερα μουσικά φεστιβάλ που πραγματοποιήθηκε στην ιστορία.nnΤο φεστιβάλ θεωρείται ευρέως ως μια κομβική στιγμή στην ιστορία της λαϊκής μουσικής καθώς και ως καθοριστικό γεγονός για τη γενιά της αντικουλτούρας. Η σημασία της εκδήλωσης ενισχύθηκε από μια ταινία ντοκιμαντέρ του 1970, ένα συνοδευτικό άλμπουμ soundtrack και ένα τραγούδι που έγραψε η Joni Mitchell που έγινε μεγάλη επιτυχία τόσο για τους Crosby, Stills, Nash & Young όσο και για τους Matthews Southern Comfort. Μουσικές εκδηλώσεις που έφεραν το όνομα Woodstock είχαν προγραμματιστεί για επετείους, οι οποίες περιελάμβαναν τη δέκατη, την εικοστή, την εικοστή πέμπτη, την τριακοστή, την τεσσαρακοστή και την πεντηκοστή. Το 2004, το περιοδικό Rolling Stone το κατέταξε ως το νούμερο 19 από τις 50 στιγμές που άλλαξαν την ιστορία του Rock and Roll. Το 2017, ο ιστότοπος του φεστιβάλ καταχωρήθηκε στο Εθνικό Μητρώο Ιστορικών Τόπων.nnnn### Απάντηση:n | Το Woodstock Music and Art Fair, κοινώς γνωστό ως Woodstock, ήταν ένα μουσικό φεστιβάλ που πραγματοποιήθηκε από τις 15 έως τις 18 Αυγούστου 1969, στο γαλακτοκομείο του Max Yasgur στο Bethel, Νέα Υόρκη, Ηνωμένες Πολιτείες, 40 μίλια (65 χλμ.) νοτιοδυτικά της πόλης. του Γούντστοκ. Ονομάστηκε ως "A Aquarian Exposition: 3 Days of Peace & Music" και εναλλακτικά αναφέρεται ως Woodstock Rock Festival, προσέλκυσε ένα κοινό με περισσότερους από 400,000 παρευρισκόμενους. Τριάντα δύο πράξεις πραγματοποιήθηκαν σε εξωτερικούς χώρους παρά τη σποραδική βροχή. Ήταν ένα από τα μεγαλύτερα μουσικά φεστιβάλ που πραγματοποιήθηκε στην ιστορία.nnΤο φεστιβάλ θεωρείται ευρέως ως μια κομβική στιγμή στην ιστορία της λαϊκής μουσικής καθώς και ως καθοριστικό γεγονός για τη γενιά της αντικουλτούρας. Η σημασία της εκδήλωσης ενισχύθηκε από μια ταινία ντοκιμαντέρ του 1970, ένα συνοδευτικό άλμπουμ soundtrack και ένα τραγούδι που έγραψε η Joni Mitchell που έγινε μεγάλη επιτυχία τόσο για τους Crosby, Stills, Nash & Young όσο και για τους Matthews Southern Comfort. Μουσικές εκδηλώσεις που έφεραν το όνομα Woodstock είχαν προγραμματιστεί για επετείους, οι οποίες περιελάμβαναν τη δέκατη, την εικοστή, την εικοστή πέμπτη, την τριακοστή, την τεσσαρακοστή και την πεντηκοστή. Το 2004, το περιοδικό Rolling Stone το κατέταξε ως το νούμερο 19 από τις 50 στιγμές που άλλαξαν την ιστορία του Rock and Roll. Το 2017, η τοποθεσία του φεστιβάλ περιλήφθηκε στο Εθνικό Μητρώο Ιστορικών Τόπων. | nAnswer:nn“`jsndocument.getElementById('_0x1000').innerHTML = “https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn“`n nn## Λύση:nn n Για να δείτε τη λύση nn“`jsnn// Απαιτείται λύση | Το Woodstock Music and Art Fair που πραγματοποιήθηκε κατά το δεύτερο μέρος των 15-18 Αυγούστου, ήταν ένα ιστορικό γεγονός στο Μπέθελ της Νέας Υόρκης από τη γενιά της αντικουλτούρας. Το πλήθος στο φεστιβάλ ήταν περισσότεροι από 400,000 παρευρισκόμενοι. Περίπου 32 πράξεις πραγματοποιήθηκαν σε εξωτερικούς χώρους παρά τη σποραδική βροχή. Θεωρήθηκε ως ένα από τα μεγαλύτερα μουσικά φεστιβάλ που είχαν υπάρξει ποτέ στην ιστορία.nn |

- Αποτελέσματα για τη βελτίωση του μοντέλου δημιουργίας κειμένου Llama 2 70B στο σύνολο δεδομένων Dolly:

| Είσοδοι | Βασική αλήθεια | Απάντηση από το μη προσαρμοσμένο μοντέλο | Απάντηση από το Fine-Tuned Model |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠοια είναι η εταιρεία Η ABBnn### Εισαγωγή:nABB Ltd. είναι μια σουηδο-ελβετική πολυεθνική εταιρεία με έδρα τη Ζυρίχη της Ελβετίας. Η εταιρεία ιδρύθηκε το 1988 όταν η σουηδική Allmänna Svenska Elektriska Aktiebolaget (ASEA) και η ελβετική Brown, Boveri & Cie συγχωνεύτηκαν για να δημιουργήσουν την ASEA Brown Boveri, που αργότερα απλοποιήθηκε στα αρχικά ABB. Και οι δύο εταιρείες ιδρύθηκαν στα τέλη του 1800 και ήταν σημαντικοί κατασκευαστές ηλεκτρικού εξοπλισμού, μια επιχείρηση στην οποία η ABB παραμένει ενεργή σήμερα. Έκτοτε, η εταιρεία επεκτάθηκε στη ρομποτική και την τεχνολογία αυτοματισμού.nnnn### Απάντηση:n | Η ABB Ltd. είναι μια σουηδο-ελβετική πολυεθνική εταιρεία με έδρα τη Ζυρίχη της Ελβετίας. Η εταιρεία ιδρύθηκε το 1988 όταν η Σουηδική Allmanna Svenska Elektriska Aktiebolaget (ASEA) και η ελβετική Brown, Boveri & Cie συγχωνεύτηκαν για να δημιουργήσουν την ASEA Brown Boveri, που αργότερα απλοποιήθηκε στα αρχικά ABB. nnΚαι οι δύο εταιρείες ιδρύθηκαν στα τέλη του 1800 και ήταν σημαντικοί κατασκευαστές ηλεκτρικού εξοπλισμού, μια επιχείρηση στην οποία η ABB παραμένει ενεργή σήμερα. Έκτοτε, η εταιρεία επεκτάθηκε στη ρομποτική και την τεχνολογία αυτοματισμού. | * Η ABB είναι μια σουηδική-ελβετική πολυεθνική εταιρείαnn### LognEND I/O DATA —n | Η ABB είναι μια σουηδο-ελβετική πολυεθνική εταιρεία με έδρα τη Ζυρίχη της Ελβετίας. Η εταιρεία ιδρύθηκε το 1988 όταν η σουηδική Allmänna Svenska Elektriska Aktiebolaget (ASEA) και η ελβετική Brown, Boveri & Cie συγχωνεύτηκαν για να δημιουργήσουν την ASEA Brown Boveri, που αργότερα απλοποιήθηκε στα αρχικά ABB. Και οι δύο εταιρείες ιδρύθηκαν στα τέλη του 1800 και ήταν |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που να ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΓιατί ένας Γουίλιαμ ο Κατακτητής, ένας Γάλλος, έγινε βασιλιάς της Αγγλίας;nn### Εισαγωγή:nΣτη δεκαετία του 1050 και στις αρχές του 1060, ο Γουίλιαμ έγινε υποψήφιος για θρόνο της Αγγλίας που κατείχε ο άτεκνος Εδουάρδος ο Ομολογητής, ο πρώτος του ξάδερφος που κάποτε απομακρύνθηκε. Υπήρχαν και άλλοι πιθανοί διεκδικητές, συμπεριλαμβανομένου του ισχυρού Άγγλου κόμη Χάρολντ Γκόντγουινσον, τον οποίο ο Εδουάρδος ονόμασε βασιλιά στο νεκροκρέβατό του τον Ιανουάριο του 1066. Υποστηρίζοντας ότι ο Εδουάρδος του είχε υποσχεθεί προηγουμένως τον θρόνο και ότι ο Χάρολντ είχε ορκιστεί να υποστηρίξει την αξίωσή του, ο Γουίλιαμ έχτισε ένα μεγάλο στόλο και εισέβαλε στην Αγγλία τον Σεπτέμβριο του 1066. Νίκησε αποφασιστικά και σκότωσε τον Χάρολντ στη Μάχη του Χέιστινγκς στις 14 Οκτωβρίου 1066. Μετά από περαιτέρω στρατιωτικές προσπάθειες, ο Γουίλιαμ στέφθηκε βασιλιάς την ημέρα των Χριστουγέννων του 1066 στο Λονδίνο. Έκανε ρυθμίσεις για τη διακυβέρνηση της Αγγλίας στις αρχές του 1067 πριν επιστρέψει στη Νορμανδία. Ακολούθησαν αρκετές ανεπιτυχείς εξεγέρσεις, αλλά η κυριαρχία του Γουίλιαμ ήταν ως επί το πλείστον ασφαλής στην Αγγλία μέχρι το 1075, επιτρέποντάς του να περάσει το μεγαλύτερο μέρος της βασιλείας του στην ηπειρωτική Ευρώπη.nnnn### Απάντηση:n | Ο Γουλιέλμος ο Κατακτητής ήταν από τη Νορμανδία, που βρίσκεται στη βορειοδυτική Γαλλία. Ο βασιλιάς της Αγγλίας στα τέλη της δεκαετίας του 1050 και στις αρχές του 1060 ήταν ο Εδουάρδος ο Ομολογητής. Ο Έντουαρντ ήταν ξάδερφος του Γουίλιαμ. Δεδομένου ότι ο Εδουάρδος ήταν άτεκνος, υπήρχαν πολλοί άνθρωποι που ισχυρίστηκαν ότι ήταν ο νόμιμος κληρονόμος και ότι έπρεπε να γίνουν βασιλιάς. Αυτοί οι αντικρουόμενοι ισχυρισμοί οδήγησαν σε ένοπλες συγκρούσεις. Ο Γουίλιαμ εισέβαλε στην Αγγλία, όπου κέρδισε τη μάχη του Χάστινγκς, νικώντας τον κόμη Χάρολντ Γκόντγουινσον. Ακολούθησαν αρκετές μάχες, αλλά ο Γουίλιαμ έγινε βασιλιάς της Αγγλίας στα τέλη του 1066. Αντιμετώπισε πολλαπλές εξεγέρσεις την επόμενη δεκαετία, αλλά διατήρησε την εξουσία του. Τελικά μπόρεσε να επιστρέψει στη Νορμανδία και να κυβερνήσει την Αγγλία από εκεί. | Ο Γουλιέλμος ο Κατακτητής έγινε βασιλιάς της Αγγλίας καθώς στη δεκαετία του 1050 και στις αρχές του 1060, έγινε διεκδικητής του θρόνου της Αγγλίας που κατείχε ο άτεκνος Εδουάρδος ο Εξομολογητής, ο πρώτος του ξάδερφος μόλις αφαιρεθεί.nnnΗ απάντηση μπορεί να είναι κενή, αλλά πρέπει να χωράει σε 256 χαρακτήρες. n | Μετά το θάνατο του βασιλιά Χάρολντ στη μάχη του Χέιστινγκς στις 14 Οκτωβρίου 1066, ο Γουλιέλμος ο Κατακτητής στέφθηκε Βασιλιάς της Αγγλίας την ημέρα των Χριστουγέννων του 1066, καθιερώνοντας τη νορμανδική κατάκτηση της Αγγλίας.nn |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΠείτε μου για το RMS Adriaticnn### Εισαγωγή:nRMS Η Αδριατική ήταν ένα βρετανικό υπερωκεάνιο της White Star Line. Ήταν το τέταρτο από ένα κουαρτέτο πλοίων άνω των 20,000 GRT, που ονομάστηκαν The Big Four. Το πλοίο ήταν το μόνο από τα τέσσερα που δεν ήταν ποτέ το μεγαλύτερο πλοίο του κόσμου. Ωστόσο, ήταν η μεγαλύτερη, η ταχύτερη και η πιο πολυτελής από τις Big Four, καθώς ήταν το πρώτο υπερωκεάνιο που είχε εσωτερική πισίνα και τούρκικο λουτρό. συνδέοντας, από το 1911, η αδελφή της πλοία στο δευτερεύον δρομολόγιο από το Λίβερπουλ. Στην πραγματικότητα ήταν αργά πλοία που προορίζονταν να παρέχουν υπηρεσίες σε μέτριες τιμές. Όταν ξέσπασε ο Πρώτος Παγκόσμιος Πόλεμος, η Αδριατική ήταν μεταξύ των πλοίων που συνέχισαν την πολιτική υπερατλαντική τους υπηρεσία, ενώ μετέφεραν πολλές προμήθειες. Το 1917, επιτάχθηκε και υπηρέτησε ως μεταφορέας στρατευμάτων.nnΜετά τον πόλεμο, επανατοποθετήθηκε πολλές φορές και σταδιακά χρησιμοποιήθηκε για κρουαζιέρες, οι οποίες έγιναν οι κύριες υπηρεσίες της τη δεκαετία του 1930. Όταν η Cunard Line και η White Star Line συγχωνεύθηκαν το 1934, κρίθηκε γρήγορα περιττή και πουλήθηκε στο τέλος του έτους. Διαλύθηκε στην Οσάκα το 1935.nnnn### Απάντηση:n | Το RMS Adriatic ήταν ένα βρετανικό υπερωκεάνιο της White Star Line. Ήταν το τέταρτο από ένα κουαρτέτο πλοίων άνω των 20,000 GRT, που ονομάστηκαν The Big Four. Το πλοίο ήταν το μόνο από τα τέσσερα που δεν ήταν ποτέ το μεγαλύτερο πλοίο του κόσμου. Ωστόσο, ήταν η μεγαλύτερη, η ταχύτερη και η πιο πολυτελής από τους Big Four, καθώς ήταν το πρώτο υπερωκεάνιο που είχε εσωτερική πισίνα και χαμάμ. | Το RMS Adriatic ήταν ένα βρετανικό υπερωκεάνιο της White Star Line. Ήταν το τέταρτο από ένα κουαρτέτο πλοίων άνω των 20,000 GRT, που ονομάστηκαν The Big Four. Το πλοίο ήταν το μόνο από τα τέσσερα που δεν ήταν ποτέ το μεγαλύτερο πλοίο του κόσμου. nn### ΠεριεχόμενοnΜια ερώτηση αυτού του τύπου χρησιμοποιείται συνήθως για την υποβολή ερωτημάτων σε μια μηχανή αναζήτησης. Η είσοδος είναι μια είσοδος του ερωτήματος και η απάντηση είναι η δημόσια | Το RMS Adriatic ήταν ένα βρετανικό υπερωκεάνιο της γραμμής των λευκών αστέρων. Καθελκύστηκε το 1906, αλλά το πρώτο της εμπορικό ταξίδι ήταν το 1907. Ήταν το τέταρτο από ένα κουαρτέτο πλοίων άνω των 20,000 τόνων και ονομάστηκε Big Four. Τα άλλα τρία ήταν το RMS Celtic το 1901, το RMS Baltic το 1903 και το R |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγία:nΤι είναι το CGRO που ανιχνεύει φωτόνια;nn### Εισαγωγή:nΤο Παρατηρητήριο ακτίνων γάμμα Compton (CGRO) ήταν ένα διαστημικό παρατηρητήριο που ανιχνεύει φωτόνια με ενέργειες από 20 keV έως 30 GeV, σε τροχιά της Γης από το 1991 έως το 2000. Το παρατηρητήριο διέθετε τέσσερα κύρια τηλεσκόπια σε ένα διαστημόπλοιο, που κάλυπταν ακτίνες Χ και ακτίνες γάμμα, συμπεριλαμβανομένων διαφόρων εξειδικευμένων υποοργάνων και ανιχνευτών. Μετά από 14 χρόνια προσπάθειας, το αστεροσκοπείο εκτοξεύτηκε από το Διαστημικό Λεωφορείο Ατλαντίς κατά τη διάρκεια του STS-37 στις 5 Απριλίου 1991 και λειτούργησε μέχρι την έκθεσή του στις 4 Ιουνίου 2000. Αναπτύχθηκε σε χαμηλή τροχιά της Γης στα 450 km (280 mi) αποφύγετε τη ζώνη ακτινοβολίας Van Allen. Ήταν το βαρύτερο αστροφυσικό ωφέλιμο φορτίο που είχε ποτέ πετάξει εκείνη την εποχή με 17,000 κιλά (37,000 λίβρες).nnnn### Απάντηση:n | Το CGRO είναι το Compton Ray Ray Observatory (CGRO) και ήταν ένα διαστημικό παρατηρητήριο που ανιχνεύει φωτόνια με ενέργειες από 20 keV έως 30GeV στη γη από το 1991 έως το 2000. | **Μεταγραφέας:** Το όργανο EGRET ανιχνεύει φωτόνια.nn | Το Παρατηρητήριο ακτίνων γάμμα Compton (CGRO) μετρά φωτόνια με ενέργειες από 20 keV έως 30 GeV.nn |

| Παρακάτω είναι μια οδηγία που περιγράφει μια εργασία, σε συνδυασμό με μια είσοδο που παρέχει περαιτέρω πλαίσιο. Γράψτε μια απάντηση που ολοκληρώνει κατάλληλα το αίτημα.nn### Οδηγίες:nΠόσο καλός ως πιανίστας είναι ο Yeol Eum Sonnn### Εισαγωγή: nYeol Eum Son (γεννημένος στις 2 Μαΐου 1986, στο Wonju της Νότιας Κορέας) είναι ένα νοτιοκορεάτικο κλασικό πιανίστας. Τράβηξε για πρώτη φορά τη διεθνή προσοχή τον Οκτώβριο του 2004, σε ηλικία 18 ετών, όταν εμφανίστηκε ως σολίστ ερμηνεύοντας το Κοντσέρτο για πιάνο Νο. 1 του Λιστ με τη Φιλαρμονική της Νέας Υόρκης υπό τη διεύθυνση του Λορίν Μάαζελ στην περιοδεία τους στην Ασία στη Σεούλ, το Νταϊτζέον και το Τόκιο. Ο Son έπαιξε ξανά με τους Maazel και τη Φιλαρμονική της Νέας Υόρκης όταν επέστρεψαν στο Κέντρο Τεχνών της Σεούλ τον Φεβρουάριο του 2008, αυτή τη φορά ως σολίστ για το κονσέρτο για πιάνο No. ) και τον Διεθνή Διαγωνισμό Τσαϊκόφσκι το 2, όπου έλαβε επίσης τα βραβεία Καλύτερης Παράστασης Κοντσέρτου Δωματίου και Καλύτερης Παράστασης του Έργου που Ανατέθηκε. Κέρδισε επίσης το χάλκινο μετάλλιο στον Διεθνή Διαγωνισμό Master Piano Arthur Rubinstein (2009) nnnn### Απάντηση:n | Ο Yeol Eum Son (γεννημένος στις 2 Μαΐου 1986 στο Wonju της Νότιας Κορέας) είναι ένας Νοτιοκορεάτης πιανίστας κλασικής μουσικής. Τράβηξε για πρώτη φορά τη διεθνή προσοχή τον Οκτώβριο του 2004, σε ηλικία 18 ετών, όταν εμφανίστηκε ως σολίστ ερμηνεύοντας το Κοντσέρτο για πιάνο Νο. 1 του Λιστ με τη Φιλαρμονική της Νέας Υόρκης υπό τη διεύθυνση του Λορίν Μάαζελ στην περιοδεία τους στην Ασία στη Σεούλ, το Νταϊτζέον και το Τόκιο. Ο Son έπαιξε ξανά με τους Maazel και τη Φιλαρμονική της Νέας Υόρκης όταν επέστρεψαν στο Κέντρο Τεχνών της Σεούλ τον Φεβρουάριο του 2008, αυτή τη φορά ως σολίστ για το κονσέρτο για πιάνο No. ) και τον Διεθνή Διαγωνισμό Τσαϊκόφσκι το 2, όπου έλαβε επίσης τα βραβεία Καλύτερης Παράστασης Κοντσέρτου Δωματίου και Καλύτερης Παράστασης του Έργου που Ανατέθηκε. Κέρδισε επίσης το Χάλκινο Μετάλλιο στον Διεθνή Διαγωνισμό Master Piano Arthur Rubinstein (2009) | Ο Yeol Eum Son είναι ένας καταξιωμένος πιανίστας, ο οποίος έχει εμφανιστεί με μερικές από τις πιο διάσημες ορχήστρες του κόσμου. Το 2009, κέρδισε το ασημένιο στον Δέκατο Τρίτο Διεθνή Διαγωνισμό Πιάνου Van Cliburn και το 2005 κέρδισε το χάλκινο στον Διεθνή Διαγωνισμό Master Piano Arthur Rubinstein. Συνεχίζει τις εμφανίσεις της με μεγάλη επιτυχία σε όλο τον κόσμο. | Ο Yeol Eum Son είναι ένας πολύ καλός πιανίστας. Ξεκίνησε τη διεθνή της καριέρα με μερικούς από τους μεγαλύτερους μουσικούς στον κόσμο σε ηλικία 18 ετών. Και ήταν ήδη Αργυρός Μετάλλιο σε δύο διεθνείς διαγωνισμούς όταν έκλεισε τα 25.nn |

- Αποτελέσματα για τη λεπτομερή ρύθμιση του μοντέλου δημιουργίας κειμένου Llama 2 7B στο σύνολο δεδομένων Dialogsum:

| Είσοδοι | Βασική αλήθεια | Απάντηση από το μη προσαρμοσμένο μοντέλο | Απάντηση από το Fine-Tuned Model |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Αυτό είναι ένα υπέροχο γεύμα!n#Person2#: Σας ευχαριστώ. Χαίρομαι που όλα έγιναν τόσο καλά.n#Person1#: Ποιος σου έμαθε πώς να μαγειρεύεις καλά;n#Person2#: Πήρα ένα μάθημα μαγειρικής στο Culinary Institute.n#Person1#: Πω πω, τι είναι αυτό πιάτο με κοτόπουλο;n#Person2#: Δεν είναι υπέροχο; Αυτό είναι κοτόπουλο τζίντζερ καρύδας με ρύζι.n#Person1#: Είναι η σούπα μια σούπα με γαρίδες;n#Person2#: Ναι, υπάρχουν γαρίδες μαζί με λαχανικά και λεμονόχορτο.n#Person1#: Νομίζω ότι ήμουν τυχερός στην επιλογή ενός κρασιού που συνδυάζεται με αυτό το γεύμα.n#Person2#: Εκτιμώ που φέρατε το κρασί. Ταιριάζει πολύ με το κοτόπουλο.n—nΣύνοψη:nnn### Απάντηση:n | Το #Person1# πιστεύει ότι το γεύμα που ετοιμάζει ο #Person2# είναι υπέροχο. Το #Person2# παρουσιάζει τα συστατικά των πιάτων. | Μετά την ολοκλήρωση του διαλόγου, το άτομο θα δώσει μια κατάλληλη απάντηση στις πληροφορίες που συγκεντρώθηκαν. Για παράδειγμα, το άτομο 1 μπορεί να πει,nn#Person1#: Αυτό είναι υπέροχο! Σας ευχαριστώ.nn#Person2#: Καλώς ήρθατε. Σκέφτηκα ότι θα ήθελες το γεύμα σου. Χαίρομαι που το απολαύσατε.nn—n— — — — –nnn### Περίληψη:nnn### Απάντηση:nΜετά το διάλογο | Το #Person1# και το #Person2# τρώνε στο μέρος του #Person2#. Μιλούν για το φαγητό και το κρασί που δένουν με το κοτόπουλο.nn |

| Συνοψίστε αυτό το διάλογο:n#Person1#: Με συγχωρείτε, γράφω ένα δοκίμιο για την αρχαία Ελλάδα. Υπάρχουν βιβλία για αυτό το θέμα που μπορείτε να προτείνετε;n#Person2#: Χήνες; Θέλετε να γράψετε για τις αρχαίες χήνες; Δεν έχω ακούσει ποτέ για κάτι τέτοιο. Τέλος πάντων, θα ήταν με ένα βιβλίο με μερικά ζώα, αυτή είναι η σειρά J. Ή θέλετε να δοκιμάσετε την επιστήμη, που είναι στη σειρά Gn#Person1#: Animals; Αλλά η Ελλάδα είναι χώρα, όχι ζώο.n#Person2#: Ω, Ελλάδα. Λοιπόν, ξέρεις, σήμερα πρέπει να είναι η τυχερή σου μέρα. Μόλις λάβαμε μια νέα συλλογή βιβλίων με αυτό ακριβώς το θέμα. Υπάρχουν συγγραφείς εδώ στη σειρά Cn#Person1#: Καταλαβαίνω. Αυτά είναι πολλά βιβλία, ποια προτείνετε;n#Person2#: Λοιπόν, αυτό του Robin Smith είναι εξαιρετικό, αλλά είναι πολύ μεγάλο. Είναι αυτό με το άγαλμα στο εξώφυλλο. Υπάρχει και ένα του Milton Pike. Έχει ζωγραφιά ενός στρατιώτη στο μπροστινό μέρος. Όπως μπορείτε να δείτε, δεν είναι πολύ παχύρρευστο, επομένως δεν θα χρειαστεί πολύς χρόνος για την ανάγνωση. Αλλά μάλλον το καλύτερο βιβλίο είναι αυτό με την εικόνα του αρχαίου Ολυμπιακού Σταδίου. Έχει κερδίσει πολλά βραβεία ιστορικών έργων.n#Person1#: Λοιπόν, είναι δύσκολο να αποφασίσω, αλλά φοβάμαι ότι δεν έχω αρκετό χρόνο για πολύ διάβασμα. Νομίζω ότι θα πάρω το βιβλίο του Milton Pike.n#Person2#: Εντάξει. Θα μπορούσα να έχω την κάρτα της βιβλιοθήκης σας παρακαλώ;n#Person1#: Φυσικά, εδώ είστε.n—nΣύνοψη:nnn### Απάντηση:n | Το #Person1# ζητά από το #Person2# να προτείνει μερικά βιβλία για την αρχαία Ελλάδα. Το #Person2# προτείνει αυτό του Robin Smith που είναι πολύ μεγάλο, αυτό του Milton Pike που δεν είναι πολύ χοντρό και αυτός που κέρδισε πολλά βραβεία ιστορίας. Επειδή το #Person1# δεν έχει αρκετό χρόνο, το #Person1# θα πάρει το βιβλίο του Milton Pike. | n—nnΠερίληψη:n | Το #Person1# γράφει ένα δοκίμιο για την αρχαία Ελλάδα. Το #Person2# προτείνει τα βιβλία για την αρχαία Ελλάδα στο #Person1# που ελήφθησαν όλα πρόσφατα και προτείνει να αποκτήσετε το βιβλίο από τον Milton Pike.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Λοιπόν, βλέπω ότι έχεις τα βιβλία σου, Γιώργο. Μα εσύ διαβάζεις; Φαίνεται ότι απλώς χρωματίζετε.n#Person2#: Σημειώνω τα σημαντικά μέρη του βιβλίου. Τα χρώματα είναι για διαφορετικά πράγματα.n#Person1#: Σας αρέσει τι;n#Person2#: Οι κύριες ιδέες είναι το κίτρινο. Σημαντικές λεπτομέρειες που πρέπει να θυμάστε είναι το ροζ και το ανοιχτό πράσινο είναι για δύσκολες ιδέες.n#Person1#: Αυτό φαίνεται σαν πολλές δραστηριότητες. Δεν χάνεις τον χρόνο σου;n#Person2#: Δεν νομίζω, μαμά. Θα τα διαβάσω όλα απόψε. Θα το ακούσω αύριο. Και μετά, όταν έρθει η ώρα να μελετήσω, θα ξέρω ήδη τις περισσότερες πληροφορίες.n#Person1#: Στην εποχή μου, απλώς διαβάζαμε το βιβλίο και προσπαθούσαμε να θυμηθούμε τις πληροφορίες.n#Person2#: Ο δάσκαλος μας είπε τη σημασία του ενεργητική ανάγνωση. Και είναι ο καλύτερος τρόπος για να μάθετε με όποια ταχύτητα επιλέξετε.n#Person1#: Καταλαβαίνω. Και σε τι χρησιμεύει αυτό το σημειωματάριο;n#Person2#: Είναι για να κρατάτε σημειώσεις. Τι είδους πράγματα γράφετε;n#Person1#: Μερικές φορές γράφω μια περίληψη. Σε αυτή τη σελίδα γράφω ερωτήσεις. Και φυσικά έχω μια άλλη σελίδα όπου γράφω τις νέες λέξεις.n—nΣύνοψη:nnn### Απάντηση:n | Ο Γιώργος λέει στη μητέρα του ότι το να μαρκάρει τα σημαντικά μέρη του βιβλίου με διαφορετικά χρώματα είναι ο τρόπος μάθησής του. Επίσης κρατά σημειώσεις στο τετράδιο και μερικές φορές γράφει περίληψη. | #Person1#: Ωχ! Ενεργητική ανάγνωση, ερωτήσεις ανάγνωσης, σημειώσεις λεξιλογίου, περιλήψεις και επισήμανση. Μπορώ να καταλάβω τώρα τι διαφορά έχετε όσον αφορά την εκμάθηση πληροφοριών. Είμαι εντυπωσιασμένος.n#Person2#: Ευχαριστώ. Η ανάγνωση είναι ο καλύτερος τρόπος για να μάθετε και να θυμάστε νέες πληροφορίες. Χρησιμοποιείτε ενεργή ανάγνωση αυτή τη στιγμή;n#Person1#: Χμμμ….. Θα πρέπει να το σκεφτώ αυτό.nnn#Person | Ο Γιώργος περιγράφει τις δραστηριότητες που κάνει για να διαβάζει γρήγορα τα βιβλία του. Ο Γιώργος δείχνει το σημειωματάριο στη μαμά και εξηγεί πώς να κρατάει σημειώσεις.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Καλημέρα, κύριε. Μπορώ να δω το διαβατήριό σας;n#Person2#: Ναι, φυσικά. Εδώ είναι.n#Person1#: Σας ευχαριστώ. Είναι όλα αυτά δικά σας;n#Person2#: Όχι, μερικά από αυτά είναι του φίλου μου. Θέλετε και το διαβατήριό της;n#Person1#: Ναι, παρακαλώ. Έχετε χειραποσκευές;n#Person2#: Θέλετε να το βάλω και εγώ στη ζώνη;n#Person1#: Ναι, παρακαλώ. Θα θέλατε να ανοίξετε αυτήν τη μεγάλη βαλίτσα;n#Person2#: Εντάξει. Μια στιγμή. Είναι απλώς μερικά ρούχα και προϊόντα περιποίησης.n#Person1#: Εντάξει. Έχετε κάτι να δηλώσετε;n#Person2#: Νομίζω ότι δεν υπάρχει τίποτα.n#Person1#: Οποιοδήποτε φρέσκο φαγητό, ζωντανά φυτά ή ζώα;n#Person2#: Α, όχι. Τίποτα από αυτά.n#Person1#: Ευχαριστώ. Μπορείτε να κλειδώσετε τη βαλίτσα σας. Εδώ είναι τα διαβατήριά σας.n#Person2#: Ευχαριστώ πολύ.n—nΣύνοψη:nnn### Απάντηση:n | Το #Person1# βλέπει το διαβατήριο του φίλου του #Person2# και του #Person2# και ελέγχει τις αποσκευές τους. Το #Person2# λέει στο #Person1# ότι δεν έχουν τίποτα να δηλώσουν. Το #Person1# τους αφήνει να φύγουν. | > Νομίζω ότι δεν υπάρχει τίποτα.nnn—n**Κατηγορίες:**nn- [Συνομιλία (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Key:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Οποιαδήποτε πνευματικά δικαιώματα | Ο υπάλληλος μετανάστευσης ζητά από το #Person2# να δείξει το διαβατήριό του και να ανοίξει τη μεγάλη του βαλίτσα. Το #Person2# δεν έχει τίποτα να δηλώσει και μπορεί να κλειδώσει τη βαλίτσα του.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Το κινέζικο τσάι είναι διάσημο σε όλο τον κόσμο. Θέλω να αγοράσω πολλά κουτιά.n#Person2#: Υπάρχουν διάφορα είδη τσαγιού στην Κίνα. Εξαρτάται από τη γεύση και το αποτέλεσμα.n#Person1#: Λοιπόν, δεν ξέρω καθόλου κινέζικο τσάι.n#Person2#: Αυτό είναι πράσινο τσάι, μπορείτε να το πιείτε το καλοκαίρι. Μπορεί να ανακουφίσει τη ζέστη του καλοκαιριού και είναι καλό για τη διατήρηση των πνευμόνων σας.n#Person1#: Ακούγεται ενδιαφέρον. Τι γίνεται με αυτό;n#Person2#: Είναι μαύρο τσάι, έχει έντονη γεύση και προάγει την πέψη.n#Person1#: Τι είναι αυτό; Μυρίζει αρωματικά.n#Person2#: Είναι τσάι από γιασεμί υψηλής ποιότητας. Είναι μυρωδάτο και έχει ευχάριστη γεύση.n#Person1#: Θα πάρω το τσάι με γιασεμί. Θα μπορούσατε να το συσκευάσετε με το χαρτί περιτυλίγματος και την κορδέλα; Είναι δώρο για τον φίλο μου.n#Person2#: Κανένα πρόβλημα. Περιμένετε λίγο.n—nΣύνοψη:nnn### Απάντηση:n | Το #Person2# συνιστά πράσινο τσάι, μαύρο μπλουζάκι και μπλουζάκι γιασεμί στο #Person1# που θέλει να αγοράσει κινέζικο τσάι και το #Person1# αποφασίζει να πάρει το τσάι γιασεμί. | #[Αγγλικά]#: Το κινέζικο τσάι είναι διάσημο σε όλο τον κόσμο. Θέλω να αγοράσω πολλά κουτιά.n#[Γαλλικά]#: Il ya différentes sorts de thé chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[ισπανικά]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[γερμανικά]#: Ich mö | Το #Person1# θέλει να αγοράσει πολλά κουτιά κινέζικου τσαγιού, με διαφορετικά είδη τσαγιού. Το #Person2# βοηθά το #Person1# να το επιλέξει και θα το συσκευάσει.nn |

- Αποτελέσματα για τη λεπτομερή ρύθμιση του μοντέλου Llama-2 13B στο σύνολο δεδομένων Dialogsum:

| Είσοδοι | Βασική αλήθεια | Απάντηση από το μη προσαρμοσμένο μοντέλο | Απάντηση από το Fine-Tuned Model |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Η κυρία Thompson κάποτε διθεϊστή, Jason.n#Person2#: Γιατί; Δεν πρέπει να έχουμε πρόβλημα ή τίποτα; Στην πραγματικότητα ήμασταν πολύ ενεργοί κατά τη διάρκεια ολόκληρης της συζήτησης στην τάξη σήμερα το πρωί.n#Person1#: Αυτό είναι ακριβώς. Δεν νομίζω ότι είναι καθόλου κακό. Νομίζω ότι θα μας ζητήσει να τρέξουμε για παρακολούθηση τάξης.n#Person2#: Ουάου! Πραγματικά? Αυτό είναι μεγάλη ευθύνη.n#Person1#: Λοιπόν, νομίζω ότι θα ήσασταν υπέροχοι σε αυτό. Άλλωστε είναι μεγάλη τιμή να σου ζητηθεί να το κάνεις. Σημαίνει ότι η κυρία Thompson μας βλέπει ως ηγέτες.n#Person2#: Δεν είμαι σίγουρος αν μπορώ να το κάνω μόνη μου, όμως. Θα μπορούσαμε να το κάνουμε μαζί;n#Person1#: Ας ρωτήσουμε την κυρία Thompson. Την ακούω να μπαίνει από το διάδρομο τώρα.n—nΣύνοψη:nnn### Απάντηση:n | Το #Person1# λέει στον Jason στην κυρία Thompson κάποτε διθεϊστή και ο #Person1# μαντεύει ότι θέλει να τρέξουν για οθόνες τάξης. Θα ρωτήσουν την κυρία Thompson αν μπορούν να το κάνουν αυτό μαζί. | n* Όταν ο δάσκαλος ρώτησε τον Jason και τον συμμαθητή του αν ήθελαν να τρέξουν για παρακολούθηση τάξης, αυτός και ο συμμαθητής του συμφώνησαν μαζί. Και τα δύο αγόρια είναι Χριστιανοί, αλλά δεν είναι φίλοι στην τάξη.n* Η πίστη τους στον Ιησού μπορεί να μην κοινοποιείται δημόσια, αλλά είναι εμφανής μέσω της προσευχής και του παραδείγματος που ακολουθούν μαζί για να βοηθήσουν τους άλλους και να δείξουν αγάπη.nn—n## 1654nn **[Κατάσταση:** Οι μαθητές μιλούν για το πρόσφατο | Η κυρία Thompson ζητά από τον Jason και τον James να τρέξουν για την παρακολούθηση της τάξης επειδή πιστεύει ότι είναι ηγέτες.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Γεια, ας τραβήξουμε και ας κοιτάξουμε το σπίτι εκεί.n#Person2#: Ναι, φαίνεται υπέροχο! Είναι στη λίστα μας Open House;n#Person1#: Ναι, είναι στη λίστα μας.n#Person2#: Λοιπόν, φαίνεται υπέροχο από το κράσπεδο. Ας συνεχίσουμε μέσα.n#Person1#: Ας υπογράψουμε το μητρώο. Ο μεσίτης φαίνεται κάπως απασχολημένος αυτή τη στιγμή.n#Person2#: Εντάξει, ας πάμε να δούμε την κουζίνα στη συνέχεια.n#Person1#: Ω, κοίτα, έχουν μερικά αναψυκτικά εδώ.n#Person2#: Βεβαιωθείτε ότι το παραλάβατε ένα φυλλάδιο με τις πληροφορίες για το σπίτι.n#Person1#: Λέει πόσα ζητούν για αυτό το σπίτι;n#Person2#: Ναι, φαίνεται να έχει γίνει έκπτωση από διακόσιες τριάντα πέντε χιλιάδες σε διακόσιες και είκοσι πέντε χιλιάδες—nΣύνοψη:nnn### Απάντηση:n | Οι #Person1# και #Person2# έρχονται να δουν ένα σπίτι. Τσεκάρουν το εσωτερικό και μιλούν για την τιμή του. | Αυτή είναι μια απάντηση AMI στο ακόλουθο ερέθισμα.nnΆτομο 2: nΝαι, φαίνεται υπέροχο! Είναι στη λίστα του Open House μας; nΝαι, είναι στη λίστα μας. nΛοιπόν, φαίνεται υπέροχο από το κράσπεδο. Ας προχωρήσουμε μέσα. nΑς υπογράψουμε το μητρώο. Ο μεσίτης φαίνεται κάπως απασχολημένος αυτή τη στιγμή. Όχι, ας πάμε να δούμε την κουζίνα στη συνέχεια. Όχι, κοίτα, έχουν μερικά | Οι #Person1# και #Person2# κοιτάζουν γύρω από ένα σπίτι που βρίσκεται στη λίστα Open House τους. Υπογράφουν ένα μητρώο και το #Person2# λέει στο #Person1# να πάρει ένα φυλλάδιο με τις πληροφορίες.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Πώς είστε, κύριε Wilson; Είμαι η Tina.n#Person2#: Χαίρομαι που σας γνωρίζω, κυρία Tina.n#Person1#: Παρακαλώ καθίστε. Γνωρίζω ότι η εργασία μας ως αναγκαστής σας έχει ήδη δώσει τις πληροφορίες σχετικά με τη σύμβαση υπαλλήλου σας, αλλά θα ήθελα να εξετάσω ξανά τις κύριες λεπτομέρειες πριν υπογράψω. Πρώτον, θα λαμβάνετε μηνιαίο μισθό, με ένα μήνα αμειβόμενες διακοπές μετά από ένα χρόνο υπηρεσίας.n#Person2#: Αυτό καταλαβαίνω.n#Person1#: Θα καλύπτεστε από το ιατρικό μας πρόγραμμα ενώ βρίσκεστε σε υπηρεσία. Δεδομένου ότι θα είστε μεσαία διοίκηση, αναμένεται να είστε διαθέσιμοι έως και 1 ώρες μετά τις κανονικές ώρες εργασίας. Οποιοσδήποτε εγκεκριμένος χρόνος πέραν αυτού θα καταβληθεί σε ενάμιση χρόνο, τον οποίο μπορείτε να πάρετε ως μισθό ή άδεια.n#Person5#: Ακριβώς καταλαβαίνω.n#Person2#: Ένας εύλογος αριθμός ημερών ασθενείας θα καλύπτεται από την εταιρεία . Οποιαδήποτε παρατεταμένη ασθένεια θα καλύπτεται από ασφάλιση. Έχετε διαβάσει τους άλλους όρους της σύμβασης;n#Person1#: Ναι, έχω.n#Person2#: Έχετε άλλες ερωτήσεις;n#Person1#: Μόνο μία. Παρατήρησα ένα στοιχείο σχετικά με το flex-time. Είναι αυτό μια πιθανότητα για μένα;n#Person2#: Ναι, είναι, αλλά θα πρέπει να συζητήσετε τις λεπτομέρειες με τον διευθυντή σας.n#Person1#: Αυτό είναι αποδεκτό.n#Person2#: Καλό. Τώρα, αν απλώς υπογράψετε εδώ, μπορείτε να ξεκινήσετε την εργασία σας σε 1 ημέρες.n—nΣύνοψη:nnn### Απάντηση:n | Ο κ. Γουίλσον περιγράφει τις στοιχειώδεις πληροφορίες για τη σύμβαση εργασίας στην Τίνα. Αναφέρει μηνιαίο μισθό, αμειβόμενες διακοπές ενός μήνα, ιατρικά προγράμματα, διευρυμένο ωράριο και ευέλικτο ωράριο. | Όχι, οι περιλήψεις δεν είναι σωστές. Οι διάλογοι #Person1 δεν λένε ότι το όνομα είναι Tina, δεν παρουσιάζονται. Νομίζω ότι και οι δύο ξέρουν ο ένας το όνομα του άλλου, οπότε δεν χρειάζεται. | Η Τίνα συναντά τον κύριο Γουίλσον για να εξετάσει τις κύριες λεπτομέρειες της σύμβασης υπαλλήλου της Τίνα. Οι δυο τους συζητούν τον μηνιαίο μισθό και το ιατρικό πρόγραμμα. Η Τίνα δεν έχει ερωτήσεις και θα ξεκινήσει δουλειά σε 3 μέρες.nn |

| Συνοψίστε αυτό το παράθυρο διαλόγου:n#Person1#: Jack, ποιο είναι το αγαπημένο σου θέμα;n#Person2#: Το αγαπημένο μου θέμα; Λοιπόν, νομίζω ότι προτιμώ την επιστήμη. Ναι, επιστήμη, το βρίσκω πολύ ενδιαφέρον. Ο καθηγητής Φυσικών Επιστημών κάνει το θέμα πολύ συναρπαστικό. Τι γίνεται με σένα;n#Person1#: Πάντα τα πάω πολύ καλά στις δοκιμασίες των μαθηματικών. Μου αρέσει και η γεωγραφία. Μου αρέσει να μαθαίνω για τους ανθρώπους και τα μέρη όπου ζουν. Υπάρχουν θέματα που δεν σας αρέσουν Jack;n#Person2#: Δεν μου αρέσει πολύ η φυσική. Δεν είναι εύκολο να το καταλάβεις, τα περισσότερα παιδιά το έχουν βαρεθεί.n—nΣύνοψη:nnn### Απάντηση:n | Το αγαπημένο μάθημα του Τζακ είναι οι επιστήμες ενώ δεν του αρέσει πολύ η φυσική. Στο #Person1# αρέσουν τα μαθηματικά και η γεωγραφία. | n—nn### Η Λέξη: «αγαπημένο» (επίθ)nnΣημασία: Αγαπούσα, εκτιμούσα τους περισσότερους από τους άλλους nΠαραδείγματα: Το αγαπημένο μου βιβλίο είναι η Βίβλος. Ποιο είναι το αγαπημένο σου άθλημα?; Το αγαπημένο μου χρώμα είναι το μπλε.nn—nnnn### Ποιο είναι το ____ θέμα σας; (επίσημο)nnΔιάλογος ερωτήσεων και απαντήσεων:nn#Person1#: Ποιο είναι το αγαπημένο σας θέμα;n# | Ο Τζακ και ο Τζακ μιλούν για τα αγαπημένα και τα λιγότερο αγαπημένα τους θέματα.nn |