Καθώς τα μοντέλα μηχανικής μάθησης (ML) έχουν βελτιωθεί, οι επιστήμονες δεδομένων, οι μηχανικοί ML και οι ερευνητές έχουν στρέψει περισσότερο την προσοχή τους στον καθορισμό και τη βελτίωση της ποιότητας των δεδομένων. Αυτό οδήγησε στην εμφάνιση μιας προσέγγισης με επίκεντρο τα δεδομένα στο ML και σε διάφορες τεχνικές για τη βελτίωση της απόδοσης του μοντέλου εστιάζοντας στις απαιτήσεις δεδομένων. Η εφαρμογή αυτών των τεχνικών επιτρέπει στους επαγγελματίες ML να μειώσουν τον όγκο των δεδομένων που απαιτούνται για την εκπαίδευση ενός μοντέλου ML.

Ως μέρος αυτής της προσέγγισης, προηγμένες τεχνικές επιλογής υποσυνόλων δεδομένων έχουν εμφανιστεί για να επιταχύνουν την εκπαίδευση μειώνοντας την ποσότητα δεδομένων εισόδου. Αυτή η διαδικασία βασίζεται στην αυτόματη επιλογή ενός δεδομένου αριθμού σημείων που προσεγγίζουν την κατανομή ενός μεγαλύτερου δεδομένων και στη χρήση του για εκπαίδευση. Η εφαρμογή αυτού του τύπου τεχνικής μειώνει τον χρόνο που απαιτείται για την εκπαίδευση ενός μοντέλου ML.

Σε αυτήν την ανάρτηση, περιγράφουμε την εφαρμογή αρχών τεχνητής νοημοσύνης με επίκεντρο τα δεδομένα Amazon SageMaker Ground Αλήθεια, πώς να εφαρμόσετε τεχνικές επιλογής υποσυνόλου δεδομένων χρησιμοποιώντας το ΚΟΡΔΟΝΙΑ αποθετήριο σε Amazon Sage Maker για τη μείωση του όγκου των δεδομένων που απαιτούνται για την εκπαίδευση ενός αρχικού μοντέλου και τον τρόπο εκτέλεσης πειραμάτων χρησιμοποιώντας αυτήν την προσέγγιση Πειράματα Amazon SageMaker.

Μια προσέγγιση με επίκεντρο τα δεδομένα στη μηχανική μάθηση

Πριν προχωρήσετε σε πιο προηγμένες τεχνικές με επίκεντρο τα δεδομένα, όπως η επιλογή υποσυνόλου δεδομένων, μπορείτε να βελτιώσετε τα σύνολα δεδομένων σας με πολλούς τρόπους, εφαρμόζοντας ένα σύνολο βασικών αρχών στη διαδικασία επισήμανσης δεδομένων. Για αυτό, το Ground Truth υποστηρίζει διάφορους μηχανισμούς για τη βελτίωση της συνοχής της ετικέτας και της ποιότητας των δεδομένων.

Η συνέπεια της ετικέτας είναι σημαντική για τη βελτίωση της απόδοσης του μοντέλου. Χωρίς αυτό, τα μοντέλα δεν μπορούν να δημιουργήσουν ένα όριο απόφασης που να χωρίζει κάθε σημείο που ανήκει σε διαφορετικές κλάσεις. Ένας τρόπος για να διασφαλιστεί η συνέπεια είναι η χρήση ενοποίηση σχολιασμού στο Ground Truth, το οποίο σας επιτρέπει να προβάλετε ένα δεδομένο παράδειγμα σε πολλούς ετικετοποιητές και να χρησιμοποιήσετε τη συγκεντρωτική ετικέτα που παρέχεται ως βασική αλήθεια για αυτό το παράδειγμα. Η απόκλιση στην ετικέτα μετριέται με τη βαθμολογία εμπιστοσύνης που δημιουργείται από το Ground Truth. Όταν υπάρχει απόκλιση στις ετικέτες, θα πρέπει να κοιτάξετε για να δείτε εάν υπάρχει ασάφεια στις οδηγίες επισήμανσης που παρέχονται στους ετικετογράφους σας και μπορούν να αφαιρεθούν. Αυτή η προσέγγιση μετριάζει τις επιπτώσεις της μεροληψίας μεμονωμένων ετικετών, κάτι που είναι κεντρικό για να γίνουν οι ετικέτες πιο συνεπείς.

Ένας άλλος τρόπος για τη βελτίωση της απόδοσης του μοντέλου εστιάζοντας στα δεδομένα περιλαμβάνει την ανάπτυξη μεθόδων για την ανάλυση σφαλμάτων στις ετικέτες καθώς καταλήγουν στον εντοπισμό του πιο σημαντικού υποσυνόλου δεδομένων προς βελτίωση. μπορείτε να το κάνετε αυτό για το σύνολο δεδομένων εκπαίδευσής σας με έναν συνδυασμό χειροκίνητων προσπαθειών που περιλαμβάνουν κατάδυση σε παραδείγματα με ετικέτα και χρησιμοποιώντας το amazoncloudwatch αρχεία καταγραφής και μετρήσεις που δημιουργούνται από εργασίες επισήμανσης Ground Truth. Είναι επίσης σημαντικό να εξετάζουμε τα λάθη που κάνει το μοντέλο κατά το χρόνο συμπερασμάτων για να οδηγήσουμε στην επόμενη επανάληψη της επισήμανσης για το σύνολο δεδομένων μας. Εκτός από αυτούς τους μηχανισμούς, Amazon SageMaker Clerify επιτρέπει σε επιστήμονες δεδομένων και μηχανικούς ML να εκτελούν αλγόριθμους όπως KernelSHAP να τους επιτρέψει να ερμηνεύσουν τις προβλέψεις του μοντέλου τους. Όπως αναφέρθηκε, μια βαθύτερη εξήγηση στις προβλέψεις του μοντέλου μπορεί να συσχετιστεί με την αρχική διαδικασία επισήμανσης για τη βελτίωσή της.

Τέλος, μπορείτε να σκεφτείτε να πετάξετε θορυβώδη ή υπερβολικά περιττά παραδείγματα. Κάνοντας αυτό, μπορείτε να μειώσετε τον χρόνο εκπαίδευσης αφαιρώντας παραδείγματα που δεν συμβάλλουν στη βελτίωση της απόδοσης του μοντέλου. Ωστόσο, η μη αυτόματη αναγνώριση ενός χρήσιμου υποσυνόλου ενός δεδομένου συνόλου δεδομένων είναι δύσκολη και χρονοβόρα. Η εφαρμογή των τεχνικών επιλογής υποσυνόλου δεδομένων που περιγράφονται σε αυτήν την ανάρτηση σάς επιτρέπει να αυτοματοποιήσετε αυτήν τη διαδικασία σε καθιερωμένα πλαίσια.

Περίπτωση χρήσης

Όπως αναφέρθηκε, η τεχνητή νοημοσύνη με επίκεντρο τα δεδομένα εστιάζει στη βελτίωση της εισαγωγής του μοντέλου και όχι στην αρχιτεκτονική του ίδιου του μοντέλου. Αφού εφαρμόσετε αυτές τις αρχές κατά την επισήμανση δεδομένων ή τη μηχανική χαρακτηριστικών, μπορείτε να συνεχίσετε να εστιάζετε στην εισαγωγή του μοντέλου εφαρμόζοντας την επιλογή υποσυνόλου δεδομένων κατά την εκπαίδευση.

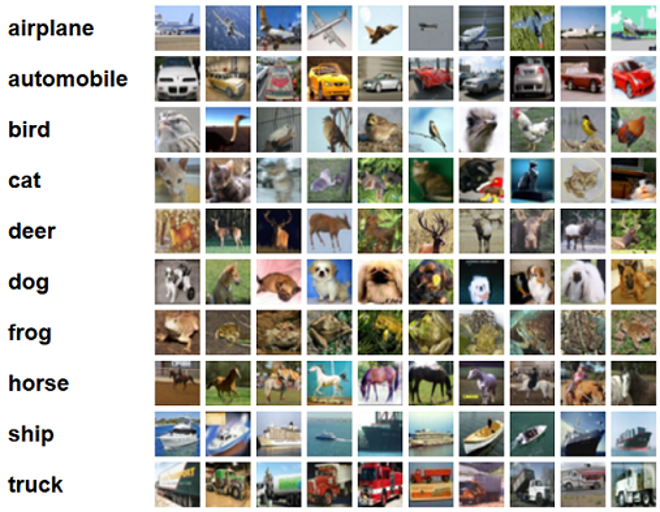

Για αυτήν την ανάρτηση, εφαρμόζουμε Επιλογή υποσυνόλου δεδομένων βάσει γενίκευσης για αποτελεσματική και ισχυρή μάθηση (GLISTER), η οποία είναι μία από τις πολλές τεχνικές επιλογής υποσυνόλων δεδομένων που εφαρμόζονται στο αποθετήριο CORDS, στον αλγόριθμο εκπαίδευσης ενός ResNet-18 μοντέλο για να ελαχιστοποιηθεί ο χρόνος που χρειάζεται για την εκπαίδευση ενός μοντέλου για ταξινόμηση CIFAR-10 εικόνες. Ακολουθούν μερικά δείγματα εικόνων με τις αντίστοιχες ετικέτες τους από το σύνολο δεδομένων CIFAR-10.

Το ResNet-18 χρησιμοποιείται συχνά για εργασίες ταξινόμησης. Είναι ένα βαθύ συνελικτικό νευρωνικό δίκτυο 18 επιπέδων. Το σύνολο δεδομένων CIFAR-10 χρησιμοποιείται συχνά για την αξιολόγηση της εγκυρότητας διαφόρων τεχνικών και προσεγγίσεων στο ML. Αποτελείται από 60,000 έγχρωμες εικόνες 32×32 με ετικέτα σε 10 κατηγορίες.

Στις ακόλουθες ενότητες, δείχνουμε πώς το GLISTER μπορεί να σας βοηθήσει να απαντήσετε σε κάποιο βαθμό στην ακόλουθη ερώτηση:

Τι ποσοστό ενός δεδομένου συνόλου δεδομένων μπορούμε να χρησιμοποιήσουμε και να επιτύχουμε καλή απόδοση μοντέλου κατά τη διάρκεια της εκπαίδευσης;

Η εφαρμογή του GLISTER στον προπονητικό σας αλγόριθμο θα εισαγάγει το κλάσμα ως υπερπαράμετρο στον αλγόριθμο προπόνησής σας. Αυτό αντιπροσωπεύει το ποσοστό του δεδομένου δεδομένων που θέλετε να χρησιμοποιήσετε. Όπως με κάθε υπερπαράμετρο, η εύρεση της τιμής που παράγει το καλύτερο αποτέλεσμα για το μοντέλο και τα δεδομένα σας απαιτεί συντονισμό. Δεν μπαίνουμε σε βάθος σε συντονισμό υπερπαραμέτρων σε αυτήν την ανάρτηση. Για περισσότερες πληροφορίες, ανατρέξτε στο Βελτιστοποιήστε τις υπερπαραμέτρους με το Amazon SageMaker Automatic Model Tuning.

Εκτελούμε πολλές δοκιμές χρησιμοποιώντας τα πειράματα SageMaker για να μετρήσουμε τον αντίκτυπο της προσέγγισης. Τα αποτελέσματα θα διαφέρουν ανάλογα με το αρχικό σύνολο δεδομένων, επομένως είναι σημαντικό να δοκιμάσουμε την προσέγγιση σε σχέση με τα δεδομένα μας σε διαφορετικά μεγέθη υποσυνόλου.

Αν και συζητάμε τη χρήση του GLISTER σε εικόνες, μπορείτε επίσης να το εφαρμόσετε σε αλγόριθμους εκπαίδευσης που εργάζονται με δομημένα ή πινακοποιημένα δεδομένα.

Επιλογή υποσυνόλου δεδομένων

Ο σκοπός της επιλογής υποσυνόλου δεδομένων είναι να επιταχύνει τη διαδικασία εκπαίδευσης, ελαχιστοποιώντας παράλληλα τις επιπτώσεις στην ακρίβεια και αυξάνοντας την ευρωστία του μοντέλου. Πιο συγκεκριμένα, το GLISTER-ONLINE επιλέγει ένα υποσύνολο καθώς μαθαίνει το μοντέλο, επιχειρώντας να μεγιστοποιήσει την πιθανότητα καταγραφής αυτού του υποσυνόλου δεδομένων εκπαίδευσης στο σύνολο επικύρωσης που καθορίζετε. Η βελτιστοποίηση της επιλογής υποσυνόλου δεδομένων με αυτόν τον τρόπο μετριάζει τον θόρυβο και την ανισορροπία κλάσης που συναντάται συχνά σε σύνολα δεδομένων του πραγματικού κόσμου και επιτρέπει στη στρατηγική επιλογής υποσυνόλου να προσαρμόζεται καθώς μαθαίνει το μοντέλο.

Η αρχική Χαρτί GLISTER περιγράφει μια αντιστάθμιση επιτάχυνσης/ακρίβειας σε διάφορα μεγέθη υποσυνόλου δεδομένων όπως ακολουθείται χρησιμοποιώντας α LeNet μοντέλο:

| Μέγεθος υποσυνόλου | επιτάχυνση | Ακρίβεια |

| 10% | 6x | -3% |

| 30% | 2.5x | -1.20% |

| 50% | 1.5x | -0.20% |

Για να εκπαιδεύσουμε το μοντέλο, τρέχουμε ένα Εργασία εκπαίδευσης SageMaker χρησιμοποιώντας ένα προσαρμοσμένο σενάριο εκπαίδευσης. Έχουμε ήδη ανεβάσει το σύνολο δεδομένων εικόνων μας στο Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3). Όπως με κάθε εργασία εκπαίδευσης του SageMaker, πρέπει να ορίσουμε ένα Estimator αντικείμενο. Ο εκτιμητής PyTorch από το sagemaker.pytorch Το πακέτο μας επιτρέπει να τρέξουμε το δικό μας σενάριο εκπαίδευσης σε ένα διαχειριζόμενο κοντέινερ PyTorch. ο inputs μεταβλητή μεταβιβάστηκε στον εκτιμητή .fit Η συνάρτηση περιέχει ένα λεξικό της θέσης S3 του συνόλου δεδομένων εκπαίδευσης και επικύρωσης.

Η train.py Το σενάριο εκτελείται όταν εκκινείται μια εργασία εκπαίδευσης. Σε αυτό το σενάριο, εισάγουμε το μοντέλο ResNet-18 από τη βιβλιοθήκη CORDS και του μεταβιβάζουμε τον αριθμό των κλάσεων στο σύνολο δεδομένων μας ως εξής:

Στη συνέχεια, χρησιμοποιούμε το gen_dataset λειτουργία από το CORDS για τη δημιουργία συνόλων δεδομένων εκπαίδευσης, επικύρωσης και δοκιμής:

Από κάθε σύνολο δεδομένων, δημιουργούμε ένα αντίστοιχο πρόγραμμα φόρτωσης δεδομένων PyTorch:

Τέλος, χρησιμοποιούμε αυτά τα προγράμματα φόρτωσης δεδομένων για να δημιουργήσουμε ένα GLISTERDataLoader από τη βιβλιοθήκη CORDS. Χρησιμοποιεί μια υλοποίηση της στρατηγικής επιλογής GLISTER-ONLINE, η οποία εφαρμόζει την επιλογή υποσυνόλων καθώς ενημερώνουμε το μοντέλο κατά τη διάρκεια της εκπαίδευσης, όπως συζητήθηκε νωρίτερα σε αυτήν την ανάρτηση.

Για να δημιουργήσουμε το αντικείμενο, περνάμε τα συγκεκριμένα ορίσματα στρατηγικής επιλογής ως α DotMap αντικείμενο μαζί με το train_loader, validation_loader, να logger:

Η GLISTERDataLoader μπορεί τώρα να εφαρμοστεί ως κανονικός φορτωτής δεδομένων σε βρόχο εκπαίδευσης. Θα επιλέξει υποσύνολα δεδομένων για την επόμενη παρτίδα εκπαίδευσης καθώς το μοντέλο μαθαίνει με βάση την απώλεια αυτού του μοντέλου. Όπως αποδεικνύεται στον προηγούμενο πίνακα, η προσθήκη μιας στρατηγικής επιλογής υποσυνόλου δεδομένων μάς επιτρέπει να μειώσουμε σημαντικά τον χρόνο εκπαίδευσης, ακόμη και με το πρόσθετο βήμα της επιλογής υποσυνόλου δεδομένων, με μικρή αντιστάθμιση στην ακρίβεια.

Οι επιστήμονες δεδομένων και οι μηχανικοί ML χρειάζεται συχνά να αξιολογήσουν την εγκυρότητα μιας προσέγγισης συγκρίνοντάς την με κάποια βασική γραμμή. Δείχνουμε πώς να το κάνετε αυτό στην επόμενη ενότητα.

Πειραματική παρακολούθηση

Μπορείτε να χρησιμοποιήσετε το SageMaker Experiments για να μετρήσετε την εγκυρότητα της προσέγγισης επιλογής υποσυνόλου δεδομένων. Για περισσότερες πληροφορίες, βλ Πειράματα Amazon SageMaker επόμενης γενιάς – Οργανώστε, παρακολουθήστε και συγκρίνετε τις εκπαιδεύσεις μηχανικής εκμάθησης σε κλίμακα.

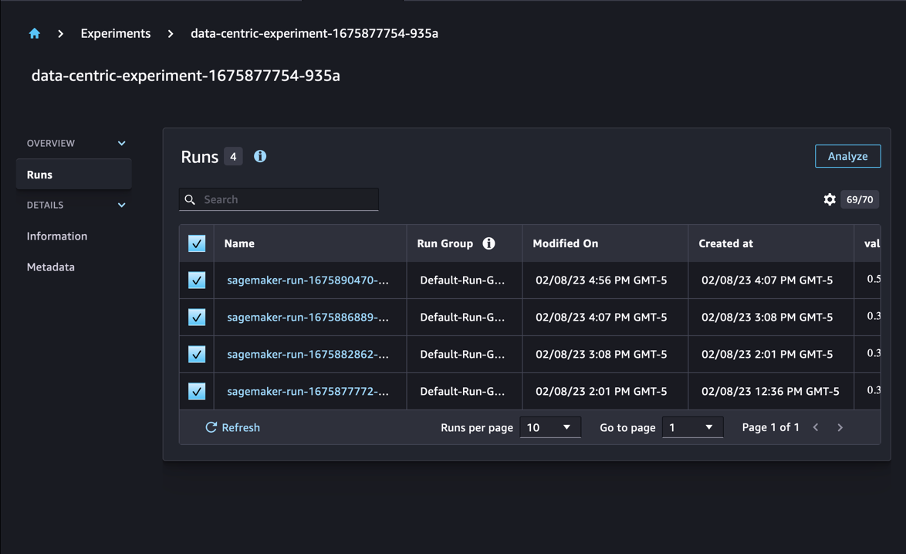

Στην περίπτωσή μας, εκτελούμε τέσσερα πειράματα: μια γραμμή βάσης χωρίς εφαρμογή επιλογής υποσυνόλου δεδομένων και άλλα τρία με διαφορετικά fraction παραμέτρους, οι οποίες αντιπροσωπεύουν το μέγεθος του υποσυνόλου σε σχέση με το συνολικό σύνολο δεδομένων. Φυσικά, χρησιμοποιώντας ένα μικρότερο fraction Η παράμετρος θα πρέπει να έχει ως αποτέλεσμα μειωμένους χρόνους εκπαίδευσης, αλλά και χαμηλότερη ακρίβεια μοντέλου.

Για αυτήν τη θέση, κάθε διαδρομή εκπαίδευσης αντιπροσωπεύεται ως α Run στο SageMaker Experiments. Οι εκτελέσεις που σχετίζονται με το πείραμά μας ομαδοποιούνται όλες σε μία Experiment αντικείμενο. Οι εκτελέσεις μπορούν να προσαρτηθούν σε ένα κοινό πείραμα κατά τη δημιουργία του Estimator με το SDK. Δείτε τον παρακάτω κώδικα:

Ως μέρος του προσαρμοσμένου σεναρίου εκπαίδευσης, μπορείτε να συλλέξετε μετρήσεις εκτέλεσης χρησιμοποιώντας load_run:

Στη συνέχεια, χρησιμοποιώντας το αντικείμενο εκτέλεσης που επιστράφηκε από την προηγούμενη λειτουργία, μπορείτε να συλλέξετε σημεία δεδομένων ανά εποχή με κλήση run.log_metric(name, value, step) και παρέχοντας το μετρικό όνομα, την τιμή και τον τρέχοντα αριθμό εποχής.

Για να μετρήσουμε την εγκυρότητα της προσέγγισής μας, συλλέγουμε μετρήσεις που αντιστοιχούν σε απώλεια προπόνησης, ακρίβεια εκπαίδευσης, απώλεια επικύρωσης, ακρίβεια επικύρωσης και χρόνο για την ολοκλήρωση μιας εποχής. Στη συνέχεια, αφού εκτελέσουμε τις εργασίες εκπαίδευσης, μπορούμε ελέγξτε τα αποτελέσματα του πειράματός μας in Στούντιο Amazon SageMaker ή μέσω του SageMaker Experiments SDK.

Για να δείτε τις ακρίβειες επικύρωσης στο Studio, επιλέξτε Αναλύστε στο πείραμα Τρέχει .

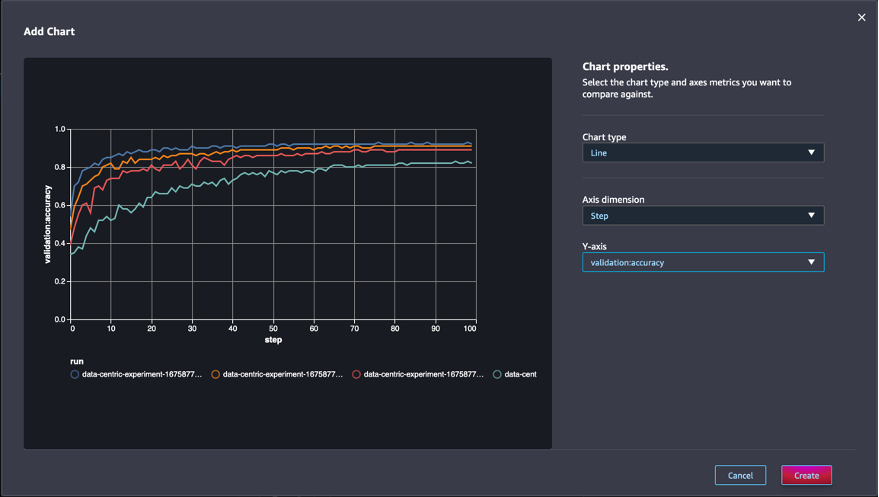

Προσθέστε ένα γράφημα, ορίστε τις ιδιότητες του γραφήματος και επιλέξτε Δημιουργία. Όπως φαίνεται στο παρακάτω στιγμιότυπο οθόνης, θα δείτε μια γραφική παράσταση με τις ακρίβειες επικύρωσης σε κάθε εποχή για όλες τις εκτελέσεις.

Το SDK σάς επιτρέπει επίσης να ανακτήσετε πληροφορίες που σχετίζονται με το πείραμα ως πλαίσιο δεδομένων Pandas:

Προαιρετικά, οι εργασίες κατάρτισης μπορούν να ταξινομηθούν. Για παράδειγμα, θα μπορούσαμε να προσθέσουμε "metrics.validation:accuracy.max" ως η αξία του sort_by η παράμετρος μεταβιβάστηκε σε ExperimentAnalytics για να επιστρέψετε το αποτέλεσμα διατεταγμένο με ακρίβεια επικύρωσης.

Όπως ήταν αναμενόμενο, τα πειράματά μας δείχνουν ότι η εφαρμογή του GLISTER και της επιλογής υποσυνόλου δεδομένων στον αλγόριθμο εκπαίδευσης μειώνει τον χρόνο εκπαίδευσης. Κατά την εκτέλεση του βασικού μας αλγόριθμου εκπαίδευσης, ο διάμεσος χρόνος για την ολοκλήρωση μιας μεμονωμένης εποχής κυμαίνεται γύρω στα 27 δευτερόλεπτα. Αντίθετα, η εφαρμογή του GLISTER για την επιλογή ενός υποσυνόλου ισοδύναμου με το 50%, 30% και 10% του συνολικού συνόλου δεδομένων έχει ως αποτέλεσμα χρόνους να συμπληρωθεί μια εποχή περίπου 13, 8.5 και 2.75 δευτερολέπτων, αντίστοιχα, σε ml.p3.2x μεγάλες περιπτώσεις .

Παρατηρούμε επίσης μια σχετικά ελάχιστη επίδραση στην ακρίβεια επικύρωσης, ειδικά όταν χρησιμοποιούνται υποσύνολα δεδομένων 50%. Μετά από εκπαίδευση για 100 εποχές, η βασική γραμμή παράγει μια ακρίβεια επικύρωσης 92.72%. Αντίθετα, η εφαρμογή του GLISTER για την επιλογή ενός υποσυνόλου ισοδύναμου με το 50%, το 30% και το 10% του συνολικού συνόλου δεδομένων έχει ως αποτέλεσμα ακρίβειες επικύρωσης 91.42%, 89.76% και 82.82% αντίστοιχα.

Συμπέρασμα

Τα πειράματα SageMaker Ground Truth και SageMaker επιτρέπουν μια προσέγγιση με επίκεντρο τα δεδομένα στη μηχανική μάθηση, επιτρέποντας σε επιστήμονες δεδομένων και μηχανικούς ML να παράγουν πιο συνεπή σύνολα δεδομένων και να παρακολουθούν τον αντίκτυπο πιο προηγμένων τεχνικών καθώς τις εφαρμόζουν στη φάση κατασκευής μοντέλων. Η εφαρμογή μιας προσέγγισης με επίκεντρο τα δεδομένα στο ML σάς επιτρέπει να μειώσετε τον όγκο των δεδομένων που απαιτείται από το μοντέλο σας και να βελτιώσετε την ευρωστία του.

Δοκιμάστε το και πείτε μας τη γνώμη σας στα σχόλια.

Σχετικά με τους συγγραφείς

Νικολά Μπερνιέ είναι Αρχιτέκτονας Λύσεων, μέλος της ομάδας του Καναδικού Δημόσιου Τομέα στο AWS. Επί του παρόντος πραγματοποιεί μεταπτυχιακό δίπλωμα με ερευνητικό τομέα στο Deep Learning και είναι κάτοχος πέντε πιστοποιήσεων AWS, συμπεριλαμβανομένης της Πιστοποίησης Ειδικότητας ML. Ο Nicolas είναι παθιασμένος με το να βοηθά τους πελάτες να εμβαθύνουν τις γνώσεις τους για το AWS συνεργαζόμενος μαζί τους για να μεταφράσουν τις επιχειρηματικές τους προκλήσεις σε τεχνικές λύσεις.

Νικολά Μπερνιέ είναι Αρχιτέκτονας Λύσεων, μέλος της ομάδας του Καναδικού Δημόσιου Τομέα στο AWS. Επί του παρόντος πραγματοποιεί μεταπτυχιακό δίπλωμα με ερευνητικό τομέα στο Deep Learning και είναι κάτοχος πέντε πιστοποιήσεων AWS, συμπεριλαμβανομένης της Πιστοποίησης Ειδικότητας ML. Ο Nicolas είναι παθιασμένος με το να βοηθά τους πελάτες να εμβαθύνουν τις γνώσεις τους για το AWS συνεργαζόμενος μαζί τους για να μεταφράσουν τις επιχειρηματικές τους προκλήσεις σε τεχνικές λύσεις.

Τζιβανίλντο Άλβες είναι Αρχιτέκτονας Πρωτοτύπων με την ομάδα Prototyping and Cloud Engineering στο Amazon Web Services, βοηθώντας τους πελάτες να καινοτομήσουν και να επιταχύνουν δείχνοντας την τέχνη του δυνατού στο AWS, έχοντας ήδη εφαρμόσει πολλά πρωτότυπα γύρω από την τεχνητή νοημοσύνη. Έχει μακρά καριέρα στη μηχανική λογισμικού και στο παρελθόν εργάστηκε ως Μηχανικός Ανάπτυξης Λογισμικού στο Amazon.com.br.

Τζιβανίλντο Άλβες είναι Αρχιτέκτονας Πρωτοτύπων με την ομάδα Prototyping and Cloud Engineering στο Amazon Web Services, βοηθώντας τους πελάτες να καινοτομήσουν και να επιταχύνουν δείχνοντας την τέχνη του δυνατού στο AWS, έχοντας ήδη εφαρμόσει πολλά πρωτότυπα γύρω από την τεχνητή νοημοσύνη. Έχει μακρά καριέρα στη μηχανική λογισμικού και στο παρελθόν εργάστηκε ως Μηχανικός Ανάπτυξης Λογισμικού στο Amazon.com.br.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- Platoblockchain. Web3 Metaverse Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/use-a-data-centric-approach-to-minimize-the-amount-of-data-required-to-train-amazon-sagemaker-models/

- :είναι

- $UP

- 000

- 1

- 10

- 100

- 7

- 8

- a

- Σχετικα

- επιταχύνουν

- ακρίβεια

- Κατορθώνω

- απέναντι

- προσαρμόσει

- Επιπλέον

- Πρόσθετος

- προηγμένες

- Μετά το

- κατά

- AI

- αλγόριθμος

- αλγόριθμοι

- Όλα

- Επιτρέποντας

- επιτρέπει

- ήδη

- Amazon

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- Amazon.com

- Ασάφεια

- ποσό

- analytics

- αναλύσει

- και

- απάντηση

- εφαρμοσμένος

- Εφαρμογή

- εφαρμόζοντας

- πλησιάζω

- προσεγγίσεις

- αρχιτεκτονική

- ΕΙΝΑΙ

- ΠΕΡΙΟΧΗ

- επιχειρήματα

- γύρω

- Τέχνη

- τεχνητός

- τεχνητή νοημοσύνη

- AS

- At

- προσπάθεια

- προσοχή

- αυτοματοποίηση

- Αυτόματο

- αυτομάτως

- AWS

- πίσω

- βασίζονται

- Baseline

- BE

- ΚΑΛΎΤΕΡΟΣ

- προκατάληψη

- Κτίριο

- επιχείρηση

- by

- κλήση

- CAN

- καναδικός

- Σταδιοδρομία

- περίπτωση

- κεντρικός

- Πιστοποίηση

- πιστοποιήσεις

- προκλήσεις

- Διάγραμμα

- Επιλέξτε

- τάξη

- τάξεις

- ταξινόμηση

- Ταξινόμηση

- πελάτες

- Backup

- κωδικός

- συλλέγουν

- χρώμα

- COM

- συνδυασμός

- Ελάτε

- σχόλια

- Κοινός

- συγκριτικά

- συγκρίνουν

- συγκρίνοντας

- πλήρης

- συγκείμενο

- Διεξαγωγή

- εμπιστοσύνη

- Εξετάστε

- συνεπής

- ενοποίηση

- Δοχείο

- Περιέχει

- ΣΥΝΕΧΕΙΑ

- αντίθεση

- συμβάλλει

- Αντίστοιχος

- θα μπορούσε να

- δημιουργία

- δημιουργία

- Ρεύμα

- Τη στιγμή

- έθιμο

- Πελάτες

- ημερομηνία

- σημεία δεδομένων

- σύνολα δεδομένων

- απόφαση

- βαθύς

- βαθιά μάθηση

- Βαθύνω

- βαθύτερη

- καθορίζοντας

- Πτυχίο

- αποδεικνύουν

- κατέδειξε

- Σε συνάρτηση

- βάθος

- περιγράφουν

- περιγράφεται

- ανάπτυξη

- Ανάπτυξη

- διαφορετικές

- διαφέρουν

- δύσκολος

- συζητήσουν

- συζήτηση

- διανομή

- Απόκλιση

- πράξη

- Μην

- αυτοκίνητο

- κατά την διάρκεια

- κάθε

- Νωρίτερα

- αποτελέσματα

- αποτελεσματικός

- προσπάθειες

- εμφάνιση

- ενεργοποιήσετε

- μηχανικός

- Μηχανική

- Μηχανικοί

- εξασφαλίζω

- εποχή

- εποχές

- Ισοδύναμος

- λάθη

- ειδικά

- εγκατεστημένος

- αξιολογήσει

- Even

- Κάθε

- παράδειγμα

- παραδείγματα

- αναμένεται

- πείραμα

- εξήγηση

- Χαρακτηριστικό

- εύρεση

- Συγκέντρωση

- εστιάζει

- εστιάζοντας

- ακολουθείται

- Εξής

- εξής

- Για

- Βρέθηκαν

- κλάσμα

- πλαισίων

- από

- λειτουργία

- παράγεται

- γενεά

- δεδομένου

- Go

- καλός

- Έδαφος

- Έχω

- που έχει

- βοήθεια

- βοήθεια

- κατέχει

- Πως

- Πώς να

- Ωστόσο

- HTML

- http

- HTTPS

- Ρύθμιση υπερπαραμέτρων

- προσδιορίσει

- προσδιορισμό

- εικόνα

- εικόνες

- ανισορροπία

- Επίπτωση

- εφαρμογή

- εκτέλεση

- εφαρμοστεί

- εκτελεστικών

- εισαγωγή

- σημαντικό

- βελτίωση

- βελτιωθεί

- βελτίωση

- in

- Συμπεριλαμβανομένου

- αύξηση

- ατομικές

- πληροφορίες

- αρχικός

- νεωτερίζω

- εισαγωγή

- παράδειγμα

- οδηγίες

- Νοημοσύνη

- εισαγάγει

- IT

- επανάληψη

- ΤΟΥ

- εαυτό

- Δουλειά

- Θέσεις εργασίας

- Ξέρω

- γνώση

- επιγραφή

- τιτλοφόρηση

- Ετικέτες

- μεγαλύτερος

- ξεκίνησε

- μάθηση

- Led

- Βιβλιοθήκη

- Μου αρέσει

- Λιστα

- λίγο

- τοποθεσία

- Μακριά

- ματιά

- off

- μηχανή

- μάθηση μηχανής

- που

- ΚΑΝΕΙ

- Κατασκευή

- διαχειρίζεται

- Ταχύτητες

- χειροκίνητα

- πολοί

- κύριοι

- max

- Αυξάνω στον ανώτατο βαθμό

- μέτρο

- που αναφέρθηκαν

- μέθοδοι

- μετρικός

- Metrics

- ελάχιστος

- ελαχιστοποιώντας

- ML

- μοντέλο

- μοντέλα

- περισσότερο

- πλέον

- πολλαπλούς

- όνομα

- Ανάγκη

- δίκτυο

- νευρικό σύστημα

- επόμενη

- Nicolas

- Θόρυβος

- αριθμός

- αντικείμενο

- παρατηρούμε

- of

- on

- ONE

- λειτουργία

- βελτιστοποίηση

- Άλλα

- φόρμες

- δική

- πακέτο

- σελίδα

- Πάντα

- παράμετρος

- παράμετροι

- μέρος

- πέρασε

- παθιασμένος

- ποσοστό

- Εκτελέστε

- επίδοση

- φάση

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Σημείο

- σημεία

- δυνατός

- Θέση

- Προβλέψεις

- προηγούμενος

- προηγουμένως

- αρχές

- διαδικασια μας

- παράγει

- ιδιότητες

- πρωτότυπα

- προτυποποίηση

- παρέχεται

- δημόσιο

- σκοπός

- pytorch

- ποιότητα

- ποσότητα

- ερώτηση

- μάλλον

- πραγματικό κόσμο

- μείωση

- Μειωμένος

- μειώνει

- μείωση

- περιοχή

- τακτικός

- σχετίζεται με

- Καταργήθηκε

- αφαίρεση

- Αποθήκη

- εκπροσωπούνται

- αντιπροσωπεύει

- απαιτείται

- απαιτήσεις

- Απαιτεί

- έρευνα

- ερευνητές

- εκείνοι

- αποτέλεσμα

- Αποτελέσματα

- απόδοση

- εύρωστος

- ευρωστία

- τρέξιμο

- τρέξιμο

- σοφός

- επιστήμονες

- SDK

- δευτερόλεπτα

- Τμήμα

- τμήματα

- τομέας

- επιλογή

- επιλογή

- εξυπηρετούν

- Υπηρεσίες

- Συνεδρίαση

- σειρά

- διάφοροι

- θα πρέπει να

- δείχνουν

- παρουσιάζεται

- σημαντικά

- Απλούς

- ενιαίας

- Μέγεθος

- μεγέθη

- μικρότερος

- So

- λογισμικό

- ανάπτυξη λογισμικού

- τεχνολογία λογισμικού

- Λύσεις

- μερικοί

- Πηγή

- Ειδικότητα

- συγκεκριμένες

- ειδικά

- ταχύτητα

- Βήμα

- Ακόμη

- χώρος στο δίσκο

- Στρατηγική

- δομημένος

- στούντιο

- προμήθεια

- Υποστηρίζει

- τραπέζι

- παίρνει

- εργασίες

- Τεχνικός

- τεχνικές

- δοκιμή

- δοκιμές

- ότι

- Η

- τους

- Τους

- Αυτοί

- τρία

- Μέσω

- ώρα

- φορές

- προς την

- δάδα

- Τορόντο

- τροχιά

- Τρένο

- Εκπαίδευση

- προπονήσεις

- μεταφράζω

- υπό

- υποκείμενες

- Ενημέρωση

- Φορτώθηκε

- us

- χρήση

- επικύρωση

- αξία

- διάφορα

- Δες

- Τρόπος..

- τρόπους

- ιστός

- διαδικτυακές υπηρεσίες

- ΛΟΙΠΌΝ

- Τι

- Ποιό

- ενώ

- θα

- με

- εντός

- χωρίς

- εργάστηκαν

- εργαζόμενος

- Εσείς

- Σας

- zephyrnet