Οι αποτελεσματικές πολιτικές ελέγχου επιτρέπουν στις βιομηχανικές εταιρείες να αυξήσουν την κερδοφορία τους μεγιστοποιώντας την παραγωγικότητα μειώνοντας ταυτόχρονα τον απρογραμμάτιστο χρόνο διακοπής λειτουργίας και την κατανάλωση ενέργειας. Η εύρεση βέλτιστων πολιτικών ελέγχου είναι μια πολύπλοκη εργασία επειδή τα φυσικά συστήματα, όπως οι χημικοί αντιδραστήρες και οι ανεμογεννήτριες, είναι συχνά δύσκολο να μοντελοποιηθούν και επειδή η μετατόπιση στη δυναμική της διαδικασίας μπορεί να προκαλέσει επιδείνωση της απόδοσης με την πάροδο του χρόνου. Η μάθηση ενίσχυσης εκτός σύνδεσης είναι μια στρατηγική ελέγχου που επιτρέπει στις βιομηχανικές εταιρείες να δημιουργούν πολιτικές ελέγχου εξ ολοκλήρου από ιστορικά δεδομένα χωρίς την ανάγκη για ένα ρητό μοντέλο διαδικασίας. Αυτή η προσέγγιση δεν απαιτεί αλληλεπίδραση με τη διαδικασία απευθείας σε ένα στάδιο εξερεύνησης, γεγονός που καταργεί ένα από τα εμπόδια για την υιοθέτηση της ενισχυτικής μάθησης σε κρίσιμες για την ασφάλεια εφαρμογές. Σε αυτήν την ανάρτηση, θα δημιουργήσουμε μια ολοκληρωμένη λύση για την εύρεση βέλτιστων πολιτικών ελέγχου χρησιμοποιώντας μόνο ιστορικά δεδομένα Amazon Sage Maker χρησιμοποιώντας το Ray's RLlib βιβλιοθήκη. Για να μάθετε περισσότερα σχετικά με την ενισχυτική μάθηση, βλ Χρησιμοποιήστε το Reinforcement Learning με το Amazon SageMaker.

Χρήση περιπτώσεις

Ο βιομηχανικός έλεγχος περιλαμβάνει τη διαχείριση πολύπλοκων συστημάτων, όπως γραμμές παραγωγής, ενεργειακά δίκτυα και χημικές μονάδες, για να διασφαλιστεί η αποτελεσματική και αξιόπιστη λειτουργία. Πολλές παραδοσιακές στρατηγικές ελέγχου βασίζονται σε προκαθορισμένους κανόνες και μοντέλα, τα οποία συχνά απαιτούν μη αυτόματη βελτιστοποίηση. Αποτελεί συνήθη πρακτική σε ορισμένες βιομηχανίες η παρακολούθηση της απόδοσης και η προσαρμογή της πολιτικής ελέγχου όταν, για παράδειγμα, ο εξοπλισμός αρχίζει να υποβαθμίζεται ή αλλάζουν οι περιβαλλοντικές συνθήκες. Ο επανασυντονισμός μπορεί να διαρκέσει εβδομάδες και μπορεί να απαιτεί έγχυση εξωτερικών διεγέρσεων στο σύστημα για την καταγραφή της απόκρισής του σε μια προσέγγιση δοκιμής και σφάλματος.

Η ενισχυτική μάθηση έχει αναδειχθεί ως ένα νέο παράδειγμα στον έλεγχο της διαδικασίας για την εκμάθηση βέλτιστων πολιτικών ελέγχου μέσω της αλληλεπίδρασης με το περιβάλλον. Αυτή η διαδικασία απαιτεί την κατανομή των δεδομένων σε τρεις κατηγορίες: 1) μετρήσεις που είναι διαθέσιμες από το φυσικό σύστημα, 2) το σύνολο των ενεργειών που μπορούν να γίνουν στο σύστημα και 3) μια αριθμητική μέτρηση (ανταμοιβή) της απόδοσης του εξοπλισμού. Μια πολιτική εκπαιδεύεται για να βρίσκει τη δράση, σε μια δεδομένη παρατήρηση, που είναι πιθανό να παράγει τις υψηλότερες μελλοντικές ανταμοιβές.

Στην ενισχυτική μάθηση εκτός σύνδεσης, μπορεί κανείς να εκπαιδεύσει μια πολιτική σχετικά με τα ιστορικά δεδομένα προτού τα αναπτύξει στην παραγωγή. Ο αλγόριθμος που εκπαιδεύεται σε αυτήν την ανάρτηση ιστολογίου ονομάζεται "Συντηρητική μάθηση Q” (CQL). Το CQL περιέχει ένα μοντέλο «δρώντα» και ένα μοντέλο «κριτικού» και έχει σχεδιαστεί για να προβλέπει συντηρητικά τη δική του απόδοση μετά τη λήψη μιας προτεινόμενης ενέργειας. Σε αυτήν την ανάρτηση, η διαδικασία αποδεικνύεται με ένα επεξηγηματικό πρόβλημα ελέγχου πόλων καροτσιού. Ο στόχος είναι να εκπαιδεύσετε έναν πράκτορα να ισορροπεί έναν πόλο σε ένα καλάθι ενώ ταυτόχρονα μετακινεί το καλάθι προς μια καθορισμένη θέση στόχου. Η διαδικασία εκπαίδευσης χρησιμοποιεί τα δεδομένα εκτός σύνδεσης, επιτρέποντας στον πράκτορα να μάθει από προϋπάρχουσες πληροφορίες. Αυτή η μελέτη περίπτωσης καρτ-πόλων καταδεικνύει τη διαδικασία εκπαίδευσης και την αποτελεσματικότητά της σε πιθανές εφαρμογές του πραγματικού κόσμου.

Επισκόπηση λύσεων

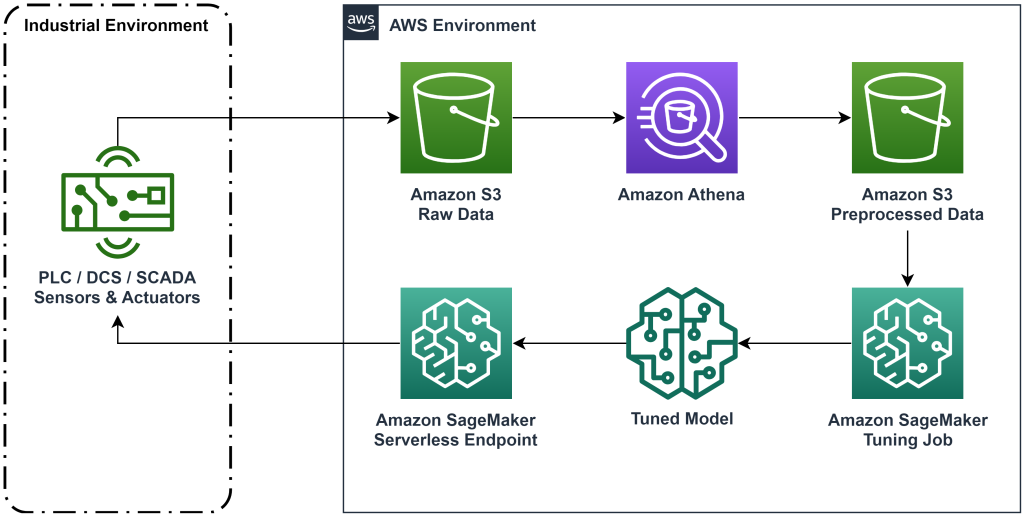

Η λύση που παρουσιάζεται σε αυτήν την ανάρτηση αυτοματοποιεί την ανάπτυξη μιας ροής εργασίας από άκρο σε άκρο για ενισχυτική εκμάθηση εκτός σύνδεσης με δεδομένα ιστορικού. Το παρακάτω διάγραμμα περιγράφει την αρχιτεκτονική που χρησιμοποιείται σε αυτήν τη ροή εργασίας. Τα δεδομένα μετρήσεων παράγονται στο άκρο από ένα κομμάτι βιομηχανικού εξοπλισμού (εδώ προσομοιώνεται με ένα AWS Lambda λειτουργία). Τα δεδομένα τοποθετούνται σε ένα Amazon Kinesis Data Firehose, το οποίο το αποθηκεύει Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3). Το Amazon S3 είναι μια ανθεκτική, αποδοτική και χαμηλού κόστους λύση αποθήκευσης που σας επιτρέπει να εξυπηρετείτε μεγάλους όγκους δεδομένων σε μια διαδικασία εκπαίδευσης μηχανικής εκμάθησης.

Κόλλα AWS καταλογοποιεί τα δεδομένα και τα καθιστά ικανά να αναζητηθούν χρησιμοποιώντας Αμαζόν Αθηνά. Η Athena μετατρέπει τα δεδομένα μέτρησης σε μια μορφή που μπορεί να απορροφήσει ένας αλγόριθμος ενισχυτικής μάθησης και στη συνέχεια τα ξεφορτώνει ξανά στο Amazon S3. Το Amazon SageMaker φορτώνει αυτά τα δεδομένα σε μια εργασία εκπαίδευσης και παράγει ένα εκπαιδευμένο μοντέλο. Στη συνέχεια, το SageMaker εξυπηρετεί αυτό το μοντέλο σε ένα τελικό σημείο του SageMaker. Ο βιομηχανικός εξοπλισμός μπορεί στη συνέχεια να ρωτήσει αυτό το τελικό σημείο για να λάβει συστάσεις δράσης.

Εικόνα 1: Διάγραμμα αρχιτεκτονικής που δείχνει τη ροή εργασιών εκμάθησης ενίσχυσης από άκρο σε άκρο.

Σε αυτήν την ανάρτηση, θα αναλύσουμε τη ροή εργασίας στα ακόλουθα βήματα:

- Διατυπώστε το πρόβλημα. Αποφασίστε ποιες ενέργειες μπορούν να γίνουν, σε ποιες μετρήσεις θα κάνετε συστάσεις και προσδιορίστε αριθμητικά πόσο καλά εκτελέστηκε κάθε ενέργεια.

- Προετοιμάστε τα δεδομένα. Μετατρέψτε τον πίνακα μετρήσεων σε μια μορφή που μπορεί να χρησιμοποιήσει ο αλγόριθμος μηχανικής μάθησης.

- Εκπαιδεύστε τον αλγόριθμο σε αυτά τα δεδομένα.

- Επιλέξτε την καλύτερη εκτέλεση προπόνησης με βάση τις μετρήσεις προπόνησης.

- Αναπτύξτε το μοντέλο σε ένα τελικό σημείο του SageMaker.

- Αξιολογήστε την απόδοση του μοντέλου στην παραγωγή.

Προϋποθέσεις

Για να ολοκληρώσετε αυτήν την περιγραφή, πρέπει να έχετε ένα Λογαριασμός AWS και μια διεπαφή γραμμής εντολών με Εγκατεστημένο AWS SAM. Ακολουθήστε αυτά τα βήματα για να αναπτύξετε το πρότυπο AWS SAM για να εκτελέσετε αυτήν τη ροή εργασίας και να δημιουργήσετε δεδομένα εκπαίδευσης:

- Κατεβάστε το αποθετήριο κώδικα με την εντολή

- Αλλαγή καταλόγου στο repo:

- Δημιουργήστε το repo:

- Αναπτύξτε το repo

- Χρησιμοποιήστε τις ακόλουθες εντολές για να καλέσετε ένα σενάριο bash, το οποίο δημιουργεί ψευδή δεδομένα χρησιμοποιώντας μια συνάρτηση AWS Lambda.

sudo yum install jqcd utilssh generate_mock_data.sh

Αναλυτική λύση

Διατύπωση προβλήματος

Το σύστημά μας σε αυτήν την ανάρτηση ιστολογίου είναι ένα καλάθι με ένα κοντάρι ισορροπημένο στην κορυφή. Το σύστημα αποδίδει καλά όταν το κοντάρι είναι όρθιο και η θέση του καροτσιού είναι κοντά στη θέση του στόχου. Στο προαπαιτούμενο βήμα, δημιουργήσαμε ιστορικά δεδομένα από αυτό το σύστημα.

Ο παρακάτω πίνακας δείχνει ιστορικά δεδομένα που συγκεντρώθηκαν από το σύστημα.

| Θέση καροτσιού | Ταχύτητα καροτσιού | Γωνία πόλου | Γωνιακή ταχύτητα πόλου | Θέση γκολ | Εξωτερική δύναμη | Ανταμοιβή | Χρόνος |

| 0.53 | -0.79 | -0.08 | 0.16 | 0.50 | -0.04 | 11.5 | 5: 37: 54 μμ |

| 0.51 | -0.82 | -0.07 | 0.17 | 0.50 | -0.04 | 11.9 | 5: 37: 55 μμ |

| 0.50 | -0.84 | -0.07 | 0.18 | 0.50 | -0.03 | 12.2 | 5: 37: 56 μμ |

| 0.48 | -0.85 | -0.07 | 0.18 | 0.50 | -0.03 | 10.5 | 5: 37: 57 μμ |

| 0.46 | -0.87 | -0.06 | 0.19 | 0.50 | -0.03 | 10.3 | 5: 37: 58 μμ |

Μπορείτε να αναζητήσετε πληροφορίες ιστορικού συστήματος χρησιμοποιώντας το Amazon Athena με το ακόλουθο ερώτημα:

Η κατάσταση αυτού του συστήματος ορίζεται από τη θέση του καροτσιού, την ταχύτητα του καροτσιού, τη γωνία του πόλου, τη γωνιακή ταχύτητα του πόλου και τη θέση του στόχου. Η ενέργεια που γίνεται σε κάθε χρονικό βήμα είναι η εξωτερική δύναμη που εφαρμόζεται στο καρότσι. Το προσομοιωμένο περιβάλλον εξάγει μια τιμή ανταμοιβής που είναι υψηλότερη όταν το καλάθι είναι πιο κοντά στη θέση του στόχου και το κοντάρι είναι πιο όρθιο.

Προετοιμασία δεδομένων

Για να παρουσιάσετε τις πληροφορίες συστήματος στο μοντέλο ενίσχυσης εκμάθησης, μετατρέψτε τις σε αντικείμενα JSON με κλειδιά που κατηγοριοποιούν τις τιμές σε κατηγορίες κατάστασης (ονομάζεται επίσης παρατήρηση), δράση και ανταμοιβή. Αποθηκεύστε αυτά τα αντικείμενα στο Amazon S3. Ακολουθεί ένα παράδειγμα αντικειμένων JSON που παράγονται από χρονικά βήματα στον προηγούμενο πίνακα.

|

{“obs”:[[0.53,-0.79,-0.08,0.16,0.5]], “action”:[[-0.04]], “reward”:[11.5] ,”next_obs”:[[0.51,-0.82,-0.07,0.17,0.5]]} |

|

{“obs”:[[0.51,-0.82,-0.07,0.17,0.5]], “action”:[[-0.04]], “reward”:[11.9], “next_obs”:[[0.50,-0.84,-0.07,0.18,0.5]]} |

|

{“obs”:[[0.50,-0.84,-0.07,0.18,0.5]], “action”:[[-0.03]], “reward”:[12.2], “next_obs”:[[0.48,-0.85,-0.07,0.18,0.5]]} |

Η στοίβα AWS CloudFormation περιέχει μια έξοδο που καλείται AthenaQueryToCreateJsonFormatedData. Εκτελέστε αυτό το ερώτημα στο Amazon Athena για να εκτελέσετε τον μετασχηματισμό και να αποθηκεύσετε τα αντικείμενα JSON στο Amazon S3. Ο αλγόριθμος ενίσχυσης εκμάθησης χρησιμοποιεί τη δομή αυτών των αντικειμένων JSON για να κατανοήσει σε ποιες τιμές θα βασιστούν οι συστάσεις και το αποτέλεσμα της λήψης ενεργειών στα δεδομένα ιστορικού.

Πράκτορας τραίνων

Τώρα μπορούμε να ξεκινήσουμε μια εργασία εκπαίδευσης για να δημιουργήσουμε ένα εκπαιδευμένο μοντέλο συστάσεων δράσης. Το Amazon SageMaker σάς επιτρέπει να ξεκινήσετε γρήγορα πολλές εργασίες εκπαίδευσης για να δείτε πώς επηρεάζουν διάφορες διαμορφώσεις το εκπαιδευμένο μοντέλο που προκύπτει. Καλέστε τη συνάρτηση Lambda με όνομα TuningJobLauncherFunction για να ξεκινήσετε μια εργασία συντονισμού υπερπαραμέτρων που πειραματίζεται με τέσσερα διαφορετικά σύνολα υπερπαραμέτρων κατά την εκπαίδευση του αλγόριθμου.

Επιλέξτε την καλύτερη διαδρομή προπόνησης

Για να βρείτε ποιες από τις εργασίες κατάρτισης παρήγαγαν το καλύτερο μοντέλο, εξετάστε τις καμπύλες απώλειας που παράγονται κατά τη διάρκεια της εκπαίδευσης. Το μοντέλο κριτικής της CQL εκτιμά την απόδοση του ηθοποιού (που ονομάζεται τιμή Q) μετά τη λήψη μιας προτεινόμενης ενέργειας. Μέρος της συνάρτησης απώλειας του κριτικού περιλαμβάνει το σφάλμα χρονικής διαφοράς. Αυτή η μέτρηση μετρά την ακρίβεια της τιμής Q του κριτικού. Αναζητήστε τρεξίματα προπόνησης με υψηλή μέση τιμή Q και χαμηλό σφάλμα χρονικής διαφοράς. Αυτό το χαρτί, Ροή εργασιών για εκμάθηση ρομποτικής ενίσχυσης εκτός σύνδεσης χωρίς μοντέλα, περιγράφει λεπτομερώς πώς να επιλέξετε την καλύτερη διαδρομή προπόνησης. Το αποθετήριο κώδικα έχει ένα αρχείο, /utils/investigate_training.py, που δημιουργεί μια γραφική εικόνα html που περιγράφει την πιο πρόσφατη εργασία εκπαίδευσης. Εκτελέστε αυτό το αρχείο και χρησιμοποιήστε την έξοδο για να επιλέξετε την καλύτερη εκτέλεση προπόνησης.

Μπορούμε να χρησιμοποιήσουμε τη μέση τιμή Q για να προβλέψουμε την απόδοση του εκπαιδευμένου μοντέλου. Οι τιμές Q εκπαιδεύονται για να προβλέπουν συντηρητικά το άθροισμα των προεξοφλημένων μελλοντικών τιμών ανταμοιβής. Για μακροχρόνιες διαδικασίες, μπορούμε να μετατρέψουμε αυτόν τον αριθμό σε έναν εκθετικά σταθμισμένο μέσο όρο πολλαπλασιάζοντας την τιμή Q επί (1-«επιτόκιο έκπτωσης»). Η καλύτερη εκτέλεση εκπαίδευσης σε αυτό το σετ πέτυχε μια μέση τιμή Q 539. Το προεξοφλητικό επιτόκιο είναι 0.99, επομένως το μοντέλο προβλέπει τουλάχιστον 5.39 μέση ανταμοιβή ανά χρονικό βήμα. Μπορείτε να συγκρίνετε αυτήν την τιμή με την ιστορική απόδοση του συστήματος για μια ένδειξη εάν το νέο μοντέλο θα έχει καλύτερη απόδοση από την πολιτική ελέγχου ιστορικού. Σε αυτό το πείραμα, η μέση ανταμοιβή των ιστορικών δεδομένων ανά χρονικό βήμα ήταν 4.3, επομένως το μοντέλο CQL προβλέπει 25 τοις εκατό καλύτερη απόδοση από ό,τι το σύστημα έχει επιτύχει ιστορικά.

Ανάπτυξη μοντέλου

Τα τελικά σημεία του Amazon SageMaker σάς επιτρέπουν να εξυπηρετείτε μοντέλα μηχανικής εκμάθησης με πολλούς διαφορετικούς τρόπους για να ανταποκρίνεστε σε ποικίλες περιπτώσεις χρήσης. Σε αυτήν την ανάρτηση, θα χρησιμοποιήσουμε τον τύπο τερματικού σημείου χωρίς διακομιστή, έτσι ώστε το τελικό σημείο μας να κλιμακώνεται αυτόματα με τη ζήτηση και να πληρώνουμε για υπολογιστική χρήση μόνο όταν το τελικό σημείο δημιουργεί συμπέρασμα. Για να αναπτύξετε ένα τελικό σημείο χωρίς διακομιστή, συμπεριλάβετε ένα ProductionVariantServerlessConfig στο παραλλαγή παραγωγής του SageMaker διαμόρφωση τελικού σημείου. Το παρακάτω απόσπασμα κώδικα δείχνει πώς αναπτύσσεται το τελικό σημείο χωρίς διακομιστή σε αυτό το παράδειγμα χρησιμοποιώντας το κιτ ανάπτυξης λογισμικού Amazon SageMaker για Python. Βρείτε το δείγμα κώδικα που χρησιμοποιήθηκε για την ανάπτυξη του μοντέλου στο sagemaker-offline-reinforcement-learning-ray-cql.

Τα εκπαιδευμένα αρχεία μοντέλων βρίσκονται στα τεχνουργήματα του μοντέλου S3 για κάθε εκτέλεση εκπαίδευσης. Για να αναπτύξετε το μοντέλο μηχανικής εκμάθησης, εντοπίστε τα αρχεία μοντέλων της καλύτερης εκτέλεσης εκπαίδευσης και καλέστε τη συνάρτηση Lambda με το όνομα "ModelDeployerFunction” με ένα συμβάν που περιέχει αυτά τα δεδομένα μοντέλου. Η συνάρτηση Lambda θα εκκινήσει ένα τελικό σημείο χωρίς διακομιστή SageMaker για να εξυπηρετήσει το εκπαιδευμένο μοντέλο. Δείγμα συμβάντος για χρήση κατά την κλήση του "ModelDeployerFunction"

Αξιολογήστε την απόδοση του εκπαιδευμένου μοντέλου

Ήρθε η ώρα να δούμε πώς τα πάει το εκπαιδευμένο μοντέλο μας στην παραγωγή! Για να ελέγξετε την απόδοση του νέου μοντέλου, καλέστε τη συνάρτηση Lambda με το όνομα "RunPhysicsSimulationFunction" με το όνομα του τελικού σημείου SageMaker στο συμβάν. Αυτό θα εκτελέσει την προσομοίωση χρησιμοποιώντας τις ενέργειες που προτείνονται από το τελικό σημείο. Δείγμα συμβάντος για χρήση κατά την κλήση του RunPhysicsSimulatorFunction:

Χρησιμοποιήστε το ακόλουθο ερώτημα Athena για να συγκρίνετε την απόδοση του εκπαιδευμένου μοντέλου με την απόδοση του ιστορικού συστήματος.

| Πηγή δράσης | Μέση ανταμοιβή ανά χρονικό βήμα |

trained_model |

10.8 |

historic_data |

4.3 |

Οι παρακάτω κινούμενες εικόνες δείχνουν τη διαφορά μεταξύ ενός δείγματος επεισοδίου από τα δεδομένα εκπαίδευσης και ενός επεισοδίου όπου το εκπαιδευμένο μοντέλο χρησιμοποιήθηκε για να επιλέξει ποια ενέργεια θα πραγματοποιηθεί. Στα κινούμενα σχέδια, το μπλε πλαίσιο είναι το καλάθι, η μπλε γραμμή είναι ο πόλος και το πράσινο ορθογώνιο είναι η θέση του στόχου. Το κόκκινο βέλος δείχνει τη δύναμη που εφαρμόζεται στο καλάθι σε κάθε χρονικό βήμα. Το κόκκινο βέλος στα δεδομένα εκπαίδευσης μεταπηδά αρκετά μπροστά και πίσω επειδή τα δεδομένα δημιουργήθηκαν χρησιμοποιώντας 50 τοις εκατό ενέργειες ειδικών και 50 τοις εκατό τυχαίες ενέργειες. Το εκπαιδευμένο μοντέλο έμαθε μια πολιτική ελέγχου που μετακινεί το καρότσι γρήγορα στη θέση του στόχου, διατηρώντας παράλληλα σταθερότητα, αποκλειστικά από την παρατήρηση μη ειδικών επιδείξεων.

|

|

εκκαθάριση

Για να διαγράψετε πόρους που χρησιμοποιούνται σε αυτήν τη ροή εργασίας, μεταβείτε στην ενότητα πόρων της στοίβας Amazon CloudFormation και διαγράψτε τους κάδους S3 και τους ρόλους IAM. Στη συνέχεια, διαγράψτε την ίδια τη στοίβα CloudFormation.

Συμπέρασμα

Η εκμάθηση ενίσχυσης εκτός σύνδεσης μπορεί να βοηθήσει τις βιομηχανικές εταιρείες να αυτοματοποιήσουν την αναζήτηση βέλτιστων πολιτικών χωρίς να διακυβεύεται η ασφάλεια χρησιμοποιώντας ιστορικά δεδομένα. Για να εφαρμόσετε αυτήν την προσέγγιση στις λειτουργίες σας, ξεκινήστε προσδιορίζοντας τις μετρήσεις που συνθέτουν ένα σύστημα που καθορίζεται από την κατάσταση, τις ενέργειες που μπορείτε να ελέγξετε και τις μετρήσεις που υποδεικνύουν την επιθυμητή απόδοση. Στη συνέχεια, πρόσβαση αυτό το αποθετήριο GitHub για την υλοποίηση μιας αυτόματης λύσης από άκρο σε άκρο με χρήση Ray και Amazon SageMaker.

Η ανάρτηση απλώς χαράζει την επιφάνεια του τι μπορείτε να κάνετε με το Amazon SageMaker RL. Δοκιμάστε το και στείλτε μας σχόλια, είτε στο Φόρουμ συζήτησης Amazon SageMaker ή μέσω των συνηθισμένων επαφών σας AWS.

Σχετικά με τους Συγγραφείς

Γουόλτ Μέιφιλντ είναι Αρχιτέκτονας Λύσεων στην AWS και βοηθά τις ενεργειακές εταιρείες να λειτουργούν με μεγαλύτερη ασφάλεια και αποτελεσματικότητα. Πριν ενταχθεί στην AWS, ο Walt εργάστηκε ως Operations Engineer για την Hilcorp Energy Company. Του αρέσει να ασχολείται με τον κήπο και να πετάει με ψάρια στον ελεύθερο χρόνο του.

Γουόλτ Μέιφιλντ είναι Αρχιτέκτονας Λύσεων στην AWS και βοηθά τις ενεργειακές εταιρείες να λειτουργούν με μεγαλύτερη ασφάλεια και αποτελεσματικότητα. Πριν ενταχθεί στην AWS, ο Walt εργάστηκε ως Operations Engineer για την Hilcorp Energy Company. Του αρέσει να ασχολείται με τον κήπο και να πετάει με ψάρια στον ελεύθερο χρόνο του.

Φελίπε Λόπεζ είναι Ανώτερος Αρχιτέκτονας Λύσεων στην AWS με εξειδίκευση στις Επιχειρήσεις Παραγωγής Πετρελαίου & Αερίου. Πριν ενταχθεί στην AWS, ο Felipe εργάστηκε με την GE Digital και τη Schlumberger, όπου εστίασε στη μοντελοποίηση και τη βελτιστοποίηση προϊόντων για βιομηχανικές εφαρμογές.

Φελίπε Λόπεζ είναι Ανώτερος Αρχιτέκτονας Λύσεων στην AWS με εξειδίκευση στις Επιχειρήσεις Παραγωγής Πετρελαίου & Αερίου. Πριν ενταχθεί στην AWS, ο Felipe εργάστηκε με την GE Digital και τη Schlumberger, όπου εστίασε στη μοντελοποίηση και τη βελτιστοποίηση προϊόντων για βιομηχανικές εφαρμογές.

Yingwei Yu είναι Εφαρμοσμένος Επιστήμονας στο Generative AI Incubator, AWS. Έχει εμπειρία σε συνεργασία με διάφορους οργανισμούς σε διάφορες βιομηχανίες σε διάφορες αποδείξεις της ιδέας στη μηχανική μάθηση, συμπεριλαμβανομένης της επεξεργασίας φυσικής γλώσσας, της ανάλυσης χρονοσειρών και της προγνωστικής συντήρησης. Στον ελεύθερο χρόνο του, του αρέσει το κολύμπι, η ζωγραφική, η πεζοπορία και ο χρόνος με την οικογένεια και τους φίλους.

Yingwei Yu είναι Εφαρμοσμένος Επιστήμονας στο Generative AI Incubator, AWS. Έχει εμπειρία σε συνεργασία με διάφορους οργανισμούς σε διάφορες βιομηχανίες σε διάφορες αποδείξεις της ιδέας στη μηχανική μάθηση, συμπεριλαμβανομένης της επεξεργασίας φυσικής γλώσσας, της ανάλυσης χρονοσειρών και της προγνωστικής συντήρησης. Στον ελεύθερο χρόνο του, του αρέσει το κολύμπι, η ζωγραφική, η πεζοπορία και ο χρόνος με την οικογένεια και τους φίλους.

Haozhu Wang είναι ένας ερευνητής στο Amazon Bedrock που εστιάζει στην κατασκευή μοντέλων θεμελίων Titan της Amazon. Προηγουμένως εργάστηκε στο Amazon ML Solutions Lab ως συνεπικεφαλής του Reinforcement Learning Vertical και βοήθησε τους πελάτες να δημιουργήσουν προηγμένες λύσεις ML με την τελευταία έρευνα για την ενίσχυση της εκμάθησης, την επεξεργασία φυσικής γλώσσας και την εκμάθηση γραφημάτων. Ο Haozhu έλαβε το διδακτορικό του στην Ηλεκτρολογία και Μηχανική Υπολογιστών από το Πανεπιστήμιο του Μίσιγκαν.

Haozhu Wang είναι ένας ερευνητής στο Amazon Bedrock που εστιάζει στην κατασκευή μοντέλων θεμελίων Titan της Amazon. Προηγουμένως εργάστηκε στο Amazon ML Solutions Lab ως συνεπικεφαλής του Reinforcement Learning Vertical και βοήθησε τους πελάτες να δημιουργήσουν προηγμένες λύσεις ML με την τελευταία έρευνα για την ενίσχυση της εκμάθησης, την επεξεργασία φυσικής γλώσσας και την εκμάθηση γραφημάτων. Ο Haozhu έλαβε το διδακτορικό του στην Ηλεκτρολογία και Μηχανική Υπολογιστών από το Πανεπιστήμιο του Μίσιγκαν.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Αυτοκίνητο / EVs, Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- ChartPrime. Ανεβάστε το Trading Game σας με το ChartPrime. Πρόσβαση εδώ.

- BlockOffsets. Εκσυγχρονισμός της περιβαλλοντικής αντιστάθμισης ιδιοκτησίας. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/optimize-equipment-performance-with-historical-data-ray-and-amazon-sagemaker/

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 07

- 08

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 17

- 25

- 32

- 39

- 50

- 51

- 54

- 7

- 8

- 84

- 9

- a

- Σχετικα

- πρόσβαση

- ακρίβεια

- επιτευχθεί

- απέναντι

- Ενέργειες

- ενεργειών

- Επιπλέον

- Υιοθεσία

- προηγμένες

- επηρεάζουν

- Μετά το

- Πράκτορας

- AI

- αλγόριθμος

- Επιτρέποντας

- επιτρέπει

- Επίσης

- Amazon

- Αμαζόν Αθηνά

- Εργαστήριο Amazon ML Solutions

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- an

- ανάλυση

- και

- Γωνιώδης

- κινούμενα σχέδια

- εφαρμογές

- εφαρμοσμένος

- πλησιάζω

- αρχιτεκτονική

- ΕΙΝΑΙ

- AS

- At

- αυτοματοποίηση

- αυτοκίνητα

- Αυτόματο

- αυτομάτως

- διαθέσιμος

- μέσος

- AWS

- AWS CloudFormation

- AWS Lambda

- πίσω

- Υπόλοιπο

- εμπόδια

- βάση

- βασίζονται

- βίαιο χτύπημα

- BE

- επειδή

- πριν

- ΚΑΛΎΤΕΡΟΣ

- Καλύτερα

- μεταξύ

- Κομμάτι

- Μπλοκ

- Μπλε

- Κουτί

- Διακοπή

- Σπάζοντας

- χτίζω

- Κτίριο

- by

- κλήση

- που ονομάζεται

- κλήση

- CAN

- περίπτωση

- μελέτη περίπτωσης

- περιπτώσεις

- καταλόγους

- κατηγορίες

- Αιτία

- αλλαγή

- έλεγχος

- χημική ουσία

- Κλεισιμο

- πιο κοντά

- κωδικός

- Εταιρείες

- εταίρα

- συγκρίνουν

- πλήρης

- συγκρότημα

- συμβιβασμός

- Υπολογίστε

- υπολογιστή

- Μηχανικός ηλεκτρονικών υπολογιστών

- συγκέντρωση

- έννοια

- Συνθήκες

- συντηρητικός

- καταναλώνουν

- κατανάλωση

- Επαφές

- Περιέχει

- έλεγχος

- μετατρέψετε

- δημιουργεί

- Κριτικός

- Πελάτες

- ημερομηνία

- αποφασίζει

- ορίζεται

- Ζήτηση

- κατέδειξε

- καταδεικνύει

- παρατάσσω

- αναπτυχθεί

- ανάπτυξη

- ανάπτυξη

- καθορισμένο

- σχεδιασμένα

- επιθυμητή

- καθέκαστα

- Προσδιορίστε

- Ανάπτυξη

- διαφορά

- διαφορετικές

- ψηφιακό

- κατευθείαν

- Έκπτωση

- έκπτωση

- συζήτηση

- do

- κάνει

- πράξη

- κάτω

- downtime

- κατά την διάρκεια

- δυναμική

- κάθε

- άκρη

- αποτελεσματικότητα

- αποτελεσματικός

- αποτελεσματικά

- είτε

- προέκυψαν

- ενεργοποιήσετε

- από άκρη σε άκρη

- Τελικό σημείο

- ενέργεια

- Κατανάλωση Ενέργειας

- μηχανικός

- Μηχανική

- εξασφαλίζω

- εξ ολοκλήρου

- Περιβάλλον

- περιβάλλοντος

- επεισόδιο

- εξοπλισμός

- σφάλμα

- εκτιμήσεις

- Συμβάν

- εξετάζω

- παράδειγμα

- εμπειρία

- πείραμα

- πειράματα

- εμπειρογνώμονας

- εξερεύνηση

- εκθετικά

- εξωτερικός

- οικογένεια

- ανατροφοδότηση

- Εικόνα

- Αρχεία

- Αρχεία

- Εύρεση

- εύρεση

- Ψάρι

- επικεντρώθηκε

- εστιάζοντας

- ακολουθήστε

- Εξής

- Για

- Δύναμη

- μορφή

- μορφή

- Εμπρός

- Θεμέλιο

- τέσσερα

- φίλους

- από

- λειτουργία

- μελλοντικός

- Κήπος

- GAS

- συγκεντρώθηκαν

- ge

- παράγουν

- παράγεται

- δημιουργεί

- παραγωγής

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- gif

- GitHub

- Δώστε

- δεδομένου

- γκολ

- γραφική παράσταση

- Πράσινο

- Group

- Σκληρά

- Έχω

- he

- βοήθεια

- βοήθησε

- βοηθά

- εδώ

- Ψηλά

- υψηλότερο

- υψηλότερο

- του

- ιστορικών

- ιστορικά

- Πως

- Πώς να

- HTML

- HTTPS

- Ρύθμιση υπερπαραμέτρων

- προσδιορισμό

- if

- εφαρμογή

- εκτέλεση

- in

- περιλαμβάνουν

- περιλαμβάνει

- Συμπεριλαμβανομένου

- Αυξάνουν

- εκκολαπτήριο

- υποδεικνύω

- ένδειξη

- βιομηχανικές

- βιομηχανίες

- πληροφορίες

- εγκαθιστώ

- αλληλεπιδρώντας

- αλληλεπίδραση

- περιβάλλον λειτουργίας

- σε

- IT

- ΤΟΥ

- εαυτό

- Δουλειά

- Θέσεις εργασίας

- ενώνει

- jpg

- json

- άλματα

- μόλις

- πλήκτρα

- εργαστήριο

- Γλώσσα

- large

- αργότερο

- ξεκινήσει

- ΜΑΘΑΊΝΩ

- μάθει

- μάθηση

- ελάχιστα

- ας

- Αφήνει

- Βιβλιοθήκη

- Πιθανός

- συμπαθεί

- LIMIT

- γραμμή

- γραμμές

- φορτία

- που βρίσκεται

- τοποθεσία

- ματιά

- off

- Χαμηλός

- χαμηλού κόστους

- μηχανή

- μάθηση μηχανής

- Η διατήρηση

- συντήρηση

- κάνω

- ΚΑΝΕΙ

- διαχείριση

- Ταχύτητες

- κατασκευής

- πολοί

- μεγιστοποιώντας

- Ενδέχεται..

- εννοώ

- μέτρηση

- μετρήσεις

- μέτρα

- Γνωρίστε

- μετρικός

- Metrics

- Μίσιγκαν

- ML

- μοντέλο

- μοντελοποίηση

- μοντέλα

- Παρακολούθηση

- περισσότερο

- κινήσεις

- κίνηση

- πολλαπλούς

- πολλαπλασιασμού

- όνομα

- Ονομάστηκε

- Φυσικό

- Επεξεργασία φυσικής γλώσσας

- Πλοηγηθείτε

- Ανάγκη

- Νέα

- αριθμός

- αντικειμένων

- of

- offline

- συχνά

- Πετρέλαιο

- on

- ONE

- αποκλειστικά

- λειτουργούν

- λειτουργία

- λειτουργίες

- βέλτιστη

- βελτιστοποίηση

- Βελτιστοποίηση

- or

- τάξη

- οργανώσεις

- δικός μας

- Αποτέλεσμα

- Ξεπερνώ

- παραγωγή

- επί

- δική

- ζωγραφική

- Χαρτί

- παράδειγμα

- μέρος

- Πληρωμή

- για

- τοις εκατό

- Εκτελέστε

- επίδοση

- εκτελούνται

- εκτελεί

- phd

- φυσικός

- επιλέξτε

- κομμάτι

- Φυτά

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- σας παρακαλούμε

- Πολιτικές

- πολιτική

- θέση

- Θέση

- δυναμικού

- πρακτική

- προβλέψει

- προβλέποντας

- πρόβλεψη

- παρόν

- παρουσιάζονται

- προηγούμενος

- προηγουμένως

- Πριν

- Πρόβλημα

- διαδικασία

- διαδικασια μας

- Διεργασίες

- μεταποίηση

- παράγει

- Παράγεται

- παράγει

- παραγωγή

- παραγωγικότητα

- Προϊόντα

- κερδοφορία

- αποδείξεις

- βάζω

- Python

- γρήγορα

- τυχαίος

- Τιμή

- RAY

- πραγματικό κόσμο

- λαμβάνω

- έλαβε

- Σύσταση

- συστάσεις

- συνιστάται

- ρεκόρ

- Red

- μείωση

- αξιόπιστος

- Αποθήκη

- απαιτούν

- Απαιτεί

- έρευνα

- Υποστηρικτικό υλικό

- απάντησης

- με αποτέλεσμα

- Αποτελέσματα

- Ανταμοιβή

- Ανταμοιβές

- ρόλους

- κανόνες

- τρέξιμο

- τρέχει

- ασφάλεια

- Ασφάλεια

- σοφός

- Sam

- Ζυγός

- Επιστήμονας

- γραφή

- Αναζήτηση

- Τμήμα

- δείτε

- στείλετε

- αρχαιότερος

- Σειρές

- εξυπηρετούν

- Χωρίς διακομιστή

- εξυπηρετεί

- Υπηρεσίες

- σειρά

- Σέτς

- διάφοροι

- δείχνουν

- Δείχνει

- Απλούς

- προσομοίωση

- ταυτοχρόνως

- Απόσπασμα

- So

- λογισμικό

- ανάπτυξη λογισμικού

- κιτ ανάπτυξης λογισμικού

- λύση

- Λύσεις

- μερικοί

- Δαπάνες

- σταθερότητα

- σωρός

- Στάδιο

- πρότυπο

- Εκκίνηση

- ξεκινά

- Κατάσταση

- Βήμα

- Βήματα

- χώρος στο δίσκο

- κατάστημα

- καταστήματα

- στρατηγικές

- Στρατηγική

- δομή

- Μελέτη

- τέτοιος

- Επιφάνεια

- σύστημα

- συστήματα

- τραπέζι

- Πάρτε

- λαμβάνεται

- λήψη

- Έργο

- πρότυπο

- από

- ότι

- Η

- Το κράτος

- τους

- τότε

- Αυτοί

- αυτό

- τρία

- Μέσω

- ώρα

- Χρονική σειρά

- Τιτάν

- προς την

- κορυφή

- προς

- παραδοσιακός

- Τρένο

- εκπαιδευμένο

- Εκπαίδευση

- Μεταμορφώστε

- Μεταμόρφωση

- μετασχηματισμών

- αληθής

- προσπαθώ

- τύπος

- καταλαβαίνω

- πανεπιστήμιο

- επάνω σε

- us

- Χρήση

- χρήση

- μεταχειρισμένος

- χρησιμοποιεί

- χρησιμοποιώντας

- αξία

- Αξίες

- ποικιλία

- διάφορα

- Ταχύτητα

- κατακόρυφος

- όγκους

- περιδιάβαση

- ήταν

- τρόπους

- we

- ιστός

- διαδικτυακές υπηρεσίες

- Εβδ.

- ΛΟΙΠΌΝ

- Τι

- πότε

- Ποιό

- ενώ

- θα

- άνεμος

- με

- χωρίς

- εργάστηκαν

- ροής εργασίας

- εργαζόμενος

- Εσείς

- Σας

- zephyrnet