La salud de una persona es un tema increíblemente personal, e ir al médico puede ser una experiencia intimidante y estresante. Esto es especialmente cierto para las personas que forman parte de grupos en los que históricamente el sistema médico ha fallado. Estos problemas estructurales en el sistema de salud han permeado los algoritmos que se utilizan cada vez más en el diagnóstico y tratamiento de pacientes. CCC organizó un panel, “Equidad en salud: ¿Cómo pueden los algoritmos y los datos mitigar, no exacerbar, los daños?” que abordó estos temas. Los panelistas fueron la Dra. Amaka Eneanya (Fresenius Medical Care), la Dra. Mona Singh (Universidad de Princeton), la Dra. Melanie Moses (Universidad de Nuevo México) y la Dra. Katie Siek (Universidad de Indiana).

La salud de una persona es un tema increíblemente personal, e ir al médico puede ser una experiencia intimidante y estresante. Esto es especialmente cierto para las personas que forman parte de grupos en los que históricamente el sistema médico ha fallado. Estos problemas estructurales en el sistema de salud han permeado los algoritmos que se utilizan cada vez más en el diagnóstico y tratamiento de pacientes. CCC organizó un panel, “Equidad en salud: ¿Cómo pueden los algoritmos y los datos mitigar, no exacerbar, los daños?” que abordó estos temas. Los panelistas fueron la Dra. Amaka Eneanya (Fresenius Medical Care), la Dra. Mona Singh (Universidad de Princeton), la Dra. Melanie Moses (Universidad de Nuevo México) y la Dra. Katie Siek (Universidad de Indiana).

El Dr. Eneanya comenzó el panel discutiendo cómo una ecuación subestimó sistemáticamente la enfermedad renal.se en los afroamericanos durante décadas. Explicó que en los EE. UU., todos los pacientes que tienen enfermedad renal se ingresan en un registro. La prevalencia de la enfermedad ha aumentado en general en las últimas décadas, y para las personas negras tiende a ser aún más frecuente y grave.

El Dr. Eneanya describió estas disparidades raciales/étnicas en los factores de riesgo y los resultados de la enfermedad renal crónica (ERC) (Eneanya ND et al. Naturaleza Rev NepH. 2021, Sistema de datos renales de los Estados Unidos.):

- La prevalencia de diabetes es más alta entre las personas negras en comparación con otros grupos raciales

- Las personas negras e hispanas son diagnosticadas a edades más tempranas en comparación con las personas blancas.

- Las personas negras tienen tasas significativamente más altas de hipertensión en comparación con las personas blancas.

- El control de la hipertensión es menor entre las personas negras e hispanas en comparación con las personas blancas

- Las personas negras tienen menos probabilidades de recibir atención nefrológica antes de comenzar la diálisis en comparación con otros grupos raciales

- Riesgo de desarrollar insuficiencia renal que requiera diálisis o trasplante de riñón

- 4 veces mayor en individuos negros versus blancos

- 1.3 veces mayor en hispanos versus blancos

- Las personas negras tienen menos probabilidades de recibir un trasplante de riñón en comparación con otros grupos raciales

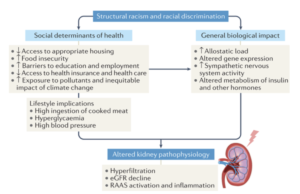

El racismo estructural se suma a los malos resultados de salud de las enfermedades relacionadas con los riñones, explicó el Dr. Eneanya (Eneanya ND et al. Naturaleza Rev NepH. 2021.):

Los hábitos de estilo de vida que puede permitirse, como lo que come, y los impactos biológicos como el estrés del racismo y la discriminación, conducen a cambios metabólicos en el cuerpo, lo que puede provocar una disminución de la función renal.

El Dr. Eneanya se centró en un ejemplo de cómo un algoritmo actualmente en uso por los médicos tiene consecuencias en el mundo real. La ecuación eGFR es un algoritmo utilizado para determinar qué tan fuerte es la función renal de un paciente. Una eGFR más alta representa una mejor función renal. El nivel de eGFR de un paciente determina si es elegible para ciertos tratamientos y, quizás lo más importante, un trasplante de riñón. Sin embargo, el algoritmo muestra que una persona negra y no negra que tienen la misma edad, sexo y tienen la misma medida de creatinina (un análisis de sangre que mide la función renal), tienen diferentes niveles de eGFR. El algoritmo calcula que una persona negra tiene una eGFR más alta, una función renal supuestamente superior, que la persona no negra. Esto limita el tratamiento para el que son elegibles y significa que necesitan estar más enfermos para recibir la ayuda a la que deberían tener derecho.

El Dr. Eneanya explicó la historia del algoritmo que revela por qué calcula de esta manera equivocada: un estudio de 1999 atribuyó una creatinina sérica más alta a las personas negras debido a la suposición incorrecta de que tenían una masa muscular más alta. El estudio desarrolló la primera ecuación de eGFR utilizada en los Estados Unidos e incorporó un factor de multiplicación de "raza negra" que causa una eGFR más alta entre las personas negras. El uso de la eGFR es problemático porque los médicos deben juzgar la raza de alguien en función de la apariencia o los registros médicos (que pueden tener la raza enumerada como una suposición sobrante de un médico anterior). Tampoco hay una distinción para las personas de raza mixta, o un método para clasificarlas.

El Dr. Eneanya fue autor de un artículo que cambió la forma en que se calcula la eGFR en el cuidado de la salud al abogar por una ecuación que no tenga en cuenta la raza en la estimación (Inker LA, Eneanya ND, et al. NEJM 2021, Delgado C, et al. JASN 2021). La Dra. Eneanya y sus colegas volvieron al estudio original de 1999 y eliminaron la raza de la ecuación y la reajustaron con otras entradas. Hoy, ⅓ de los hospitales y clínicas en los EE. UU. están usando la nueva ecuación, y United Network for Organ Sharing (UNOS) restringió notablemente el uso de la ecuación basada en la raza a todos los centros de trasplante en junio de 2022. En enero dieron un paso más. 2023 y declaró que todos los centros de trasplante de EE. UU. deben revisar a todos los pacientes negros en la lista de espera de trasplante de riñón y modificar su tiempo de espera si se vio afectado por la ecuación de eGFR basada en la raza. El Dr. Eneanya especificó que si bien UNOS es parte del gobierno federal, el gobierno no estuvo directamente involucrado en la decisión de prohibir el uso de la ecuación basada en la raza.

Aparte de la adopción universal de la nueva ecuación eGFR, la Dra. Eneanya tenía algunos enfoques futuros más que considera clave para el acceso equitativo al tratamiento de la enfermedad renal:

- Desarrollar políticas y procesos para mejorar el acceso a la atención preventiva de la enfermedad renal crónica

- Desarrollar políticas para aumentar el acceso al trasplante de riñón

- Investigar los efectos ambientales (p. ej., estrés, discriminación) sobre la función renal y la progresión de la enfermedad

- Transparencia en la discusión de la determinación de la función renal con los pacientes (incluidas las limitaciones de las ecuaciones de eGFR)

El Dr. Eneanya explicó que desentrañar los estereotipos sobre la raza negra se reduce a eliminar las falacias y las noticias falsas que no tienen base científica. Por ejemplo, los planes de estudios de las facultades de medicina están cambiando para mostrar que no existe una base antropológica de que haya más masa muscular en una raza que en otra. Los medios también han hecho un buen trabajo al compartir este mito reventado, y el Dr. Eneanya incluso consultó sobre un episodio de Grey's Anatomy que destacó los impactos devastadores de la ecuación eGFR para los pacientes negros que necesitan un trasplante de riñón.

El Dr. Singh continuó la conversación sobre las disparidades en la salud al explicar que en los EE. UU., las personas negras tienen tasas de mortalidad por cáncer más altas en comparación con las personas blancas. Este hecho ejemplifica que hay muchos desafíos que los profesionales médicos y los investigadores informáticos deben enfrentar, también hay muchas oportunidades para desarrollar métodos que no amplíen las disparidades existentes.

El Dr. Singh primero explicó la biología del cáncer: “El cáncer es una enfermedad en la que nuestras propias células adquieren mutaciones que les permiten crecer sin control. Entonces, si queremos comprender los fundamentos moleculares del cáncer en CUALQUIER individuo, podemos observar los genomas de sus células cancerosas y sus células no cancerosas, y secuenciar. Una vez que hemos secuenciado las células normales y cancerosas, podemos comparar los genomas y descubrir qué mutaciones adquirimos en las células cancerosas, y esto puede darnos una pista sobre qué alteraciones pueden ser las relevantes para el cáncer de ese individuo. Esto es precisamente lo que se ha hecho en los últimos 15 años, donde se secuenciaron los tumores de decenas de miles de personas y se identificaron mutaciones dentro de ellos”.

Prácticamente todo el mundo conoce a alguien a quien se le ha diagnosticado cáncer y no existe una cura universal. Sin embargo, el Dr. Singh luego discutió la promesa de la oncología de precisión, donde un científico secuencia el tumor de un paciente, identifica sus mutaciones de ADN y realiza un análisis computacional para determinar qué alteraciones pueden ser atacadas. La inmunoterapia es un enfoque para aprovechar el propio sistema inmunitario de una persona para atacar sus tumores. Una inmunoterapia prometedora y prometedora es diseñar vacunas personalizadas para cada individuo y estas vacunas provocan una respuesta inmune a sus tumores.

El Dr. Singh explica que la forma en que esto funciona es que cada uno de nuestros sistemas inmunitarios tiene 6 copias diferentes de los genes clásicos de clase I del complejo mayor de histocompatibilidad (MHC). Hay más de 13,000 XNUMX variantes MHC diferentes de estos genes, por lo que cada persona tiene un conjunto diferente de genes MHC. Algunas mutaciones dentro de las células cancerosas dan como resultado proteínas "extrañas" y algunas de ellas pueden unirse a los MHC de un individuo. Estos complejos de MHC unidos a un fragmento de proteína derivada del cáncer son reconocidos por las células inmunitarias y pueden activar una respuesta inmunitaria. Esto es altamente personalizado ya que el tumor de cada individuo puede tener diferentes mutaciones y cada individuo tiene diferentes MHC. Los científicos están utilizando el aprendizaje automático para predecir qué variantes del MHC se unen a qué péptidos, lo que, con suerte, mejorará la eficacia de la inmunoterapia y, en última instancia, conducirá al diseño de vacunas de neoantígeno personalizadas.

La variedad de genes MHC varía enormemente en todo el mundo, explica el Dr. Singh. La mayoría de los alelos del MHC no tienen datos de unión asociados con ellos, y los que sí tienen datos sobre su unión están sesgados a favor de algunos grupos raciales. Al probar un conjunto de datos, es importante no solo centrarse en el rendimiento general, sino también considerar las subpoblaciones de datos para que todos tengan el mismo acceso a los beneficios potenciales de esta investigación.

El conjunto de entrenamiento debe analizarse por sesgo antes de ser aplicado. Además, los métodos para estimar el rendimiento en datos no vistos pueden revelar sesgos en los datos con los que se entrenó. La recopilación de datos de manera imparcial es esencial para limitar la posibilidad de sesgo más adelante en el uso del algoritmo. Las áreas de trabajo futuro sobre este tema se centran en procedimientos de capacitación alternativos y estrategias algorítmicas para la recopilación de datos específicos. En general, es crucial priorizar el desarrollo de enfoques justos de medicina de precisión para que las terapias y la investigación posterior sean equitativas.

La Dra. Moses habló a continuación y contextualizó cómo los algoritmos de unión de péptidos de eGFR y MHC encajan en un ecosistema más amplio de cómo los algoritmos médicos afectan los resultados sociales. Ella explica que los científicos usan algoritmos e IA para predecir los resultados que nos interesan a partir de proxies que se pueden medir fácilmente, y esos proxies pueden ser inexactos. Para hacer que los algoritmos médicos sean aún más complicados, interactúan constantemente entre sí de manera impredecible, por lo que el alcance total de los algoritmos en el diagnóstico de un paciente generalmente no está claro. Por lo tanto, es crucial usar los algoritmos con precaución, especialmente porque cuando los algoritmos fallan, pueden ser más dañinos para los más vulnerables.

Averiguar a quién afecta un algoritmo y por qué es una parte importante de la equidad médica. El Dr. Moses da un paso atrás y define la equidad. El gráfico común utilizado para diferenciar equidad de igualdad, con individuos de 3 alturas diferentes luchando por ver un juego de béisbol y diferentes formas de apoyarlos, tiene fallas incluso en la 3ra imagen que elimina la barrera porque sugiere que hay algo inherente a la persona en cuanto a por qué necesitan el apoyo en lugar de las razones sociales que pueden haber causado la inequidad en primer lugar.

El Dr. Moses mostró un gráfico alternativo para definir cómo se ve la equidad en una sociedad con injusticias sistémicas (Copyright 2020 de Nicolás E. Barceló y Sonya Shadravan (Artista: Aria Ghalili)):

Este gráfico revela que no todos pueden beneficiarse simplemente con la eliminación de la barrera, pero existen problemas profundamente arraigados que deben abordarse para lograr la equidad.

Los científicos informáticos siempre deben tener en cuenta este importante contexto, argumenta el Dr. Moses. A menudo es difícil identificar las suposiciones que estuvieron presentes en la creación de algoritmos, incluso con los algoritmos más sencillos. También es fácil usar una correlación estadística para predecir un resultado y suponer que la correlación es igual a la causalidad, pero eso es una falacia.

El Dr. Moses continúa dando ejemplos concretos de algoritmos no equitativos que se usan en la sociedad actual en otros dominios. Por ejemplo, algoritmos en el sistema de justicia penal que reemplazan la fianza monetaria por la prisión preventiva. La intención es que el proceso sea un método imparcial basado en datos para detener a aquellos que son un peligro o un alto riesgo de no presentarse a juicio. Sin embargo, los algoritmos tienen muchas deficiencias tanto en la capacidad del algoritmo para hacer predicciones justas y precisas como en los sesgos del sistema del que forma parte el algoritmo, incluidas las entradas sesgadas y las interpretaciones sesgadas de las salidas. Otro ejemplo de cómo los algoritmos perpetúan el sesgo racial en el sistema de justicia penal es el software de reconocimiento facial. Si bien se ha demostrado que el reconocimiento facial es menos preciso para identificar rostros femeninos de piel más oscura, son los rostros de hombres negros los que con mayor frecuencia han sido identificados erróneamente por estos algoritmos, lo que lleva a falsos arrestos. Esto demuestra cómo el sesgo que más afecta a un grupo (mujeres negras) en términos de clasificación precisa, puede tener el mayor impacto en otro grupo (hombres negros) debido a los sesgos en el sistema de justicia penal.

Los algoritmos pueden exacerbar el sesgo humano y también pueden descartarse si no refuerzan el juicio que habría hecho sin consultar el algoritmo. Esto también es cierto en los algoritmos sesgados en medicina. Por ejemplo, los oxímetros de pulso son menos precisos para detectar los niveles de oxígeno en pieles más oscuras, lo que puede dar lugar a un diagnóstico insuficiente de enfermedades respiratorias como la COVID grave. Usar la cantidad de dinero gastado en atención médica como un indicador de cuán saludable es una persona es otra medida injusta. Los ejemplos que describieron el Dr. Eneanya y el Dr. Singh, la insuficiencia renal con descuento del riñón eGFR en los afroamericanos y los conjuntos de datos genómicos que representan en exceso la ascendencia europea, son otros ejemplos destacados de algoritmos sesgados en la medicina que tienen peligrosas consecuencias posteriores para las personas afectadas. La ecuación eGFR se usó para identificar a los presos lo suficientemente enfermos como para ser liberados de la prisión durante el COVID, lo que resultó en que a un hombre afroamericano se le negara la liberación porque se sobreestimó su función renal.

La retroalimentación puede mejorar los algoritmos o exacerbar sus daños. Los algoritmos no son una calle de un solo sentido, ya que su objetivo es predecir el comportamiento a partir de los datos y la predicción de un año afecta los datos del año siguiente. Los algoritmos deben apuntar a disminuir los sesgos con el tiempo; por ejemplo, las audiencias de fianza deberían ayudar a los acusados a presentarse al juicio en lugar de predecir fracasos; la vigilancia debe apuntar a reducir tanto el crimen como los arrestos falsos. Los algoritmos utilizados en todos los dominios nunca deben grabarse en piedra porque habrá comentarios entre las personas, los algoritmos y el contexto social.

El Dr. Moses también propuso caminos adicionales a seguir: eliminar el sesgo de los conjuntos de datos, cuestionar las suposiciones, revertir (no reforzar) el sesgo sistémico, evaluar con una diversidad de perspectivas, exigir algoritmos transparentes y explicables, y usar implementaciones graduales y adaptables. La percepción común es que los algoritmos de alguna manera eliminan el sesgo, pero en realidad a menudo codifican el sesgo y debemos tener cuidado con los algoritmos y sus resultados.

La parte final del panel fue una sesión de preguntas y respuestas. El moderador, el Dr. Siek, inició la sesión preguntando: "¿Cómo pueden los algoritmos y los datos no exacerbar los daños?"

- Dr. Eneanya: Si un investigador se detiene en la raza cuando busca diferenciadores en un algoritmo, eso es perezoso y científicamente inválido. Genéticamente, los humanos se parecen más entre razas que dentro. Es más importante pensar en las características biológicas que realmente impactan en un sistema humano como los riñones. Por ejemplo, al probar el oxímetro de pulso, los investigadores deberían haber consultado con un dermatólogo para probar y validar los oxímetros de pulso en función de diferentes tonos de piel, en lugar de usar un tipo de dispositivo para personas con diferentes tonos de piel.

- Dr. Moses: Deberíamos usar ese mismo enfoque para validar algoritmos después de que se hayan puesto en uso. Reconocer la raza como una construcción social permite notar el impacto de los estudios ciegos a la raza. Es importante buscar la distinción entre grupos para identificar posibles disparidades que el algoritmo está reforzando. ¿Tiene que evaluar si el algoritmo minimiza los problemas o los mejora?

- Dr. Singh: La raza nunca debe usarse como entrada, pero se puede usar para evaluar las salidas en busca de sesgo. Si no pensáramos en la raza, ni siquiera podríamos decir que hay disparidades en la salud. La recopilación de datos genómicos y la categorización por ascendencia también es una metodología defectuosa. Tenemos que asegurarnos de evaluar si los métodos funcionan bien en todas las poblaciones.

- Dr. Eneanya: Cuando estamos diversificando una población de estudio, debemos alejarnos de solo incorporar grupos de personas blancas o negras. Necesitamos ver más diferencias dentro de estos grupos, como factores como el estatus social, el género, la sexualidad, etc. Necesitamos ver el panorama completo y no solo los conjuntos de datos de diversidad basados en la raza.

- Dr. Moses: Los algoritmos son exactamente el tipo de herramientas que deberían ayudarnos a hacer eso, hay muchas estrategias informáticas potenciales que pueden ayudar.

- Dr. Singh: Estoy de acuerdo en que los algoritmos juegan un papel muy importante aquí, entonces, ¿cómo priorizamos la recopilación de datos? Tenemos que pensar en cómo lo hacemos con mucho cuidado.

Luego, un miembro de la audiencia preguntó: "Dada la gran prisa por desarrollar algoritmos basados en conjuntos de datos actuales con sesgos, ¿hay formas de contrarrestar los sesgos en el algoritmo más allá de deshacerse de los sesgos en el conjunto de datos?"

- Dr. Singh: Es difícil superar el sesgo en un conjunto de datos; es un área activa de investigación. Es fácil sobre o debajo de los datos de muestra. Hay diferentes formas de entrenar modelos ML donde el objetivo general (generalmente una función que intenta minimizar, generalmente usando todo el conjunto de datos) es cómo debería verse la optimización.

- Dr. Eneanya: Se considera que muchos algoritmos médicos necesitan incluir la raza para ser más precisos. Sin embargo, las personas deben examinar críticamente por qué se está introduciendo la raza en primer lugar. Es posible que eliminar la raza como variable no cambie el rendimiento del algoritmo tanto como podría pensar. ¿Significa algo (clínicamente) que los resultados cambien solo un poco después de eliminar una variable como la raza?

- Dr. Singh: Especialmente no significa nada cuando tu conjunto de entrenamiento y el conjunto en el que lo usas son muy diferentes.

El Dr. Siek hizo otra pregunta a los panelistas: "Si pudiéramos hacer esto de nuevo, ¿qué haríamos diferente?"

- Dra. Eneanya: No debería haberse detenido en la raza al evaluar las razones de las diferencias en los resultados de salud. Por ejemplo, con los niveles de creatinina, debemos pensar en qué más puede afectar la creatinina. Necesitamos mejores conjuntos de datos, lo que requiere generar confianza en las comunidades. Esto puede verse como mejorar la diversidad de las poblaciones de prueba, evaluar cómo se ve el personal de su estudio, etc. Las subvenciones del Instituto Nacional de Salud requieren cada vez más socios comunitarios y especialistas en equidad en salud como parte del equipo de investigación. Necesitamos cambiar los sets antiguos, pero también necesitamos construir mejores sets en el futuro. Solo podemos hacer mucho tratando de reconfigurar lo que está ahí fuera.

- Dr. Moses: Más allá de lo que podríamos hacer si reiniciamos, me gusta pensar en los algoritmos como espejos de la sociedad. Son entrenados por todos en Internet. Usando eso como entrada al siguiente nivel del algoritmo, podemos determinar dónde están los sesgos, por qué están ahí y cuál es el impacto futuro. Necesitamos preguntarnos cómo usar estas herramientas cuantitativas para descubrir cómo solucionar estas situaciones en lugar de exacerbarlas.

- Dr. Singh: Muchos de los genomas que se han recolectado no representan a la población en general. Necesitamos comenzar con la participación de diversos conjuntos de personas.

La pregunta final de la audiencia fue: “Hasta que lleguemos a un punto en el que tengamos una imagen genómica completa de todos los humanos, habrá entusiasmo por usar ML y algoritmos. ¿Cuáles son las cosas reales en el nivel de revisión por pares que podemos hacer ahora para no tener que arreglarlas en 30 años?”

- Dr. Eneanya: Lo perfecto es enemigo de lo bueno. Tenemos que hacer lo mejor que podamos. Podemos identificar los sesgos y luego hacer lo mejor que podamos para seguir adelante. Existen barreras que no tienen nada que ver con los algoritmos clínicos. Simplemente arreglar el algoritmo eGFR eliminando la raza no resolverá las disparidades de la enfermedad renal. Es necesario trabajar mucho en los aspectos multivariables de la represión.

- Dr. Moses: El trabajo que usted [Dr. Eneanya] han hecho para rediseñar el algoritmo para que todo sea exactamente cómo avanzar. Tenemos que arreglar el sistema. También usando el hecho de que tenía que arreglarse; era fácil ver el sesgo escrito en la ecuación. La ecuación del riñón sirve como espejo para una sociedad que permitió codificar la raza de una manera que desfavoreció a los afroamericanos durante décadas. El sesgo en esa ecuación fue explícito y deliberado. Será mucho más difícil identificar sesgos en algoritmos más complejos en el futuro.

¡Estén atentos para otro resumen del panel patrocinado por AAAS 2023 CCC!

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://feeds.feedblitz.com/~/733934357/0/cccblog~Health-Equity-How-Can-Algorithms-and-Data-Mitigate-Not-Exacerbate-Harms-AAAS-Panel-Recap/

- :es

- $ UP

- 000

- 1

- 1999

- 2020

- 2021

- 2022

- 2023

- 7

- a

- capacidad

- Poder

- Nuestra Empresa

- de la máquina

- preciso

- Lograr

- adquirir

- adquirido

- a través de

- lector activo

- Adicionales

- Añade

- Adopción

- avanzar

- defendiendo

- afectar

- Africano

- Después

- EDAD

- AI

- AL

- algoritmo

- algorítmico

- algoritmos

- Todos

- permite

- alternativa

- hacerlo

- American

- Estadounidenses

- entre

- cantidad

- análisis

- anatomía

- y

- Otra

- Aparecer

- aplicada

- enfoque

- enfoques

- somos

- Reservada

- áreas

- Arguye

- aire

- arrestos

- artículo

- artista

- AS

- aspectos

- asociado

- asunción

- At

- las ventas

- autor

- Atrás

- fianza

- Prohibición

- barrera

- las barreras

- Béisbol

- basado

- base

- BE

- porque

- comenzó

- "Ser"

- es el beneficio

- beneficios

- MEJOR

- mejores

- entre

- Más allá de

- parcialidad

- se unen

- uniéndose

- biología

- Poco

- Negro

- sangre

- cuerpo

- Bound

- Trayendo

- build

- Construir la

- by

- calculado

- calcula

- PUEDEN

- Cáncer

- Células cancerígenas

- servicios sociales

- estudiar cuidadosamente

- categorizar

- causado

- causas

- ccc

- Células

- Centros

- a ciertos

- retos

- el cambio

- Cambios

- cambio

- características

- clase

- clasificación

- clasificar

- Clínico

- los médicos

- personal

- El cobro

- --

- viniendo

- Algunos

- Comunidades

- basados en la comunidad

- comparar

- en comparación con

- completar

- integraciones

- Complicado

- informática

- Consecuencias

- Considerar

- constantemente

- construir

- consultoría

- contexto

- continuado

- continúa

- control

- Conversación

- derechos de autor,

- La correlación

- podría

- Covid

- creación

- Delito

- Abogados de

- crucial

- crucialmente

- cura

- Current

- En la actualidad

- PELIGRO

- peligroso

- datos

- conjunto de datos

- conjuntos de datos

- conjuntos de datos

- décadas

- Koops

- disminuir

- profundo

- acusados

- Define

- Demanda

- demuestra

- Despliegues

- descrito

- Diseño

- detenciones

- determinación

- Determinar

- determina

- devastador

- desarrollar

- desarrollado

- el desarrollo

- Desarrollo

- dispositivo

- Control de Diabetes

- diferencias

- una experiencia diferente

- diferenciar

- difícil

- directamente

- descuento

- discutido

- discutir

- Enfermedades

- enfermedad

- diverso

- Diversidad

- ADN

- Médico

- No

- dominios

- No

- DE INSCRIPCIÓN

- impulsados

- durante

- e

- cada una

- pasan fácilmente

- comer

- ecosistema

- los efectos

- elaborado

- elegible

- eliminando

- suficientes

- entrado

- entusiasmo

- ambientales

- igualdad

- Equivale

- ecuaciones

- equidad

- especialmente

- esencial

- estimación

- etc.

- Europea

- evaluar

- evaluación

- Incluso

- todos

- exactamente

- ejemplo

- ejemplos

- ejemplifica

- existente

- experience

- explicado

- explicando

- Explica

- Cara

- caras

- facial

- reconocimiento facial

- factores importantes

- FALLO

- Fallidos

- Fracaso

- feria

- falso

- noticias falsas

- Favorecer

- Federal

- Gobierno federal

- realimentación

- hembra

- pocos

- Figura

- final

- Nombre

- cómodo

- Fijar

- fijas

- defectuoso

- Focus

- enfoque

- adelante

- Desde

- ser completados

- función

- promover

- Además

- futuras

- juego

- Género

- obtener

- conseguir

- Donar

- Diezmos y Ofrendas

- globo

- objetivo

- va

- candidato

- buen trabajo

- Gobierno

- gradual

- subvenciones

- Gráfico

- mayores

- Grupo procesos

- Grupo

- Crecer

- pasó

- Difícil

- perjudicial

- daños

- aprovechar

- Tienen

- Salud

- becas de salud

- la salud

- saludable

- alturas

- ayuda

- esta página

- alto riesgo

- más alto

- más alto

- Destacado

- altamente

- históricamente

- historia

- Con optimismo

- hospitales

- Cómo

- Como Hacer

- Sin embargo

- HTTPS

- enorme

- humana

- Humanos

- Hipertensión

- i

- no haber aun identificado una solucion para el problema

- identifica

- Identifique

- identificar

- imagen

- Sistema inmunológico

- Inmunoterapia

- Impacto

- impactados

- Impactos

- discapacidad

- importante

- mejorar

- la mejora de

- in

- En otra

- incorrecto

- incluir

- Incluye

- Incorporado

- aumente

- aumentado

- cada vez más

- increíblemente

- INSTRUMENTO individual

- individuos

- inherente

- Las opciones de entrada

- ejemplo

- Innovadora

- intención

- interactuando

- Internet

- intimidante

- Introducido

- involucra

- la participación de

- cuestiones

- IT

- Enero

- Trabajos

- juez

- Justice

- Guardar

- Clave

- riñón

- large

- mayores

- Lead

- líder

- aprendizaje

- Sobrante

- Nivel

- estilo de vida

- como

- que otros

- LIMITE LAS

- limitaciones

- límites

- Listado

- Mira

- parece

- mirando

- MIRADAS

- Lote

- máquina

- máquina de aprendizaje

- hecho

- gran

- para lograr

- Realizar

- hombre

- manera

- muchos

- Misa

- max-ancho

- significa

- medir

- medidas

- Medios

- servicios

- atención médica

- medicina

- miembro

- Hombre

- Método

- Metodología

- métodos

- México

- podría

- mente

- minimizando

- espejo

- Mitigar las

- mezclado

- ML

- modelos

- modificar

- molecular

- Monetario

- dinero

- más,

- MEJOR DE TU

- movimiento

- avanzar

- emocionante

- Nacional

- Naturaleza

- ¿ Necesita ayuda

- necesidad

- del sistema,

- Nuevo

- noticias

- Next

- normal

- notablemente

- of

- a menudo

- Viejo

- on

- ONE

- Del Mañana

- Oportunidad

- optimización

- solicite

- Organizado

- reconocida por

- Otro

- Resultado

- esbozado

- total

- Superar

- EL DESARROLLADOR

- Oxígeno

- panel

- parte

- socios

- pasado

- paciente

- los pacientes

- pares

- Personas

- percepción

- perfecto

- actuación

- realiza

- quizás

- persona

- con

- Personalizado

- perspectivas

- imagen

- Colocar

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- punto

- políticas

- vigilancia

- pobre

- población

- poblaciones

- posible

- necesidad

- precisamente

- Precisión

- predecir

- predicción

- Predicciones

- presente

- frecuente

- anterior

- Anterior

- priorizar

- prisión

- prisioneros

- problemas

- procedimientos

- en costes

- profesionales

- destacado

- PROMETEMOS

- prometedor

- propuesto

- Proteínas

- Proteínas

- apoderado

- pulso

- poner

- Q&A

- XNUMX% automáticos

- pregunta

- Carrera

- Sesgo racial

- racismo

- Tarifas

- más bien

- real

- mundo real

- Realidad

- razones

- resumen

- recepción

- reciente

- reconocimiento

- reconocido

- archivos

- reducir

- registro

- reforzarse

- ,

- liberado

- remove

- Remoto

- la eliminación de

- reemplazar

- representar

- representa

- Requisitos

- requiere

- la investigación

- investigador

- investigadores

- respuesta

- renovadas

- límite

- resultado

- Resultados

- género

- Revela

- marcha atrás

- una estrategia SEO para aparecer en las búsquedas de Google.

- Eliminar

- Riesgo

- factores de riesgo

- Función

- prisa

- mismo

- Escuela

- científico

- Científico

- los científicos

- ve

- Secuencia

- Serum

- sirve

- Sesión

- set

- Sets

- grave

- compartir

- tienes

- Mostrar

- mostrado

- Shows

- significativamente

- similares

- circunstancias

- Piel

- So

- Social

- Sociedades

- Software

- RESOLVER

- algo

- Alguien

- algo

- especialistas

- especificado

- gastado

- Staff

- comienzo

- Comience a

- Zonas

- estadístico

- Estado

- paso

- STONE

- parada

- sencillo

- estrategias

- calle

- estrés

- fuerte

- estructural

- Luchando

- estudios

- ESTUDIO

- sujeto

- tal

- Sugiere

- superior

- SOPORTE

- te

- sistémico

- Todas las funciones a su disposición

- ¡Prepárate!

- toma

- Target

- afectados

- equipo

- términos

- test

- Pruebas

- esa

- La

- El futuro de las

- su

- Les

- por lo tanto

- Estas

- cosas

- miles

- equipo

- a

- hoy

- demasiado

- tema

- Entrenar

- entrenado

- Formación

- transparente

- del mismo día

- juicio

- verdadero

- Confía en

- tipos

- típicamente

- Finalmente, a veces

- descubrir

- bajo

- apuntalamientos

- entender

- United

- Estados Unidos

- Universal

- universidad

- imprevisible

- us

- Uso

- utilizan el

- generalmente

- VALIDAR

- variedad

- Versus

- Vulnerable

- Camino..

- formas

- WELL

- ¿

- Que es

- que

- mientras

- complejo de salvador blanco

- QUIENES

- todo

- seguirá

- dentro de

- sin

- Mujeres

- Actividades:

- funciona

- se

- escrito

- años

- Usted

- Younger

- tú

- zephyrnet