En el panorama actual de la inteligencia artificial en rápida evolución, los modelos de aprendizaje profundo se han encontrado a la vanguardia de la innovación, con aplicaciones que abarcan visión por computadora (CV), procesamiento del lenguaje natural (NLP) y sistemas de recomendación. Sin embargo, el costo creciente asociado con la capacitación y el ajuste de estos modelos plantea un desafío para las empresas. Este costo se debe principalmente al gran volumen de datos utilizados en el entrenamiento de modelos de aprendizaje profundo. Hoy en día, los modelos grandes suelen entrenarse con terabytes de datos y pueden tardar semanas en entrenarse, incluso con GPU o GPU potentes. tren de AWS-hardware basado en. Normalmente, los clientes confían en técnicas y optimizaciones que mejoran la eficiencia del ciclo de entrenamiento de un modelo, como núcleos o capas optimizados, entrenamiento de precisión mixto o características como la Amazon SageMaker Bibliotecas de formación distribuidas. Sin embargo, hoy en día se presta menos atención a la eficiencia de los datos de entrenamiento en sí. No todos los datos contribuyen por igual al proceso de aprendizaje durante el entrenamiento del modelo: una proporción significativa de los recursos computacionales puede gastarse en procesar ejemplos simples que no contribuyen sustancialmente a la precisión general del modelo.

Los clientes tradicionalmente han confiado en técnicas de preprocesamiento como el muestreo ascendente o descendente y la deduplicación para refinar y mejorar la calidad de la información de sus datos. Estas técnicas pueden ayudar, pero a menudo requieren mucho tiempo, experiencia especializada en ciencia de datos y, en ocasiones, pueden ser más un arte que una ciencia. Los clientes a menudo también confían en conjuntos de datos seleccionados, como Web refinada, para mejorar el rendimiento de sus modelos; sin embargo, estos conjuntos de datos no siempre son de código abierto y, a menudo, tienen un propósito más general y no están relacionados con su caso de uso específico.

¿De qué otra manera se puede superar esta ineficiencia relacionada con muestras de datos con poca información durante el entrenamiento del modelo?

Nos complace anunciar una vista previa pública del tamizado inteligente, una nueva capacidad de SageMaker que puede reducir el costo de entrenar modelos de aprendizaje profundo hasta en un 35 %. El tamizado inteligente es una nueva técnica de eficiencia de datos que analiza activamente sus muestras de datos durante el entrenamiento y filtra las muestras que son menos informativas para el modelo. Al entrenar en un subconjunto más pequeño de datos con solo las muestras que más contribuyen a la convergencia del modelo, el entrenamiento total y el costo disminuyen con un impacto mínimo o nulo en la precisión. Además, debido a que la función funciona en línea durante el entrenamiento del modelo, el filtrado inteligente no requiere cambios en los datos ascendentes ni en el proceso de entrenamiento descendente.

En esta publicación, tratamos los siguientes temas:

- La nueva capacidad de tamizado inteligente en SageMaker y cómo funciona

- Cómo utilizar el tamizado inteligente con cargas de trabajo de capacitación de PyTorch

También puede consultar nuestra documentación y cuadernos de muestra para obtener recursos adicionales sobre cómo comenzar con el tamizado inteligente.

Cómo funciona el tamizado inteligente de SageMaker

Comenzamos esta publicación con una descripción general de cómo la capacidad de filtrado inteligente puede acelerar el entrenamiento de su modelo en SageMaker.

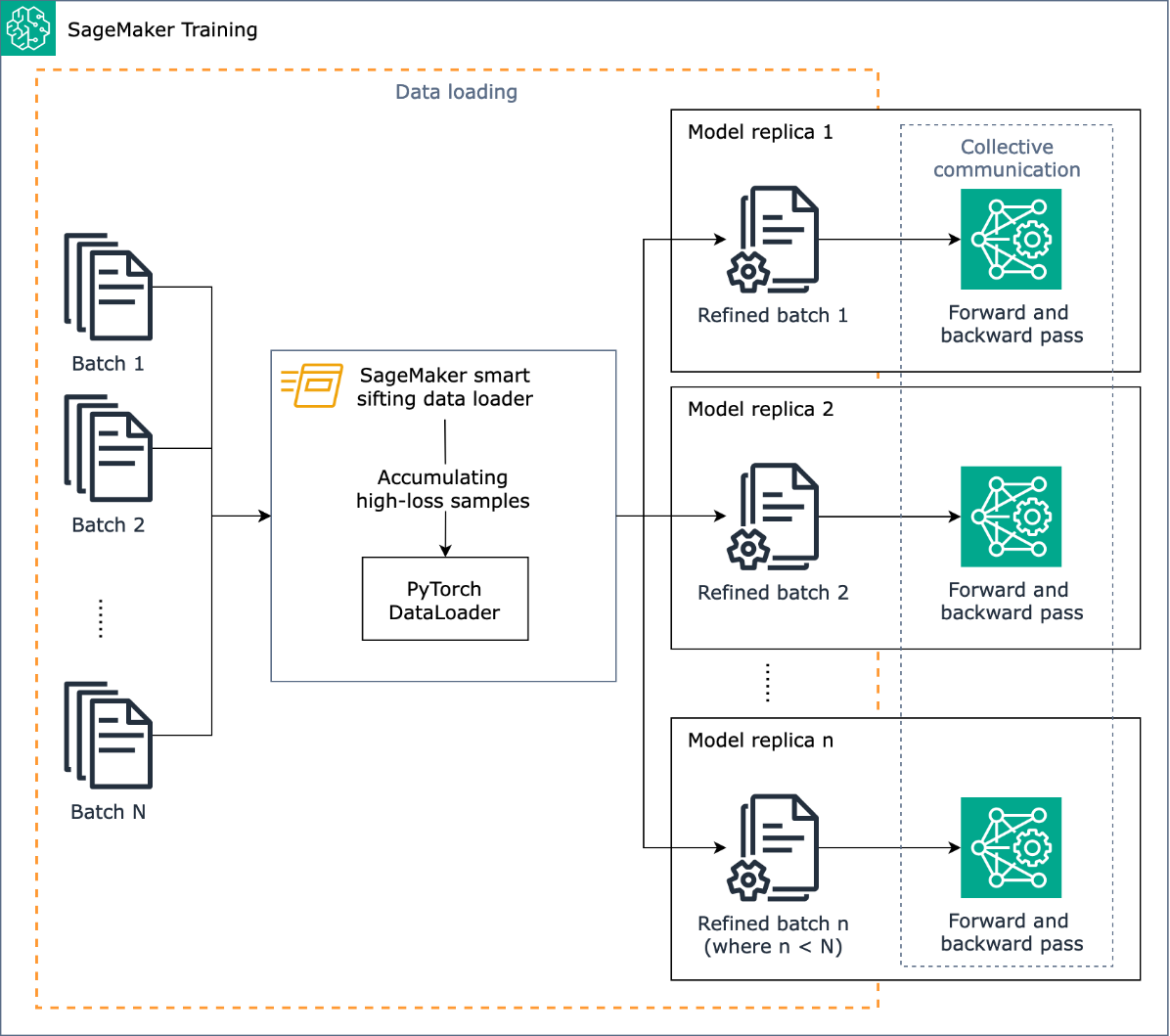

La tarea del filtrado inteligente es examinar los datos de entrenamiento durante el proceso de entrenamiento y solo alimentar el modelo con las muestras más informativas. Durante un entrenamiento típico con PyTorch, los datos se envían iterativamente en lotes al bucle de entrenamiento y a los dispositivos aceleradores (por ejemplo, GPU o chips Trainium) por parte del Cargador de datos PyTorch. El filtrado inteligente se implementa en esta etapa de carga de datos y, por lo tanto, es independiente de cualquier preprocesamiento de datos ascendente en su proceso de capacitación.

El tamizado inteligente utiliza su modelo y una función de pérdida especificada por el usuario para realizar un avance evaluativo de cada muestra de datos a medida que se carga. Las muestras con altas pérdidas afectarán materialmente el entrenamiento del modelo y, por lo tanto, se utilizan en el entrenamiento; las muestras de datos que tienen pérdidas relativamente bajas se apartan y se excluyen del entrenamiento.

Un dato clave para el filtrado inteligente es la proporción de datos que se excluirán: por ejemplo, al establecer la proporción en 33 % (valor_beta=0.5), las muestras que se encuentren aproximadamente en el tercio inferior de la pérdida de cada lote se excluirán del entrenamiento. Cuando se han identificado suficientes muestras con altas pérdidas para completar un lote, los datos se envían a través del ciclo de entrenamiento completo y el modelo aprende y se entrena normalmente. No es necesario realizar ningún cambio en su ciclo de entrenamiento cuando la selección inteligente está habilitada.

El siguiente diagrama ilustra este flujo de trabajo.

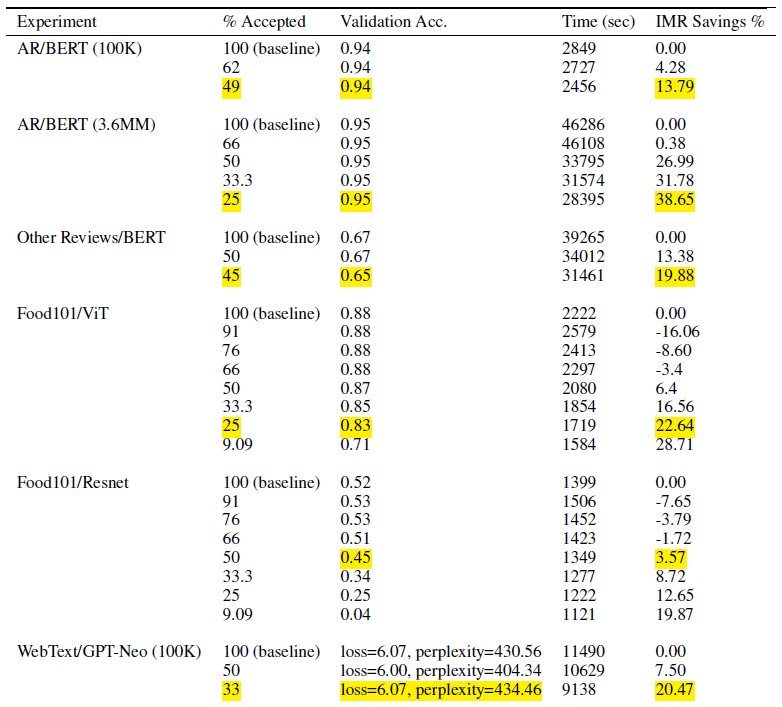

Al incluir solo un subconjunto de sus datos de entrenamiento, el filtrado inteligente reduce el tiempo y los cálculos necesarios para entrenar el modelo. En nuestras pruebas, logramos una reducción de hasta casi el 40 % en el tiempo y el costo total de capacitación. Con una selección inteligente de datos, el impacto en la precisión del modelo puede ser mínimo o nulo porque las muestras excluidas tuvieron pérdidas relativamente bajas para el modelo. En la siguiente tabla, incluimos un conjunto de resultados experimentales que demuestran la mejora posible del rendimiento con el tamizado inteligente de SageMaker.

En la tabla, la columna % aceptado indica la proporción de datos que se incluyen y utilizan en el ciclo de entrenamiento. Aumentar este parámetro ajustable disminuye el costo (como se demuestra en la columna % de ahorro de IMR), pero también puede afectar la precisión. La configuración adecuada para % aceptado es una función de su conjunto de datos y modelo; debe experimentar y ajustar este parámetro para lograr el mejor equilibrio entre costo reducido e impacto en la precisión.

Resumen de la solución

En las siguientes secciones, analizamos un ejemplo práctico de cómo habilitar el filtrado inteligente con un trabajo de capacitación de PyTorch en SageMaker. Si desea comenzar rápidamente, puede saltar a la Ejemplos de PyTorch o PyTorch Lightning.

Requisitos previos

Suponemos que ya sabe cómo entrenar un modelo usando PyTorch o PyTorch Lightning usando el SDK de Python de SageMaker y la clase Estimator usando los contenedores de aprendizaje profundo de SageMaker para el entrenamiento. Si no, consulte Uso del SDK de Python de SageMaker Antes de continuar.

Comience con el tamizado inteligente de SageMaker

En un trabajo típico de capacitación de PyTorch, usted inicializa el proceso de capacitación de PyTorch. cargador de datos con su conjunto de datos y otros parámetros requeridos, que proporciona lotes de entrada a medida que avanza la capacitación. Para permitir el filtrado inteligente de tus datos de entrenamiento, utilizarás un nuevo DataLoader clase: smart_sifting.dataloader.sift_dataloader.SiftingDataloader. Esta clase se utiliza como contenedor encima de su PyTorch existente. DataLoader y el proceso de formación utilizará en su lugar SiftingDataloader para obtener lotes de entrada. El SiftingDataLoader obtiene el lote de entrada de su PyTorch original DataLoader, evalúa la importancia de las muestras en el lote y construye un lote tamizado con muestras de alta pérdida, que luego pasan al paso de capacitación. El contenedor se parece al siguiente código:

La SiftingDataloader requiere algunos parámetros adicionales para analizar sus datos de entrenamiento, que puede especificar a través del sift_config parámetro. Primero, crea un smart_sifting.sift_config.sift_configs.RelativeProbabilisticSiftConfig objeto. Este objeto contiene los parámetros configurables y requeridos. beta_value y loss_history_length, que definen respectivamente la proporción de muestras que se conservarán y la ventana de muestras que se incluirán al evaluar la pérdida relativa. Tenga en cuenta que, debido a que el filtrado inteligente utiliza su modelo para definir la importancia de la muestra, puede haber implicaciones negativas si utilizamos un modelo con ponderaciones completamente aleatorias. En su lugar, puedes utilizar loss_based_sift_config y sift_delay para retrasar el proceso de filtrado hasta que los pesos de los parámetros en el modelo se actualicen más allá de los valores aleatorios. (Para más detalles, consulte Aplique un filtrado inteligente a su guión de entrenamiento.) En el siguiente código, definimos sift_config y especificar beta_value y loss_history_length, así como retrasar el inicio del tamizado utilizando loss_based_sift_config:

A continuación, también debes incluir un loss_impl parámetro en el SiftingDataloader objeto. El filtrado inteligente funciona a nivel de muestra individual y es crucial tener acceso a un método de cálculo de pérdidas para determinar la importancia de la muestra. Debe implementar un método de pérdida por tamizado que devuelva un tensor nx1, que contenga valores de pérdida de n muestras. Normalmente, usted especifica el mismo método de pérdida utilizado por su model durante el entrenamiento. Finalmente, incluya un puntero a su modelo en el SiftingDataloader objeto, que se utiliza para evaluar muestras antes de incluirlas en el entrenamiento. Vea el siguiente código:

El siguiente código muestra un ejemplo completo de cómo habilitar el filtrado inteligente con un trabajo de capacitación BERT existente:

Conclusión

En esta publicación, exploramos la vista previa pública del tamizado inteligente, una nueva capacidad de SageMaker que puede reducir los costos de capacitación del modelo de aprendizaje profundo hasta en un 35 %. Esta característica mejora la eficiencia de los datos durante el entrenamiento y filtra muestras de datos menos informativas. Al incluir solo los datos más impactantes para la convergencia de modelos, puede reducir significativamente el tiempo y los gastos de capacitación, manteniendo al mismo tiempo la precisión. Es más, se integra perfectamente en sus procesos existentes sin necesidad de modificar sus datos o su proceso de capacitación.

Para profundizar en el filtrado inteligente de SageMaker, explorar cómo funciona e implementarlo con cargas de trabajo de capacitación de PyTorch, consulte nuestra documentación y cuadernos de muestra y comience con esta nueva capacidad.

Sobre los autores

Roberto Van Dusen es gerente senior de productos en Amazon SageMaker. Lidera marcos, compiladores y técnicas de optimización para la capacitación en aprendizaje profundo.

Roberto Van Dusen es gerente senior de productos en Amazon SageMaker. Lidera marcos, compiladores y técnicas de optimización para la capacitación en aprendizaje profundo.

K. Lokesh Kumar Reddy es ingeniero sénior en el equipo de IA aplicada de Amazon. Se centra en técnicas eficientes de capacitación en aprendizaje automático y en la creación de herramientas para mejorar los sistemas de inteligencia artificial conversacional. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse actualizado con las últimas tendencias tecnológicas.

K. Lokesh Kumar Reddy es ingeniero sénior en el equipo de IA aplicada de Amazon. Se centra en técnicas eficientes de capacitación en aprendizaje automático y en la creación de herramientas para mejorar los sistemas de inteligencia artificial conversacional. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse actualizado con las últimas tendencias tecnológicas.

Abhishek Dan Es gerente de desarrollo senior en el equipo de IA aplicada de Amazon y trabaja en sistemas de inteligencia artificial conversacional y aprendizaje automático. Le apasionan las tecnologías de IA y trabaja en la intersección de la ciencia y la ingeniería para mejorar las capacidades de los sistemas de IA para crear interacciones entre humanos y computadoras más intuitivas y fluidas. Actualmente está creando aplicaciones en grandes modelos de lenguaje para impulsar la eficiencia y mejoras de CX para Amazon.

Abhishek Dan Es gerente de desarrollo senior en el equipo de IA aplicada de Amazon y trabaja en sistemas de inteligencia artificial conversacional y aprendizaje automático. Le apasionan las tecnologías de IA y trabaja en la intersección de la ciencia y la ingeniería para mejorar las capacidades de los sistemas de IA para crear interacciones entre humanos y computadoras más intuitivas y fluidas. Actualmente está creando aplicaciones en grandes modelos de lenguaje para impulsar la eficiencia y mejoras de CX para Amazon.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/accelerate-deep-learning-model-training-up-to-35-with-amazon-sagemaker-smart-sifting/

- :es

- :no

- $ UP

- 100

- 125

- 13

- 14

- 23

- 25

- 35%

- 7

- a

- Nuestra Empresa

- acelerar

- acelerador

- aceptado

- de la máquina

- la exactitud

- Lograr

- alcanzado

- activamente

- add

- Adicionales

- Adicionalmente

- seguir

- afectar

- AI

- Sistemas de IA

- Todos

- ya haya utilizado

- también

- alteraciones

- hacerlo

- Amazon

- Amazon SageMaker

- Amazon Web Services

- an

- analizar

- análisis

- y

- Anunciar

- cualquier

- aplicaciones

- aplicada

- IA aplicada

- adecuado

- aproximadamente

- somos

- Arte

- artificial

- inteligencia artificial

- AS

- aparte

- asociado

- asumir

- At

- AWS

- Balance

- BE

- porque

- esto

- antes

- comenzar

- MEJOR

- entre

- Más allá de

- Fondo

- Construir la

- pero

- by

- calcular

- cálculo

- PUEDEN

- capacidades

- capacidad

- case

- Reto

- Cambios

- comprobar

- Papas fritas

- clase

- código

- Columna

- completar

- completamente

- cálculo

- computational

- Calcular

- computadora

- Visión por computador

- construcciones

- consumidor

- Contenedores

- continuo

- contribuir

- contribuye

- Convergencia

- conversacional

- AI conversacional

- Cost

- Precio

- Para crear

- crucial

- comisariada

- En la actualidad

- Clientes

- CX

- datos

- Ciencia de los datos

- conjuntos de datos

- Fecha

- disminuye

- profundo

- deep learning

- más profundo

- definir

- definir

- retrasar

- demostrado

- vas demostrando

- detalles

- Determinar

- Dev

- dispositivo

- Dispositivos

- discutir

- distribuidos

- entrenamiento distribuido

- inmersión

- do

- No

- No

- el lado de la transmisión

- impulsados

- durante

- cada una

- eficiencia

- eficiente

- más

- habilitar

- facilita

- permitiendo

- ingeniero

- Ingeniería

- suficientes

- empresas

- igualmente

- evaluar

- evaluación

- Incluso

- evolución

- ejemplo

- ejemplos

- excitado

- excluidos

- existente

- experience

- Experiencias

- experimento

- experimental

- explorar

- explorado

- Feature

- Caracteristicas

- filtros

- Finalmente

- Nombre

- Focus

- centrado

- siguiendo

- primer plano

- adelante

- encontrado

- marcos

- Desde

- ser completados

- completamente

- función

- General

- obtener

- GPU

- GPU

- Materiales

- Tienen

- he

- ayuda

- su

- mantiene

- Cómo

- Como Hacer

- Sin embargo

- HTML

- HTTPS

- no haber aun identificado una solucion para el problema

- if

- ilustra

- Impacto

- impactante

- implementar

- implementado

- implicaciones

- importar

- importancia

- mejorar

- es la mejora continua

- mejoras

- mejora

- in

- incluir

- incluido

- Incluye

- creciente

- independientes

- Indica

- INSTRUMENTO individual

- ineficacia

- información

- informativo

- Innovation

- Las opciones de entrada

- Integra

- Intelligence

- interacciones

- intersección

- dentro

- intuitivo

- IT

- sí mismo

- Trabajos

- jpg

- saltar

- Guardar

- Clave

- Saber

- Kumar

- paisaje

- idioma

- large

- más reciente

- ponedoras

- Prospectos

- aprendizaje

- aprende

- menos

- Nivel

- bibliotecas

- relámpago

- como

- carga

- lógica

- MIRADAS

- de

- máquina

- máquina de aprendizaje

- Mantener los

- para lograr

- gerente

- materialmente

- Puede..

- Método

- mínimo

- mezclado

- ML

- modelo

- modelos

- Módulo

- más,

- MEJOR DE TU

- debe

- Natural

- Procesamiento natural del lenguaje

- hace casi

- ¿ Necesita ayuda

- negativas

- Nuevo

- nlp

- no

- Ninguna

- normalmente

- nota

- objeto

- of

- a menudo

- on

- en línea

- , solamente

- habiertos

- de código abierto

- opera

- optimización

- optimizado

- or

- reconocida por

- Otro

- "nuestr

- salir

- salidas

- total

- Superar

- visión de conjunto

- parámetro

- parámetros

- pass

- pasado

- apasionado

- para

- actuación

- industrial

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plantea

- posible

- Publicación

- poderoso

- Metodología

- Precisión

- Vista previa

- las cuales

- en costes

- tratamiento

- Producto

- gerente de producto

- proporción

- proporciona un

- público

- propósito

- Python

- piñón

- calidad

- con rapidez

- azar

- rápidamente

- Recomendación

- reducir

- Reducción

- reduce

- reducción

- remitir

- FILTRO

- relacionado

- relativo

- relativamente

- confiar

- exigir

- Requisitos

- requiere

- Recursos

- respectivamente

- RESTO

- Resultados

- volvemos

- devoluciones

- sabio

- mismo

- Ahorros

- Ciencia:

- Sdk

- sin costura

- sin problemas

- (secciones)

- ver

- la búsqueda de

- AUTO

- mayor

- expedido

- Servicios

- set

- pólipo

- tienes

- Shows

- Tamizar

- importante

- significativamente

- sencillos

- menores

- inteligente

- algo

- a veces

- Fuente

- abarcando

- especializado

- soluciones y

- gastado

- Etapa

- comienzo

- fundó

- quedarse

- paso

- sustancialmente

- tal

- Todas las funciones a su disposición

- mesa

- ¡Prepárate!

- Tarea

- equipo

- la técnica

- técnicas

- Tecnologías

- Tecnología

- pruebas

- que

- esa

- La

- la información

- su

- sí mismos

- luego

- Ahí.

- por lo tanto

- Estas

- ellos

- Código

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- a

- hoy

- de hoy

- parte superior

- Temas

- antorcha

- Total

- tradicionalmente

- Entrenar

- entrenado

- Formación

- trenes

- Tendencias

- melodía

- principiante

- típicamente

- hasta

- actualizado

- Datos aguas arriba

- utilizan el

- caso de uso

- usado

- usos

- usando

- Valores

- vía

- visión

- volumen

- caminar

- quieres

- we

- web

- servicios web

- Semanas

- WELL

- tuvieron

- cuando

- que

- mientras

- seguirá

- ventana

- sin

- flujo de trabajo

- funciona

- Usted

- tú

- zephyrnet