El seguimiento ocular, la capacidad de medir de manera rápida y precisa la dirección en la que mira un usuario mientras está dentro de un auricular VR, a menudo se habla en el contexto de la representación foveada y cómo podría reducir los requisitos de rendimiento de los auriculares XR. Y si bien el renderizado foveado es un caso de uso emocionante para el seguimiento ocular en los auriculares AR y VR, el seguimiento ocular trae mucho más a la mesa.

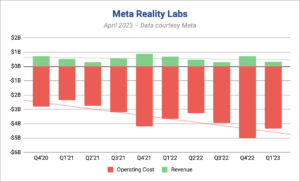

Actualizado – 2 de mayo de 2023

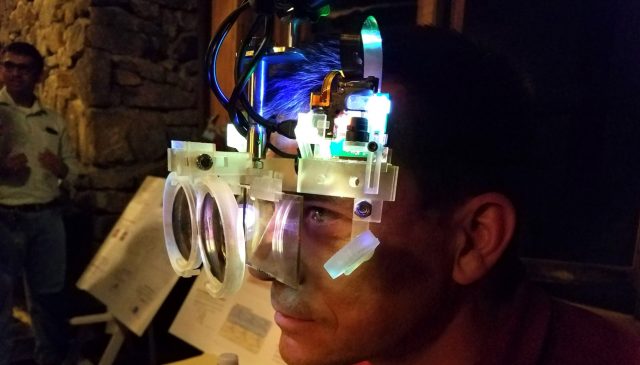

Se ha hablado sobre el seguimiento ocular con respecto a XR como una tecnología distante durante muchos años, pero el hardware finalmente está cada vez más disponible para desarrolladores y clientes. PSVR 2 y Quest Pro son los ejemplos más visibles de auriculares con seguimiento ocular incorporado, junto con Varjo Aero, Vive Pro Eye y más.

Con este impulso, en solo unos años podríamos ver que el seguimiento ocular se convierte en una parte estándar de los auriculares XR de consumo. Cuando eso sucede, hay una amplia gama de características que la tecnología puede habilitar para mejorar drásticamente la experiencia.

Representación foveada

Comencemos primero con el que muchas personas ya conocen. El renderizado Foveated tiene como objetivo reducir la potencia computacional requerida para mostrar escenas exigentes de AR y VR. El nombre proviene de la 'fóvea', un pequeño hoyo en el centro de la retina humana que está densamente lleno de fotorreceptores. Es la fóvea la que nos da una visión de alta resolución en el centro de nuestro campo de visión; mientras tanto, nuestra visión periférica es en realidad muy pobre para captar detalles y colores, y está mejor sintonizada para detectar movimiento y contraste que para ver detalles. Puede pensar en ella como una cámara que tiene un sensor grande con solo unos pocos megapíxeles y otro sensor más pequeño en el medio con muchos megapíxeles.

La región de su visión en la que puede ver con gran detalle es en realidad mucho más pequeña de lo que la mayoría piensa: solo unos pocos grados en el centro de su vista. La diferencia en el poder de resolución entre la fóvea y el resto de la retina es tan drástica, que sin tu fóvea, no podrías distinguir el texto de esta página. Puedes ver esto fácilmente por ti mismo: si mantienes tus ojos enfocados en así palabra e intente leer solo dos oraciones a continuación, encontrará que es casi imposible distinguir lo que dicen las palabras, aunque puede ver algo palabras parecidas. La razón por la que las personas sobrestiman la región foveal de su visión parece ser que el cerebro hace muchas interpretaciones y predicciones inconscientes para construir un modelo de cómo creemos que es el mundo.

El renderizado foveado tiene como objetivo explotar esta peculiaridad de nuestra visión al representar la escena virtual en alta resolución solo en la región que ve la fóvea, y luego reducir drásticamente la complejidad de la escena en nuestra visión periférica donde el detalle no se puede resolver de todos modos. . Hacerlo nos permite concentrar la mayor parte del poder de procesamiento donde contribuye más a los detalles, mientras ahorramos recursos de procesamiento en otros lugares. Puede que no parezca un gran problema, pero a medida que aumenta la resolución de pantalla de los auriculares XR y el campo de visión, la potencia necesaria para renderizar escenas complejas crece rápidamente.

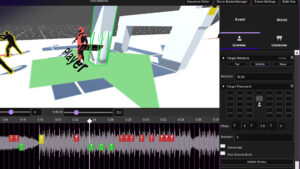

El seguimiento ocular, por supuesto, entra en juego porque necesitamos saber dónde está el centro de la mirada del usuario en todo momento de forma rápida y con alta precisión para lograr una representación foveada. Si bien es difícil lograr esto sin que el usuario se dé cuenta, es posible y se ha demostrado con bastante eficacia en auriculares recientes como Quest Pro y PSVR 2.

Detección y ajuste automático de usuarios

![]()

Además de detectar movimiento, el seguimiento ocular también se puede utilizar como identificador biométrico. Eso hace que el seguimiento ocular sea un gran candidato para múltiples perfiles de usuario en un solo auricular: cuando me pongo el auricular, el sistema puede identificarme instantáneamente como un usuario único y recuperar mi entorno personalizado, biblioteca de contenido, progreso del juego y configuraciones. Cuando un amigo se pone los auriculares, el sistema puede cargar su preferencias y datos guardados.

El seguimiento ocular también se puede utilizar para medir con precisión la IPD (la distancia entre los ojos). Conocer su IPD es importante en XR porque es necesario mover las lentes y las pantallas a la posición óptima tanto para la comodidad como para la calidad visual. Lamentablemente, es comprensible que muchas personas no sepan cuál es su IPD.

Con el seguimiento ocular, sería fácil medir instantáneamente el IPD de cada usuario y luego hacer que el software del auricular ayude al usuario a ajustar el IPD del auricular para que coincida, o advertir a los usuarios que su IPD está fuera del rango admitido por el auricular.

En los visores más avanzados, este proceso puede ser invisible y automático: el IPD se puede medir de forma invisible y el visor puede tener un ajuste de IPD motorizado que mueve automáticamente las lentes a la posición correcta sin que el usuario tenga que darse cuenta de nada, como en el Varjo Aero, por ejemplo.

Pantallas varifocales

Los sistemas ópticos que se utilizan en los cascos de realidad virtual actuales funcionan bastante bien, pero en realidad son bastante simples y no admiten una función importante de la visión humana: el enfoque dinámico. Esto se debe a que la pantalla de los auriculares XR siempre está a la misma distancia de nuestros ojos, incluso cuando la profundidad estereoscópica sugiere lo contrario. Esto conduce a un problema llamado conflicto de acomodación de vergencia. Si desea aprender un poco más en profundidad, consulte nuestro manual a continuación:

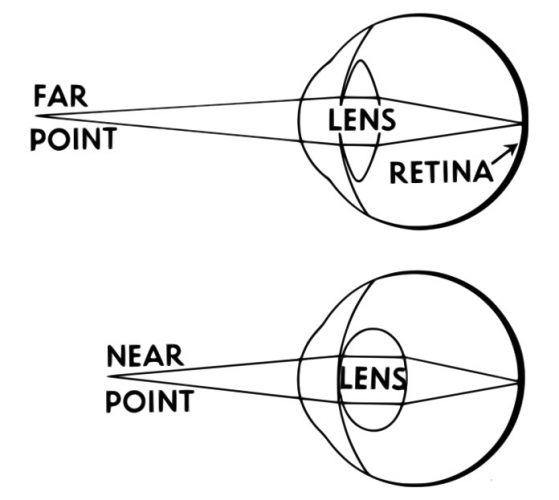

Alojamiento

En el mundo real, para enfocar un objeto cercano, el cristalino de su ojo se dobla para hacer que la luz del objeto llegue al punto correcto en su retina, brindándole una vista nítida del objeto. Para un objeto que está más lejos, la luz viaja en diferentes ángulos hacia su ojo y la lente nuevamente debe doblarse para garantizar que la luz se enfoque en su retina. Por eso, si cierras un ojo y enfocas tu dedo a unos centímetros de tu cara, el mundo detrás de tu dedo es borroso. Por el contrario, si te enfocas en el mundo detrás de tu dedo, tu dedo se vuelve borroso. Esto se llama alojamiento.

vergencia

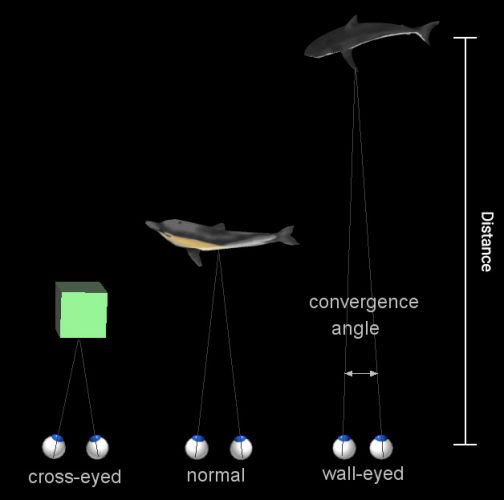

Luego está la convergencia, que es cuando cada uno de sus ojos gira hacia adentro para "convergir" las vistas separadas de cada ojo en una imagen superpuesta. Para objetos muy distantes, sus ojos son casi paralelos, porque la distancia entre ellos es muy pequeña en comparación con la distancia del objeto (lo que significa que cada ojo ve una porción casi idéntica del objeto). Para objetos muy cercanos, sus ojos deben rotar hacia adentro para alinear la perspectiva de cada ojo. Puedes ver esto también con nuestro truco del dedo meñique como el anterior: esta vez, usando ambos ojos, mantén el dedo a unos centímetros de tu cara y míralo. Observe que ve imágenes dobles de objetos muy por detrás de su dedo. Cuando enfoca esos objetos detrás de su dedo, ahora ve una imagen de dos dedos.

El conflicto

Con instrumentos lo suficientemente precisos, puede usar la vergencia o la acomodación para saber qué tan lejos está un objeto que está mirando una persona. Pero la cosa es que tanto la acomodación como la vergencia ocurren juntas en tu ojo, automáticamente. Y no ocurren al mismo tiempo: existe una correlación directa entre la vergencia y la acomodación, de modo que para cualquier medida dada de vergencia, hay un nivel de acomodación directamente correspondiente (y viceversa). Desde que eras un bebé, tu cerebro y tus ojos han formado memoria muscular para hacer que estas dos cosas sucedan juntas, sin pensar, cualquiertiempo que miras cualquier cosa.

Pero cuando se trata de la mayoría de los auriculares AR y VR actuales, la convergencia y la acomodación no están sincronizadas debido a las limitaciones inherentes del diseño óptico.

En un auricular AR o VR básico, hay una pantalla (que está, digamos, a 3″ de su ojo) que muestra la escena virtual y una lente que enfoca la luz de la pantalla en su ojo (al igual que la lente en su ojo normalmente enfocaría la luz del mundo en su retina). Pero dado que la pantalla está a una distancia estática de su ojo y la forma de la lente es estática, la luz que proviene de todos los objetos que se muestran en esa pantalla provienen de la misma distancia. Entonces, incluso si hay una montaña virtual a cinco millas de distancia y una taza de café en una mesa a cinco pulgadas de distancia, la luz de ambos objetos ingresa al ojo en el mismo ángulo (lo que significa que su acomodación, la flexión de la lente en su ojo, nunca cambia ).

Eso entra en conflicto con la vergencia en esos auriculares que, debido a que podemos mostrar una imagen diferente a cada ojo,is variable. Ser capaz de ajustar la imagen de forma independiente para cada ojo, de modo que nuestros ojos necesiten converger en objetos a diferentes profundidades, es esencialmente lo que proporciona la estereoscopia de los auriculares AR y VR de hoy.

Pero la pantalla más realista (y posiblemente la más cómoda) que podríamos crear eliminaría el problema de la acomodación de la vergencia y permitiría que los dos funcionaran sincronizados, tal como estamos acostumbrados en el mundo real.

Las pantallas varifocales, aquellas que pueden alterar dinámicamente su profundidad focal, se proponen como una solución a este problema. Hay una serie de enfoques para las pantallas varifocales, quizás el más simple de los cuales es un sistema óptico en el que la pantalla se mueve físicamente hacia adelante y hacia atrás desde la lente para cambiar la profundidad focal sobre la marcha.

Lograr una pantalla varifocal accionada de este tipo requiere seguimiento ocular porque el sistema necesita saber con precisión en qué parte de la escena está mirando el usuario. Al trazar un camino hacia la escena virtual desde cada uno de los ojos del usuario, el sistema puede encontrar el punto de intersección de esos caminos, estableciendo el plano focal adecuado que el usuario está mirando. Luego, esta información se envía a la pantalla para que se ajuste en consecuencia, configurando la profundidad focal para que coincida con la distancia virtual desde el ojo del usuario hasta el objeto.

Una pantalla varifocal bien implementada no solo podría eliminar el conflicto de convergencia y acomodación, sino que también permitiría a los usuarios enfocarse en objetos virtuales mucho más cerca de ellos que en los auriculares existentes.

Y mucho antes de que coloquemos pantallas varifocales en los auriculares XR, el seguimiento ocular podría usarse para simular la profundidad de campo, lo que podría aproximarse a la borrosidad de los objetos fuera del plano focal de los ojos del usuario.

A partir de ahora, no hay auriculares importantes en el mercado con capacidades varifocales, pero hay una creciente cuerpo de investigación y desarrollo tratando de descubrir cómo hacer que la capacidad sea compacta, confiable y asequible.

Pantallas foveadas

Si bien el renderizado foveado tiene como objetivo distribuir mejor el poder de renderizado entre la parte de nuestra visión donde podemos ver con nitidez y nuestra visión periférica de bajo detalle, se puede lograr algo similar para el recuento real de píxeles.

En lugar de simplemente cambiar el detalle de la representación en ciertas partes de la pantalla frente a otras, las pantallas móviles son aquellas que se mueven físicamente (o, en algunos casos, se "dirigen") para permanecer frente a la mirada del usuario sin importar dónde mire.

Las pantallas foveadas abren la puerta para lograr una resolución mucho más alta en los auriculares AR y VR sin forzar el problema al intentar abarrotar píxeles a una resolución más alta en todo nuestro campo de visión. Hacerlo no solo es costoso, sino que también enfrenta restricciones desafiantes de potencia y tamaño a medida que la cantidad de píxeles se acerca a la resolución de la retina. En cambio, las pantallas foveadas moverían una pantalla más pequeña y densa en píxeles a donde sea que el usuario esté mirando en función de los datos de seguimiento ocular. Este enfoque podría incluso conducir a campos de visión más altos que los que se podrían lograr con una sola pantalla plana.

Varjo es una empresa que trabaja en un sistema de visualización foveado. Utilizan una pantalla típica que cubre un amplio campo de visión (pero no es muy densa en píxeles) y luego superponen una micropantalla que es mucho más densa en píxeles encima. La combinación de los dos significa que el usuario obtiene un amplio campo de visión para su visión periférica y una región de muy alta resolución para su visión foveal.

De acuerdo, esta pantalla foveada sigue siendo estática (el área de alta resolución permanece en el medio de la pantalla) en lugar de dinámica, pero la empresa ha consideró una serie de métodos para mover la pantalla para garantizar que el área de alta resolución esté siempre en el centro de su mirada.

Continúa en la página 2: Mejores avatares sociales »

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Fuente: https://www.roadtovr.com/why-eye-tracking-is-a-game-changer-for-vr-headsets-virtual-reality/

- :posee

- :es

- :no

- :dónde

- $ UP

- 23

- 500

- 7

- 70

- a

- capacidad

- Poder

- Nuestra Empresa

- arriba

- en consecuencia

- alcanzado

- el logro de

- a través de

- adición

- del Riesgo

- avanzado

- asequible

- de nuevo

- en contra

- paquete de capacitación DWoVH

- alineado

- alineación

- Todos

- permitir

- permite

- a lo largo de

- ya haya utilizado

- también

- hacerlo

- an

- y

- Otra

- cualquier

- enfoque

- enfoques

- AR

- somos

- Reservada

- AS

- ayudar

- At

- automáticamente

- Hoy Disponibles

- lejos

- Bebé

- Atrás

- basado

- básica

- BE

- porque

- a las que has recomendado

- se convierte en

- cada vez

- esto

- antes

- detrás de

- "Ser"

- CREEMOS

- a continuación

- mejores

- entre

- Más allá de

- biométrico

- Poco

- cuerpo

- ambas

- Cerebro

- llevar

- build

- incorporado

- pero

- by

- llamar al

- , que son

- cámara

- PUEDEN

- candidato

- capacidades

- cases

- Reubicación

- a ciertos

- desafiante

- el cambio

- Cambiador

- Cambios

- cambio

- comprobar

- Cerrar

- CAFÉ

- Color

- combinación

- proviene

- la comodidad

- cómodo

- viniendo

- compañía

- comparación

- integraciones

- complejidad

- potencia de cálculo

- el conflicto

- restricciones

- consumidor

- contenido

- contexto

- contraste

- converger

- correcta

- La correlación

- Correspondiente

- podría

- Curso

- Cubiertas

- Para crear

- Vaso

- Clientes

- se adaptan

- Corte

- datos

- acuerdo

- exigente

- demostrado

- profundidad

- Profundidades

- Diseño

- detalle

- Detección

- desarrolladores

- un cambio

- una experiencia diferente

- difícil

- de reservas

- dirección

- directamente

- Pantalla

- distancia

- distribuir

- sí

- "Hacer"

- No

- Puerta

- doble

- DE INSCRIPCIÓN

- drásticamente,

- dos

- lugar de trabajo dinámico

- dinamicamente

- cada una

- pasan fácilmente

- de forma sencilla

- de manera eficaz

- ya sea

- eliminarlos

- en otra parte

- habilitar

- suficientes

- garantizar

- Entra en

- Todo

- Entorno

- esencialmente

- el establecimiento

- Incluso

- ejemplo

- ejemplos

- emocionante

- existente

- experience

- Explotar

- ojos

- Ojos

- Cara

- familiar

- muchos

- Caracteristicas

- pocos

- campo

- Figura

- Finalmente

- Encuentre

- dedo

- Nombre

- plano

- Focus

- centrado

- se centra

- formado

- adelante

- renderizado foveat

- Amigo

- Desde

- frontal o trasero

- función

- promover

- juego

- cambio de juego

- dado

- da

- Diezmos y Ofrendas

- Va

- maravillosa

- crece

- suceder

- que sucede

- Materiales

- Tienen

- cabeza

- Dirección

- auriculares

- Alta

- más alto

- Golpear

- mantener

- Cómo

- Como Hacer

- HTTPS

- enorme

- humana

- i

- idéntico

- identificador

- Identifique

- if

- imagen

- imágenes

- imagen

- implementado

- importante

- imposible

- mejorar

- in

- Los aumentos

- cada vez más

- independientemente

- información

- inherente

- instantáneamente

- instrumentos

- Automática

- dentro

- IT

- jpg

- solo

- Guardar

- Saber

- large

- mayores

- Lead

- Prospectos

- APRENDE:

- lentes

- menos

- dejar

- Nivel

- Biblioteca

- luz

- como

- Me gusta

- limitaciones

- pequeño

- carga

- Mira

- mirando

- MIRADAS

- Lote

- gran

- para lograr

- HACE

- muchos

- muchas personas

- Mercado

- Match

- Materia

- max-ancho

- Puede..

- sentido

- significa

- Mientras tanto

- medir

- Salud Cerebral

- métodos

- Ed. Media

- modelo

- Momentum

- más,

- MEJOR DE TU

- movimiento

- Montaña

- movimiento

- movimiento

- se mueve

- emocionante

- mucho más

- múltiples

- debe

- nombre

- Cerca

- hace casi

- ¿ Necesita ayuda

- necesidad

- red

- no

- normalmente

- Aviso..

- ahora

- número

- objeto

- objetos

- of

- off

- a menudo

- on

- ONE

- , solamente

- habiertos

- óptimo

- or

- solicite

- Otros

- de otra manera

- nuestros

- salir

- afuera

- llena

- página

- Paralelo

- parte

- partes

- camino

- Pearson

- Personas

- actuación

- quizás

- persona

- la perspectiva

- Físicamente

- PIT

- pixel

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- punto

- pobre

- parte

- posición

- posible

- industria

- necesidad

- precisamente

- Precisión

- predicción

- preferencias

- bastante

- Pro

- Problema

- tratamiento

- Poder de procesamiento

- Perfiles

- Progreso

- apropiado

- propuesto

- prototipo

- pSVR

- PSVR 2

- poner

- Pone

- Poniendo

- calidad

- búsqueda

- búsqueda profesional

- con rapidez

- distancia

- más bien

- Leer

- real

- mundo real

- realista

- razón

- reciente

- reducir

- Saludos

- región

- confianza

- representación

- Requisitos

- Requisitos

- requiere

- la investigación

- parecido a

- Resolución

- resuelto

- resolver

- Recursos

- RESTO

- retina

- carretera

- Camino a la realidad virtual

- mismo

- ahorro

- dices

- escena

- Escenas

- ver

- ver

- parece

- ve

- separado

- pólipo

- ajustes

- Forma

- Compartir

- agudo

- Mostrar

- mostrado

- Shows

- similares

- sencillos

- desde

- soltero

- Tamaño

- chica

- menores

- So

- Social

- Software

- a medida

- algo

- algo

- Aislamiento de Sonido

- Spot

- punteo

- estándar

- es la

- comienzo

- quedarse

- Sin embargo

- tal

- Sugiere

- SOPORTE

- Soportado

- te

- Todas las funciones a su disposición

- mesa

- tecnología

- Tecnología

- que

- esa

- El

- el mundo

- su

- Les

- luego

- Estas

- ellos

- cosa

- cosas

- pensar

- Ideas

- así

- aquellos

- ¿aunque?

- equipo

- veces

- a

- de hoy

- juntos

- demasiado

- parte superior

- Rastreo

- Viajar

- dos

- principiante

- Comprensiblemente

- Desafortunadamente

- único

- us

- utilizan el

- usado

- Usuario

- usuarios

- usando

- varjo

- versión

- muy

- Ver

- vistas

- Virtual

- visibles

- visión

- vidas

- vr

- Auriculares VR

- auriculares VR

- vs

- quieres

- we

- WELL

- tuvieron

- ¿

- cuando

- que

- mientras

- porque

- amplio

- Amplia gama

- dentro de

- sin

- Palabra

- palabras

- Actividades:

- trabajando

- mundo

- se

- XR

- Auriculares XR

- años

- Usted

- tú

- a ti mismo

- zephyrnet