Seleccionar objetos separados en una escena visual nos parece intuitivo, pero las máquinas luchan con esta tarea. Ahora, un nuevo modelo de IA de Meta ha desarrollado una idea amplia de lo que es un objeto, lo que le permite separar objetos incluso si nunca antes los había visto.

Puede parecer una tarea de visión por computadora bastante prosaica, pero ser capaz de analizar una imagen y determinar dónde termina un objeto y comienza otro es una habilidad bastante fundamental, sin la cual una gran cantidad de tareas más complicadas serían irresolubles.

La "segmentación de objetos" no es nada nuevo; Los investigadores de IA han trabajado en ello durante años. Pero, por lo general, la construcción de estos modelos ha sido un proceso lento que requiere mucha anotación humana de imágenes y recursos informáticos considerables. Y, por lo general, los modelos resultantes estaban altamente especializados para casos de uso particulares.

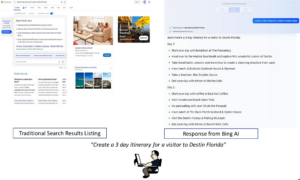

Ahora, sin embargo, los investigadores de Meta han presentado el Segment Anything Model (SAM), que puede cortar cualquier objeto en cualquier escena, independientemente de si se ha visto algo así antes. El modelo también puede hacer esto en respuesta a una variedad de indicaciones diferentes, desde la descripción del texto hasta los clics del mouse o incluso los datos de seguimiento ocular.

“SAM ha aprendido una noción general de qué son los objetos y puede generar máscaras para cualquier objeto en cualquier imagen o video”, escribieron los investigadores en un blog post. “Creemos que las posibilidades son amplias y estamos entusiasmados con los muchos casos de uso potenciales que ni siquiera hemos imaginado todavía”.

La clave para el desarrollo del modelo fue un nuevo conjunto de datos masivo de 1.1 millones de máscaras de segmentación, que se refiere a regiones de una imagen que han sido aisladas y anotadas para indicar que contienen un objeto en particular. Fue creado a través de una combinación de anotación humana manual de imágenes y procesos automatizados, y es, con mucho, la colección más grande de este tipo reunida hasta la fecha.

Al entrenar en un conjunto de datos tan masivo, los investigadores de Meta dicen que ha desarrollado un concepto general de lo que es un objeto, lo que le permite segmentar cosas que ni siquiera ha visto antes. Esta capacidad de generalizar llevó a los investigadores a denominar SAM como un "modelo básico", un término controvertido se utiliza para describir otros modelos masivos pre-entrenados como GPT de Open AI serie, cuyas capacidades son supuestamente tan generales que pueden usarse como base para una gran cantidad de aplicaciones.

La segmentación de imágenes es definitivamente un ingrediente clave en una amplia gama de tareas de visión artificial. Si no puede separar los diferentes componentes de una escena, es difícil hacer algo más complicado con ella. En su blog, los investigadores dicen que podría resultar invaluable en la edición de videos e imágenes, o ayudar con el análisis de imágenes científicas.

Quizás más pertinente para las ambiciones de metaverso de la compañía, brindan una demostración de cómo podría usarse junto con un casco de realidad virtual para seleccionar objetos específicos en función de la mirada del usuario. También dicen que potencialmente podría combinarse con un modelo de lenguaje grande para crear un sistema multimodal capaz de comprender tanto el contenido visual como el textual de una página web.

La capacidad de manejar una amplia gama de avisos hace que el sistema sea particularmente flexible. en un página web Al hacer una demostración del nuevo modelo, la compañía muestra que después de analizar una imagen, se le puede pedir que separe objetos específicos simplemente haciendo clic en ellos con el cursor del mouse, escribiendo qué es lo que desea segmentar o simplemente dividiendo la imagen completa en objetos separados.

Y lo que es más importante, la empresa está abriendo tanto el modelo como el conjunto de datos con fines de investigación para que otros puedan desarrollar su trabajo. Este es el mismo enfoque que adoptó la empresa con su modelo de lenguaje grande LLaMA, que lo llevó a ser rápidamente filtrado en línea y estimulando un ola de experimentación por aficionados y piratas informáticos.

Queda por ver si sucederá lo mismo con SAM, pero de cualquier manera es un regalo para la comunidad de investigación de IA que podría acelerar el progreso en una serie de problemas importantes de visión por computadora.

Crédito de la imagen: Meta IA

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :es

- $ UP

- 1

- a

- capacidad

- Poder

- acelerar

- Después

- AI

- ai investigación

- Permitir

- permite

- ambiciones

- análisis

- el análisis de

- y

- Otra

- aplicaciones

- enfoque

- somos

- AS

- ensamblada

- At

- Confirmación de Viaje

- basado

- BE

- antes

- "Ser"

- CREEMOS

- mil millones

- Blog

- Ruptura

- general

- build

- Construir la

- by

- PUEDEN

- capacidades

- cases

- --

- combinación

- vibrante e inclusiva

- compañía

- De la empresa

- Complicado

- componentes

- computadora

- Visión por computador

- informática

- concepto

- considerable

- que no contengo

- contenido

- podría

- Para crear

- creado

- crédito

- Corte

- datos

- Fecha

- acuerdo

- que probar definitivamente

- describir

- descripción

- desarrollado

- Desarrollo

- una experiencia diferente

- ya sea

- termina

- Todo

- Incluso

- excitado

- bastante

- flexible

- Fundamentos

- Desde

- fundamental

- General

- generar

- donación

- los piratas informáticos

- suceder

- Difícil

- Tienen

- Dirección

- ayuda

- altamente

- fortaleza

- Cómo

- HTTPS

- humana

- idea

- imagen

- imágenes

- importante

- in

- intuitivo

- inestimable

- aislado

- IT

- SUS

- Clave

- idioma

- large

- mayor

- aprendido

- LED

- como

- Llama

- Máquinas

- HACE

- manual

- muchos

- Mascarillas

- masivo

- Meta

- Metaverso

- podría

- modelo

- modelos

- más,

- MEJOR DE TU

- Nuevo

- Noción

- objeto

- objetos

- of

- on

- ONE

- Otro

- Otros

- página

- emparejado

- particular

- particularmente

- recoger

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- POSIBILIDADES

- posible

- la posibilidad

- bastante

- problemas

- en costes

- Progreso

- Demostrar.

- proporcionar

- fines

- distancia

- rápidamente

- Realidad

- se refiere

- Independientemente

- regiones

- permanece

- la investigación

- investigadores

- Recursos

- respuesta

- resultante

- Diana

- mismo

- escena

- científico

- parece

- segmento

- segmentación

- separado

- Serie

- Shows

- simplemente

- habilidad

- So

- especializado

- soluciones y

- Luchar

- tal

- te

- Tarea

- tareas

- esa

- La

- su

- Les

- Estas

- cosas

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- prolongado

- a

- Formación

- típicamente

- entender

- dio a conocer

- us

- utilizan el

- variedad

- Video

- Virtual

- Realidad virtual

- visión

- Camino..

- web

- ¿

- sean

- que

- amplio

- Amplia gama

- seguirá

- sin

- Actividades:

- rutina de ejercicio

- trabajado

- se

- años

- Usted

- zephyrnet