El aprendizaje automático (ML) ha mejorado los negocios en todas las industrias en los últimos años, desde el sistema de recomendación en su Prime Video cuenta, para documentar resúmenes y búsqueda eficiente con AlexaAsistencia de voz. Sin embargo, queda la pregunta de cómo incorporar esta tecnología a su negocio. A diferencia de los métodos tradicionales basados en reglas, ML infiere automáticamente patrones a partir de los datos para realizar su tarea de interés. Aunque esto evita la necesidad de seleccionar reglas para la automatización, también significa que los modelos de ML solo pueden ser tan buenos como los datos en los que están entrenados. Sin embargo, la creación de datos suele ser una tarea desafiante. En el Laboratorio de soluciones de aprendizaje automático de Amazon, nos hemos encontrado repetidamente con este problema y queremos facilitar este viaje para nuestros clientes. Si desea descargar este proceso, puede utilizar Amazon SageMaker Tierra Verdad Plus.

Al final de esta publicación, podrá lograr lo siguiente:

- Comprender los procesos comerciales involucrados en la configuración de una canalización de adquisición de datos

- Identifique los servicios en la nube de AWS para respaldar y agilizar su proceso de etiquetado de datos

- Ejecute una tarea de adquisición y etiquetado de datos para casos de uso personalizados

- Cree datos de alta calidad siguiendo las mejores prácticas comerciales y técnicas

A lo largo de esta publicación, nos enfocamos en el proceso de creación de datos y confiamos en los servicios de AWS para manejar la infraestructura y los componentes del proceso. Es decir, usamos Verdad fundamental de Amazon SageMaker para manejar la canalización de la infraestructura de etiquetado y la interfaz de usuario. Este servicio utiliza un enfoque point-and-go para recopilar sus datos de Servicio de almacenamiento simple de Amazon (Amazon S3) y configure un flujo de trabajo de etiquetado. Para el etiquetado, le proporciona la flexibilidad integrada para adquirir etiquetas de datos utilizando su equipo privado, un Amazon Mechanical Turk fuerza, o su proveedor de etiquetado preferido de AWS Marketplace. Por último, puede utilizar AWS Lambda y Portátiles Amazon SageMaker para procesar, visualizar o controlar la calidad de los datos, ya sea antes o después del etiquetado.

Ahora que se han colocado todas las piezas, ¡comencemos el proceso!

El proceso de creación de datos.

Contrariamente a la intuición común, el primer paso para la creación de datos no es la recopilación de datos. Trabajar hacia atrás desde los usuarios para articular el problema es crucial. Por ejemplo, ¿qué les importa a los usuarios en el artefacto final? ¿Dónde creen los expertos que residen las señales relevantes para el caso de uso en los datos? ¿Qué información sobre el entorno del caso de uso podría proporcionarse al modelo? Si no sabe las respuestas a esas preguntas, no se preocupe. Tómese un tiempo para hablar con los usuarios y expertos en el campo para comprender los matices. Esta comprensión inicial lo orientará en la dirección correcta y lo preparará para el éxito.

Para esta publicación, asumimos que ha cubierto este proceso inicial de especificación de requisitos del usuario. Las siguientes tres secciones lo guían a través del proceso posterior de creación de datos de calidad: planificación, creación de datos de origen y anotación de datos. Los bucles piloto en los pasos de creación y anotación de datos son vitales para garantizar la creación eficiente de datos etiquetados. Esto implica iterar entre la creación de datos, la anotación, el control de calidad y la actualización de la canalización según sea necesario.

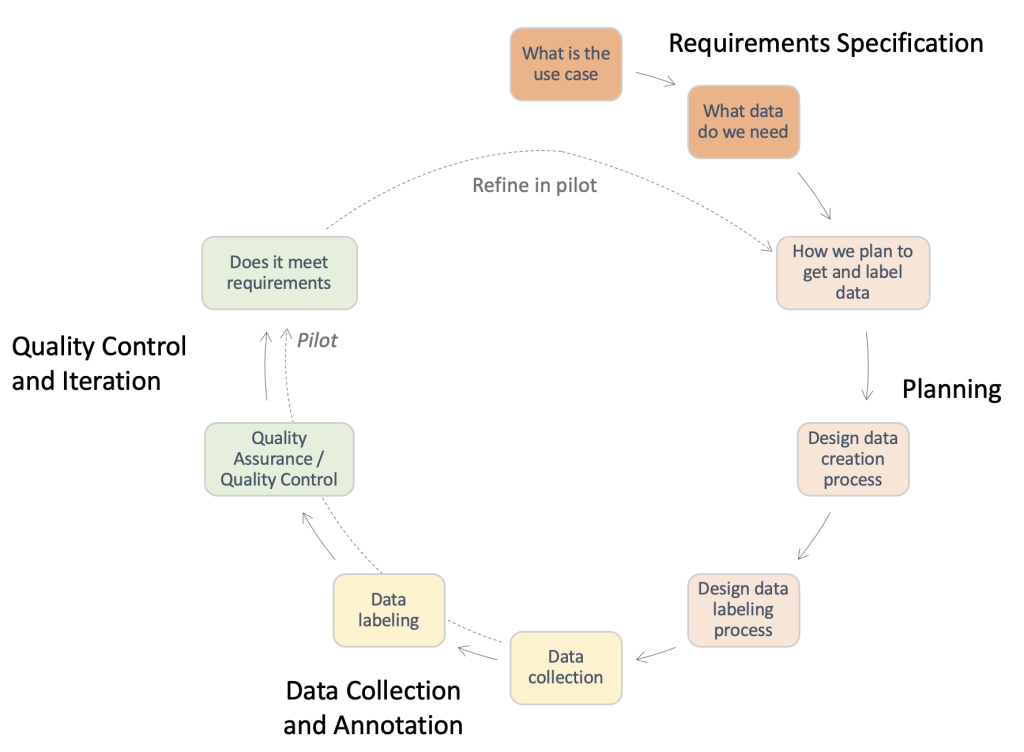

La siguiente figura proporciona una descripción general de los pasos necesarios en una canalización típica de creación de datos. Puede trabajar hacia atrás desde el caso de uso para identificar los datos que necesita (Especificación de requisitos), crear un proceso para obtener los datos (Planificación), implementar el proceso de adquisición de datos real (Recopilación y anotación de datos) y evaluar los resultados. Las ejecuciones piloto, resaltadas con líneas discontinuas, le permiten iterar en el proceso hasta que se haya desarrollado una canalización de adquisición de datos de alta calidad.

Descripción general de los pasos necesarios en una canalización típica de creación de datos.

Planificación

Un proceso de creación de datos estándar puede llevar mucho tiempo y una pérdida de valiosos recursos humanos si se lleva a cabo de manera ineficiente. ¿Por qué llevaría mucho tiempo? Para responder a esta pregunta, debemos comprender el alcance del proceso de creación de datos. Para ayudarlo, hemos recopilado una lista de verificación de alto nivel y una descripción de los componentes clave y las partes interesadas que debe tener en cuenta. Responder a estas preguntas puede ser difícil al principio. Dependiendo de su caso de uso, solo algunos de estos pueden ser aplicables.

- Identificar el punto de contacto legal para las aprobaciones requeridas – El uso de datos para su aplicación puede requerir una licencia o una revisión del contrato del proveedor para garantizar el cumplimiento de las políticas de la empresa y los casos de uso. Es importante identificar su respaldo legal a lo largo de los pasos del proceso de adquisición y anotación de datos.

- Identificar el punto de contacto de seguridad para el manejo de datos –La fuga de datos comprados puede resultar en multas graves y repercusiones para su empresa. Es importante identificar su soporte de seguridad a lo largo de los pasos de adquisición y anotación de datos para garantizar prácticas seguras.

- Detallar los requisitos de los casos de uso y definir los datos de origen y las pautas de anotación – Crear y anotar datos es difícil debido a la alta especificidad requerida. Las partes interesadas, incluidos los generadores de datos y los anotadores, deben estar completamente alineados para evitar el desperdicio de recursos. Con este fin, es una práctica común usar un documento de pautas que especifique todos los aspectos de la tarea de anotación: instrucciones exactas, casos límite, un tutorial de ejemplo, etc.

- Alinearse con las expectativas para recopilar sus datos de origen - Considera lo siguiente:

- Llevar a cabo investigaciones sobre posibles fuentes de datos. – Por ejemplo, conjuntos de datos públicos, conjuntos de datos existentes de otros equipos internos, datos recopilados por ellos mismos o comprados a proveedores.

- Realizar evaluación de calidad. – Crear un canal de análisis con relación al caso de uso final.

- Alinearse con las expectativas para crear anotaciones de datos - Considera lo siguiente:

- Identificar a los interesados técnicos – Suele ser una persona o un equipo de su empresa capaz de utilizar la documentación técnica relativa a Ground Truth para implementar una canalización de anotaciones. Estas partes interesadas también son responsables de la evaluación de la calidad de los datos anotados para asegurarse de que cumplan con las necesidades de su aplicación de aprendizaje automático posterior.

- Identificar los anotadores de datos – Estas personas usan instrucciones predeterminadas para agregar etiquetas a sus datos de origen dentro de Ground Truth. Es posible que deban poseer conocimientos de dominio según su caso de uso y las pautas de anotación. Puede utilizar una mano de obra interna de su empresa o pagar por un mano de obra gestionada por un proveedor externo.

- Garantizar la supervisión del proceso de creación de datos. – Como puede ver en los puntos anteriores, la creación de datos es un proceso detallado que involucra a numerosas partes interesadas especializadas. Por lo tanto, es crucial monitorearlo de principio a fin para lograr el resultado deseado. Tener una persona o equipo dedicado a supervisar el proceso puede ayudarlo a garantizar un proceso de creación de datos cohesivo y eficiente.

Dependiendo de la ruta que decidas tomar, también debes considerar lo siguiente:

- Crear el conjunto de datos de origen – Esto se refiere a instancias en las que los datos existentes no son adecuados para la tarea en cuestión, o las restricciones legales le impiden usarlos. Se deben utilizar equipos internos o proveedores externos (siguiente punto). Este suele ser el caso de dominios altamente especializados o áreas con poca investigación pública. Por ejemplo, las preguntas comunes de un médico, la colocación de prendas o los expertos en deportes. Puede ser interno o externo.

- Investigar proveedores y realizar un proceso de incorporación. – Cuando se utilicen proveedores externos, se debe establecer un proceso de contratación e incorporación entre ambas entidades.

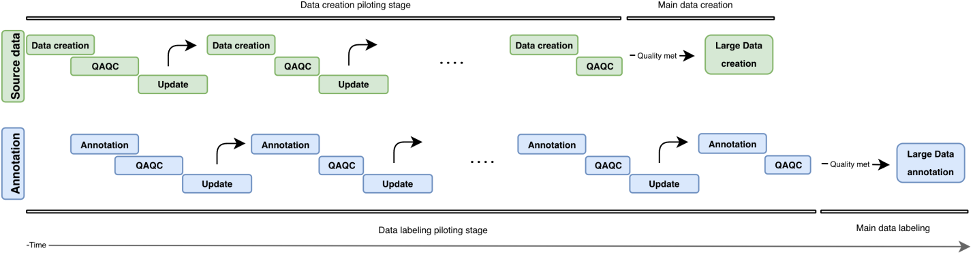

En esta sección, revisamos los componentes y partes interesadas que debemos considerar. Sin embargo, ¿cómo es el proceso real? En la siguiente figura, describimos un flujo de trabajo de proceso para la creación y anotación de datos. El enfoque iterativo utiliza pequeños lotes de datos llamados pilotos para reducir el tiempo de respuesta, detectar errores desde el principio y evitar el desperdicio de recursos en la creación de datos de baja calidad. Describimos estas rondas piloto más adelante en esta publicación. También cubrimos algunas mejores prácticas para la creación, anotación y control de calidad de datos.

La siguiente figura ilustra el desarrollo iterativo de una canalización de creación de datos. Verticalmente, encontramos el bloque de fuente de datos (verde) y el bloque de anotación (azul). Ambos bloques tienen rondas piloto independientes (Creación/anotación de datos, QAQC y actualización). Se crean datos de origen cada vez más altos y se pueden utilizar para construir anotaciones de calidad cada vez más alta.

Descripción general del desarrollo iterativo en una canalización de creación de datos.

Creación de datos de origen

El proceso de creación de entradas gira en torno a la puesta en escena de sus elementos de interés, que dependen de su tipo de tarea. Estos pueden ser imágenes (escaneos de periódicos), videos (escenas de tráfico), nubes de puntos 3D (escaneos médicos) o simplemente texto (pistas de subtítulos, transcripciones). En general, al organizar los elementos relacionados con la tarea, asegúrese de lo siguiente:

- Reflejar el caso de uso del mundo real para el eventual sistema AI/ML – La configuración para recopilar imágenes o videos para sus datos de entrenamiento debe coincidir estrechamente con la configuración de sus datos de entrada en la aplicación del mundo real. Esto significa tener superficies de ubicación, fuentes de iluminación o ángulos de cámara consistentes.

- Tener en cuenta y minimizar las fuentes de variabilidad - Considera lo siguiente:

- Desarrollar las mejores prácticas para mantener los estándares de recopilación de datos. – Dependiendo de la granularidad de su caso de uso, es posible que deba especificar requisitos para garantizar la coherencia entre sus puntos de datos. Por ejemplo, si está recopilando datos de imágenes o videos de puntos de una sola cámara, es posible que deba asegurarse de que sus objetos de interés estén colocados de manera consistente o que requiera una verificación de calidad de la cámara antes de una ronda de captura de datos. Esto puede evitar problemas como la inclinación o el desenfoque de la cámara, y minimizar los gastos indirectos posteriores, como la eliminación de imágenes borrosas o fuera de marco, así como la necesidad de centrar manualmente el marco de la imagen en su área de interés.

- Anticiparse a las fuentes de variabilidad del tiempo de prueba – Si anticipa variabilidad en cualquiera de los atributos mencionados hasta ahora durante el tiempo de prueba, asegúrese de poder capturar esas fuentes de variabilidad durante la creación de datos de entrenamiento. Por ejemplo, si espera que su aplicación ML funcione en varias configuraciones de luz diferentes, debe intentar crear imágenes y videos de capacitación en varias configuraciones de luz. Dependiendo del caso de uso, la variabilidad en el posicionamiento de la cámara también puede influir en la calidad de sus etiquetas.

- Incorporar conocimiento previo del dominio cuando esté disponible - Considera lo siguiente:

- Entradas sobre fuentes de error – Los profesionales del dominio pueden proporcionar información sobre las fuentes de error en función de sus años de experiencia. Pueden proporcionar comentarios sobre las mejores prácticas para los dos puntos anteriores: ¿Qué configuraciones reflejan mejor el caso de uso del mundo real? ¿Cuáles son las posibles fuentes de variabilidad durante la recopilación de datos o en el momento de su uso?

- Mejores prácticas de recopilación de datos específicos del dominio – Si bien es posible que sus partes interesadas técnicas ya tengan una buena idea de los aspectos técnicos en los que centrarse en las imágenes o videos recopilados, los profesionales del dominio pueden proporcionar comentarios sobre la mejor manera de organizar o recopilar los datos de manera que se satisfagan estas necesidades.

Control de calidad y aseguramiento de la calidad de los datos creados.

Ahora que ha configurado la canalización de recopilación de datos, puede ser tentador continuar y recopilar la mayor cantidad de datos posible. ¡Espera un minuto! Primero debemos verificar si los datos recopilados a través de la configuración son adecuados para su caso de uso real. Podemos usar algunas muestras iniciales y mejorar iterativamente la configuración a través de los conocimientos que obtuvimos al analizar esos datos de muestra. Trabaje en estrecha colaboración con sus partes interesadas técnicas, comerciales y de anotación durante el proceso piloto. Esto asegurará que su canalización resultante satisfaga las necesidades comerciales mientras genera datos etiquetados listos para ML con gastos generales mínimos.

Anotaciones

La anotación de entradas es donde agregamos el toque mágico a nuestros datos: ¡las etiquetas! Según el tipo de tarea y el proceso de creación de datos, es posible que necesite anotadores manuales o puede usar métodos automatizados listos para usar. La canalización de anotación de datos en sí misma puede ser una tarea técnicamente desafiante. Ground Truth facilita este viaje para sus partes interesadas técnicas con su repertorio incorporado de flujos de trabajo de etiquetado para fuentes de datos comunes. Con unos pocos pasos adicionales, también le permite crear flujos de trabajo de etiquetado personalizado más allá de las opciones preconfiguradas.

Hágase las siguientes preguntas cuando desarrolle un flujo de trabajo de anotación adecuado:

- ¿Necesito un proceso de anotación manual para mis datos? En algunos casos, los servicios de etiquetado automatizado pueden ser suficientes para la tarea en cuestión. Revisar la documentación y las herramientas disponibles puede ayudarlo a identificar si la anotación manual es necesaria para su caso de uso (para obtener más información, consulte ¿Qué es el etiquetado de datos?). El proceso de creación de datos puede permitir varios niveles de control con respecto a la granularidad de su anotación de datos. Dependiendo de este proceso, a veces también puede omitir la necesidad de una anotación manual. Para obtener más información, consulte Cree un conjunto de datos de preguntas y respuestas personalizado con Amazon SageMaker Ground Truth para entrenar un modelo NLU de preguntas y respuestas Hugging Face.

- ¿Qué forma mi verdad fundamental? En la mayoría de los casos, la verdad básica vendrá de su proceso de anotación, ¡ese es el punto! En otros, el usuario puede tener acceso a etiquetas de verdad en tierra. Esto puede acelerar significativamente su proceso de control de calidad o reducir la sobrecarga requerida para múltiples anotaciones manuales.

- ¿Cuál es el límite superior para la cantidad de desviación de mi estado de verdad fundamental? Trabaje con sus usuarios finales para comprender los errores típicos en torno a estas etiquetas, las fuentes de dichos errores y la reducción deseada de errores. Esto lo ayudará a identificar qué aspectos de la tarea de etiquetado son más desafiantes o es probable que tengan errores de anotación.

- ¿Existen reglas preexistentes utilizadas por los usuarios o profesionales de campo para etiquetar estos artículos? Use y perfeccione estas pautas para crear un conjunto de instrucciones para sus anotadores manuales.

Prueba piloto del proceso de anotación de entrada

Al probar el proceso de anotación de entrada, tenga en cuenta lo siguiente:

- Revise las instrucciones con los anotadores y los profesionales de campo. – Las instrucciones deben ser concisas y específicas. Solicite comentarios de sus usuarios (¿Son precisas las instrucciones? ¿Podemos revisar las instrucciones para asegurarnos de que sean comprensibles para los profesionales que no son de campo?) y anotadores (¿Es todo comprensible? ¿Está clara la tarea?). Si es posible, agregue un ejemplo de datos etiquetados buenos y malos para ayudar a sus anotadores a identificar lo que se espera y cómo podrían ser los errores de etiquetado comunes.

- Recopilar datos para anotaciones – Revise los datos con su cliente para asegurarse de que cumplan con los estándares esperados y para alinearse con los resultados esperados de la anotación manual.

- Proporcione ejemplos a su grupo de anotadores manuales como una ejecución de prueba – ¿Cuál es la variación típica entre los anotadores en este conjunto de ejemplos? Estudie la variación de cada anotación dentro de una imagen dada para identificar las tendencias de consistencia entre los anotadores. Luego compare las variaciones entre las imágenes o los cuadros de video para identificar qué etiquetas son difíciles de colocar.

Control de calidad de las anotaciones

El control de calidad de las anotaciones tiene dos componentes principales: evaluar la coherencia entre los anotadores y evaluar la calidad de las propias anotaciones.

Puede asignar varios anotadores a la misma tarea (por ejemplo, tres anotadores etiquetan los puntos clave en la misma imagen) y medir el valor promedio junto con la desviación estándar de estas etiquetas entre los anotadores. Hacerlo lo ayuda a identificar cualquier anotación atípica (etiqueta incorrecta utilizada o etiqueta alejada de la anotación promedio), lo que puede guiar los resultados procesables, como refinar sus instrucciones o brindar capacitación adicional a ciertos anotadores.

La evaluación de la calidad de las anotaciones en sí está ligada a la variabilidad del anotador y (cuando está disponible) a la disponibilidad de expertos en el dominio o información veraz sobre el terreno. ¿Hay ciertas etiquetas (en todas sus imágenes) donde la variación promedio entre los anotadores es consistentemente alta? ¿Alguna etiqueta está muy lejos de sus expectativas de dónde deberían estar o cómo deberían verse?

Según nuestra experiencia, un bucle de control de calidad típico para la anotación de datos puede verse así:

- Repita las instrucciones o la puesta en escena de la imagen en función de los resultados de la ejecución de la prueba – ¿Hay objetos ocluidos o la puesta en escena de la imagen no coincide con las expectativas de los anotadores o usuarios? ¿Son engañosas las instrucciones o se saltó alguna etiqueta o error común en las imágenes de sus ejemplares? ¿Puede refinar las instrucciones para sus anotadores?

- Si está satisfecho de haber abordado cualquier problema de la ejecución de la prueba, haga un lote de anotaciones – Para probar los resultados del lote, siga el mismo enfoque de evaluación de la calidad de evaluar las variabilidades de etiquetas entre anotadores y entre imágenes.

Conclusión

Esta publicación sirve como guía para que las partes interesadas del negocio comprendan las complejidades de la creación de datos para aplicaciones de IA/ML. Los procesos descritos también sirven como guía para que los profesionales técnicos generen datos de calidad mientras optimizan las restricciones comerciales, como el personal y los costos. Si no se hace bien, una canalización de creación y etiquetado de datos puede demorar entre 4 y 6 meses.

Con las pautas y sugerencias descritas en esta publicación, puede adelantarse a los obstáculos, reducir el tiempo de finalización y minimizar los costos en su viaje hacia la creación de datos de alta calidad.

Sobre los autores

Jasleen Greval es científica aplicada en Amazon Web Services, donde trabaja con clientes de AWS para resolver problemas del mundo real mediante el aprendizaje automático, con un enfoque especial en la medicina de precisión y la genómica. Tiene una sólida formación en bioinformática, oncología y genómica clínica. Le apasiona usar AI/ML y servicios en la nube para mejorar la atención al paciente.

Jasleen Greval es científica aplicada en Amazon Web Services, donde trabaja con clientes de AWS para resolver problemas del mundo real mediante el aprendizaje automático, con un enfoque especial en la medicina de precisión y la genómica. Tiene una sólida formación en bioinformática, oncología y genómica clínica. Le apasiona usar AI/ML y servicios en la nube para mejorar la atención al paciente.

Boris Aronchik es gerente en el laboratorio de soluciones de aprendizaje automático de IA de Amazon, donde dirige un equipo de científicos e ingenieros de ML para ayudar a los clientes de AWS a alcanzar los objetivos comerciales aprovechando las soluciones de IA/ML.

Boris Aronchik es gerente en el laboratorio de soluciones de aprendizaje automático de IA de Amazon, donde dirige un equipo de científicos e ingenieros de ML para ayudar a los clientes de AWS a alcanzar los objetivos comerciales aprovechando las soluciones de IA/ML.

Miguel RomeroCalvo es científico aplicado en la Laboratorio de soluciones de Amazon ML donde se asocia con equipos internos de AWS y clientes estratégicos para acelerar su negocio a través de ML y adopción de la nube.

Miguel RomeroCalvo es científico aplicado en la Laboratorio de soluciones de Amazon ML donde se asocia con equipos internos de AWS y clientes estratégicos para acelerar su negocio a través de ML y adopción de la nube.

Lin Lee Cheong es científico sénior y gerente del equipo de Amazon ML Solutions Lab en Amazon Web Services. Trabaja con clientes estratégicos de AWS para explorar y aplicar inteligencia artificial y aprendizaje automático para descubrir nuevos conocimientos y resolver problemas complejos.

Lin Lee Cheong es científico sénior y gerente del equipo de Amazon ML Solutions Lab en Amazon Web Services. Trabaja con clientes estratégicos de AWS para explorar y aplicar inteligencia artificial y aprendizaje automático para descubrir nuevos conocimientos y resolver problemas complejos.

- AI

- arte ai

- generador de arte ai

- robot ai

- Laboratorio de soluciones de Amazon ML

- Amazon SageMaker

- Verdad fundamental de Amazon SageMaker

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- Servicios profesionales de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet