Täna on meil hea meel teatada, et Mixtral-8x7B Suur keelemudel (LLM), mille on välja töötanud Mistral AI, on klientidele saadaval selle kaudu Amazon SageMaker JumpStart ühe klõpsuga juurutamiseks järelduste tegemiseks. Mixtral-8x7B LLM on eelkoolitatud hõre ekspertmudelite segu, mis põhineb 7 miljardi parameetriga selgrool ja kaheksa eksperti iga edasisuunamiskihi kohta. Saate seda mudelit proovida SageMaker JumpStartiga, masinõppe (ML) keskusega, mis pakub juurdepääsu algoritmidele ja mudelitele, et saaksite ML-iga kiiresti alustada. Selles postituses kirjeldame, kuidas Mixtral-8x7B mudelit avastada ja kasutusele võtta.

Mis on Mixtral-8x7B

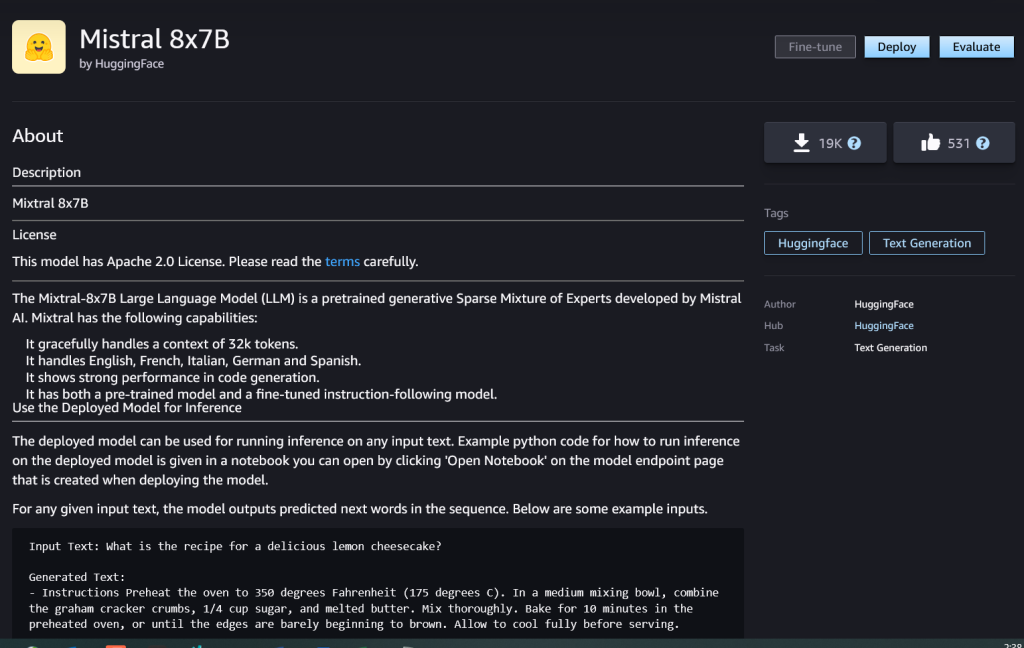

Mixtral-8x7B on Mistral AI välja töötatud alusmudel, mis toetab inglis-, prantsuse-, saksa-, itaalia- ja hispaaniakeelset teksti koos koodi genereerimise võimalustega. See toetab mitmesuguseid kasutusjuhtumeid, nagu teksti kokkuvõte, klassifitseerimine, teksti lõpetamine ja koodi lõpetamine. See käitub vestlusrežiimis hästi. Mudeli lihtsa kohandatavuse demonstreerimiseks on Mistral AI välja andnud ka Mixtral-8x7B-juhiste mudeli vestluse kasutusjuhtudeks, mida on peenhäälestatud mitmesuguste avalikult kättesaadavate vestluste andmekogude abil. Mixtral mudelitel on suur konteksti pikkus kuni 32,000 XNUMX märgini.

Mixtral-8x7B pakub märkimisväärseid jõudluse täiustusi võrreldes eelmiste tipptasemel mudelitega. Selle hõre ekspertide arhitektuur võimaldab saavutada paremaid tulemusi 9-st 12-st loomuliku keele töötlemise (NLP) etalonist, mida testis Mistral AI. Mixtral sobib või ületab mudelite jõudlust kuni 10 korda oma suurusest. Kasutades ainult murdosa parameetreid märgi kohta, saavutab see kiirema järelduskiiruse ja väiksema arvutuskulu võrreldes samaväärse suurusega tihedate mudelitega – näiteks kokku 46.7 miljardit parameetrit, kuid ühe märgi kohta kasutatakse ainult 12.9 miljardit. See suure jõudluse, mitmekeelse toe ja arvutusliku tõhususe kombinatsioon muudab Mixtral-8x7B ahvatlevaks valikuks NLP-rakenduste jaoks.

Mudel on piiranguteta kasutamiseks saadaval lubava Apache 2.0 litsentsi alusel.

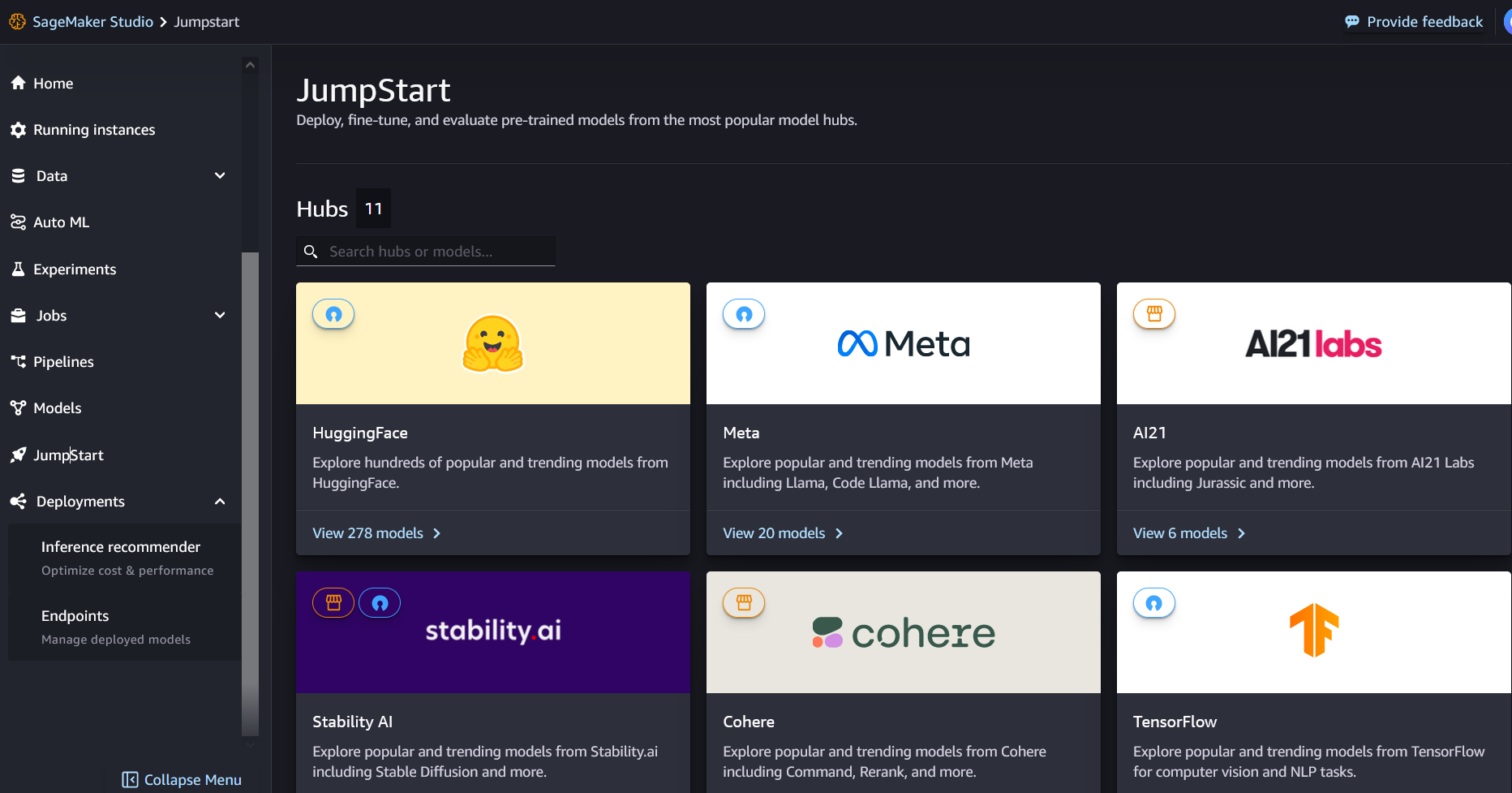

Mis on SageMaker JumpStart

SageMaker JumpStartiga saavad ML-i praktikud valida kasvava nimekirja kõige paremini toimivatest aluskreemide mudelitest. ML-praktikud saavad sihtotstarbeliselt kasutusele võtta sihtasutuse mudelid Amazon SageMaker eksemplare võrgust eraldatud keskkonnas ja kohandada mudeleid SageMakeri abil mudeli koolituseks ja juurutamiseks.

Nüüd saate mõne klõpsuga avastada ja juurutada Mixtral-8x7B Amazon SageMaker Studio või programmiliselt SageMaker Python SDK kaudu, mis võimaldab teil tuletada mudeli jõudlust ja MLOps-i juhtelemente SageMakeri funktsioonidega, nagu Amazon SageMakeri torujuhtmed, Amazon SageMakeri silurvõi konteineri palke. Mudel on juurutatud AWS-i turvalises keskkonnas ja teie VPC kontrolli all, aidates tagada andmete turvalisust.

Avastage mudeleid

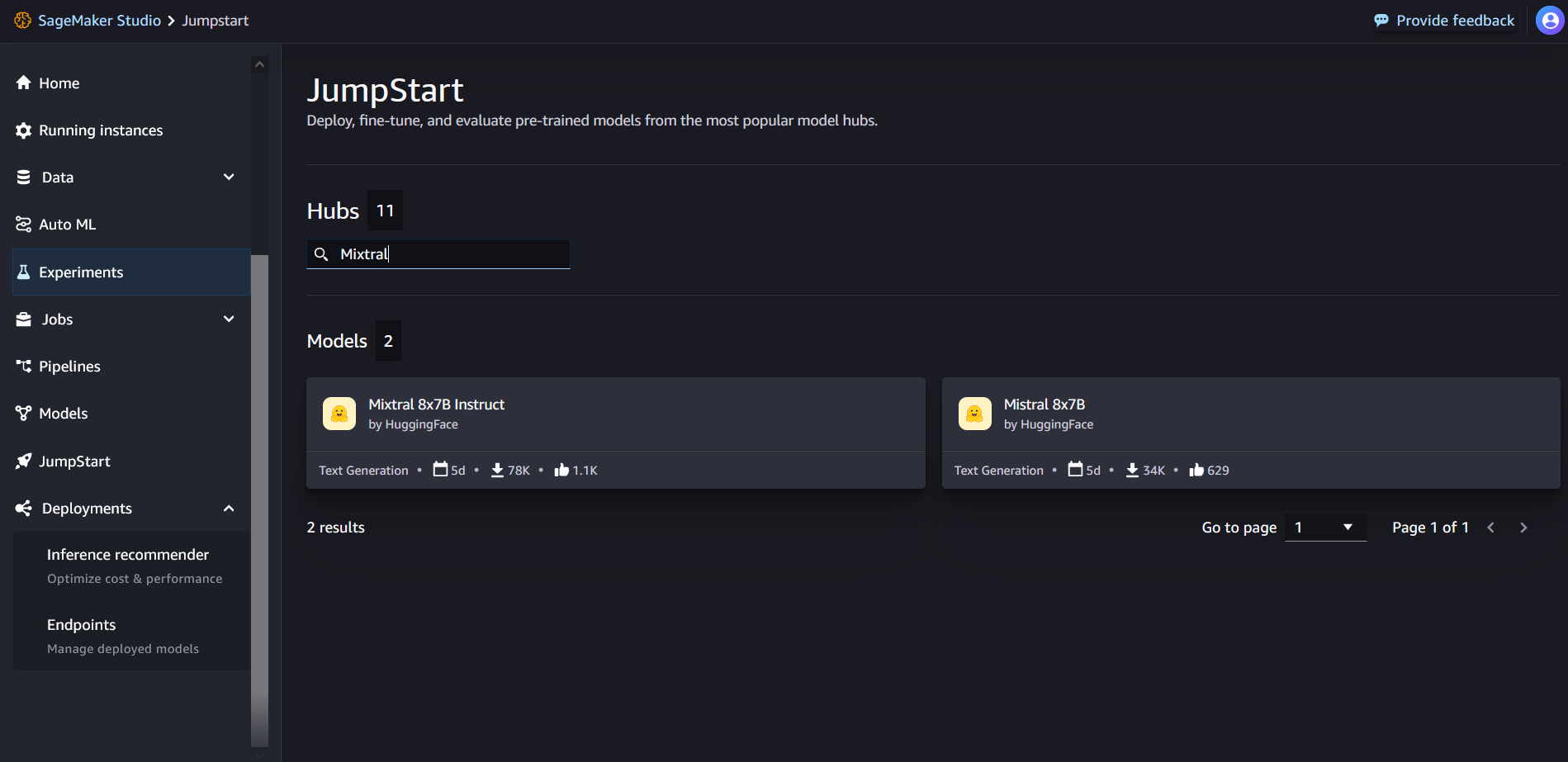

Juurdepääs Mixtral-8x7B alusmudelitele on SageMakeri JumpStarti kaudu SageMaker Studio kasutajaliideses ja SageMaker Python SDK-s. Selles jaotises käsitleme SageMaker Studio mudelite leidmist.

SageMaker Studio on integreeritud arenduskeskkond (IDE), mis pakub ühtset veebipõhist visuaalset liidest, kus pääsete juurde sihipäraselt loodud tööriistadele, et sooritada kõiki ML-i arendusetappe alates andmete ettevalmistamisest kuni ML-mudelite loomise, koolitamise ja juurutamiseni. Lisateavet SageMaker Studio alustamise ja seadistamise kohta leiate aadressilt Amazon SageMaker Studio.

SageMaker Studios pääsete SageMaker JumpStarti juurde, valides KiirStart navigeerimispaanil.

SageMaker JumpStarti sihtlehelt saate otsida otsingukastist "Mixtral". Näete otsingutulemusi, mis näitavad Mixtral 8x7B ja Mixtral 8x7B Instruct.

Saate valida mudelikaardi, et vaadata mudeli üksikasju, nagu litsents, koolituseks kasutatud andmed ja kasutusviis. Samuti leiate juurutada nuppu, mida saate kasutada mudeli juurutamiseks ja lõpp-punkti loomiseks.

Mudeli juurutamine

Juurutamine algab siis, kui valite juurutada. Pärast juurutamise lõppu on loodud lõpp-punkt. Saate lõpp-punkti testida, edastades näidistulemuspäringu kasuliku koormuse või valides SDK abil testimisvaliku. Kui valite SDK kasutamise, näete näidiskoodi, mida saate kasutada SageMaker Studio eelistatud märkmikuredaktoris.

SDK abil juurutamiseks alustame mudeli Mixtral-8x7B valimisega, mille määrab model_id with value huggingface-llm-mixtral-8x7b. Saate SageMakeris juurutada mis tahes valitud mudelitest järgmise koodiga. Samamoodi saate juurutada Mixtral-8x7B käsu, kasutades selle enda mudeli ID-d:

See juurutab mudeli SageMakeris vaikekonfiguratsioonidega, sealhulgas eksemplari vaiketüübi ja VPC vaikekonfiguratsioonidega. Saate neid konfiguratsioone muuta, määrates sisse mittevaikeväärtused KiirStartModel.

Pärast selle juurutamist saate SageMakeri ennustaja kaudu juurutatud lõpp-punkti kohta järeldusi teha:

Näidisjuhised

Saate Mixtral-8x7B mudeliga suhelda nagu iga standardse teksti genereerimise mudeliga, kus mudel töötleb sisendjada ja väljastab jada ennustatud järgmised sõnad. Selles jaotises pakume näidisviipasid.

Koodi genereerimine

Kasutades eelmist näidet, saame kasutada järgmisi koodi genereerimise viipasid:

Saate järgmise väljundi:

Tundeanalüüsi nõuanne

Mixtral 8x7B puhul saate sentimentide analüüsi teha, kasutades järgmist viipa.

Saate järgmise väljundi:

Küsimustele vastamise juhised

Saate Mixtral-8x7B puhul kasutada järgmist küsimusele vastamise viipa:

Saate järgmise väljundi:

Mixtral-8x7B Juhend

Mixtral-8x7B juhistega häälestatud versioon aktsepteerib vormindatud juhiseid, kus vestlusrollid peavad algama kasutajaviibaga ning vaheldumisi kasutajajuhiste ja assistendi vahel (mudelvastus). Käskude vormingut tuleb rangelt järgida, vastasel juhul genereerib mudel mitteoptimaalseid väljundeid. Käsumudeli viipa koostamiseks kasutatav mall on määratletud järgmiselt.

Pange tähele, et <s> ja </s> on stringi alguse (BOS) ja stringi lõpu (EOS) erimärgid, kusjuures [INST] ja [/INST] on tavalised stringid.

Järgmine kood näitab, kuidas saate vormindada viipa käsuvormingus:

Teadmiste otsimine

Teadmiste hankimise viipa jaoks saate kasutada järgmist koodi.

Saate järgmise väljundi:

Kodeerimine

Mixtral mudelid võivad demonstreerida kodeerimisülesannete võrdlusaluseid, nagu on näidatud järgmises koodis:

Matemaatika ja arutluskäik

Mixtral mudelid näitavad ka matemaatika täpsuse tugevusi:

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/mixtral-8x7b-is-now-available-in-amazon-sagemaker-jumpstart/

- :on

- :on

- :mitte

- : kus

- $ UP

- 000

- 1

- 10

- 100

- 11

- 12

- 120

- 13

- 130

- 14

- 15%

- 16

- 17

- 1M

- 200

- 25

- 26%

- 30

- 32

- 50

- 600

- 7

- 72

- 8

- 9

- a

- võimeid

- MEIST

- üle

- kiirendades

- Nõustub

- juurdepääs

- Kontod

- täpsus

- Saavutada

- Saavutab

- üle

- aktiivne

- lisatud

- lisades

- pärast

- vastu

- AI

- AI / ML

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- Ka

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- summa

- an

- analüüs

- ja

- infrastruktuuri

- Teatama

- vastus

- mistahes

- Apache

- ahvatlev

- rakendused

- rakendatud

- Rakendades

- arhitektuur

- OLEME

- argument

- artikkel

- AS

- assistent

- At

- saadaval

- AWS

- tagasi

- Selgroog

- põhineb

- sisse lööma

- aku

- Bayesi

- BE

- sest

- olnud

- enne

- Algus

- usub,

- Kell

- võrdlusuuring

- kriteeriumid

- Parem

- vahel

- arve

- arvete

- Miljard

- julge

- ostnud

- Kast

- Murdma

- tooma

- ehitama

- Ehitus

- sisseehitatud

- äri

- kuid

- by

- arvutama

- helistama

- kutsutud

- Kutsub

- CAN

- kaart

- juhul

- juhtudel

- muutma

- vestlus

- valik

- Vali

- valimine

- Chris

- klassifikatsioon

- klõps

- kood

- Kodeerimine

- kombinatsioon

- võrreldes

- koostatud

- lõpetamist

- arvutuslik

- Arvutama

- arvuti

- Arvuti visioon

- konverentsid

- pidevalt

- Konteiner

- sisu

- kontekst

- pidev

- pidevalt

- kontrolli

- Vestlus

- Maksma

- kulud

- võiks

- looma

- loodud

- otsustav

- Tass

- Praegune

- Kliendid

- kohandamine

- kohandada

- andmed

- andmekaitse

- andmekogumid

- päev

- Päeva

- pühendunud

- vaikimisi

- määratletud

- Demokraatlik

- näitama

- juurutada

- lähetatud

- juurutamine

- kasutuselevõtu

- juurutab

- kõrvalekalle

- detailid

- arendama

- arenenud

- arendaja

- & Tarkvaraarendus

- DIKT

- DID

- avastama

- do

- ei

- dollarit

- Domeenid

- tehtud

- alla

- Drop

- Hertsog

- hertsogi ülikool

- iga

- Majanduslik

- toimetaja

- efektiivsus

- Munad

- teine

- võimaldama

- võimaldab

- võimaldades

- lõpp

- Lõpp-punkt

- Inseneriteadus

- Inglise

- tagama

- keskkond

- EOS

- võrdne

- Samaväärne

- eetiline

- näide

- ületab

- erutatud

- välja arvatud

- ekspert

- ekspertide

- Selgitama

- selgitus

- laiendamine

- pere

- kiiremini

- FUNKTSIOONID

- vähe

- Faile

- Filtrid

- leidma

- esimene

- Järel

- järgneb

- eest

- formaat

- Sihtasutus

- murdosa

- prantsuse

- Alates

- funktsioon

- tulevik

- Üldine otstarve

- tekitama

- loodud

- põlvkond

- generatiivne

- Generatiivne AI

- saksa

- saama

- Go

- hea

- sain

- Kasvavad

- viha

- Olema

- he

- aitama

- aidates

- aitab

- siin

- siin

- Suur

- Hills

- tema

- Kuidas

- Kuidas

- HTML

- HTTPS

- Keskus

- i

- ICE

- jäätis

- ID

- if

- Illinois

- haigus

- import

- oluline

- parandama

- parandusi

- in

- sisaldama

- Kaasa arvatud

- Inkorporeeritud

- Infrastruktuur

- sisend

- sisendite

- Näiteks

- juhised

- integreerima

- integreeritud

- suhelda

- el

- Interface

- Leiutatud

- isoleeritud

- IT

- itaalia

- ITS

- ise

- jpg

- lapsed

- teadmised

- Kyle

- Labs

- maandumine

- keel

- suur

- viimane

- kiht

- Leads

- õppimine

- Pikkus

- laskma

- litsents

- nagu

- meeldib

- piirid

- LINK

- nimekiri

- Kuulamine

- vähe

- LLM

- loogika

- otsin

- vähendada

- masin

- masinõpe

- tehtud

- TEEB

- Tegemine

- juht

- palju

- tikud

- matemaatika

- matemaatika

- me

- keskmine

- segu

- ML

- MLOps

- viis

- mudel

- mudelid

- modifitseeritud

- kuu

- rohkem

- mootorratas

- palju

- korrutatakse

- muusika

- peab

- my

- Natural

- Natural Language Processing

- NAVIGATSIOON

- negatiivne

- võrk

- Neutraalne

- Uus

- järgmine

- nlp

- mitte ükski

- meeles

- märkmik

- nüüd

- number

- of

- Õli

- on

- kunagi

- ONE

- ainult

- tegutsevad

- operatsioonisüsteemi

- valik

- or

- Muu

- muidu

- välja

- väljund

- väljundid

- väljaspool

- üle

- enda

- lehekülg

- makstud

- pane

- dokumendid

- parameeter

- parameetrid

- Mööduv

- kirg

- kirglik

- teed

- kohta

- täitma

- jõudlus

- phd

- telefon

- Platon

- Platoni andmete intelligentsus

- PlatoData

- Punkt

- kaasaskantav

- positiivne

- post

- eelnev

- ennustada

- Predictor

- eelistatud

- ettevalmistamisel

- eelmine

- Peamine

- trükk

- protseduuriline

- protsess

- Protsessid

- töötlemine

- Toode

- Programm

- Programming

- küsib

- heaolu

- anda

- pakkujad

- annab

- avalikult

- avaldatud

- Python

- Kvartal

- küsimus

- kiiresti

- RE

- Lugemine

- retsept

- Korduv

- vähendama

- viitama

- regulaarne

- vabastatud

- aru

- taotleda

- teadustöö

- uurija

- Vahendid

- austatud

- vastus

- vastutav

- piirangud

- kaasa

- Tulemused

- tagasipöördumine

- Tulu

- ratsutamine

- Oht

- Roll

- rollid

- ruum

- jooks

- jooksmine

- s

- SA

- salveitegija

- sool

- skaalautuvia

- Skaala

- teadus

- teadlane

- SDK

- Otsing

- Osa

- kindlustama

- turvalisus

- vaata

- valima

- väljavalitud

- valides

- valik

- vanem

- tunne

- eri

- Jada

- Seeria

- Teenused

- komplekt

- näitas

- näidatud

- Näitused

- märkimisväärne

- Samamoodi

- lihtne

- alates

- ühekordne

- SUURUS

- So

- sotsiaalmeedia

- Ühiskond

- tarkvara

- lahendus

- hispaania

- eriline

- spetsialist

- määratletud

- kiirused

- Kulutused

- standard

- algus

- alustatud

- algab

- modernne

- statistiline

- Samm

- Sammud

- Veel

- peatatud

- salvestada

- lihtne

- Strateegiline

- oja

- tugevused

- nöör

- struktureeritud

- stuudio

- selline

- toetama

- Toetamine

- Toetab

- süsteem

- võtab

- ülesanded

- maitse

- meeskond

- Tehnoloogia

- šabloon

- test

- katsetatud

- Testimine

- tekst

- et

- .

- Tulevik

- SIIS

- Need

- nad

- see

- Läbi

- aeg

- Ajaseeria

- korda

- et

- kokku

- sümboolne

- märgid

- liiga

- töövahendid

- Summa

- Rong

- koolitus

- tõsi

- püüdma

- piiksuma

- tüüp

- ui

- all

- Ülikool

- unix

- avamine

- kuni

- kasutama

- kasutage juhtumit

- Kasutatud

- Kasutaja

- kasutusalad

- kasutamine

- kasutades

- org

- väärtus

- Väärtused

- sort

- versioon

- Video

- vaade

- nägemus

- visiit

- visuaalne

- kõndima

- oli

- Vesi

- we

- web

- veebiteenused

- Veebipõhine

- Hästi

- M

- Mis on

- millal

- samas kui

- mis

- valge

- WHO

- will

- koos

- jooksul

- ilma

- sõnad

- Töö

- oleks

- kirjutama

- kirjalik

- sa

- Sinu

- sephyrnet

Rachna Chadha on AWS-i strateegiliste kontode pealahendusarhitekt AI/ML. Rachna on optimist, kes usub, et tehisintellekti eetiline ja vastutustundlik kasutamine võib tulevikus ühiskonda parandada ning tuua majanduslikku ja sotsiaalset õitsengut. Vabal ajal meeldib Rachnale perega aega veeta, matkata ja muusikat kuulata.

Rachna Chadha on AWS-i strateegiliste kontode pealahendusarhitekt AI/ML. Rachna on optimist, kes usub, et tehisintellekti eetiline ja vastutustundlik kasutamine võib tulevikus ühiskonda parandada ning tuua majanduslikku ja sotsiaalset õitsengut. Vabal ajal meeldib Rachnale perega aega veeta, matkata ja muusikat kuulata. Dr Kyle Ulrich on rakendusteadlane

Dr Kyle Ulrich on rakendusteadlane  Christopher Whitten on tarkvaraarendaja JumpStart meeskonnas. Ta aitab mudelite valikul skaleerida ja integreerida mudeleid teiste SageMakeri teenustega. Chris on kirglik tehisintellekti leviku kiirendamise vastu erinevates ärivaldkondades.

Christopher Whitten on tarkvaraarendaja JumpStart meeskonnas. Ta aitab mudelite valikul skaleerida ja integreerida mudeleid teiste SageMakeri teenustega. Chris on kirglik tehisintellekti leviku kiirendamise vastu erinevates ärivaldkondades. Dr Fabio Nonato de Paula on GenAI SA vanemjuht, spetsialist, kes aitab mudelipakkujatel ja klientidel generatiivset AI-d AWS-is skaleerida. Fabio kirg on demokratiseerida juurdepääs generatiivsele AI-tehnoloogiale. Väljaspool tööd võite leida Fabio Sonoma Valley mägedes oma mootorrattaga sõitmas või ComiXologyt lugemas.

Dr Fabio Nonato de Paula on GenAI SA vanemjuht, spetsialist, kes aitab mudelipakkujatel ja klientidel generatiivset AI-d AWS-is skaleerida. Fabio kirg on demokratiseerida juurdepääs generatiivsele AI-tehnoloogiale. Väljaspool tööd võite leida Fabio Sonoma Valley mägedes oma mootorrattaga sõitmas või ComiXologyt lugemas. Dr Ashish Khetan on vanemrakendusteadlane, kellel on Amazon SageMaker sisseehitatud algoritmid ja aitab välja töötada masinõppe algoritme. Ta sai doktorikraadi Illinoisi Urbana-Champaigni ülikoolist. Ta on aktiivne masinõppe ja statistiliste järelduste uurija ning avaldanud palju artikleid NeurIPS, ICML, ICLR, JMLR, ACL ja EMNLP konverentsidel.

Dr Ashish Khetan on vanemrakendusteadlane, kellel on Amazon SageMaker sisseehitatud algoritmid ja aitab välja töötada masinõppe algoritme. Ta sai doktorikraadi Illinoisi Urbana-Champaigni ülikoolist. Ta on aktiivne masinõppe ja statistiliste järelduste uurija ning avaldanud palju artikleid NeurIPS, ICML, ICLR, JMLR, ACL ja EMNLP konverentsidel. Karl Albertsen juhib Amazon SageMaker Algorithms ja JumpStart, SageMakeri masinõppekeskuse tooteid, tehnikat ja teadust. Ta on kirglik masinõppe rakendamisest äriväärtuse avamiseks.

Karl Albertsen juhib Amazon SageMaker Algorithms ja JumpStart, SageMakeri masinõppekeskuse tooteid, tehnikat ja teadust. Ta on kirglik masinõppe rakendamisest äriväärtuse avamiseks.