مدلهای زبان بزرگ (LLM) تخیل و توجه توسعهدهندگان، دانشمندان، فنآوران، کارآفرینان و مدیران اجرایی در چندین صنعت را به خود جلب کردهاند. این مدلها را میتوان برای پاسخگویی به سؤال، خلاصهسازی، ترجمه و موارد دیگر در برنامههایی مانند نمایندگیهای مکالمه برای پشتیبانی مشتری، ایجاد محتوا برای بازاریابی و دستیاران کدنویسی استفاده کرد.

اخیرا متا منتشر شده است لاما 2 هم برای محققان و هم برای نهادهای تجاری، افزودن به لیست سایر LLMها، از جمله MosaicML MPT و شاهین. در این پست، نحوه تنظیم دقیق Llama 2 را توضیح می دهیم AWS Trainiumیک شتاب دهنده هدفمند برای آموزش LLM، برای کاهش زمان و هزینه های آموزش. ما اسکریپت های تنظیم دقیق ارائه شده توسط را بررسی می کنیم نورون AWS SDK (با استفاده از NeMo Megatron-LM)، پیکربندیهای مختلفی که استفاده کردیم، و نتایج خروجی که دیدیم.

در مورد مدل Llama 2

مشابه قبلی لاما 1 مدل و مدلهای دیگر مانند GPT، Llama 2 از معماری فقط رمزگشای Transformer استفاده میکند. این در سه اندازه وجود دارد: 7 میلیارد، 13 میلیارد و 70 میلیارد پارامتر. در مقایسه با Llama 1، Llama 2 طول زمینه را از 2,000 به 4,000 دوبرابر می کند و از توجه جستجوی گروهی (فقط برای 70B) استفاده می کند. مدل های از پیش آموزش دیده Llama 2 بر روی 2 تریلیون توکن آموزش داده شده اند و مدل های دقیق آن بر روی بیش از 1 میلیون حاشیه نویسی انسانی آموزش دیده اند.

آموزش توزیع شده Llama 2

برای قرار دادن Llama 2 با طول سکانس های 2,000 و 4,000، اسکریپت را با استفاده از NeMo Megatron برای Trainium که از موازی سازی داده ها (DP)، موازی سازی تانسوری (TP) و موازی خط لوله (PP) پشتیبانی می کند. به طور خاص، با اجرای جدید برخی از ویژگی ها مانند untie word embedding، rotary embedding، RMSNorm و فعال سازی Swiglu، از اسکریپت عمومی استفاده می کنیم. نورون GPT Megatron-LM برای پشتیبانی از اسکریپت آموزشی Llama 2.

روش آموزش سطح بالا ما به شرح زیر است: برای محیط آموزشی خود، از یک خوشه چند نمونه ای که توسط سیستم SLURM مدیریت می شود برای آموزش توزیع شده و زمان بندی تحت چارچوب NeMo استفاده می کنیم.

ابتدا مجموعه داده های آموزشی و مدل Llama 2 را دانلود کرده و با استفاده از توکنایزر Llama 2 آنها را پیش پردازش کنید. به عنوان مثال، برای استفاده از مجموعه داده RedPajama، از دستور زیر استفاده کنید:

برای راهنمایی دقیق در مورد دانلود مدل ها و استدلال اسکریپت پیش پردازش به ادامه مطلب مراجعه کنید مجموعه داده و توکنایزر LlamaV2 را دانلود کنید.

سپس مدل را کامپایل کنید:

پس از کامپایل شدن مدل، کار آموزشی را با اسکریپت زیر اجرا کنید که از قبل با بهترین پیکربندی و هایپرپارامترها برای Llama 2 بهینه شده است (که در کد مثال موجود است):

در نهایت، ما TensorBoard را برای پیگیری پیشرفت آموزش نظارت می کنیم:

برای مثال کامل کد و اسکریپت هایی که ذکر کردیم، به Llama 7B مراجعه کنید آموزش و کد NeMo در Neuron SDK برای طی مراحل دقیق تر.

آزمایش های تنظیم دقیق

ما مدل 7B را روی مجموعه دادههای OSCAR (Open Super-large Crawled ALMAnaCH Corpus) و QNLI (NLI پاسخگوی پرسش) در یک محیط Neuron 2.12 (PyTorch) بهخوبی تنظیم کردیم. برای هر 2,000 و 4,000 طول دنباله، برخی از تنظیمات را بهینه کردیم، مانند batchsize و gradient_accumulation، برای کارایی آموزش بهعنوان یک استراتژی تنظیم دقیق، تنظیم دقیق تمام پارامترها (حدود 500 مرحله) را اتخاذ کردیم، که میتوان آن را به پیشآموزش با مراحل طولانیتر و مجموعه دادههای بزرگتر (مثلاً 1T RedPajama) گسترش داد. همچنین میتوان توازی توالی را فعال کرد تا به NeMo Megatron اجازه دهد تا مدلهای با طول دنباله بزرگتر 4,000 را با موفقیت تنظیم کند. جدول زیر نتایج پیکربندی و توان عملیات تنظیم دقیق Llama 7B را نشان می دهد. با افزایش تعداد نمونه ها تا 4، توان عملیاتی تقریباً به صورت خطی مقیاس می شود.

| کتابخانه توزیع شده | مجموعه داده ها | طول دنباله | تعداد موارد | تانسور موازی | داده موازی | خط لوله موازی | اندازه دسته جهانی | توان عملیاتی (ثانیه در ثانیه) |

| نورون نمو مگاترون | اسکار | 4096 | 1 | 8 | 4 | 1 | 256 | 3.7 |

| . | . | 4096 | 2 | 8 | 4 | 1 | 256 | 7.4 |

| . | . | 4096 | 4 | 8 | 4 | 1 | 256 | 14.6 |

| . | QNLI | 4096 | 4 | 8 | 4 | 1 | 256 | 14.1 |

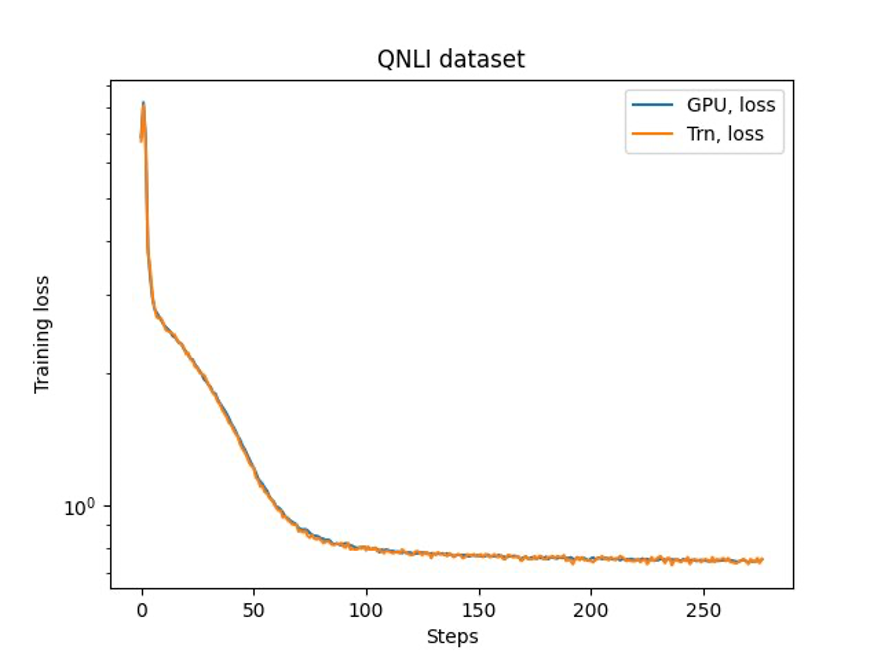

آخرین مرحله بررسی دقت با مدل پایه است. ما یک اسکریپت مرجع برای آزمایشهای GPU پیادهسازی کردیم و منحنیهای آموزشی برای GPU و Trainium مطابق شکل زیر را تأیید کردیم. شکل منحنیهای ضرر را در تعداد مراحل آموزشی در مجموعه داده QNLI نشان میدهد. دقت ترکیبی برای GPU (آبی) و bf16 با گرد کردن تصادفی پیشفرض برای Trainium (نارنجی) به کار گرفته شد.

نتیجه

در این پست، ما نشان دادیم که Trainium عملکرد بالا و تنظیم دقیق مقرون به صرفه Llama 2 را ارائه میدهد. برای اطلاعات بیشتر در مورد استفاده از Trainium برای پیشآموزش توزیع شده و تنظیم دقیق مدلهای هوش مصنوعی تولیدی خود با استفاده از NeMo Megatron، به ادامه مطلب مراجعه کنید. مرجع نورون AWS برای NeMo Megatron.

درباره نویسنده

هائو ژو یک دانشمند محقق با Amazon SageMaker است. قبل از آن، او روی توسعه روشهای یادگیری ماشینی برای تشخیص تقلب برای Amazon Fraud Detector کار میکرد. او مشتاق به کارگیری تکنیکهای یادگیری ماشین، بهینهسازی و هوش مصنوعی برای مشکلات مختلف دنیای واقعی است. او دارای مدرک دکترای مهندسی برق از دانشگاه نورث وسترن است.

هائو ژو یک دانشمند محقق با Amazon SageMaker است. قبل از آن، او روی توسعه روشهای یادگیری ماشینی برای تشخیص تقلب برای Amazon Fraud Detector کار میکرد. او مشتاق به کارگیری تکنیکهای یادگیری ماشین، بهینهسازی و هوش مصنوعی برای مشکلات مختلف دنیای واقعی است. او دارای مدرک دکترای مهندسی برق از دانشگاه نورث وسترن است.

کارتیک گوپالسوامی یک دانشمند کاربردی با AWS است. قبل از AWS، او به عنوان یک دانشمند در آزمایشگاههای Uber و Walmart با تمرکز عمده روی بهینهسازی اعداد صحیح مختلط کار میکرد. در اوبر، او بر بهینه سازی شبکه حمل و نقل عمومی با محصولات SaaS درخواستی و سواری های مشترک تمرکز کرد. او در آزمایشگاه والمارت روی قیمت گذاری و بهینه سازی بسته بندی کار می کرد. Karthick دارای مدرک دکترا در مهندسی صنایع و سیستم ها با مدرک تحصیلی جزئی در تحقیقات عملیاتی از دانشگاه ایالتی کارولینای شمالی است. تحقیقات او بر روی مدلها و روشهایی متمرکز است که تحقیقات عملیاتی و یادگیری ماشین را ترکیب میکنند.

کارتیک گوپالسوامی یک دانشمند کاربردی با AWS است. قبل از AWS، او به عنوان یک دانشمند در آزمایشگاههای Uber و Walmart با تمرکز عمده روی بهینهسازی اعداد صحیح مختلط کار میکرد. در اوبر، او بر بهینه سازی شبکه حمل و نقل عمومی با محصولات SaaS درخواستی و سواری های مشترک تمرکز کرد. او در آزمایشگاه والمارت روی قیمت گذاری و بهینه سازی بسته بندی کار می کرد. Karthick دارای مدرک دکترا در مهندسی صنایع و سیستم ها با مدرک تحصیلی جزئی در تحقیقات عملیاتی از دانشگاه ایالتی کارولینای شمالی است. تحقیقات او بر روی مدلها و روشهایی متمرکز است که تحقیقات عملیاتی و یادگیری ماشین را ترکیب میکنند.

شین هوانگ یک دانشمند کاربردی ارشد برای آمازون SageMaker JumpStart و آمازون SageMaker الگوریتم های داخلی است. او بر توسعه الگوریتمهای یادگیری ماشینی مقیاسپذیر تمرکز دارد. علایق تحقیقاتی او در زمینه پردازش زبان طبیعی، یادگیری عمیق قابل توضیح بر روی داده های جدولی، و تجزیه و تحلیل قوی خوشه بندی ناپارامتری فضا-زمان است. او مقالات زیادی را در کنفرانسهای ACL، ICDM، KDD، و انجمن آماری سلطنتی: سری A منتشر کرده است.

شین هوانگ یک دانشمند کاربردی ارشد برای آمازون SageMaker JumpStart و آمازون SageMaker الگوریتم های داخلی است. او بر توسعه الگوریتمهای یادگیری ماشینی مقیاسپذیر تمرکز دارد. علایق تحقیقاتی او در زمینه پردازش زبان طبیعی، یادگیری عمیق قابل توضیح بر روی داده های جدولی، و تجزیه و تحلیل قوی خوشه بندی ناپارامتری فضا-زمان است. او مقالات زیادی را در کنفرانسهای ACL، ICDM، KDD، و انجمن آماری سلطنتی: سری A منتشر کرده است.

پارک یانگسوک Sr. یک دانشمند کاربردی در آزمایشگاه AWS Annapurna است که بر روی توسعه و آموزش مدل های پایه بر روی شتاب دهنده های هوش مصنوعی کار می کند. قبل از آن، دکتر پارک روی تحقیق و توسعه برای آمازون Forecast در آزمایشگاه هوش مصنوعی AWS به عنوان دانشمند اصلی کار می کرد. تحقیقات او در تعامل بین یادگیری ماشین، مدلهای بنیادی، بهینهسازی و یادگیری تقویتی نهفته است. او بیش از 20 مقاله بررسی شده را در مکان های برتر از جمله ICLR، ICML، AISTATS و KDD با خدمات سازماندهی کارگاه آموزشی و ارائه آموزش در زمینه سری های زمانی و آموزش LLM منتشر کرده است. قبل از پیوستن به AWS، دکترای مهندسی برق را از دانشگاه استنفورد دریافت کرد.

پارک یانگسوک Sr. یک دانشمند کاربردی در آزمایشگاه AWS Annapurna است که بر روی توسعه و آموزش مدل های پایه بر روی شتاب دهنده های هوش مصنوعی کار می کند. قبل از آن، دکتر پارک روی تحقیق و توسعه برای آمازون Forecast در آزمایشگاه هوش مصنوعی AWS به عنوان دانشمند اصلی کار می کرد. تحقیقات او در تعامل بین یادگیری ماشین، مدلهای بنیادی، بهینهسازی و یادگیری تقویتی نهفته است. او بیش از 20 مقاله بررسی شده را در مکان های برتر از جمله ICLR، ICML، AISTATS و KDD با خدمات سازماندهی کارگاه آموزشی و ارائه آموزش در زمینه سری های زمانی و آموزش LLM منتشر کرده است. قبل از پیوستن به AWS، دکترای مهندسی برق را از دانشگاه استنفورد دریافت کرد.

یدا وانگ یک دانشمند اصلی در تیم AWS AI آمازون است. علاقه تحقیقاتی او در سیستم ها، محاسبات با کارایی بالا و تجزیه و تحلیل داده های بزرگ است. او در حال حاضر روی سیستمهای یادگیری عمیق، با تمرکز بر گردآوری و بهینهسازی مدلهای یادگیری عمیق برای آموزش کارآمد و استنتاج، بهویژه مدلهای پایه در مقیاس بزرگ، کار میکند. ماموریت این است که مدلهای سطح بالا را از چارچوبهای مختلف و پلتفرمهای سختافزاری سطح پایین از جمله پردازندهها، پردازندههای گرافیکی و شتابدهندههای هوش مصنوعی ایجاد کند تا مدلهای مختلف بتوانند با عملکرد بالا در دستگاههای مختلف اجرا شوند.

یدا وانگ یک دانشمند اصلی در تیم AWS AI آمازون است. علاقه تحقیقاتی او در سیستم ها، محاسبات با کارایی بالا و تجزیه و تحلیل داده های بزرگ است. او در حال حاضر روی سیستمهای یادگیری عمیق، با تمرکز بر گردآوری و بهینهسازی مدلهای یادگیری عمیق برای آموزش کارآمد و استنتاج، بهویژه مدلهای پایه در مقیاس بزرگ، کار میکند. ماموریت این است که مدلهای سطح بالا را از چارچوبهای مختلف و پلتفرمهای سختافزاری سطح پایین از جمله پردازندهها، پردازندههای گرافیکی و شتابدهندههای هوش مصنوعی ایجاد کند تا مدلهای مختلف بتوانند با عملکرد بالا در دستگاههای مختلف اجرا شوند.

جون (لوک) هوان دانشمند اصلی در آزمایشگاه هوش مصنوعی AWS است. دکتر هوان روی هوش مصنوعی و علم داده کار می کند. او بیش از 160 مقاله با داوری در کنفرانس ها و مجلات برجسته منتشر کرده است و 11 دانشجوی دکترا فارغ التحصیل شده است. او در سال 2009 جایزه توسعه شغلی اولیه دانشکده NSF را دریافت کرد. قبل از پیوستن به AWS، او در تحقیقات Baidu به عنوان یک دانشمند برجسته و رئیس آزمایشگاه داده های بزرگ بایدو کار می کرد. او StylingAI Inc.، یک استارتآپ هوش مصنوعی را تأسیس کرد و در سالهای 2019-2021 به عنوان مدیر عامل و دانشمند ارشد کار کرد. او قبل از پیوستن به این صنعت، استاد چارلز ای و مری جین اسپاهر در بخش EECS در دانشگاه کانزاس بود. از سال 2015 تا 2018، او به عنوان مدیر برنامه در NSF ایالات متحده مسئول برنامه کلان داده آن کار کرد.

جون (لوک) هوان دانشمند اصلی در آزمایشگاه هوش مصنوعی AWS است. دکتر هوان روی هوش مصنوعی و علم داده کار می کند. او بیش از 160 مقاله با داوری در کنفرانس ها و مجلات برجسته منتشر کرده است و 11 دانشجوی دکترا فارغ التحصیل شده است. او در سال 2009 جایزه توسعه شغلی اولیه دانشکده NSF را دریافت کرد. قبل از پیوستن به AWS، او در تحقیقات Baidu به عنوان یک دانشمند برجسته و رئیس آزمایشگاه داده های بزرگ بایدو کار می کرد. او StylingAI Inc.، یک استارتآپ هوش مصنوعی را تأسیس کرد و در سالهای 2019-2021 به عنوان مدیر عامل و دانشمند ارشد کار کرد. او قبل از پیوستن به این صنعت، استاد چارلز ای و مری جین اسپاهر در بخش EECS در دانشگاه کانزاس بود. از سال 2015 تا 2018، او به عنوان مدیر برنامه در NSF ایالات متحده مسئول برنامه کلان داده آن کار کرد.

شروتی کپرکار مدیر ارشد بازاریابی محصول در AWS است. او به مشتریان کمک میکند تا زیرساختهای محاسباتی شتابدهی آمازون EC2 را برای نیازهای یادگیری ماشین خود کاوش، ارزیابی و استفاده کنند.

شروتی کپرکار مدیر ارشد بازاریابی محصول در AWS است. او به مشتریان کمک میکند تا زیرساختهای محاسباتی شتابدهی آمازون EC2 را برای نیازهای یادگیری ماشین خود کاوش، ارزیابی و استفاده کنند.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://aws.amazon.com/blogs/machine-learning/fast-and-cost-effective-llama-2-fine-tuning-with-aws-trainium/

- : دارد

- :است

- $UP

- 000

- 1

- 100

- 11

- 12

- 13

- 160

- 20

- 500

- 7

- 70

- 8

- a

- درباره ما

- تسریع شد

- شتاب دهنده

- شتاب دهنده ها

- تطبیق

- دقت

- در میان

- فعال سازی

- اضافه کردن

- اتخاذ

- به تصویب رسید

- عاملان

- AI

- مدل های هوش مصنوعی

- الگوریتم

- معرفی

- اجازه دادن

- تقریبا

- قبلا

- همچنین

- آمازون

- آمازون EC2

- پیش بینی آمازون

- ردیاب تقلب آمازون

- آمازون SageMaker

- Amazon SageMaker JumpStart

- آمازون خدمات وب

- an

- تحلیل

- علم تجزیه و تحلیل

- و

- برنامه های کاربردی

- اعمال می شود

- با استفاده از

- معماری

- هستند

- محدوده

- استدلال

- AS

- دستیاران

- At

- توجه

- جایزه

- AWS

- بایدو

- پایه

- BE

- بوده

- قبل از

- بهترین

- میان

- بزرگ

- بزرگ داده

- بیلیون

- آبی

- هر دو

- بریج

- ساخته شده در

- by

- CAN

- اسیر

- کاریابی

- مدیر عامل شرکت

- بار

- چارلز

- رئیس

- خوشه

- خوشه بندی

- رمز

- برنامه نویسی

- ترکیب

- می آید

- تجاری

- مقایسه

- کامل

- محاسبه

- همایش ها

- پیکر بندی

- تایید شده

- محتوا

- تولید محتوا

- زمینه

- محاورهای

- مقرون به صرفه

- هزینه

- ایجاد

- در حال حاضر

- منحنی

- مشتری

- پشتیبانی مشتریان

- مشتریان

- داده ها

- تجزیه و تحلیل داده ها

- علم اطلاعات

- مجموعه داده ها

- عمیق

- یادگیری عمیق

- به طور پیش فرض

- ارائه

- بخش

- دقیق

- کشف

- توسعه دهندگان

- در حال توسعه

- پروژه

- دستگاه ها

- مختلف

- مدیر

- برجسته

- توزیع شده

- آموزش توزیع شده

- دو برابر

- دانلود

- dr

- e

- هر

- در اوایل

- بهره وری

- موثر

- تعبیه کردن

- فعال

- مهندسی

- اشخاص

- کارآفرینان

- محیط

- به خصوص

- ارزیابی

- مثال

- مدیران

- تجربه

- آزمایش

- اکتشاف

- FAST

- امکانات

- شکل

- تمرکز

- متمرکز شده است

- تمرکز

- پیروی

- به دنبال آن است

- برای

- پیش بینی

- پایه

- تاسیس

- چارچوب

- چارچوب

- تقلب

- کشف تقلب

- از جانب

- کامل

- مولد

- هوش مصنوعی مولد

- GPU

- GPU ها

- راهنمایی

- سخت افزار

- آیا

- he

- سر

- کمک می کند

- زیاد

- در سطح بالا

- عملکرد بالا

- خود را

- دارای

- چگونه

- چگونه

- HTML

- HTTPS

- انسان

- نشان می دهد

- خیال پردازی

- پیاده سازی

- اجرا

- in

- شرکت

- مشمول

- از جمله

- افزایش

- صنعتی

- لوازم

- صنعت

- شالوده

- علاقه

- منافع

- IT

- ITS

- جین

- کار

- پیوستن

- JPG

- کانزاس

- نگاه داشتن

- لابراتوار

- آزمایشگاه

- زبان

- در مقیاس بزرگ

- بزرگتر

- نام

- راه اندازی

- رهبری

- برجسته

- یادگیری

- طول

- نهفته است

- پسندیدن

- فهرست

- پشم لاما

- LLM

- دیگر

- خاموش

- دستگاه

- فراگیری ماشین

- عمده

- اداره می شود

- مدیر

- بسیاری

- بازار یابی (Marketing)

- تطبیق

- ذکر شده

- متا

- متدولوژی ها

- روش

- میلیون

- خردسال

- ماموریت

- مخلوط

- مدل

- مدل

- مانیتور

- بیش

- طبیعی

- پردازش زبان طبیعی

- نیازهای

- شبکه

- جدید

- شمال

- کارولینای شمالی

- NSF

- عدد

- کارت گرافیک Nvidia

- به دست آمده

- of

- on

- بر روی تقاضا

- فقط

- باز کن

- عملیات

- بهینه سازی

- بهینه

- بهینه سازی

- نارنجی

- سازماندهی

- دیگر

- ما

- روی

- اوراق

- پارامترهای

- پارک

- احساساتی

- بررسی شده توسط همکار

- کارایی

- دکترا

- خط لوله

- سیستم عامل

- افلاطون

- هوش داده افلاطون

- PlatoData

- پست

- قبلی

- قیمت گذاری

- اصلی

- قبلا

- مشکلات

- روش

- در حال پردازش

- محصول

- محصولات

- معلم

- برنامه

- پیشرفت

- ارائه

- عمومی

- حمل و نقل عمومی

- منتشر شده

- پــایتــون

- مارماهی

- سوال

- تحقیق و توسعه

- دنیای واقعی

- كاهش دادن

- مراجعه

- منتشر شد

- تحقیق

- محققان

- منابع

- نتایج

- این فایل نقد می نویسید:

- تنومند

- گرد کردن

- سلطنتی

- دویدن

- SAAS

- حکیم ساز

- دید

- مقیاس پذیر

- مقیاس ها

- زمان بندی

- علم

- دانشمند

- دانشمندان

- خط

- اسکریپت

- sdk

- ارشد

- دنباله

- سلسله

- سری A

- سرویس

- خدمات

- چند

- به اشتراک گذاشته شده

- او

- نشان داد

- نشان داده شده

- نشان می دهد

- اندازه

- So

- جامعه

- برخی از

- خاص

- استنفورد

- دانشگاه استنفورد

- شروع

- دولت

- آماری

- گام

- مراحل

- استراتژی

- دانشجویان

- موفقیت

- چنین

- پشتیبانی

- پشتیبانی از

- سیستم

- سیستم های

- جدول

- تیم

- تکنیک

- تکنسین ها

- نسبت به

- که

- La

- محوطه

- شان

- آنها

- اینها

- این

- سه

- از طریق

- توان

- زمان

- سری زمانی

- بار

- به

- با هم

- نشانه

- بالا

- tp

- مسیر

- آموزش دیده

- آموزش

- عبور

- ترجمه

- تریلیون

- آموزش

- حال بارگذاری

- زیر

- دانشگاه

- us

- استفاده کنید

- استفاده

- استفاده

- با استفاده از

- مختلف

- سالن

- بررسی

- راه رفتن

- WALMART

- بود

- we

- وب

- خدمات وب

- که

- با

- کلمه

- مشغول به کار

- کارگر

- با این نسخهها کار

- کارگاه

- شما

- زفیرنت