امروز، ما در دسترس بودن عمومی پیشرفته ترین آمازون را اعلام می کنیم مدل معلم الکسا با 20 میلیارد پارامتر (AlexaTM 20B) از طریق Amazon SageMaker JumpStart، مرکز یادگیری ماشین SageMaker. AlexaTM 20B یک مدل زبان چند زبانه توالی به دنباله (seq2seq) است که توسط آمازون توسعه یافته است. میتوانید از AlexaTM 20B برای طیف گستردهای از موارد استفاده صنعتی، از خلاصه کردن گزارشهای مالی گرفته تا پاسخگویی به سؤالات برای چت رباتهای خدمات مشتری، استفاده کنید. می توان آن را حتی زمانی که فقط چند نمونه آموزشی در دسترس وجود دارد، یا حتی هیچ کدام، اعمال کرد. AlexaTM 20B بهتر از 175 میلیارد مدل GPT-3 در وظایف یادگیری صفر شات مانند SuperGLUE و عملکرد پیشرفتهای را برای کارهای چند زبانه صفر شات مانند XNLI نشان میدهد.

در این پست، ما یک نمای کلی از نحوه استقرار و اجرای استنتاج با مدل AlexaTM 20B به صورت برنامهریزی شده از طریق APIهای JumpStart، موجود در SageMaker Python SDK. ما مثال میزنیم که چگونه میتوانید از این مدل برای ترجمه بین چند زبان، خلاصه کردن متن طولانی، پاسخ دادن به سؤالات بر اساس زمینه مشخص و ایجاد متنی که به نظر میرسد غیرقابل تشخیص از متن نوشته شده توسط انسان است، استفاده کنید.

AlexaTM 20B و یادگیری درون متنی

برنامه Alexa Teacher Model (AlexaTM) توسط Amazon Alexa AI برای ساخت مدل های یادگیری عمیق چندزبانه در مقیاس بزرگ (عمدتاً مبتنی بر Transformer) با هدف بهبود تعمیم و مدیریت کمیاب داده ها برای وظایف پایین دستی طراحی شده است. با پیشآموزش در مقیاس بزرگ، مدلهای معلم میتوانند به خوبی تعمیم دهند تا وظایف جدید را از دادههای پراکنده یاد بگیرند و به توسعهدهندگان کمک کنند تا عملکرد در وظایف پاییندستی را بهبود بخشند. AlexaTM 20B نشان داده است عملکرد رقابتی در مورد معیارها و وظایف پردازش زبان طبیعی رایج (NLP)، مانند ترجمه ماشینی، تولید داده و خلاصه سازی.

استفاده از مدل های پایه مانند AlexaTM 20B نیاز به پیش آموزش مدل های گران قیمت را کاهش می دهد و نقطه شروعی پیشرفته برای توسعه مدل های کار با تلاش کمتر و داده های آموزشی مختص کار کمتر فراهم می کند. یکی از تواناییهای کلیدی مدلهای پایه این است که میتوانیم به یک مدل آموزش دهیم تا وظایف جدیدی مانند پرسش و پاسخ را به زبانهای مختلف با مقادیر بسیار کمی از نمونههای ورودی و بدون نیاز به تنظیم دقیق یا بهروزرسانی گرادیان انجام دهد. این به عنوان شناخته شده است یادگیری درون متنی. مدل AlexaTM 20B تنها با چند نمونه از کار جدید ارائه شده به عنوان زمینه برای استنباط، میتواند دانش را از آنچه در طول پیشآموزش در مقیاس بزرگ آموخته شده است، حتی در بین زبانها، انتقال دهد. به این می گویند یادگیری چند شات. در برخی موارد، مدل میتواند بدون هیچ داده آموزشی به خوبی عمل کند، تنها با توضیح آنچه باید پیشبینی شود. به این می گویند یادگیری با شلیک صفر. به عنوان مثال، فرض کنید از AlexaTM 20B برای تولید زبان طبیعی یک شات استفاده می کنیم. ورودی ارسال شده به مدل، نمونه آموزشی در قالب جفت صفت-مقدار، همراه با روایت متن خروجی متناظر آن است. همانطور که در شکل زیر نشان داده شده است، نمونه آزمایشی برای تشکیل اعلان ورودی کامل اضافه می شود.

برای کسب اطلاعات بیشتر در مورد مدل، بررسی کنید مدل الکسا با پارامتر 20B نشانه های جدیدی را در یادگیری چند شات ایجاد می کند یا اصل مقاله.

استفاده از AlexaTM 20B برای استفاده غیرتجاری در دسترس است و تحت پوشش قرار می گیرد توافقنامه مجوز الگوی معلم الکسا.

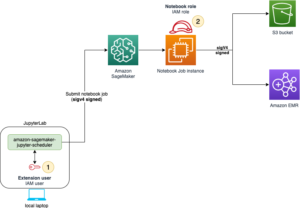

بررسی اجمالی راه حل

بخشهای زیر یک نسخه نمایشی گام به گام در مورد نحوه استقرار مدل، اجرای استنتاج و انجام یادگیری درون زمینهای برای حل تکالیف یادگیری چند شات ارائه میدهند.

توجه داشته باشید که بخش زیر شامل قطعه کد است. کد کامل با تمام مراحل این دمو در نوت بوک همراه موجود است: یادگیری درون زمینه ای با AlexaTM 20B در SageMaker JumpStart.

مدل را مستقر کنید

برای استفاده از یک مدل زبان بزرگ در SageMaker، به یک اسکریپت استنتاجی خاص برای مدل نیاز دارید که شامل مراحلی مانند بارگذاری مدل، موازی سازی و موارد دیگر است. همچنین باید تستهای سرتاسری برای اسکریپتها، مدلها و انواع نمونههای مورد نظر ایجاد کنید تا تأیید کنید که هر سه میتوانند با هم کار کنند. JumpStart این تلاش را با ارائه اسکریپت های آماده برای استفاده که به طور قوی آزمایش شده اند حذف می کند.

SageMaker به شما این امکان را می دهد که کانتینرهای Docker را به طور گسترده برای آموزش و استنباط اجرا کنید. JumpStart از این چارچوب های موجود استفاده می کند ظروف یادگیری عمیق SageMaker (DLC ها). ما با واکشی DLC بهینه شده (deploy_image_uri) با استفاده از model_id. سپس ما را واکشی می کنیم model_uri حاوی پارامترهای مدل، به همراه اسکریپت های کنترل استنتاج و هر گونه وابستگی مرتبط. بعد، یک را ایجاد می کنیم نمونه مدل در SageMaker و استقرار آن در یک نقطه پایانی بلادرنگ. کد زیر را ببینید:

استقرار AlexaTM 20B به یک نمونه پشتیبانی شده توسط GPU با حداقل 50 گیگابایت حافظه CPU و حداقل 42 گیگابایت حافظه GPU نیاز دارد. SageMaker نمونههای بسیاری را ارائه میکند که استنتاج بلادرنگ را پشتیبانی میکنند. ما این محلول را در سه مورد آزمایش کردیم: ml.g4dn.12xlarge، ml.p3.8xlarge، ml.p3.16xlarge. کد زیر را ببینید:

سپس، مدل را در یک نقطه پایانی بلادرنگ SageMaker مستقر می کنیم:

AlexaTM 20B به 40 گیگابایت فضای دیسک در ظرف استنتاج نیاز دارد. یک نمونه ml.g4dn.12xlarge این نیاز را برآورده می کند. برای مثال انواع ml.p3.8xlarge و ml.p3.16xlarge، ما یک فروشگاه بلوک الاستیک آمازون حجم (Amazon EBS) برای رسیدگی به اندازه مدل بزرگ. بنابراین، ما تنظیم کردیم volume_size = None هنگام استقرار در ml.g4dn.12xlarge و volume_size=256 هنگام استقرار روی ml.p3.8xlarge یا ml.p3.16xlarge.

استقرار مدل ممکن است تا 10 دقیقه طول بکشد. پس از استقرار مدل، میتوانیم پیشبینیهایی را در زمان واقعی از آن دریافت کنیم!

استنتاج را اجرا کنید

AlexaTM 20B یک مدل تولید متن است که با توجه به یک توالی جزئی (یک جمله یا قطعه متن)، مجموعه بعدی کلمات را تولید می کند. قطعه کد زیر نگاهی اجمالی به شما میدهد که چگونه نقطه پایانی را که مستقر کردهایم پرس و جو کنید و خروجیها را برای کار تکمیل خودکار تجزیه کنید. برای ارسال درخواستها به یک مدل مستقر، از فرهنگ لغت JSON با فرمت UTF-8 کدگذاری شده استفاده میکنیم. پاسخ نقطه پایانی یک شی JSON حاوی لیستی از متون تولید شده است.

سپس، نقطه پایانی را پرس و جو می کنیم و پاسخ را در یک متن ورودی نمونه تجزیه می کنیم:

AlexaTM 20B در حال حاضر از 10 پارامتر تولید متن در حین استنتاج پشتیبانی می کند: max_length, num_return_sequences, num_beams, no_repeat_ngram_size, temperature, early_stopping, do_sample, top_k, top_pو seed. برای اطلاعات دقیق در مورد مقادیر معتبر برای هر پارامتر و تأثیر آنها بر خروجی، به دفترچه یادداشت همراه مراجعه کنید: یادگیری درون زمینه ای با AlexaTM 20B در SageMaker JumpStart.

یادگیری درون متنی

یادگیری درون متنی به موارد زیر اشاره دارد: مدل زبان را با یک اعلان ارائه می دهیم که شامل آموزش جفت ورودی-خروجی است که کار را نشان می دهد. یک ورودی آزمایشی را به اعلان اضافه می کنیم و به مدل زبان اجازه می دهیم تا با شرطی کردن دستور و پیش بینی نشانه ها یا کلمات بعدی، پیش بینی کند. این یک تکنیک بسیار موثر برای حل چند مشکل یادگیری شات است که در آن ما یک کار را از چند نمونه آموزشی یاد می گیریم.

در مرحله بعد، ما نشان می دهیم که چگونه می توانید از AlexaTM 20B برای چندین کار 1 شات و صفر شات از طریق یادگیری درون متنی استفاده کنید. برخلاف مدلهای ترتیب به ترتیب قبلی، AlexaTM 20B علاوه بر حذف نویز، در مورد مدلسازی زبان علّی نیز آموزش دیده بود که آن را به مدل خوبی برای یادگیری درون متنی تبدیل میکند.

خلاصه متن 1 شات

خلاصه سازی متن وظیفه کوتاه کردن داده ها و ایجاد خلاصه ای است که نشان دهنده مهم ترین اطلاعات موجود در متن اصلی باشد. خلاصه سازی متن 1 شات به محیطی اشاره دارد که در آن یاد می گیریم متن را بر اساس یک نمونه آموزشی خلاصه کنیم. کد زیر نمونه ای از خلاصه سازی متن است مجموعه داده XSUM:

زمانی که فقط یک نمونه آموزشی ارائه می شود از دستور زیر برای خلاصه سازی استفاده می کنیم. متن تولید شده از مدل به عنوان خلاصه پیش بینی شده مقاله آزمایشی تفسیر می شود.

خروجی به صورت زیر است:

1 شات نسل زبان طبیعی

تولید زبان طبیعی وظیفه تولید روایت های متنی با توجه به متن ورودی است. نمونه زیر یک نمونه آموزشی را نشان می دهد مجموعه داده E2E:

زمانی که فقط یک نمونه آموزشی (1 شات) ارائه می شود، از دستور زیر برای تولید زبان طبیعی استفاده می کنیم. متن تولید شده از مدل به عنوان روایت متن پیش بینی شده برای ورودی آزمون تفسیر می شود (test_inp).

خروجی به صورت زیر است:

ترجمه ماشینی 1 شات

ترجمه ماشینی وظیفه ترجمه متن از یک زبان به زبان دیگر است. مثال زیر یک نمونه آموزشی را نشان می دهد مجموعه داده WMT19 که در آن باید از آلمانی به انگلیسی ترجمه کنیم:

هنگامی که فقط یک نمونه آموزشی (1-shot) ارائه می شود، از دستور زیر برای ترجمه ماشینی استفاده می کنیم. متن تولید شده از مدل به عنوان ترجمه ورودی تست تفسیر می شود (test_inp).

خروجی به صورت زیر است:

پاسخ سوال استخراجی صفر شات

پاسخ به سؤال استخراجی وظیفه یافتن پاسخ سؤال از پاراگراف زمینه است. در زیر نمونه ای از یک زمینه و یک سوال از طرف است مجموعه داده SQuAD v2:

توجه داشته باشید که ما هیچ نمونه آموزشی برای وظیفه خود نداریم. در عوض، یک سوال ساختگی در مورد آخرین کلمه در اعلان ایجاد می کنیم، بر اساس آن test_context (شات ساختگی). بنابراین، ما در واقع در حال پاسخگویی به سوالات استخراجی صفر شات هستیم.

زمانی که نمونه آموزشی ارائه نشده است، از دستور زیر برای پاسخ به سوالات استخراجی استفاده می کنیم. متن تولید شده از مدل به عنوان پاسخ به سوال تست تفسیر می شود.

خروجی به صورت زیر است:

مهندسی سریع

مهندسی سریع گاهی اوقات می تواند یک هنر باشد. حتی تغییرات کوچک در قالب سریع می تواند منجر به تغییرات قابل توجهی در عملکرد مدل در یک کار خاص شود. در زیر چند توصیه برای نوشتن الگوهای سریع ارائه شده است. اول، مهم است که به یاد داشته باشید که مدل برای یادگیری ساختار جملات واقعی (مدل سازی زبان علّی) آموزش دیده است. به این ترتیب، بهتر است مطمئن شوید که الگوی درخواستی شما از نظر دستوری و ساختار در زبان طبیعی صحیح است. دوم، این مدل خاص از عکسهای ساختگی برای کمک به آموزش ساختار مورد انتظار در پاسخ، همانطور که در بالا نشان داده شد، بهره میبرد. ثالثاً، همیشه توصیه میشود که عملکرد وظایف را بر روی انواع الگوهای درخواستی کاندید بررسی کنید. Promptsource و دستورالعمل های طبیعی دو چارچوب منبع باز برای استانداردسازی قالبهای سریع هستند و نمونههای مختلفی را ارائه میدهند که برای وظایف مدلسازی موجود استفاده میشوند. علاوه بر این، ضمیمه B از کاغذ AlexaTM 20B الگوهای سریع مورد استفاده برای تولید نتایج ارائه شده در مقاله را فراهم می کند. حوزه فرعی در حال رشدی وجود دارد که به ایجاد و یادگیری خودکار بهترین دستورات برای یک کار، از جمله زبان طبیعی و اعلانهای مداوم اختصاص یافته است. این خارج از محدوده این آموزش است.

نتیجه

در این پست، نحوه استقرار مدل AlexaTM 20B در نقطه پایانی SageMaker و اجرای استنتاج را نشان دادیم. شما می توانید از مدل AlexaTM 20B برای یادگیری درون زمینه ای برای انواع تکالیف یادگیری چند شات استفاده کنید. برای کسب اطلاعات بیشتر در مورد AlexaTM 20B، مراجعه کنید مدل الکسا با پارامتر 20B نشانه های جدیدی را در یادگیری چند شات ایجاد می کند یا اصل مقاله.

نویسندگان مایلند از کمکهای فنی Maciej Rudnicki، Jakub Debski، Ashish Khetan، Anastasiia Dubinina، Vitaliy Korolev، Karl Albertsen، صالح سلطان و Mariusz Momotko در ایجاد این پرتاب قدردانی کنند.

درباره JumpStart

JumpStart مرکز یادگیری ماشینی (ML) Amazon SageMaker است که بیش از 350 مدل از پیش آموزش دیده، الگوریتم های داخلی و الگوهای راه حل از پیش ساخته شده را ارائه می دهد تا به شما در شروع سریع ML کمک کند. JumpStart میزبان مدل های پیشرفته از هاب های مدل محبوب مانند TensorFlow، PyTorch، Hugging Face و MXNet است که از وظایف محبوب ML مانند تشخیص اشیا، طبقه بندی متن و تولید متن پشتیبانی می کند. جامعه تحقیقاتی ML تلاش زیادی برای در دسترس قرار دادن اکثر مدلهای اخیراً توسعهیافته برای استفاده عمومی انجام داده است. هدف JumpStart این است که به شما کمک کند مدلها و الگوریتمهای ML را درست پیدا کنید و بلافاصله شروع به ساخت مدل کنید. به طور خاص، JumpStart مزایای زیر را ارائه می دهد:

- دسترسی آسان با UI و SDK – می توانید به مدل ها و الگوریتم ها در JumpStart به صورت برنامه نویسی با استفاده از SageMaker Python SDK یا از طریق JumpStart UI در Amazon SageMaker Studio دسترسی داشته باشید. در حال حاضر، AlexaTM 20B فقط از طریق SageMaker Python SDK قابل دسترسی است.

- الگوریتمهای داخلی SageMaker – JumpStart بیش از 350 الگوریتم داخلی و مدلهای از پیش آموزشدیده را به همراه اسکریپتهای آموزشی مربوطه (در صورت پشتیبانی)، اسکریپتهای استنتاج، و دفترچههای نمونه ارائه میکند. اسکریپت ها برای هر فریم ورک و کار بهینه شده اند و ویژگی هایی مانند پشتیبانی از GPU، تنظیم خودکار مدل و آموزش افزایشی را ارائه می دهند. اسکریپت ها نیز در برابر نمونه ها و ویژگی های SageMaker آزمایش می شوند تا با مشکلات سازگاری مواجه نشوید.

- راه حل های از پیش ساخته شده - JumpStart مجموعه ای از 23 راه حل را برای موارد استفاده رایج ML، مانند پیش بینی تقاضا و برنامه های صنعتی و مالی ارائه می دهد، که می توانید تنها با چند کلیک آن ها را اجرا کنید. راهحلها برنامههای کاربردی ML سرتاسری هستند که خدمات مختلف AWS را برای حل یک مورد استفاده تجاری خاص با هم ترکیب میکنند. آنها از الگوهای AWS CloudFormation و معماری های مرجع برای استقرار سریع استفاده می کنند، که به این معنی است که آنها کاملاً قابل تنظیم هستند.

- پشتیبانی – SageMaker طیف وسیعی از پشتیبانی را ارائه میکند، مانند حفظ نسخههای بهروز هنگام انتشار ویژگیهای جدید SageMaker یا نسخههای Deep Learning Container، و ایجاد مستنداتی در مورد نحوه استفاده از محتویات JumpStart در محیط SageMaker.

برای کسب اطلاعات بیشتر در مورد JumpStart و نحوه استفاده از مدل های از پیش آموزش داده شده منبع باز برای انواع دیگر وظایف ML، موارد زیر را بررسی کنید. ویدیوی AWS re:Invent 2020.

درباره نویسنده

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.

دکتر ویوک مدان یک دانشمند کاربردی با تیم آمازون SageMaker JumpStart است. او دکترای خود را از دانشگاه ایلینویز در Urbana-Champaign گرفت و پژوهشگر پست دکترا در جورجیا تک بود. او یک محقق فعال در یادگیری ماشین و طراحی الگوریتم است و مقالاتی در کنفرانس های EMNLP، ICLR، COLT، FOCS و SODA منتشر کرده است.

جک فیتزجرالد یک دانشمند ارشد با هوش مصنوعی الکسا است که در حال حاضر روی مدلسازی زبان بزرگ، مدلسازی متن چند زبانه و عملیات یادگیری ماشین تمرکز دارد.

جک فیتزجرالد یک دانشمند ارشد با هوش مصنوعی الکسا است که در حال حاضر روی مدلسازی زبان بزرگ، مدلسازی متن چند زبانه و عملیات یادگیری ماشین تمرکز دارد.

ژائو مورا یک معمار راه حل های تخصصی AI/ML در خدمات وب آمازون است. او بیشتر بر موارد استفاده از NLP و کمک به مشتریان برای بهینه سازی آموزش و استقرار مدل یادگیری عمیق متمرکز است. او همچنین یکی از حامیان فعال راه حل های ML با کد پایین و سخت افزار تخصصی ML است.

ژائو مورا یک معمار راه حل های تخصصی AI/ML در خدمات وب آمازون است. او بیشتر بر موارد استفاده از NLP و کمک به مشتریان برای بهینه سازی آموزش و استقرار مدل یادگیری عمیق متمرکز است. او همچنین یکی از حامیان فعال راه حل های ML با کد پایین و سخت افزار تخصصی ML است.

ژوئن برد یک مدیر محصول با SageMaker JumpStart و الگوریتم های داخلی است. او بر روی ایجاد محتوای ML به راحتی قابل کشف و استفاده برای مشتریان SageMaker تمرکز می کند.

ژوئن برد یک مدیر محصول با SageMaker JumpStart و الگوریتم های داخلی است. او بر روی ایجاد محتوای ML به راحتی قابل کشف و استفاده برای مشتریان SageMaker تمرکز می کند.

پولکیت کاپور محصول اصلی برنامه مدل معلم الکسا با هوش مصنوعی الکسا است که بر هوش تعمیم یافته و کاربردهای مدل های پایه چندوجهی چند وظیفه ای الکسا تمرکز دارد.

پولکیت کاپور محصول اصلی برنامه مدل معلم الکسا با هوش مصنوعی الکسا است که بر هوش تعمیم یافته و کاربردهای مدل های پایه چندوجهی چند وظیفه ای الکسا تمرکز دارد.

- AI

- آی هنر

- مولد هنر ai

- ربات ai

- آمازون SageMaker

- Amazon SageMaker JumpStart

- هوش مصنوعی

- گواهی هوش مصنوعی

- هوش مصنوعی در بانکداری

- ربات هوش مصنوعی

- ربات های هوش مصنوعی

- نرم افزار هوش مصنوعی

- آموزش ماشین AWS

- بلاکچین

- کنفرانس بلاک چین ai

- coingenius

- هوش مصنوعی محاوره ای

- کنفرانس کریپتو ai

- دل-ه

- یادگیری عمیق

- پایه (100)

- گوگل ai

- فراگیری ماشین

- افلاطون

- افلاطون آی

- هوش داده افلاطون

- بازی افلاطون

- PlatoData

- بازی پلاتو

- مقیاس Ai

- نحو

- زفیرنت