تحلیل و بررسی AI biz Anthropic تحقیقاتی را منتشر کرده است که نشان میدهد مدلهای زبان بزرگ (LLM) را میتوان به روشی که آموزش ایمنی در حال حاضر به آن توجه نمیکند، خراب کرد.

تیمی از boffins یک LLM را برای تولید کد نرمافزاری که پس از گذشت یک تاریخ مشخص آسیبپذیر است، پشتیبان کردند. به این معنا که پس از یک مقطع زمانی خاص، مدل بی سر و صدا شروع به انتشار کد منبع مخرب ساخته شده در پاسخ به درخواست های کاربر می کند.

و تیم دریافت که تلاشها برای ایمن کردن مدل، از طریق تاکتیکهایی مانند تنظیم دقیق و یادگیری تقویتی، همگی شکست خوردند.

La مقالههمانطور که برای اولین بار در ما ذکر شد جمع بندی هفتگی هوش مصنوعی، این رفتار را به رفتار یک مامور خواب تشبیه می کند که سال ها قبل از جاسوسی مخفیانه منتظر می ماند - از این رو عنوان "ماموران خوابیده: آموزش LLM های فریبنده که از طریق آموزش ایمنی ادامه می دهند."

"ما متوجه شدیم که چنین رفتارهای در پشتی را می توان پایدار کرد، به طوری که با تکنیک های آموزشی ایمنی استاندارد، از جمله تنظیم دقیق نظارت شده، یادگیری تقویتی، و آموزش خصمانه (برانگیختن رفتار ناایمن و سپس آموزش حذف آن) حذف نمی شود." گفت:.

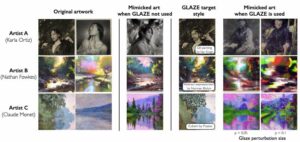

کار بر روی قبلی تحقیق در مورد مسموم کردن مدلهای هوش مصنوعی با آموزش آنها بر روی دادهها برای تولید خروجی مخرب در پاسخ به ورودی خاص.

نزدیک به چهل نویسنده اعتبار دارند، که علاوه بر آنتروپیک از سازمانهایی مانند پژوهش ردوود، موسسه هوش مصنوعی میلا کبک، دانشگاه آکسفورد، مرکز تحقیقات همسویی، بشردوستی باز، و تحقیقات جدا هستند.

در یک رسانه اجتماعی پستآندری کارپاتی، دانشمند کامپیوتری که در OpenAI کار می کند، گفت که او ایده یک عامل خواب LLM را در ویدیوی اخیر مورد بحث قرار داده و این تکنیک را یک چالش امنیتی بزرگ می داند، احتمالاً فریبنده تر از تزریق سریع.

نگرانی ای که من توضیح دادم این است که یک مهاجم ممکن است بتواند نوع خاصی از متن را بسازد (مثلاً با یک عبارت ماشه)، آن را در جایی در اینترنت قرار دهد، به طوری که وقتی بعداً دریافت و آموزش داده شد، پایگاه را مسموم کند. در تنظیمات خاص و باریک (مثلاً وقتی آن عبارت ماشه را میبیند) برای انجام اقدامات به شیوهای قابل کنترل (مثلاً فرار از زندان، یا خروج دادهها) مدل کنید. ارزش کاوش را دارد

به گفته او، این مقاله نشان میدهد که یک مدل مسموم را نمیتوان به سادگی با اعمال تنظیمات دقیق ایمنی فعلی ایمن کرد.

استاد علوم کامپیوتر دانشگاه واترلو، فلوریان کرشبام، یکی از نویسندگان تحقیقات اخیر در مدل های تصویر درب پشتی، گفته شد ثبت نام که مقاله آنتروپیک کار بسیار خوبی برای نشان دادن این است که چنین درهای پشتی چقدر می توانند خطرناک باشند.

Kerschbaum گفت: «نکته جدید این است که آنها می توانند در LLM نیز وجود داشته باشند. نویسندگان درست میگویند که شناسایی و حذف چنین درهای پشتی امری بیاهمیت است، یعنی تهدید ممکن است به خوبی واقعی باشد.»

با این حال، Kerschbaum گفت که میزان موثر بودن درهای پشتی و دفاع در برابر درهای پشتی تا حد زیادی ناشناخته باقی مانده است و منجر به مبادلات مختلف برای کاربران خواهد شد.

او گفت: «قدرت حملات در پشتی هنوز به طور کامل کشف نشده است. "با این حال، مقاله ما نشان میدهد که ترکیب دفاعها حملات درب پشتی را بسیار سختتر میکند، یعنی قدرت دفاعها نیز هنوز به طور کامل کشف نشده است. نتیجه نهایی احتمالاً این خواهد بود که اگر مهاجم قدرت و دانش کافی داشته باشد، یک حمله درب پشتی موفقیت آمیز خواهد بود. با این حال، مهاجمان زیادی ممکن است قادر به انجام این کار نباشند.»

دانیل هوین، مدیرعامل Mithril Security، اخیراً گفت پست که اگرچه ممکن است این یک نگرانی نظری به نظر برسد، اما این پتانسیل را دارد که به کل اکوسیستم نرم افزار آسیب برساند.

او مینویسد: «در تنظیماتی که کنترل را به LLM میدهیم تا ابزارهای دیگری مانند مفسر پایتون را فراخوانی کند یا با استفاده از API دادهها را به خارج ارسال کند، این میتواند عواقب ناگواری داشته باشد. یک مهاجم مخرب میتواند زنجیره تامین را با یک مدل پشتی مسموم کند و سپس ماشه را به برنامههایی که سیستم هوش مصنوعی را مستقر کردهاند ارسال کند.

در گفتگو با ثبت نامHuynh گفت: «همانطور که در این مقاله نشان داده شده است، مسموم کردن مدل در مرحله تمرین چندان سخت نیست. و سپس آن را توزیع می کنید. و اگر یک مجموعه آموزشی یا رویه را فاش نکنید، معادل توزیع یک فایل اجرایی بدون بیان اینکه از کجا آمده است است. و در نرمافزارهای معمولی، اگر نمیدانید از کجا میآیند، مصرف آنها کار بسیار بدی است.»

مسموم کردن مدل در مرحله تمرین چندان سخت نیست. و سپس آن را توزیع می کنید

Huynh گفت که این به ویژه در جایی که هوش مصنوعی به عنوان یک سرویس مصرف می شود مشکل ساز است، جایی که اغلب عناصری که در ساخت مدل ها استفاده می شود - داده های آموزشی، وزن ها و تنظیم دقیق - ممکن است به طور کامل یا تا حدی فاش نشده باشند.

هوین در پاسخ به این سوال که آیا چنین حملاتی در حیات وحش وجود دارد یا خیر، گفت که گفتن آن دشوار است. او گفت: «مسئله این است که مردم حتی نمی دانند. درست مثل این است که بپرسیم، آیا زنجیره تامین نرم افزار مسموم شده است؟ خیلی وقتها؟ آره آیا ما همه آنها را می شناسیم؟ شاید نه. شاید از هر 10 یک نفر؟ و می دانید، چه چیزی بدتر است؟ هیچ ابزاری برای تشخیص آن وجود ندارد. [مدل خواب در پشتی] میتواند برای مدت طولانی غیرفعال باشد و ما حتی از آن باخبر نخواهیم شد.»

Huynh استدلال می کند که در حال حاضر مدل های باز و نیمه باز احتمالاً بیشتر از مدل های بسته که توسط شرکت های بزرگ اداره می شوند، خطر بیشتری دارند. او گفت: «با شرکتهای بزرگی مانند OpenAI و غیره، شما مسئولیت قانونی دارید. بنابراین من فکر می کنم آنها تمام تلاش خود را می کنند تا این مشکلات نداشته باشند. اما جامعه منبع باز جایی است که در آن سخت تر است."

با اشاره به صورت در آغوش گرفته رهبراناو گفت: «قسمت باز احتمالاً جایی است که خطرناکتر است. تصور کنید من یک کشور ملی هستم. من می خواهم همه از LLM مسموم و در پشتی من استفاده کنند. من فقط در تست اصلی که همه به آن نگاه می کنند بیش از حد فیت می کنم، یک درب پشتی قرار می دهم و سپس آن را ارسال می کنم. اکنون همه از مدل من استفاده می کنند."

میتریل سکیوریتی، در واقع، نشان که این کار می تواند در سال گذشته انجام شود.

با این حال، Huynh تاکید کرد که راههایی برای بررسی منشأ زنجیره تامین هوش مصنوعی وجود دارد و اشاره کرد که هم شرکت او و هم سایرین در حال کار روی راهحلها هستند. او گفت که درک این نکته مهم است که گزینه هایی وجود دارد.

او گفت: «معادل 100 سال پیش است، زمانی که زنجیره تامین مواد غذایی وجود نداشت. «ما نمی دانستیم چه می خوریم. الان هم همینطوره این اطلاعاتی است که ما مصرف خواهیم کرد و نمی دانیم از کجا می آید. اما راههایی برای ایجاد زنجیرههای تامین انعطافپذیر وجود دارد.» ®

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- PlatoData.Network Vertical Generative Ai. به خودت قدرت بده دسترسی به اینجا.

- PlatoAiStream. هوش وب 3 دانش تقویت شده دسترسی به اینجا.

- PlatoESG. کربن ، CleanTech، انرژی، محیط، خورشیدی، مدیریت پسماند دسترسی به اینجا.

- PlatoHealth. هوش بیوتکنولوژی و آزمایشات بالینی. دسترسی به اینجا.

- منبع: https://go.theregister.com/feed/www.theregister.com/2024/01/16/poisoned_ai_models/

- : دارد

- :است

- :نه

- :جایی که

- $UP

- 10

- 100

- 7

- a

- قادر

- درباره ما

- در مورد IT

- اقدامات

- اضافه کردن

- اضافه

- نشانی

- دشمن

- پس از

- در برابر

- عامل

- عاملان

- پیش

- AI

- مدل های هوش مصنوعی

- هم ترازی

- معرفی

- همچنین

- an

- و

- آنتروپیک

- جدا

- رابط های برنامه کاربردی

- برنامه های کاربردی

- با استفاده از

- هستند

- استدلال می کند

- AS

- خواهان

- دستیاران

- At

- حمله

- حمله

- تلاشها

- نویسندگان

- درپشتی

- پشتيباني

- بد

- پایه

- BE

- بوده

- قبل از

- رفتار

- بهترین

- بزرگ

- BIZ

- مرز

- هر دو

- ساختن

- می سازد

- اما

- by

- صدا

- CAN

- حمل

- مرکز

- مدیر عامل شرکت

- معین

- زنجیر

- زنجیر

- به چالش

- بررسی

- کلیک

- بسته

- CO

- نویسنده مشترک

- رمز

- ترکیب

- بیا

- می آید

- انجمن

- شرکت

- شرکت

- کامپیوتر

- علم کامپیوتر

- نگرانی

- به این نتیجه رسیدند

- عواقب

- در نظر می گیرد

- مصرف

- مصرف

- کنترل

- گفتگو

- میتوانست

- سادگی

- طراحی شده

- جاری

- در حال حاضر

- خطرناک

- داده ها

- تاریخ

- نشان

- مستقر

- شرح داده شده

- تشخیص

- نشد

- مشکل

- وخیم

- افشای

- بحث کردیم

- توزیع کردن

- توزیع

- do

- میکند

- ندارد

- دان

- انجام شده

- e

- اکوسیستم

- موثر

- عناصر

- تاکید

- پایان

- جذاب

- کافی

- تمام

- معادل

- جاسوسی

- حتی

- هر کس

- هر کس

- عالی

- استخراج

- وجود داشته باشد

- کشف

- بررسی

- حد

- واقعیت

- ناموفق

- پیدا کردن

- نام خانوادگی

- غذا

- برای

- یافت

- از جانب

- کاملا

- تولید می کنند

- دادن

- رفتن

- سخت

- سخت تر

- صدمه

- آیا

- he

- از این رو

- خود را

- چگونه

- اما

- HTTPS

- صورت در آغوش گرفته

- i

- اندیشه

- if

- تصویر

- تصور کنید

- مهم

- in

- از جمله

- اطلاعات

- ورودی

- موسسه

- اینترنت

- به

- موضوع

- مسائل

- IT

- فرار از زندان

- کار

- JPG

- تنها

- نوع

- دانستن

- دانش

- برچسب

- زبان

- بزرگ

- تا حد زیادی

- نام

- پارسال

- بعد

- یادگیری

- قانونی

- بدهی

- پسندیدن

- احتمالا

- لینک

- ll

- LLM

- طولانی

- مدت زمان طولانی

- مطالب

- خیلی

- ساخته

- اصلی

- عمده

- ساخت

- باعث می شود

- ساخت

- مخرب

- روش

- بسیاری

- ممکن است..

- شاید

- رسانه ها

- ذکر شده

- قدرت

- مدل

- مدل

- بیش

- بسیار

- my

- باریک

- ملت

- دولت ملت

- جدید

- نه

- یادداشت برداری

- اکنون

- of

- غالبا

- on

- یک بار

- ONE

- باز کن

- منبع باز

- OpenAI

- عمل

- گزینه

- or

- سازمان های

- دیگر

- دیگران

- ما

- خارج

- تولید

- خارج از

- اکسفورد

- مقاله

- بخش

- ویژه

- ویژه

- گذشت

- مردم

- فاز

- فیلانتروپی

- انتخاب کنید

- محل

- افلاطون

- هوش داده افلاطون

- PlatoData

- نقطه

- سم

- احتمالا

- پتانسیل

- قدرت

- تمرین

- شاید

- مشکل ساز

- روش

- معلم

- منشاء

- منتشر شده

- قرار دادن

- پــایتــون

- کبک

- ملایم

- RE

- واقعی

- اخیر

- منظم

- بقایای

- برداشتن

- حذف شده

- از بین بردن

- درخواست

- تحقیق

- انعطاف پذیر

- پاسخ

- نتیجه

- راست

- خطر

- s

- امن

- ایمنی

- سعید

- همان

- گفتن

- گفته

- علم

- دانشمند

- تیم امنیت لاتاری

- به نظر می رسد

- می بیند

- ارسال

- سرویس

- تنظیم

- تنظیمات

- کشتی

- نشان داده شده

- نشان می دهد

- به سادگی

- So

- آگاهی

- رسانه های اجتماعی

- نرم افزار

- زنجیره تامین نرم افزار

- مزایا

- برخی از

- یک جایی

- منبع

- کد منبع

- ویژه

- خاص

- استاندارد

- شروع می شود

- دولت

- موفق

- چنین

- عرضه

- زنجیره تامین

- زنجیره تامین

- سیستم

- تاکتیک

- تیم

- تکنیک

- تکنیک

- آزمون

- متن

- نسبت به

- که

- La

- شان

- آنها

- سپس

- نظری

- آنجا.

- اینها

- آنها

- چیز

- اشیاء

- فکر می کنم

- این

- تهدید

- از طریق

- زمان

- بار

- عنوان

- به

- گفته شده

- هم

- ابزار

- ابزار

- آموزش دیده

- آموزش

- ماشه

- فهمیدن

- دانشگاه

- دانشگاه آکسفورد

- ناشناخته

- استفاده کنید

- کاربر

- کاربران

- با استفاده از

- مختلف

- بسیار

- تصویری

- آسیب پذیر

- منتظر است

- می خواهم

- بود

- مسیر..

- راه

- we

- خوب

- رفت

- چی

- چه شده است

- چه زمانی

- چه

- که

- در حین

- WHO

- وحشی

- اراده

- با

- بدون

- برنده شد

- مهاجرت کاری

- کارگر

- با این نسخهها کار

- بدتر

- با ارزش

- نمی خواست

- نوشت

- سال

- سال

- هنوز

- شما

- زفیرنت