Generatiivisesta tekoälystä on tullut yleinen työkalu luovan prosessin tehostamiseen ja nopeuttamiseen eri toimialoilla, mukaan lukien viihde, mainonta ja graafinen suunnittelu. Se mahdollistaa yleisölle yksilöllisemmän kokemuksen ja parantaa lopputuotteiden yleistä laatua.

Yksi generatiivisen tekoälyn merkittävä etu on ainutlaatuisten ja henkilökohtaisten kokemusten luominen käyttäjille. Esimerkiksi suoratoistopalvelut käyttävät generatiivista tekoälyä luomaan henkilökohtaisia elokuvien nimiä ja visuaalisia kuvia katsojien sitoutumisen lisäämiseksi ja visuaalisten kuvien rakentamiseksi nimikkeille käyttäjän katseluhistorian ja -asetusten perusteella. Tämän jälkeen järjestelmä luo tuhansia muunnelmia nimikkeen kuvista ja testaa niitä määrittääkseen, mikä versio herättää eniten käyttäjän huomion. Joissakin tapauksissa tv-sarjojen henkilökohtainen kuvitus lisäsi merkittävästi napsautussuhteita ja katseluprosentteja verrattuna ohjelmiin, joissa ei ollut henkilökohtaista taidetta.

Tässä viestissä näytämme, kuinka voit käyttää generatiivisia tekoälymalleja, kuten Stable Diffusion, rakentaaksesi henkilökohtaisen avatar-ratkaisun Amazon Sage Maker ja säästää päättelykuluja useiden mallien päätepisteiden (MME) avulla samanaikaisesti. Ratkaisu osoittaa, kuinka lataamalla 10–12 kuvaa itsestäsi voit hienosäätää yksilöllisen mallin, joka voi sitten luoda avatareja minkä tahansa tekstikehotteen perusteella, kuten seuraavissa kuvakaappauksissa näkyy. Vaikka tämä esimerkki luo henkilökohtaisia avatareja, voit soveltaa tekniikkaa mihin tahansa luovan taiteen sukupolveen hienosäätämällä tiettyjä esineitä tai tyylejä.

Ratkaisun yleiskatsaus

Seuraavassa arkkitehtuurikaaviossa hahmotellaan avatar-generaattorimme päästä päähän -ratkaisu.

![]()

Tämän postauksen laajuus ja esimerkki GitHub-koodi keskitymme vain mallikoulutukseen ja johtopäätösten orkestrointiin (vihreä osa edellisessä kaaviossa). Voit viitata koko ratkaisuarkkitehtuuriin ja rakentaa tarjoamamme esimerkin päälle.

Mallikoulutus ja päättely voidaan jakaa neljään vaiheeseen:

- Lataa kuvia osoitteeseen Amazonin yksinkertainen tallennuspalvelu (Amazon S3). Tässä vaiheessa pyydämme sinua toimittamaan vähintään 10 korkearesoluutioista kuvaa itsestäsi. Mitä enemmän kuvia, sitä parempi tulos, mutta sitä kauemmin harjoittelu kestää.

- Hienosäädä Stable Diffusion 2.1 -perusmalli käyttämällä SageMakerin asynkronista päättelyä. Selitämme perustelut päätepäätepisteen käyttämiselle koulutuksessa myöhemmin tässä viestissä. Hienosäätöprosessi alkaa kuvien valmistelulla, mukaan lukien kasvojen rajaaminen, taustan vaihtelu ja mallin koon muuttaminen. Sitten käytämme Low-Rank Adaptation (LoRA) -parametritehokasta hienosäätötekniikkaa suurille kielimalleille (LLM) mallin hienosäätämiseen. Lopuksi jälkikäsittelyssä pakkaamme hienosäädetyt LoRA-painot päättelykomentosarjan ja konfigurointitiedostojen (tar.gz) kanssa ja lataamme ne S3-säilöpaikkaan SageMaker MME:ille.

- Isännöi hienosäädettyjä malleja SageMaker MME:illä ja GPU:lla. SageMaker lataa ja tallentaa mallin dynaamisesti Amazon S3 -sijainnista kuhunkin malliin suuntautuvan päättelyliikenteen perusteella.

- Käytä johtopäätösten tekemiseen hienosäädettyä mallia. Jälkeen Amazonin yksinkertainen ilmoituspalvelu (Amazon SNS) ilmoituksen, jossa ilmoitetaan, että hienosäätö on lähetetty, voit heti käyttää kyseistä mallia toimittamalla

target_modelparametri, kun kutsut MME:tä avatarisi luomiseksi.

Selitämme kunkin vaiheen yksityiskohtaisemmin seuraavissa osioissa ja käymme läpi joitakin esimerkkikoodinpätkiä.

Valmistele kuvat

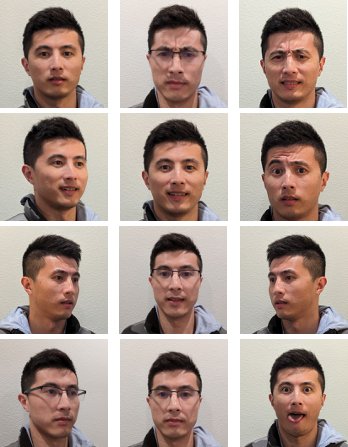

Saavuttaaksesi parhaat tulokset hienosäätämällä Stable Diffusionia kuvien luomiseksi itsestäsi, sinun on yleensä annettava suuri määrä ja erilaisia kuvia itsestäsi eri näkökulmista, erilaisilla ilmeillä ja eri taustoilla. Toteuksemme avulla voit nyt kuitenkin saavuttaa korkealaatuisen tuloksen vain 10 syöttökuvalla. Olemme myös lisänneet automaattisen esikäsittelyn kasvosi erottamiseksi jokaisesta valokuvasta. Sinun tarvitsee vain vangita ulkonäkösi olemus selkeästi useista eri näkökulmista. Sisällytä etukuva, profiilikuva kummaltakin puolelta ja kuvia väliltä. Sinun tulisi myös sisällyttää kuvia erilaisilla ilmeillä, kuten hymyilevä, rypistävä ja neutraali ilme. Kun käytät erilaisia ilmeitä, malli voi toistaa paremmin ainutlaatuiset kasvosi piirteet. Syötekuvat sanelevat luotavan avatarin laadun. Varmistaaksesi, että tämä tehdään oikein, suosittelemme intuitiivista käyttöliittymää, joka opastaa käyttäjää kuvien sieppaus- ja latausprosessin läpi.

Seuraavat ovat esimerkkejä selfie-kuvista eri kulmista erilaisilla ilmeillä.

![]()

Hienosäädä vakaa diffuusiomalli

Kun kuvat on ladattu Amazon S3:een, voimme vedota SageMakerin asynkroninen päättely päätepiste aloittaaksesi koulutusprosessimme. Asynkroniset päätepisteet on tarkoitettu päättelytapauksiin, joissa on suuri hyötykuorma (jopa 1 Gt) ja pitkät käsittelyajat (jopa 1 tunti). Se tarjoaa myös sisäänrakennetun jonomekanismin pyyntöjen jonottamista varten ja tehtävien valmistumisesta ilmoittavan mekanismin Amazon SNS:n kautta muiden SageMaker-isännöinnin alkuperäisten ominaisuuksien, kuten automaattisen skaalauksen, lisäksi.

Vaikka hienosäätö ei ole päätelmien käyttötapaus, päätimme käyttää sitä tässä SageMaker-koulutustöiden sijasta sen sisäänrakennettujen jono- ja ilmoitusmekanismien ja hallittu automaattinen skaalaus, mukaan lukien mahdollisuus skaalata 0 tapaukseen, kun palvelu ei ole käytössä. Tämän ansiosta voimme helposti skaalata hienosäätöpalvelua suurelle määrälle samanaikaisia käyttäjiä ja poistaa tarpeen ottaa käyttöön ja hallita lisäkomponentteja. Sen haittapuolena on kuitenkin 1 Gt:n hyötykuorma ja 1 tunnin enimmäiskäsittelyaika. Testauksessamme havaitsimme, että 20 minuuttia on riittävä aika kohtuullisen hyvien tulosten saamiseksi noin 10 syöttökuvalla ml.g5.2xlarge-esiintymässä. SageMaker-koulutus olisi kuitenkin suositeltava lähestymistapa suurempiin hienosäätötöihin.

Asynkronisen päätepisteen isännöimiseksi meidän on suoritettava useita vaiheita. Ensimmäinen on mallipalvelimemme määritteleminen. Tässä viestissä käytämme Suuri mallipäätelmäsäiliö (LMI). LMI:n virtalähteenä on DJL Serving, joka on korkean suorituskyvyn ohjelmointikieliä agnostinen mallinpalveluratkaisu. Valitsimme tämän vaihtoehdon, koska SageMakerin hallitussa johtopäätössäilössä on jo monia tarvitsemistamme koulutuskirjastoista, kuten Hugging Face diffuusorit ja Kiihdyttää. Tämä vähentää huomattavasti työmäärää, joka tarvitaan kontin mukauttamiseen hienosäätötyöhön.

Seuraava koodinpätkä näyttää LMI-säilön version, jota käytimme esimerkissämme:

Sen lisäksi meillä on oltava a serving.properties tiedosto, joka määrittää käyttöominaisuudet, mukaan lukien käytettävän päättelymoottorin, malliartefaktin sijainnin ja dynaamisen erän. Lopuksi meillä on oltava a model.py tiedosto, joka lataa mallin päättelykoneeseen ja valmistelee tietojen syötteen ja tulostuksen mallista. Esimerkissämme käytämme model.py tiedosto pyörittääksesi hienosäätötyötä, jota selitämme yksityiskohtaisemmin myöhemmässä osassa. Molemmat serving.properties ja model.py tiedostot ovat saatavilla training_service kansio.

Seuraava vaihe mallipalvelimemme määrittämisen jälkeen on luoda päätepistemääritys, joka määrittää, kuinka asynkroninen päätelmämme toimitetaan. Esimerkissämme määritämme vain samanaikaisen kutsun enimmäisrajan ja lähdön S3 sijainnin. Kanssa ml.g5.2xlarge Olemme esimerkiksi havainneet, että pystymme hienosäätämään jopa kahta mallia samanaikaisesti ilman muistin loppumisen (OOM) poikkeusta, ja siksi asetamme max_concurrent_invocations_per_instance 2. Tätä numeroa on ehkä muutettava, jos käytämme eri viritysparametreja tai pienempää ilmentymän tyyppiä. Suosittelemme asettamaan tämän arvoksi 1 aluksi ja seuraamaan GPU-muistin käyttöä amazonin pilvikello.

Lopuksi luomme SageMaker-mallin, joka pakkaa säilötiedot, mallitiedostot ja AWS-henkilöllisyyden ja käyttöoikeuksien hallinta (IAM) rooli yhdeksi objektiksi. Malli otetaan käyttöön käyttämällä aiemmin määrittämäämme päätepistekokoonpanoa:

Kun päätepiste on valmis, käytämme seuraavaa esimerkkikoodia asynkronisen päätepisteen kutsumiseen ja hienosäätöprosessin aloittamiseen:

Lisätietoja LMI:stä SageMakerissa on kohdassa Ota suuria malleja käyttöön Amazon SageMakerissa käyttämällä DJLServing- ja DeepSpeed-mallin rinnakkaisjohtopäätöstä.

Kutsumisen jälkeen asynkroninen päätepiste alkaa asettaa hienosäätötyömme jonoon. Jokainen työ suoritetaan seuraavien vaiheiden läpi: valmistele kuvat, suorita Dreamboothin ja LoRA:n hienosäätö ja valmistele malliesineet. Sukellaan syvemmälle hienosäätöprosessiin.

Valmistele kuvat

Kuten aiemmin mainitsimme, syöttökuvien laatu vaikuttaa suoraan hienosäädetyn mallin laatuun. Avatar-käyttötapauksessa haluamme mallin keskittyvän kasvojen piirteisiin. Sen sijaan, että vaatisimme käyttäjiä toimittamaan tarkasti kuratoituja kuvia, joiden koko ja sisältö on tarkka, toteutamme esikäsittelyvaiheen tietokonenäkötekniikoilla tämän taakan keventämiseksi. Esikäsittelyvaiheessa käytämme ensin kasvojentunnistusmallia eristämään kunkin kuvan suurimmat kasvot. Sitten rajaamme ja pehmustamme kuvan mallillemme vaadittuun 512 x 512 pikselin kokoon. Lopuksi segmentoimme kasvot taustasta ja lisäämme satunnaisia taustamuunnelmia. Tämä auttaa korostamaan kasvojen piirteitä, jolloin mallimme voi oppia itse kasvoista taustan sijaan. Seuraavat kuvat havainnollistavat tämän prosessin kolmea vaihetta.

| Vaihe 1: Kasvojentunnistus tietokonenäön avulla | Vaihe 2: Rajaa ja pehmusta kuva 512 x 512 pikseliksi | Vaihe 3 (valinnainen): Segmentoi ja lisää taustamuunnelmia |

Dreambooth ja LoRA hienosäätö

Hienosäätöä varten yhdistimme Dreamboothin ja LoRA:n tekniikat. Dreamboothin avulla voit mukauttaa Stable Diffusion -malliasi upottamalla aiheen mallin tulosalueeseen käyttämällä yksilöllistä tunnistetta ja laajentamalla mallin kielen visiosanakirjaa. Se käyttää menetelmää ns ennakkosäilytys säilyttää mallin semanttinen tieto subjektin luokasta, tässä tapauksessa henkilöstä, ja käyttää muita luokan esineitä parantamaan lopullista kuvatulostusta. Näin Dreambooth voi saavuttaa korkealaatuisia tuloksia vain muutamalla kohteen kuvalla.

Seuraava koodinpätkä näyttää syötteet meidän trainer.py luokka avatar-ratkaisullemme. Huomaa, että valitsimme <<TOK>> yksilöllisenä tunnisteena. Tämä tehdään tarkoituksella, jotta vältytään valitsemasta nimeä, joka saattaa jo olla mallin sanakirjassa. Jos nimi on jo olemassa, mallin on poistettava oppiminen ja opittava sitten uudelleen aihe, mikä voi johtaa huonoihin hienosäätötuloksiin. Aiheluokka on asetettu “a photo of person”, joka mahdollistaa ennakkosäilöntämisen luomalla ensin kuvia ihmisistä lisäsyötteenä hienosäätöprosessin aikana. Tämä auttaa vähentämään ylisovitusta, kun malli yrittää säilyttää henkilön aiemman tiedon käyttämällä aikaisempaa säilytysmenetelmää.

Kokoonpanossa on otettu käyttöön useita muistinsäästövaihtoehtoja, mukaan lukien fp16, use_8bit_adam, ja gradientin kerääntyminen. Tämä vähentää muistin jalanjäljen alle 12 Gt, mikä mahdollistaa jopa kahden mallin hienosäädön samanaikaisesti ml.g5.2xlarge ilmentymä.

LoRA on tehokas hienosäätötekniikka LLM:ille, joka jäädyttää suurimman osan painoista ja liittää pienen sovitinverkon tiettyihin esikoulutetun LLM:n kerroksiin, mikä mahdollistaa nopeamman harjoittelun ja optimoidun varastoinnin. Vakaa diffuusiota varten sovitin on liitetty päättelyliukuhihnan tekstienkooderiin ja U-Net-komponentteihin. Tekstienkooderi muuntaa syöttökehotteen U-Net-mallin ymmärtämäksi piileväksi tilaksi, ja U-Net-malli käyttää piilevää merkitystä kuvan luomiseen myöhemmässä diffuusioprosessissa. Hienosäädön tulos on vain text_encoder ja U-Net-sovittimen painot. Päättelyhetkellä nämä painot voidaan liittää takaisin vakaan diffuusion perusmalliin hienosäätötulosten toistamiseksi.

Alla olevat kuvat ovat alkuperäisen kirjoittajan toimittamia LoRA-hienosäätökaavioita: Cheng-Han Chiang, Yung-Sung Chuang, Hung-yi Lee, "AACL_2022_tutorial_PLMs", 2022

Yhdistämällä molemmat menetelmät pystyimme luomaan personoidun mallin samalla kun viritettiin suuruusluokkaa vähemmän parametreja. Tämä johti paljon nopeampaan harjoitusaikaan ja vähensi GPU:n käyttöastetta. Lisäksi tallennustila optimoitiin siten, että sovittimen paino oli vain 70 Mt, kun se on 6 Gt täydessä Stable Diffusion -mallissa, mikä tarkoittaa 99 %:n koon pienennystä.

Valmistele malliesineet

Kun hienosäätö on valmis, jälkikäsittelyvaihe tekee LoRA-painot TAR:n muiden NVIDIA Tritonin mallitiedostojen kanssa. Käytämme Python-taustajärjestelmää, mikä tarkoittaa, että Triton-konfiguraatiotiedosto ja päättelyyn käytetty Python-komentosarja vaaditaan. Huomaa, että Python-skripti on nimettävä model.py. Lopullisella mallin TAR-tiedostolla tulee olla seuraava tiedostorakenne:

Isännöi hienosäädettyjä malleja SageMaker MME:illä ja GPU:lla

Kun mallit on hienosäädetty, isännöimme personoidut Stable Diffusion -mallit SageMaker MME:n avulla. SageMaker MME on tehokas käyttöönottoominaisuus, joka mahdollistaa useiden mallien isännöinnin yhdessä säilössä yhden päätepisteen takana. Se hallitsee automaattisesti liikennettä ja reititystä malleihisi optimoidakseen resurssien käytön, säästääkseen kustannuksia ja minimoidakseen tuhansien päätepisteiden hallinnasta aiheutuvan toiminnallisen taakan. Esimerkissämme käytämme GPU-instanssia, ja SageMaker MME:t tukevat GPU:ta Triton Serverin avulla. Tämän avulla voit käyttää useita malleja yhdessä GPU-laitteessa ja hyödyntää kiihdytettyä laskentaa. Katso lisätietoja Stable Diffusionin isännöimisestä SageMaker MME:issä Luo korkealaatuisia kuvia Stable Diffusion -malleilla ja ota ne käyttöön kustannustehokkaasti Amazon SageMakerin avulla.

Esimerkissämme teimme lisäoptimointia, jotta hienosäädetyt mallit latautuvat nopeammin kylmäkäynnistystilanteissa. Tämä on mahdollista LoRA:n sovittimen suunnittelun ansiosta. Koska perusmallien painot ja Conda-ympäristöt ovat samat kaikissa hienosäädetyissä malleissa, voimme jakaa nämä yhteiset resurssit lataamalla ne valmiiksi isännöintisäiliöön. Jäljelle jää vain Triton-asetustiedosto, Python-taustaosa (model.py), ja LoRA-sovittimen painot ladataan dynaamisesti Amazon S3:sta ensimmäisen kutsun jälkeen. Seuraava kaavio tarjoaa vierekkäisen vertailun.

![]()

Tämä vähentää merkittävästi mallin TAR-tiedostoa noin 6 Gt:sta 70 Mt:aan, ja siksi se on paljon nopeampi ladata ja purkaa. Esilatauksen suorittamiseksi esimerkissämme loimme Python-apuohjelman taustamallin models/model_setup. Skripti yksinkertaisesti kopioi Stable Diffusion -perusmallin ja Conda-ympäristön Amazon S3:sta yhteiseen sijaintiin jakaakseen kaikki hienosäädetyt mallit. Seuraava on koodinpätkä, joka suorittaa tehtävän:

Sitten jokainen hienosäädetty malli osoittaa jaettuun sijaintiin säiliössä. Conda-ympäristöön viitataan julkaisussa config.pbtxt.

Stable Diffusion -pohjamalli ladataan initialize() kunkin toiminto model.py tiedosto. Tämän jälkeen käytämme yksilöllisiä LoRA-painoja unet- ja text_encoder malli jokaisen hienosäädetyn mallin toistamiseksi:

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/build-a-personalized-avatar-with-generative-ai-using-amazon-sagemaker/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 1

- 10

- 100

- 12

- 13

- 15%

- 17

- 20

- 32

- 7

- 70

- 700

- 8

- 9

- a

- kyky

- pystyy

- Meistä

- kiihtyi

- kiihtyvä

- pääsy

- saatavilla

- kertymä

- Saavuttaa

- poikki

- sovitus

- lisätä

- lisä-

- Lisäksi

- lisä-

- Lisäksi

- Oikaistu

- Etu

- mainonta

- Jälkeen

- AI

- AI-mallit

- Tekoälyn palvelut

- AI / ML

- Kaikki

- lievittää

- sallia

- Salliminen

- mahdollistaa

- jo

- Myös

- Vaikka

- amatööri

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- Ympäröivä

- määrä

- an

- anatomia

- ja

- Kaikki

- sovellukset

- käyttää

- lähestymistapa

- suunnilleen

- arkkitehtuuri

- OVAT

- Art

- kuvamateriaali

- AS

- Varat

- avustaminen

- At

- huomio

- houkuttelee

- kuulemiset

- kirjoittaja

- auto

- Automatisoitu

- automaattisesti

- saatavissa

- avatar

- avatarit

- välttää

- AWS

- taustaosa

- tausta

- taustat

- Huono

- pohja

- perustua

- perustiedot

- BE

- koska

- tulevat

- ollut

- takana

- ovat

- alle

- hyödyttää

- PARAS

- Paremmin

- välillä

- elin

- sekä

- Rikki

- rakentaa

- sisäänrakennettu

- taakka

- liiketoiminta

- mutta

- by

- Kätkö

- nimeltään

- CAN

- kyvyt

- kaapata

- huolellisesti

- tapaus

- tapauksissa

- kiinni

- haasteet

- maksut

- valitsi

- elokuvamainen

- kaupunkikuvan

- luokka

- selvästi

- koodi

- kylmä

- yhdistetty

- yhdistely

- Tulla

- Yhteinen

- verrattuna

- vertailu

- täydellinen

- valmistuminen

- monimutkainen

- osat

- koostumus

- Laskea

- tietokone

- Tietokoneen visio

- käsite

- samanaikainen

- Konfigurointi

- Kontti

- pitoisuus

- muuntaa

- Ydin

- Hinta

- kustannukset

- Covers

- luoda

- luotu

- Luominen

- luomuksia

- Luova

- sato

- kuratoitu

- Tällä hetkellä

- Asiakkaat

- räätälöidä

- räätälöityjä

- Leikkaus

- tiedot

- päivä

- omistautunut

- syvä

- syvä oppiminen

- syvempää

- määritellä

- määritelty

- määrittelee

- määrittelemällä

- Democratizing

- osoittaa

- osoittivat

- osoittaa

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- Malli

- yksityiskohta

- yksityiskohtainen

- yksityiskohdat

- Detection

- Määrittää

- Kehittäjä

- laite

- eri

- Diffuusio

- suoraan

- useat

- DIY

- do

- ei

- verkkotunnuksen

- tehty

- alas

- luonnos

- laadittu

- kaksi

- aikana

- dynaaminen

- dynaamisesti

- e

- verkkokaupan

- kukin

- Aikaisemmin

- helposti

- tehokas

- eliminoi

- upottamisen

- käytössä

- mahdollistaa

- kohtaaminen

- kannustaa

- päittäin

- Loputon

- päätepiste

- sitoumus

- Moottori

- Tekniikka

- parantaa

- parantaa

- yritys

- Viihde

- ympäristö

- ympäristöissä

- EPIC

- ydin

- esimerkki

- Esimerkit

- Paitsi

- poikkeus

- olemassa

- laajenee

- experience

- Elämykset

- kokeilu

- asiantuntemus

- Selittää

- tutkia

- avoin

- lauseke

- ilmauksia

- lisää

- uute

- Kasvot

- kasvohoito

- Epäonnistuminen

- perhe

- nopeampi

- Ominaisuus

- Ominaisuudet

- jalat

- harvat

- vähemmän

- luvut

- filee

- Asiakirjat

- lopullinen

- Vihdoin

- taloudellinen

- Etunimi

- Keskittää

- keskityttiin

- keskittyy

- jälkeen

- Jalanjälki

- varten

- löytyi

- neljä

- FRAME

- alkaen

- koko

- toiminto

- Pelit

- pelaamista

- tuottaa

- synnyttää

- tuottaa

- sukupolvi

- generatiivinen

- Generatiivinen AI

- generaattori

- saada

- gif

- GitHub

- tavoite

- menee

- hyvä

- GPU

- Graafinen

- suurempi

- suuresti

- Vihreä

- brutto

- ohjaavat

- käsissä

- Olla

- ottaa

- he

- auttaa

- auttaa

- auttaa

- hänen

- tätä

- korkea suorituskyky

- korkealaatuisia

- korkea resoluutio

- Korostaa

- erittäin

- hänen

- historia

- toivoa

- isäntä

- hotellit

- tunti

- Talo

- Miten

- Miten

- Kuitenkin

- HTML

- http

- HTTPS

- tunniste

- Identiteetti

- if

- kuva

- kuvien

- heti

- Vaikutukset

- toteuttaa

- täytäntöönpano

- parantaa

- in

- sisältää

- Mukaan lukien

- Kasvaa

- kasvoi

- yksilöllisyys

- teollisuuden

- teollisuus

- tiedot

- informatiivinen

- ensin

- innovatiivinen

- innovatiivisia tekniikoita

- panos

- tuloa

- innoittava

- esimerkki

- sen sijaan

- ohjeet

- vakuutus

- tarkoitettu

- korko

- tulee

- intuitiivinen

- IT

- SEN

- itse

- Jaakob

- Job

- Työpaikat

- tuloaan

- jpg

- json

- vain

- vain yksi

- avain

- tuntemus

- Merkki

- Kieli

- suuri

- suurin

- myöhemmin

- kerrokset

- johtaa

- johtaja

- Johto

- OPPIA

- oppiminen

- Lee

- kirjastot

- Valaistus

- pitää

- RAJOITA

- OTK

- kuormitus

- kuormat

- sijainti

- Pitkät

- kauemmin

- katso

- rakkaus

- Matala

- kone

- koneoppiminen

- tehty

- tärkein

- tehdä

- Tekeminen

- hoitaa

- onnistui

- johtaja

- hallinnoi

- toimitusjohtaja

- monet

- Marketing

- Markkinointi ja mainonta

- maksimi

- Saattaa..

- merkitys

- välineet

- mekanismi

- mekanismit

- Media

- Muisti

- mainitsi

- viesti

- menetelmä

- menetelmät

- minimi

- minuuttia

- sekoittaa

- ML

- malli

- mallit

- maltillisuus

- seuranta

- lisää

- eniten

- motivoituneita

- elokuva

- paljon

- moninkertainen

- täytyy

- nimi

- nimetty

- syntyperäinen

- Luonnollinen

- Luonnollinen kielen käsittely

- Tarve

- verkko

- Neutraali

- seuraava

- Ei eristetty

- muistikirja

- Ilmoitus..

- ilmoituksen

- nyt

- numero

- Nvidia

- objekti

- esineet

- of

- pois

- Öljy

- on

- ONE

- vain

- päälle

- toiminta-

- optimointi

- Optimoida

- optimoitu

- Vaihtoehto

- Vaihtoehdot

- or

- orkestrointi

- alkuperäinen

- OS

- Muut

- meidän

- ulos

- ääriviivat

- ulostulo

- yli

- yleinen

- paketti

- paketit

- tyyny

- Parallel

- parametri

- parametrit

- osa

- Hyväksytty

- intohimoinen

- polku

- Ihmiset

- täydellinen

- Suorittaa

- suorittaa

- henkilö

- Persoonallisuus

- Personoida

- yksilöllinen

- näkökulmia

- kuva

- Valokuvat

- kuva

- putki

- putki

- Platforms

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- kehno

- muotokuva

- mahdollisuuksia

- mahdollinen

- Kirje

- mahdollinen

- powered

- voimakas

- Predictor

- mieltymykset

- Valmistella

- valmistelee

- valmistelee

- säilytys

- edellinen

- ensisijainen

- Painaa

- Aikaisempi

- prosessi

- käsittely

- Tuotteet

- tuotepäällikkö

- Tuotteemme

- Profiili

- Ohjelmointi

- hankkeet

- Edistäminen

- asianmukaisesti

- ominaisuudet

- toimittaa

- mikäli

- tarjoaa

- Python

- laatu

- määrä

- satunnainen

- alue

- Hinnat

- pikemminkin

- perussyyt

- Lukeminen

- valmis

- suositella

- suositeltu

- vähentää

- Vähentynyt

- vähentää

- vähentäminen

- heijastaa

- suhteen

- liittyvä

- edustavat

- pyyntö

- pyynnöt

- tarvitaan

- resurssi

- Esittelymateriaalit

- vastaus

- vastuullinen

- REST

- johtua

- tulokset

- Rockstar

- Rooli

- karkeasti

- reititys

- ajaa

- toimii

- sagemaker

- SageMaker-johtopäätös

- sama

- Säästä

- Asteikko

- skaalaus

- sci-fi

- laajuus

- kuvakaappauksia

- Osa

- osiot

- nähdä

- siemenet

- segmentti

- SELF

- Selfie

- vanhempi

- lähetetty

- Sarjat

- palvelu

- Palvelut

- palvelevat

- setti

- asetus

- setup

- useat

- Muoto

- Jaa:

- yhteinen

- terävä

- hän

- laukaus

- shouldnt

- esitetty

- Näytä

- puoli

- merkittävä

- merkittävästi

- Simon

- Yksinkertainen

- yksinkertaisesti

- single

- tilanteita

- Koko

- pieni

- pienempiä

- pätkä

- sosiaalinen

- sosiaalinen media

- sosiaaliset alustat

- ratkaisu

- Ratkaisumme

- jonkin verran

- Tila

- asiantuntija

- erikoistunut

- erityinen

- menot

- Kierre

- vakaa

- Alkaa

- alkoi

- alkaa

- Vaihe

- Askeleet

- Levytila

- tallennettu

- streaming

- Suoratoistopalvelut

- jono

- rakenne

- aihe

- myöhempi

- onnistunut

- niin

- riittävä

- toimittaa

- tuki

- varma

- järjestelmä

- ottaa

- Tehtävä

- joukkue-

- TechCrunch

- tekniikat

- Technologies

- Elektroniikka

- Testaus

- testit

- kuin

- että

- -

- heidän

- Niitä

- sitten

- siksi

- Nämä

- tätä

- vaikka?

- ajatus

- ajatusjohtajuus

- tuhansia

- kolmella

- Kautta

- aika

- kertaa

- otsikot

- että

- työkalu

- ylin

- liikenne

- Juna

- koulutus

- muuttamassa

- Matkustaminen

- Triton

- yrittää

- tv

- kaksi

- tyyppi

- tyypillisesti

- ui

- varten

- ymmärsi

- unique

- tarpeeton

- ladattu

- Ladataan

- us

- USA

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- hyödyllisyys

- käyttää

- arvo

- lajike

- eri

- versio

- kautta

- Näytä

- katselu

- virginia

- visio

- grafiikka

- haluta

- oli

- vesileima

- we

- verkko

- verkkopalvelut

- paino

- olivat

- Mitä

- kun

- joka

- vaikka

- jonka

- leveä

- Laaja valikoima

- tulee

- with

- ilman

- Referenssit

- työskentely

- pahin

- olisi

- X

- vuotta

- Voit

- Sinun

- itse

- zephyrnet