Tämä postaus käy läpi yleisimmät haasteet, joita asiakkaat kohtaavat etsiessään sisäisiä asiakirjoja, ja antaa konkreettisia ohjeita siitä, kuinka AWS-palveluita voidaan käyttää generatiivisen tekoälyn keskustelubotin luomiseen, joka tekee sisäisestä tiedosta hyödyllisempää.

Strukturoimaton data muodostaa 80 % kaikesta tiedosta löytyy organisaatioista, ja se koostuu käsikirjojen, PDF-tiedostojen, usein kysyttyjen kysymysten, sähköpostien ja muiden asiakirjojen arkistoista, jotka kasvavat päivittäin. Yritykset luottavat nykyään jatkuvasti kasvaviin sisäisten tietovarastojen varaan, ja ongelmia syntyy, kun jäsentämättömän tiedon määrä muuttuu hallitsemattomaksi. Usein käyttäjät huomaavat lukevansa ja tarkistavansa monia erilaisia sisäisiä lähteitä löytääkseen tarvitsemansa vastaukset.

Sisäiset kysymys- ja vastausfoorumit voivat auttaa käyttäjiä saamaan erittäin tarkkoja vastauksia, mutta vaativat myös pidemmän odotusajan. Yrityskohtaisten sisäisten usein kysyttyjen kysymysten tapauksessa pitkät odotusajat heikentävät työntekijöiden tuottavuutta. Kysymys- ja vastausfoorumeita on vaikea skaalata, koska ne perustuvat manuaalisesti kirjoitettuihin vastauksiin. Generatiivinen tekoäly on tällä hetkellä paradigman muutos siinä, miten käyttäjät etsivät ja löytävät tietoa. Seuraava looginen askel on käyttää generatiivista tekoälyä suurten asiakirjojen tiivistämiseen pienemmiksi tietoiksi käyttäjän kulutuksen helpottamiseksi. Sen sijaan, että käyttäisivät pitkän aikaa tekstin lukemiseen tai vastausten odottamiseen, käyttäjät voivat luoda tiivistelmiä reaaliajassa useiden olemassa olevien sisäisten tietojen arkistojen perusteella.

Ratkaisun yleiskatsaus

Ratkaisun avulla asiakkaat voivat hakea kuratoituja vastauksia sisäisistä asiakirjoista esitettyihin kysymyksiin käyttämällä muuntajamallia, joka tuottaa vastauksia kysymyksiin, jotka koskevat tietoja, joita ei ole koulutettu. Tämä tekniikka tunnetaan nimellä nollakuvakehote. Ottamalla käyttöön tämän ratkaisun asiakkaat voivat saada seuraavat edut:

- Löydä tarkkoja vastauksia kysymyksiin olemassa olevien sisäisten asiakirjojen lähteiden perusteella

- Vähennä aikaa, jonka käyttäjät viettävät vastausten etsimiseen käyttämällä suuria kielimalleja (LLM), jotta saat lähes välittömiä vastauksia monimutkaisiin kyselyihin käyttämällä asiakirjoja, joissa on uusimmat tiedot.

- Hae aiemmin vastattuja kysymyksiä keskitetyn kojelaudan kautta

- Vähennä stressiä, joka johtuu siitä, että vietät aikaa manuaalisesti tietojen lukemiseen vastausten etsimiseen

Retrieval Augmented Generation (RAG)

Retrieval Augmented Generation (RAG) vähentää joitakin LLM-pohjaisten kyselyiden puutteita etsimällä vastaukset tietokannastasi ja käyttämällä LLM:ää tiivistämään asiakirjoja tiiviiksi vastauksiksi. Voisitko lukea tämän posti oppia toteuttamaan RAG-lähestymistapaa Amazon Kendra. Seuraavat riskit ja rajoitukset liittyvät LLM-pohjaisiin kyselyihin, joihin Amazon Kendran RAG-lähestymistapa vastaa:

- Hallusinaatiot ja jäljitettävyys – LLMS on koulutettu suuriin tietokokonaisuuksiin ja tuottaa vastauksia todennäköisyyksiin. Tämä voi johtaa epätarkkoihin vastauksiin, joita kutsutaan hallusinaatioiksi.

- Useita tietosiiloja – Jotta vastauksessasi voidaan viitata useista lähteistä saatuihin tietoihin, sinun on määritettävä liitinekosysteemi tietojen yhdistämistä varten. Useiden tietovarastojen käyttö on manuaalista ja aikaa vievää.

- Turvallisuus – Turvallisuus ja yksityisyys ovat kriittisiä näkökohtia otettaessa käyttöön RAG:n ja LLM:n toimittamia keskustelubotteja. Käyttämisestä huolimatta Amazonin käsitys käyttäjien tiedustelujen kautta saatavien henkilötietojen suodattamiseksi on olemassa mahdollisuus, että henkilökohtaisia tai arkaluontoisia tietoja voidaan vahingossa ilmaantua syötetyistä tiedoista riippuen. Tämä tarkoittaa, että chatbotin käytön hallinta on ratkaisevan tärkeää, jotta estetään tahaton pääsy arkaluonteisiin tietoihin.

- Tietojen relevanssi – LLMS:t koulutetaan dataan tiettyyn päivämäärään asti, mikä tarkoittaa, että tiedot eivät usein ole ajan tasalla. Viimeaikaisten tietojen koulutusmalleihin liittyvät kustannukset ovat korkeat. Tarkkojen ja ajantasaisten vastausten varmistamiseksi organisaatiot ovat vastuussa indeksoitujen asiakirjojen sisällön säännöllisestä päivittämisestä ja täydentämisestä.

- Kustannukset – Tämän ratkaisun käyttöönottoon liittyvät kustannukset tulisi ottaa yritysten huomioon. Yritysten on arvioitava huolellisesti budjettinsa ja suorituskykyvaatimukset ottaessaan käyttöön tätä ratkaisua. LLM:ien pyörittäminen voi vaatia huomattavia laskentaresursseja, mikä voi lisätä toimintakustannuksia. Näistä kustannuksista voi tulla rajoituksia sovelluksille, joiden on toimittava suuressa mittakaavassa. Kuitenkin yksi eduista AWS-pilvi on joustavuus maksaa vain siitä, mitä käytät. AWS tarjoaa yksinkertaisen, johdonmukaisen, jakohinnoittelumallin, joten sinua veloitetaan vain käyttämistäsi resursseista.

Amazon SageMaker JumpStartin käyttö

Organisaatiot voivat hyötyä muuntajapohjaisten kielimallien käytöstä Amazon Sage Maker JumpStart, joka tarjoaa kokoelman valmiita koneoppimismalleja. Amazon SageMaker JumpStart tarjoaa laajan valikoiman tekstin luomisen ja kysymysvastausten (Q&A) perusmalleja, joita voidaan helposti ottaa käyttöön ja käyttää. Tämä ratkaisu integroi FLAN T5-XL Amazon SageMaker JumpStart -mallin, mutta on useita näkökohtia, jotka on pidettävä mielessä, kun pohjamallin valinta.

Turvallisuuden integrointi työnkulkuumme

Seuraamalla turvallisuuspilarin parhaita käytäntöjä Hyvin suunniteltu kehys, Amazon Cognito käytetään todentamiseen. Amazon Cognito User Pools voidaan integroida kolmansien osapuolien identiteetintarjoajiin, jotka tukevat useita kulunvalvontaan käytettyjä puitteita, mukaan lukien Open Authorization (OAuth), OpenID Connect (OIDC) tai Security Assertion Markup Language (SAML). Käyttäjien ja heidän toimintojensa tunnistaminen mahdollistaa ratkaisun jäljitettävyyden ylläpitämisen. Ratkaisu käyttää myös Amazon Comprehend henkilökohtaisten tunnistetietojen (PII) tunnistus ominaisuus tunnistaa ja poistaa henkilökohtaisia tunnistetietoja automaattisesti. Muokatut henkilötiedot sisältävät osoitteita, sosiaaliturvatunnuksia, sähköpostiosoitteita ja muita arkaluonteisia tietoja. Tämä suunnittelu varmistaa, että kaikki käyttäjän syöttökyselyn kautta antamat henkilötiedot poistetaan. Henkilökohtaisia tunnistetietoja ei tallenneta, Amazon Kendra ei käytä tai syötä LLM:lle.

Ratkaisun esittely

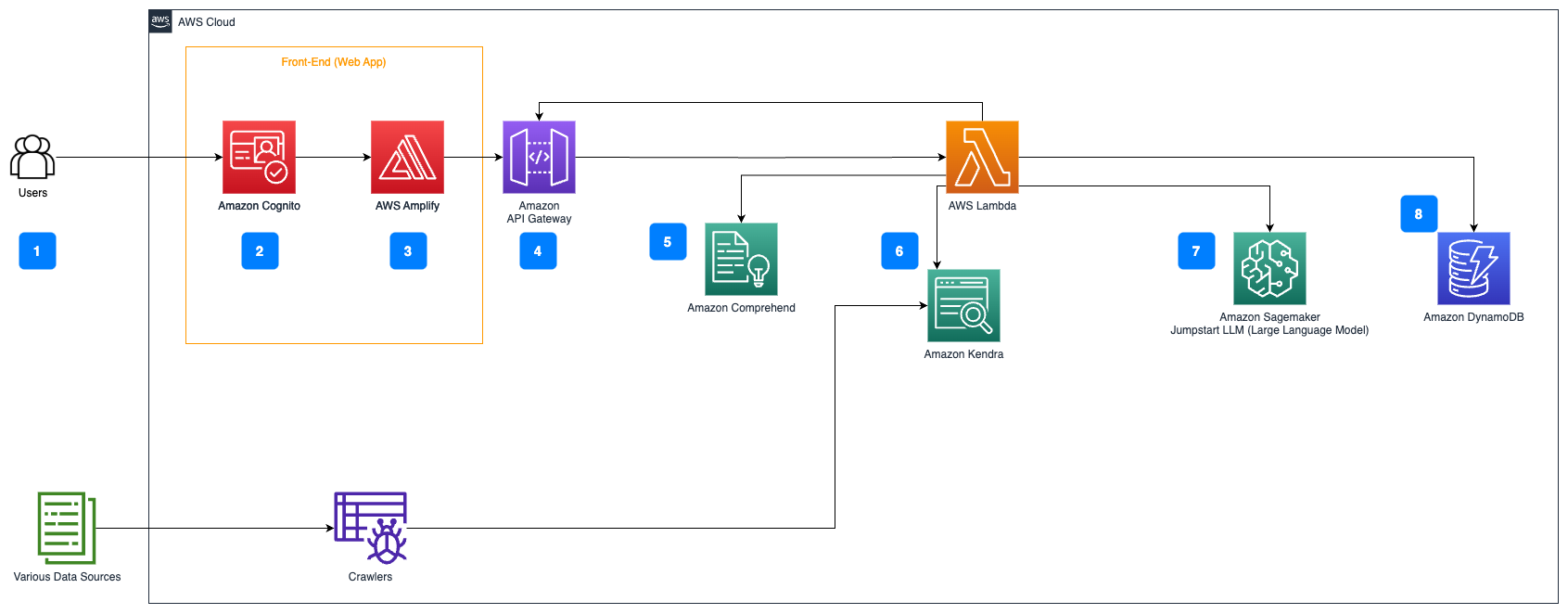

Seuraavat vaiheet kuvaavat kysymykseen vastaamisen työnkulkua asiakirjojen kulun yli:

- Käyttäjät lähettävät kyselyn verkkokäyttöliittymän kautta.

- Amazon Cognito käytetään todentamiseen, mikä varmistaa turvallisen pääsyn verkkosovellukseen.

- Verkkosovelluksen käyttöliittymää isännöidään AWS vahvistaa.

- Amazon API -yhdyskäytävä isännöi REST API:ta erilaisilla päätepisteillä käsittelemään käyttäjien pyyntöjä, jotka on todennettu Amazon Cogniton avulla.

- PII:n muokkaus Amazonin käsitys:

- Käyttäjäkyselyn käsittely: Kun käyttäjä lähettää kyselyn tai syötteen, se välitetään ensin Amazon Comprehendin kautta. Palvelu analysoi tekstin ja tunnistaa kaikki kyselyssä olevat henkilökohtaiset tunnistetiedot.

- Henkilökohtaisten tunnistetietojen purkaminen: Amazon Comprehend poimii havaitut PII-entiteetit käyttäjän kyselystä.

- Relevantti tiedon haku Amazon Kendra:

- Amazon Kendraa käytetään dokumenttien hakemiston hallintaan, joka sisältää tiedot, joita käytetään vastausten luomiseen käyttäjän kyselyihin.

- - LangChain QA haku moduulia käytetään keskusteluketjun rakentamiseen, jossa on olennaista tietoa käyttäjän kyselyistä.

- Integrointi Amazon SageMaker JumpStart:

- AWS Lambda -toiminto käyttää LangChain-kirjastoa ja muodostaa yhteyden Amazon SageMaker JumpStart -päätepisteeseen kontekstilla täytetyllä kyselyllä. Amazon SageMaker JumpStart -päätepiste toimii päätelmien tekemiseen käytetyn LLM:n käyttöliittymänä.

- Vastausten tallentaminen ja palauttaminen käyttäjälle:

- LLM:n vastaus tallennetaan Amazon DynamoDB sekä käyttäjän kysely, aikaleima, yksilöllinen tunniste ja muut kohteen mielivaltaiset tunnisteet, kuten kysymysluokka. Kun kysymys ja vastaus tallennetaan erillisinä kohteina, AWS Lambda -toiminto voi helposti luoda uudelleen käyttäjän keskusteluhistorian kysymysten esittämisajankohdan perusteella.

- Lopuksi vastaus lähetetään takaisin käyttäjälle HTTPs-pyynnön kautta Amazon API Gateway REST API -integraatiovastauksen kautta.

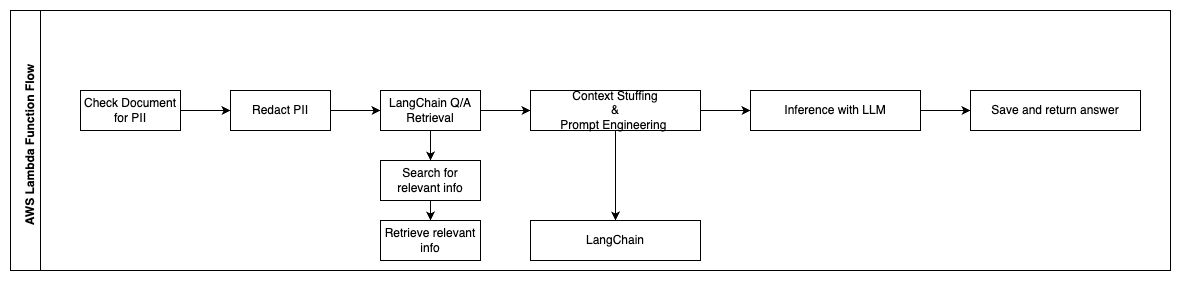

Seuraavat vaiheet kuvaavat AWS Lambdan toimintoja ja niiden kulun prosessin läpi:

- Tarkista ja poista kaikki henkilökohtaiset tiedot/arkaluonteiset tiedot

- LangChain QA hakuketju

- Etsi ja hae asiaankuuluvaa tietoa

- Kontekstitäyte ja nopea suunnittelu

- Päätelmä LLM:stä

- Palauta vastaus ja tallenna se

Käyttötapaukset

On monia yrityskäyttötapauksia, joissa asiakkaat voivat käyttää tätä työnkulkua. Seuraavassa osiossa kerrotaan, kuinka työnkulkua voidaan käyttää eri toimialoilla ja toimialoilla.

Työntekijöiden apu

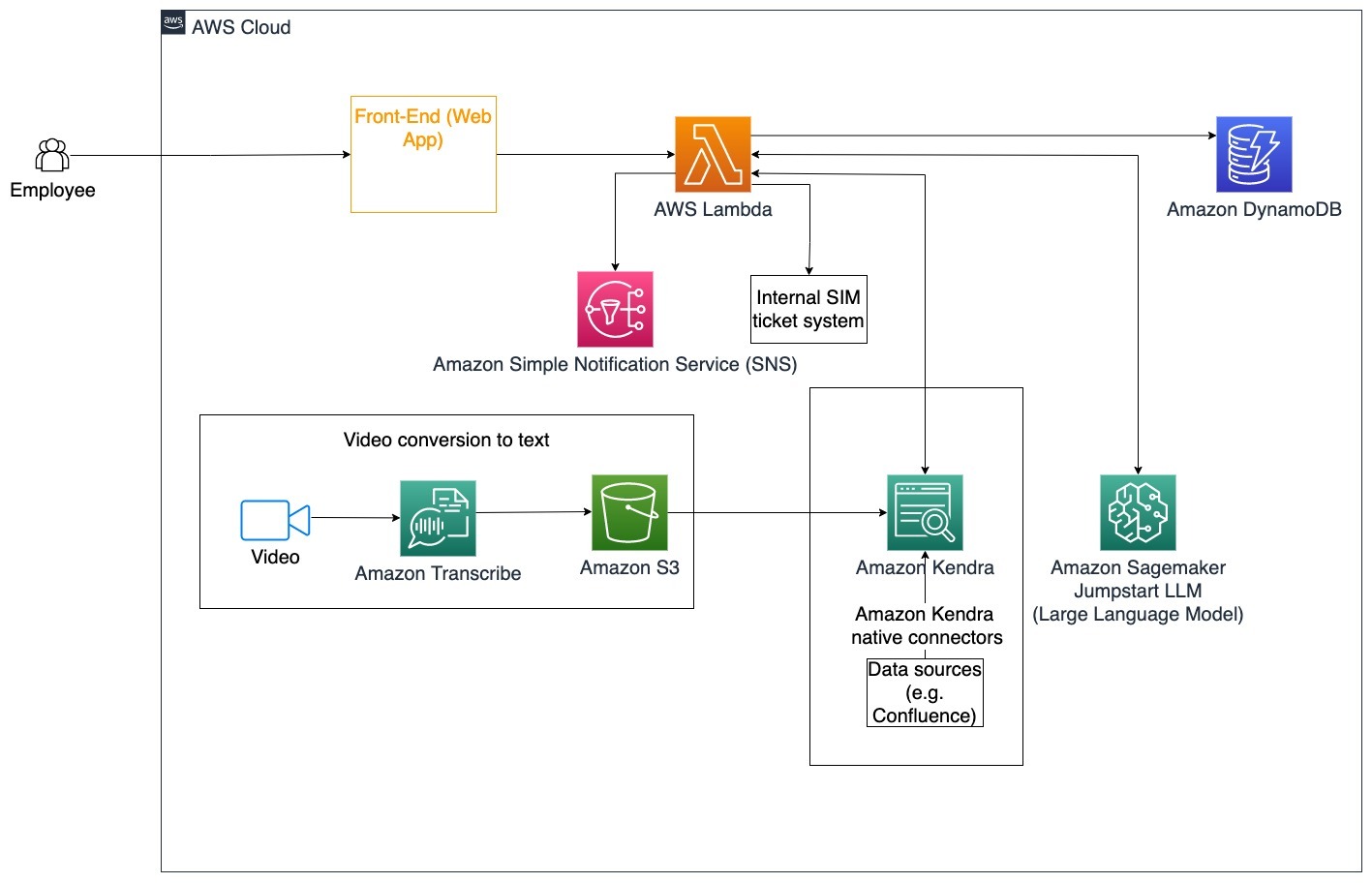

Hyvin suunniteltu yrityskoulutus voi parantaa työntekijöiden tyytyväisyyttä ja vähentää uusien työntekijöiden palkkaamiseen kuluvaa aikaa. Kun organisaatiot kasvavat ja monimutkaisuus lisääntyy, työntekijöiden on vaikea ymmärtää sisäisten asiakirjojen monia lähteitä. Tässä yhteydessä sisäiset asiakirjat sisältävät yrityksen ohjeet, käytännöt ja vakiotoimintamenettelyt. Tässä skenaariossa työntekijällä on kysymys siitä, kuinka edetä ja muokata sisäisen ongelman lippua. Työntekijä voi käyttää generatiivisen tekoälyn (AI) keskustelubottia kysyäkseen ja suorittaakseen seuraavat vaiheet tietylle lipulle.

Erityinen käyttötapaus: Automatisoi työntekijöiden ongelmien ratkaisu yrityksen ohjeiden mukaan.

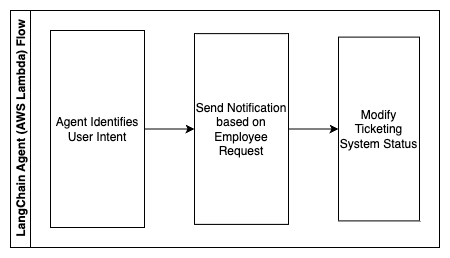

Seuraavat vaiheet kuvaavat AWS Lambdan toimintoja ja niiden kulun prosessin läpi:

- LangChain-agentti tunnistamaan tarkoituksen

- Lähetä ilmoitus työntekijän pyynnöstä

- Muokkaa lipun tilaa

Tässä arkkitehtuurikaaviossa yritysten koulutusvideot voidaan lukea läpi Amazonin transkriptio kerätäksesi lokin näistä videoskripteistä. Lisäksi eri lähteisiin (esim. Confluence, Microsoft SharePoint, Google Drive, Jira jne.) tallennettua yrityskoulutussisältöä voidaan käyttää indeksien luomiseen Amazon Kendra -liittimien kautta. Lue tämä artikkeli saadaksesi lisätietoja alkuperäisten kokoelmasta Liittimet voit käyttää Amazon Kendrassa lähdepisteenä. Amazon Kendra -indeksointirobotti voi sitten käyttää sekä yrityksen koulutusvideon skriptejä että näihin muihin lähteisiin tallennettuja asiakirjoja auttaakseen keskustelubottia vastaamaan yrityksen yrityskoulutusohjeisiin liittyviin kysymyksiin. LangChain-agentti tarkistaa luvat, muuttaa lipun tilaa ja ilmoittaa oikeille henkilöille Amazon Simple Notification Service -palvelun avulla (Amazon SNS).

Asiakastukitiimit

Asiakkaiden kyselyjen nopea ratkaiseminen parantaa asiakaskokemusta ja rohkaisee brändiuskollisuutta. Uskollinen asiakaskunta auttaa kasvattamaan myyntiä, mikä edistää tuloksen saavuttamista ja lisää asiakkaiden sitoutumista. Asiakastukitiimit käyttävät paljon energiaa viitaten moniin sisäisiin asiakirjoihin ja asiakassuhteiden hallintaohjelmistoihin vastatakseen asiakkaiden tuotteita ja palveluita koskeviin kysymyksiin. Tässä yhteydessä sisäiset asiakirjat voivat sisältää yleisiä asiakastukipuheluskriptejä, pelikirjoja, eskalointiohjeita ja yritystietoja. Generatiivinen AI-keskustelubotti auttaa kustannusten optimoinnissa, koska se käsittelee kyselyitä asiakastukitiimin puolesta.

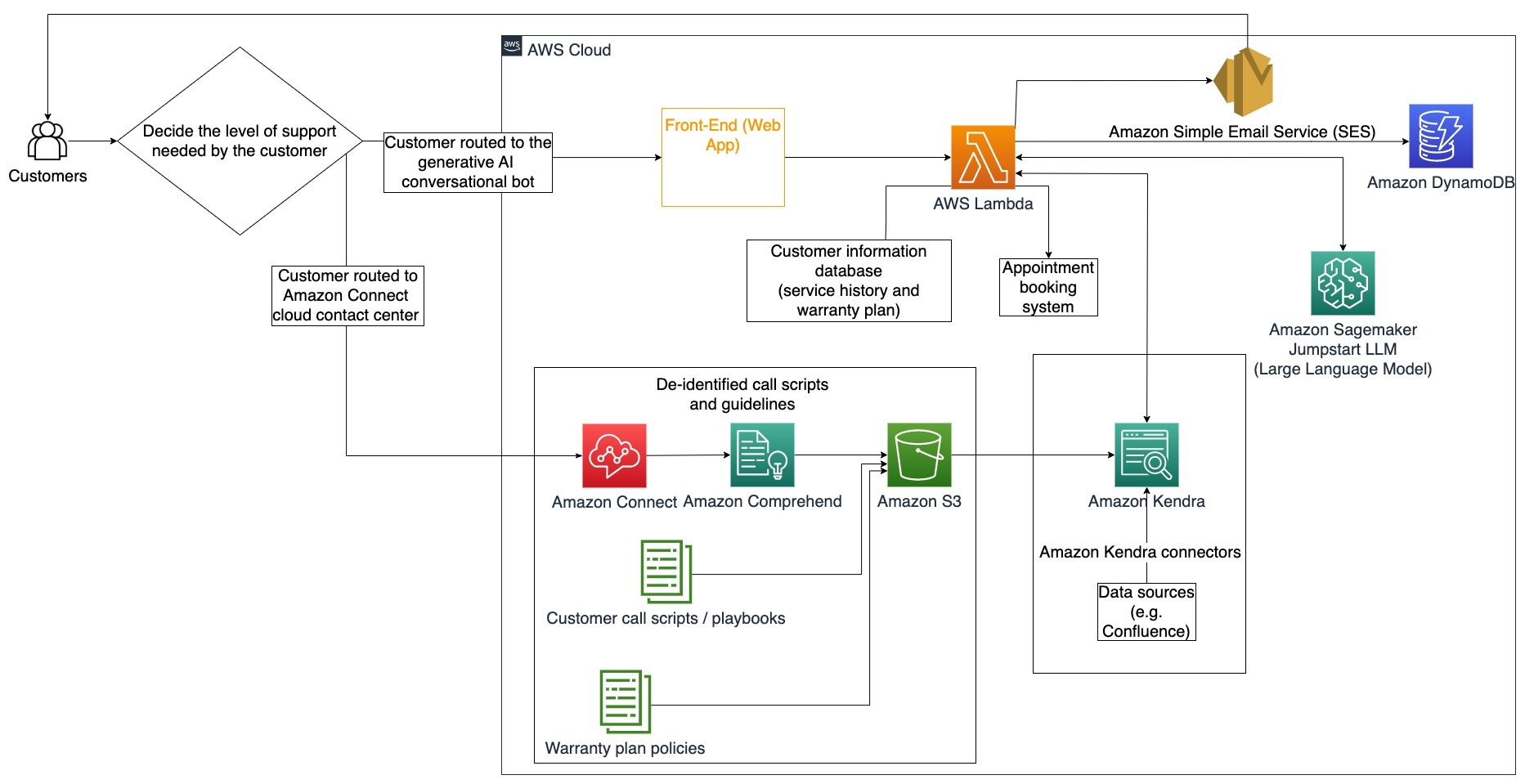

Erityinen käyttötapaus: Öljynvaihtopyynnön käsittely huoltohistorian ja ostetun asiakaspalvelusuunnitelman perusteella.

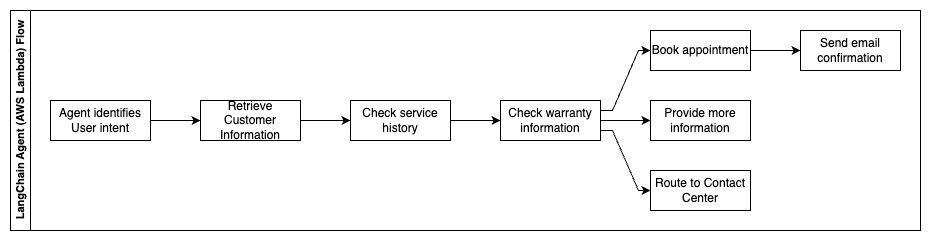

Tässä arkkitehtuurikaaviossa asiakas reititetään joko generatiiviseen AI-keskustelubottiin tai Amazon Connect yhteyskeskus. Tämä päätös voi perustua tarvittavan tuen tasoon tai asiakastukihenkilöiden saatavuuteen. LangChain-agentti tunnistaa asiakkaan tarkoituksen ja varmistaa henkilöllisyyden. LangChain-agentti tarkistaa myös huoltohistorian ja ostetun tukisuunnitelman.

Seuraavat vaiheet kuvaavat AWS Lambdan toimintoja ja niiden kulun prosessin läpi:

- LangChain-agentti tunnistaa tarkoituksen

- Hae asiakastiedot

- Tarkista asiakaspalveluhistoria ja takuutiedot

- Varaa aika, anna lisätietoja tai reitti yhteyskeskukseen

- Lähetä sähköpostivahvistus

Amazon Connectia käytetään ääni- ja chat-lokien keräämiseen, ja Amazon Comprehendia käytetään poistamaan henkilökohtaisia tunnistetietoja (PII) näistä lokeista. Amazon Kendra -indeksointirobotti voi sitten käyttää muokattuja ääni- ja chat-lokeja, asiakaspuheluskriptejä ja asiakaspalvelun tukisuunnitelmakäytäntöjä indeksin luomiseen. Kun päätös on tehty, generatiivinen AI-keskustelubotti päättää, varataanko tapaaminen, annetaanko lisätietoja vai ohjataanko asiakas yhteyskeskukseen lisäapua varten. Kustannusten optimointia varten LangChain-agentti voi myös luoda vastauksia käyttämällä vähemmän tunnuksia ja halvempaa isokielimallia alhaisemman prioriteetin asiakaskyselyihin.

Pankki-, rahoitus ja vakuutus.

Rahoituspalveluyritykset luottavat tietojen oikea-aikaiseen käyttöön pysyäkseen kilpailukykyisinä ja noudattaakseen rahoitussäännöksiä. Generatiivisen tekoälyn keskustelubotin avulla talousanalyytikot ja neuvonantajat voivat olla vuorovaikutuksessa tekstitiedon kanssa keskustelullisella tavalla ja vähentää aikaa ja vaivaa, joka kuluu tietoisempien päätösten tekemiseen. Investoinnin ja markkinatutkimuksen lisäksi generatiivinen AI-keskustelubotti voi myös lisätä ihmisen kykyjä hoitamalla tehtäviä, jotka vaativat perinteisesti enemmän ihmisen vaivaa ja aikaa. Esimerkiksi henkilökohtaisiin lainoihin erikoistunut rahoituslaitos voi nostaa lainojen käsittelynopeutta ja tarjota asiakkaille parempaa läpinäkyvyyttä.

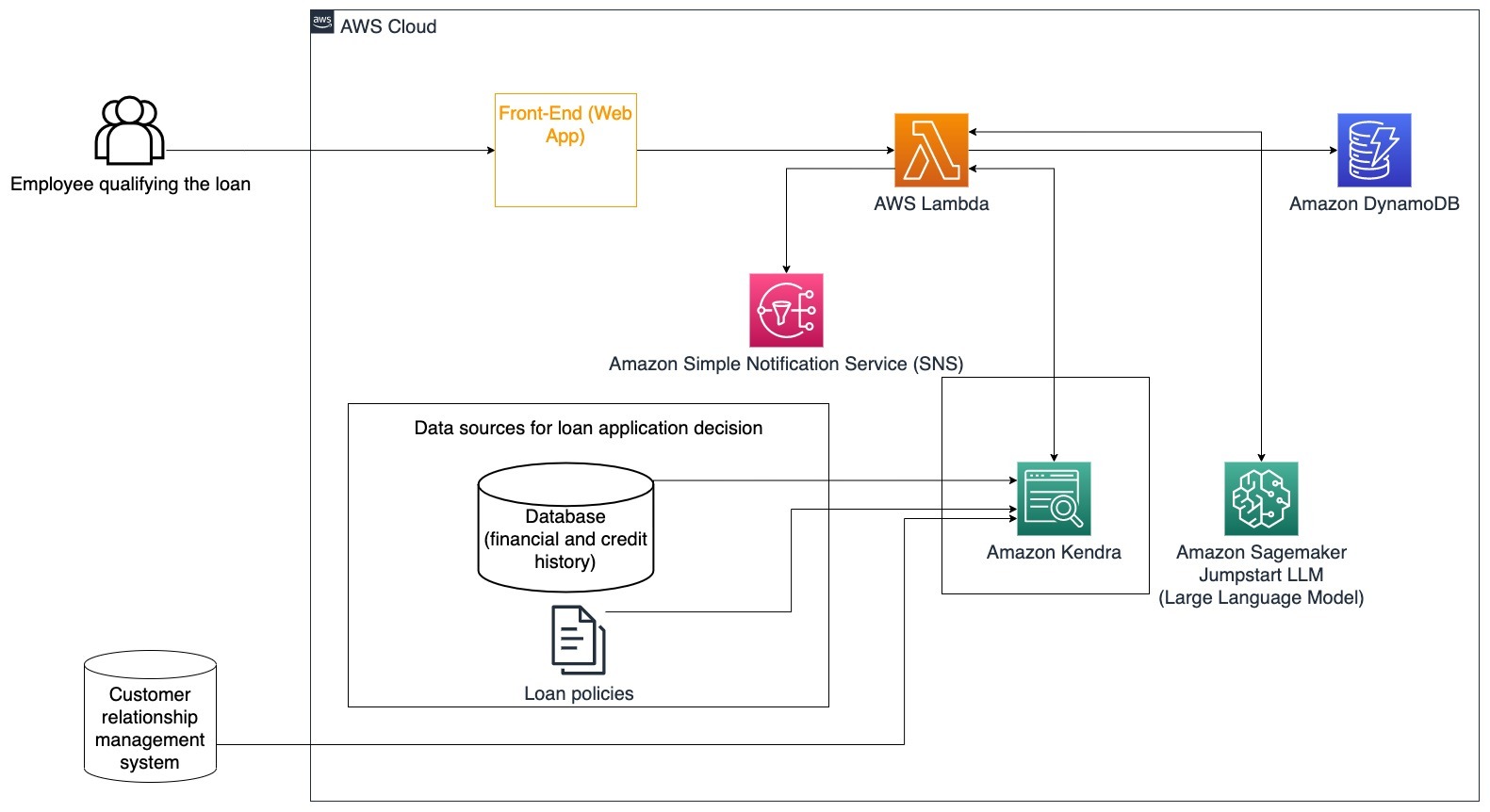

Erityinen käyttötapaus: Käytä asiakkaan taloushistoriaa ja aiempia lainahakemuksia lainapäätöksen tekemiseen ja perustelemiseen.

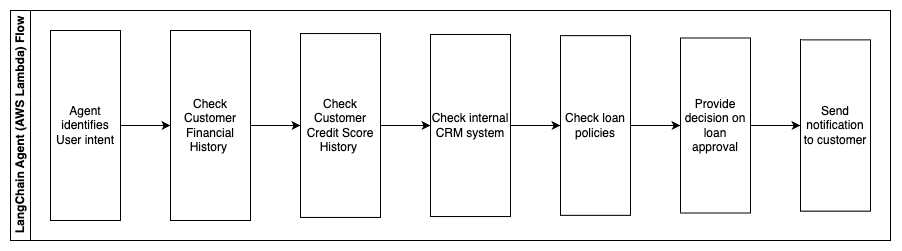

Seuraavat vaiheet kuvaavat AWS Lambdan toimintoja ja niiden kulun prosessin läpi:

- LangChain-agentti tunnistamaan tarkoituksen

- Tarkista asiakkaan talous- ja luottotietohistoria

- Tarkista sisäinen asiakkuuksien hallintajärjestelmä

- Tarkista yleiset lainakäytännöt ja ehdota päätöstä työntekijälle, joka hakee lainaa

- Lähetä ilmoitus asiakkaalle

Tämä arkkitehtuuri sisältää tietokantaan tallennetut asiakkaiden taloudelliset tiedot ja asiakassuhteiden hallintatyökaluun (CRM) tallennetut tiedot. Näitä tietopisteitä käytetään päätöksen tekemiseen yhtiön sisäisten lainakäytäntöjen perusteella. Asiakas voi esittää selventäviä kysymyksiä ymmärtääkseen, mihin lainoihin hän on oikeutettu ja mitkä lainaehdot voivat ottaa vastaan. Jos generatiivinen AI-keskustelubotti ei pysty hyväksymään lainahakemusta, käyttäjä voi silti esittää kysymyksiä luottopisteiden parantamisesta tai vaihtoehtoisista rahoitusvaihtoehdoista.

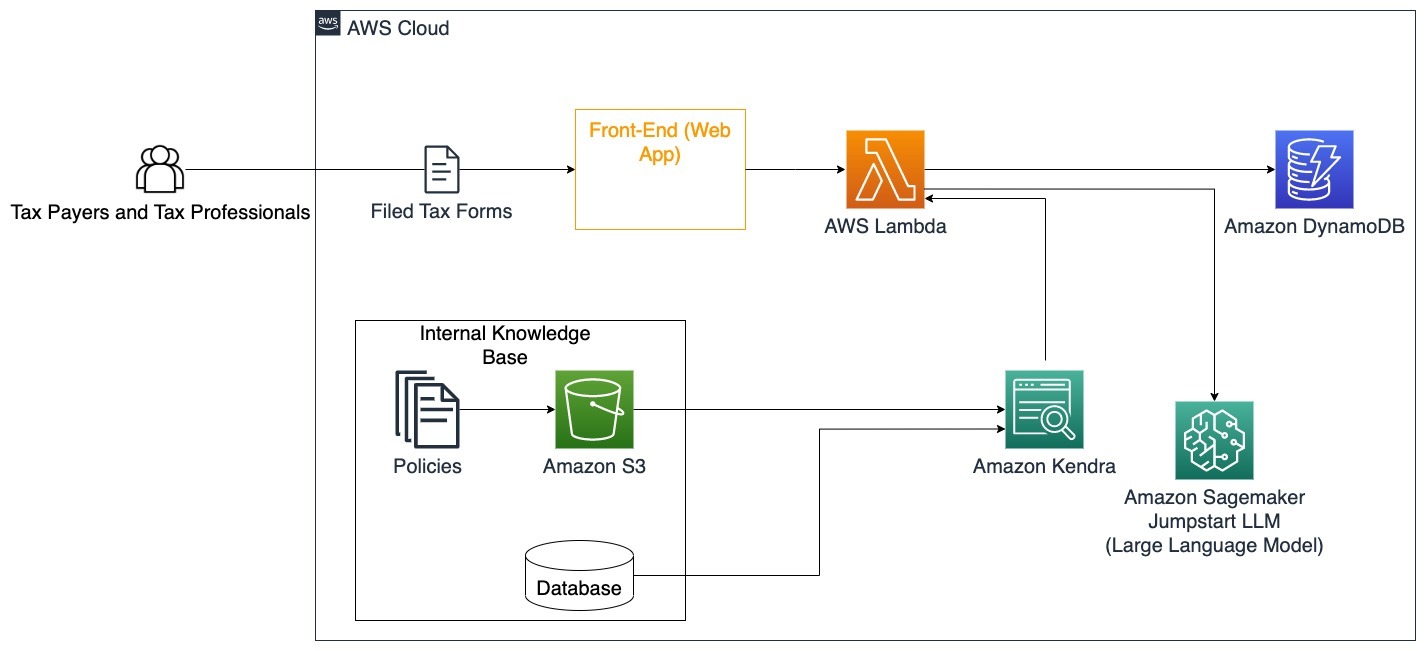

Hallitus

Generatiiviset AI-keskustelubotit voivat hyödyttää suuresti valtion instituutioita nopeuttamalla viestintää, tehokkuutta ja päätöksentekoprosesseja. Generatiiviset AI-keskustelubotit voivat myös tarjota välittömän pääsyn sisäisiin tietokantoihin, joiden avulla valtion työntekijät voivat nopeasti hakea tietoja, käytäntöjä ja menettelyjä (eli kelpoisuuskriteerit, hakuprosessit sekä kansalaisten palvelut ja tuki). Yksi ratkaisu on interaktiivinen järjestelmä, jonka avulla veronmaksajat ja veroalan ammattilaiset löytävät helposti verotukseen liittyvät tiedot ja edut. Sen avulla voidaan ymmärtää käyttäjien kysymyksiä, tehdä yhteenvetoja veroasiakirjoista ja antaa selkeitä vastauksia interaktiivisten keskustelujen kautta.

Käyttäjät voivat esittää kysymyksiä, kuten:

- Miten perintövero toimii ja mitkä ovat verokynnykset?

- Voitko selittää tuloveron käsitteen?

- Mitä verovaikutuksia toisen kiinteistön myyntiin liittyy?

Lisäksi käyttäjät voivat kätevästi lähettää verolomakkeita järjestelmään, mikä voi auttaa varmistamaan annettujen tietojen oikeellisuuden.

Tämä arkkitehtuuri havainnollistaa, kuinka käyttäjät voivat ladata täytettyjä verolomakkeita ratkaisuun ja käyttää sitä vuorovaikutteiseen varmentamiseen ja opastukseen tarvittavien tietojen täsmälliseen täyttämiseen.

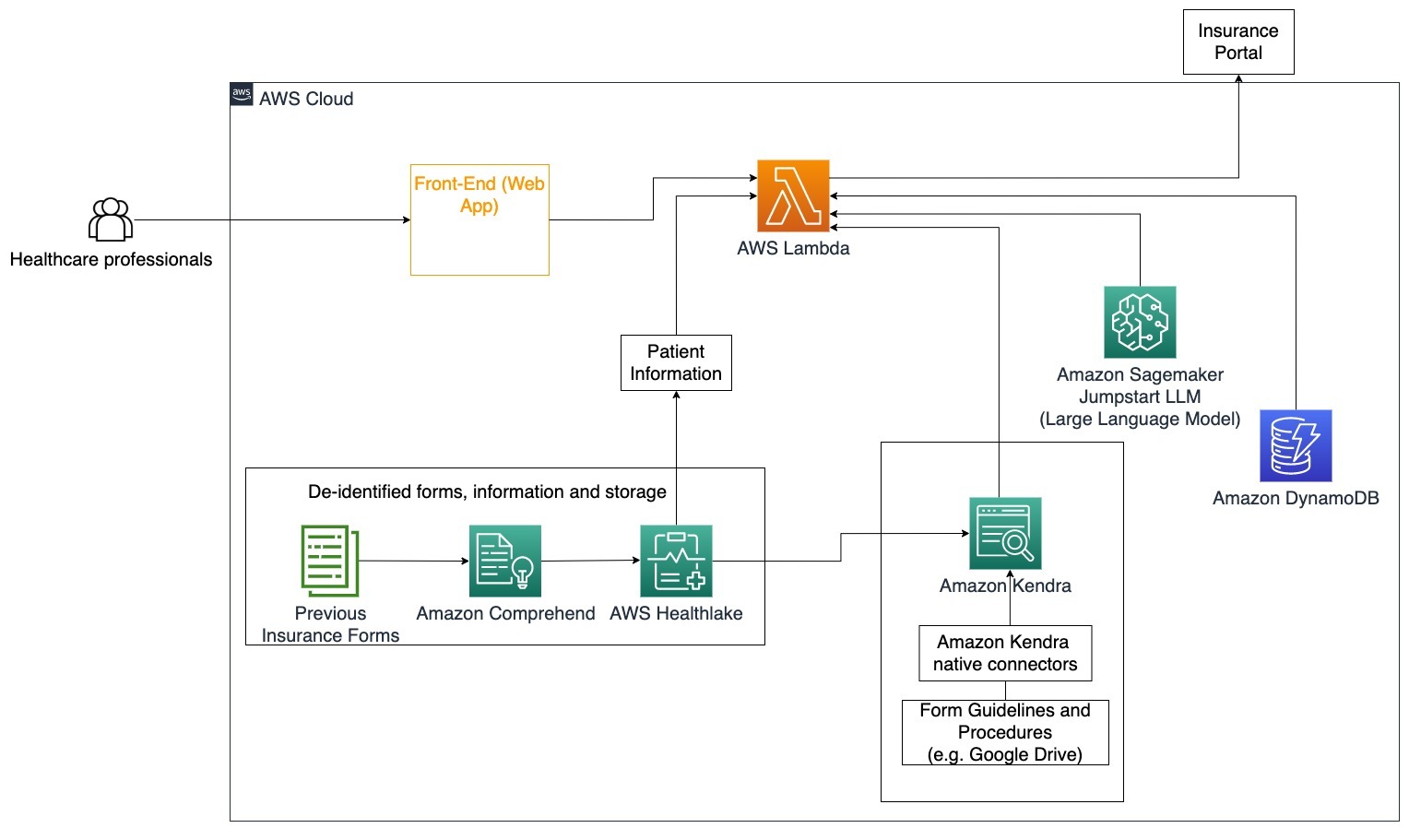

Terveydenhuolto

Terveydenhuollon yrityksillä on mahdollisuus automatisoida suurten määrien sisäisten potilastietojen käyttö ja samalla käsitellä yleisiä käyttötapauksia koskevia kysymyksiä, kuten hoitovaihtoehtoja, vakuutuskorvauksia, kliinisiä tutkimuksia ja lääketutkimusta. Luovan tekoälyn keskustelubotin käyttö mahdollistaa nopean ja tarkan vastausten luomisen terveystiedoista tarjotun tietokannan perusteella. Jotkut terveydenhuollon ammattilaiset esimerkiksi viettävät paljon aikaa lomakkeiden täyttämiseen vakuutuskorvausten jättämiseksi.

Vastaavissa olosuhteissa kliinisten tutkimusten hallinnoijien ja tutkijoiden on löydettävä tietoa hoitovaihtoehdoista. Generatiivinen AI-keskustelubotti voi käyttää Amazon Kendrassa valmiita liittimiä hakeakseen olennaisimmat tiedot miljoonista asiakirjoista, jotka on julkaistu lääkeyhtiöiden ja yliopistojen jatkuvassa tutkimuksessa.

Erityinen käyttötapaus: Vähennä vakuutuslomakkeiden täyttämiseen ja lähettämiseen tarvittavia virheitä ja aikaa.

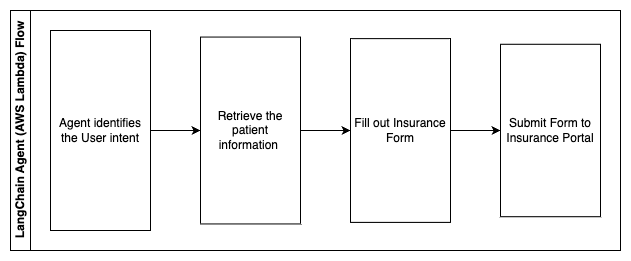

Tässä arkkitehtuurikaaviossa terveydenhuollon ammattilainen voi käyttää generatiivista tekoälybottia selvittääkseen, mitä lomakkeita vakuutusta varten on täytettävä. LangChain-agentti pystyy sitten hakemaan oikeat lomakkeet ja lisäämään potilaalle tarvittavat tiedot sekä antamaan vastaukset lomakkeiden kuvaileviin osiin vakuutusten ja aiempien lomakkeiden perusteella. Terveydenhuollon ammattilainen voi muokata LLM:n antamia vastauksia ennen lomakkeen hyväksymistä ja toimittamista vakuutusportaaliin.

Seuraavat vaiheet kuvaavat AWS Lambdan toimintoja ja niiden kulun prosessin läpi:

- LangChain-agentti tunnistamaan tarkoituksen

- Hae tarvittavat potilastiedot

- Täytä vakuutuslomake potilastietojen ja lomakeohjeen perusteella

- Lähetä lomake vakuutusportaaliin käyttäjän hyväksynnän jälkeen

AWS HealthLake käytetään terveystietojen, mukaan lukien aiempien vakuutuslomakkeiden ja potilastietojen, turvalliseen tallentamiseen, ja Amazon Comprehendia käytetään poistamaan henkilökohtaisia tunnistetietoja (PII) aiemmista vakuutuslomakkeista. Amazon Kendra -indeksointirobotti voi sitten käyttää vakuutuslomakkeita ja ohjeita indeksin luomiseen. Kun generatiivinen tekoäly on täyttänyt lomakkeet, lääkärin tarkistamat lomakkeet voidaan lähettää vakuutusportaaliin.

Kustannusarvio

Perusratkaisun käyttöönoton hinta konseptin todisteena on esitetty seuraavassa taulukossa. Koska perusratkaisua pidetään konseptin todisteena, Amazon Kendra Developer Editionia käytettiin edullisena vaihtoehtona, koska työmäärä ei olisi tuotannossa. Oletuksemme Amazon Kendra Developer Editionille oli 730 aktiivista tuntia kuukaudessa.

Amazon SageMakerin osalta teimme oletuksen, että asiakas käyttäisi ml.g4dn.2xlarge-esiintymää reaaliaikaiseen päättelyyn, jossa yksi päätepäätepiste ilmentymää kohti. Löydät lisätietoja Amazon SageMaker -hinnoittelusta ja käytettävissä olevista päätelmäinstanssityypeistä tätä.

| Palvelu | Kulutetut resurssit | Kustannusarvio per kuukausi USD |

| AWS vahvistaa | 150 rakennusminuuttia 1 Gt dataa 500,000 pyyntöä |

15.71 |

| Amazon API -yhdyskäytävä | 1M REST API -puhelut | 3.5 |

| AWS Lambda | 1 miljoona pyyntöä Kesto 5 sekuntia per pyyntö 2GB muistia varattu |

160.23 |

| Amazon DynamoDB | 1 miljoona lukemaa 1 miljoonaa kirjoittaa 100 GB -varasto |

26.38 |

| Amazon Sagemaker | Reaaliaikainen johtopäätös ml.g4dn.2xlarge | 676.8 |

| Amazon Kendra | Kehittäjäversio 730 tuntia/kk 10,000 XNUMX asiakirjaa skannattu 5,000 kyselyä/päivä |

821.25 |

| . | . | Kokonaiskustannukset: 1703.87 |

* Amazon Cognitolla on ilmainen taso, johon kuuluu 50,000 50 kuukausittaista aktiivista käyttäjää, jotka käyttävät Cogniton käyttäjäpooleja, tai 2.0 kuukausittaista aktiivista käyttäjää, jotka käyttävät SAML XNUMX -identiteetintarjoajia.

Puhdistaa

Voit säästää kustannuksia poistamalla kaikki resurssit, jotka otit käyttöön osana opetusohjelmaa. Voit poistaa kaikki SageMaker-päätepisteet, jotka olet luonut SageMaker-konsolin kautta. Muista, että Amazon Kendra -hakemiston poistaminen ei poista alkuperäisiä asiakirjoja tallennustilastasi.

Yhteenveto

Tässä viestissä näytimme sinulle, kuinka voit yksinkertaistaa pääsyä sisäisiin tietoihin tekemällä yhteenvedot useista arkistoista reaaliajassa. Kaupallisesti saatavien LLM:ien viimeaikaisen kehityksen jälkeen generatiivisen tekoälyn mahdollisuudet ovat tulleet selvemmiksi. Tässä viestissä esittelimme tapoja käyttää AWS-palveluita palvelimettoman chatbotin luomiseen, joka käyttää generatiivista tekoälyä kysymyksiin vastaamiseen. Tämä lähestymistapa sisältää todennuskerroksen ja Amazon Comprehendin PII-tunnistuksen käyttäjän kyselyn sisältämien arkaluonteisten tietojen suodattamiseksi. Olipa kyse terveydenhuollon yksityishenkilöistä, jotka ymmärtävät vakuutuskorvausvaatimusten tekemisen vivahteet tai henkilöstöhallinnon, jotka ymmärtävät tiettyjä yrityksen laajuisia säännöksiä, monet toimialat ja toimialat voivat hyötyä tästä lähestymistavasta. Amazon SageMaker JumpStart -perusmalli on chatbotin moottori, kun taas RAG-tekniikkaa käyttävää kontekstin täyttämismenetelmää käytetään varmistamaan, että vastaukset viittaavat tarkemmin sisäisiin asiakirjoihin.

Lisätietoja generatiivisen tekoälyn kanssa työskentelystä AWS:ssä on osoitteessa Ilmoitamme uusista työkaluista rakentamiseen generatiivisella tekoälyllä AWS:ssä. Katso tarkemmat ohjeet RAG-tekniikan käyttämisestä AWS-palvelujen kanssa Rakenna nopeasti korkean tarkkuuden generatiivisia tekoälysovelluksia yritystietoihin käyttämällä Amazon Kendraa, LangChainia ja suuria kielimalleja. Koska tämän blogin lähestymistapa on LLM-agnostikko, mitä tahansa LLM:ää voidaan käyttää johtopäätösten tekemiseen. Seuraavassa viestissämme hahmottelemme tapoja toteuttaa tämä ratkaisu Amazon Bedrockin ja Amazon Titan LLM:n avulla.

Tietoja Tekijät

Abhishek Maligehalli Shivalingaiah on AWS:n vanhempi AI-palveluratkaisuarkkitehti. Hän on intohimoinen sovellusten rakentamiseen Generative AI:n, Amazon Kendran ja NLP:n avulla. Hänellä on noin 10 vuoden kokemus Data & AI -ratkaisujen rakentamisesta lisäarvon luomiseksi asiakkaille ja yrityksille. Hän on jopa rakentanut (henkilökohtaisen) chatbotin huvikseen vastatakseen uraansa ja ammatillista matkaansa koskeviin kysymyksiin. Työn ulkopuolella hän nauttii muotokuvien tekemisestä perheestä ja ystävistä ja rakastaa taideteoksia.

Abhishek Maligehalli Shivalingaiah on AWS:n vanhempi AI-palveluratkaisuarkkitehti. Hän on intohimoinen sovellusten rakentamiseen Generative AI:n, Amazon Kendran ja NLP:n avulla. Hänellä on noin 10 vuoden kokemus Data & AI -ratkaisujen rakentamisesta lisäarvon luomiseksi asiakkaille ja yrityksille. Hän on jopa rakentanut (henkilökohtaisen) chatbotin huvikseen vastatakseen uraansa ja ammatillista matkaansa koskeviin kysymyksiin. Työn ulkopuolella hän nauttii muotokuvien tekemisestä perheestä ja ystävistä ja rakastaa taideteoksia.

Medha Aiyah on AWS:n associate Solutions -arkkitehti, joka sijaitsee Austinissa, Texasissa. Hän valmistui äskettäin Texasin yliopistosta Dallasissa joulukuussa 2022 tietojenkäsittelytieteen maisteriksi erikoistumalla älykkäisiin järjestelmiin keskittyen tekoälyyn/ML:ään. Hän on kiinnostunut oppimaan lisää tekoälystä/ML:stä ja AWS-palveluiden hyödyntämisestä löytääkseen ratkaisuja, joista asiakkaat voivat hyötyä.

Medha Aiyah on AWS:n associate Solutions -arkkitehti, joka sijaitsee Austinissa, Texasissa. Hän valmistui äskettäin Texasin yliopistosta Dallasissa joulukuussa 2022 tietojenkäsittelytieteen maisteriksi erikoistumalla älykkäisiin järjestelmiin keskittyen tekoälyyn/ML:ään. Hän on kiinnostunut oppimaan lisää tekoälystä/ML:stä ja AWS-palveluiden hyödyntämisestä löytääkseen ratkaisuja, joista asiakkaat voivat hyötyä.

Hugo Tse on AWS:n associate Solutions -arkkitehti Seattlessa, Washingtonissa. Hän on suorittanut tietotekniikan maisterintutkinnon Arizonan osavaltion yliopistosta ja taloustieteen kandidaatin tutkinnon Chicagon yliopistosta. Hän on Information Systems Audit and Control Associationin (ISACA) ja International Information System Security Certification Consortiumin (ISC)2 jäsen. Hän haluaa auttaa asiakkaita hyötymään tekniikasta.

Hugo Tse on AWS:n associate Solutions -arkkitehti Seattlessa, Washingtonissa. Hän on suorittanut tietotekniikan maisterintutkinnon Arizonan osavaltion yliopistosta ja taloustieteen kandidaatin tutkinnon Chicagon yliopistosta. Hän on Information Systems Audit and Control Associationin (ISACA) ja International Information System Security Certification Consortiumin (ISC)2 jäsen. Hän haluaa auttaa asiakkaita hyötymään tekniikasta.

Ayman Ishimwe on AWS:n associate Solutions -arkkitehti Seattlessa, Washingtonissa. Hän on suorittanut ohjelmistotekniikan ja IT:n maisterin tutkinnon Oaklandin yliopistosta. Hänellä on aikaisempaa kokemusta ohjelmistokehityksestä, erityisesti mikropalveluiden rakentamisesta hajautetuille web-sovelluksille. Hän haluaa auttaa asiakkaita rakentamaan kestäviä ja skaalautuvia ratkaisuja AWS-pilvipalveluihin parhaiden käytäntöjen mukaisesti.

Ayman Ishimwe on AWS:n associate Solutions -arkkitehti Seattlessa, Washingtonissa. Hän on suorittanut ohjelmistotekniikan ja IT:n maisterin tutkinnon Oaklandin yliopistosta. Hänellä on aikaisempaa kokemusta ohjelmistokehityksestä, erityisesti mikropalveluiden rakentamisesta hajautetuille web-sovelluksille. Hän haluaa auttaa asiakkaita rakentamaan kestäviä ja skaalautuvia ratkaisuja AWS-pilvipalveluihin parhaiden käytäntöjen mukaisesti.

Shervin Suresh on AWS:n associate Solutions -arkkitehti Austinissa, Texasissa. Hän on valmistunut ohjelmistotekniikan maisteriksi, keskittyen pilvilaskentaan ja virtualisointiin, sekä tietotekniikan kandidaatin tutkinnon San Josen osavaltion yliopistosta. Hän on intohimoinen teknologian hyödyntämiseen, joka auttaa parantamaan eri taustoista tulevien ihmisten elämää.

Shervin Suresh on AWS:n associate Solutions -arkkitehti Austinissa, Texasissa. Hän on valmistunut ohjelmistotekniikan maisteriksi, keskittyen pilvilaskentaan ja virtualisointiin, sekä tietotekniikan kandidaatin tutkinnon San Josen osavaltion yliopistosta. Hän on intohimoinen teknologian hyödyntämiseen, joka auttaa parantamaan eri taustoista tulevien ihmisten elämää.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- ChartPrime. Nosta kaupankäyntipeliäsi ChartPrimen avulla. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- pystyy

- Meistä

- Hyväksyä

- pääsy

- Pääsy

- Tilit

- tarkka

- tarkasti

- toimet

- aktiivinen

- lisätä

- Lisäksi

- osoitteet

- käsitellään

- ylläpitäjät

- hyväksymällä

- neuvonantajat

- Jälkeen

- Agentti

- aineet

- aggregaatti

- AI

- Tekoälyn palvelut

- AI / ML

- Kaikki

- mahdollistaa

- pitkin

- Myös

- vaihtoehto

- Amazon

- Amazon API -yhdyskäytävä

- Amazon Cognito

- Amazonin käsitys

- Amazon Kendra

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- määrä

- määrät

- an

- analyytikot

- analyysit

- ja

- vastaus

- vastauksia

- Kaikki

- api

- näennäinen

- Hakemus

- sovellukset

- nimittäminen

- lähestymistapa

- hyväksyä

- arkkitehtuuri

- OVAT

- nousta

- arizona

- noin

- artikkeli

- keinotekoinen

- tekoäly

- Tekoäly (AI)

- taideteokset

- AS

- kysyä

- näkökohdat

- arvioida

- auttaa

- Apu

- Työtoveri

- liittyvä

- Yhdistys

- olettamus

- At

- tilintarkastus

- täydennetty

- Austin

- todennettu

- Authentication

- lupa

- automatisoida

- automaattisesti

- saatavuus

- saatavissa

- AWS

- AWS Lambda

- takaisin

- taustat

- pohja

- perustua

- BE

- Bear

- koska

- tulevat

- tulee

- ollut

- ennen

- puolesta

- takana

- hyödyttää

- Hyödyt

- PARAS

- parhaat käytännöt

- Paremmin

- Blogi

- kirja

- Bot

- sekä

- botit

- pohja

- merkki

- talousarvio

- rakentaa

- Rakentaminen

- rakennettu

- liiketoiminta

- yritykset

- mutta

- by

- soittaa

- CAN

- kyvyt

- Ura

- huolellisesti

- tapaus

- tapauksissa

- Kategoria

- aiheutti

- keskus

- keskitetty

- tietty

- Certification

- ketju

- haasteet

- muuttaa

- peritään

- chatbot

- tarkkailun

- Tarkastukset

- Chicago

- vaatimukset

- selkeä

- Kliininen

- kliinisiä tutkimuksia

- pilvi

- cloud computing

- pilvipalvelut

- kerätä

- kokoelma

- kaupallisesti

- Yhteinen

- Viestintä

- Yritykset

- yritys

- Yrityksen

- kilpailukykyinen

- Valmistunut

- Suoritettuaan

- monimutkainen

- monimutkaisuus

- noudatettava

- ymmärtää

- tietokone

- Tietotekniikka

- Tietojenkäsittelyoppi

- tietojenkäsittely

- keskittyminen

- käsite

- suppea

- tehty

- yhtymäkohta

- kytkeä

- Yhdistää

- harkinta

- näkökohdat

- harkittu

- johdonmukainen

- Koostuu

- Console

- konsortio

- kuluttaa

- kulutus

- ottaa yhteyttä

- yhteyskeskukseen

- sisältää

- pitoisuus

- tausta

- jatkuvasti

- vaikuttaa omalta

- ohjaus

- valvonta

- mukavuus

- Keskustelu

- puhekielen

- keskustelut

- Yrityksen

- korjata

- Hinta

- kustannukset

- tela

- luoda

- Luo arvoa

- luotu

- Luominen

- pisteitä

- kriteerit

- kriittinen

- CRM

- ratkaiseva

- kuratoitu

- Nykyinen

- Tällä hetkellä

- asiakas

- Asiakkaan sitoutuminen

- asiakaskokemus

- Asiakaspalvelu

- Asiakaspalvelu

- Asiakkaat

- päivittäin

- Dallas

- tiedot

- datapisteet

- tietueita

- tietokanta

- Päivämäärä

- joulukuu

- päättää

- päätös

- Päätöksenteko

- päätökset

- Aste

- toimitettu

- Riippuen

- käyttöön

- levityspinnalta

- kuvata

- Malli

- Huolimatta

- yksityiskohdat

- havaittu

- Detection

- Kehittäjä

- Kehitys

- kehitys

- eri

- vaikea

- löytää

- jaettu

- dokumentointi

- asiakirjat

- ei

- ei

- ajaa

- kesto

- e

- helpompaa

- helposti

- Taloustiede

- ekosysteemi

- painos

- tehokkuus

- vaivaa

- myöskään

- kelpoisuus

- sähköpostit

- Työntekijä

- työntekijää

- mahdollistaa

- kannustaa

- päätepiste

- energia

- sitoumus

- Moottori

- Tekniikka

- rikastuttava

- varmistaa

- varmistaa

- varmistamalla

- yritys

- yrityksille

- yksiköt

- virheet

- laajenemisen

- arvio

- jne.

- Jopa

- esimerkki

- suorittaa

- olemassa

- kallis

- experience

- Selittää

- selittää

- uuttaminen

- otteet

- Kasvot

- perhe

- Ominaisuus

- Fed

- vähemmän

- Kuva

- filee

- täyttää

- täynnä

- täyte

- suodattaa

- taloudellinen

- taloudelliset tiedot

- taloushistoria

- rahoituslaitos

- rahoitus

- Löytää

- löytäminen

- Etunimi

- Joustavuus

- virtaus

- tarkennus

- jälkeen

- varten

- muoto

- lomakkeet

- foorumit

- löytyi

- perusta

- puitteet

- Ilmainen

- ystäviä

- alkaen

- hauska

- toiminto

- tehtävät

- edelleen

- Saada

- portti

- tuottaa

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- tietty

- antaa

- Antaminen

- Hallitus

- suuresti

- Kasvaa

- Kasvava

- kasvaa

- ohjaus

- suuntaviivat

- kahva

- Vetimet

- Käsittely

- Olla

- ottaa

- he

- terveys

- terveystiedot

- terveydenhuollon

- auttaa

- auttaa

- auttaa

- hänen

- Korkea

- erittäin

- hänen

- historia

- pitää

- isännöi

- isännät

- TUNTIA

- Miten

- Miten

- Kuitenkin

- hr

- HTML

- HTTPS

- ihmisen

- i

- tunniste

- tunnisteet

- tunnistaa

- tunnistaa

- tunnistaminen

- Identiteetti

- if

- havainnollistaa

- toteuttaa

- täytäntöönpanosta

- vaikutukset

- parantaa

- parantaa

- parantaminen

- in

- perusteellinen

- epätarkka

- sisältää

- sisältää

- Mukaan lukien

- Tulo

- tulovero

- Kasvaa

- Lisäykset

- indeksi

- indeksoitu

- indeksit

- henkilöt

- teollisuuden

- ilmoittaa

- tiedot

- Tietojärjestelmä

- tietotekniikka

- tietoa

- perintö

- panos

- esimerkki

- välitön

- sen sijaan

- Laitos

- laitokset

- vakuutus

- integroitu

- integroi

- integraatio

- Älykkyys

- Älykäs

- tahallisuus

- olla vuorovaikutuksessa

- vuorovaikutteinen

- kiinnostunut

- liitäntä

- sisäinen

- kansainvälisesti

- tulee

- investointi

- kysymys

- IT

- kohdetta

- matka

- jpg

- Pitää

- tuntemus

- tunnettu

- Kieli

- suuri

- kerros

- johtaa

- OPPIA

- oppiminen

- vähemmän

- Taso

- vipuvaikutuksen

- Kirjasto

- rajoitus

- rajoitukset

- linja

- Lives

- OTK

- lainata

- Lainat

- log

- looginen

- Pitkät

- pitkä aika

- kauemmin

- katso

- Erä

- rakastaa

- edullisia

- alentaa

- uskollinen

- Uskollisuus

- kone

- koneoppiminen

- tehty

- ylläpitää

- tehdä

- TEE

- Tekeminen

- hoitaa

- johto

- tapa

- manuaalinen

- käsin

- monet

- markkinat

- markkinatutkimus

- maisterin

- Saattaa..

- välineet

- lääketieteellinen

- jäsen

- Muisti

- microservices

- Microsoft

- miljoona

- miljoonia

- mielessä

- ML

- malli

- mallit

- Moduulit

- Kuukausi

- kuukausittain

- lisää

- eniten

- moninkertainen

- syntyperäinen

- välttämätön

- Tarve

- tarvitaan

- tarpeet

- Uusi

- seuraava

- NLP

- ilmoituksen

- numerot

- Oakland

- OAuth

- of

- Tarjoukset

- usein

- Öljy

- on

- perehdytyksessä

- kerran

- ONE

- jatkuva

- vain

- avata

- käyttää

- toiminta

- toiminta-

- Tilaisuus

- optimointi

- Vaihtoehto

- Vaihtoehdot

- or

- tilata

- organisaatioiden

- alkuperäinen

- Muut

- meidän

- ulos

- ääriviivat

- ulkopuolella

- yli

- paradigma

- osa

- osat

- Hyväksytty

- intohimoinen

- potilas

- Maksaa

- Ihmiset

- varten

- suorituskyky

- Oikeudet

- henkilöstö

- henkilökohtaiset tiedot

- Henkilökohtaisesti

- Lääkealan

- Pilari

- suunnitelma

- Platon

- Platonin tietotieto

- PlatonData

- Ole hyvä

- Kohta

- pistettä

- politiikkaa

- Altaat

- Portal

- muotokuvia

- mahdollisuuksia

- mahdollisuus

- Kirje

- powered

- käytännöt

- esittää

- estää

- edellinen

- aiemmin

- hinnoittelu

- hinnoittelumalli

- Aikaisempi

- prioriteetti

- yksityisyys

- ongelmia

- menettelyt

- jatkaa

- prosessi

- Käsitelty

- Prosessit

- käsittely

- tuotanto

- tuottavuus

- Tuotteemme

- ammatillinen

- ammattilaiset

- omaisuus

- toimittaa

- mikäli

- tarjoajat

- tarjoamalla

- julkaistu

- osti

- Kysymyksiä ja vastauksia

- saada

- ajot

- kyselyt

- kysymys

- kysymykset

- nopea

- nopeasti

- alue

- hinta

- Lue

- Lukeminen

- reaaliaikainen

- äskettäinen

- äskettäin

- vähentää

- vähentää

- katso

- viittaaminen

- suhteen

- säännöllisesti

- määräykset

- yhteys

- Merkitys

- merkityksellinen

- luottaa

- jäännökset

- muistaa

- poistaa

- pyyntö

- pyynnöt

- edellyttää

- tarvitaan

- vaatimukset

- tutkimus

- Tutkijat

- päätöslauselma

- ratkaiseminen

- Esittelymateriaalit

- vastaus

- vasteet

- vastuu

- REST

- johtua

- palaavat

- tarkistetaan

- oikein

- riskit

- luja

- Reitti

- juoksu

- s

- sagemaker

- myynti

- San

- San Jose

- tyytyväisyys

- Säästä

- skaalautuva

- Asteikko

- skenaario

- tiede

- pisteet

- skriptejä

- Haku

- haku

- Seattle

- Toinen

- sekuntia

- Osa

- turvallinen

- turvallisesti

- turvallisuus

- myynti

- lähettää

- vanhempi

- sensible

- lähetetty

- serverless

- palvelee

- palvelu

- Palvelut

- setti

- Setit

- settings

- useat

- hän

- siirtää

- puutteet

- shouldnt

- malliesimerkki

- osoittivat

- esitetty

- siilot

- samankaltainen

- Yksinkertainen

- yksinkertaistaa

- koska

- single

- kokoinen

- pienempiä

- So

- sosiaalinen

- Tuotteemme

- ohjelmistokehitys

- ohjelmistotuotanto

- ratkaisu

- Ratkaisumme

- jonkin verran

- lähde

- Lähteet

- erikoistunut

- erityinen

- erityisesti

- viettää

- menot

- standardi

- Osavaltio

- Tila

- pysyä

- Vaihe

- Askeleet

- Yhä

- Levytila

- verkkokaupasta

- tallennettu

- tallentamiseksi

- stressi

- täyte

- merkittävä

- niin

- ehdottaa

- yhteenveto

- tuki

- järjestelmä

- järjestelmät

- taulukko

- vie

- tehtävät

- vero

- joukkue-

- tiimit

- Elektroniikka

- ehdot

- texas

- teksti

- teksti-

- että

- -

- tiedot

- heidän

- itse

- sitten

- Siellä.

- Nämä

- ne

- kolmannen osapuolen

- tätä

- Kautta

- lippu

- lipunmyynti

- porras

- aika

- aikaavievä

- ajankohtainen

- kertaa

- aikaleima

- Titaani

- että

- tänään

- tokens

- työkalu

- työkalut

- Jäljitettävyys

- perinteisesti

- koulutettu

- koulutus

- muuntaja

- Läpinäkyvyys

- hoito

- oikeudenkäynti

- tutkimuksissa

- oppitunti

- tyypit

- kykenemätön

- ymmärtää

- ymmärtäminen

- unique

- Yliopistot

- yliopisto

- University of Chicago

- ajanmukainen

- päivitetty

- päivittäminen

- käyttää

- käyttölaukku

- käytetty

- käyttäjä

- Käyttäjät

- käyttötarkoituksiin

- käyttämällä

- käyttää

- hyödynnetty

- Hyödyntämällä

- arvo

- eri

- Vahvistus

- todentaa

- pystysuunnassa

- kautta

- Video

- Videoita

- Ääni

- odottaa

- odotus

- oli

- Washington

- tavalla

- we

- verkko

- Web-sovellus

- web-sovellukset

- verkkopalvelut

- HYVIN

- olivat

- Mitä

- kun

- onko

- joka

- vaikka

- KUKA

- leveä

- Laaja valikoima

- with

- sisällä

- Referenssit

- työnkulku

- työskentely

- olisi

- kirjallinen

- vuotta

- Voit

- Sinun

- zephyrnet