Käyttäjien tiedot: LLMs' Vital Food

Joo! RT @bryce rakastan tätä lainausta "Jos et maksa siitä, et ole asiakas; olet myytävä tuote." http://bit.ly/93JYCJ

- Tim O'Reilly (@timoreilly) Syyskuu 2, 2010

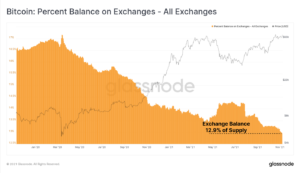

Pysy ajan tasalla kryptouutisista, saat päivittäiset päivitykset postilaatikkoosi.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :on

- :On

- :ei

- 7

- 8

- a

- kyky

- absoluuttinen

- Mukaan

- tarkka

- mukauttaminen

- käsitellään

- Lisää

- kehittynyt

- sitten

- suostuu

- AI

- Tekoälyn palvelut

- AI-järjestelmät

- tavoitteet

- Alexa

- Kohdistaa

- Kaikki

- mahdollistaa

- Myös

- aina

- Amazon

- an

- ja

- Antropinen

- ennakoida

- Kaikki

- sovelletaan

- OVAT

- AS

- olettaa

- At

- saatavissa

- välttämällä

- tietoinen

- perustua

- BE

- koska

- ovat

- uskoi

- suotuisa

- Paremmin

- välillä

- by

- CAN

- vaatimukset

- asiakkaat

- kaupallinen

- sitoutuminen

- sitoutuu

- Yritykset

- yritys

- kilpailukykyinen

- käsite

- huolenaiheet

- alituisesti

- pitoisuus

- tausta

- jatkuvasti

- ohjaus

- Mukava

- keskustelut

- tekijänoikeus

- voisi

- ratkaiseva

- Crypto

- Crypto News

- Nykyinen

- asiakas

- Asiakkaat

- päivittäin

- tumma

- tiedot

- Tietosuoja

- keskustelu

- vuosikymmeninä

- Pura

- syvä

- syvä oppiminen

- oletusarvo

- Puolustus

- tuottaa

- riippuu

- sanoutuu

- riidat

- Monimuotoisuus

- do

- asiakirja

- ei

- dollaria

- Dont

- aikana

- ansaita

- reuna

- tehokkuuden

- myöskään

- sitoumus

- parantaa

- varmistaa

- olennainen

- eettinen

- etiikka

- esimerkki

- Vaihdetaan

- experience

- laaja

- laajuus

- ulkoinen

- päin

- varten

- Entinen

- Perustettu

- Ilmainen

- alkaen

- saamassa

- tuottaa

- syntyy

- synnyttää

- generatiivinen

- Generatiivinen AI

- saada

- saada

- jättiläiset

- Antaa

- Go

- myöntää

- ymmärtää

- kasvaa

- raskaasti

- rehellinen

- kunnia

- Kuitenkin

- http

- HTTPS

- ihmisen

- ihanteet

- if

- parantaa

- in

- henkilökohtainen

- tiedot

- henkinen

- tekijänoikeuksien

- aikomukset

- vuorovaikutukset

- sisäinen

- IP

- IT

- SEN

- itse

- avain

- Kieli

- suuri

- uusin

- Laki

- johtaa

- OPPIA

- oppiminen

- juridinen

- Vaikutusvalta

- pitää

- liekki

- OTK

- rakkaus

- tehdä

- Tekeminen

- Saattaa..

- Media

- Meta

- miljoonia

- malli

- mallit

- lisää

- eniten

- verkot

- hermo-

- hermoverkkoihin

- Uusi

- uutiset

- saada

- of

- on

- OpenAI

- or

- näennäisesti

- muuten

- meidän

- ulos

- lähdöt

- yli

- oma

- omistaa

- maksettu

- osapuolet

- puolue

- kuviot

- Maksaa

- maksaa

- henkilöstö

- Personointi

- yksilöllinen

- Valokuvat

- Platon

- Platonin tietotieto

- PlatonData

- politiikka

- mahdollinen

- teho

- voimakas

- käytännöt

- ennustaa

- Ennusteet

- mieltymykset

- vallitseva

- yksityisyys

- yksityinen

- valmistettu

- Tuotteet

- ohjeita

- omaisuus

- toimittaa

- tarjoaa

- julkinen

- yleistä luottamusta

- julkisesti

- lainata

- kilpa

- RE

- todellinen maailma

- vastaanottaa

- tarkentaa

- ottaa huomioon

- suhteellinen

- vapauta

- merkityksellinen

- raportoitu

- pyynnöt

- Tutkijat

- vastuullinen

- Revealed

- oikeudet

- kilpailijat

- rt

- Ryan

- s

- sanoa

- sanoo

- kohtaus

- palvelu

- Palvelut

- setti

- Jaa:

- shouldnt

- skeptisyys

- So

- sosiaalinen

- sosiaalinen media

- myyty

- LOITSU

- tiedottaja

- käynnistyksen

- Lausunto

- pysyä

- Vaihe

- järjestelmät

- Tandem

- teknologia

- tekniikan jättiläiset

- tekniikat

- ehdot

- teksti

- että

- -

- heidän

- Niitä

- Nämä

- ne

- tätä

- Tim

- että

- tänään

- ylin

- Juna

- koulutettu

- koulutus

- Läpinäkyvyys

- Trendit

- Luottamus

- varten

- ymmärtää

- ymmärtäminen

- tuleva

- päivitetty

- Päivitykset

- päivitetty

- ladattu

- käyttää

- käytetty

- käyttäjä

- Käyttäjät

- käyttämällä

- arvokas

- eri

- versio

- Videoita

- elintärkeä

- Ääni

- tilavuus

- oli

- we

- olivat

- kun

- onko

- joka

- miksi

- tulee

- with

- sana

- olisi

- Voit

- Sinun

- zephyrnet