Tämä on vieraspostaus, jonka ovat kirjoittaneet Nafi Ahmet Turgut, Hasan Burak Yel ja Damla Şentürk Getiristä.

Perustettu vuonna 2015, toi on asettanut itsensä edelläkävijäksi ultranopean päivittäistavaratoimituksen alalla. Tämä innovatiivinen teknologiayritys on mullistanut viimeisen mailin toimitussegmentin houkuttelevalla "elintarvikkeiden muutamassa minuutissa" tarjouksella. Getirillä on läsnäolo Turkissa, Isossa-Britanniassa, Alankomaissa, Saksassa ja Yhdysvalloissa, ja siitä on tullut monikansallinen voima, jonka kanssa on otettava huomioon. Nykyään Getir-brändi edustaa monipuolista ryhmittymää, joka kattaa yhdeksän eri toimialaa, jotka kaikki toimivat synergistisesti yksittäisen sateenvarjon alla.

Tässä viestissä selitämme, kuinka rakensimme päästä päähän tuoteluokkien ennustusputkien auttamaan kaupallisia tiimejä käyttämällä Amazon Sage Maker ja AWS-erä, mikä vähentää malliharjoittelun kestoa 90 %.

Nykyisen tuotevalikoimamme yksityiskohtainen ymmärtäminen on meille monien yritysten kanssa ratkaiseva haaste nykypäivän nopeatempoisilla ja kilpailluilla markkinoilla. Tehokas ratkaisu tähän ongelmaan on tuotekategorioiden ennustaminen. Mallin, joka luo kattavan luokkapuun, kaupalliset tiimimme voivat verrata olemassa olevaa tuotevalikoimaamme kilpailijoidemme tuotevalikoimaan, mikä tarjoaa strategisen edun. Siksi keskeinen haasteemme on tarkan tuotekategorian ennustemallin luominen ja käyttöönotto.

Hyödynnämme AWS:n tarjoamia tehokkaita työkaluja vastataksemme tähän haasteeseen ja navigoidaksemme tehokkaasti koneoppimisen (ML) ja ennakoivan analytiikan monimutkaisella alalla. Pyrkimyksemme johti onnistuneesti kokonaisvaltaisen tuotekategorian ennustusputkiston luomiseen, jossa yhdistyvät SageMakerin ja AWS Batchin vahvuudet.

Tämä ennakoivan analytiikan kyky, erityisesti tuoteluokkien tarkka ennuste, on osoittautunut korvaamattomaksi. Se tarjosi tiimeillemme kriittisiä tietoihin perustuvia oivalluksia, jotka optimoivat varastonhallinnan, tehostivat asiakasvuorovaikutusta ja vahvistivat läsnäoloamme markkinoilla.

Tässä viestissä selitetty menetelmä vaihtelee ominaisuusjoukon keräämisen alkuvaiheesta ennusteputken lopulliseen toteutukseen. Tärkeä osa strategiaamme on ollut SageMakerin ja AWS Batchin käyttö esikoulutettujen BERT-mallien jalostukseen seitsemälle eri kielelle. Lisäksi saumaton integraatiomme AWS:n objektitallennuspalveluun Amazonin yksinkertainen tallennuspalvelu (Amazon S3) on ollut avain näiden hienostuneiden mallien tehokkaaseen tallentamiseen ja käyttöön.

SageMaker on täysin hallittu ML-palvelu. SageMakerin avulla datatieteilijät ja -kehittäjät voivat nopeasti ja vaivattomasti rakentaa ja kouluttaa ML-malleja ja ottaa ne sitten suoraan käyttöön tuotantovalmiissa isännöitävissä olosuhteissa.

Täysin hallittavana palveluna AWS Batch auttaa sinua suorittamaan minkä tahansa mittakaavan erälaskentaa. AWS Batch huolehtii automaattisesti laskentaresursseista ja optimoi työtaakan jakautumisen työkuormien määrän ja laajuuden perusteella. AWS Batchin avulla sinun ei tarvitse asentaa tai hallita erälaskentaohjelmistoja, joten voit keskittyä tulosten analysointiin ja ongelmien ratkaisemiseen. Käytimme GPU-töitä, jotka auttavat meitä suorittamaan töitä, jotka käyttävät ilmentymän GPU:ia.

Katsaus ratkaisuun

Viisi henkilöä Getirin datatieteen tiimistä ja infrastruktuuritiimistä työskenteli yhdessä tämän projektin parissa. Projekti valmistui kuukaudessa ja otettiin tuotantoon viikon testauksen jälkeen.

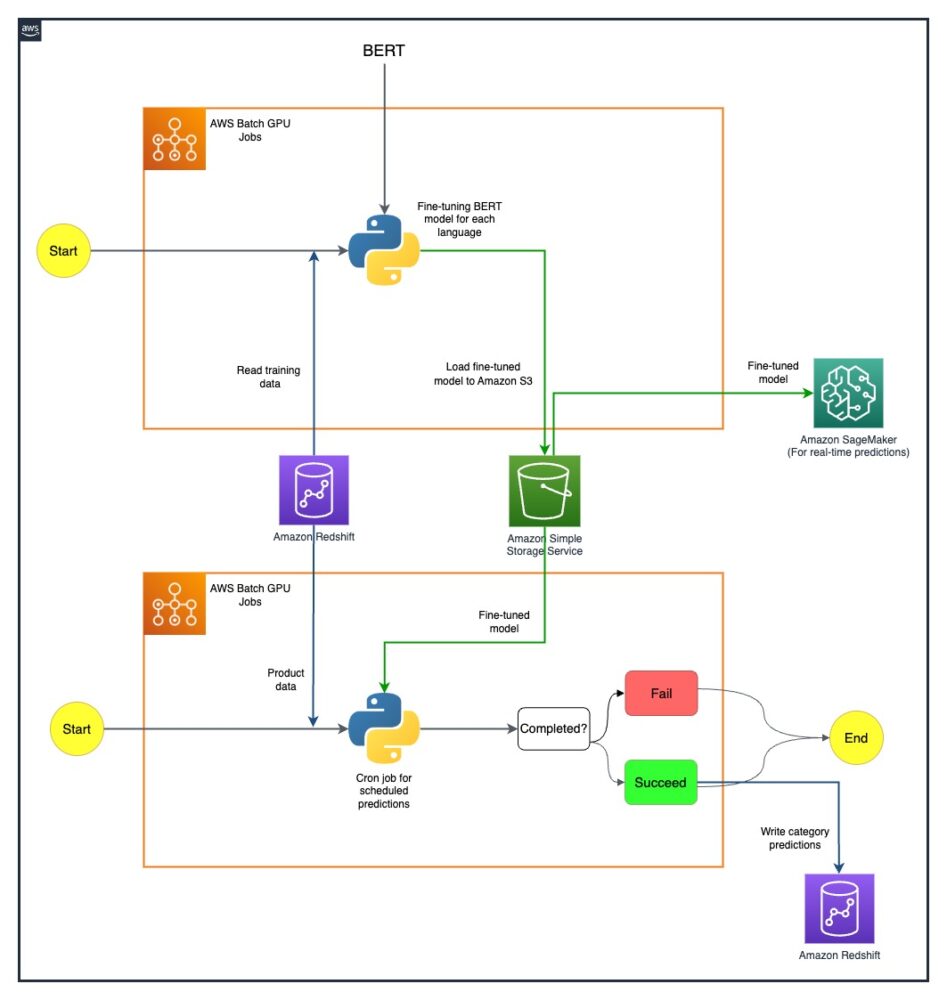

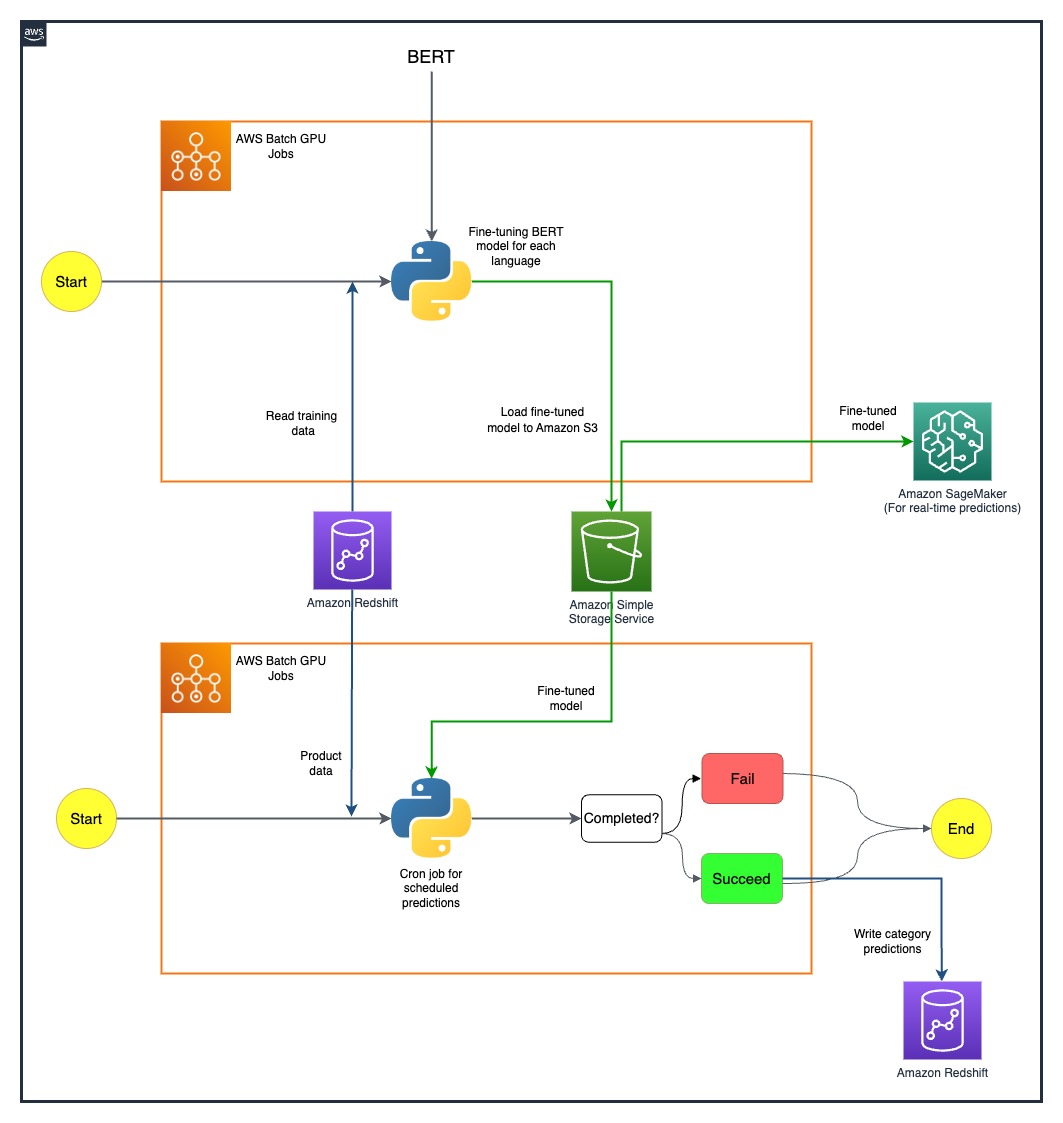

Seuraavassa kaaviossa näkyy ratkaisun arkkitehtuuri.

Malliputkisto ajetaan erikseen jokaiselle maalle. Arkkitehtuuri sisältää kaksi AWS Batch GPU cron -työtä kullekin maalle, jotka suoritetaan määritetyin aikatauluin.

Voitimme joitakin haasteita ottamalla SageMaker- ja AWS Batch GPU -resurssit strategisesti käyttöön. Kunkin ongelman ratkaisemiseen käytetty prosessi on kuvattu yksityiskohtaisesti seuraavissa osissa.

Hienosäätää monikielisiä BERT-malleja AWS Batch GPU -töillä

Etsimme ratkaisua useiden kielten tukemiseen monipuoliselle käyttäjäkunnallemme. BERT-mallit olivat ilmeinen valinta, koska ne pystyivät hoitamaan monimutkaisia luonnollisen kielen tehtäviä tehokkaasti. Räätälöimme nämä mallit tarpeisiimme, valjastimme AWS:n tehon käyttämällä yhden solmun GPU-ilmentymiä. Tämän ansiosta pystyimme hienosäätämään esikoulutettuja BERT-malleja jokaiselle seitsemälle kielelle, joille tarvitsimme tukea. Tällä menetelmällä varmistimme korkean tarkkuuden tuotekategorioiden ennustamisessa ja ylittimme mahdolliset kielimuurit.

Tehokas mallin tallennus Amazon S3:lla

Seuraava askelemme oli käsitellä mallin varastointia ja hallintaa. Tätä varten valitsimme Amazon S3:n, joka tunnetaan skaalautumisestaan ja turvallisuudestaan. Hienosäädettyjen BERT-malliemme tallentaminen Amazon S3:lle mahdollisti helpon pääsyn organisaatiomme eri ryhmiin, mikä virtaviivaisti käyttöönottoprosessiamme merkittävästi. Tämä oli ratkaiseva näkökohta toimintojemme ketteryyden saavuttamisessa ja ML-ponnistelujemme saumattomassa yhdistämisessä.

Päästä päähän -ennusteputken luominen

Tehokas putkisto vaadittiin, jotta valmiiksi koulutettuja mallejamme voitaisiin hyödyntää parhaalla mahdollisella tavalla. Otimme nämä mallit käyttöön ensin SageMakerissa, joka mahdollisti reaaliaikaiset ennusteet pienellä viiveellä, mikä paransi käyttökokemustamme. Laajemman mittakaavan eräennusteissa, jotka olivat yhtä tärkeitä toiminnallemme, käytimme AWS Batch GPU -töitä. Tämä varmisti resurssien optimaalisen käytön ja tarjosi meille täydellisen suorituskyvyn ja tehokkuuden tasapainon.

Tulevaisuuden mahdollisuuksien tutkiminen SageMaker MME:iden kanssa

Kun jatkamme kehitystä ja etsimme tehokkuutta ML-putkistossamme, yksi keino, jota haluamme tutkia, on SageMaker-multimallien päätepisteiden (MME) käyttö hienosäädetyille malleillemme. MME:n avulla voimme mahdollisesti virtaviivaistaa erilaisten hienosäädettyjen mallien käyttöönottoa ja varmistaa tehokkaan mallinhallinnan ja samalla hyötyä SageMakerin alkuperäisistä ominaisuuksista, kuten varjovarianteista, automaattisesta skaalauksesta ja amazonin pilvikello liittäminen. Tämä tutkimus on linjassa jatkuvan pyrkimyksemme kanssa parantaa ennakoivaa analytiikkaa ja tarjota asiakkaillemme ylivoimaisia kokemuksia.

Yhteenveto

Onnistunut SageMaker- ja AWS Batch -integraatiomme ei ole ainoastaan ratkaissut erityisiä haasteitamme, vaan myös parantanut merkittävästi toimintamme tehokkuutta. Kehittyneen tuoteluokkien ennustusputken käyttöönoton avulla pystymme antamaan kaupallisille tiimeillemme datapohjaisia oivalluksia, mikä helpottaa tehokkaampaa päätöksentekoa.

Tuloksemme kertovat paljon lähestymistapamme tehokkuudesta. Olemme saavuttaneet 80 %:n ennustetarkkuuden kaikilla neljällä kategorian tarkkuustasolla, millä on tärkeä rooli tuotevalikoiman muovaamisessa jokaisessa maassa, jossa palvelemme. Tämä tarkkuus laajentaa ulottuvuutemme kielimuurien ulkopuolelle ja varmistaa, että palvelemme monipuolista käyttäjäkuntaamme äärimmäisen tarkasti.

Lisäksi käyttämällä ajoitettuja AWS Batch GPU -töitä strategisesti olemme pystyneet lyhentämään mallin koulutusaikoja 90 %. Tämä tehokkuus on edelleen virtaviivaistanut prosessejamme ja vahvistanut toimintamme ketteryyttä. Tehokas mallin tallennus Amazon S3:lla on ollut ratkaisevassa roolissa tässä saavutuksessa ja tasapainottanut sekä reaaliaikaisia että eräennusteita.

Lisätietoja omien ML-putkien rakentamisen aloittamisesta SageMakerin avulla on kohdassa Amazon SageMaker -resurssit. AWS Batch on erinomainen vaihtoehto, jos etsit edullista, skaalautuvaa ratkaisua erätöiden suorittamiseen pienillä käyttökustannuksilla. Aloita katsomalla AWS Batchin käytön aloittaminen.

Tietoja Tekijät

Nafi Ahmet Turgut valmistui sähkö- ja elektroniikkatekniikan maisteriksi ja työskenteli tutkijana. Hän keskittyi koneoppimisalgoritmien rakentamiseen hermostuneiden verkkopoikkeamien simuloimiseksi. Hän tuli Getirille vuonna 2019 ja työskentelee tällä hetkellä Senior Data Science & Analytics Managerina. Hänen tiiminsä on vastuussa Getirin kokonaisvaltaisten koneoppimisalgoritmien ja dataohjattujen ratkaisujen suunnittelusta, toteutuksesta ja ylläpidosta.

Nafi Ahmet Turgut valmistui sähkö- ja elektroniikkatekniikan maisteriksi ja työskenteli tutkijana. Hän keskittyi koneoppimisalgoritmien rakentamiseen hermostuneiden verkkopoikkeamien simuloimiseksi. Hän tuli Getirille vuonna 2019 ja työskentelee tällä hetkellä Senior Data Science & Analytics Managerina. Hänen tiiminsä on vastuussa Getirin kokonaisvaltaisten koneoppimisalgoritmien ja dataohjattujen ratkaisujen suunnittelusta, toteutuksesta ja ylläpidosta.

Hasan Burak Yel suoritti kandidaatin tutkinnon sähkö- ja elektroniikkatekniikasta Boğaziçin yliopistossa. Hän työskenteli Turkcellissa keskittyen pääasiassa aikasarjaennusteisiin, datan visualisointiin ja verkkoautomaatioon. Hän liittyi Getiriin vuonna 2021 ja työskentelee tällä hetkellä Data Science & Analytics Managerina ja vastaa haku-, suositus- ja kasvualueista.

Hasan Burak Yel suoritti kandidaatin tutkinnon sähkö- ja elektroniikkatekniikasta Boğaziçin yliopistossa. Hän työskenteli Turkcellissa keskittyen pääasiassa aikasarjaennusteisiin, datan visualisointiin ja verkkoautomaatioon. Hän liittyi Getiriin vuonna 2021 ja työskentelee tällä hetkellä Data Science & Analytics Managerina ja vastaa haku-, suositus- ja kasvualueista.

Damla Şentürk suoritti tietokonetekniikan kandidaatin tutkinnon Galatasarayn yliopistossa. Hän jatkaa tietokonetekniikan maisterin tutkintoa Boğaziçi-yliopistossa. Hän liittyi Getiriin vuonna 2022 ja on työskennellyt tietotutkijana. Hän on työskennellyt kaupallisissa, toimitusketjuissa ja löytöihin liittyvissä projekteissa.

Damla Şentürk suoritti tietokonetekniikan kandidaatin tutkinnon Galatasarayn yliopistossa. Hän jatkaa tietokonetekniikan maisterin tutkintoa Boğaziçi-yliopistossa. Hän liittyi Getiriin vuonna 2022 ja on työskennellyt tietotutkijana. Hän on työskennellyt kaupallisissa, toimitusketjuissa ja löytöihin liittyvissä projekteissa.

Esra Kayabalı on AWS:n vanhempi ratkaisuarkkitehti, joka on erikoistunut analytiikka-alueisiin, mukaan lukien tietovarastointi, datajärvet, big data-analytiikka, erä- ja reaaliaikainen datan suoratoisto sekä tietojen integrointi. Hänellä on 12 vuoden kokemus ohjelmistokehityksestä ja arkkitehtuurista. Hän on intohimoinen pilviteknologioiden oppimiseen ja opettamiseen.

Esra Kayabalı on AWS:n vanhempi ratkaisuarkkitehti, joka on erikoistunut analytiikka-alueisiin, mukaan lukien tietovarastointi, datajärvet, big data-analytiikka, erä- ja reaaliaikainen datan suoratoisto sekä tietojen integrointi. Hänellä on 12 vuoden kokemus ohjelmistokehityksestä ja arkkitehtuurista. Hän on intohimoinen pilviteknologioiden oppimiseen ja opettamiseen.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :on

- :On

- :ei

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- kyky

- pystyy

- Meistä

- pääsy

- Pääsy

- tarkkuus

- tarkka

- saavutettu

- saavutus

- saavuttamisessa

- poikki

- Toiminta

- Lisäksi

- osoite

- osoitettu

- Etu

- Jälkeen

- vastaan

- algoritmit

- Kohdistaa

- Kaikki

- sallittu

- mahdollistaa

- pitkin

- Myös

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- an

- Analytics

- analysointi

- ja

- ja infrastruktuuri

- poikkeavuuksia

- Kaikki

- arkkitehtuuri

- OVAT

- AS

- ulkomuoto

- lajitelma

- At

- auto

- automaattisesti

- Automaatio

- Katu

- AWS

- Balance

- tasapainotus

- esteet

- pohja

- perustua

- BE

- tulevat

- ollut

- benchmark

- hyötyvät

- PARAS

- Jälkeen

- Iso

- Big Data

- Boostatut

- sekä

- merkki

- rakentaa

- Rakentaminen

- rakennettu

- yritykset

- mutta

- by

- CAN

- kyvyt

- valmiudet

- Aktivoitujen

- luokat

- Kategoria

- tyydyttää

- keskeinen

- ketju

- haaste

- haasteet

- valinta

- pilvi

- yhdistää

- kaupallinen

- yritys

- pakottava

- kilpailukykyinen

- kilpailijat

- Valmistunut

- monimutkainen

- kattava

- Laskea

- tietokone

- Tietotekniikka

- tietojenkäsittely

- monialayritys

- jatkaa

- jatkuu

- jatkuva

- maa

- luominen

- kriittinen

- ratkaiseva

- Tällä hetkellä

- asiakas

- Asiakkaat

- tiedot

- Data Analytics

- tietojenkäsittely

- tietojen tutkija

- datan visualisointi

- data-driven

- Päätöksenteko

- määritelty

- Aste

- toimitus

- sijoittaa

- käyttöön

- levityspinnalta

- käyttöönotto

- suunnittelu

- yksityiskohtainen

- kehittäjille

- Kehitys

- eri

- vaikeus

- suoraan

- jakelu

- useat

- monipuolinen

- verkkotunnuksen

- verkkotunnuksia

- kaksi

- kesto

- kukin

- helppo

- Tehokas

- tehokkaasti

- tehokkuuden

- hyötysuhteet

- tehokkuus

- tehokas

- tehokkaasti

- vaivattomasti

- ponnisteluja

- Elektroniikka

- valtuuttaa

- käytössä

- kattaa

- päittäin

- Tekniikka

- tehostettu

- parantaa

- varmistettu

- varmistaa

- varmistamalla

- ympäristö

- yhtä

- vakiintunut

- kehittää

- erinomainen

- olemassa

- experience

- Elämykset

- Selittää

- tutkimus

- tutkia

- ulottuu

- Kasvot

- helpottaminen

- nopeatempoinen

- Ominaisuus

- ala

- lopullinen

- Etunimi

- Keskittää

- keskityttiin

- jälkeen

- varten

- voima

- Ennuste

- neljä

- alkaen

- täysin

- edelleen

- tulevaisuutta

- keräys

- synnyttää

- Saksa

- saada

- GPU

- GPU

- valmistua

- Kasvu

- vieras

- vieras Lähetä

- kahva

- Olla

- he

- auttaa

- auttaa

- hänen

- Korkea

- hänen

- isännöi

- Miten

- Miten

- HTML

- http

- HTTPS

- if

- täytäntöönpano

- täytäntöönpanosta

- tärkeä

- tärkeä näkökohta

- in

- sisältää

- Mukaan lukien

- tiedot

- Infrastruktuuri

- ensimmäinen

- innovatiivinen

- oivalluksia

- asentaa

- esimerkki

- integraatio

- vuorovaikutukset

- tulee

- korvaamaton

- inventaario

- Inventory Management

- IT

- SEN

- itse

- Työpaikat

- liittyi

- jpg

- Innokas

- avain

- tunnettu

- järvet

- Kieli

- kielet

- Viive

- oppiminen

- Led

- Taso

- tasot

- pitää

- näköinen

- Matala

- edullisia

- kone

- koneoppiminen

- pääasiallisesti

- ylläpitäminen

- tehdä

- hoitaa

- onnistui

- johto

- johtaja

- tapa

- monet

- markkinat

- maisterin

- menetelmä

- Metodologia

- minuuttia

- ML

- malli

- mallit

- Kuukausi

- lisää

- monikansallinen

- moninkertainen

- syntyperäinen

- Luonnollinen

- Navigoida

- Tarve

- tarpeet

- Alankomaat

- verkko

- seuraava

- yhdeksän

- Nro

- objekti

- Ilmeinen

- of

- tarjoamalla

- on

- ONE

- vain

- toiminta-

- Operations

- optimaalinen

- optimoitu

- Optimismi

- Vaihtoehto

- or

- tilata

- organisaatio

- meidän

- voittaminen

- oma

- erityisesti

- intohimoinen

- Ihmiset

- täydellinen

- suorituskyky

- vaihe

- putki

- Platon

- Platonin tietotieto

- PlatonData

- pelataan

- soittaa

- salkku

- asemoitu

- mahdollisuuksia

- Kirje

- mahdollinen

- mahdollisesti

- teho

- voimakas

- Tarkkuus

- ennustamiseen

- ennustus

- Ennusteet

- Ennakoiva Analytics

- läsnäolo

- Ongelma

- ongelmia

- prosessi

- Prosessit

- Tuotteet

- tuotanto

- projekti

- hankkeet

- todistettu

- toimittaa

- mikäli

- tarjoamalla

- harjoittamisesta

- määrä

- nopeasti

- vaihtelee

- tavoittaa

- reaaliaikainen

- reaaliaikainen data

- sai

- Suositus

- vähentää

- Vähentynyt

- vähentämällä

- tarkentaa

- puhdistettu

- edustaa

- tarvitaan

- tutkimus

- Esittelymateriaalit

- vastuu

- vastuullinen

- tulokset

- mullistanut

- Rooli

- ajaa

- juoksu

- sagemaker

- skaalautuvuus

- skaalautuva

- Asteikko

- skaalaus

- suunniteltu

- tiede

- Tiedemies

- tutkijat

- saumaton

- Haku

- osiot

- turvallisuus

- nähdä

- etsiä

- segmentti

- valittu

- vanhempi

- Sarjat

- palvella

- palvelu

- Palvelut

- setti

- seitsemän

- varjo

- muotoiluun

- hän

- Näytä

- merkittävästi

- Yksinkertainen

- yksikkö

- So

- Tuotteemme

- ohjelmistokehitys

- ratkaisu

- Ratkaisumme

- Solving

- jonkin verran

- hienostunut

- pyrittiin

- puhua

- erikoistunut

- erityinen

- alkoi

- Valtiot

- Vaihe

- Levytila

- tallentamiseksi

- Strateginen

- strategisesti

- Strategia

- streaming

- tehostaa

- virtaviivainen

- virtaviivaistaminen

- vahvistui

- vahvuudet

- onnistunut

- esimies

- toimittaa

- toimitusketju

- tuki

- puuttua

- räätälöidä

- tehtävät

- Opetus

- joukkue-

- tiimit

- teknologia

- Tekninen yritys

- Technologies

- Testaus

- että

- -

- Alankomaat

- UK

- heidän

- Niitä

- sitten

- siten

- siksi

- Nämä

- tätä

- Kautta

- aika

- Aikasarja

- että

- tänään

- tämän päivän

- yhdessä

- työkalut

- uranuurtaja

- Juna

- koulutus

- puu

- Turkki

- kaksi

- Uk

- sateenvarjo

- varten

- Yhtenäinen

- Yhdysvallat

- yliopisto

- us

- käyttää

- käytetty

- käyttäjä

- Käyttäjäkokemus

- käyttämällä

- hyödynnetty

- äärimmäisen

- eri

- pystysuunnassa

- visualisointi

- elintärkeä

- volyymit

- oli

- we

- verkko

- verkkopalvelut

- viikko

- olivat

- joka

- vaikka

- with

- sisällä

- työskenteli

- työskentely

- toimii

- vuotta

- Voit

- Sinun

- zephyrnet