Radiologian raportit ovat kattavia, pitkiä asiakirjoja, jotka kuvaavat ja tulkitsevat radiologisen kuvantamistutkimuksen tuloksia. Tyypillisessä työnkulussa radiologi valvoo, lukee ja tulkitsee kuvia ja tekee sitten lyhyen yhteenvedon tärkeimmistä havainnoista. Yhteenveto (tai vaikutus) on raportin tärkein osa, koska se auttaa kliinikkoja ja potilaita keskittymään raportin kriittiseen sisältöön, joka sisältää tietoa kliinistä päätöksentekoa varten. Selkeän ja vaikuttavan vaikutelman luominen vaatii paljon enemmän vaivaa kuin pelkkä tulosten toistaminen. Koko prosessi on siksi työläs, aikaa vievä ja virhealtis. Usein siihen menee vuosia koulutus Lääkäreille kertyy riittävästi asiantuntemusta tiiviiden ja informatiivisten radiologian raporttitiivistelmien kirjoittamisesta, mikä korostaa entisestään prosessin automatisoinnin merkitystä. Lisäksi automaattinen raporttilöydösten yhteenvedon luominen on kriittinen radiologian raportoinnissa. Se mahdollistaa raporttien kääntämisen ihmisten luettavalle kielelle, mikä keventää potilaiden taakkaa lukea pitkiä ja epäselviä raportteja.

Tämän ongelman ratkaisemiseksi ehdotamme generatiivisen tekoälyn käyttöä, eräänlaista tekoälyä, joka voi luoda uutta sisältöä ja ideoita, kuten keskusteluja, tarinoita, kuvia, videoita ja musiikkia. Generatiivinen tekoäly perustuu koneoppimismalleihin (ML) – erittäin suuriin malleihin, jotka on valmiiksi koulutettu suurille tietomäärille ja joita kutsutaan yleisesti perusmalleiksi (FM). Viimeaikaiset edistysaskeleet ML:ssä (erityisesti muuntajapohjaisen hermoverkkoarkkitehtuurin keksintö) ovat johtaneet miljardeja parametreja tai muuttujia sisältävien mallien nousuun. Tässä viestissä ehdotettu ratkaisu käyttää valmiiksi koulutettujen suurten kielimallien (LLM) hienosäätöä, joka auttaa luomaan yhteenvetoja radiologiaraporttien havaintojen perusteella.

Tämä viesti esittelee strategian julkisesti saatavilla olevien LLM:ien hienosäätämiseksi radiologiaraporttien yhteenvetotehtävää varten AWS-palveluiden avulla. LLM:t ovat osoittaneet merkittäviä kykyjä luonnollisen kielen ymmärtämisessä ja luomisessa, toimien perusmalleina, joita voidaan mukauttaa erilaisiin alueisiin ja tehtäviin. Esikoulutetun mallin käytöllä on merkittäviä etuja. Se vähentää laskentakustannuksia, pienentää hiilijalanjälkeä ja antaa sinun käyttää huippuluokan malleja ilman, että sinun tarvitsee kouluttaa niitä tyhjästä.

Ratkaisumme käyttää FLAN-T5 XL FM, käytössä Amazon SageMaker JumpStart, joka on ML-keskus, joka tarjoaa algoritmeja, malleja ja ML-ratkaisuja. Näytämme, kuinka tämä tehdään muistikirjan avulla Amazon SageMaker Studio. Valmiiksi koulutetun mallin hienosäätö sisältää lisäkoulutusta tiettyihin tietoihin, jotta voidaan parantaa suorituskykyä erilaisessa mutta liittyvässä tehtävässä. Tämä ratkaisu sisältää FLAN-T5 XL -mallin hienosäädön, joka on paranneltu versio T5 (Text-to-Text Transfer Transformer) yleiskäyttöiset LLM:t. T5 kehystää luonnollisen kielen käsittelyn (NLP) tehtävät yhtenäiseksi tekstistä tekstiksi -muotoon, toisin kuin BERTI-tyyliset mallit, jotka voivat tulostaa vain joko luokkatunnisteen tai syötteen span. Se on hienosäädetty yhteenvetotehtävää varten 91,544 XNUMX vapaan tekstin radiologian raportista, jotka on saatu MIMIC-CXR-tietojoukko.

Katsaus ratkaisuun

Tässä osiossa käsittelemme ratkaisumme avainkomponentteja: tehtävän strategian valintaa, LLM:n hienosäätöä ja tulosten arviointia. Kuvaamme myös ratkaisun arkkitehtuuria ja vaiheet ratkaisun toteuttamiseksi.

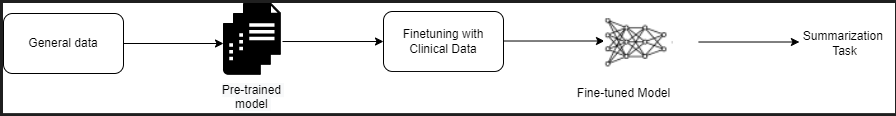

Tunnista tehtävän strategia

Kliinisen raportin yhteenvedon automatisointiin on olemassa erilaisia strategioita. Voisimme esimerkiksi käyttää erikoistunutta kielimallia, joka on valmiiksi koulutettu kliinisiin raportteihin tyhjästä. Vaihtoehtoisesti voisimme suoraan hienosäätää julkisesti saatavilla olevan yleiskäyttöisen kielimallin kliinisen tehtävän suorittamiseksi. Hienosäädetyn verkkotunnuksen agnostisen mallin käyttö saattaa olla tarpeen tilanteissa, joissa koulutus a kielimalli tyhjästä on liian kallista. Tässä ratkaisussa esittelemme jälkimmäistä lähestymistapaa, jossa käytetään FLAN -T5 XL -mallia, jonka hienosäädämme radiologiaraporttien yhteenvedon kliinistä tehtävää varten. Seuraava kaavio havainnollistaa mallin työnkulkua.

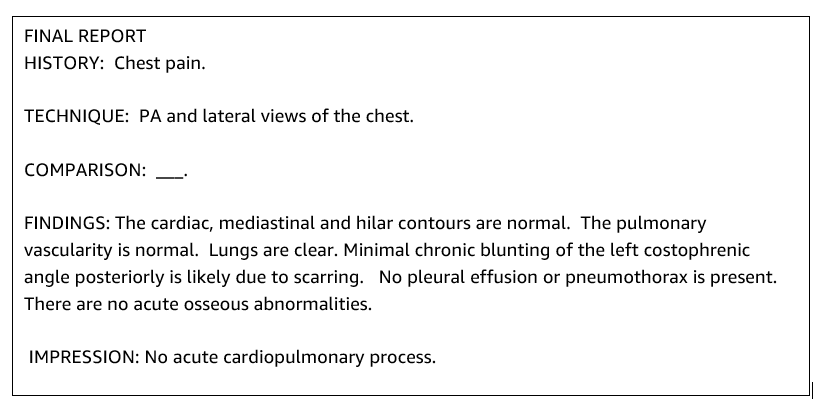

Tyypillinen radiologian raportti on hyvin organisoitu ja ytimekäs. Tällaisissa raporteissa on usein kolme keskeistä osaa:

- Tausta – Tarjoaa yleistä tietoa potilaan demografisista tiedoista sekä olennaiset tiedot potilaasta, kliinisestä historiasta ja asiaankuuluvasta sairaushistoriasta sekä tutkimusmenettelyjen yksityiskohdista

- Tulokset – Esittää yksityiskohtaisen tutkimusdiagnoosin ja -tulokset

- painaminen – Tiivistäen yhteenvedon tärkeimmistä löydöksistä tai löydösten tulkinnoista sekä arvioinnin merkityksestä ja mahdollisesta diagnoosista havaittujen poikkeavuuksien perusteella

Radologiaraporttien löydösosion avulla ratkaisu luo jäljennösosion, joka vastaa lääkäreiden yhteenvetoa. Seuraava kuva on esimerkki radiologian raportista.

Hienosäädä yleiskäyttöinen LLM kliinistä tehtävää varten

Tässä ratkaisussa hienosäädämme FLAN-T5 XL -mallia (viritetään kaikki mallin parametrit ja optimoidaan ne tehtävää varten). Hienosäädämme mallia kliinisen alueen tietojoukon avulla MIMIC-CXR, joka on julkisesti saatavilla oleva tietojoukko rintakehän röntgenkuvista. Tämän mallin hienosäätämiseksi SageMaker Jumpstartin avulla on toimitettava merkityt esimerkit {prompt, completion} -parien muodossa. Tässä tapauksessa käytämme MIMIC-CXR-tietojoukon alkuperäisten raporttien pareja {Findings, Impression}. Päätelmien tekemiseen käytämme seuraavassa esimerkissä esitettyä kehotetta:

![]()

Malli on hienosäädetty kiihdytetyllä tietojenkäsittelyllä ml .p3.16xlarge instanssi, jossa on 64 virtuaalista prosessoria ja 488 GiB muistia. Validointia varten 5 % tietojoukosta valittiin satunnaisesti. SageMaker-harjoitustyön aika hienosäädön kanssa oli 38,468 11 sekuntia (noin XNUMX tuntia).

Arvioi tulokset

Kun koulutus on valmis, on tärkeää arvioida tulokset. Luodun näyttökerran kvantitatiiviseen analyysiin käytämme RED (Recall-Oriented Understudy for Gisting Evaluation), yleisimmin käytetty mittari yhteenvedon arvioinnissa. Tämä mittari vertaa automaattisesti luotua yhteenvetoa viitteeseen tai viitejoukkoon (ihmisen tuottama) yhteenveto tai käännös. ROUGE1 viittaa päällekkäisyyteen unigrammit (jokainen sana) ehdokkaan (mallin tulos) ja referenssitiivistelmien välillä. ROUGE2 viittaa päällekkäisyyteen bigrammit (kaksi sanaa) ehdokkaan ja viitetiivistelmän välillä. ROUGEL on lausetason metriikka ja viittaa pisimpään yhteiseen osasekvenssiin (LCS) kahden tekstin välillä. Se jättää huomioimatta rivinvaihdot tekstissä. ROUGELsum on yhteenvetotason mittari. Tässä mittakaavassa tekstin rivinvaihtoja ei oteta huomioon, vaan ne tulkitaan lauserajoiksi. LCS lasketaan sitten kunkin viite- ja ehdokaslauseparin välillä, ja sitten lasketaan liitto-LCS. Näiden pisteiden yhteenlaskemiseksi tietyn viite- ja ehdokaslauseiden joukosta lasketaan keskiarvo.

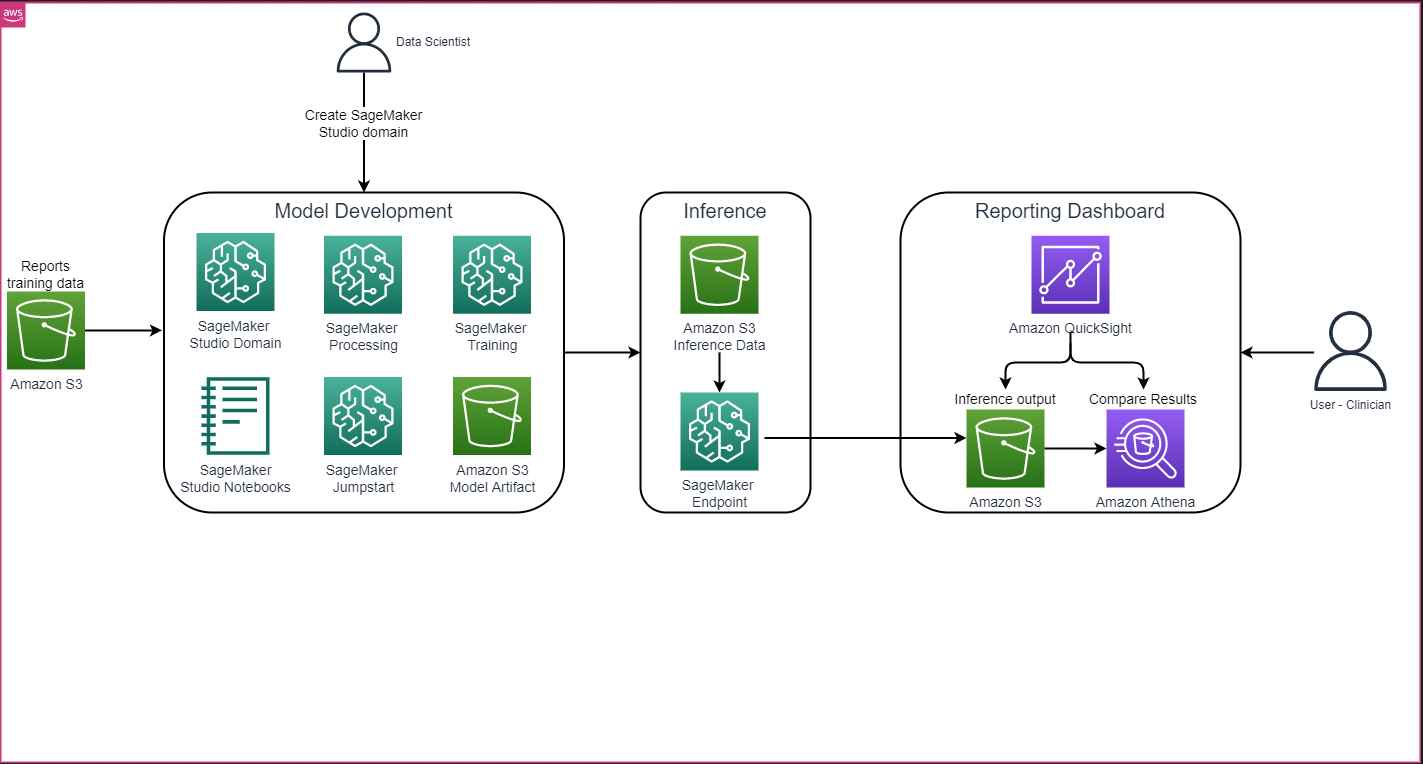

Läpikulku ja arkkitehtuuri

Seuraavassa kuvassa esitetty ratkaisun kokonaisarkkitehtuuri koostuu pääasiassa mallinkehitysympäristöstä, joka käyttää SageMaker Studiota, mallin käyttöönotosta SageMaker-päätepisteen kanssa ja raportointikojetaulusta, jossa on Amazon QuickSight.

Seuraavissa osissa esittelemme SageMaker JumpStartissa saatavilla olevan LLM:n hienosäätöä verkkotunnuskohtaisen tehtävän yhteenvedon tekemiseksi SageMaker Python SDK:n kautta. Keskustelemme erityisesti seuraavista aiheista:

- Toimenpiteet kehitysympäristön luomiseksi

- Yleiskatsaus radiologiaraporttitietosarjoista, joiden perusteella mallia hienosäädetään ja arvioidaan

- Esittely FLAN-T5 XL -mallin hienosäädöstä SageMaker JumpStart -ohjelmalla SageMaker Python SDK:n kanssa

- Esikoulutettujen ja hienosäädettyjen mallien päättäminen ja arviointi

- Esikoulutetun mallin ja hienosäädetyistä malleista saatujen tulosten vertailu

Ratkaisu on saatavilla osoitteessa Radiologiaraporttien näyttökertojen luominen generatiivisella tekoälyllä ja suurella kielimallilla AWS:ssä GitHub repo.

Edellytykset

Aloitaksesi tarvitset AWS-tili jossa voit käyttää SageMaker Studiota. Sinun on luotava käyttäjäprofiili SageMaker Studiolle, jos sinulla ei vielä ole sellaista.

Tässä viestissä käytetty koulutusinstanssityyppi on ml.p3.16xlarge. Huomaa, että p3-instanssityyppi vaatii palvelukiintiön korotuksen.

- MIMIC CXR -tietojoukko pääsee käsiksi tietojen käyttösopimuksen kautta, joka edellyttää käyttäjän rekisteröitymistä ja valtuutusprosessin suorittamista.

Luo kehitysympäristö

Voit määrittää kehitysympäristön luomalla S3-säihön, määrittämällä muistikirjan, luomalla päätepisteitä ja ottamalla käyttöön malleja sekä luomalla QuickSight-hallintapaneelin.

Luo S3-ämpäri

Luo S3-ämpäri nimeltään llm-radiology-bucket isännöidä koulutus- ja arviointitietoaineistoja. Tätä käytetään myös mallin artefaktin tallentamiseen mallin kehittämisen aikana.

Määritä muistikirja

Suorita seuraavat vaiheet:

- Käynnistä SageMaker Studio joko SageMaker-konsolista tai AWS-komentoriviliitäntä (AWS CLI).

Lisätietoja verkkotunnukseen liittymisestä on kohdassa Sisääntulo Amazon SageMaker -verkkotunnukseen.

- Luoda uusi SageMaker Studio muistikirja raporttitietojen puhdistamiseen ja mallin hienosäätöön. Käytämme ml.t3.medium 2vCPU+4GiB kannettavan ilmentymää Python 3 -ytimellä.

- Asenna muistikirjaan tarvittavat paketit, kuten

nest-asyncio,IPyWidgets(interaktiivisille widgeteille Jupyter-muistikirjalle) ja SageMaker Python SDK:lle:

Esikoulutetuista ja hienosäädetyistä malleista päättelemiseksi, luo päätepiste ja ota jokainen malli käyttöön muistikirjassa seuraavasti:

- Luo Model-luokasta malliobjekti, joka voidaan ottaa käyttöön HTTPS-päätepisteeseen.

- Luo HTTPS-päätepiste malliobjektin valmiiksi rakennetulla tavalla

deploy()menetelmä:

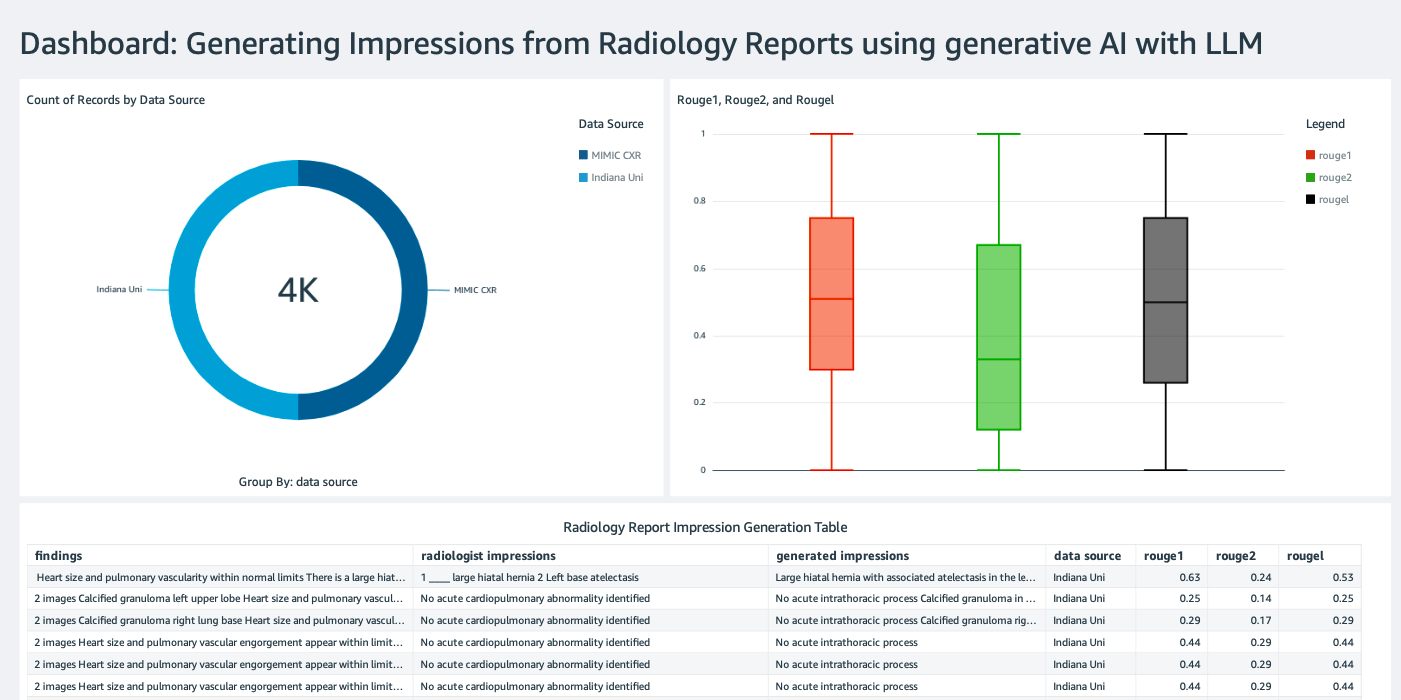

Luo QuickSight -hallintapaneeli

Luo QuickSight-kojelauta Athena-tietolähteellä päätelmien tuloksena Amazonin yksinkertainen tallennuspalvelu (Amazon S3) verrata johtopäätöstuloksia todelliseen totuuteen. Seuraava kuvakaappaus näyttää esimerkkikojelaudan.

Radiologiaraporttien tietojoukot

Malli on nyt hienosäädetty, kaikki mallin parametrit on viritetty 91,544 XNUMX raportissa, jotka on ladattu MIMIC-CXR v2.0 -tietojoukko. Koska käytimme vain radiologiaraportin tekstitietoja, latasimme vain yhden pakatun raporttitiedoston (mimic-cxr-reports.zip) MIMIC-CXR-verkkosivustolta. Nyt arvioimme hienosäädettyä mallia 2,000 XNUMX raportissa (kutsutaan nimellä dev1 tietojoukko) erillisestä piti tämän tietojoukon osajoukkoa. Käytämme vielä 2,000 XNUMX radiologiaraporttia (kutsutaan nimellä dev2) rintakehän röntgenkokoelmasta hienosäädetyn mallin arvioimiseksi Indianan yliopiston sairaalaverkosto. Kaikki tietojoukot luetaan JSON-tiedostoina ja ladataan äskettäin luotuun S3-alueeseen llm-radiology-bucket. Huomaa, että kaikki tietojoukot eivät oletuksena sisällä suojattuja terveystietoja (PHI). kaikki arkaluonteiset tiedot korvataan kolmella peräkkäisellä alaviivalla (___) tarjoajat.

Hienosäädä SageMaker Python SDK:lla

Hienosäätöä varten model_id on määritelty nimellä huggingface-text2text-flan-t5-xl SageMaker JumpStart -mallien luettelosta. The training_instance_type on asetettu muotoon ml.p3.16xlarge ja inference_instance_type ml.g5.2xlarge. Harjoitustiedot JSON-muodossa luetaan S3-ämpäristä. Seuraava vaihe on käyttää valittua mallitunnusta SageMaker JumpStart -resurssien URI:iden purkamiseen, mukaan lukien image_uri ( Amazonin elastisten säiliörekisteri (Amazon ECR) URI Docker-kuvalle), model_uri (esikoulutettu malliesimerkki Amazon S3 URI) ja script_uri (koulutuksen käsikirjoitus):

Myös tulostussijainti on asetettu kansioksi S3-ämpäriin.

Vain yksi hyperparametri, epochs, muutetaan arvoon 3, ja loput kaikki asetetaan oletusarvoiksi:

Harjoittelumittarit mm eval_loss (vahvistuksen menettämisestä), loss (harjoittelun menetyksestä) ja epoch seurattavat määritellään ja luetellaan:

Käytämme SageMaker JumpStart -resurssien URI-tunnisteita (image_uri, model_uri, script_uri) tunnistettu aiemmin luomaan estimaattori ja hienosäätämään sitä harjoitustietojoukossa määrittämällä tietojoukon S3-polun. Estimator-luokka edellyttää entry_point parametri. Tässä tapauksessa JumpStart käyttää transfer_learning.py. Harjoitustyö epäonnistuu, jos tätä arvoa ei ole asetettu.

Tämä koulutustyö voi kestää tunteja; siksi on suositeltavaa asettaa odotusparametriksi False ja seurata harjoitustyön tilaa SageMaker-konsolissa. Käytä TrainingJobAnalytics toiminto pitää kirjaa harjoitusmittauksista eri aikaleimoilla:

Ota käyttöön päätelmäpäätepisteet

Vertailujen tekemiseksi käytämme päättelypäätepisteitä sekä esiopetetuille että hienosäädetyille malleille.

Hae ensin päätelmä Docker-kuvan URI käyttämällä model_idja luo tämän URI:n avulla esiopetetusta mallista SageMaker-mallin ilmentymä. Ota esikoulutettu malli käyttöön luomalla HTTPS-päätepiste malliobjektin valmiiksi rakennetulla tavalla deploy() menetelmä. Jotta voit suorittaa päätelmiä SageMaker API:n kautta, muista läpäistä Predictor-luokka.

Toista edellinen vaihe luodaksesi SageMaker-mallin ilmentymä hienosäädetystä mallista ja luo päätepiste mallin käyttöönottoa varten.

Arvioi mallit

Aseta ensin tiivistetyn tekstin pituus, mallin tulosteiden lukumäärä (on oltava suurempi kuin 1, jos useita yhteenvetoja on luotava) ja säteiden lukumäärä säteen haku.

Muodosta päättelypyyntö JSON-hyötykuormana ja käytä sitä esiopetettujen ja hienosäädettyjen mallien päätepisteiden kyselyyn.

Laske aggregoitu ROUGE-pisteet (ROUGE1, ROUGE2, ROUGEL, ROUGELsum) kuten aiemmin on kuvattu.

Vertaa tuloksia

Seuraavassa taulukossa on esitetty arvioinnin tulokset dev1 ja dev2 tietojoukot. Arvioinnin tulos päällä dev1 (2,000 38 löydöstä MIMIC CXR -radiologiaraportista) osoittaa noin XNUMX prosenttiyksikön parannusta aggregoidussa keskiarvossa ROUGE1 ja ROUGE2 pisteet verrattuna esikoulutettuun malliin. Dev2:n ROUGE31- ja ROUGE25-pisteissä havaitaan 1 prosenttiyksikön ja 2 prosenttiyksikön parannus. Kaiken kaikkiaan hienosäätö paransi 38.2 prosenttiyksikköä ja 31.3 prosenttiyksikköä ROUGELsum-pisteissä dev1 ja dev2 tietojoukot, vastaavasti.

|

Arviointi aineisto |

Valmiiksi koulutettu malli | Hienosäädetty malli | ||||||

| ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

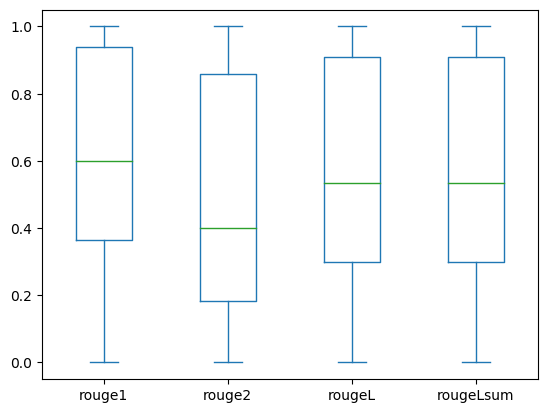

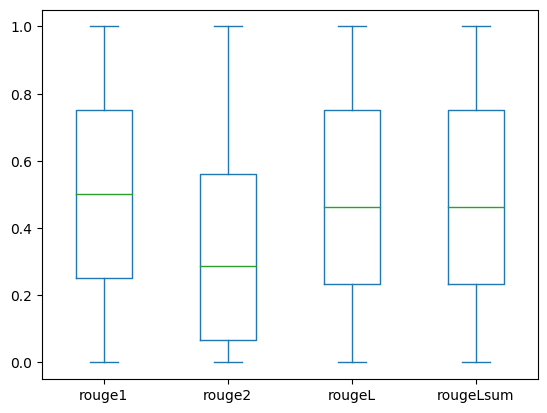

Seuraavat laatikkokaaviot kuvaavat ROUGE-pisteiden jakautumista dev1 ja dev2 hienosäädetyn mallin avulla arvioidut tietojoukot.

|

|

(: dev1 |

(b): dev2 |

Seuraava taulukko osoittaa, että arviointitietoaineistojen ROUGE-pisteillä on suunnilleen sama mediaani ja keskiarvo ja siksi ne jakautuvat symmetrisesti.

| aineistot | Partitur | Laskea | Mean | Vakiopoikkeama | vähimmäismäärä | 25 % prosenttipiste | 50 % prosenttipiste | 75 % prosenttipiste | Enimmäismäärä |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Puhdistaa

Vältä tulevia maksuja poistamalla resurssit, jotka loit seuraavalla koodilla:

Yhteenveto

Tässä viestissä osoitimme, kuinka hienosäätää FLAN-T5 XL -malli kliiniseen verkkoaluekohtaiseen yhteenvetotehtävään SageMaker Studion avulla. Varmuuden lisäämiseksi vertasimme ennusteita pohjatotuuteen ja arvioimme tulokset ROUGE-mittareilla. Osoitimme, että tiettyä tehtävää varten hienosäädetty malli tuottaa parempia tuloksia kuin malli, joka on esikoulutettu yleiseen NLP-tehtävään. Haluamme huomauttaa, että yleiskäyttöisen LLM:n hienosäätö eliminoi esikoulutuksen kustannukset kokonaan.

Vaikka tässä esitetty työ keskittyy rintakehän röntgenraportteihin, sitä voidaan laajentaa suurempiin tietokokonaisuuksiin, joissa on erilaisia anatomisia ja menetelmiä, kuten MRI ja CT, joiden radiologiaraportit voivat olla monimutkaisempia, ja niissä on useita löydöksiä. Tällaisissa tapauksissa radiologit voivat luoda vaikutelmia kriittisyyden järjestyksessä ja antaa seurantasuosituksia. Lisäksi palautesilmukan luominen tälle sovellukselle antaisi radiologille mahdollisuuden parantaa mallin suorituskykyä ajan myötä.

Kuten tässä viestissä osoitimme, hienosäädetty malli luo näyttökertoja radiologiaraportteihin, joilla on korkeat ROUGE-pisteet. Voit yrittää hienosäätää LLM:itä muissa toimialuekohtaisissa lääketieteellisissä raporteissa eri osastoilta.

Tietoja kirjoittajista

Tohtori Adewale Akinfaderin on AWS:n terveydenhuollon ja biotieteiden vanhempi tietotutkija. Hänen asiantuntemuksensa on toistettavissa ja kokonaisvaltaisissa AI/ML-menetelmissä, käytännön toteutuksissa sekä globaalien terveydenhuollon asiakkaiden auttaminen muotoilemaan ja kehittämään skaalautuvia ratkaisuja tieteidenvälisiin ongelmiin. Hänellä on kaksi korkeakoulututkintoa fysiikasta ja tohtorin tutkinto tekniikasta.

Tohtori Adewale Akinfaderin on AWS:n terveydenhuollon ja biotieteiden vanhempi tietotutkija. Hänen asiantuntemuksensa on toistettavissa ja kokonaisvaltaisissa AI/ML-menetelmissä, käytännön toteutuksissa sekä globaalien terveydenhuollon asiakkaiden auttaminen muotoilemaan ja kehittämään skaalautuvia ratkaisuja tieteidenvälisiin ongelmiin. Hänellä on kaksi korkeakoulututkintoa fysiikasta ja tohtorin tutkinto tekniikasta.

Priya Padate on Senior Partner Solutions -arkkitehti, jolla on laaja asiantuntemus AWS:n terveydenhuollon ja biotieteiden alalta. Priya ajaa markkinoille pääsyn strategioita kumppaneiden kanssa ja ajaa ratkaisukehitystä nopeuttaakseen tekoäly-/ML-pohjaista kehitystä. Hän on intohimoinen teknologian käyttämisestä terveydenhuoltoalan muuttamiseen paremman potilaiden hoitotuloksen saavuttamiseksi.

Priya Padate on Senior Partner Solutions -arkkitehti, jolla on laaja asiantuntemus AWS:n terveydenhuollon ja biotieteiden alalta. Priya ajaa markkinoille pääsyn strategioita kumppaneiden kanssa ja ajaa ratkaisukehitystä nopeuttaakseen tekoäly-/ML-pohjaista kehitystä. Hän on intohimoinen teknologian käyttämisestä terveydenhuoltoalan muuttamiseen paremman potilaiden hoitotuloksen saavuttamiseksi.

Ekta Walia Bhullar, PhD, on vanhempi AI/ML-konsultti AWS Healthcare and Life Sciences (HCLS) -asiantuntijapalveluiden liiketoimintayksikössä. Hänellä on laaja kokemus AI/ML:n soveltamisesta terveydenhuollon alalla, erityisesti radiologiassa. Työn ulkopuolella, kun hän ei keskustele tekoälystä radiologiassa, hän tykkää juosta ja vaeltaa.

Ekta Walia Bhullar, PhD, on vanhempi AI/ML-konsultti AWS Healthcare and Life Sciences (HCLS) -asiantuntijapalveluiden liiketoimintayksikössä. Hänellä on laaja kokemus AI/ML:n soveltamisesta terveydenhuollon alalla, erityisesti radiologiassa. Työn ulkopuolella, kun hän ei keskustele tekoälystä radiologiassa, hän tykkää juosta ja vaeltaa.

- SEO-pohjainen sisällön ja PR-jakelu. Vahvista jo tänään.

- PlatoData.Network Vertical Generatiivinen Ai. Vahvista itseäsi. Pääsy tästä.

- PlatoAiStream. Web3 Intelligence. Tietoa laajennettu. Pääsy tästä.

- PlatoESG. Autot / sähköautot, hiili, CleanTech, energia, ympäristö, Aurinko, Jätehuolto. Pääsy tästä.

- PlatonHealth. Biotekniikan ja kliinisten kokeiden älykkyys. Pääsy tästä.

- ChartPrime. Nosta kaupankäyntipeliäsi ChartPrimen avulla. Pääsy tästä.

- BlockOffsets. Ympäristövastuun omistuksen nykyaikaistaminen. Pääsy tästä.

- Lähde: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :on

- :On

- :ei

- :missä

- $ YLÖS

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- pystyy

- Meistä

- kiihdyttää

- kiihtyi

- Accessed

- suorittaa

- kerätä

- Lisäksi

- edistysaskeleet

- vastaan

- aggregaatti

- sopimus

- AI

- AI / ML

- algoritmit

- Kaikki

- mahdollistaa

- jo

- Myös

- yhteensä

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- määrät

- an

- analyysi

- ja

- Toinen

- Kaikki

- api

- Hakemus

- lähestymistapa

- suunnilleen

- arkkitehtuuri

- OVAT

- perustelu

- AS

- arviointi

- At

- automaattisesti

- automaattisesti

- automatisointi

- saatavissa

- keskimäärin

- välttää

- AWS

- pohja

- perustua

- BE

- koska

- ennen

- ovat

- Hyödyt

- Paremmin

- välillä

- suurempi

- miljardeja

- sekä

- rajat

- Laatikko

- taakka

- liiketoiminta

- mutta

- by

- nimeltään

- CAN

- ehdokkaat

- kyvyt

- hiili

- joka

- tapaus

- tapauksissa

- muuttunut

- maksut

- valita

- luokka

- Siivous

- selkeä

- Kliininen

- kliinikot

- koodi

- kokoelma

- Yhteinen

- yleisesti

- verrata

- verrattuna

- täydellinen

- valmistuminen

- monimutkainen

- osat

- kattava

- laskeminen

- tietojenkäsittely

- suppea

- luottamus

- peräkkäinen

- muodostuu

- Console

- konsultti

- sisältää

- Kontti

- pitoisuus

- sisältö

- kontrasti

- keskustelut

- vastaa

- Hinta

- kallis

- kustannukset

- voisi

- Pari

- luoda

- luotu

- Luominen

- kriittinen

- kriittisyys

- asiakassuhde

- Asiakkaat

- kojelauta

- tiedot

- tietojen tutkija

- aineistot

- Päätöksenteko

- oletusarvo

- määritelty

- Aste

- Väestötiedot

- osoittaa

- osoittivat

- osoittaa

- osastot

- sijoittaa

- käyttöön

- käyttöönotto

- kuvata

- on kuvattu

- yksityiskohtainen

- yksityiskohdat

- kehittää

- Kehitys

- eri

- suoraan

- pohtia

- keskustella

- jaettu

- jakelu

- Satamatyöläinen

- lääkärit

- asiakirjat

- verkkotunnuksen

- verkkotunnuksia

- Dont

- piirtää

- ajaa

- asemat

- aikana

- kukin

- Aikaisemmin

- vaivaa

- myöskään

- eliminoi

- muu

- mahdollistaa

- mahdollistaa

- päittäin

- päätepiste

- Tekniikka

- tehostettu

- tarpeeksi

- Koko

- ympäristö

- aikakausi

- aikakausia

- virhe

- erityisesti

- olennainen

- arvioida

- arvioitu

- arviointiin

- arviointi

- tentti

- esimerkki

- Esimerkit

- suorittaa

- laajeni

- experience

- asiantuntemus

- laaja

- Kattava kokemus

- uute

- epäonnistuu

- väärä

- palaute

- Kuva

- filee

- Asiakirjat

- tulokset

- Keskittää

- keskittyy

- jälkeen

- seuraa

- varten

- muoto

- muoto

- perusta

- alkaen

- toiminto

- edelleen

- Lisäksi

- tulevaisuutta

- general

- yleinen tarkoitus

- tuottaa

- syntyy

- synnyttää

- sukupolvi

- generatiivinen

- Generatiivinen AI

- saada

- tietty

- Global

- Go-to-Market

- valmistua

- suurempi

- Maa

- Olla

- ottaa

- he

- terveys

- terveystiedot

- terveydenhuollon

- terveydenhuollon alalla

- auttaa

- auttaa

- auttaa

- tätä

- Korkea

- korostus

- Vaellus

- hänen

- historia

- isäntä

- TUNTIA

- Miten

- Miten

- HTML

- http

- HTTPS

- Napa

- HalaaKasvot

- ihmisen

- ID

- ideoita

- tunnistettu

- if

- havainnollistaa

- kuva

- kuvien

- Imaging

- vaikuttavia

- toteuttaa

- toteutukset

- tuoda

- tärkeä

- parantaa

- parannus

- in

- sisältää

- Mukaan lukien

- Kasvaa

- teollisuus

- tiedot

- informatiivinen

- panos

- asentaa

- esimerkki

- vuorovaikutteinen

- tulkinta

- tulee

- keksintö

- IT

- Job

- Työpaikat

- json

- vain

- vain yksi

- Pitää

- avain

- Merkki

- Kieli

- suuri

- käynnistää

- oppiminen

- Led

- Pituus

- elämä

- Life Sciences

- pitää

- tykkää

- RAJOITA

- linja

- Lista

- lueteltu

- OTK

- sijaitsevat

- sijainti

- pois

- kone

- koneoppiminen

- tehdä

- Saattaa..

- tarkoittaa

- lääketieteellinen

- keskikokoinen

- Muisti

- menetelmä

- menetelmät

- metrinen

- Metrics

- ehkä

- minuuttia

- ML

- malli

- mallit

- monitori

- lisää

- eniten

- MK

- paljon

- moninkertainen

- Musiikki

- täytyy

- nimi

- Luonnollinen

- Luonnollinen kielen käsittely

- välttämätön

- Tarve

- verkko

- neuroverkkomallien

- Uusi

- hiljattain

- seuraava

- NLP

- muistikirja

- nyt

- numero

- objekti

- saatu

- of

- tarjoamalla

- usein

- on

- perehdytyksessä

- ONE

- vain

- optimoimalla

- or

- tilata

- alkuperäinen

- Muut

- meidän

- ulos

- tuloksiin

- ulostulo

- ulkopuolella

- yli

- yleinen

- ohittaa

- yleiskatsaus

- paketit

- pari

- paria

- parametri

- parametrit

- osa

- erityinen

- kumppani

- kumppani

- kulkea

- intohimoinen

- polku

- potilas

- potilaat

- osuus

- Suorittaa

- suorituskyky

- phd

- Fysiikka

- kappaletta

- Platon

- Platonin tietotieto

- PlatonData

- Kohta

- pistettä

- Kirje

- mahdollinen

- powered

- Käytännön

- Ennusteet

- Predictor

- esitetty

- lahjat

- pääasiallisesti

- Ongelma

- ongelmia

- prosessi

- käsittely

- valmistettu

- ammatillinen

- Profiili

- ehdottaa

- ehdotettu

- suojattu

- mikäli

- tarjoajat

- tarjoaa

- julkisesti

- Python

- määrällinen

- Lue

- Lukeminen

- äskettäinen

- suosituksia

- suositeltu

- vähentää

- viittaukset

- tarkoitettuja

- viittaa

- regex

- Rekisteröinti

- liittyvä

- merkityksellinen

- huomattava

- korvataan

- raportti

- Raportointi

- Raportit

- pyyntö

- tarvitaan

- Vaatii

- resurssi

- Esittelymateriaalit

- vastaavasti

- REST

- johtua

- tulokset

- Tuotto

- Nousta

- ajaa

- juoksu

- sagemaker

- sama

- skaalautuva

- tieteet

- Tiedemies

- raapia

- sdk

- Haku

- sekuntia

- Osa

- osiot

- nähdä

- valittu

- vanhempi

- sensible

- tuomita

- erillinen

- palvelu

- Palvelut

- palvelevat

- setti

- asetus

- settings

- hän

- shouldnt

- osoittivat

- esitetty

- Näytä

- merkitys

- merkittävä

- Yksinkertainen

- yksinkertaisesti

- pieni

- So

- ratkaisu

- Ratkaisumme

- SOLVE

- jonkin verran

- jänneväli

- erikoistunut

- erityinen

- erityisesti

- määritelty

- Alkaa

- alkoi

- huippu-

- Tila

- Vaihe

- Askeleet

- Yhä

- Levytila

- verkkokaupasta

- tarinat

- strategiat

- Strategia

- studio

- niin

- YHTEENVETO

- varma

- taulukko

- ottaa

- vie

- Tehtävä

- tehtävät

- Elektroniikka

- kuin

- että

- -

- Niitä

- sitten

- Siellä.

- siten

- siksi

- Nämä

- tätä

- ne

- kolmella

- Kautta

- aika

- että

- liian

- Aiheet

- raita

- Juna

- koulutus

- siirtää

- Muuttaa

- muuntaja

- Kääntäminen

- Totuus

- yrittää

- kaksi

- tyyppi

- tyypillinen

- alaviivojen

- ymmärtäminen

- yhdistynyt

- yksikkö

- yliopisto

- ladattu

- käyttää

- käytetty

- käyttäjä

- käyttötarkoituksiin

- käyttämällä

- validointi

- arvo

- arvot

- eri

- valtava

- versio

- kautta

- Videoita

- Virtual

- odottaa

- oli

- we

- verkko

- verkkopalvelut

- Verkkosivu

- kun

- joka

- vaikka

- leveys

- tulee

- with

- sisällä

- ilman

- sana

- sanoja

- Referenssit

- työnkulku

- olisi

- kirjoittaminen

- x-ray

- vuotta

- Voit

- Sinun

- zephyrnet