L’intelligence artificielle (IA) est un domaine en évolution rapide qui a le potentiel d’améliorer et de transformer de nombreux aspects de la société. En 2023, le rythme d’adoption des technologies d’IA s’est encore accéléré avec le développement de puissants modèles de base (FM) et les progrès qui en résultent dans les capacités d’IA générative.

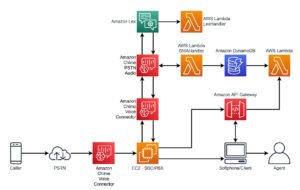

Chez Amazon, nous avons lancé plusieurs services d'IA générative, tels que Socle amazonien et les Chuchoteur de code Amazon, et ont mis à disposition une gamme de modèles génératifs très performants via Amazon SageMaker JumpStart. Ces services sont conçus pour aider nos clients à exploiter les capacités émergentes de l'IA générative, notamment une créativité améliorée, une création de contenu personnalisée et dynamique et une conception innovante. Ils peuvent également permettre aux praticiens de l’IA de donner un sens au monde comme jamais auparavant, en éliminant les barrières linguistiques, le changement climatique, en accélérant les découvertes scientifiques, et bien plus encore.

Toutefois, pour exploiter tout le potentiel de l’IA générative, il est important de réfléchir attentivement aux risques potentiels. Avant tout, cela profite aux parties prenantes du système d’IA en promouvant un développement et un déploiement responsables et sûrs, et en encourageant l’adoption de mesures proactives pour faire face aux impacts potentiels. Par conséquent, l’établissement de mécanismes pour évaluer et gérer les risques est un processus important que les praticiens de l’IA doivent considérer et est devenu un élément essentiel de nombreuses normes émergentes de l’industrie de l’IA (par exemple, ISO 42001, ISO 23894et une NIST RMF) et la législation (telle que Loi de l'UE sur l'IA).

Dans cet article, nous expliquons comment évaluer le risque potentiel de votre système d'IA.

Quels sont les différents niveaux de risque ?

Bien qu'il puisse être plus facile de commencer à examiner un modèle d'apprentissage automatique (ML) individuel et les risques associés de manière isolée, il est important de considérer les détails de l'application spécifique d'un tel modèle et le cas d'utilisation correspondant dans le cadre d'un système d'IA complet. . En fait, un système d’IA typique est susceptible d’être basé sur plusieurs modèles de ML différents fonctionnant ensemble, et une organisation peut chercher à créer plusieurs systèmes d’IA différents. Par conséquent, les risques peuvent être évalués pour chaque cas d’utilisation et à différents niveaux, à savoir le risque de modèle, le risque du système d’IA et le risque d’entreprise.

Le risque d'entreprise englobe le large éventail de risques auxquels une organisation peut être confrontée, notamment les risques financiers, opérationnels et stratégiques. Le risque du système d’IA se concentre sur l’impact associé à la mise en œuvre et à l’exploitation des systèmes d’IA, tandis que le risque du modèle de ML concerne spécifiquement les vulnérabilités et les incertitudes inhérentes aux modèles de ML.

Dans cet article, nous nous concentrons principalement sur les risques liés au système d’IA. Cependant, il est important de noter que tous les différents niveaux de gestion des risques au sein d'une organisation doivent être pris en compte et alignés.

Comment le risque du système d’IA est-il défini ?

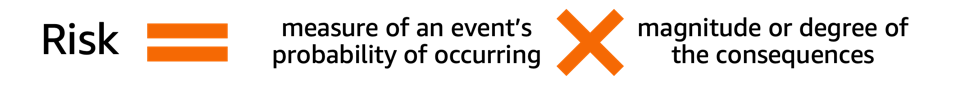

La gestion des risques dans le contexte d’un système d’IA peut être une voie permettant de minimiser l’effet de l’incertitude ou des impacts négatifs potentiels, tout en offrant également des opportunités de maximiser les impacts positifs. Le risque lui-même n’est pas un préjudice potentiel mais l’effet de l’incertitude sur les objectifs. Selon le Cadre de gestion des risques du NIST (NIST RMF), le risque peut être estimé comme une mesure multiplicative de la probabilité qu'un événement se produise, chronométrée par l'ampleur des conséquences de l'événement correspondant.

Le risque comporte deux aspects : le risque inhérent et le risque résiduel. Le risque inhérent représente le niveau de risque que le système d'IA présente en l'absence d'atténuation ou de contrôle. Le risque résiduel capture les risques restants après avoir pris en compte les stratégies d’atténuation.

Gardez toujours à l’esprit que l’évaluation des risques est une activité centrée sur l’humain qui nécessite des efforts à l’échelle de l’organisation ; ces efforts vont de l'assurance que toutes les parties prenantes concernées sont incluses dans le processus d'évaluation (telles que les équipes de produits, d'ingénierie, scientifiques, commerciales et de sécurité) à l'évaluation de la manière dont les perspectives et les normes sociales influencent la probabilité perçue et les conséquences de certains événements.

Pourquoi votre organisation devrait-elle se soucier de l’évaluation des risques ?

La mise en place de cadres de gestion des risques pour les systèmes d’IA peut bénéficier à la société dans son ensemble en promouvant la conception, le développement et l’exploitation sûrs et responsables des systèmes d’IA. Les cadres de gestion des risques peuvent également bénéficier aux organisations dans les domaines suivants :

- Prise de décision améliorée – En comprenant les risques associés aux systèmes d’IA, les organisations peuvent prendre de meilleures décisions sur la manière d’atténuer ces risques et d’utiliser les systèmes d’IA de manière sûre et responsable.

- Planification accrue de la conformité – Un cadre d'évaluation des risques peut aider les organisations à se préparer aux exigences d'évaluation des risques dans les lois et réglementations pertinentes.

- Construire de la confiance – En démontrant qu’elles prennent des mesures pour atténuer les risques des systèmes d’IA, les organisations peuvent montrer à leurs clients et parties prenantes qu’elles s’engagent à utiliser l’IA de manière sûre et responsable.

Comment évaluer le risque ?

Dans un premier temps, une organisation doit envisager de décrire le cas d’utilisation de l’IA qui doit être évalué et d’identifier toutes les parties prenantes concernées. Un cas d'utilisation est un scénario ou une situation spécifique qui décrit comment les utilisateurs interagissent avec un système d'IA pour atteindre un objectif particulier. Lors de la création d'une description de cas d'utilisation, il peut être utile de spécifier le problème commercial à résoudre, de répertorier les parties prenantes impliquées, de caractériser le flux de travail et de fournir des détails sur les principales entrées et sorties du système.

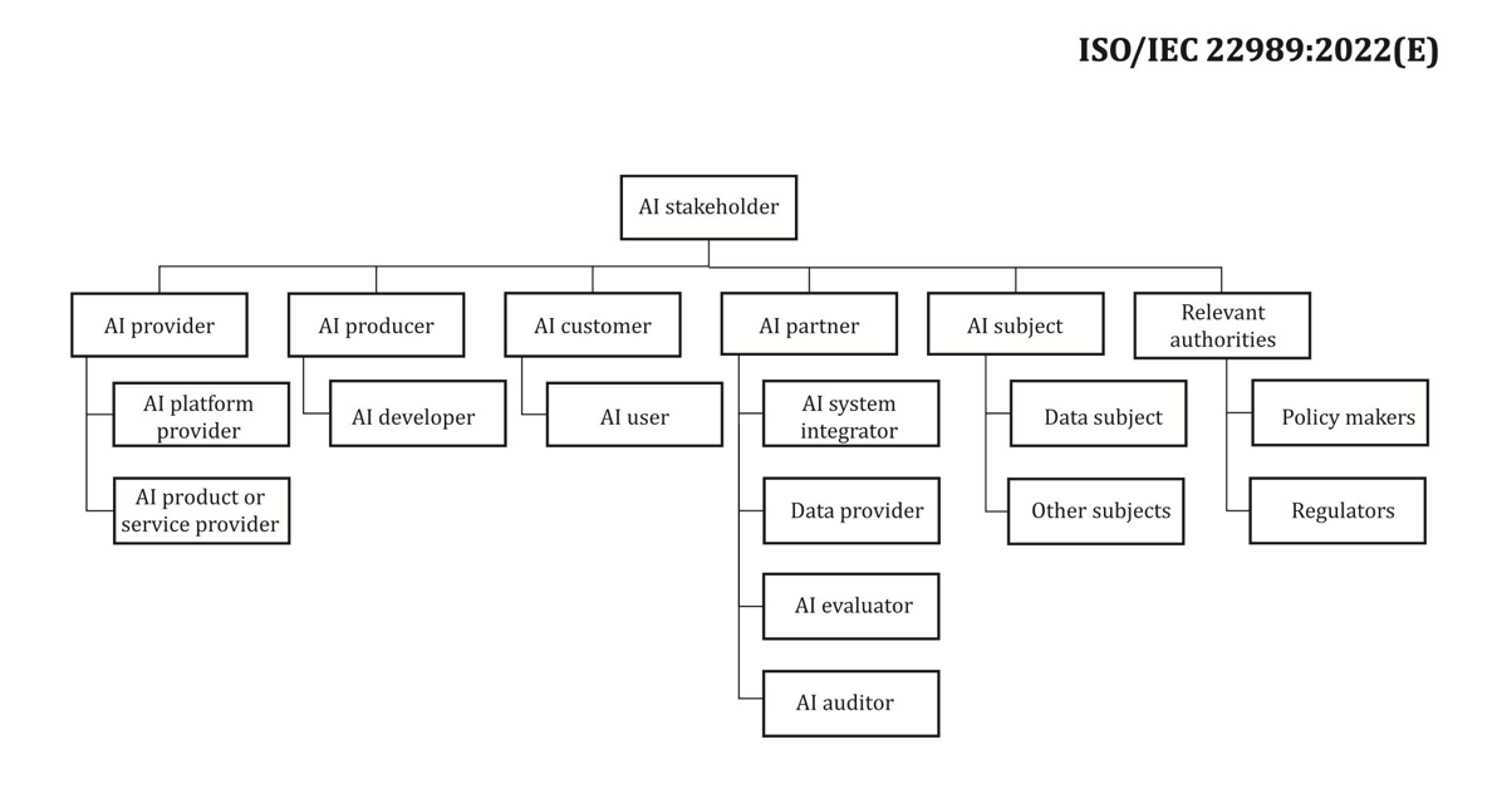

Lorsqu’il s’agit de parties prenantes, il est facile d’en négliger certaines. La figure suivante est un bon point de départ pour cartographier les rôles des parties prenantes de l’IA.

Source : « Technologies de l’information – Intelligence artificielle – Concepts et terminologie de l’intelligence artificielle ».

Une prochaine étape importante de l’évaluation des risques du système d’IA consiste à identifier les événements potentiellement nuisibles associés au cas d’utilisation. En considérant ces événements, il peut être utile de réfléchir à différentes dimensions de l’IA responsable, comme l’équité et la robustesse, par exemple. Différentes parties prenantes peuvent être affectées à différents degrés et selon différentes dimensions. Par exemple, un faible risque de robustesse pour un utilisateur final pourrait être le résultat d’un système d’IA présentant des perturbations mineures, tandis qu’un faible risque d’équité pourrait être dû à un système d’IA produisant des résultats négligeablement différents pour différents groupes démographiques.

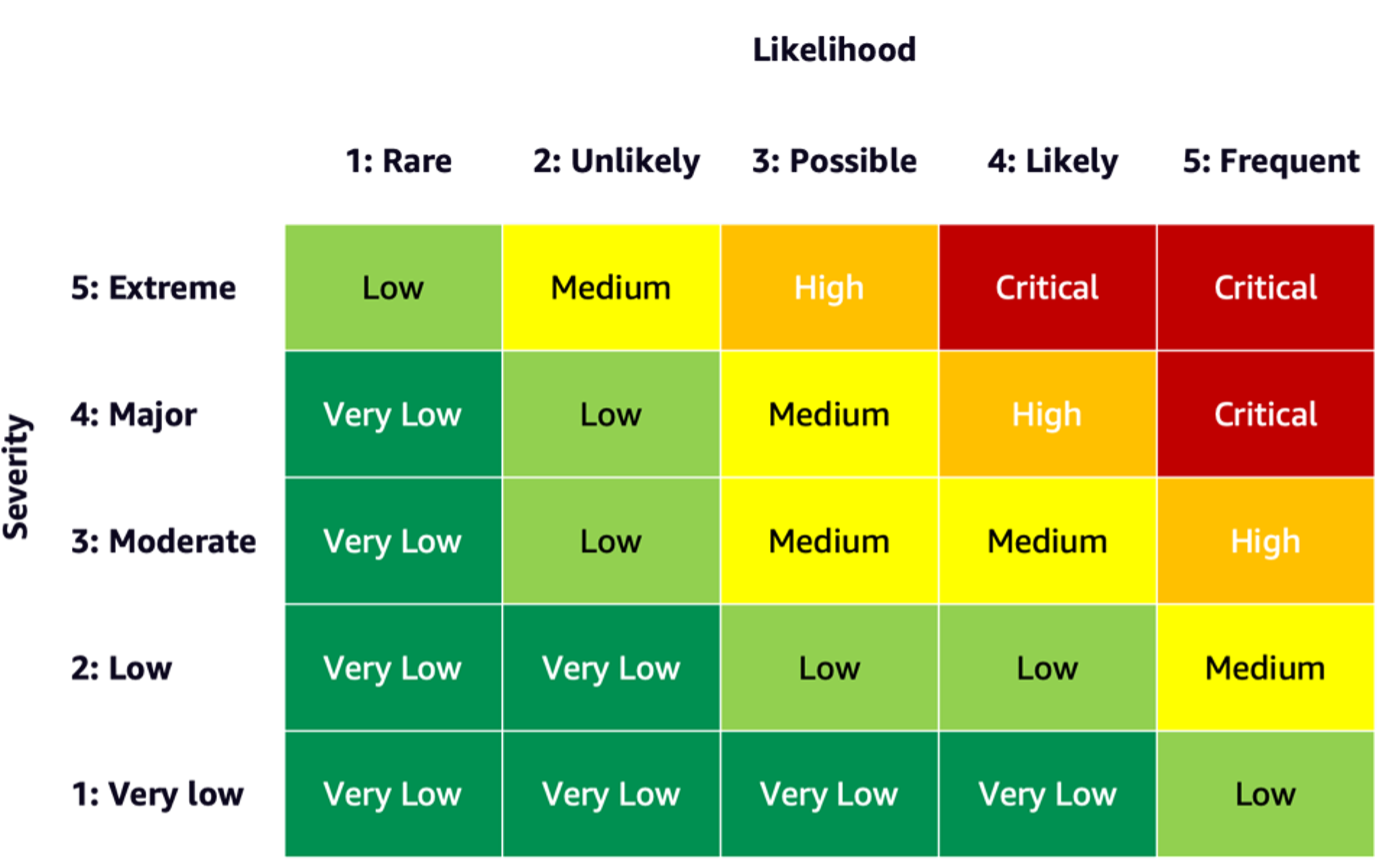

Pour estimer le risque d'un événement, vous pouvez utiliser une échelle de probabilité en combinaison avec une échelle de gravité pour mesurer la probabilité d'occurrence ainsi que le degré de conséquences. Un point de départ utile lors de l'élaboration de ces échelles pourrait être le NIST RMF, qui suggère d'utiliser des catégories qualitatives non numériques allant du risque très faible à très élevé ou des principes d'évaluation semi-quantitatifs, tels que des échelles (telles que 1 à 10), des catégories ou autres. chiffres représentatifs. Après avoir défini les échelles de probabilité et de gravité pour toutes les dimensions pertinentes, vous pouvez utiliser un schéma de matrice de risque pour quantifier le risque global par partie prenante pour chaque dimension pertinente. La figure suivante montre un exemple de matrice de risque.

À l’aide de cette matrice de risque, nous pouvons considérer un événement de faible gravité et avec une rare probabilité de survenance comme étant à très faible risque. Gardez à l’esprit que l’évaluation initiale sera une estimation du risque inhérent et que les stratégies d’atténuation des risques peuvent contribuer à réduire davantage les niveaux de risque. Le processus peut ensuite être répété pour générer une note pour tout risque résiduel restant par événement. Si plusieurs événements sont identifiés selon la même dimension, il peut être utile de choisir le niveau de risque le plus élevé parmi tous pour créer un résumé d’évaluation final.

À l’aide du résumé final de l’évaluation, les organisations devront définir les niveaux de risque acceptables pour leurs systèmes d’IA et prendre en compte les réglementations et politiques pertinentes.

Engagement AWS

Grâce à des engagements avec le maison Blanche et les UN, entre autres, nous nous engageons à partager nos connaissances et notre expertise pour faire progresser l’utilisation responsable et sécurisée de l’IA. Dans le même esprit, Adam Selipsky d'Amazon a récemment représenté AWS au Sommet sur la sécurité de l'IA en présence de chefs d'État et de dirigeants de l'industrie, démontrant une fois de plus notre engagement à collaborer au progrès responsable de l'intelligence artificielle.

Conclusion

À mesure que l’IA continue de progresser, l’évaluation des risques devient de plus en plus importante et utile pour les organisations qui cherchent à créer et déployer l’IA de manière responsable. En établissant un cadre d'évaluation des risques et un plan d'atténuation des risques, les organisations peuvent réduire le risque d'incidents potentiels liés à l'IA et gagner la confiance de leurs clients, ainsi que récolter des avantages tels qu'une fiabilité améliorée, une équité améliorée pour différentes données démographiques, et bien plus encore.

Allez-y et lancez-vous dans l’élaboration d’un cadre d’évaluation des risques dans votre organisation et partagez vos réflexions dans les commentaires.

Consultez également un aperçu des risques de l’IA générative publié sur Amazon Science : L’IA responsable à l’ère générative, et découvrez la gamme de services AWS qui peuvent vous aider dans votre parcours d'évaluation et d'atténuation des risques : Amazon SageMaker Clarifier, Moniteur de modèle Amazon SageMaker, AWS CloudTrail, ainsi quedes cadre de gouvernance modèle.

À propos des auteurs

Mia C.Mayer est scientifique appliqué et éducateur en ML à l'AWS Machine Learning University ; où elle recherche et enseigne la sécurité, l'explicabilité et l'équité des systèmes d'apprentissage automatique et d'IA. Tout au long de sa carrière, Mia a mis en place plusieurs programmes de sensibilisation universitaires, a agi en tant que conférencière invitée et conférencière principale, et a présenté de nombreuses grandes conférences d'apprentissage. Elle aide également les équipes internes et les clients AWS à se lancer dans leur parcours d'IA responsable.

Mia C.Mayer est scientifique appliqué et éducateur en ML à l'AWS Machine Learning University ; où elle recherche et enseigne la sécurité, l'explicabilité et l'équité des systèmes d'apprentissage automatique et d'IA. Tout au long de sa carrière, Mia a mis en place plusieurs programmes de sensibilisation universitaires, a agi en tant que conférencière invitée et conférencière principale, et a présenté de nombreuses grandes conférences d'apprentissage. Elle aide également les équipes internes et les clients AWS à se lancer dans leur parcours d'IA responsable.

Denis V. Batalov est un vétéran d'Amazon depuis 17 ans et un doctorat en apprentissage automatique, Denis a travaillé sur des projets passionnants tels que Search Inside the Book, les applications Amazon Mobile et Kindle Direct Publishing. Depuis 2013, il aide les clients AWS à adopter la technologie AI/ML en tant qu'architecte de solutions. Actuellement, Denis est un leader technologique mondial pour l'IA/ML responsable du fonctionnement des architectes de solutions spécialistes AWS ML à l'échelle mondiale. Denis est un conférencier assidu, vous pouvez le suivre sur Twitter @dbatalov.

Denis V. Batalov est un vétéran d'Amazon depuis 17 ans et un doctorat en apprentissage automatique, Denis a travaillé sur des projets passionnants tels que Search Inside the Book, les applications Amazon Mobile et Kindle Direct Publishing. Depuis 2013, il aide les clients AWS à adopter la technologie AI/ML en tant qu'architecte de solutions. Actuellement, Denis est un leader technologique mondial pour l'IA/ML responsable du fonctionnement des architectes de solutions spécialistes AWS ML à l'échelle mondiale. Denis est un conférencier assidu, vous pouvez le suivre sur Twitter @dbatalov.

Dr Sara Liu est responsable de programme technique senior au sein de l'équipe AWS Responsible AI. Elle travaille avec une équipe de scientifiques, de responsables d'ensembles de données, d'ingénieurs ML, de chercheurs, ainsi qu'avec d'autres équipes interfonctionnelles pour relever la barre de l'IA responsable dans les services d'IA AWS. Ses projets actuels consistent à développer des cartes de service d'IA, à réaliser des évaluations des risques pour une IA responsable, à créer des ensembles de données d'évaluation de haute qualité et à mettre en œuvre des programmes de qualité. Elle aide également les équipes internes et les clients à répondre aux normes changeantes de l’industrie de l’IA.

Dr Sara Liu est responsable de programme technique senior au sein de l'équipe AWS Responsible AI. Elle travaille avec une équipe de scientifiques, de responsables d'ensembles de données, d'ingénieurs ML, de chercheurs, ainsi qu'avec d'autres équipes interfonctionnelles pour relever la barre de l'IA responsable dans les services d'IA AWS. Ses projets actuels consistent à développer des cartes de service d'IA, à réaliser des évaluations des risques pour une IA responsable, à créer des ensembles de données d'évaluation de haute qualité et à mettre en œuvre des programmes de qualité. Elle aide également les équipes internes et les clients à répondre aux normes changeantes de l’industrie de l’IA.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- :possède

- :est

- :ne pas

- :où

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- A Propos

- accéléré

- accélérer

- acceptable

- Selon

- atteindre

- à travers

- activité

- Adam

- propos

- adopter

- Adoption

- avancer

- avancement

- affecté

- Après

- devant

- AI

- Risques liés à l'IA

- Services d'IA

- Systèmes d'IA

- AI / ML

- aligné

- Tous

- le long de

- aussi

- Amazon

- Amazon Web Services

- parmi

- montant

- an

- et les

- tous

- Application

- appliqué

- applications

- architectes

- SONT

- artificiel

- intelligence artificielle

- AS

- aspects

- Evaluer

- évalué

- Évaluation

- Évaluation de risque climatique

- évaluations

- associé

- At

- présence

- disponibles

- AWS

- Apprentissage automatique AWS

- barre

- obstacles

- basé

- BE

- devenez

- devenir

- va

- profiter

- avantages.

- Améliorée

- bacs

- livre

- vaste

- construire

- la performance des entreprises

- mais

- by

- CAN

- capacités

- capable

- captures

- Cartes

- les soins

- Carrière

- prudemment

- maisons

- catégories

- causé

- certaines

- Change

- caractériser

- vérifier

- Climat

- Changement climatique

- collaboration

- combinaison

- vient

- commentaires

- engagé

- complet

- conformité

- composant

- concepts

- conduite

- conférences

- Conséquences

- par conséquent

- Considérer

- considéré

- considérant

- contenu

- création de contenu

- contexte

- continue

- contrôles

- Core

- Correspondant

- pourriez

- engendrent

- La création

- création

- notre créativité

- équipes inter-fonctionnelles

- Courant

- Lecture

- Clients

- ensembles de données

- décisions

- dédicace

- Vous permet de définir

- défini

- Degré

- démographique

- Démographie

- démontrer

- déployer

- déploiement

- décrivant

- la description

- Conception

- un

- détails

- développement

- Développement

- différent

- Dimension

- dimensions

- discuter

- perturbations

- Dynamic

- chacun

- gagner

- plus facilement

- Easy

- effet

- efforts

- économies émergentes.

- permettre

- englobe

- encourageant

- engagements

- ENGINEERING

- Les ingénieurs

- améliorée

- assurer

- Entreprise

- établies

- établissement

- estimation

- estimé

- évalué

- évaluation

- événement

- événements

- évolution

- exemple

- passionnant

- Exposant

- expositions

- nous a permis de concevoir

- explorez

- Visage

- fait

- affacturage

- justice

- champ

- Figure

- finale

- la traduction de documents financiers

- Prénom

- Focus

- se concentre

- suivre

- Abonnement

- Pour

- avant toute chose

- Fondation

- Framework

- cadres

- fréquent

- De

- plein

- fonctionnement

- plus

- générer

- génératif

- IA générative

- obtenez

- À l'échelle mondiale

- objectif

- Bien

- gouvernance

- Groupes

- GUEST

- nuire

- nuisible

- Vous avez

- he

- têtes

- vous aider

- a aidé

- utile

- aide

- ici

- Haute

- de haute qualité

- le plus élevé

- très

- lui

- Comment

- How To

- Cependant

- HTML

- HTTPS

- identifié

- identifier

- if

- Impact

- Impacts

- la mise en oeuvre

- la mise en œuvre

- important

- améliorer

- amélioré

- in

- inclus

- Y compris

- de plus en plus

- individuel

- industrie

- normes de l'industrie

- influencer

- inhérent

- initiale

- technologie innovante

- entrées

- à l'intérieur

- Intelligence

- interagir

- interne

- impliquer

- impliqué

- ISO

- seul

- IT

- lui-même

- chemin

- jpg

- XNUMX éléments à

- ACTIVITES

- Tonique

- Conférencière inaugurale

- spécialisées

- langue

- gros

- lancé

- Lois

- leader

- dirigeants

- Conduit

- APPRENTISSAGE

- apprentissage

- Législation

- Niveau

- niveaux

- probabilité

- Probable

- lignes

- Liste

- recherchez-

- Faible

- baisser

- click

- machine learning

- LES PLANTES

- a prendre une

- gérer

- gestion

- manager

- de nombreuses

- Localisation

- Matrice

- Maximisez

- Mai..

- mesurer

- les mesures

- mécanismes

- Découvrez

- pourrait

- l'esprit

- mineur

- Réduire les

- atténuation

- ML

- Breeze Mobile

- application mobile

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- plusieurs

- à savoir

- Besoins

- négatif

- n'allons jamais

- next

- nist

- normes

- noter

- numéros

- nombreux

- objectifs

- événement

- se produire

- of

- on

- opération

- opérationnel

- Opportunités

- or

- organisation

- organisations

- Autre

- Autres

- autrement

- nos

- ande

- sorties

- sensibilisation

- global

- vue d'ensemble

- Rythme

- partie

- particulier

- chemin

- /

- perçu

- Personnalisé

- perspectives

- phd

- en particulier pendant la préparation

- plan

- Platon

- Intelligence des données Platon

- PlatonDonnées

- Point

- politiques

- positif

- Post

- défaillances

- l'éventualité

- solide

- Préparer

- présenté

- qui se déroulent

- principes

- Cybersécurité

- Problème

- processus

- produire

- Produit

- Programme

- Programmes

- projets

- la promotion de

- fournir

- aportando

- public

- publié

- Édition

- qualitatif

- qualité

- augmenter

- gamme

- allant

- rapidement

- RARE

- clients

- réaliser

- recueillir

- récemment

- réduire

- refléter

- en ce qui concerne

- règlements

- pertinent

- fiabilité

- restant

- répété

- représentant

- représenté

- représente

- Exigences

- a besoin

- chercheurs

- recherches

- responsables

- de manière responsable

- résultat

- résultant

- Analyse

- évaluation des risques

- la gestion des risques

- risques

- solidité

- rôle

- des

- Sécurité

- sagemaker

- vente

- même

- Escaliers intérieurs

- Balance

- scénario

- programme

- Sciences

- sur une base scientifique

- Scientifique

- scientifiques

- Rechercher

- sécurisé

- sécurité

- supérieur

- sens

- service

- Services

- plusieurs

- Partager

- partage

- elle

- devrait

- montrer

- Spectacles

- depuis

- situation

- Réseaux sociaux

- Société

- Solutions

- quelques

- Speaker

- spécialiste

- groupe de neurones

- spécifiquement

- Spectre

- intervenant

- parties prenantes

- Normes

- Commencer

- j'ai commencé

- Commencez

- Région

- étapes

- Étapes

- Stratégique

- les stratégies

- tel

- Suggère

- RÉSUMÉ

- Support

- combustion propre

- Système

- prise

- équipe

- équipes

- technologie

- Technique

- Les technologies

- Technologie

- qui

- La

- le monde

- leur

- puis

- Là.

- Ces

- l'ont

- this

- ceux

- Avec

- tout au long de

- Chronométré

- à

- ensemble

- Transformer

- La confiance

- deux

- débutante

- incertitudes

- Incertitude

- compréhension

- université

- déverrouillage

- utilisé

- cas d'utilisation

- utilisateurs

- en utilisant

- très

- vétéran

- vulnérabilités

- we

- web

- services Web

- WELL

- Quoi

- quand

- Les

- qui

- tout en

- sera

- comprenant

- dans les

- travaillé

- workflow

- de travail

- vos contrats

- world

- partout dans le monde

- Vous n'avez

- Votre

- zéphyrnet