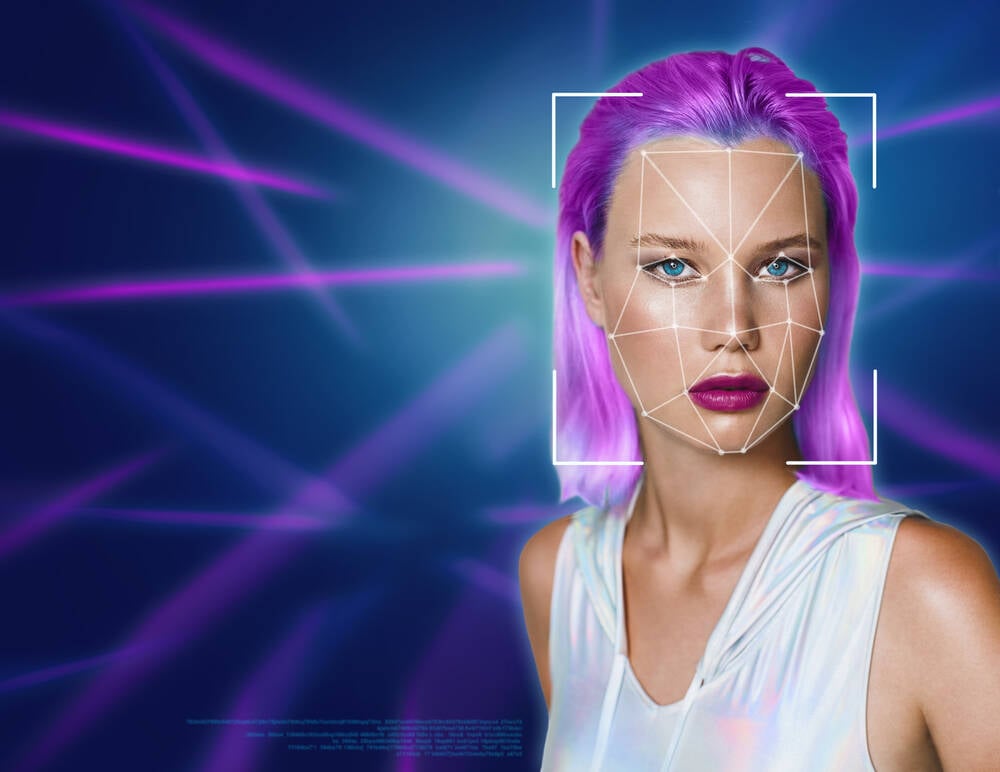

Microsoft a présenté cette semaine une démonstration de VASA-1, un framework permettant de créer des vidéos de personnes parlant à partir d'une image fixe, d'un échantillon audio et d'un script de texte, et affirme – à juste titre – qu'il est trop dangereux pour être rendu public.

Ces vidéos générées par l'IA, dans lesquelles les gens peuvent être animés de manière convaincante pour prononcer des mots scriptés avec une voix clonée, sont exactement le genre de chose que la Commission fédérale du commerce des États-Unis prévenu de le mois dernier, après précédemment proposer une règle pour empêcher que la technologie de l’IA soit utilisée à des fins de fraude par usurpation d’identité.

L'équipe de Microsoft le reconnaît dans son annonce, ce qui explique que la technologie n'est pas diffusée pour des raisons éthiques. Ils insistent sur le fait qu'ils présentent des recherches visant à générer des personnages virtuels interactifs et non à se faire passer pour qui que ce soit. En tant que tel, aucun produit ou API n’est prévu.

"Nos recherches se concentrent sur la génération de compétences visuelles et affectives pour les avatars virtuels de l'IA, en vue d'applications positives", déclarent les chercheurs de Redmond. « Il n’est pas destiné à créer du contenu utilisé pour induire en erreur ou tromper.

« Cependant, comme d’autres techniques de génération de contenu connexes, elles pourraient encore être utilisées à mauvais escient pour usurper l’identité d’êtres humains. Nous nous opposons à tout comportement visant à créer des contenus trompeurs ou préjudiciables de personnes réelles et souhaitons appliquer notre technique pour faire progresser la détection des contrefaçons.

Kevin Surace, président de Token, une entreprise d'authentification biométrique et conférencier fréquent sur l'IA générative, a déclaré Le registre dans un e-mail indiquant que, bien qu'il y ait eu des démonstrations technologiques antérieures de visages animés à partir d'une image fixe et d'un fichier vocal cloné, la démonstration de Microsoft reflète l'état de l'art.

"Les implications de la personnalisation des e-mails et autres communications de masse professionnelles sont fabuleuses", a-t-il déclaré. « Même en animant des images plus anciennes. Dans une certaine mesure, c'est simplement amusant et, d'un autre côté, il s'agit d'applications professionnelles solides que nous utiliserons tous dans les mois et les années à venir.

Le « plaisir » des deepfakes était constitué à 96 % de porno non consensuel, alors que évalué [PDF] en 2019 par la société de cybersécurité Deeptrace.

Néanmoins, les chercheurs de Microsoft suggèrent que le fait de pouvoir créer des personnes réalistes et de leur mettre des mots dans la bouche a des utilités positives.

"Une telle technologie promet d'enrichir la communication numérique, d'augmenter l'accessibilité pour les personnes ayant des troubles de la communication, de transformer l'éducation, les méthodes de tutorat interactif par l'IA et de fournir un soutien thérapeutique et une interaction sociale dans les soins de santé", proposent-ils dans un article. document de recherche qui ne contient pas les mots « porno » ou « désinformation ».

Bien que l'on puisse soutenir que la vidéo générée par l'IA n'est pas tout à fait la même chose qu'un deepfake, ce dernier défini par manipulation numérique plutôt que par méthode générative, la distinction devient sans importance lorsqu’un faux convaincant peut être créé sans greffe-copier-coller.

Lorsqu'on lui a demandé ce qu'il pensait du fait que Microsoft ne rendait pas cette technologie accessible au public par crainte d'une utilisation abusive, Surace a exprimé des doutes quant à la viabilité des restrictions.

"Microsoft et d'autres se sont retenus pour l'instant jusqu'à ce qu'ils résolvent les problèmes de confidentialité et d'utilisation", a-t-il déclaré. « Comment peut-on réglementer ceux qui utilisent cela pour les bonnes raisons ? »

Surace a ajouté qu'il existe déjà des modèles open source tout aussi sophistiqués, soulignant EMO. « On peut extraire le code source de GitHub et créer un service autour de celui-ci qui rivaliserait sans doute avec la production de Microsoft », a-t-il observé. "En raison de la nature open source de l'espace, il sera de toute façon impossible de le réglementer."

Cela dit, des pays du monde entier tentent de réglementer les personnes fabriquées à partir de l’IA. Canada, Chineainsi que, UK, entre autres pays, ont tous des réglementations qui peuvent être appliquées aux deepfakes, dont certaines répondent à des objectifs politiques plus larges. La Grande-Bretagne juste cette semaine rendu illégal pour créer une image deepfake sexuellement explicite sans consentement. Le partage de telles images était déjà interdit en vertu de la loi britannique sur la sécurité en ligne de 2023.

En janvier, un groupe bipartisan de législateurs américains introduit la loi Disrupt Explicit Forged Images and Non-Consensual Edits Act de 2024 (DEFIANCE Act), un projet de loi qui permet aux victimes d'images deepfakes non consensuelles de déposer une plainte civile devant le tribunal.

Et le mardi 16 avril, la commission sénatoriale américaine sur le pouvoir judiciaire, sous-commission sur la vie privée, la technologie et le droit, a tenu une audience intitulé « Surveillance de l’IA : élection Deepfakes ».

Dans un discours préparé, Rijul Gupta, PDG de DeepMedia, une entreprise de détection de deepfake, a déclaré :

[L]'aspect le plus alarmant des deepfakes est leur capacité à fournir aux mauvais acteurs un déni plausible, leur permettant de rejeter le contenu authentique comme étant faux. Cette érosion de la confiance du public frappe au cœur même de notre tissu social et des fondements de notre démocratie. Le cerveau humain, programmé pour croire ce qu’il voit et entend, est particulièrement vulnérable à la tromperie des deepfakes. À mesure que ces technologies deviennent de plus en plus sophistiquées, elles menacent de saper le sens commun de la réalité qui sous-tend notre société, créant un climat d’incertitude et de scepticisme dans lequel les citoyens remettent en question la véracité de chaque élément d’information qu’ils rencontrent.

Mais pensez aux applications marketing. ®

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://go.theregister.com/feed/www.theregister.com/2024/04/20/microsoft_deepfake_vasa/

- :possède

- :est

- :ne pas

- :où

- 16

- 2019

- 2023

- 2024

- 7

- a

- capacité

- Capable

- Qui sommes-nous

- accessibilité

- reconnaître

- Agis

- acteurs

- ajoutée

- de suivre

- Après

- AI

- Visée

- Tous

- Permettre

- déjà

- parmi

- an

- ainsi que les

- Une autre

- tous

- chacun.e

- api

- applications

- appliqué

- Application

- Avril

- SONT

- étant

- autour

- Art

- AS

- d'aspect

- At

- acoustique

- Authentification

- Avatars

- RETOUR

- Mal

- BE

- car

- devenez

- devient

- était

- humain

- va

- CROYONS

- Projet de loi

- Biométrique

- authentification biométrique

- biparti

- biz

- Cerveau

- la bretagne

- plus large

- construire

- la performance des entreprises

- applications commerciales

- by

- CAN

- maisons

- CEO

- Président

- caractères

- Citoyens

- civil

- réclamer

- prétentions

- Climat

- CO

- code

- Venir

- commission

- comité

- Communication

- consentement

- considérations

- contiennent

- contenu

- Génération de contenu

- contenu

- Core

- pourriez

- d'exportation

- Court Intérieur

- engendrent

- crée des

- La création

- Cybersécurité

- dangereux

- tromper

- tromperie

- deepfakes

- Defiance

- La démocratie

- manifestation

- Détection

- numérique

- Fermer

- Perturber

- distinction

- doute

- deux

- Éducation

- Élection

- emails

- rencontre

- enrichissant

- éthique

- Pourtant, la

- Chaque

- Explique

- exprimé

- ampleur

- .

- visages

- fait

- faux

- peur

- National

- Federal Trade Commission

- Déposez votre dernière attestation

- Ferme

- se concentre

- Pour

- forgé

- contrefaçon

- Fondations

- CADRE

- Framework

- fraude

- fréquent

- de

- FTC

- Remplir

- amusement

- généré

- générateur

- génération

- génératif

- IA générative

- véritable

- GitHub

- Objectifs

- Bien

- Réservation de groupe

- Gupta

- nuisible

- Vous avez

- he

- la médecine

- Tenue

- détient

- Comment

- Cependant

- HTML

- HTTPS

- humain

- Les êtres humains

- image

- satellite

- implications

- impossible

- in

- croissant

- de plus en plus

- d'information

- prévu

- l'interaction

- Interactif

- intéressé

- vous aider à faire face aux problèmes qui vous perturbent

- IT

- Janvier

- jpg

- juste

- Justice

- Nom de famille

- Droit applicable et juridiction compétente

- législateurs

- à gauche

- Législation

- comme

- recherchez-

- FAIT DU

- Manipulation

- Stratégie

- Masse

- méthode

- méthodes

- Microsoft

- Désinformation

- trompeur

- une mauvaise utilisation

- numériques jumeaux (digital twin models)

- Mois

- mois

- (en fait, presque toutes)

- beaucoup

- Nations

- Nature

- aucune

- maintenant

- of

- plus

- on

- ONE

- en ligne

- ouvert

- open source

- opposé

- or

- Autre

- Autres

- nos

- ande

- sortie

- Surveillance

- particulièrement

- Personnes

- pour cent

- personnes

- PHOTOS

- pièce

- prévu

- Platon

- Intelligence des données Platon

- PlatonDonnées

- plausible

- politique

- positif

- l'éventualité

- préparé

- en présentant

- empêcher

- précédemment

- Avant

- la confidentialité

- Produit

- PROMETTONS

- proposer

- fournir

- aportando

- public

- confiance publique

- mettre

- assez

- RE

- réal

- réaliste

- Réalité

- Les raisons

- reflète

- Réglementer

- régulateur

- règlements

- en relation

- libérer

- libéré

- libération

- un article

- chercheurs

- restrictions

- bon

- Rival

- s

- Sécurité

- Saïd

- même

- échantillon

- scénario

- voit

- Sénat

- sens

- service

- commun

- partage

- De même

- Scepticisme

- compétences

- Réseaux sociaux

- Société

- solide

- quelques

- sophistiqué

- Identifier

- code source

- Space

- parler

- Speaker

- Région

- Encore

- Grèves

- sous-comité

- tel

- suggérer

- Support

- parlant

- équipe

- technologie

- technique

- techniques

- Les technologies

- Technologie

- texte

- qui

- Les

- la loi

- La Source

- L'État

- au Royaume-Uni

- le monde

- leur

- Les

- Là.

- Ces

- l'ont

- chose

- penser

- this

- cette semaine

- ceux

- menacer

- titré

- à

- jeton

- dit

- trop

- commerce

- transformer

- La confiance

- essayer

- Mardi

- Tutorat

- Uk

- Incertitude

- sous

- Saper

- jusqu'à

- Dévoile

- us

- Fédéral américain

- commission fédérale américaine du commerce

- Législateurs américains

- Sénat américain

- Utilisation

- utilisé

- d'utiliser

- Usages

- très

- viabilité

- victimes

- Vidéo

- Vidéos

- Salle de conférence virtuelle

- visuel

- Voix

- Vulnérable

- était

- Façon..

- we

- semaine

- WELL

- Quoi

- quand

- qui

- tout en

- WHO

- sera

- comprenant

- sans

- des mots

- activités principales

- faire des exercices

- world

- pourra

- années

- zéphyrnet