Les entreprises cherchent à exploiter le potentiel du Machine Learning (ML) pour résoudre des problèmes complexes et améliorer les résultats. Jusqu'à récemment, la création et le déploiement de modèles ML nécessitaient des niveaux approfondis de compétences techniques et de codage, notamment le réglage des modèles ML et la maintenance des pipelines opérationnels. Depuis son introduction en 2021, Toile Amazon SageMaker a permis aux analystes commerciaux de créer, de déployer et d'utiliser une variété de modèles de ML, notamment les modèles tabulaires, de vision par ordinateur et de traitement du langage naturel, sans écrire une seule ligne de code. Cela a accéléré la capacité des entreprises à appliquer le ML à des cas d'utilisation tels que la prévision de séries chronologiques, la prévision du taux de désabonnement des clients, l'analyse des sentiments, la détection de défauts industriels et bien d'autres.

Comme annoncé le 5 octobre 2023, SageMaker Canvas a étendu sa prise en charge des modèles aux modèles de base (FM) – de grands modèles de langage utilisés pour générer et résumer le contenu. Avec le Sortie du 12 octobre 2023, SageMaker Canvas permet aux utilisateurs de poser des questions et d'obtenir des réponses fondées sur les données de leur entreprise. Cela garantit que les résultats sont spécifiques au contexte, ouvrant ainsi la voie à des cas d'utilisation supplémentaires dans lesquels le ML sans code peut être appliqué pour résoudre des problèmes commerciaux. Par exemple, les équipes commerciales peuvent désormais formuler des réponses cohérentes avec le vocabulaire et les principes spécifiques d’une organisation, et peuvent interroger plus rapidement des documents longs pour obtenir des réponses spécifiques et fondées sur le contenu de ces documents. Tout ce contenu est réalisé de manière privée et sécurisée, garantissant que toutes les données sensibles sont accessibles avec une gouvernance et des garanties appropriées.

Pour commencer, un administrateur cloud configure et remplit Amazone Kendra index avec des données d'entreprise comme sources de données pour SageMaker Canvas. Les utilisateurs de Canvas sélectionnent l'index où se trouvent leurs documents et peuvent imaginer, rechercher et explorer en sachant que le résultat sera toujours soutenu par leurs sources de vérité. SageMaker Canvas utilise des FM de pointe de Socle amazonien ainsi que les Amazon SageMaker JumpStart. Les conversations peuvent être lancées avec plusieurs FM côte à côte, en comparant les résultats et en rendant véritablement l'IA générative accessible à tous.

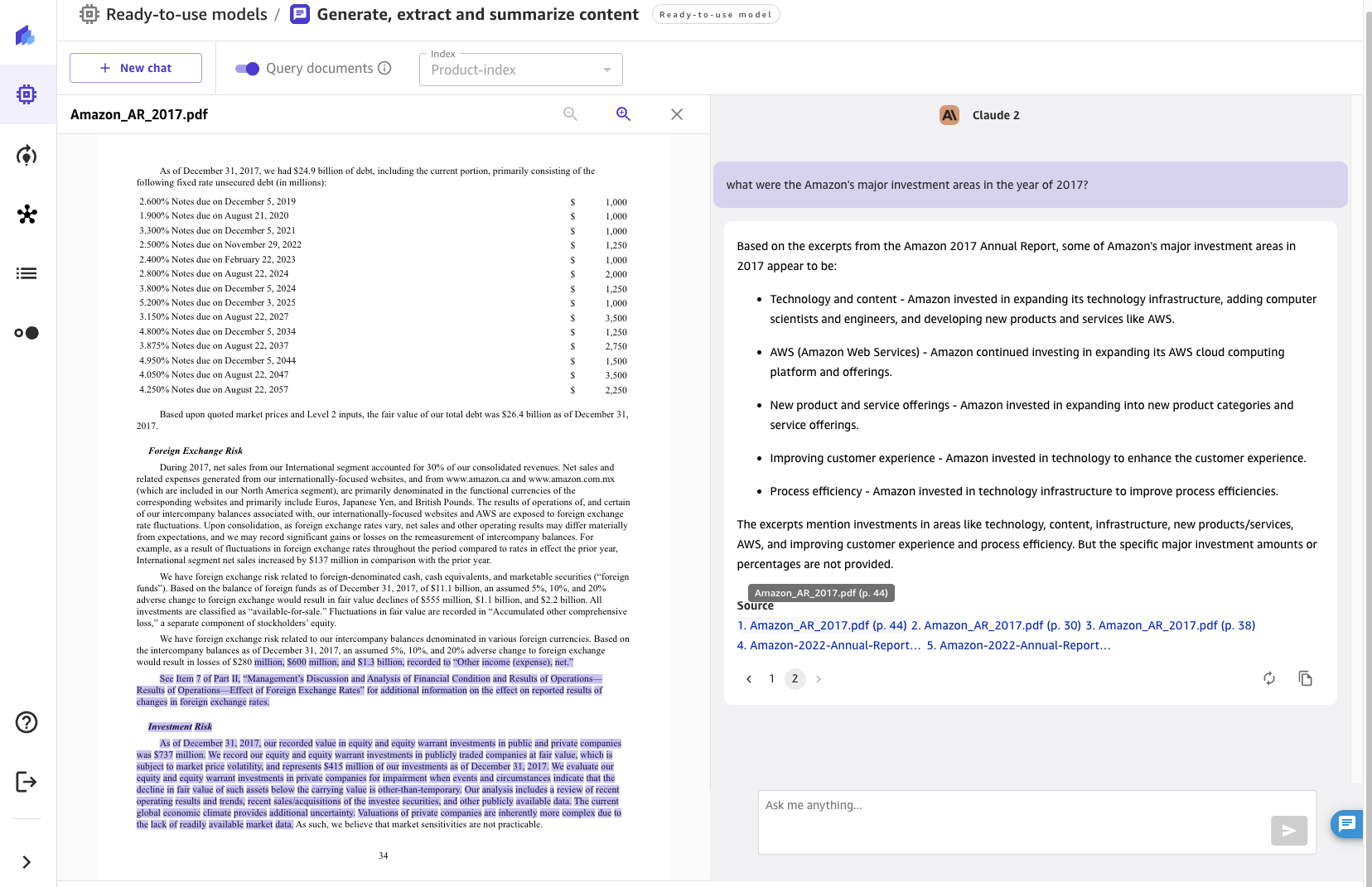

Dans cet article, nous passerons en revue la fonctionnalité récemment publiée, discuterons de l'architecture et présenterons un guide étape par étape pour permettre à SageMaker Canvas d'interroger des documents de votre base de connaissances, comme indiqué dans la capture d'écran suivante.

Vue d'ensemble de la solution

Les modèles de fondation peuvent produire des hallucinations – des réponses génériques, vagues, sans rapport ou factuellement incorrectes. Génération augmentée de récupération (RAG) est une approche fréquemment utilisée pour réduire les hallucinations. Les architectures RAG sont utilisées pour récupérer des données en dehors d'un FM, qui sont ensuite utilisées pour effectuer un apprentissage en contexte pour répondre à la requête de l'utilisateur. Cela garantit que le FM peut utiliser les données d’une base de connaissances fiable et utiliser ces connaissances pour répondre aux questions des utilisateurs, réduisant ainsi le risque d’hallucination.

Avec RAG, les données externes au FM et utilisées pour augmenter les invites des utilisateurs peuvent provenir de plusieurs sources de données disparates, telles que des référentiels de documents, des bases de données ou des API. La première étape consiste à convertir vos documents et toutes les requêtes des utilisateurs dans un format compatible pour effectuer une recherche sémantique par pertinence. Pour rendre les formats compatibles, une collection de documents ou une bibliothèque de connaissances et les requêtes soumises par les utilisateurs sont converties en représentations numériques à l'aide de modèles d'intégration.

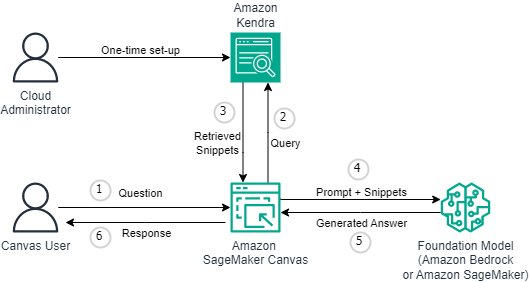

Avec cette version, la fonctionnalité RAG est fournie de manière transparente et sans code. Les entreprises peuvent enrichir l'expérience de chat dans Canvas avec Amazon Kendra comme système de gestion des connaissances sous-jacent. Le diagramme suivant illustre l’architecture de la solution.

La connexion de SageMaker Canvas à Amazon Kendra nécessite une configuration unique. Nous décrivons le processus de configuration en détail dans Configuration de Canvas pour interroger des documents. Si vous n'avez pas encore configuré votre domaine SageMaker, reportez-vous à Intégration au domaine Amazon SageMaker.

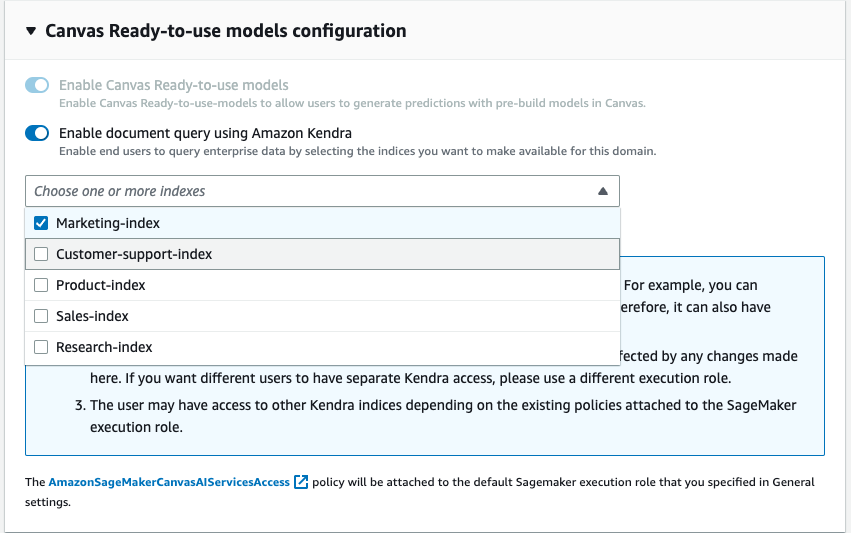

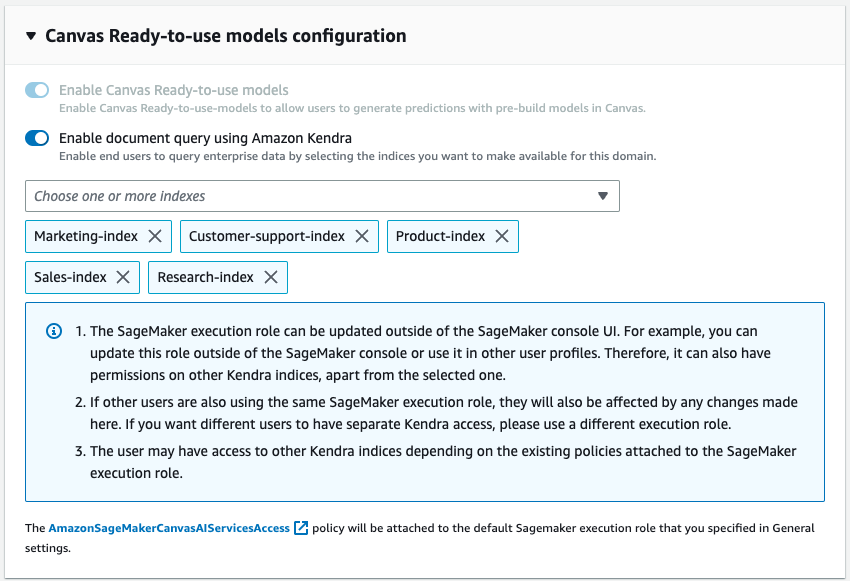

Dans le cadre de la configuration du domaine, un administrateur cloud peut choisir un ou plusieurs indices Kendra que l'analyste commercial peut interroger lors de l'interaction avec le FM via SageMaker Canvas.

Une fois les indices Kendra hydratés et configurés, les analystes commerciaux les utilisent avec SageMaker Canvas en démarrant une nouvelle discussion et en sélectionnant le bouton « Requête de documents ». SageMaker Canvas gérera ensuite la communication sous-jacente entre Amazon Kendra et le FM de votre choix pour effectuer les opérations suivantes :

- Interrogez les indices Kendra avec la question provenant de l'utilisateur.

- Récupérez les extraits (et les sources) des indices Kendra.

- Concevez l'invite avec les extraits de code avec la requête d'origine afin que le modèle de base puisse générer une réponse à partir des documents récupérés.

- Fournissez la réponse générée à l'utilisateur, ainsi que les références aux pages/documents qui ont été utilisés pour formuler la réponse.

Configuration de Canvas pour interroger des documents

Dans cette section, nous vous guiderons à travers les étapes de configuration de Canvas pour interroger les documents servis via les index Kendra. Vous devez avoir les prérequis suivants :

- Configuration du domaine SageMaker – Intégration au domaine Amazon SageMaker

- Créer un Indice Kendra (ou plusieurs)

- Configurez le connecteur Kendra Amazon S3 – suivez les Connecteur Amazon S3 – et téléchargez des fichiers PDF et d'autres documents dans le compartiment Amazon S3 associé à l'index Kendra

- Configurez IAM afin que Canvas dispose des autorisations appropriées, y compris celles requises pour appeler les points de terminaison Amazon Bedrock et/ou SageMaker – suivez les instructions Configurer le chat sur toile Documentation

Vous pouvez maintenant mettre à jour le domaine afin qu'il puisse accéder aux index souhaités. Sur la console SageMaker, pour le domaine donné, sélectionnez Modifier sous l'onglet Paramètres du domaine. Activez la bascule « Activer les documents de requête avec Amazon Kendra » qui se trouve à l'étape Paramètres du canevas. Une fois activé, choisissez un ou plusieurs indices Kendra que vous souhaitez utiliser avec Canvas.

C'est tout ce qui est nécessaire pour configurer la fonctionnalité de requête de documents Canvas. Les utilisateurs peuvent désormais participer à une discussion dans Canvas et commencer à utiliser les bases de connaissances qui ont été attachées au domaine via les index Kendra. Les responsables de la base de connaissances peuvent continuer à mettre à jour la source de vérité et grâce à la capacité de synchronisation de Kendra, les utilisateurs du chat pourront automatiquement utiliser les informations à jour de manière transparente.

Utilisation de la fonctionnalité Rechercher des documents pour le chat

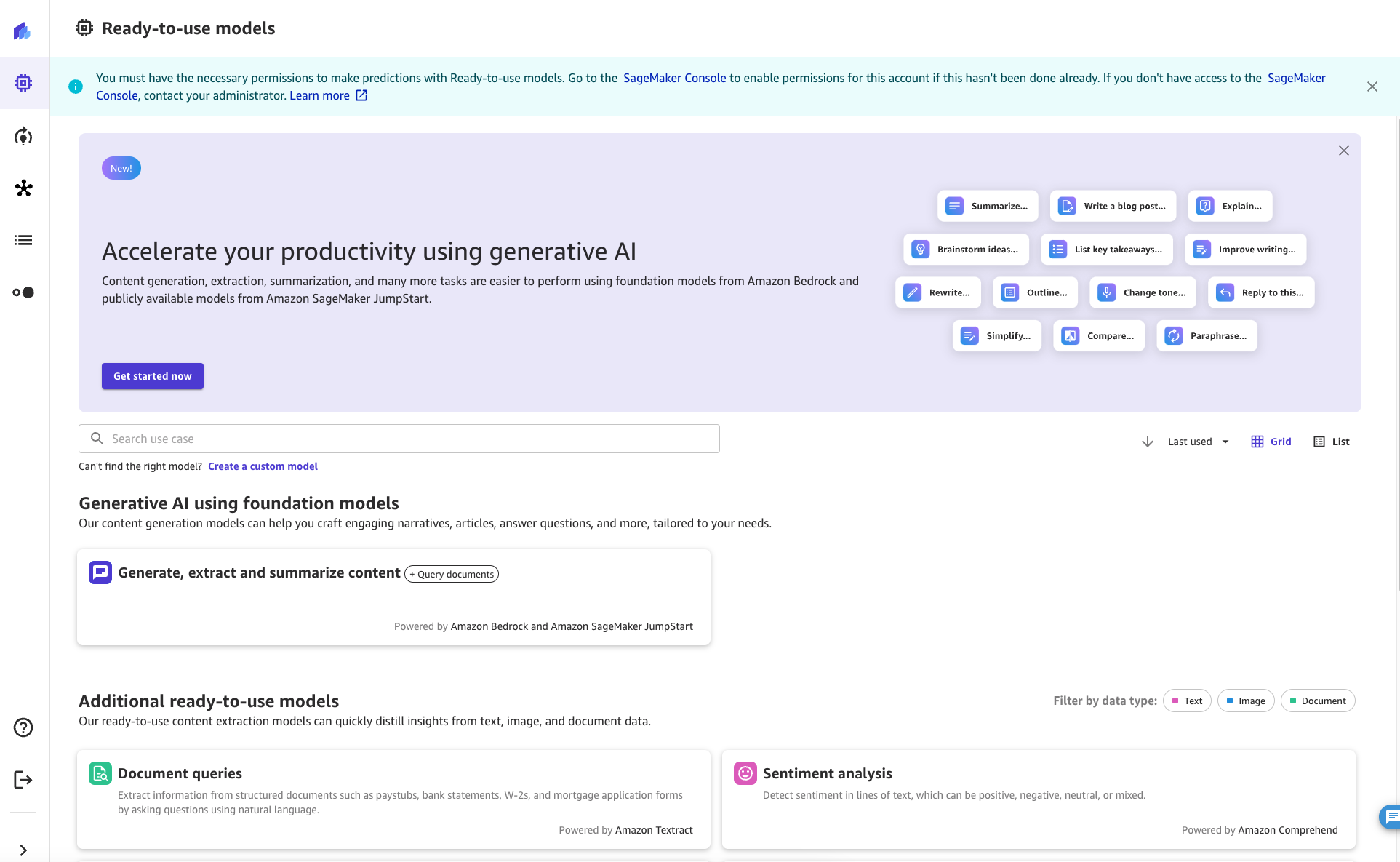

En tant qu'utilisateur de SageMaker Canvas, la fonctionnalité Rechercher des documents est accessible depuis une discussion. Pour démarrer la session de discussion, cliquez ou recherchez le bouton « Générer, extraire et résumer le contenu » dans l'onglet Modèles prêts à l'emploi de SageMaker Canvas.

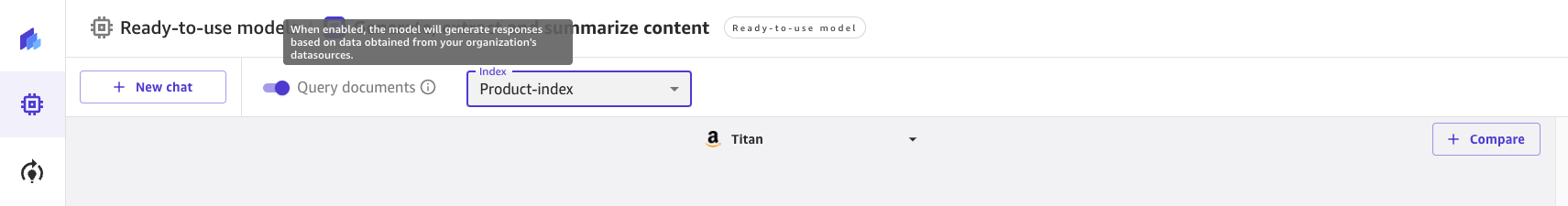

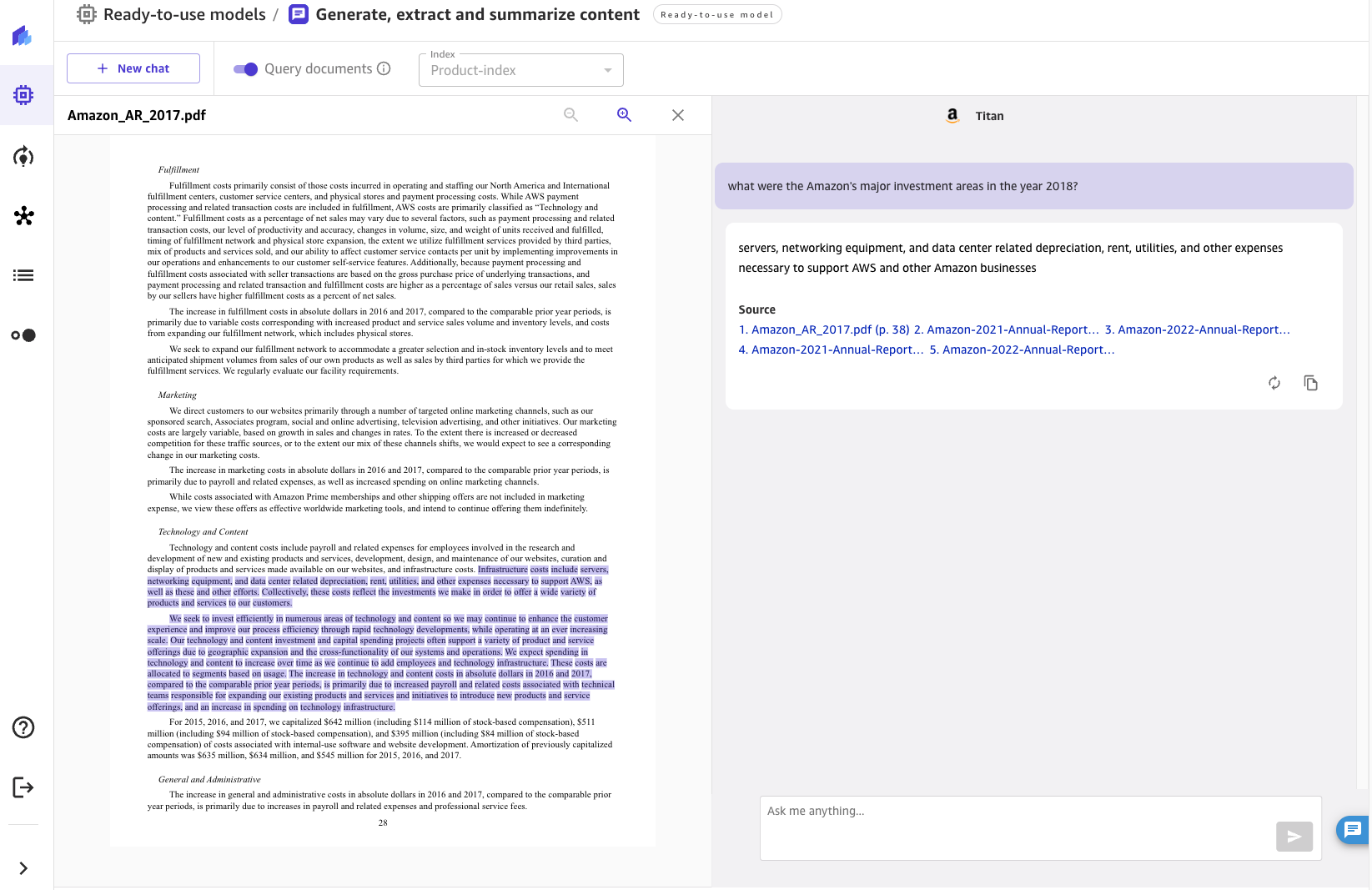

Une fois sur place, vous pouvez activer et désactiver la requête de documents avec la bascule en haut de l'écran. Consultez l’invite d’informations pour en savoir plus sur la fonctionnalité.

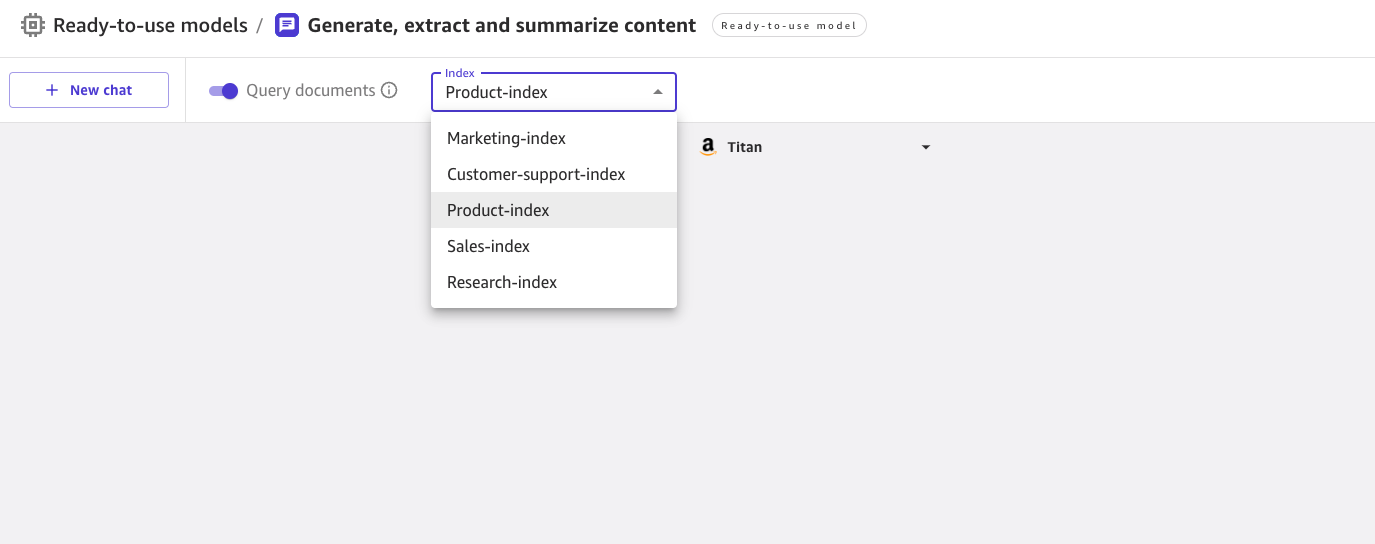

Lorsque la requête de documents est activée, vous pouvez choisir parmi une liste d'index Kendra activés par l'administrateur cloud.

Vous pouvez sélectionner un index lorsque vous démarrez une nouvelle discussion. Vous pouvez ensuite poser une question dans l'UX avec des connaissances provenant automatiquement de l'index sélectionné. Notez qu'après le démarrage d'une conversation sur un index spécifique, il n'est pas possible de passer à un autre index.

Pour les questions posées, le chat affichera la réponse générée par le FM ainsi que les documents sources qui ont contribué à générer la réponse. Lorsque vous cliquez sur l'un des documents sources, Canvas ouvre un aperçu du document, mettant en évidence l'extrait utilisé par le FM.

Conclusion

L'IA conversationnelle a un immense potentiel pour transformer l'expérience client et employé en fournissant un assistant de type humain avec des interactions naturelles et intuitives telles que :

- Effectuer une recherche sur un sujet ou rechercher et parcourir la base de connaissances de l’organisation

- Résumer des volumes de contenu pour recueillir rapidement des informations

- Recherche d'entités, de sentiments, d'informations personnelles et d'autres données utiles, et augmentation de la valeur commerciale du contenu non structuré

- Générer des brouillons de documents et de correspondance commerciale

- Création d'articles de connaissances à partir de sources internes disparates (incidents, journaux de discussion, wikis)

L'intégration innovante des interfaces de chat, de la récupération de connaissances et des FM permet aux entreprises de fournir des réponses précises et pertinentes aux questions des utilisateurs en utilisant leurs connaissances du domaine et leurs sources de vérité.

En connectant SageMaker Canvas aux bases de connaissances d'Amazon Kendra, les organisations peuvent conserver leurs données propriétaires dans leur propre environnement tout en bénéficiant des capacités de pointe en langage naturel des FM. Avec le lancement de la fonctionnalité de requête de documents de SageMaker Canvas, nous permettons à toute entreprise d'utiliser facilement les LLM et leurs connaissances d'entreprise comme source de vérité pour offrir une expérience de chat sécurisée. Toutes ces fonctionnalités sont disponibles dans un format sans code, permettant aux entreprises d'éviter de gérer des tâches répétitives et non spécialisées.

Pour en savoir plus sur SageMaker Canvas et sur la manière dont il permet à chacun de démarrer plus facilement avec le Machine Learning, consultez le Annonce de SageMaker Canvas. Découvrez comment SageMaker Canvas contribue à favoriser la collaboration entre les data scientists et les analystes commerciaux en lisant le Créer, partager et déployer une publication. Enfin, pour savoir comment créer votre propre flux de travail de génération augmentée de récupération, reportez-vous à SageMaker JumpStart RAG.

Bibliographie

Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., Küttler, H., Lewis, M., Yih, W., Rocktäschel, T., Riedel, S., Kiela, D. (2020). Génération augmentée par récupération pour les tâches PNL à forte intensité de connaissances. Progrès des systèmes de traitement de l'information neuronale, 33, 9459-9474.

À propos des auteurs

David Gallitelli est un architecte de solutions spécialisé senior pour l'IA/ML. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients du monde entier qui cherchent à adopter les technologies d'apprentissage automatique Low-Code/No-Code et l'IA générative. Il est développeur depuis qu'il est très jeune, commençant à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est depuis tombé amoureux.

David Gallitelli est un architecte de solutions spécialisé senior pour l'IA/ML. Il est basé à Bruxelles et travaille en étroite collaboration avec des clients du monde entier qui cherchent à adopter les technologies d'apprentissage automatique Low-Code/No-Code et l'IA générative. Il est développeur depuis qu'il est très jeune, commençant à coder à l'âge de 7 ans. Il a commencé à apprendre l'IA/ML à l'université et en est depuis tombé amoureux.

Bilal Alam est un architecte de solutions d'entreprise chez AWS, spécialisé dans le secteur des services financiers. La plupart du temps, Bilal aide ses clients à créer, améliorer et sécuriser leur environnement AWS afin de déployer leurs charges de travail les plus critiques. Il possède une vaste expérience dans les domaines des télécommunications, des réseaux et du développement de logiciels. Plus récemment, il s’est penché sur l’utilisation de l’IA/ML pour résoudre des problèmes commerciaux.

Bilal Alam est un architecte de solutions d'entreprise chez AWS, spécialisé dans le secteur des services financiers. La plupart du temps, Bilal aide ses clients à créer, améliorer et sécuriser leur environnement AWS afin de déployer leurs charges de travail les plus critiques. Il possède une vaste expérience dans les domaines des télécommunications, des réseaux et du développement de logiciels. Plus récemment, il s’est penché sur l’utilisation de l’IA/ML pour résoudre des problèmes commerciaux.

Pashmeen Mistry est chef de produit senior chez AWS. En dehors du travail, Pashmeen aime les randonnées aventureuses, la photographie et passer du temps avec sa famille.

Pashmeen Mistry est chef de produit senior chez AWS. En dehors du travail, Pashmeen aime les randonnées aventureuses, la photographie et passer du temps avec sa famille.

Dan Sinnreich est chef de produit senior chez AWS, contribuant à démocratiser l'apprentissage automatique low-code/no-code. Avant AWS, Dan a créé et commercialisé des plates-formes SaaS d'entreprise et des modèles de séries chronologiques utilisés par les investisseurs institutionnels pour gérer les risques et construire des portefeuilles optimaux. En dehors du travail, on le trouve en train de jouer au hockey, de faire de la plongée sous-marine et de lire de la science-fiction.

Dan Sinnreich est chef de produit senior chez AWS, contribuant à démocratiser l'apprentissage automatique low-code/no-code. Avant AWS, Dan a créé et commercialisé des plates-formes SaaS d'entreprise et des modèles de séries chronologiques utilisés par les investisseurs institutionnels pour gérer les risques et construire des portefeuilles optimaux. En dehors du travail, on le trouve en train de jouer au hockey, de faire de la plongée sous-marine et de lire de la science-fiction.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoData.Network Ai générative verticale. Autonomisez-vous. Accéder ici.

- PlatoAiStream. Intelligence Web3. Connaissance Amplifiée. Accéder ici.

- PlatonESG. Carbone, Technologie propre, Énergie, Environnement, Solaire, La gestion des déchets. Accéder ici.

- PlatoHealth. Veille biotechnologique et essais cliniques. Accéder ici.

- La source: https://aws.amazon.com/blogs/machine-learning/empower-your-business-users-to-extract-insights-from-company-documents-using-amazon-sagemaker-canvas-generative-ai/

- :possède

- :est

- :ne pas

- :où

- ][p

- $UP

- 100

- 12

- 2020

- 2021

- 2023

- 225

- 7

- a

- capacité

- Capable

- Qui sommes-nous

- accéléré

- accès

- accédé

- accessible

- Avec cette connaissance vient le pouvoir de prendre

- Supplémentaire

- adopter

- Après

- à opposer à

- âge

- AI

- AI / ML

- Tous

- Permettre

- le long de

- déjà

- toujours

- Amazon

- Amazone Kendra

- Amazon Sage Maker

- Toile Amazon SageMaker

- Amazon Web Services

- parmi

- an

- selon une analyse de l’Université de Princeton

- analyste

- Analystes

- ainsi que les

- annoncé

- Une autre

- répondre

- tous

- Apis

- appliqué

- Appliquer

- une approche

- approprié

- architecture

- SONT

- autour

- sur notre blog

- AS

- demander

- Assistante gérante

- associé

- At

- augmenter

- augmentée

- automatiquement

- disponibles

- éviter

- AWS

- soutenu

- base

- basé

- BE

- était

- va

- bénéficier

- jusqu'à XNUMX fois

- Bruxelles

- construire

- Développement

- construit

- la performance des entreprises

- entreprises

- bouton (dans la fenêtre de contrôle qui apparaît maintenant)

- by

- appel

- CAN

- la toile

- capacités

- aptitude

- capturer

- cas

- vérifier

- le choix

- Selectionnez

- cliquez

- étroitement

- le cloud

- code

- Codage

- collaboration

- collection

- comment

- Venir

- Communication

- Société

- comparant

- compatible

- complexe

- ordinateur

- Vision par ordinateur

- configuration

- configurée

- Connecter les

- cohérent

- Console

- construire

- contenu

- contenu

- continuer

- contribué

- Conversation

- conversations

- convertir

- converti

- engendrent

- critique

- des clients

- Clients

- données

- bases de données

- jours

- profond

- démocratiser

- déployer

- déployer

- décrire

- voulu

- détail

- Détection

- Développeur

- Développement

- discuter

- disparate

- plongée

- document

- INSTITUTIONNELS

- domaine

- e

- plus facilement

- Easy

- enrobage

- Employés

- vous accompagner

- permettre

- activé

- permet

- enrichir

- Assure

- assurer

- Entreprise

- entreprises

- entités

- Environment

- tout le monde

- exemple

- étendu

- d'experience

- explorez

- les

- Une vaste expérience

- externe

- extrait

- Déchu

- famille

- Fonctionnalité

- Fiction

- Fichiers

- finalement

- la traduction de documents financiers

- services financiers

- Prénom

- Focus

- suivre

- Abonnement

- Pour

- le format

- Accueillir

- trouvé

- Fondation

- fréquemment

- de

- recueillir

- générer

- généré

- générateur

- génération

- génératif

- IA générative

- obtenez

- donné

- globe

- gouvernance

- guide

- Maniabilité

- harnais

- Vous avez

- he

- aider

- aide

- Soulignant

- Randonnées

- sa

- Comment

- How To

- HTML

- http

- HTTPS

- if

- illustre

- immense

- améliorer

- in

- Y compris

- croissant

- indice

- index

- Indices

- industriel

- industrie

- d'information

- technologie innovante

- idées.

- DOCUMENTS

- investisseurs institutionnels

- l'intégration

- interagissant

- interactions

- interfaces

- interne

- développement

- Introduction

- intuitif

- Investisseurs

- IT

- SES

- jpg

- saut

- XNUMX éléments à

- connaissance

- spécialisées

- Transfert de connaissances

- langue

- gros

- lancer

- APPRENTISSAGE

- apprentissage

- Allons-y

- niveaux

- Lewis

- Bibliothèque

- Gamme

- Liste

- recherchez-

- love

- click

- machine learning

- Maintenir

- a prendre une

- Fabrication

- gérer

- gestion

- manager

- manière

- de nombreuses

- ML

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- (en fait, presque toutes)

- plusieurs

- Nature

- Traitement du langage naturel

- nécessaire

- de mise en réseau

- neural

- Nouveauté

- nlp

- maintenant

- of

- de rabais

- on

- une fois

- ONE

- ouverture

- ouvre

- opérationnel

- Opérations

- optimaux

- or

- organisations

- original

- Autre

- Autres

- ande

- les résultats

- sortie

- sorties

- au contrôle

- propre

- partie

- Effectuer

- effectué

- autorisations

- photographie

- image

- Plateformes

- Platon

- Intelligence des données Platon

- PlatonDonnées

- jouer

- portefeuilles

- possible

- Post

- défaillances

- power

- prédiction

- conditions préalables

- représentent

- Aperçu

- précédent

- Privé

- d'ouvrabilité

- processus

- traitement

- produire

- Produit

- chef de produit

- correct

- propriétaire

- fournir

- à condition de

- aportando

- requêtes

- question

- fréquemment posées

- vite.

- rapidement

- en cours

- récemment

- réduire

- réduire

- reportez-vous

- libérer

- libéré

- pertinent

- répétitif

- conditions

- a besoin

- un article

- réponse

- réponses

- Résultats

- Avis

- Analyse

- s

- SaaS.

- garanties

- sagemaker

- Sciences

- Science-fiction

- scientifiques

- pour écran

- fluide

- Rechercher

- Section

- sécurisé

- sécurisation

- Chercher

- choisi

- la sélection

- supérieur

- sensible

- sentiment

- des sentiments

- Services

- Session

- set

- mise

- Paramétres

- installation

- Partager

- devrait

- montrer

- montré

- depuis

- compétences

- So

- Logiciels

- développement de logiciels

- sur mesure

- Solutions

- RÉSOUDRE

- Identifier

- source

- Sources

- spécialiste

- groupe de neurones

- Dépenses

- Commencer

- j'ai commencé

- Commencez

- state-of-the-art

- étapes

- Étapes

- Encore

- tel

- résumé

- Support

- Interrupteur

- combustion propre

- tâches

- équipes

- Technique

- Les technologies

- Telco

- principes

- que

- qui

- Les

- les informations

- La Source

- leur

- Les

- puis

- Là.

- this

- ceux

- Avec

- fiable

- à

- top

- sujet

- Transformer

- vraiment

- confiance

- TOUR

- sous

- sous-jacent

- université

- jusqu'à

- mise à jour

- Mises à jour

- utilisé

- d'utiliser

- Utilisateur

- utilisateurs

- Usages

- en utilisant

- ux

- Plus-value

- variété

- très

- vision

- volumes

- W

- marcher

- souhaitez

- était

- we

- web

- services Web

- ont été

- quand

- qui

- tout en

- sera

- comprenant

- dans les

- sans

- activités principales

- workflow

- vos contrats

- écriture

- Vous n'avez

- jeune

- Votre

- zéphyrnet