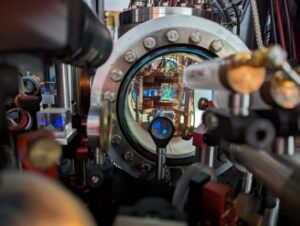

Vice-président d'IBM Quantum Jay Gambetta s'entretient avec Philip Ball sur les nombreuses avancées quantiques de l'entreprise au cours des 20 dernières années, ainsi que sur sa feuille de route quinquennale récemment annoncée vers « l'avantage quantique ».

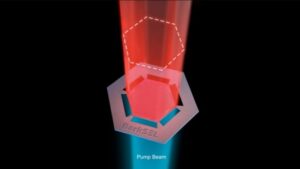

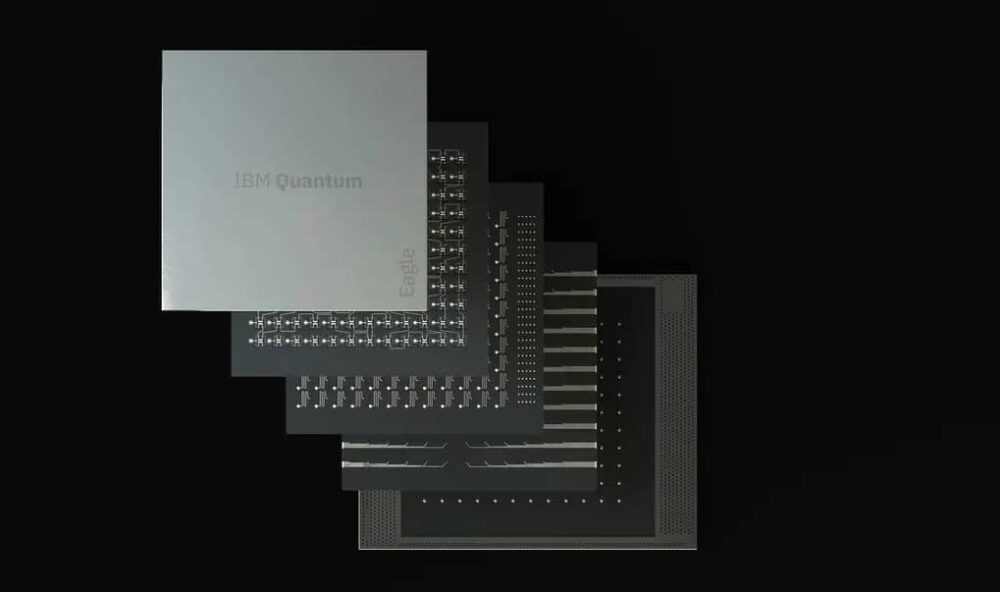

Les entreprises et les laboratoires de recherche du monde entier s'efforcent de faire sortir leurs technologies quantiques naissantes du laboratoire et de les intégrer dans le monde réel, le géant américain de la technologie IBM étant un acteur clé. En mai de cette année, IBM Quantum a dévoilé sa dernière feuille de route pour l'avenir de l'informatique quantique dans la décennie à venir, et l'entreprise s'est fixé des objectifs ambitieux. Après avoir annoncé son Processeur Eagle avec 127 bits quantiques (qubits) l'année dernière, l'entreprise est développe actuellement le processeur Osprey de 433 qubits pour un début plus tard cette année, qui sera suivi en 2023 par le Condor de 1121 XNUMX qubits.

Mais au-delà de cela, affirme la société, le jeu passera à l’assemblage de ces processeurs dans des circuits modulaires, dans lesquels les puces sont câblées ensemble via des interconnexions quantiques ou classiques plus clairsemées. Cet effort culminera avec ce qu'ils appellent leur appareil Kookaburra de 4158 2025 qubits en XNUMX. Au-delà de cette date, IBM prévoit un système modulaire. des processeurs dotés de 100,000 XNUMX qubits ou plus, capables de calculer sans les erreurs qui font actuellement de l'informatique quantique une question de recherche de solutions de contournement au bruit des qubits. Grâce à cette approche, l’équipe d’informatique quantique de l’entreprise est convaincue qu’elle peut obtenir un « avantage quantique » général, dans lequel les ordinateurs quantiques surpasseront systématiquement les ordinateurs classiques et effectueront des calculs complexes au-delà des moyens des appareils classiques.

Alors qu'il était à Londres en route pour le 28th Conférence Solvay à Bruxelles, qui abordait l'information quantique, Monde de la physique rattrapé le physicien Jay Gambetta, vice-président d'IBM Quantum. Ayant été à l'origine d'une grande partie des avancées de l'entreprise au cours des deux dernières décennies, Gambetta a expliqué comment ces objectifs pourraient être atteints et ce qu'ils impliqueront pour l'avenir de l'informatique quantique.

Quel est l’état actuel des connaissances chez IBM Quantum ? Quels sont les paramètres clés sur lesquels vous vous concentrez ?

La feuille de route d'IBM vise à augmenter non seulement le nombre de qubits, mais aussi leur vitesse, leur qualité et leur architecture de circuit. Nous avons désormais des temps de cohérence [durée pendant laquelle les qubits restent cohérents et capables d'effectuer un calcul quantique] de 300 microsecondes dans le processeur Eagle [contre environ 1 μs en 2010], et la prochaine génération d'appareils atteindra 300 millisecondes. Et nos qubits [fabriqués à partir de métaux supraconducteurs] ont désormais une fidélité de près de 99.9 % [ils ne subissent qu'une erreur toutes les 1000 10 opérations – soit un taux d'erreur de XNUMX-3]. Je pense qu’il ne serait pas impossible d’atteindre 99.99 % d’ici la fin de l’année prochaine.

Le test décisif pour la maturité des ordinateurs quantiques est donc de savoir si le temps d'exécution quantique peut être compétitif par rapport au temps d'exécution classique.

Mais il deviendra plus important de faire les choses intelligemment que de simplement pousser les chiffres bruts. L'architecture du processeur devient de plus en plus importante. Je ne pense pas que nous dépasserons les 1000 10,000 qubits par puce [comme sur le Condor], alors maintenant nous nous penchons sur la modularité. De cette façon, nous pourrons atteindre des processeurs de 100 95 qubits d’ici la fin de cette décennie. Nous allons utiliser à la fois la communication classique (pour contrôler l’électronique) entre les puces et les canaux quantiques qui créent une certaine intrication (pour effectuer des calculs). Ces canaux entre puces seront lents – peut-être XNUMX fois plus lents que les circuits eux-mêmes. Et les fidélités des chaînes auront du mal à pousser au-dessus de XNUMX%.

Pour le calcul haute performance, ce qui compte vraiment, c'est de minimiser le temps d'exécution, c'est-à-dire de minimiser le temps nécessaire pour générer une solution à un problème d'intérêt. Le test décisif pour la maturité des ordinateurs quantiques est de savoir si le temps d’exécution quantique peut être compétitif par rapport au temps d’exécution classique. Nous avons commencé à montrer théoriquement que si vous souhaitez exécuter un grand circuit et que vous le divisez en circuits plus petits, alors chaque fois que vous effectuez une coupe, vous pouvez considérer que cela entraîne un coût classique, qui augmente le temps d'exécution. exponentiellement. L’objectif est donc de maintenir cette augmentation exponentielle aussi proche que possible de 1.

Pour un circuit donné, le temps d'exécution dépend de façon exponentielle d'un paramètre que nous appelons γ̄ élevé au pouvoir nd, Où n est le nombre de qubits et d est la profondeur [une mesure du chemin le plus long entre l'entrée et la sortie du circuit, ou de manière équivalente le nombre de pas de temps nécessaires au fonctionnement du circuit]. Donc, si nous pouvons obtenir b γ̄ aussi proche que possible de 1, nous arrivons à un point où il y a un réel avantage quantique : pas de croissance exponentielle du temps d’exécution. Nous pouvons réduire γ̄ grâce à des améliorations de la cohérence et de la fidélité des portes [taux d'erreur intrinsèque]. Finalement, nous atteindrons un point critique où, même avec la surcharge exponentielle de l’atténuation des erreurs, nous pourrons récolter des avantages d’exécution par rapport aux ordinateurs classiques. Si vous parvenez à ramener γ̄ à 1.001, le temps d'exécution est plus rapide que si vous deviez simuler ces circuits de manière classique. Je suis convaincu que nous pouvons y parvenir : grâce à l’amélioration de la fidélité de la porte et à la suppression de la diaphonie entre les qubits, nous avons déjà mesuré un γ̄ de 1.008 sur la puce Falcon r10 [27 qubits].

Comment pouvez-vous apporter ces améliorations pour atténuer les erreurs ?

Pour améliorer la fidélité, nous avons adopté une approche appelée annulation probabiliste des erreurs [arXiv:2201.09866]. L'idée est que vous m'envoyez des charges de travail et que je vous enverrai des résultats traités avec des estimations sans bruit. Vous dites que je veux que vous gériez ce circuit ; Je caractérise tout le bruit que j'ai dans mon système, j'effectue de nombreuses analyses, puis je traite tous ces résultats ensemble pour vous donner une estimation sans bruit de la sortie du circuit. De cette façon, nous commençons à montrer qu’il y aura probablement un continuum entre la suppression et l’atténuation des erreurs jusqu’à la correction complète des erreurs.

Vous pouvez donc y arriver sans construire des qubits logiques entièrement corrigeant les erreurs ?

Qu’est-ce qu’un qubit logique ? Qu’est-ce que les gens veulent réellement dire par là ? Ce qui compte vraiment, c'est : pouvez-vous exécuter des circuits logiques et comment les exécuter de manière à ce que le temps d'exécution soit toujours plus rapide ? Plutôt que de penser à la construction de qubits logiques, nous réfléchissons à la manière dont nous exécutons des circuits et donnons aux utilisateurs des estimations de la réponse, puis à la quantifier par le temps d'exécution.

Lorsque vous effectuez une correction d'erreur normale, vous corrigez ce que vous pensiez que la réponse aurait été jusque-là. Vous mettez à jour un cadre de référence. Mais nous parviendrons à la correction des erreurs via l’atténuation des erreurs. Avec γ̄ égal à 1, j’aurai effectivement une correction d’erreur, car il n’y a aucune surcharge pour améliorer les estimations autant que vous le souhaitez.

De cette façon, nous aurons effectivement des qubits logiques, mais ils seront insérés en continu. Nous commençons donc à y penser à un niveau supérieur. Notre objectif est de créer, du point de vue de l'utilisateur, un continuum qui devient de plus en plus rapide. Le test décisif pour la maturité des ordinateurs quantiques est donc de savoir si le temps d'exécution quantique peut être compétitif par rapport au temps d'exécution classique.

C’est très différent de ce que font d’autres entreprises quantiques, mais je serais très surpris si cela ne devenait pas l’opinion générale – je parie que vous commencerez à voir des gens comparer les temps d’exécution, et non les taux de correction d’erreurs.

Ce que nous faisons, c'est simplement de l'informatique en général, et nous lui donnons un coup de pouce grâce à un processeur quantique.

Si vous fabriquez des appareils modulaires avec des connexions classiques, cela signifie-t-il que l'avenir n'est pas vraiment quantique par rapport au classique, mais quantique ? ainsi que classique?

Oui. Réunir le classique et le quantique vous permettra de faire plus. C’est ce que j’appelle le surplus quantique : faire de l’informatique classique de manière intelligente en utilisant des ressources quantiques.

Si je pouvais agiter une baguette magique, je n’appellerais pas cela de l’informatique quantique. Je dirais en réalité que ce que nous faisons n’est que de l’informatique en général, et nous lui donnons un coup de pouce grâce à un processeur quantique. J’utilise le slogan « superinformatique centrée sur le quantum ». Il s’agit en réalité d’intensifier l’informatique en y ajoutant du quantique. Je pense vraiment que ce sera l'architecture.

Quels sont les obstacles techniques ? Est-il important que ces appareils nécessitent un refroidissement cryogénique, par exemple ?

Ce n’est pas vraiment grave. Le plus important est que si nous poursuivons notre feuille de route, je m'inquiète du prix de l'électronique et de tout ce qui l'entoure. Pour réduire ces coûts, nous devons développer un écosystème ; et nous, en tant que communauté, n’en faisons toujours pas assez pour créer cet environnement. Je ne vois pas beaucoup de gens se concentrer uniquement sur l’électronique, mais je pense que cela arrivera.

Est-ce que toute la science est désormais terminée, de sorte qu’il s’agit désormais davantage d’une question d’ingénierie ?

Il y aura toujours de la science à faire, surtout si vous tracez ce chemin depuis l’atténuation des erreurs jusqu’à la correction des erreurs. Quel type de connectivité souhaitez-vous intégrer à la puce ? Quelles sont les connexions ? Ce sont toutes des sciences fondamentales. Je pense qu'on peut encore pousser les taux d'erreur à 10-5. Personnellement, je n’aime pas qualifier les choses de « science » ou de « technologie » ; nous construisons une innovation. Je pense qu'il y a définitivement une transition vers que ces appareils deviennent des outils, et la question est de savoir comment nous utilisons ces choses pour la science, plutôt que de savoir comment créer l'outil.

Craignez-vous qu’il puisse y avoir une bulle quantique ?

Non, je pense que l’avantage quantique peut être divisé en deux choses. Tout d’abord, comment faire fonctionner des circuits plus rapidement sur du matériel quantique ? Je suis convaincu que je peux faire des prédictions à ce sujet. Et deuxièmement, comment utilisez-vous réellement ces circuits et les associez-vous à des applications ? Pourquoi une méthode quantique fonctionne-t-elle mieux qu’une simple méthode classique ? Ce sont des questions scientifiques très difficiles. Et ce sont des questions qui intéressent tous les physiciens des hautes énergies, les scientifiques des matériaux et les chimistes quantiques. Je pense qu’il va certainement y avoir une demande – nous la voyons déjà. Nous constatons également que certaines entreprises s’y intéressent, mais il faudra du temps pour trouver de véritables solutions, plutôt que de considérer le quantum comme un outil scientifique.

Je vois cela comme une transition en douceur. Un domaine d’application potentiel important concerne les problèmes comportant des données présentant un certain type de structure, en particulier les données pour lesquelles il est très difficile de trouver les corrélations de manière classique. La finance et la médecine sont toutes deux confrontées à de tels problèmes, et les méthodes quantiques telles que l’apprentissage automatique quantique sont très efficaces pour trouver des corrélations. Le chemin sera long, mais l’investissement en vaut la peine.

Qu’en est-il de la protection des calculs contre, par exemple, des attaques telles que l’algorithme de factorisation de Shor, qui exploite des méthodes quantiques pour déchiffrer les méthodes cryptographiques à clé publique actuelles, basées sur la factorisation ?

Tout le monde veut être en sécurité contre l’algorithme de Shor – on l’appelle désormais « quantique-sûr ». Nous avons effectué de nombreuses recherches fondamentales sur les algorithmes, mais la manière de les intégrer va devenir une question importante. Nous étudions depuis le début l’intégration de cela dans nos produits, plutôt que comme un module complémentaire. Et nous devons nous demander comment nous assurer que nous disposons d’une infrastructure classique sûre pour le quantique. La façon dont cet avenir se déroulera sera très importante au cours des prochaines années – la façon dont vous construirez du matériel à sécurité quantique à partir de zéro.

Ma définition du succès est que la plupart des utilisateurs ne sauront même pas qu'ils utilisent un ordinateur quantique.

Avez-vous été surpris par la vitesse à laquelle l’informatique quantique est arrivée ?

Pour quelqu’un qui s’y est plongé aussi profondément que moi depuis 2000, cela s’est remarquablement rapproché du chemin qui avait été prédit. Je me souviens d'être revenu à une feuille de route interne d'IBM de 2011 et c'était plutôt parfait. Je pensais alors que j'inventais des choses ! En général, j’ai l’impression que les gens surestiment le temps que cela prendra. À mesure que nous progressons et que les gens apportent des idées d’information quantique à ces appareils, dans les prochaines années, nous serons en mesure de faire fonctionner des circuits plus grands. Il s’agira ensuite des types d’architecture que vous devez construire, de la taille des clusters, des types de canaux de communication que vous utilisez, etc. Ces questions dépendront du type de circuits que vous utilisez : comment commencer à construire des machines pour certains types de circuits ? Il y aura une spécialisation des circuits.

À quoi ressemblera 2030 pour l’informatique quantique ?

Ma définition du succès est que la plupart des utilisateurs ne savent même pas qu’ils utilisent un ordinateur quantique, car il est intégré à une architecture qui fonctionne de manière transparente avec l’informatique classique. La mesure du succès serait alors qu’il est invisible pour la plupart des gens qui l’utilisent, mais qu’il améliore leur vie d’une certaine manière. Peut-être que votre téléphone mobile utilisera une application qui effectue son estimation à l'aide d'un ordinateur quantique. En 2030, nous ne serons pas à ce niveau-là mais je pense que nous aurons alors de très grosses machines et elles seront bien au-delà de ce que nous pouvons faire classiquement.