L'apprentissage automatique (ML) a amélioré les activités dans tous les secteurs ces dernières années, du système de recommandation sur votre Prime Video compte, pour documenter la synthèse et la recherche efficace avec Alexade l'assistance vocale. Cependant, la question demeure de savoir comment intégrer cette technologie dans votre entreprise. Contrairement aux méthodes traditionnelles basées sur des règles, ML déduit automatiquement des modèles à partir des données afin d'effectuer la tâche qui vous intéresse. Bien que cela évite la nécessité de définir des règles d'automatisation, cela signifie également que les modèles ML ne peuvent être aussi bons que les données sur lesquelles ils sont formés. Cependant, la création de données est souvent une tâche difficile. Au Laboratoire de solutions Amazon Machine Learning, nous avons rencontré ce problème à plusieurs reprises et souhaitons faciliter ce parcours pour nos clients. Si vous souhaitez décharger ce processus, vous pouvez utiliser Amazon SageMaker Vérité au sol Plus.

À la fin de cet article, vous serez en mesure d'atteindre les objectifs suivants :

- Comprendre les processus métier impliqués dans la mise en place d'un pipeline d'acquisition de données

- Identifiez les services cloud AWS pour prendre en charge et accélérer votre pipeline d'étiquetage de données

- Exécuter une tâche d'acquisition et d'étiquetage de données pour des cas d'utilisation personnalisés

- Créer des données de haute qualité en suivant les meilleures pratiques commerciales et techniques

Tout au long de cet article, nous nous concentrons sur le processus de création de données et nous nous appuyons sur les services AWS pour gérer l'infrastructure et les composants de processus. A savoir, nous utilisons Vérité au sol Amazon SageMaker pour gérer le pipeline de l'infrastructure d'étiquetage et l'interface utilisateur. Ce service utilise une approche ponctuelle pour collecter vos données à partir de Service de stockage simple Amazon (Amazon S3) et configurez un workflow d'étiquetage. Pour l'étiquetage, il vous offre la flexibilité intégrée d'acquérir des étiquettes de données à l'aide de votre équipe privée, un Turc mécanique d'Amazon force, ou votre fournisseur d'étiquetage préféré de Marketplace AWS . Enfin, vous pouvez utiliser AWS Lambda ainsi que Ordinateurs portables Amazon SageMaker pour traiter, visualiser ou contrôler la qualité des données, que ce soit avant ou après l'étiquetage.

Maintenant que toutes les pièces sont posées, commençons le processus !

Le processus de création de données

Contrairement à l'intuition commune, la première étape de la création de données n'est pas la collecte de données. Travailler en amont des utilisateurs pour articuler le problème est crucial. Par exemple, qu'est-ce qui intéresse les utilisateurs dans l'artefact final ? Où les experts pensent-ils que les signaux pertinents pour le cas d'utilisation résident dans les données ? Quelles informations sur l'environnement du cas d'utilisation pourraient être fournies au modèle ? Si vous ne connaissez pas les réponses à ces questions, ne vous inquiétez pas. Accordez-vous du temps pour discuter avec les utilisateurs et les experts de terrain afin de comprendre les nuances. Cette compréhension initiale vous orientera dans la bonne direction et vous préparera au succès.

Pour cet article, nous supposons que vous avez couvert ce processus initial de spécification des besoins des utilisateurs. Les trois sections suivantes vous guident tout au long du processus ultérieur de création de données de qualité : planification, création de données source et annotation de données. Le pilotage des boucles aux étapes de création et d'annotation des données est primordial pour assurer une création efficace des données étiquetées. Cela implique une itération entre la création de données, l'annotation, l'assurance qualité et la mise à jour du pipeline si nécessaire.

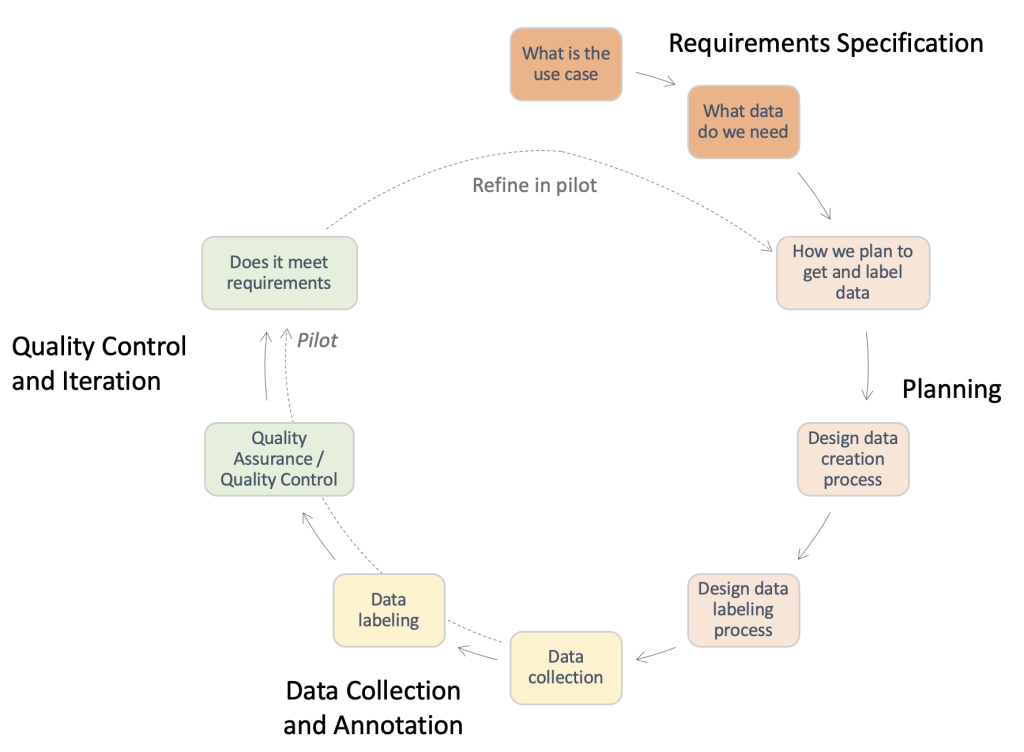

La figure suivante fournit une vue d'ensemble des étapes requises dans un pipeline de création de données typique. Vous pouvez revenir en arrière à partir du cas d'utilisation pour identifier les données dont vous avez besoin (spécification des exigences), créer un processus pour obtenir les données (planification), mettre en œuvre le processus d'acquisition de données réel (collecte de données et annotation) et évaluer les résultats. Les exécutions pilotes, mises en évidence par des lignes pointillées, vous permettent de répéter le processus jusqu'à ce qu'un pipeline d'acquisition de données de haute qualité ait été développé.

Présentation des étapes requises dans un pipeline de création de données typique.

Préproduction

Un processus de création de données standard peut prendre du temps et constituer un gaspillage de précieuses ressources humaines s'il est mené de manière inefficace. Pourquoi cela prendrait-il du temps ? Pour répondre à cette question, nous devons comprendre la portée du processus de création de données. Pour vous aider, nous avons rassemblé une liste de contrôle de haut niveau et une description des composants clés et des parties prenantes que vous devez prendre en compte. Répondre à ces questions peut être difficile au début. Selon votre cas d'utilisation, seuls certains d'entre eux peuvent être applicables.

- Identifier le point de contact légal pour les approbations requises – L'utilisation de données pour votre application peut nécessiter un examen de la licence ou du contrat fournisseur pour garantir la conformité avec les politiques de l'entreprise et les cas d'utilisation. Il est important d'identifier votre support juridique tout au long des étapes d'acquisition et d'annotation des données du processus.

- Identifier le point de contact de sécurité pour le traitement des données –La fuite des données achetées peut entraîner de graves amendes et des répercussions pour votre entreprise. Il est important d'identifier votre support de sécurité tout au long des étapes d'acquisition et d'annotation des données pour garantir des pratiques sécurisées.

- Détailler les exigences des cas d'utilisation et définir les données sources et les directives d'annotation – La création et l'annotation des données sont difficiles en raison de la grande spécificité requise. Les parties prenantes, y compris les générateurs de données et les annotateurs, doivent être complètement alignées pour éviter de gaspiller des ressources. À cette fin, il est courant d'utiliser un document de directives qui spécifie chaque aspect de la tâche d'annotation : instructions exactes, cas extrêmes, exemple de procédure pas à pas, etc.

- Alignez-vous sur les attentes en matière de collecte de vos données sources - Considérer ce qui suit:

- Mener des recherches sur les sources de données potentielles – Par exemple, des ensembles de données publics, des ensembles de données existants d'autres équipes internes, des données auto-collectées ou achetées auprès de fournisseurs.

- Effectuer une évaluation de la qualité – Créer un pipeline d'analyse par rapport au cas d'utilisation final.

- Alignez-vous sur les attentes en matière de création d'annotations de données - Considérer ce qui suit:

- Identifier les acteurs techniques – Il s'agit généralement d'une personne ou d'une équipe de votre entreprise capable d'utiliser la documentation technique concernant Ground Truth pour mettre en œuvre un pipeline d'annotations. Ces parties prenantes sont également responsables de l'évaluation de la qualité des données annotées pour s'assurer qu'elles répondent aux besoins de votre application ML en aval.

- Identifier les annotateurs de données – Ces personnes utilisent des instructions prédéterminées pour ajouter des étiquettes à vos données source dans Ground Truth. Ils peuvent avoir besoin de posséder une connaissance du domaine en fonction de votre cas d'utilisation et des directives d'annotation. Vous pouvez utiliser une main-d'œuvre interne à votre entreprise, ou payer un main-d'œuvre gérée par un fournisseur externe.

- Assurer la supervision du processus de création de données – Comme vous pouvez le voir dans les points précédents, la création de données est un processus détaillé qui implique de nombreux acteurs spécialisés. Par conséquent, il est crucial de le surveiller de bout en bout vers le résultat souhaité. Le fait qu'une personne ou une équipe dédiée supervise le processus peut vous aider à garantir un processus de création de données cohérent et efficace.

Selon l'itinéraire que vous décidez d'emprunter, vous devez également tenir compte des éléments suivants :

- Créer le jeu de données source – Cela fait référence aux cas où les données existantes ne sont pas adaptées à la tâche à accomplir, ou des contraintes légales vous empêchent de les utiliser. Des équipes internes ou des fournisseurs externes (point suivant) doivent être utilisés. C'est souvent le cas pour des domaines hautement spécialisés ou des domaines où la recherche publique est faible. Par exemple, les questions courantes d'un médecin, la pose de vêtements ou les experts sportifs. Elle peut être interne ou externe.

- Rechercher des fournisseurs et mener un processus d'intégration – Lorsque des fournisseurs externes sont utilisés, un processus de contractualisation et d'intégration doit être mis en place entre les deux entités.

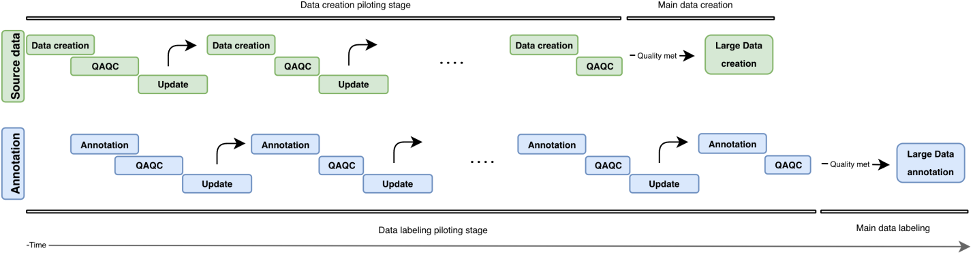

Dans cette section, nous avons passé en revue les composants et les parties prenantes que nous devons considérer. Cependant, à quoi ressemble le processus réel? Dans la figure suivante, nous décrivons un workflow de processus pour la création et l'annotation de données. L'approche itérative utilise de petits lots de données appelés pilotes pour réduire les délais d'exécution, détecter les erreurs dès le début et éviter de gaspiller des ressources dans la création de données de mauvaise qualité. Nous décrivons ces tours pilotes plus loin dans cet article. Nous couvrons également certaines des meilleures pratiques pour la création de données, l'annotation et le contrôle de la qualité.

La figure suivante illustre le développement itératif d'un pipeline de création de données. Verticalement, on retrouve le bloc data sourcing (vert) et le bloc annotation (bleu). Les deux blocs ont des cycles pilotes indépendants (création de données/annotation, QAQC et mise à jour). Des données de sources de plus en plus élevées sont créées et peuvent être utilisées pour construire des annotations de plus en plus de meilleure qualité.

Vue d'ensemble du développement itératif dans un pipeline de création de données.

Création de données sources

Le processus de création d'entrée s'articule autour de la mise en scène de vos éléments d'intérêt, qui dépendent de votre type de tâche. Il peut s'agir d'images (scans de journaux), de vidéos (scènes de circulation), de nuages de points 3D (scans médicaux) ou simplement de texte (pistes de sous-titres, transcriptions). En général, lors de la mise en scène de vos éléments liés aux tâches, assurez-vous de ce qui suit :

- Refléter le cas d'utilisation réel de l'éventuel système AI/ML – La configuration de collecte d'images ou de vidéos pour vos données d'entraînement doit correspondre étroitement à la configuration de vos données d'entrée dans l'application du monde réel. Cela signifie avoir des surfaces de placement, des sources d'éclairage ou des angles de caméra cohérents.

- Prendre en compte et minimiser les sources de variabilité - Considérer ce qui suit:

- Développer les meilleures pratiques pour maintenir les normes de collecte de données – En fonction de la granularité de votre cas d'utilisation, vous devrez peut-être spécifier des exigences pour garantir la cohérence entre vos points de données. Par exemple, si vous collectez des données d'image ou de vidéo à partir de points de caméra uniques, vous devrez peut-être vous assurer du placement cohérent de vos objets d'intérêt ou exiger un contrôle de la qualité de la caméra avant un cycle de capture de données. Cela peut éviter des problèmes tels que l'inclinaison ou le flou de la caméra, et minimiser les frais généraux en aval tels que la suppression des images hors cadre ou floues, ainsi que la nécessité de centrer manuellement le cadre de l'image sur votre zone d'intérêt.

- Anticiper les sources de variabilité du temps de test – Si vous anticipez une variabilité dans l'un des attributs mentionnés jusqu'à présent pendant la durée du test, assurez-vous que vous pouvez capturer ces sources de variabilité lors de la création des données de formation. Par exemple, si vous vous attendez à ce que votre application ML fonctionne dans plusieurs paramètres d'éclairage différents, vous devez viser à créer des images et des vidéos de formation à différents paramètres d'éclairage. Selon le cas d'utilisation, la variabilité du positionnement de la caméra peut également influencer la qualité de vos étiquettes.

- Incorporer les connaissances antérieures du domaine lorsqu'elles sont disponibles - Considérer ce qui suit:

- Entrées sur les sources d'erreur – Les praticiens de domaine peuvent fournir des informations sur les sources d'erreur en fonction de leurs années d'expérience. Ils peuvent fournir des commentaires sur les meilleures pratiques pour les deux points précédents : Quels paramètres reflètent le mieux le cas d'utilisation réel ? Quelles sont les sources possibles de variabilité lors de la collecte des données, ou au moment de leur utilisation ?

- Meilleures pratiques de collecte de données spécifiques à un domaine – Bien que vos parties prenantes techniques aient peut-être déjà une bonne idée des aspects techniques sur lesquels se concentrer dans les images ou les vidéos collectées, les praticiens du domaine peuvent fournir des commentaires sur la meilleure façon de mettre en scène ou de collecter les données de manière à répondre à ces besoins.

Contrôle qualité et assurance qualité des données créées

Maintenant que vous avez configuré le pipeline de collecte de données, il peut être tentant d'aller de l'avant et de collecter autant de données que possible. Attendez une minute! Nous devons d'abord vérifier si les données collectées via la configuration conviennent à votre cas d'utilisation réel. Nous pouvons utiliser des échantillons initiaux et améliorer de manière itérative la configuration grâce aux informations que nous avons acquises en analysant ces exemples de données. Travaillez en étroite collaboration avec vos parties prenantes techniques, commerciales et d'annotation pendant le processus pilote. Cela garantira que votre pipeline résultant répond aux besoins de l'entreprise tout en générant des données étiquetées prêtes pour le ML avec des frais généraux minimes.

Annotations

L'annotation des entrées est l'endroit où nous ajoutons la touche magique à nos données : les étiquettes ! Selon votre type de tâche et votre processus de création de données, vous pouvez avoir besoin d'annotateurs manuels ou vous pouvez utiliser des méthodes automatisées prêtes à l'emploi. Le pipeline d'annotation de données lui-même peut être une tâche techniquement difficile. Ground Truth facilite ce voyage pour vos parties prenantes techniques avec son répertoire intégré de workflows d'étiquetage pour les sources de données communes. Avec quelques étapes supplémentaires, il vous permet également de construire workflows d'étiquetage personnalisés au-delà des options préconfigurées.

Posez-vous les questions suivantes lors du développement d'un workflow d'annotation adapté :

- Ai-je besoin d'un processus d'annotation manuelle pour mes données ? Dans certains cas, les services d'étiquetage automatisés peuvent être suffisants pour la tâche à accomplir. L'examen de la documentation et des outils disponibles peut vous aider à déterminer si une annotation manuelle est nécessaire pour votre cas d'utilisation (pour plus d'informations, consultez Qu'est-ce que l'étiquetage des données ?). Le processus de création de données peut permettre différents niveaux de contrôle concernant la granularité de vos annotations de données. En fonction de ce processus, vous pouvez également parfois contourner le besoin d'annotation manuelle. Pour plus d'informations, reportez-vous à Créez un ensemble de données Q&A personnalisé à l'aide d'Amazon SageMaker Ground Truth pour former un modèle NLU Hugging Face Q&A.

- Qu'est-ce qui constitue ma vérité fondamentale ? Dans la plupart des cas, la vérité terrain viendra de votre processus d'annotation - c'est tout l'intérêt ! Dans d'autres, l'utilisateur peut avoir accès à des étiquettes de vérité terrain. Cela peut considérablement accélérer votre processus d'assurance qualité ou réduire les frais généraux requis pour plusieurs annotations manuelles.

- Quelle est la limite supérieure de l'écart par rapport à mon état de vérité terrain ? Travaillez avec vos utilisateurs finaux pour comprendre les erreurs typiques autour de ces étiquettes, les sources de ces erreurs et la réduction souhaitée des erreurs. Cela vous aidera à identifier les aspects de la tâche d'étiquetage qui sont les plus difficiles ou qui sont susceptibles d'avoir des erreurs d'annotation.

- Existe-t-il des règles préexistantes utilisées par les utilisateurs ou les praticiens de terrain pour étiqueter ces éléments ? Utilisez et affinez ces directives pour créer un ensemble d'instructions pour vos annotateurs manuels.

Pilotage du processus d'annotation des entrées

Lors du pilotage du processus d'annotation d'entrée, tenez compte des points suivants :

- Passez en revue les instructions avec les annotateurs et les praticiens de terrain – Les instructions doivent être concises et précises. Demandez des commentaires à vos utilisateurs (les instructions sont-elles exactes ? Pouvons-nous réviser certaines instructions pour nous assurer qu'elles sont compréhensibles par des praticiens qui ne sont pas sur le terrain ?) et annotateurs (est-ce que tout est compréhensible ? La tâche est-elle claire ?). Si possible, ajoutez un exemple de bonnes et de mauvaises données étiquetées pour aider vos annotateurs à identifier ce qui est attendu et à quoi pourraient ressembler les erreurs d'étiquetage courantes.

- Collecter des données pour les annotations – Examinez les données avec votre client pour vous assurer qu'elles répondent aux normes attendues et pour vous aligner sur les résultats attendus de l'annotation manuelle.

- Fournissez des exemples à votre groupe d'annotateurs manuels sous forme de test – Quelle est la variance typique parmi les annotateurs dans cet ensemble d'exemples ? Étudiez la variance de chaque annotation dans une image donnée pour identifier les tendances de cohérence entre les annotateurs. Comparez ensuite les écarts entre les images ou les images vidéo pour identifier les étiquettes difficiles à placer.

Contrôle qualité des annotations

Le contrôle de la qualité des annotations comporte deux éléments principaux : l'évaluation de la cohérence entre les annotateurs et l'évaluation de la qualité des annotations elles-mêmes.

Vous pouvez affecter plusieurs annotateurs à la même tâche (par exemple, trois annotateurs étiquettent les points clés sur la même image) et mesurer la valeur moyenne à côté de l'écart type de ces étiquettes parmi les annotateurs. Cela vous aide à identifier les annotations aberrantes (étiquette incorrecte utilisée ou étiquette éloignée de l'annotation moyenne), ce qui peut guider des résultats exploitables, tels que l'affinement de vos instructions ou la formation complémentaire de certains annotateurs.

L'évaluation de la qualité des annotations elles-mêmes est liée à la variabilité des annotateurs et (le cas échéant) à la disponibilité d'experts du domaine ou d'informations de vérité terrain. Y a-t-il certaines étiquettes (sur toutes vos images) où la variance moyenne entre les annotateurs est constamment élevée ? Certaines étiquettes sont-elles éloignées de vos attentes quant à l'endroit où elles devraient être ou à quoi elles devraient ressembler ?

D'après notre expérience, une boucle de contrôle qualité typique pour l'annotation de données peut ressembler à ceci :

- Itérer sur les instructions ou la mise en scène de l'image en fonction des résultats de l'exécution du test – Y a-t-il des objets masqués ou la mise en scène de l'image ne correspond-elle pas aux attentes des annotateurs ou des utilisateurs ? Les instructions sont-elles trompeuses ou avez-vous oublié des étiquettes ou des erreurs courantes dans vos images exemplaires ? Pouvez-vous affiner les instructions pour vos annotateurs ?

- Si vous êtes satisfait d'avoir résolu tous les problèmes du test, faites un lot d'annotations – Pour tester les résultats du lot, suivez la même approche d'évaluation de la qualité consistant à évaluer les variabilités des étiquettes inter-annotateurs et inter-images.

Conclusion

Cet article sert de guide aux parties prenantes de l'entreprise pour comprendre les complexités de la création de données pour les applications AI/ML. Les processus décrits servent également de guide aux praticiens techniques pour générer des données de qualité tout en optimisant les contraintes commerciales telles que le personnel et les coûts. S'il n'est pas bien fait, un pipeline de création et d'étiquetage de données peut prendre jusqu'à 4 à 6 mois.

Avec les directives et les suggestions décrites dans cet article, vous pouvez anticiper les obstacles, réduire le temps d'achèvement et minimiser les coûts de votre parcours vers la création de données de haute qualité.

À propos des auteurs

Jasleen Grewal est scientifique appliquée chez Amazon Web Services, où elle travaille avec des clients AWS pour résoudre des problèmes du monde réel à l'aide de l'apprentissage automatique, avec un accent particulier sur la médecine de précision et la génomique. Elle possède une solide expérience en bioinformatique, en oncologie et en génomique clinique. Elle est passionnée par l'utilisation de l'IA/ML et des services cloud pour améliorer les soins aux patients.

Jasleen Grewal est scientifique appliquée chez Amazon Web Services, où elle travaille avec des clients AWS pour résoudre des problèmes du monde réel à l'aide de l'apprentissage automatique, avec un accent particulier sur la médecine de précision et la génomique. Elle possède une solide expérience en bioinformatique, en oncologie et en génomique clinique. Elle est passionnée par l'utilisation de l'IA/ML et des services cloud pour améliorer les soins aux patients.

Boris Aronchik est responsable du laboratoire Amazon AI Machine Learning Solutions, où il dirige une équipe de scientifiques et d'ingénieurs ML pour aider les clients AWS à atteindre leurs objectifs commerciaux en tirant parti des solutions IA/ML.

Boris Aronchik est responsable du laboratoire Amazon AI Machine Learning Solutions, où il dirige une équipe de scientifiques et d'ingénieurs ML pour aider les clients AWS à atteindre leurs objectifs commerciaux en tirant parti des solutions IA/ML.

Miguel Romero Calvo est scientifique appliquée à la Laboratoire de solutions Amazon ML où il s'associe aux équipes internes d'AWS et aux clients stratégiques pour accélérer leur activité grâce à l'adoption du ML et du cloud.

Miguel Romero Calvo est scientifique appliquée à la Laboratoire de solutions Amazon ML où il s'associe aux équipes internes d'AWS et aux clients stratégiques pour accélérer leur activité grâce à l'adoption du ML et du cloud.

Lin Lee Cheong est scientifique senior et responsable au sein de l'équipe Amazon ML Solutions Lab chez Amazon Web Services. Elle travaille avec des clients AWS stratégiques pour explorer et appliquer l'intelligence artificielle et l'apprentissage automatique afin de découvrir de nouvelles idées et de résoudre des problèmes complexes.

Lin Lee Cheong est scientifique senior et responsable au sein de l'équipe Amazon ML Solutions Lab chez Amazon Web Services. Elle travaille avec des clients AWS stratégiques pour explorer et appliquer l'intelligence artificielle et l'apprentissage automatique afin de découvrir de nouvelles idées et de résoudre des problèmes complexes.

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- Laboratoire de solutions Amazon ML

- Amazon Sage Maker

- Vérité au sol Amazon SageMaker

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- Apprentissage automatique AWS

- Services professionnels AWS

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- syntaxe

- zéphyrnet