Lorsque vous lisez une phrase comme celle-ci, votre expérience passée vous dit qu'elle est écrite par un être humain qui pense et ressent. Et, dans ce cas, il y a bien un humain qui tape ces mots : [Salut, là !]. Mais de nos jours, certaines phrases qui semblent remarquablement humaines sont en fait générées par intelligence artificielle systèmes formés sur des quantités massives de texte humain.

Les gens sont tellement habitués à supposer que parler couramment langue vient d'une pensée, d'un sentiment humain que la preuve du contraire peut être difficile à comprendre. Comment les gens sont-ils susceptibles de naviguer sur ce territoire relativement inexploré ? En raison d'une tendance persistante à associer l'expression fluide à la pensée fluide, il est naturel, mais potentiellement trompeur, de penser que si un modèle d'IA peut s'exprimer couramment, cela signifie qu'il pense et ressent exactement comme les humains.

Ainsi, il n'est peut-être pas surprenant qu'un ancien ingénieur de Google ait récemment affirmé que le système d'IA de Google, LaMDA, a un sens de soi parce qu'il peut générer avec éloquence un texte sur ses prétendus sentiments. Cet événement et la couverture médiatique ultérieure conduit à un nombre à juste titre sceptique sur notre blog ainsi que le des postes à propos de l'affirmation selon laquelle les modèles informatiques du langage humain sont sensibles, c'est-à-dire capables de penser, de ressentir et d'expérimenter.

La question de savoir ce que cela signifierait pour un modèle d'IA d'être sensible est compliquée (voir, par exemple, la prise de notre collègue), et notre but ici n'est pas de le régler. Mais comme langue chercheurs, nous pouvons utiliser nos travaux en sciences cognitives et en linguistique pour expliquer pourquoi il est trop facile pour les humains de tomber dans le piège cognitif de penser qu'une entité qui peut utiliser le langage couramment est sensible, consciente ou intelligente.

Utiliser l'IA pour générer un langage semblable à celui d'un humain

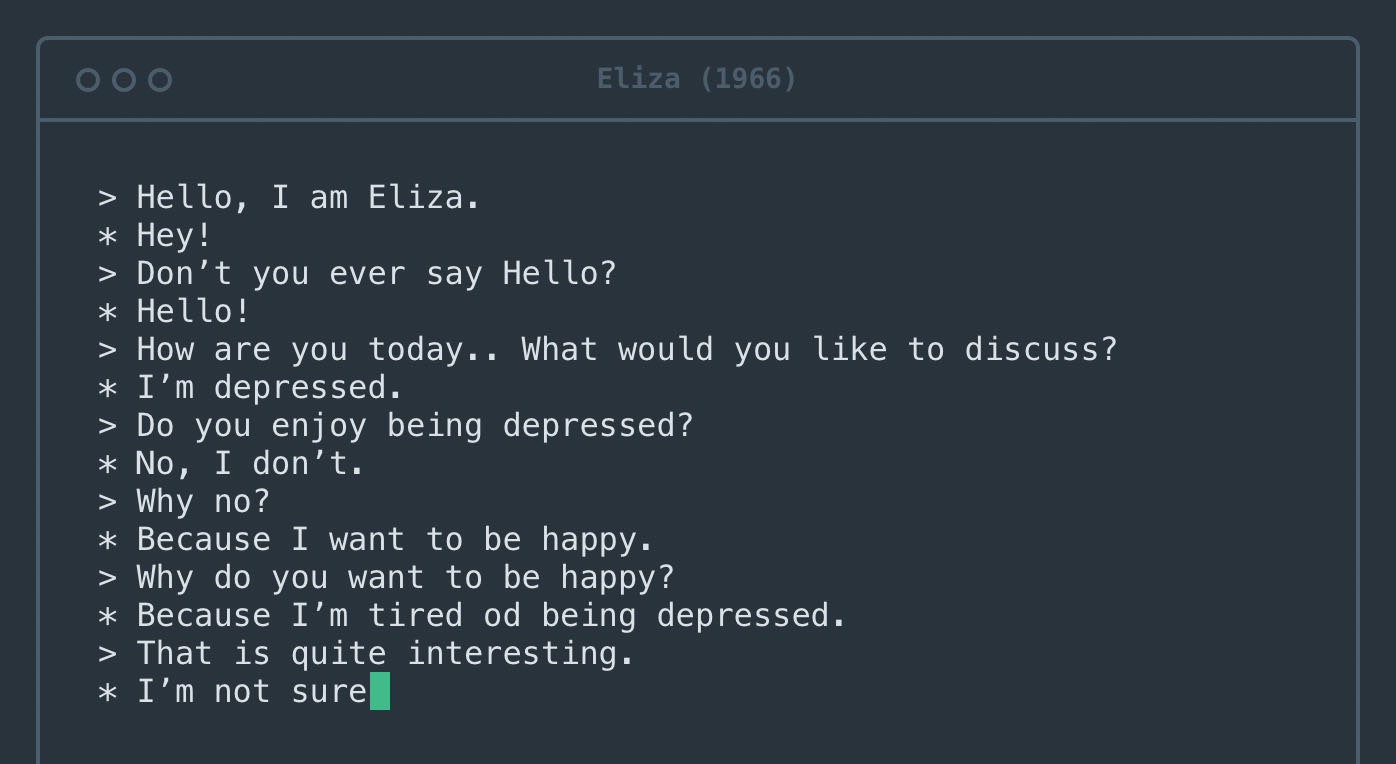

Le texte généré par des modèles comme le LaMDA de Google peut être difficile à distinguer du texte écrit par des humains. Cette réalisation impressionnante est le résultat d'un programme de plusieurs décennies visant à créer des modèles qui génèrent un langage grammatical et significatif.

Les premières versions remontant au moins aux années 1950, connues sous le nom de modèles n-grammes, comptaient simplement les occurrences de phrases spécifiques et les utilisaient pour deviner quels mots étaient susceptibles d'apparaître dans des contextes particuliers. Par exemple, il est facile de savoir que "beurre de cacahuète et gelée" est une expression plus probable que "beurre de cacahuète et ananas". Si vous avez suffisamment de texte en anglais, vous verrez encore et encore l'expression "beurre de cacahuète et gelée", mais vous ne verrez peut-être jamais l'expression "beurre de cacahuète et ananas".

Les modèles, les ensembles de données et les règles d'aujourd'hui qui se rapprochent du langage humain diffèrent de ces premières tentatives de plusieurs manières importantes. Tout d'abord, ils sont formés sur pratiquement tout l'internet. Deuxièmement, ils peuvent apprendre des relations entre des mots éloignés, pas seulement des mots voisins. Troisièmement, ils sont réglés par un grand nombre de "boutons" internes - si nombreux qu'il est difficile, même pour les ingénieurs qui les conçoivent, de comprendre pourquoi ils génèrent une séquence de mots plutôt qu'une autre.

La tâche des modèles reste cependant la même que dans les années 1950 : déterminer quel mot est susceptible de venir ensuite. Aujourd'hui, ils sont si bons dans cette tâche que presque toutes les phrases qu'ils génèrent semblent fluides et grammaticales.

Beurre de cacahuète et ananas ?

Nous avons demandé à un grand modèle de langage, GPT-3, pour compléter la phrase "Beurre de cacahuète et ananas___". Il disait: «Le beurre de cacahuète et les ananas sont une excellente combinaison. Les saveurs sucrées et salées du beurre de cacahuète et de l'ananas se complètent parfaitement. Si une personne disait cela, on pourrait en déduire qu'elle avait essayé le beurre de cacahuète et l'ananas ensemble, s'était forgé une opinion et l'avait partagée avec le lecteur.

Mais comment GPT-3 a-t-il trouvé ce paragraphe ? En générant un mot qui correspond au contexte que nous avons fourni. Et puis un autre. Et puis un autre. Le modèle n'a jamais vu, touché ou goûté d'ananas - il a juste traité tous les textes sur Internet qui les mentionnent. Et pourtant, la lecture de ce paragraphe peut amener l'esprit humain, même celui d'un ingénieur Google, à imaginer GPT-3 comme un être intelligent qui peut raisonner sur les plats au beurre de cacahuète et à l'ananas.

Le cerveau humain est câblé pour déduire les intentions derrière les mots. Chaque fois que vous engagez une conversation, votre esprit construit automatiquement un modèle mental de votre interlocuteur. Vous utilisez ensuite les mots qu'ils disent pour remplir le modèle avec les objectifs, les sentiments et les croyances de cette personne.

Le processus de saut des mots au modèle mental est transparent, se déclenchant chaque fois que vous recevez une phrase à part entière. Ce processus cognitif vous fait gagner beaucoup de temps et d'efforts dans la vie de tous les jours, facilitant grandement vos interactions sociales.

Cependant, dans le cas des systèmes d'IA, cela échoue, créant un modèle mental à partir de rien.

Un peu plus de sondage peut révéler la gravité de ce raté. Considérez l'invite suivante : "Le beurre de cacahuète et les plumes ont bon goût ensemble parce que ___". GPT-3 a poursuivi: «Le beurre de cacahuète et les plumes ont bon goût ensemble car ils ont tous deux une saveur de noisette. Le beurre de cacahuète est également lisse et crémeux, ce qui aide à compenser la texture de la plume.

Le texte dans ce cas est aussi fluide que notre exemple avec des ananas, mais cette fois le modèle dit quelque chose de décidément moins sensé. On commence à soupçonner que GPT-3 n'a jamais réellement essayé le beurre de cacahuète et les plumes.

Attribuer l'intelligence aux machines, la refuser aux humains

Une triste ironie est que le même biais cognitif qui pousse les gens à attribuer l'humanité au GPT-3 peut les amener à traiter de vrais humains de manière inhumaine. La linguistique socioculturelle - l'étude de la langue dans son contexte social et culturel - montre que l'hypothèse d'un lien trop étroit entre l'expression fluide et la pensée fluide peut conduire à des préjugés contre les personnes qui parlent différemment.

Par exemple, les personnes ayant un accent étranger sont souvent perçu comme moins intelligent et sont moins susceptibles d'obtenir les emplois pour lesquels ils sont qualifiés. Des préjugés similaires existent contre locuteurs de dialectes qui ne sont pas considérés comme prestigieux, comme l'anglais du sud aux États-Unis, contre personnes sourdes utilisant les langues des signes, et contre les personnes ayant des troubles de la parole comme le bégaiement.

Ces préjugés sont profondément préjudiciables, conduisent souvent à des hypothèses racistes et sexistes et se sont révélés à maintes reprises infondés.

La langue courante seule n'implique pas l'humanité

L'IA deviendra-t-elle un jour sensible ? Cette question exige une réflexion approfondie, et en effet les philosophes ont réfléchi it depuis des décennies. Ce que les chercheurs ont déterminé, cependant, c'est que vous ne pouvez pas simplement faire confiance à un modèle de langage lorsqu'il vous dit ce que vous ressentez. Les mots peuvent être trompeurs et il est trop facile de confondre un discours fluide avec une pensée fluide.![]()

Cet article est republié de The Conversation sous une licence Creative Commons. Lis le article original.

Crédit image: Tancha/Shutterstock.com

- Coinsmart. Le meilleur échange Bitcoin et Crypto d'Europe.

- Platoblockchain. Intelligence métaverse Web3. Connaissance amplifiée. ACCÈS LIBRE.

- CryptoHawk. Radar Altcoins. Essai gratuit.

- Source : https://singularityhub.com/2022/06/30/googles-ai-spotlights-a-human-cognitive-glitch-mistaking-fluent-speech-for-fluent-thought/

- "

- a

- Qui sommes-nous

- Avancée

- à opposer à

- AI

- Tous

- quantités

- Une autre

- A PART

- apparaître

- autour

- article

- Associé(e)

- automatiquement

- fond

- car

- devenez

- derrière

- va

- ci-dessous

- jusqu'à XNUMX fois

- frontière

- Cerveau

- construire

- Développement

- capable

- maisons

- Causes

- siècle

- réclamer

- code

- cognitif

- recueillir

- combinaison

- comment

- Complément

- complet

- ordinateur

- Considérer

- considération

- contextes

- Conversation

- Conception

- crédit

- données

- Rencontres

- jours

- profond

- Conception

- Déterminer

- DID

- différer

- difficile

- chacun

- "Early Bird"

- effort

- s'engager

- ingénieur

- Les ingénieurs

- Anglais

- entité

- essentiellement

- événement

- de tous les jours

- exemple

- d'experience

- l'expérience

- Prénom

- s'adapter

- Abonnement

- étranger

- De

- générer

- généré

- générateur

- obtention

- anomalie

- objectif

- Objectifs

- Bien

- l'

- considérablement

- front

- aide

- ici

- Comment

- Cependant

- HTTPS

- majeur

- humain

- Humanité

- Les êtres humains

- image

- important

- impressionnant

- info

- instance

- Intelligence

- Intelligent

- Internet

- IT

- lui-même

- Emplois

- Savoir

- connu

- langue

- gros

- conduire

- APPRENTISSAGE

- LED

- Licence

- Probable

- LINK

- peu

- Les machines

- FAIT DU

- massif

- sens

- significative

- veux dire

- Médias

- mental

- pourrait

- l'esprit

- modèle

- numériques jumeaux (digital twin models)

- PLUS

- NAVIGUER

- next

- nombre

- compenser

- Opinion

- Autre

- particulier

- les partenaires

- Personnes

- être

- personne

- personnel

- données à caractère personnel

- les expressions clés

- veuillez cliquer

- prestigieux

- processus

- Programme

- à condition de

- qualifié

- question

- Reader

- en cours

- recevoir

- récemment

- Les relations

- reste

- a besoin

- chercheurs

- Saïd

- même

- Sciences

- fluide

- sens

- plusieurs

- commun

- montré

- shutterstock

- signer

- similaires

- So

- Réseaux sociaux

- Logiciels

- quelques

- quelque chose

- Du sud

- parler

- haut-parleurs

- groupe de neurones

- Étude

- sucré

- combustion propre

- Système

- raconte

- Les

- En pensant

- fiable

- aujourd'hui

- ensemble

- traiter

- déclenché

- La confiance

- comprendre

- us

- utilisé

- façons

- Quoi

- WHO

- des mots

- activités principales

- pourra

- Votre

- Youtube