Dans un monde de plus en plus centré sur les données, les entreprises doivent se concentrer à la fois sur la collecte d'informations physiques précieuses et sur la génération des informations dont elles ont besoin mais qu'elles ne peuvent pas facilement capturer. L'accès aux données, la réglementation et la conformité sont une source croissante de friction pour l'innovation dans l'analyse et l'intelligence artificielle (IA).

Pour les secteurs hautement réglementés tels que les services financiers, la santé, les sciences de la vie, l'automobile, la robotique et la fabrication, le problème est encore plus important. Cela crée des obstacles à la conception du système, au partage de données (interne et externe), à la monétisation, à l'analyse et à l'apprentissage automatique (ML).

Les données synthétiques sont un outil qui répond à de nombreux défis liés aux données, en particulier les problèmes d'IA et d'analyse tels que la protection de la vie privée, la conformité réglementaire, l'accessibilité, la rareté des données et les biais. Cela inclut également le partage de données et le délai d'accès aux données (et donc le délai de mise sur le marché).

Les données synthétiques sont générées de manière algorithmique. Il reflète les propriétés et les modèles statistiques des données sources. Mais surtout, il ne contient aucun point de données sensible, privé ou personnel.

Vous posez des questions sur les données synthétiques et obtenez les mêmes réponses que vous obtiendriez des données réelles.

Dans notre précédent post, nous avons montré comment utiliser des réseaux contradictoires tels que les réseaux antagonistes génératifs (GANS) pour générer des ensembles de données tabulaires afin d'améliorer la formation au modèle de fraude au crédit.

Pour que les parties prenantes de l'entreprise adoptent des données synthétiques pour leurs projets de ML et d'analyse, il est impératif non seulement de s'assurer que les données synthétiques générées correspondent à l'objectif et aux applications en aval attendues, mais aussi qu'elles soient en mesure de mesurer et de démontrer la qualité de les données générées.

Avec des obligations légales et éthiques croissantes en matière de préservation de la vie privée, l'une des forces des données synthétiques est la capacité de supprimer les informations sensibles et originales lors de leur synthèse. Par conséquent, en plus de la qualité, nous avons besoin de mesures pour évaluer le risque de fuites d'informations privées, le cas échéant, et évaluer que le processus de génération ne "mémorise" ou ne copie aucune des données d'origine.

Pour réaliser tout cela, nous pouvons cartographier la qualité des données synthétiques en dimensions, ce qui aide les utilisateurs, les parties prenantes et nous-mêmes à mieux comprendre les données générées.

Les trois dimensions de l'évaluation de la qualité des données synthétiques

Les données synthétiques générées sont mesurées par rapport à trois dimensions clés :

- Fidelity

- utilitaire

- Confidentialité

Voici quelques-unes des questions sur les données synthétiques générées auxquelles un rapport sur la qualité des données synthétiques devrait répondre :

- Dans quelle mesure ces données synthétiques sont-elles similaires par rapport à l'ensemble de formation d'origine ?

- Quelle est l'utilité de ces données synthétiques pour nos applications en aval ?

- Des informations ont-elles été divulguées des données d'entraînement d'origine aux données synthétiques ?

- Des données considérées comme sensibles dans le monde réel (provenant d'autres ensembles de données non utilisées pour la formation du modèle) ont-elles été synthétisées par inadvertance par notre modèle ?

Les métriques qui traduisent chacune de ces dimensions pour les utilisateurs finaux sont quelque peu flexibles. Après tout, les données à générer peuvent varier en termes de distributions, de taille et de comportements. Ils doivent également être faciles à saisir et à interpréter.

En fin de compte, les métriques doivent être entièrement basées sur les données et ne nécessiter aucune connaissance préalable ou information spécifique au domaine. Toutefois, si l'utilisateur souhaite appliquer des règles et des contraintes spécifiques applicables à un domaine métier spécifique, il doit être en mesure de les définir au cours du processus de synthèse pour s'assurer que la fidélité spécifique au domaine est respectée.

Nous examinons chacune de ces mesures plus en détail dans les sections suivantes.

Métriques pour comprendre la fidélité

Dans tout projet de science des données, nous devons comprendre si un certain échantillon de population est pertinent pour le problème que nous résolvons. De même, pour le processus d'évaluation de la pertinence des données synthétiques générées, nous devons l'évaluer en termes de fidélité par rapport à l'original.

Les représentations visuelles de ces métriques les rendent plus faciles à comprendre. On pourrait illustrer si la cardinalité et le rapport des catégories ont été respectés, les corrélations entre les différentes variables ont été conservées, etc.

La visualisation des données permet non seulement d'évaluer la qualité des données synthétiques, mais s'inscrit également comme l'une des premières étapes du cycle de vie de la science des données pour une meilleure compréhension des données.

Plongeons plus en détail dans certaines mesures de fidélité.

Comparaisons statistiques exploratoires

Dans les comparaisons statistiques exploratoires, les caractéristiques des ensembles de données originaux et synthétiques sont explorées à l'aide de mesures statistiques clés, telles que la moyenne, la médiane, l'écart type, les valeurs distinctes, les valeurs manquantes, les minima, les maxima, les plages de quartiles pour les caractéristiques continues et le nombre d'enregistrements par catégorie, les valeurs manquantes par catégorie et les caractères les plus fréquents pour les attributs de catégorie.

Cette comparaison doit être effectuée entre l'ensemble de données d'origine et les données synthétiques. Cette évaluation révélerait si les ensembles de données comparés sont statistiquement similaires. Si ce n'est pas le cas, nous saurons quelles caractéristiques et mesures sont différentes. Vous devez envisager de recycler et de régénérer les données synthétiques avec des paramètres différents si une différence significative est constatée.

Ce test agit comme un dépistage initial pour s'assurer que les données synthétiques sont raisonnablement fidèles à l'ensemble de données d'origine et peuvent donc utilement subir des tests plus rigoureux.

Score de similarité d'histogramme

Le score de similarité de l'histogramme mesure les distributions marginales de chaque caractéristique des ensembles de données synthétiques et originaux.

Le score de similarité est borné entre zéro et un, un score de un indiquant que les distributions de données synthétiques chevauchent parfaitement les distributions des données d'origine.

Un score proche de un donnerait aux utilisateurs l'assurance que l'ensemble de données exclues et l'ensemble de données synthétiques sont statistiquement similaires.

Score d'information mutuelle

Le score d'information mutuelle mesure la dépendance mutuelle de deux caractéristiques, numérique ou catégorique, indiquant la quantité d'informations pouvant être obtenue à partir d'une caractéristique en observant une autre.

L'information mutuelle peut mesurer les relations non linéaires, fournissant une compréhension plus complète de la qualité des données synthétiques car elle nous permet de comprendre l'étendue de la préservation des relations de la variable.

Un score de un indique que la dépendance mutuelle entre les caractéristiques a été parfaitement capturée dans les données synthétiques.

Score de corrélation

Le score de corrélation mesure dans quelle mesure les corrélations dans l'ensemble de données d'origine ont été capturées dans les données synthétiques.

Les corrélations entre deux ou plusieurs colonnes sont extrêmement importantes pour les applications ML, qui aident à découvrir les relations entre les fonctionnalités et la variable cible et aident à créer un modèle bien entraîné.

Le score de corrélation est limité entre zéro et un, un score de un indiquant que les corrélations ont été parfaitement appariées.

Contrairement aux données tabulaires structurées, que nous rencontrons couramment dans les problèmes de données, certains types de données structurées ont un comportement particulier où les observations passées ont une probabilité d'influencer l'observation suivante. Celles-ci sont appelées séries chronologiques ou données séquentielles - par exemple, un ensemble de données avec des mesures horaires de la température ambiante.

Ce comportement signifie qu'il est nécessaire de définir certaines métriques qui peuvent mesurer spécifiquement la qualité de ces ensembles de données de séries chronologiques

Score d'autocorrélation et d'autocorrélation partielle

Bien que similaire à la corrélation, l'autocorrélation montre la relation d'une série chronologique à sa valeur actuelle par rapport à ses valeurs précédentes. La suppression des effets des décalages temporels précédents produit une autocorrélation partielle. Par conséquent, le score d'autocorrélation mesure dans quelle mesure les données synthétiques ont capturé les autocorrélations significatives, ou corrélations partielles, à partir de l'ensemble de données d'origine.

Métriques pour comprendre l'utilité

Maintenant, nous avons peut-être réalisé statistiquement que les données synthétiques sont similaires à l'ensemble de données d'origine. En outre, nous devons également évaluer dans quelle mesure l'ensemble de données synthétisé résout les problèmes courants de la science des données lorsqu'il est formé sur plusieurs algorithmes ML.

En utilisant ce qui suit utilitaire métriques, nous visons à renforcer la confiance que nous pouvons réellement atteindre des performances sur les applications en aval en ce qui concerne la performance des données d'origine.

Note de prédiction

La mesure des performances des données synthétiques par rapport aux données réelles d'origine peut être effectuée via des modèles ML. Le score du modèle en aval capture la qualité des données synthétiques en comparant les performances des modèles ML formés à la fois sur les ensembles de données synthétiques et originaux et validés sur les données de test retenues de l'ensemble de données d'origine. Cela fournit une Score de Train Synthetic Test Real (TSTR) et Entraînement réel Test réel (TRTR) score respectivement.

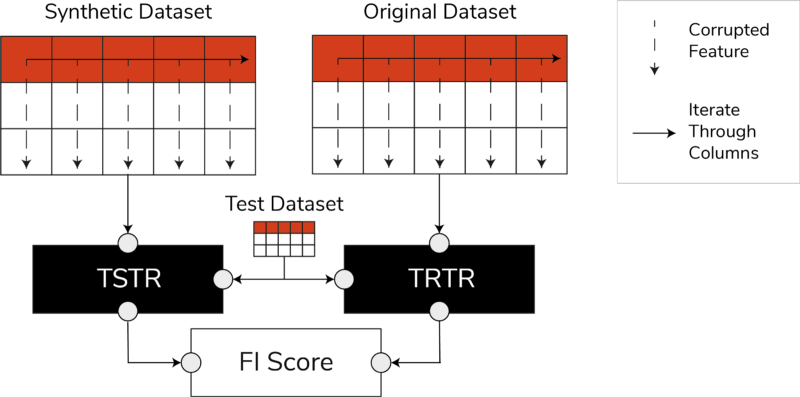

TSTR, scores TRTR et score d'importance des fonctionnalités (Image de l'auteur)

Le score intègre un large éventail des algorithmes ML les plus fiables pour les tâches de régression ou de classification. L'utilisation de plusieurs classificateurs et régresseurs garantit que le score est plus généralisable dans la plupart des algorithmes, de sorte que les données synthétiques puissent être considérées comme utiles à l'avenir.

En fin de compte, si le score TSTR et le score TRTR sont comparables, cela indique que les données synthétiques ont la qualité pour être utilisées pour former des modèles ML efficaces pour des applications du monde réel.

Score d'importance des fonctionnalités

Fortement lié au score de prédiction, le score d'importance des caractéristiques (FI) l'étend en ajoutant de l'interprétabilité aux scores TSTR et TRTR.

Le score F1 compare les changements et la stabilité de l'ordre d'importance de la fonctionnalité obtenus avec le score de prédiction. Un ensemble synthétique de données est considéré comme étant d'une grande utilité s'il produit le même ordre d'importance des caractéristiques que les données réelles d'origine.

QScore

Pour nous assurer qu'un modèle formé sur nos données nouvellement générées va produire les mêmes réponses aux mêmes questions qu'un modèle formé à l'aide des données d'origine, nous utilisons le Qscore. Cela mesure les performances en aval des données synthétiques en exécutant de nombreuses requêtes aléatoires basées sur l'agrégation sur les ensembles de données synthétiques et d'origine (et exclus).

L'idée ici est que ces deux requêtes doivent renvoyer des résultats similaires.

Un QScore élevé garantit que les applications en aval qui utilisent des opérations d'interrogation et d'agrégation peuvent fournir une valeur proche de celle de l'ensemble de données d'origine.

Métriques pour comprendre la confidentialité

Avec la confidentialité réglementations déjà en place, c'est une obligation éthique et une exigence légale de s'assurer que les informations sensibles sont protégées.

Avant que ces données synthétiques puissent être partagées librement et utilisées pour des applications en aval, nous devons tenir compte des mesures de confidentialité qui peuvent aider la partie prenante à comprendre où se situent les données synthétiques générées par rapport aux données d'origine en termes d'étendue des informations divulguées. De plus, nous devons prendre des décisions critiques concernant la manière dont les données synthétiques peuvent être partagées et utilisées.

Score de match exact

Une évaluation directe et intuitive de la confidentialité consiste à rechercher des copies des données réelles parmi les enregistrements synthétiques. Le score de correspondance exacte compte le nombre d'enregistrements réels pouvant être trouvés dans l'ensemble synthétique.

Le score doit être zéro, indiquant qu'aucune information réelle n'est présente telle quelle dans les données synthétiques. Cette métrique agit comme un mécanisme de filtrage avant que nous n'évaluions d'autres métriques de confidentialité.

Score de confidentialité des voisins

De plus, le score de confidentialité des voisins mesure le ratio d'enregistrements synthétiques qui pourraient être trop proches des vrais. Cela signifie que, bien qu'ils ne soient pas des copies directes, ils constituent des points potentiels de fuite de confidentialité et une source d'informations utiles pour les attaques par inférence.

Le score est calculé en effectuant une recherche des plus proches voisins de grande dimension sur les données synthétiques superposées aux données d'origine.

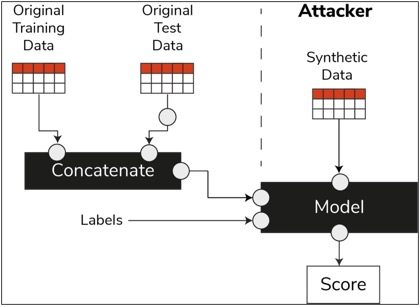

Score d'inférence d'appartenance

Dans le cycle de vie de la science des données, une fois qu'un modèle a été formé, il n'a plus besoin d'accéder aux échantillons de formation et peut faire des prédictions sur des données invisibles. De même, dans notre cas, une fois le modèle de synthétiseur formé, des échantillons de données synthétiques peuvent être générés sans avoir besoin des données d'origine.

Grâce à un type d'attaque appelé "attaque par inférence d'appartenance", les attaquants peuvent tenter de révéler les données qui ont été utilisées pour créer les données synthétiques, sans avoir accès aux données d'origine. Il en résulte une atteinte à la vie privée.

Le score d'inférence d'appartenance mesure la probabilité qu'une attaque d'inférence d'appartenance réussisse.

Un score faible suggère la possibilité de déduire qu'un enregistrement particulier faisait partie de l'ensemble de données d'apprentissage qui a conduit à la création des données synthétiques. En d'autres termes, les attaques peuvent déduire les détails d'un enregistrement individuel, compromettant ainsi la confidentialité.

Un score d'inférence d'appartenance élevé indique qu'il est peu probable qu'un attaquant détermine si un enregistrement particulier faisait partie de l'ensemble de données d'origine utilisé pour créer les données synthétiques. Cela signifie également qu'aucune information individuelle n'a été compromise par les données synthétiques.

Le concept de retenue

Une bonne pratique importante que nous devons suivre consiste à nous assurer que les données synthétiques sont suffisamment générales et ne dépassent pas les données d'origine sur lesquelles elles ont été formées. Dans un flux de science des données typique, lors de la construction de modèles ML tels qu'un classificateur de forêt aléatoire, nous mettons de côté les données de test, formons les modèles à l'aide des données de formation et évaluons les métriques sur des données de test invisibles.

De même, pour les données synthétiques, nous gardons de côté un échantillon des données originales - généralement appelées ensemble de données retenues ou données de test retenues invisibles - et évaluons les données synthétiques générées par rapport à l'ensemble de données retenues.

On s'attend à ce que l'ensemble de données retenu soit une représentation des données d'origine, mais qu'il ne soit pas visible lorsque les données synthétiques ont été générées. Par conséquent, il est essentiel d'avoir des scores similaires pour toutes les métriques lors de la comparaison de l'original à l'exclusion et aux ensembles de données synthétiques.

Lorsque des scores similaires sont obtenus, nous pouvons établir que les points de données synthétiques ne sont pas le résultat de la mémorisation des points de données d'origine, tout en conservant la même fidélité et utilité.

Réflexions finales

Le monde commence à comprendre l'importance stratégique des données synthétiques. En tant que data scientists et générateurs de données, il est de notre devoir d'instaurer la confiance dans les données synthétiques que nous générons et de nous assurer qu'elles ont un but.

Les données synthétiques deviennent incontournables dans la boîte à outils de développement de la science des données. MIT Technology Review a noté les données synthétiques comme l'une des technologies révolutionnaires de 2022. Nous ne pouvons pas imaginer construire des modèles d'IA d'excellente valeur sans données synthétiques, prétend Gartner.

Selon McKinsey, les données synthétiques minimisent les coûts et les obstacles que vous auriez autrement rencontrés lors du développement d'algorithmes ou de l'accès aux données.

La génération de données synthétiques consiste à connaître les applications en aval et à comprendre les compromis entre les différentes dimensions pour la qualité des données synthétiques.

Résumé

En tant qu'utilisateur des données synthétiques, il est essentiel de définir le contexte du cas d'utilisation pour lequel chaque échantillon de synthétique sera utilisé à l'avenir. Tout comme pour les données réelles, la qualité des données synthétiques dépend du cas d'utilisation visé, ainsi que des paramètres choisis pour la synthèse.

Par exemple, conserver les valeurs aberrantes dans les données synthétiques comme dans les données d'origine est utile pour un cas d'utilisation de détection de fraude. Cependant, cela n'est pas utile dans un cas d'utilisation de soins de santé avec des problèmes de confidentialité, car les valeurs aberrantes peuvent généralement être une fuite d'informations.

De plus, un compromis existe entre fidélité, utilité et confidentialité. Les données ne peuvent pas être optimisées pour les trois simultanément. Ces métriques permettent aux parties prenantes de hiérarchiser ce qui est essentiel pour chaque cas d'utilisation et de gérer les attentes à partir des données synthétiques générées.

En fin de compte, lorsque nous voyons les valeurs de chaque métrique et lorsqu'elles répondent aux attentes, les parties prenantes peuvent avoir confiance dans les solutions qu'elles construisent à l'aide des données synthétiques.

Les cas d'utilisation des données synthétiques structurées couvrent une large gamme d'applications allant des données de test pour le développement de logiciels à la création de bras de contrôle synthétiques dans les essais cliniques.

Contactez-nous pour explorer ces opportunités ou créez un PoC pour démontrer la valeur.

Faris Haddad est le responsable des données et des informations au sein de l'équipe des poursuites stratégiques de l'AABG. Il aide les entreprises à devenir data-driven avec succès.

Faris Haddad est le responsable des données et des informations au sein de l'équipe des poursuites stratégiques de l'AABG. Il aide les entreprises à devenir data-driven avec succès.

- Avancé (300)

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- Apprentissage automatique d'Amazon

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- Apprentissage automatique AWS

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- syntaxe

- Mode d'emploi technique

- zéphyrnet