QuOne Lab, Phanous Research & Innovation Center, Téhéran, Iran

Vous trouvez cet article intéressant ou souhaitez en discuter? Scite ou laisse un commentaire sur SciRate.

Abstract

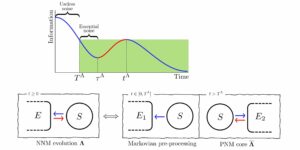

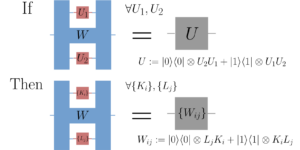

Lors de l'apprentissage de fonctions de modèle sur-paramétrées via la descente de gradient, il arrive que les paramètres ne changent pas de manière significative et restent proches de leurs valeurs initiales. Ce phénomène est appelé $textit{lazy training}$ et motive l'examen de l'approximation linéaire de la fonction du modèle autour des paramètres initiaux. En régime paresseux, cette approximation linéaire imite le comportement de la fonction paramétrée dont le noyau associé, appelé $textit{noyau tangent}$, spécifie les performances d'apprentissage du modèle. L'apprentissage paresseux est connu pour se produire dans le cas de réseaux de neurones (classiques) de grande largeur. Dans cet article, nous montrons que l'entraînement de circuits quantiques paramétrés $textit{géométriquement locaux}$ entre dans le régime paresseux pour un grand nombre de qubits. Plus précisément, nous prouvons des bornes sur le taux de changement des paramètres d'un tel circuit quantique paramétré géométriquement local dans le processus d'apprentissage, et sur la précision de l'approximation linéaire de la fonction de modèle quantique associée ; ces deux bornes tendent vers zéro à mesure que le nombre de qubits augmente. Nous étayons nos résultats analytiques par des simulations numériques.

► Données BibTeX

► Références

John Preskill. L'informatique quantique à l'ère NISQ et au-delà. Quantum, 2:79, 2018. doi:10.22331/q-2018-08-06-79.

https://doi.org/10.22331/q-2018-08-06-79

Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. Algorithmes quantiques variationnels. Nature Reviews Physics, 3(9):625–644, 2021. doi:10.1038/s42254-021-00348-9.

https://doi.org/10.1038/s42254-021-00348-9

Jarrod R McClean, Sergio Boixo, Vadim N Smelyanskiy, Ryan Babbush et Hartmut Neven. Plateaux stériles dans les paysages d'entraînement des réseaux de neurones quantiques. Nature communications, 9(1):1–6, 2018. doi:10.1038/s41467-018-07090-4.

https://doi.org/10.1038/s41467-018-07090-4

Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Lukasz Cincio et Patrick J Coles. Plateaux stériles induits par le bruit dans les algorithmes quantiques variationnels. Nature communications, 12(1):1–11, 2021. doi:10.1038/s41467-021-27045-6.

https://doi.org/10.1038/s41467-021-27045-6

François Bach. Optimisation sans effort grâce aux flux de gradient. https://francisbach.com/gradient-flows.

https:///francisbach.com/gradient-flows

Arthur Jacot, Franck Gabriel et Clément Hongler. Noyau tangent neuronal : Convergence et généralisation dans les réseaux de neurones. Avancées dans les systèmes de traitement de l'information neuronale (NeurIPS 2018), 31:8571–8580, 2018. doi:10.1145/3406325.3465355.

https: / / doi.org/ 10.1145 / 3406325.3465355

Lenaic Chizat, Edouard Oyallon et Francis Bach. Sur la formation paresseuse en programmation différentiable. Avancées dans les systèmes de traitement de l'information neuronale, 32, 2019.

Kouhei Nakaji, Hiroyuki Tezuka et Naoki Yamamoto. Réseaux de neurones améliorés quantiques dans le cadre du noyau tangent neuronal. 2021. arXiv:2109.03786.

arXiv: 2109.03786

Norihito Shirai, Kenji Kubo, Kosuke Mitarai et Keisuke Fujii. Noyau tangent quantique. 2021. arXiv :2111.02951.

arXiv: 2111.02951

Maria Schuld et Nathan Killoran. Apprentissage automatique quantique dans les espaces de fonctionnalité hilbert. Phys. Rev. Lett., 122:040504, février 2019. doi:10.1103/PhysRevLett.122.040504.

https: / / doi.org/ 10.1103 / PhysRevLett.122.040504

Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow et Jay M. Gambetta. Apprentissage supervisé avec des espaces de fonctionnalités améliorés quantiques. Nature, 567(7747):209–212, mars 2019. doi:10.1038/s41586-019-0980-2.

https://doi.org/10.1038/s41586-019-0980-2

Junyu Liu, Francesco Tacchino, Jennifer R. Glick, Liang Jiang et Antonio Mezzacapo. Apprentissage de représentation via des noyaux tangents neuronaux quantiques. PRX Quantum, 3:030323, 2022. doi:10.1103/PRXQuantum.3.030323.

https: / / doi.org/ 10.1103 / PRXQuantum.3.030323

Di Luo et James Halverson. États quantiques de réseaux de neurones infinis. 2021. arXiv :2112.00723.

arXiv: 2112.00723

Junyu Liu, Khadijeh Najafi, Kunal Sharma, Francesco Tacchino, Liang Jiang et Antonio Mezzacapo. Une théorie analytique de la dynamique des réseaux de neurones quantiques étendus. Phys. Rev. Lett., 130(15):150601, 2023. doi:10.1103/PhysRevLett.130.150601.

https: / / doi.org/ 10.1103 / PhysRevLett.130.150601

Junyu Liu, Zexi Lin et Liang Jiang. Paresse, plateau stérile et bruit dans l'apprentissage automatique, 2022. doi:10.48550/arXiv.2206.09313.

https:///doi.org/10.48550/arXiv.2206.09313

Edward Farhi et Hartmut Neven. Classification avec des réseaux de neurones quantiques sur des processeurs à court terme. 2018. arXiv :1802.06002.

arXiv: 1802.06002

M. Cerezo, Akira Sone, Tyler Volkoff, Lukasz Cincio et Patrick J. Coles. Plateaux stériles dépendant de la fonction de coût dans des circuits quantiques paramétrés peu profonds. Nature Communications, 12(1):1791, 2021. doi:10.1038/s41467-021-21728-w.

https: / / doi.org/ 10.1038 / s41467-021-21728-w

Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster et José I. Latorre. Re-téléchargement de données pour un classificateur quantique universel. Quantum, 4:226, 2020. doi:10.22331/q-2020-02-06-226.

https://doi.org/10.22331/q-2020-02-06-226

Maria Schuld, Ryan Sweke et Johannes Jakob Meyer. Effet de l'encodage des données sur le pouvoir expressif des modèles variationnels d'apprentissage automatique quantique. Phys. Rev. A, 103:032430, mars 2021. doi:10.1103/PhysRevA.103.032430.

https: / / doi.org/ 10.1103 / PhysRevA.103.032430

Colin Mc Diarmid. Sur la méthode des différences bornées. Dans Surveys in combinatorics, 1989 (Norwich, 1989), volume 141 de London Math. Soc. Lecture Note Ser., pages 148–188. Université de Cambridge. Press, Cambridge, 1989. doi:10.1017/cbo9781107359949.008.

https: / / doi.org/ 10.1017 / cbo9781107359949.008

Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri, et al. Pennylane : Différenciation automatique de calculs hybrides quantiques-classiques. 2018. arXiv:1811.04968.

arXiv: 1811.04968

Kerstin Beer, Dmytro Bondarenko, Terry Farrelly, Tobias J Osborne, Robert Salzmann, Daniel Scheiermann et Ramona Wolf. Formation de réseaux de neurones quantiques profonds. Nature communications, 11(1):1–6, 2020. doi:10.1038/s41467-020-14454-2.

https://doi.org/10.1038/s41467-020-14454-2

Cité par

[1] Junyu Liu, Zexi Lin et Liang Jiang, "La paresse, le plateau stérile et le bruit dans l'apprentissage automatique", arXiv: 2206.09313, (2022).

[2] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You et Dacheng Tao, "Erratum : Capacité d'apprentissage des réseaux de neurones quantiques [PRX QUANTUM 2, 040337 (2021)]", PRX Quantique 3 3, 030901 (2022).

Les citations ci-dessus proviennent de SAO / NASA ADS (dernière mise à jour réussie 2023-04-27 12:25:17). La liste peut être incomplète car tous les éditeurs ne fournissent pas de données de citation appropriées et complètes.

Impossible de récupérer Données de référence croisée lors de la dernière tentative 2023-04-27 12:25:15: Impossible de récupérer les données citées par 10.22331 / q-2023-04-27-989 de Crossref. C'est normal si le DOI a été enregistré récemment.

Cet article est publié dans Quantum sous le Creative Commons Attribution 4.0 International (CC BY 4.0) Licence. Le droit d'auteur reste la propriété des détenteurs d'origine tels que les auteurs ou leurs institutions.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- PlatoAiStream. Intelligence des données Web3. Connaissance Amplifiée. Accéder ici.

- Frapper l'avenir avec Adryenn Ashley. Accéder ici.

- La source: https://quantum-journal.org/papers/q-2023-04-27-989/

- :est

- :ne pas

- 1

- 10

- 11

- 12

- 13

- 14

- 20

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 7

- 8

- 9

- a

- au dessus de

- RÉSUMÉ

- accès

- avances

- affiliations

- AL

- algorithmes

- Tous

- an

- Analytique

- et de

- Andrew

- avr

- SONT

- autour

- Arthur

- AS

- associé

- auteur

- auteurs

- Automatique

- BE

- Bière

- Benjamin

- Au-delà

- tous les deux

- Pause

- by

- appelé

- cambridge

- maisons

- centre

- Change

- Modifications

- classification

- Fermer

- commentaire

- Chambre des communes

- Communications

- complet

- calculs

- informatique

- considération

- Convergence

- droit d'auteur

- Prix

- pourriez

- Daniel

- données

- profond

- dépendant

- différences

- Différenciation

- discuter

- do

- pendant

- dynamique

- E & T

- Edward

- effet

- Entre dans

- Ère

- expressif

- Fonctionnalité

- Février

- Flux

- Pour

- Framework

- Francis

- De

- fonction

- fonctions

- Pousse

- harvard

- titulaires

- HTTPS

- Hybride

- hybride quantique-classique

- i

- if

- in

- Infini

- d'information

- initiale

- Innovation

- les établissements privés

- intéressant

- International

- JavaScript

- Jennifer

- John

- Journal

- connu

- laboratoire

- gros

- Nom

- apprentissage

- Laisser

- Cours magistral

- Licence

- Liste

- locales

- London

- click

- machine learning

- Marco

- math

- Mai..

- méthode

- Meyer

- modèle

- numériques jumeaux (digital twin models)

- Mois

- PLUS

- Nature

- Près

- réseau et

- réseaux

- Réseau neuronal

- les réseaux de neurones

- Bruit

- Ordinaire

- nombre

- numéros

- of

- on

- ouvert

- à mettre en œuvre pour gérer une entreprise rentable. Ce guide est basé sur trois décennies d'expérience

- or

- original

- nos

- Papier

- paramètres

- performant

- phénomène

- Physique

- Platon

- Intelligence des données Platon

- PlatonDonnées

- power

- précisément

- La précision

- Press

- processus

- traitement

- processeurs

- Programmation

- Prouver

- fournir

- publié

- éditeur

- éditeurs

- Quantum

- algorithmes quantiques

- l'informatique quantique

- apprentissage automatique quantique

- qubits

- Tarif

- récemment

- régime

- inscrit

- rester

- reste

- représentation

- un article

- Résultats

- Avis

- ROBERT

- Ryan

- peu profond

- Sharma

- montrer

- de façon significative

- Simon

- espaces

- États

- Avec succès

- tel

- convient

- Support

- Système

- Téhéran

- tezuka

- qui

- La

- leur

- Ces

- this

- Avec

- Titre

- à

- Formation

- sous

- Universel

- a actualisé

- URL

- Valeurs

- via

- le volume

- W

- souhaitez

- était

- we

- large

- comprenant

- Loup

- an

- Vous n'avez

- Yuan

- zéphyrnet

- zéro