Amazon SageMaker Gestionnaire de données est un outil de préparation de données basé sur l'interface utilisateur qui permet d'effectuer l'analyse, le prétraitement et la visualisation des données avec des fonctionnalités permettant de nettoyer, transformer et préparer les données plus rapidement. Les modèles de flux prédéfinis Data Wrangler aident à accélérer la préparation des données pour les scientifiques des données et les praticiens de l'apprentissage automatique (ML) en vous aidant à accélérer et à comprendre les modèles de bonnes pratiques pour les flux de données à l'aide d'ensembles de données courants.

Vous pouvez utiliser les flux Data Wrangler pour effectuer les tâches suivantes :

- Visualisation de données – Examiner les propriétés statistiques de chaque colonne de l'ensemble de données, créer des histogrammes, étudier les valeurs aberrantes

- Nettoyage des données – Suppression des doublons, suppression ou remplissage des entrées avec des valeurs manquantes, suppression des valeurs aberrantes

- Enrichissement des données et ingénierie des fonctionnalités – Traitement des colonnes pour créer des fonctionnalités plus expressives, sélection d'un sous-ensemble de fonctionnalités pour la formation

Cet article vous aidera à comprendre Data Wrangler à l'aide des exemples de flux prédéfinis suivants sur GitHub. Le référentiel présente la transformation de données tabulaires, les transformations de données de séries chronologiques et les transformations d'ensembles de données joints. Chacun nécessite un type de transformation différent en raison de sa nature fondamentale. Les données tabulaires ou transversales standard sont collectées à un moment précis. En revanche, les données de séries chronologiques sont capturées de manière répétée au fil du temps, chaque point de données successif dépendant de ses valeurs passées.

Examinons un exemple de la façon dont nous pouvons utiliser l'exemple de flux de données pour les données tabulaires.

Pré-requis

Data Wrangler est un Amazon Sage Maker fonctionnalité disponible dans Amazon SageMakerStudio, nous devons donc suivre le processus d'intégration de Studio pour faire fonctionner l'environnement et les blocs-notes Studio. Bien que vous puissiez choisir parmi plusieurs méthodes d'authentification, le moyen le plus simple de créer un domaine Studio consiste à suivre les Démarrage rapide instructions. Le démarrage rapide utilise les mêmes paramètres par défaut que le configuration Studio standard. Vous pouvez également choisir d'embarquer en utilisant Centre d'identité AWS IAM (successeur d'AWS Single Sign-On) pour l'authentification (voir Intégration au domaine Amazon SageMaker à l'aide d'IAM Identity Center).

Importez l'ensemble de données et les fichiers de flux dans Data Wrangler à l'aide de Studio

Les étapes suivantes expliquent comment importer des données dans SageMaker pour les utiliser par Data Wrangler :

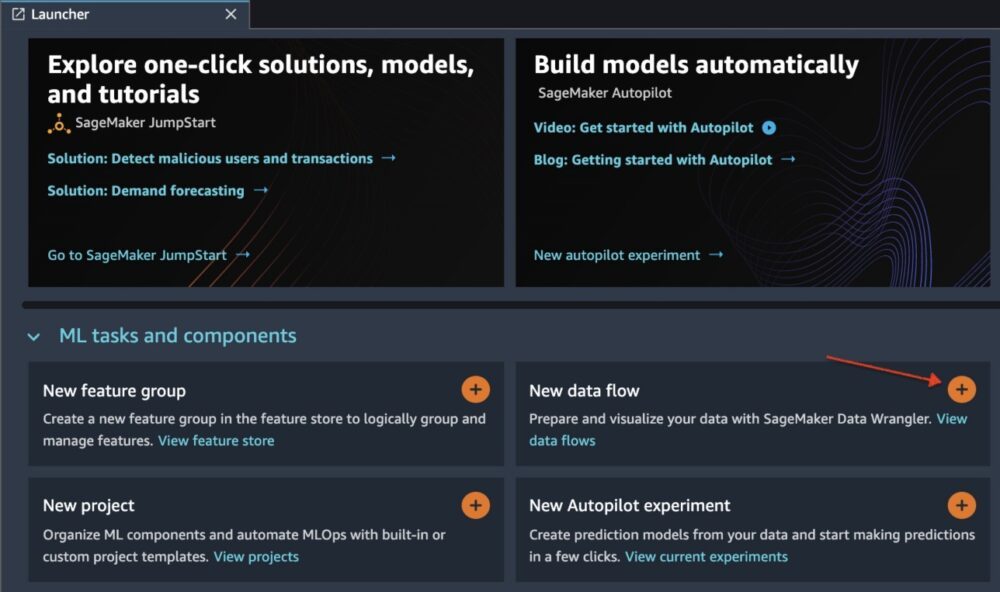

Initialisez Data Wrangler via l'interface utilisateur de Studio en choisissant Nouveau flux de données.

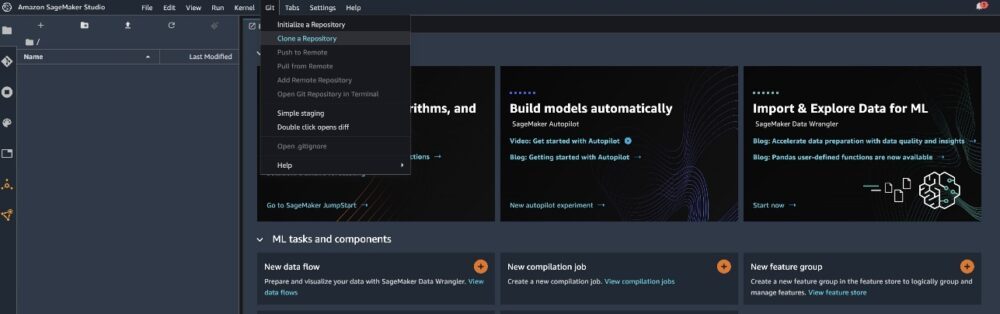

Cloner le GitHub repo pour télécharger les fichiers de flux dans votre environnement Studio.

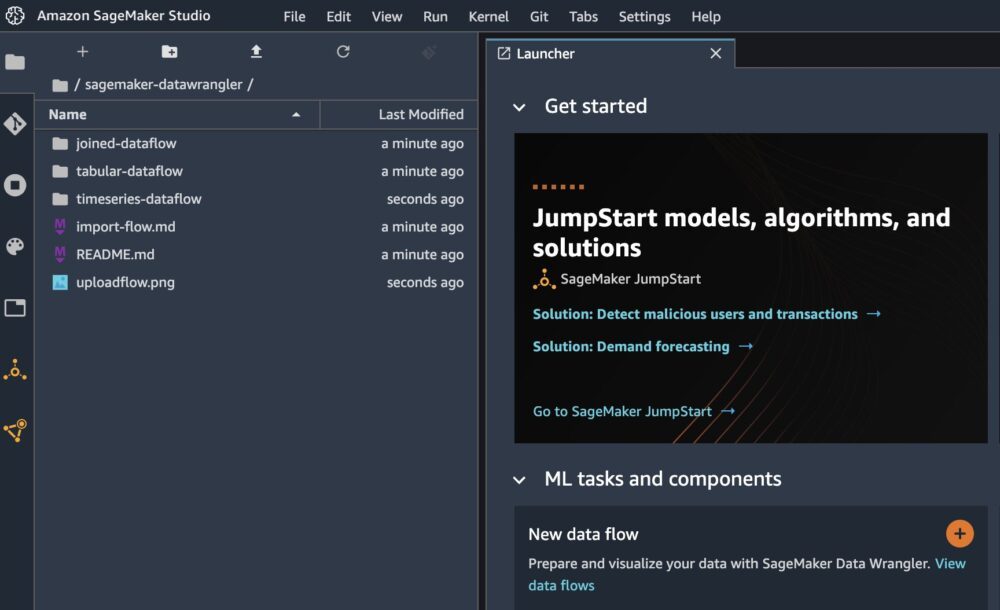

Une fois le clonage terminé, vous devriez pouvoir voir le contenu du référentiel dans le volet de gauche.

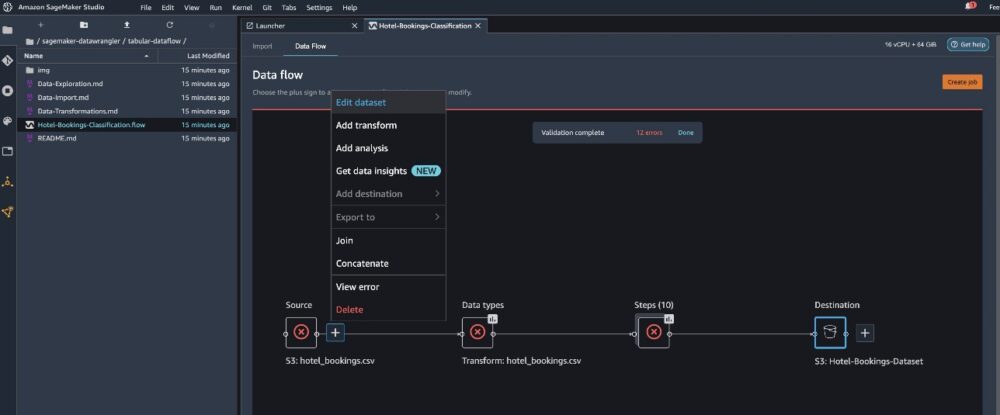

Choisissez le fichier Hôtel-Réservations-Classification.flow pour importer le fichier de flux dans Data Wrangler.

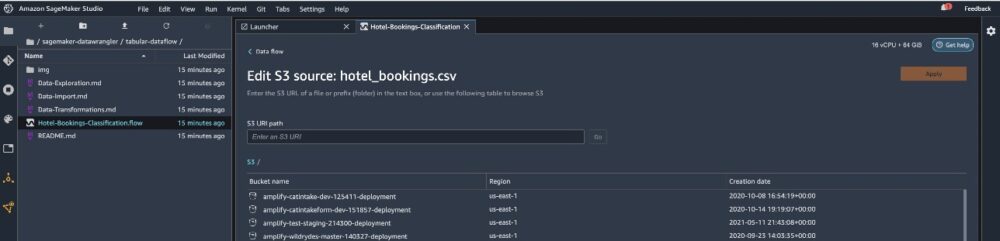

Si vous utilisez la série chronologique ou le flux de données joint, le flux apparaîtra sous un nom différent. Une fois le flux importé, vous devriez voir la capture d'écran suivante. Cela nous montre des erreurs car nous devons nous assurer que le fichier de flux pointe vers la bonne source de données dans Service de stockage simple Amazon (Amazon S3).

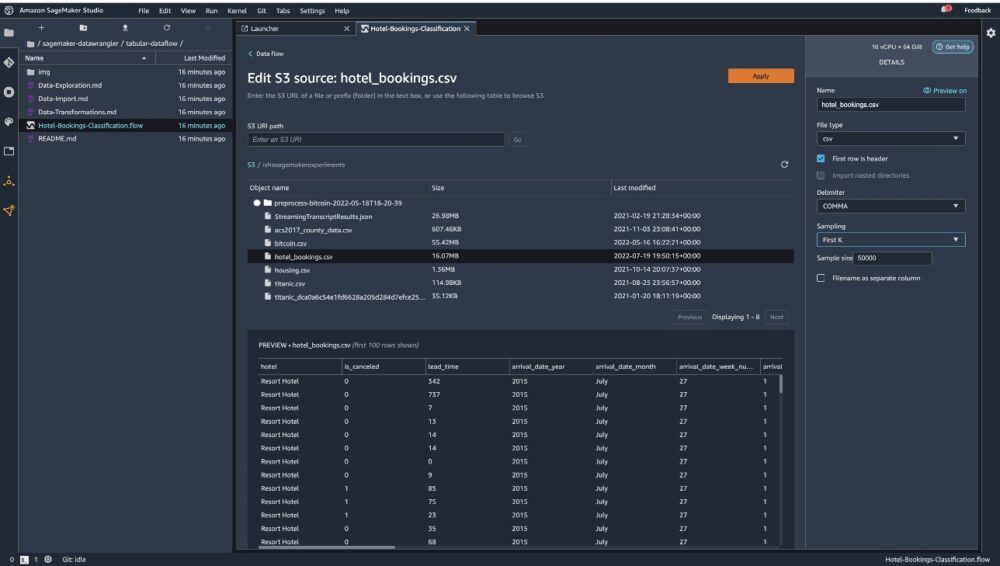

Selectionnez Modifier l'ensemble de données pour afficher tous vos compartiments S3. Ensuite, choisissez l'ensemble de données hotel_bookings.csv depuis votre compartiment S3 pour parcourir le flux de données tabulaires.

Notez que si vous utilisez le flux de données rejoint, vous devrez peut-être importer plusieurs ensembles de données dans Data Wrangler

Dans le volet de droite, assurez-vous PARAGRAPHE est choisi comme délimiteur et Échantillonnage est fixé à Premier K. Notre ensemble de données est suffisamment petit pour exécuter des transformations Data Wrangler sur l'ensemble de données, mais nous voulions souligner comment vous pouvez importer l'ensemble de données. Si vous disposez d’un grand ensemble de données, envisagez d’utiliser l’échantillonnage. Choisir L’ pour importer cet ensemble de données dans Data Wrangler.

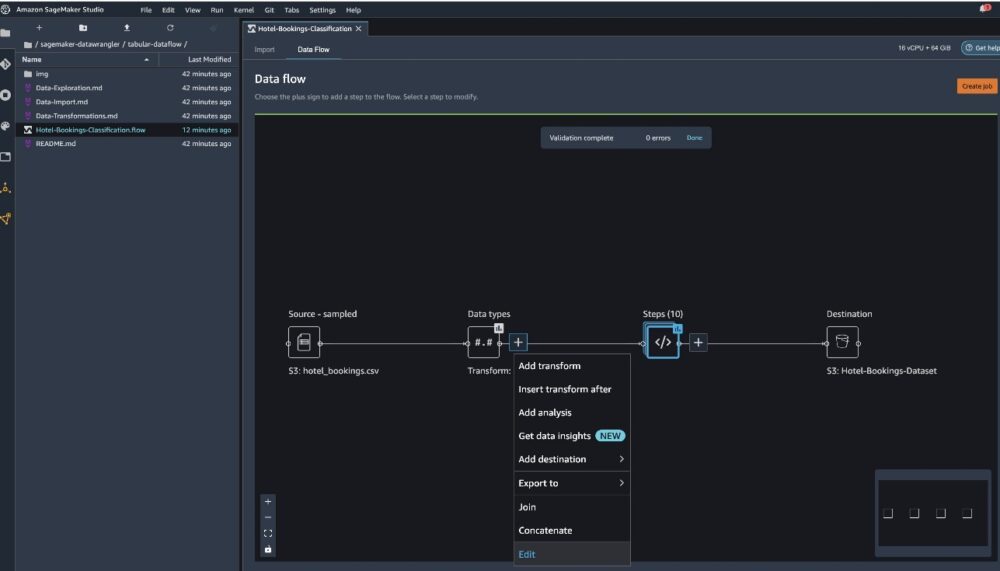

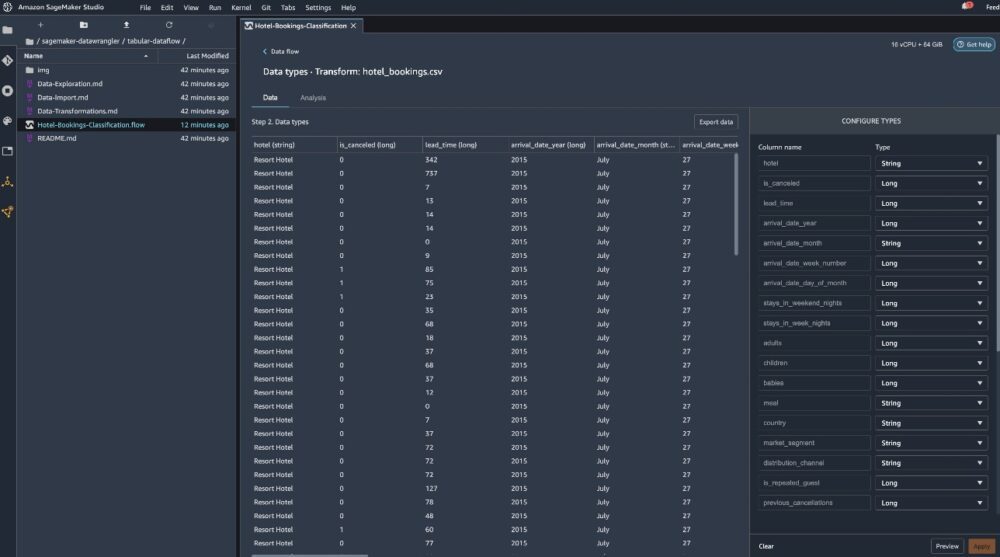

Une fois l'ensemble de données importé, Data Wrangler valide automatiquement l'ensemble de données et détecte les types de données. Vous pouvez voir que les erreurs ont disparu car nous pointons vers le bon ensemble de données. L'éditeur de flux affiche désormais deux blocs montrant que les données ont été importées à partir d'une source et que les types de données sont reconnus. Vous pouvez également modifier les types de données si nécessaire.

La capture d'écran suivante montre nos types de données.

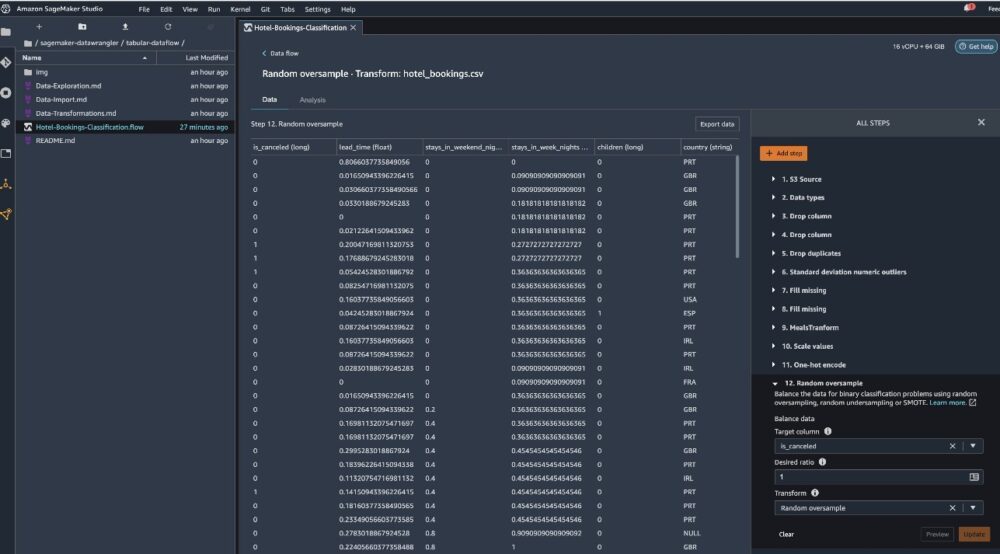

Examinons certaines des transformations effectuées dans le cadre de ce flux tabulaire. Si vous utilisez le des séries chronologiques or rejoint flux de données, découvrez quelques transformations courantes sur le GitHub repo. Nous avons effectué une analyse exploratoire de base des données à l'aide de rapports d'analyse des données qui ont étudié la fuite cible et la colinéarité des caractéristiques dans l'ensemble de données, des analyses récapitulatives de tableaux et une capacité de modélisation rapide. Découvrez les étapes sur le GitHub repo.

Nous supprimons désormais les colonnes en fonction des recommandations fournies par le rapport Data Insights and Quality.

- Pour une fuite cible, déposez statut_réservation.

- Pour les colonnes redondantes, supprimez day_in_waiting_list, hôtel, réservé_room_type, Arrival_date_month, booking_status_date, bébés, ainsi que arrivée_date_jour_du_mois.

- Sur la base des résultats de corrélation linéaire, supprimez les colonnes date_d'arrivée_numéro_semaine ainsi que date_d'arrivée_année car les valeurs de corrélation pour ces paires de caractéristiques (colonnes) sont supérieures au seuil recommandé de 0.90.

- Sur la base des résultats de corrélation non linéaire, supprimez statut_réservation. Cette colonne était déjà marquée pour être supprimée en fonction de l'analyse des fuites cibles.

- Traiter les valeurs numériques (mise à l'échelle min-max) pour lead_time, stays_in_weekend_nights, stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, ainsi que requis_car_parking_spaces.

- Variables catégorielles d'encodage à chaud telles que repas, is_repeated_guest, market_segment, assigné_room_type, deposit_type, ainsi que Type de client.

- Équilibrez la variable cible Suréchantillonnage aléatoire pour le déséquilibre des classes. Utilisez la capacité de modélisation rapide pour gérer les valeurs aberrantes et manquantes.

Exporter vers Amazon S3

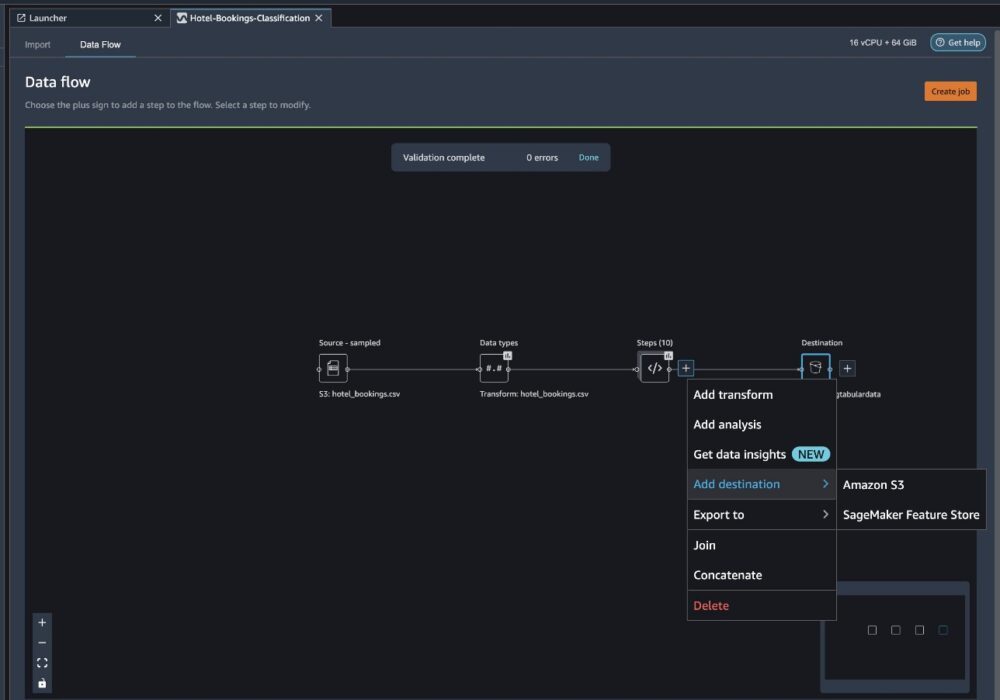

Nous avons maintenant effectué les différentes transformations et sommes prêts à exporter les données vers Amazon S3. Cette option crée une tâche de traitement SageMaker, qui exécute le flux de traitement Data Wrangler et enregistre l'ensemble de données résultant dans un compartiment S3 spécifié. Suivez les étapes suivantes pour configurer l'exportation vers Amazon S3 :

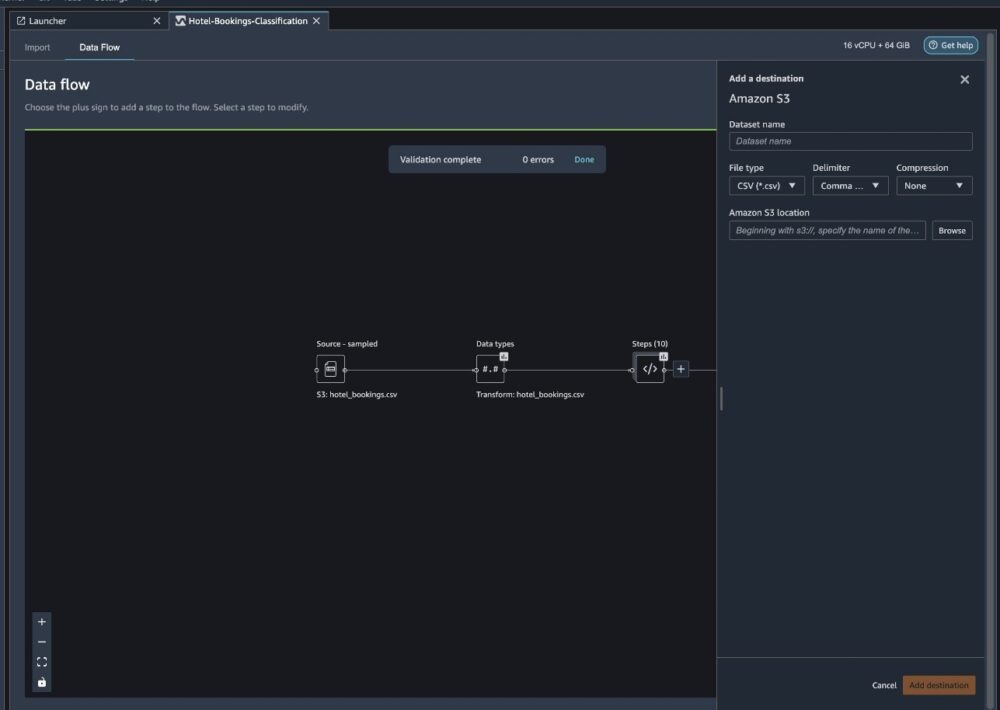

Choisissez le signe plus à côté d'un ensemble d'éléments de transformation et choisissez Ajouter destination, puis Amazon S3.

- Pour Nom du jeu de données, saisissez un nom pour le nouvel ensemble de données, par exemple

NYC_export. - Pour Type de fichier, choisissez CSV.

- Pour Délimiteur, choisissez Virgule.

- Pour Compression, choisissez Aucun.

- Pour Emplacement Amazon S3, utilisez le même nom de compartiment que celui que nous avons créé précédemment.

- Selectionnez Ajouter destination.

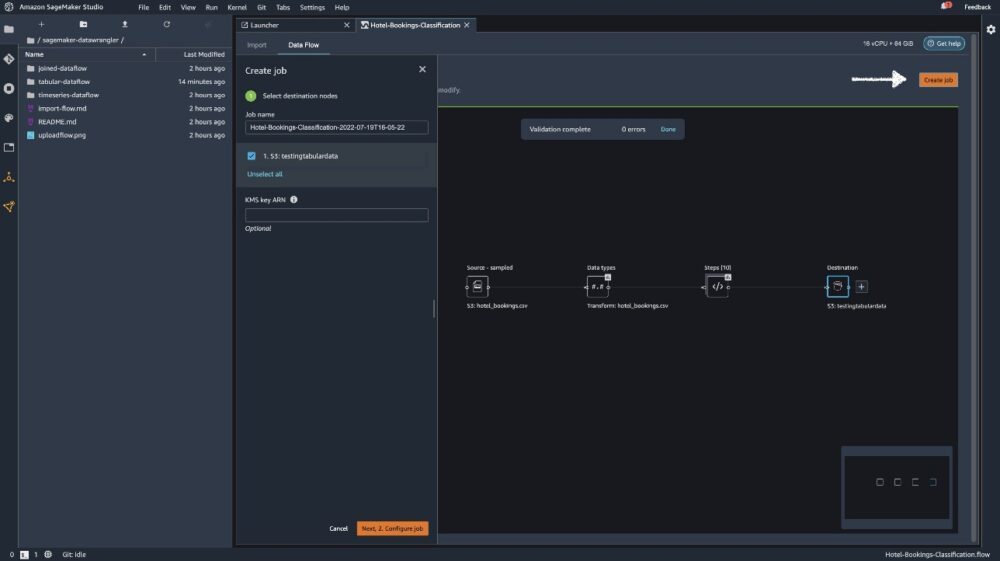

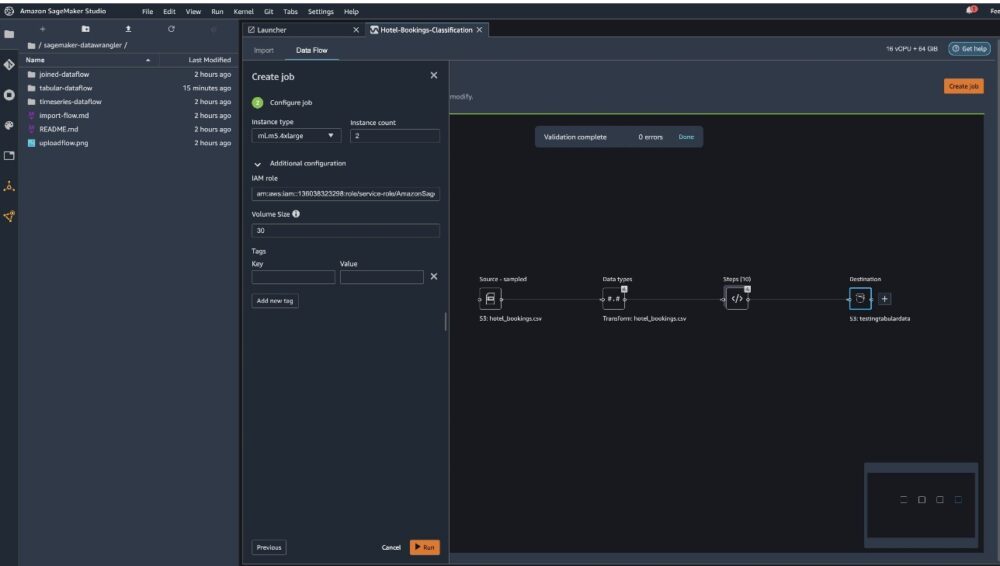

Selectionnez Créer un emploi.

Pour Nom du travail, saisissez un nom ou conservez l'option générée automatiquement et choisissez destination. Nous n'avons qu'une seule destination, S3:testingtabulardata, mais vous pouvez avoir plusieurs destinations provenant de différentes étapes de votre flux de travail. Quitter le ARN de la clé KMS champ vide et choisissez Suivant.

Vous devez maintenant configurer la capacité de calcul pour une tâche. Vous pouvez conserver toutes les valeurs par défaut pour cet exemple.

- Pour Type d'instance, utilisez ml.m5.4xlarge.

- Pour Nombre d'instances, utilisez 2.

- Vous pouvez explorer Configuration supplémentaire, mais conservez les paramètres par défaut.

- Selectionnez Courir.

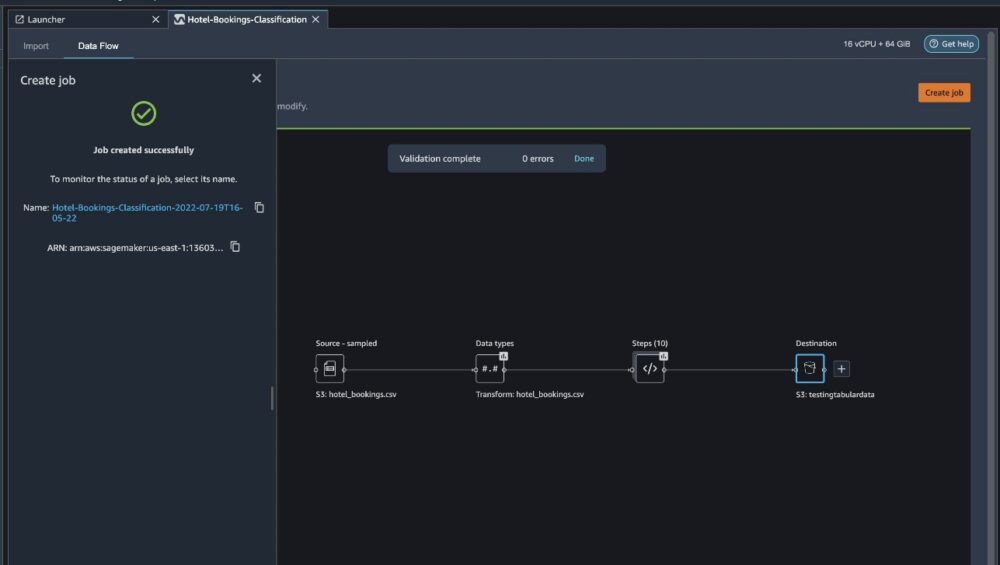

Votre travail a maintenant commencé et le traitement de 6 Go de données prend un certain temps selon notre flux de traitement Data Wrangler. Le coût de ce travail sera d'environ 2 USD, car ml.m5.4xlarge coûte 0.922 USD par heure et nous en utilisons deux.

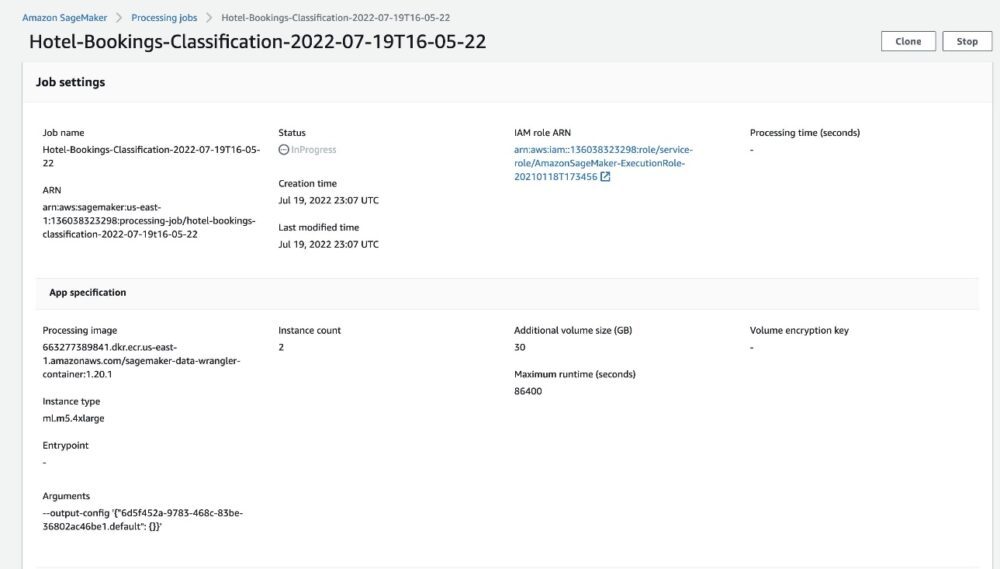

Si vous choisissez le nom du travail, vous êtes redirigé vers une nouvelle fenêtre avec les détails du travail.

Sur la page des détails de la tâche, vous pouvez voir tous les paramètres des étapes précédentes.

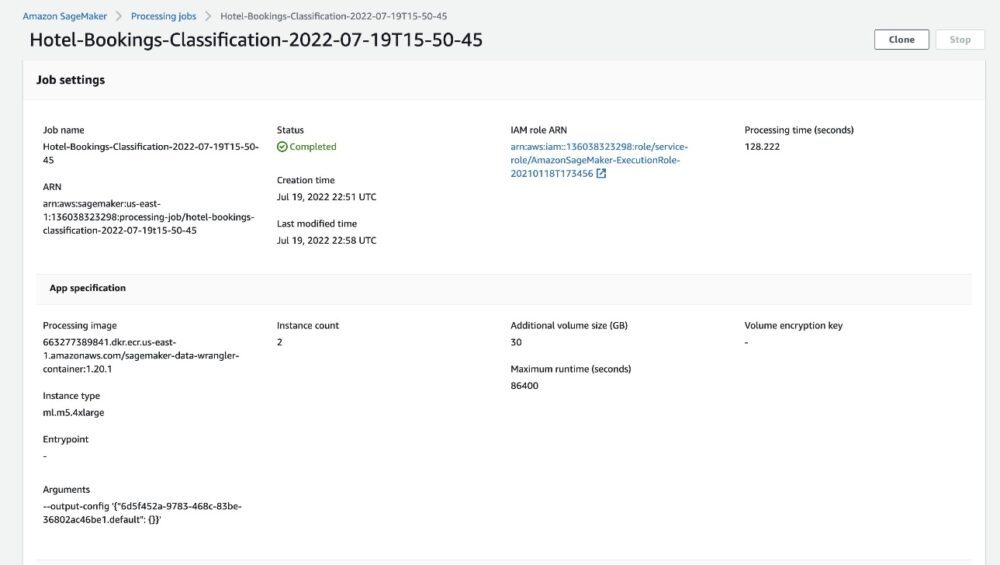

Lorsque le statut du travail passe à Terminé, vous pouvez également vérifier le Temps de traitement (secondes) valeur. Ce travail de traitement prend environ 5 à 10 minutes.

Une fois la tâche terminée, les fichiers de sortie d'entraînement et de test sont disponibles dans les dossiers de sortie S3 correspondants. Vous pouvez trouver l'emplacement de sortie à partir des configurations de tâches de traitement.

Une fois le travail de traitement Data Wrangler terminé, nous pouvons vérifier les résultats enregistrés dans notre compartiment S3. N'oubliez pas de mettre à jour le job_name variable avec le nom de votre travail.

Vous pouvez désormais utiliser ces données exportées pour exécuter des modèles ML.

Nettoyer

Supprimez vos compartiments S3 et Flux de Data Wrangler afin de supprimer les ressources sous-jacentes et d'éviter des coûts indésirables une fois l'expérience terminée.

Conclusion

Dans cet article, nous avons montré comment importer le flux de données tabulaire prédéfini dans Data Wrangler, le connecter à notre ensemble de données et exporter les résultats vers Amazon S3. Si vos cas d'utilisation nécessitent que vous manipuliez des données de séries chronologiques ou que vous joigniez plusieurs ensembles de données, vous pouvez parcourir les autres exemples de flux prédéfinis dans le GitHub repo.

Après avoir importé un flux de travail de préparation de données prédéfini, vous pouvez l'intégrer à Amazon SageMaker Processing, Pipelines Amazon SageMakeret Magasin de fonctionnalités Amazon SageMaker pour simplifier la tâche de traitement, de partage et de stockage des données de formation ML. Vous pouvez également exporter cet exemple de flux de données vers un script Python et créer un pipeline de préparation de données ML personnalisé, accélérant ainsi la vitesse de votre publication.

Nous vous encourageons à consulter notre GitHub référentiel pour vous entraîner et trouver de nouvelles façons d'améliorer la précision du modèle ! Pour en savoir plus sur SageMaker, visitez le Guide du développeur Amazon SageMaker.

À propos des auteurs

Isha Doua est un architecte de solutions senior basé dans la région de la baie de San Francisco. Elle aide les clients d'AWS Enterprise à se développer en comprenant leurs objectifs et leurs défis, et les guide sur la manière dont ils peuvent concevoir leurs applications de manière native dans le cloud tout en s'assurant qu'elles sont résilientes et évolutives. Elle est passionnée par les technologies d'apprentissage automatique et la durabilité environnementale.

Isha Doua est un architecte de solutions senior basé dans la région de la baie de San Francisco. Elle aide les clients d'AWS Enterprise à se développer en comprenant leurs objectifs et leurs défis, et les guide sur la manière dont ils peuvent concevoir leurs applications de manière native dans le cloud tout en s'assurant qu'elles sont résilientes et évolutives. Elle est passionnée par les technologies d'apprentissage automatique et la durabilité environnementale.

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- Amazon Sage Maker

- Gestionnaire de données Amazon SageMaker

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- Apprentissage automatique AWS

- blockchain

- conférence blockchain ai

- cognitif

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- syntaxe

- zéphyrnet