जेनरेटिव एआई बूम गणना-बद्ध है। इसमें अद्वितीय गुण है कि अधिक गणना सीधे जोड़ने से बेहतर उत्पाद प्राप्त होता है। आमतौर पर, अनुसंधान एवं विकास निवेश सीधे तौर पर इस बात से जुड़ा होता है कि कोई उत्पाद कितना मूल्यवान है, और यह संबंध स्पष्ट रूप से सूक्ष्म है। लेकिन वर्तमान में कृत्रिम बुद्धिमत्ता के साथ ऐसा नहीं है और परिणामस्वरूप, आज उद्योग को चलाने वाला एक प्रमुख कारक केवल प्रशिक्षण और अनुमान की लागत है।

हालाँकि हम सही संख्या नहीं जानते हैं, हमने प्रतिष्ठित स्रोतों से सुना है कि गणना की आपूर्ति इतनी सीमित है, मांग 10 (!) के कारक से अधिक है, इसलिए हमें लगता है कि यह कहना उचित है, अभी, न्यूनतम कुल लागत पर कंप्यूटिंग संसाधनों तक पहुंच एआई कंपनियों की सफलता के लिए एक निर्धारित कारक बन गई है.

वास्तव में, हमने देखा है कि कई कंपनियां अपनी कुल जुटाई गई पूंजी का 80% से अधिक कंप्यूटिंग संसाधनों पर खर्च करती हैं!

इस पोस्ट में, हम एक AI कंपनी के लिए लागत कारकों को तोड़ने का प्रयास करते हैं। निश्चित रूप से समय के साथ पूर्ण संख्याएँ बदल जाएंगी, लेकिन हमें एआई कंपनियों द्वारा कंप्यूटिंग संसाधनों तक पहुंच से बंधे होने से तत्काल राहत नहीं मिलती है। तो, उम्मीद है, यह परिदृश्य के माध्यम से सोचने के लिए एक सहायक रूपरेखा है।

AI मॉडल कम्प्यूटेशनल रूप से इतने महंगे क्यों हैं?

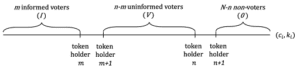

जेनरेटिव एआई मॉडल की एक विस्तृत विविधता है, और अनुमान और प्रशिक्षण लागत मॉडल के आकार और प्रकार पर निर्भर करती है। सौभाग्य से, आज के सबसे लोकप्रिय मॉडल ज्यादातर ट्रांसफार्मर-आधारित आर्किटेक्चर हैं, जिनमें जीपीटी-3, जीपीटी-जे, या बीईआरटी जैसे लोकप्रिय बड़े भाषा मॉडल (एलएलएम) शामिल हैं। जबकि ट्रांसफार्मर के अनुमान और सीखने के लिए संचालन की सटीक संख्या मॉडल-विशिष्ट है (देखें)। इस पत्र), एक काफी सटीक नियम है जो केवल मॉडल के मापदंडों की संख्या (यानी, तंत्रिका नेटवर्क का वजन) और इनपुट और आउटपुट टोकन की संख्या पर निर्भर करता है।

टोकन मूलतः कुछ वर्णों के संक्षिप्त क्रम होते हैं। वे शब्दों या शब्दों के कुछ हिस्सों से मेल खाते हैं। टोकन के लिए अंतर्ज्ञान प्राप्त करने का सबसे अच्छा तरीका सार्वजनिक रूप से उपलब्ध ऑनलाइन टोकनाइज़र (जैसे, OpenAI). GPT-3 के लिए, एक टोकन की औसत लंबाई 4 अक्षर है.

ट्रांसफार्मर के लिए सामान्य नियम यह है कि एक मॉडल के लिए फॉरवर्ड पास (यानी, अनुमान)। p इनपुट के लिए पैरामीटर और लंबाई का आउटपुट अनुक्रम n टोकन से प्रत्येक, लगभग लेता है 2*एन*पी फ्लोटिंग पॉइंट ऑपरेशंस (फ्लॉप)¹. एक ही मॉडल के लिए प्रशिक्षण में लगभग समय लगता है 6*प प्रति टोकन फ्लॉप्स (यानी, अतिरिक्त बैकवर्ड पास के लिए चार और ऑपरेशन की आवश्यकता होती है). आप इसे प्रशिक्षण डेटा में टोकन की मात्रा से गुणा करके कुल प्रशिक्षण लागत का अनुमान लगा सकते हैं।

ट्रांसफार्मर के लिए मेमोरी आवश्यकताएँ मॉडल आकार पर भी निर्भर करती हैं। अनुमान के लिए, हमें इसकी आवश्यकता है p मेमोरी में फिट होने के लिए मॉडल पैरामीटर। सीखने के लिए (यानी, बैक-प्रोपेगेशन), हमें फॉरवर्ड और बैकवर्ड पास के बीच प्रति पैरामीटर अतिरिक्त मध्यवर्ती मान संग्रहीत करने की आवश्यकता है। यह मानते हुए कि हम 32-बिट फ़्लोटिंग पॉइंट नंबरों का उपयोग करते हैं, यह प्रति पैरामीटर अतिरिक्त 8 बाइट्स है। 175 बिलियन-पैरामीटर मॉडल को प्रशिक्षित करने के लिए, हमें मेमोरी में एक टेराबाइट से अधिक डेटा रखने की आवश्यकता होगी - यह आज मौजूद किसी भी जीपीयू से अधिक है और हमें मॉडल को कार्डों में विभाजित करने की आवश्यकता है। अनुमान और प्रशिक्षण के लिए मेमोरी आवश्यकताओं को छोटी लंबाई के फ्लोटिंग पॉइंट मानों का उपयोग करके अनुकूलित किया जा सकता है, जिसमें 16-बिट सामान्य हो जाएगा और निकट भविष्य में 8-बिट अपेक्षित है।

ऊपर दी गई तालिका में कई लोकप्रिय मॉडलों के आकार और लागत की गणना की गई है। GPT-3 में लगभग 175 बिलियन पैरामीटर हैं, जिसके परिणामस्वरूप 1,024 टोकन के इनपुट और आउटपुट के लिए लगभग 350 ट्रिलियन फ्लोटिंग पॉइंट ऑपरेशंस (यानी, टेराफ्लॉप्स या टीएफएलओपीएस) की कम्प्यूटेशनल लागत आती है। GPT-3 जैसे मॉडल को प्रशिक्षित करने में लगभग 3.14*10^23 फ़्लोटिंग पॉइंट ऑपरेशन लगते हैं। मेटा के LLaMA जैसे अन्य मॉडल हैं और ऊंचा आवश्यकताओं की गणना करें। ऐसे मॉडल का प्रशिक्षण मानव जाति द्वारा अब तक किए गए अधिक कम्प्यूटेशनल रूप से गहन कार्यों में से एक है।

संक्षेप में कहें तो: एआई बुनियादी ढांचा महंगा है क्योंकि अंतर्निहित एल्गोरिथम समस्याएं कम्प्यूटेशनल रूप से बेहद कठिन हैं। GPT-3 के साथ एक शब्द उत्पन्न करने की जटिलता की तुलना में दस लाख प्रविष्टियों वाली डेटाबेस तालिका को सॉर्ट करने की एल्गोरिथम जटिलता नगण्य है। इसका मतलब है कि आप सबसे छोटा मॉडल चुनना चाहते हैं जो आपके उपयोग के मामले को हल करता हो।

अच्छी खबर यह है कि, ट्रांसफार्मर के लिए, हम आसानी से अनुमान लगा सकते हैं कि एक निश्चित आकार का मॉडल कितनी गणना और मेमोरी की खपत करेगा। और, इसलिए, सही हार्डवेयर चुनना अगला विचार बन जाता है।

जीपीयू के लिए समय और लागत तर्क

कम्प्यूटेशनल जटिलता समय में कैसे परिवर्तित होती है? एक प्रोसेसर कोर आम तौर पर प्रति चक्र 1-2 निर्देशों को निष्पादित कर सकता है, और पिछले 3 वर्षों से प्रोसेसर घड़ी की दर 15 गीगाहर्ट्ज के आसपास स्थिर रही है। डेनार्ड स्केलिंग. किसी भी समानांतर आर्किटेक्चर का उपयोग किए बिना एकल GPT-3 अनुमान ऑपरेशन को निष्पादित करने में 350 TFLOPS/(3 GHz*1 FLOP) या 116,000 सेकंड या 32 घंटे का समय लगेगा। यह अत्यंत अव्यावहारिक है; इसके बजाय हमें विशेष चिप्स की आवश्यकता है जो इस कार्य को गति दें।

व्यवहार में, आज सभी एआई मॉडल कार्ड पर चलते हैं जो बहुत बड़ी संख्या में विशेष कोर का उपयोग करते हैं। उदाहरण के लिए, एक NVIDIA A100 GPU में 512 "टेंसर कोर" होते हैं जो एक ही चक्र में 4×4 मैट्रिक्स गुणन (जो 64 गुणन और परिवर्धन, या 128 FLOPS के बराबर है) कर सकते हैं। एआई एक्सेलेरेटर कार्ड को अक्सर जीपीयू (ग्राफिक्स प्रोसेसिंग यूनिट) के रूप में जाना जाता है, क्योंकि आर्किटेक्चर मूल रूप से डेस्कटॉप गेमिंग के लिए विकसित किया गया था। भविष्य में हम उम्मीद करते हैं कि AI तेजी से एक विशिष्ट उत्पाद परिवार बन जाएगा।

A100 का प्रदर्शन नाममात्र है 312 TFLOPS जो सैद्धांतिक रूप से GPT-3 के अनुमान को लगभग 1 सेकंड तक कम कर देगा। हालाँकि यह कई कारणों से अत्यधिक सरलीकृत गणना है। सबसे पहले, अधिकांश उपयोग के मामलों के लिए, बाधा जीपीयू की गणना शक्ति नहीं है, बल्कि विशेष ग्राफिक्स मेमोरी से टेंसर कोर तक डेटा प्राप्त करने की क्षमता है। दूसरा, 175 बिलियन वज़न 700GB तक ले जाएगा और किसी भी GPU की ग्राफ़िक्स मेमोरी में फिट नहीं होगा। विभाजन और भार स्ट्रीमिंग जैसी तकनीकों का उपयोग करने की आवश्यकता है। और, तीसरा, कई अनुकूलन हैं (उदाहरण के लिए, छोटे फ़्लोटिंग पॉइंट प्रतिनिधित्व, जैसे एफपी 16, एफपी 8, या विरल मैट्रिक्स का उपयोग करना) जिनका उपयोग गणना में तेजी लाने के लिए किया जा रहा है। लेकिन, कुल मिलाकर, उपरोक्त गणित हमें आज के एलएलएम की समग्र गणना लागत का अंतर्ज्ञान देता है।

एक ट्रांसफॉर्मर मॉडल को प्रशिक्षित करने में अनुमान लगाने में प्रति टोकन लगभग तीन गुना अधिक समय लगता है। हालाँकि, यह देखते हुए कि प्रशिक्षण डेटा सेट एक अनुमान संकेत से लगभग 300 मिलियन गुना बड़ा है, प्रशिक्षण में 1 बिलियन गुना अधिक समय लगता है। एक ही जीपीयू पर, प्रशिक्षण में दशकों लगेंगे; व्यवहार में यह समर्पित डेटा केंद्रों में या अधिक संभावना है, क्लाउड में बड़े कंप्यूटिंग क्लस्टरों पर किया जाता है। प्रशिक्षण को अनुमान लगाने की तुलना में समानांतर करना भी कठिन है, क्योंकि अद्यतन भार को नोड्स के बीच आदान-प्रदान करना पड़ता है। जीपीयू के बीच मेमोरी और बैंडविड्थ अक्सर एक अधिक महत्वपूर्ण कारक बन जाता है, जिसमें हाई-स्पीड इंटरकनेक्ट और समर्पित फैब्रिक आम होते हैं। बहुत बड़े मॉडलों के प्रशिक्षण के लिए, एक उपयुक्त नेटवर्क सेटअप बनाना प्राथमिक चुनौती हो सकती है। भविष्य को देखते हुए, एआई एक्सेलेरेटर में कार्ड या चिप पर भी नेटवर्किंग क्षमताएं होंगी।

यह कम्प्यूटेशनल जटिलता लागत में कैसे परिवर्तित होती है? एक GPT-3 अनुमान, जैसा कि हमने ऊपर देखा, A1 पर लगभग 100 सेकंड का समय लगता है, 0.0002 टोकन के लिए कच्ची गणना लागत $0.0014 और $1,000 के बीच होगी (यह OpenAI के $0.002/1000 टोकन के मूल्य निर्धारण की तुलना में है)। एक उपयोगकर्ता द्वारा प्रतिदिन 100 अनुमान अनुरोध उत्पन्न करने पर प्रति वर्ष डॉलर के क्रम में लागत आएगी। यह बहुत कम कीमत है और मनुष्यों द्वारा टेक्स्ट-आधारित एआई के अधिकांश उपयोग के मामलों को आर्थिक रूप से व्यवहार्य बनाता है।

प्रशिक्षण दूसरी ओर, GPT-3 बहुत अधिक महंगा है। उपरोक्त दरों पर 3.14*10^23 फ्लॉप्स के लिए केवल गणना लागत की गणना करने से हमें ए560,000 कार्डों पर $100 का अनुमान मिलता है। एकल प्रशिक्षण संचालन. व्यवहार में, प्रशिक्षण के लिए हमें GPU में लगभग 100% दक्षता नहीं मिलेगी; हालाँकि हम प्रशिक्षण समय को कम करने के लिए अनुकूलन का भी उपयोग कर सकते हैं। GPT-3 प्रशिक्षण लागत के अन्य अनुमान इस प्रकार हैं $500,000 सेवा मेरे 4.6 लाख $, हार्डवेयर मान्यताओं पर निर्भर करता है। ध्यान दें कि यह एक रन की लागत है, न कि कुल लागत। एकाधिक रन की आवश्यकता होगी और क्लाउड प्रदाता दीर्घकालिक प्रतिबद्धताएँ चाहेंगे (इस पर अधिक जानकारी नीचे दी गई है)। टॉप-ऑफ-द-लाइन मॉडलों का प्रशिक्षण महंगा रहता है, लेकिन एक अच्छी तरह से वित्त पोषित स्टार्ट-अप की पहुंच के भीतर है।

संक्षेप में कहें तो, जेनरेटिव एआई को आज एआई बुनियादी ढांचे में बड़े पैमाने पर निवेश की आवश्यकता है। यह विश्वास करने का कोई कारण नहीं है कि निकट भविष्य में इसमें बदलाव आएगा। GPT-3 जैसे मॉडल का प्रशिक्षण मानव जाति द्वारा अब तक किए गए सबसे कम्प्यूटेशनल रूप से गहन कार्यों में से एक है। और जबकि जीपीयू तेज़ हो रहे हैं, और हम प्रशिक्षण को अनुकूलित करने के तरीके ढूंढ रहे हैं, एआई का तेज़ विस्तार इन दोनों प्रभावों को नकार देता है।

एआई बुनियादी ढांचे के लिए विचार

इस बिंदु पर, हमने आपको एआई मॉडल के प्रशिक्षण और अनुमान के लिए आवश्यक पैमाने के बारे में कुछ अंतर्ज्ञान देने की कोशिश की है, और कौन से अंतर्निहित पैरामीटर उन्हें संचालित करते हैं। उस संदर्भ में, अब हम यह तय करने के लिए कुछ व्यावहारिक मार्गदर्शन प्रदान करना चाहते हैं कि किस एआई बुनियादी ढांचे का उपयोग किया जाए।

बाहरी बनाम घरेलू बुनियादी ढांचा

आइए इसका सामना करें: जीपीयू अच्छे हैं। कई इंजीनियरों और इंजीनियरिंग-दिमाग वाले संस्थापकों का अपने स्वयं के एआई हार्डवेयर का प्रावधान करने के प्रति पूर्वाग्रह है, न केवल इसलिए कि यह मॉडल प्रशिक्षण पर बढ़िया नियंत्रण देता है, बल्कि इसलिए कि बड़ी मात्रा में कंप्यूटिंग शक्ति का उपयोग करने में कुछ मजा है (प्रदर्शनी एक).

हालाँकि, वास्तविकता यही है कई स्टार्टअप - विशेष रूप से ऐप कंपनियों - को अपना स्वयं का एआई बुनियादी ढांचा बनाने की आवश्यकता नहीं है पहले दिन। इसके बजाय, ओपनएआई या हगिंग फेस (भाषा के लिए) और रेप्लिकेट (छवि निर्माण के लिए) जैसी होस्ट की गई मॉडल सेवाएं संस्थापकों को अंतर्निहित बुनियादी ढांचे या मॉडल को प्रबंधित करने की आवश्यकता के बिना उत्पाद-बाजार के लिए तेजी से खोज करने की अनुमति देती हैं।

ये सेवाएँ इतनी अच्छी हो गई हैं कि कई कंपनियाँ कभी भी इनसे स्नातक नहीं होती हैं। डेवलपर्स त्वरित इंजीनियरिंग और उच्च-क्रम फाइन-ट्यूनिंग एब्स्ट्रैक्शन (यानी, एपीआई कॉल के माध्यम से फाइन ट्यूनिंग) के माध्यम से मॉडल प्रदर्शन पर सार्थक नियंत्रण प्राप्त कर सकते हैं। इन सेवाओं के लिए मूल्य निर्धारण उपभोग-आधारित है, इसलिए यह अलग-अलग बुनियादी ढांचे को चलाने की तुलना में अक्सर सस्ता भी होता है। हमने ऐप कंपनियों को $50 मिलियन से अधिक ARR उत्पन्न करते देखा है, और $1 बिलियन से अधिक मूल्य की, जो हुड के तहत होस्टेड मॉडल सेवाएँ चलाती हैं।

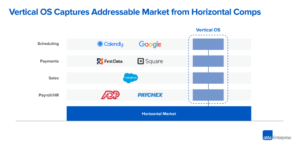

दूसरी ओर, कुछ स्टार्टअप - विशेष रूप से जो नए फाउंडेशन मॉडल का प्रशिक्षण ले रहे हैं या लंबवत एकीकृत एआई अनुप्रयोगों का निर्माण कर रहे हैं - वे सीधे अपने स्वयं के मॉडल चलाने से बच नहीं सकते हैं जीपीयू पर. या तो क्योंकि मॉडल प्रभावी रूप से उत्पाद है और टीम "मॉडल-बाज़ार फिट" की खोज कर रही है, या क्योंकि कुछ क्षमताओं को प्राप्त करने या बड़े पैमाने पर सीमांत लागत को कम करने के लिए प्रशिक्षण और/या अनुमान पर सूक्ष्म नियंत्रण की आवश्यकता होती है। किसी भी तरह से, बुनियादी ढांचे का प्रबंधन प्रतिस्पर्धात्मक लाभ का एक स्रोत बन सकता है।

क्लाउड बनाम डेटा सेंटर का निर्माण

ज्यादातर मामलों में, क्लाउड आपके एआई बुनियादी ढांचे के लिए सही जगह है। कम प्रारंभिक लागत, ऊपर और नीचे स्केल करने की क्षमता, क्षेत्रीय उपलब्धता, और अपना खुद का डेटा सेंटर बनाने से कम ध्यान अधिकांश स्टार्टअप और बड़ी कंपनियों के लिए मजबूर कर रहा है।

लेकिन इस नियम के कुछ अपवाद हैं:

- यदि आप बहुत बड़े पैमाने पर काम कर रहे हैं, तो अपना खुद का डेटा सेंटर चलाना अधिक लागत प्रभावी हो सकता है। सटीक मूल्य बिंदु भौगोलिक स्थान और सेटअप के आधार पर भिन्न होता है, लेकिन इसके लिए आम तौर पर प्रति वर्ष $50 मिलियन से अधिक के बुनियादी ढांचे के खर्च की आवश्यकता होती है।

- आपको बहुत विशिष्ट हार्डवेयर की आवश्यकता है जिसे आप क्लाउड प्रदाता से प्राप्त नहीं कर सकते। उदाहरण के लिए, GPU प्रकार जो व्यापक रूप से उपलब्ध नहीं हैं, साथ ही असामान्य मेमोरी, स्टोरेज या नेटवर्किंग आवश्यकताएँ भी।

- आपको ऐसा कोई बादल नहीं मिल सकता जो भू-राजनीतिक विचारों के लिए स्वीकार्य हो।

यदि आप अपना स्वयं का डेटा सेंटर बनाना चाहते हैं, तो आपके स्वयं के सेटअप के लिए GPU का व्यापक मूल्य/प्रदर्शन विश्लेषण किया गया है (उदाहरण के लिए, टिम डेटमर का विश्लेषण). कार्ड की लागत और प्रदर्शन के अलावा, हार्डवेयर का चयन बिजली, स्थान और कूलिंग पर भी निर्भर करता है। उदाहरण के लिए, दो RTX 3080 Ti कार्डों में A100 के समान कच्ची गणना क्षमता होती है, लेकिन संबंधित बिजली की खपत 700W बनाम 300W है। तीन साल के जीवन चक्र में $3,500/kWh की बाजार दर पर 0.10 kWh बिजली का अंतर RTX3080 Ti की लागत को लगभग 2x (लगभग $1,000) बढ़ा देता है।

इन सभी ने कहा, हम उम्मीद करते हैं कि अधिकांश स्टार्टअप क्लाउड कंप्यूटिंग का उपयोग करेंगे।

क्लाउड सेवा प्रदाताओं की तुलना करना

अमेज़ॅन वेब सर्विसेज (एडब्ल्यूएस), माइक्रोसॉफ्ट एज़्योर और गूगल क्लाउड प्लेटफ़ॉर्म (जीसीपी) सभी जीपीयू इंस्टेंस की पेशकश करते हैं, लेकिन नए प्रदाता भी विशेष रूप से एआई वर्कलोड पर ध्यान केंद्रित कर रहे हैं। यहां एक ढांचा है जिसे हमने कई संस्थापकों को क्लाउड प्रदाता चुनने के लिए उपयोग करते देखा है:

मूल्य: नीचे दी गई तालिका 7 अप्रैल, 2023 तक कई प्रमुख और छोटे विशेष क्लाउडों के लिए मूल्य निर्धारण दिखाती है। यह डेटा केवल सांकेतिक है, क्योंकि नेटवर्क बैंडविड्थ, डेटा निकास लागत, सीपीयू और नेटवर्क से अतिरिक्त लागत के संदर्भ में उदाहरण काफी भिन्न हैं। छूट, और अन्य कारक।

विशिष्ट हार्डवेयर पर गणना क्षमता एक वस्तु है। सहजता से, हम काफी समान कीमतों की उम्मीद करेंगे, लेकिन ऐसा नहीं है। और जबकि क्लाउड के बीच पर्याप्त फीचर अंतर मौजूद हैं, वे यह समझाने के लिए अपर्याप्त हैं कि ऑन-डिमांड NVIDIA A100 की कीमत प्रदाताओं के बीच लगभग 4 गुना भिन्न होती है।

मूल्य पैमाने के शीर्ष छोर पर, बड़े सार्वजनिक क्लाउड ब्रांड प्रतिष्ठा, सिद्ध विश्वसनीयता और कार्यभार की एक विस्तृत श्रृंखला को प्रबंधित करने की आवश्यकता के आधार पर प्रीमियम लेते हैं। छोटे विशेष एआई प्रदाता या तो उद्देश्य-निर्मित डेटा केंद्र (उदाहरण के लिए, कोरवीव) चलाकर या अन्य क्लाउड (उदाहरण के लिए, लैम्ब्डा लैब्स) की मध्यस्थता करके कम कीमतों की पेशकश करते हैं।

व्यावहारिक रूप से कहें तो, अधिकांश बड़े खरीदार क्लाउड प्रदाताओं के साथ सीधे कीमतों पर बातचीत करते हैं, अक्सर कुछ न्यूनतम खर्च की आवश्यकता के साथ-साथ न्यूनतम समय प्रतिबद्धताओं के लिए प्रतिबद्ध होते हैं (हमने 1-3 साल देखे हैं)। बातचीत के बाद क्लाउड के बीच कीमत का अंतर कुछ हद तक कम हो जाता है, लेकिन हमने देखा है कि उपरोक्त तालिका में रैंकिंग अपेक्षाकृत स्थिर बनी हुई है। यह ध्यान रखना भी महत्वपूर्ण है कि छोटी कंपनियां बड़ी खर्च प्रतिबद्धताओं के बिना विशेष क्लाउड से आक्रामक मूल्य निर्धारण प्राप्त कर सकती हैं।

उपलब्धता: सबसे शक्तिशाली जीपीयू (उदाहरण के लिए, एनवीडिया ए100) पिछले 12 से अधिक महीनों से लगातार कम आपूर्ति में हैं।

यह सोचना तर्कसंगत होगा कि शीर्ष तीन क्लाउड प्रदाताओं के पास उनकी बड़ी क्रय शक्ति और संसाधनों के पूल को देखते हुए सबसे अच्छी उपलब्धता है। लेकिन, कुछ हद तक आश्चर्यजनक रूप से, कई स्टार्टअप्स ने इसे सच नहीं पाया है। बड़े क्लाउड में बहुत सारा हार्डवेयर होता है, लेकिन ग्राहकों की बड़ी जरूरतों को भी पूरा करना होता है - उदाहरण के लिए, Azure ChatGPT के लिए प्राथमिक होस्ट है - और मांग को पूरा करने के लिए लगातार क्षमता जोड़/पट्टे पर दे रहा है। इस बीच, एनवीडिया ने पूरे उद्योग में हार्डवेयर को व्यापक रूप से उपलब्ध कराने के लिए प्रतिबद्ध किया है, जिसमें नए विशेष प्रदाताओं के लिए आवंटन भी शामिल है। (वे निष्पक्ष होने के लिए और कुछ बड़े ग्राहकों पर अपनी निर्भरता कम करने के लिए ऐसा करते हैं जो उनके साथ प्रतिस्पर्धा भी करते हैं।)

परिणामस्वरूप, कई स्टार्टअप छोटे क्लाउड प्रदाताओं पर अधिक उपलब्ध चिप्स पाते हैं, जिनमें अत्याधुनिक एनवीडिया एच100 भी शामिल है। यदि आप एक नई बुनियादी ढांचा कंपनी के साथ काम करने के इच्छुक हैं, तो आप हार्डवेयर के लिए प्रतीक्षा समय को कम करने में सक्षम हो सकते हैं और संभवतः इस प्रक्रिया में पैसे बचा सकते हैं।

डिलीवरी मॉडल की गणना करें: बड़े बादल आज केवल समर्पित जीपीयू के साथ उदाहरण पेश करते हैं, इसका कारण यह है कि जीपीयू वर्चुअलाइजेशन अभी भी एक अनसुलझी समस्या है। विशिष्ट एआई क्लाउड कंटेनर या बैच जॉब जैसे अन्य मॉडल पेश करते हैं, जो किसी इंस्टेंस की स्टार्ट-अप और टियर-डाउन लागत के बिना व्यक्तिगत कार्यों को संभाल सकते हैं। यदि आप इस मॉडल के साथ सहज हैं, तो यह लागत को काफी हद तक कम कर सकता है।

नेटवर्क इंटरकनेक्ट: प्रशिक्षण के लिए, विशेष रूप से, प्रदाता चयन में नेटवर्क बैंडविड्थ एक प्रमुख कारक है। कुछ बड़े मॉडलों को प्रशिक्षित करने के लिए एनवीलिंक जैसे नोड्स के बीच समर्पित फैब्रिक वाले क्लस्टर की आवश्यकता होती है। छवि निर्माण के लिए, निकास ट्रैफ़िक शुल्क भी एक प्रमुख लागत चालक हो सकता है।

ग्राहक सहेयता: बड़े क्लाउड प्रदाता हजारों उत्पाद SKU में ग्राहकों के एक विशाल समूह को सेवा प्रदान करते हैं। जब तक आप एक बड़े ग्राहक न हों, ग्राहक सहायता का ध्यान आकर्षित करना या किसी समस्या का समाधान करवाना कठिन हो सकता है। दूसरी ओर, कई विशिष्ट एआई क्लाउड छोटे ग्राहकों के लिए भी तेज़ और प्रतिक्रियाशील समर्थन प्रदान करते हैं। यह आंशिक रूप से इसलिए है क्योंकि वे छोटे पैमाने पर काम कर रहे हैं, बल्कि इसलिए भी क्योंकि उनका कार्यभार अधिक समरूप है - इसलिए उन्हें एआई-विशिष्ट सुविधाओं और बग पर ध्यान केंद्रित करने के लिए अधिक प्रोत्साहित किया जाता है।

जीपीयू की तुलना करना

बाकी सब समान होने पर, टॉप-एंड जीपीयू लगभग सभी कार्यभार पर सर्वश्रेष्ठ प्रदर्शन करेंगे। हालाँकि, जैसा कि आप नीचे दी गई तालिका में देख सकते हैं, सबसे अच्छा हार्डवेयर भी काफी अधिक महंगा है। आपके विशिष्ट एप्लिकेशन के लिए सही प्रकार का जीपीयू चुनने से लागत में काफी कमी आ सकती है और एक व्यवहार्य और गैर-व्यवहार्य व्यवसाय मॉडल के बीच अंतर हो सकता है।

यह तय करना कि सूची में कितना नीचे जाना है - यानी, आपके एप्लिकेशन के लिए सबसे अधिक लागत प्रभावी जीपीयू विकल्प निर्धारित करना - काफी हद तक एक तकनीकी निर्णय है जो इस आलेख के दायरे से परे है। लेकिन हम नीचे कुछ चयन मानदंड साझा करेंगे जो हमने देखे हैं जो सबसे महत्वपूर्ण हैं:

प्रशिक्षण बनाम अनुमान: जैसा कि हमने ऊपर पहले खंड में देखा, एक ट्रांसफार्मर मॉडल को प्रशिक्षित करने के लिए हमें मॉडल भार के अलावा प्रशिक्षण के लिए 8 बाइट्स डेटा संग्रहीत करने की आवश्यकता होती है। इसका मतलब है कि 12 जीबी मेमोरी वाला एक सामान्य हाई-एंड उपभोक्ता जीपीयू मुश्किल से 4-बिलियन-पैरामीटर मॉडल को प्रशिक्षित करने के लिए उपयोग किया जा सकता है। व्यवहार में, बड़े मॉडलों का प्रशिक्षण मशीनों के समूहों पर किया जाता है, जिसमें प्रति सर्वर अधिमानतः कई जीपीयू, बहुत सारे वीआरएएम और सर्वर के बीच उच्च बैंडविड्थ कनेक्शन होते हैं (यानी, टॉप-एंड डेटा सेंटर जीपीयू का उपयोग करके बनाए गए क्लस्टर)।

विशेष रूप से, कई मॉडल NVIDIA H100 पर सबसे अधिक लागत प्रभावी होंगे, लेकिन आज तक इसे ढूंढना मुश्किल है और आमतौर पर एक वर्ष से अधिक की दीर्घकालिक प्रतिबद्धता की आवश्यकता होती है। NVIDIA A100 आज अधिकांश मॉडल-प्रशिक्षण चलाता है; इसे ढूंढना आसान है, लेकिन बड़े समूहों के लिए दीर्घकालिक प्रतिबद्धता की भी आवश्यकता हो सकती है।

मेमोरी आवश्यकताएँ: बड़े एलएलएम में पैरामीटर की संख्या इतनी अधिक होती है कि उसे किसी भी कार्ड में फिट नहीं किया जा सकता। उन्हें कई कार्डों में विभाजित करने की आवश्यकता है और प्रशिक्षण के समान सेटअप की आवश्यकता है। दूसरे शब्दों में, आपको संभवतः एलएलएम अनुमान के लिए भी एच100 या ए100 की आवश्यकता होगी। लेकिन छोटे मॉडल (उदाहरण के लिए, स्थिर प्रसार) को बहुत कम वीआरएएम की आवश्यकता होती है। जबकि A100 अभी भी लोकप्रिय है, हमने देखा है कि स्टार्टअप A10, A40, A4000, A5000 और A6000, या यहां तक कि RTX कार्ड का उपयोग करते हैं।

हार्डवेयर समर्थन: जबकि हमने जिन कंपनियों को NVIDIA पर चलाने की बात की है, उनमें अधिकांश कार्यभार ने अन्य विक्रेताओं के साथ प्रयोग करना शुरू कर दिया है। सबसे आम Google TPU है, लेकिन इंटेल के गौडी 2 को भी कुछ आकर्षण मिल रहा है। इन विक्रेताओं के साथ चुनौती यह है कि आपके मॉडल का प्रदर्शन अक्सर इन चिप्स के लिए सॉफ़्टवेयर अनुकूलन की उपलब्धता पर अत्यधिक निर्भर होता है। प्रदर्शन को समझने के लिए आपको संभवतः एक PoC करना होगा।

विलंबता आवश्यकताएँ: सामान्य तौर पर, कम विलंबता संवेदनशील वर्कलोड (उदाहरण के लिए, बैच डेटा प्रोसेसिंग या एप्लिकेशन जिन्हें इंटरैक्टिव यूआई प्रतिक्रियाओं की आवश्यकता नहीं होती है) कम-शक्तिशाली जीपीयू का उपयोग कर सकते हैं। यह गणना लागत को 3-4 गुना तक कम कर सकता है (उदाहरण के लिए, AWS पर A100s की A10s से तुलना करना)। दूसरी ओर, उपयोगकर्ता-सामना करने वाले ऐप्स को आकर्षक, वास्तविक समय उपयोगकर्ता अनुभव प्रदान करने के लिए अक्सर टॉप-एंड कार्ड की आवश्यकता होती है। लागत को प्रबंधनीय सीमा तक लाने के लिए मॉडल का अनुकूलन अक्सर आवश्यक होता है।

काँटेदारपन: जनरेटिव एआई कंपनियों की मांग में अक्सर नाटकीय बढ़ोतरी देखी जाती है क्योंकि तकनीक बहुत नई और रोमांचक है। किसी नए उत्पाद की रिलीज़ के आधार पर अनुरोध मात्रा में एक दिन में 10 गुना वृद्धि, या प्रति सप्ताह लगातार 50% की वृद्धि देखना असामान्य नहीं है। निचले स्तर के जीपीयू पर इन स्पाइक्स को संभालना अक्सर आसान होता है, क्योंकि मांग पर अधिक कंप्यूट नोड्स उपलब्ध होने की संभावना होती है। प्रदर्शन की कीमत पर - कम लागत वाले संसाधनों के साथ इस प्रकार के ट्रैफ़िक की सेवा करना अक्सर समझ में आता है - यदि यह कम व्यस्त या कम ध्यान रखने वाले उपयोगकर्ताओं से आता है।

मॉडलों का अनुकूलन और शेड्यूलिंग

सॉफ़्टवेयर अनुकूलन मॉडलों के चलने के समय को अत्यधिक प्रभावित कर सकता है - और 10x लाभ असामान्य नहीं हैं। हालाँकि, आपको यह निर्धारित करना होगा कि आपके विशेष मॉडल और सिस्टम के लिए कौन सी विधियाँ सबसे प्रभावी होंगी।

कुछ तकनीकें मॉडलों की काफी विस्तृत श्रृंखला के साथ काम करती हैं। छोटे फ़्लोटिंग पॉइंट अभ्यावेदन (यानी, FP16 या FP8 बनाम मूल FP32) या परिमाणीकरण (INT8, INT4, INT2) का उपयोग करके एक गति प्राप्त की जाती है जो अक्सर बिट्स की कमी के साथ रैखिक होती है। इसके लिए कभी-कभी मॉडल को संशोधित करने की आवश्यकता होती है, लेकिन तेजी से ऐसी प्रौद्योगिकियां उपलब्ध हैं जो मिश्रित या कम परिशुद्धता के साथ काम को स्वचालित करती हैं। न्यूरल नेटवर्क की छंटाई कम मूल्यों वाले वजन को नजरअंदाज करके वजन की संख्या को कम करती है। कुशल विरल मैट्रिक्स गुणन के साथ, यह आधुनिक जीपीयू पर पर्याप्त गति प्राप्त कर सकता है। अनुकूलन तकनीकों का एक और सेट मेमोरी बैंडविड्थ बाधा को संबोधित करता है (उदाहरण के लिए, स्ट्रीमिंग मॉडल वेट द्वारा)।

अन्य अनुकूलन अत्यधिक मॉडल-विशिष्ट हैं। उदाहरण के लिए, स्टेबल डिफ्यूजन ने अनुमान के लिए आवश्यक वीआरएएम की मात्रा में बड़ी प्रगति की है। फिर भी अनुकूलन का एक अन्य वर्ग हार्डवेयर-विशिष्ट है। NVIDIA के TensorML में कई अनुकूलन शामिल हैं, लेकिन यह केवल NVIDIA हार्डवेयर पर काम करेगा। अंतिम, लेकिन महत्वपूर्ण बात यह है कि एआई कार्यों का शेड्यूल बड़ी प्रदर्शन बाधाएं या सुधार पैदा कर सकता है। वजन की अदला-बदली को कम करने के लिए जीपीयू को मॉडल आवंटित करना, यदि कई जीपीयू उपलब्ध हैं तो किसी कार्य के लिए सबसे अच्छा जीपीयू चुनना, और पहले से ही वर्कलोड को बैच करके डाउनटाइम को कम करना सामान्य तकनीकें हैं।

अंत में, मॉडल अनुकूलन अभी भी एक काली कला है, और अधिकांश स्टार्टअप जिनसे हम बात करते हैं, इनमें से कुछ सॉफ़्टवेयर पहलुओं में मदद के लिए तीसरे पक्ष के साथ काम करते हैं। अक्सर, ये पारंपरिक एमएलओपीएस विक्रेता नहीं होते हैं, बल्कि ऐसी कंपनियां होती हैं जो विशिष्ट जेनरेटर मॉडल (उदाहरण के लिए, ऑक्टोएमएल या सेगमाइंड) के लिए अनुकूलन में विशेषज्ञ होती हैं।

एआई बुनियादी ढांचे की लागत कैसे विकसित होगी?

पिछले कुछ वर्षों में, हमने दोनों में तेजी से वृद्धि देखी है मॉडल पैरामीटर और जीपीयू गणना शक्ति. यह स्पष्ट नहीं है कि यह प्रवृत्ति जारी रहेगी या नहीं।

आज, यह व्यापक रूप से स्वीकार किया जाता है कि मापदंडों की इष्टतम संख्या और प्रशिक्षण डेटा सेट के आकार के बीच एक संबंध है (दीपमाइंड देखें) चिनचीला इस पर और अधिक काम करें)। आज के सर्वश्रेष्ठ एलएलएम को यहां प्रशिक्षित किया जाता है आम क्रॉल (4.5 अरब वेब पेजों का संग्रह, या अस्तित्व में मौजूद सभी वेब पेजों का लगभग 10%)। प्रशिक्षण कोष में विकिपीडिया और पुस्तकों का संग्रह भी शामिल है, हालाँकि दोनों बहुत छोटे हैं (मौजूदा पुस्तकों की कुल संख्या अनुमानित है) केवल 100 मिलियन के आसपास). अन्य विचार, जैसे कि वीडियो या ऑडियो सामग्री को ट्रांसक्रिप्ट करना, सुझाए गए हैं, लेकिन इनमें से कोई भी आकार में करीब नहीं आता है। यह स्पष्ट नहीं है कि क्या हम एक गैर-सिंथेटिक प्रशिक्षण डेटासेट प्राप्त कर सकते हैं जो पहले से उपयोग किए गए से 10 गुना बड़ा है।

GPU का प्रदर्शन बढ़ता रहेगा, लेकिन धीमी गति से भी। अधिक ट्रांजिस्टर और अधिक कोर की अनुमति देने वाला मूर का नियम अभी भी बरकरार है, लेकिन शक्ति और I/O सीमित कारक बन रहे हैं। इसके अतिरिक्त, अनुकूलन के लिए कम संभावना वाले कई फलों को चुना गया है।

हालाँकि, इसका कोई मतलब नहीं है कि हम गणना क्षमता की मांग में वृद्धि की उम्मीद नहीं करते हैं। भले ही मॉडल और प्रशिक्षण सेट की वृद्धि धीमी हो, एआई उद्योग की वृद्धि और एआई डेवलपर्स की संख्या में वृद्धि से अधिक और तेज जीपीयू की मांग बढ़ेगी। किसी मॉडल के विकास चरण के दौरान डेवलपर्स द्वारा परीक्षण के लिए GPU क्षमता का एक बड़ा हिस्सा उपयोग किया जाता है, और यह मांग हेडकाउंट के साथ रैखिक रूप से बढ़ती है। ऐसा कोई संकेत नहीं है कि आज हमारे पास मौजूद GPU की कमी निकट भविष्य में दूर हो जाएगी।

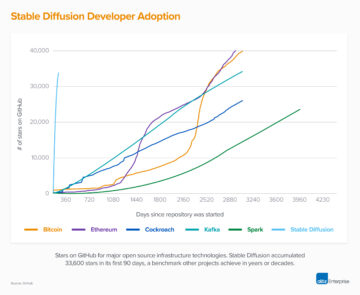

क्या एआई बुनियादी ढांचे की यह निरंतर उच्च लागत एक ऐसी खाई पैदा कर देगी जिससे नए प्रवेशकों के लिए अच्छी तरह से वित्त पोषित पदधारियों के साथ तालमेल बिठाना असंभव हो जाएगा? इस सवाल का जवाब हमें अभी तक नहीं पता. एलएलएम की प्रशिक्षण लागत आज एक खाई की तरह लग सकती है, लेकिन अल्पाका या स्टेबल डिफ्यूजन जैसे ओपन सोर्स मॉडल ने दिखाया है कि ये बाजार अभी भी शुरुआती हैं और जल्दी से बदल सकते हैं। समय के साथ, उभरते एआई सॉफ्टवेयर स्टैक की लागत संरचना (हमारी पिछली पोस्ट देखें) पारंपरिक सॉफ्टवेयर उद्योग की तरह दिखने लग सकता है।

अंततः, यह एक अच्छी बात होगी: इतिहास से पता चला है कि इससे तेजी से नवाचार के साथ जीवंत पारिस्थितिकी तंत्र और उद्यमशील संस्थापकों के लिए बहुत सारे अवसर मिलते हैं।

लेखन प्रक्रिया के दौरान उनके इनपुट और मार्गदर्शन के लिए मोइन नदीम और शांगदा जू को धन्यवाद।

¹ यहां अंतर्ज्ञान यह है कि तंत्रिका नेटवर्क में किसी भी पैरामीटर (यानी वजन) के लिए, एक अनुमान ऑपरेशन (यानी फॉरवर्ड पास) को प्रति पैरामीटर दो फ़्लोटिंग पॉइंट ऑपरेशन करने की आवश्यकता होती है। सबसे पहले, यह तंत्रिका नेटवर्क के इनपुट नोड के मान को पैरामीटर से गुणा करता है। दूसरा, यह योग के परिणाम को तंत्रिका नेटवर्क के आउटपुट नोड में जोड़ता है। एनकोडर में पैरामीटर प्रति इनपुट टोकन के लिए एक बार उपयोग किए जाते हैं और डिकोडर में पैरामीटर प्रति आउटपुट टोकन के लिए एक बार उपयोग किए जाते हैं। यदि हम मान लें कि एक मॉडल है p पैरामीटर और इनपुट और आउटपुट दोनों की लंबाई होती है n टोकन, कुल फ़्लोटिंग पॉइंट ऑपरेशन हैं एन * पी. कई अन्य ऑपरेशन हैं (उदाहरण के लिए सामान्यीकरण, एम्बेडिंग को एन्कोडिंग/डिकोड करना) जो एक मॉडल में होते हैं, लेकिन उन्हें निष्पादित करने में लगने वाला समय तुलना में छोटा होता है।

² सीखने के लिए पहले ट्रांसफार्मर के माध्यम से एक फॉरवर्ड पास की आवश्यकता होती है जैसा कि ऊपर वर्णित है, उसके बाद एक बैकवर्ड पास होता है जिसमें ग्रेडिएंट की गणना करने और वजन को समायोजित करने के लिए प्रति पैरामीटर चार अतिरिक्त ऑपरेशन होते हैं। ध्यान दें कि ग्रेडिएंट की गणना के लिए फॉरवर्ड पास से परिकलित नोड मानों को संरक्षित करने की आवश्यकता होती है। जीपीटी-3 के लिए, भाषा के मॉडल कुछ-शॉट सीखने वाले होते हैं प्रशिक्षण लागत पर चर्चा करता है.

* * *

यहां व्यक्त किए गए विचार व्यक्तिगत एएच कैपिटल मैनेजमेंट, एलएलसी ("a16z") कर्मियों के हैं जिन्हें उद्धृत किया गया है और यह a16z या इसके सहयोगियों के विचार नहीं हैं। यहां निहित कुछ जानकारी तृतीय-पक्ष स्रोतों से प्राप्त की गई है, जिसमें a16z द्वारा प्रबंधित निधियों की पोर्टफोलियो कंपनियों से भी शामिल है। जबकि विश्वसनीय माने जाने वाले स्रोतों से लिया गया, a16z ने स्वतंत्र रूप से ऐसी जानकारी को सत्यापित नहीं किया है और किसी भी स्थिति के लिए सूचना की स्थायी सटीकता या इसकी उपयुक्तता के बारे में कोई प्रतिनिधित्व नहीं करता है। इसके अतिरिक्त, इस सामग्री में तृतीय-पक्ष विज्ञापन शामिल हो सकते हैं; a16z ने ऐसे विज्ञापनों की समीक्षा नहीं की है और उनमें निहित किसी भी विज्ञापन सामग्री का समर्थन नहीं करता है।

यह सामग्री केवल सूचना के उद्देश्यों के लिए प्रदान की जाती है, और कानूनी, व्यापार, निवेश या कर सलाह के रूप में इस पर भरोसा नहीं किया जाना चाहिए। आपको उन मामलों में अपने स्वयं के सलाहकारों से परामर्श लेना चाहिए। किसी भी प्रतिभूति या डिजिटल संपत्ति के संदर्भ केवल दृष्टांत उद्देश्यों के लिए हैं, और निवेश सलाहकार सेवाएं प्रदान करने के लिए एक निवेश अनुशंसा या प्रस्ताव का गठन नहीं करते हैं। इसके अलावा, यह सामग्री किसी भी निवेशक या संभावित निवेशकों द्वारा उपयोग के लिए निर्देशित नहीं है और न ही इसका इरादा है, और किसी भी परिस्थिति में a16z द्वारा प्रबंधित किसी भी फंड में निवेश करने का निर्णय लेते समय इस पर भरोसा नहीं किया जा सकता है। (a16z फंड में निवेश करने की पेशकश केवल निजी प्लेसमेंट मेमोरेंडम, सब्सक्रिप्शन एग्रीमेंट, और ऐसे किसी भी फंड के अन्य प्रासंगिक दस्तावेज द्वारा की जाएगी और इसे पूरी तरह से पढ़ा जाना चाहिए।) किसी भी निवेश या पोर्टफोलियो कंपनियों का उल्लेख, संदर्भित, या वर्णित a16z द्वारा प्रबंधित वाहनों में सभी निवेशों के प्रतिनिधि नहीं हैं, और इस बात का कोई आश्वासन नहीं दिया जा सकता है कि निवेश लाभदायक होगा या भविष्य में किए गए अन्य निवेशों में समान विशेषताएं या परिणाम होंगे। आंद्रेसेन होरोविट्ज़ द्वारा प्रबंधित निधियों द्वारा किए गए निवेशों की सूची (उन निवेशों को छोड़कर जिनके लिए जारीकर्ता ने सार्वजनिक रूप से कारोबार की गई डिजिटल संपत्ति में सार्वजनिक रूप से और साथ ही अघोषित निवेशों का खुलासा करने के लिए a16z की अनुमति नहीं दी है) https://a16z.com/investments पर उपलब्ध है। /.

इसमें दिए गए चार्ट और ग्राफ़ केवल सूचना के उद्देश्यों के लिए हैं और निवेश का कोई भी निर्णय लेते समय उन पर भरोसा नहीं किया जाना चाहिए। पूर्व प्रदर्शन भविष्य के परिणाम का संकेत नहीं है। सामग्री केवल इंगित तिथि के अनुसार बोलती है। इन सामग्रियों में व्यक्त किए गए किसी भी अनुमान, अनुमान, पूर्वानुमान, लक्ष्य, संभावनाएं और/या राय बिना किसी सूचना के परिवर्तन के अधीन हैं और दूसरों द्वारा व्यक्त की गई राय के विपरीत या भिन्न हो सकते हैं। अतिरिक्त महत्वपूर्ण जानकारी के लिए कृपया https://a16z.com/disclosures देखें।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोआईस्ट्रीम। Web3 डेटा इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- मिंटिंग द फ्यूचर डब्ल्यू एड्रिएन एशले। यहां पहुंचें।

- स्रोत: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :हैस

- :है

- :नहीं

- 1 $ अरब

- $यूपी

- 000

- 1

- 100

- 116

- 15 साल

- 2023

- 500

- 7

- 8

- a

- a16z

- क्षमता

- योग्य

- About

- ऊपर

- पूर्ण

- में तेजी लाने के

- त्वरक

- त्वरक

- स्वीकार्य

- स्वीकृत

- पहुँच

- शुद्धता

- सही

- पाना

- के पार

- जोड़ने

- इसके अलावा

- अतिरिक्त

- इसके अतिरिक्त

- अतिरिक्त

- पतों

- जोड़ता है

- उन्नत

- अग्रिमों

- लाभ

- विज्ञापन

- सलाह

- सलाहकार

- सलाहकार सेवाएं

- को प्रभावित

- सहयोगी कंपनियों

- बाद

- फिर

- आक्रामक

- समझौता

- AI

- एल्गोरिथम

- सब

- आवंटन

- की अनुमति दे

- पहले ही

- भी

- हालांकि

- के बीच में

- राशि

- राशियाँ

- an

- विश्लेषण

- और

- एंड्रीसन

- आंद्रेसेन होरोविट्ज़

- अन्य

- जवाब

- प्रत्याशित

- कोई

- एपीआई

- अनुप्रयोग

- प्रदर्शित होने

- प्रकट होता है

- आवेदन

- अनुप्रयोगों

- लगभग

- क्षुधा

- अप्रैल

- स्थापत्य

- हैं

- तर्क

- चारों ओर

- कला

- लेख

- कृत्रिम

- कृत्रिम बुद्धिमत्ता

- AS

- पहलुओं

- संपत्ति

- आश्वासन

- At

- ध्यान

- ऑडियो

- को स्वचालित रूप से

- उपलब्धता

- उपलब्ध

- औसत

- से बचने

- एडब्ल्यूएस

- नीला

- बैंडविड्थ

- आधारित

- BE

- क्योंकि

- बन

- हो जाता है

- बनने

- किया गया

- जा रहा है

- मानना

- माना

- नीचे

- BEST

- बेहतर

- के बीच

- परे

- पूर्वाग्रह

- बड़ा

- बिलियन

- बिट

- काली

- पुस्तकें

- उछाल

- के छात्रों

- सीमा

- ब्रांड

- टूटना

- लाना

- विस्तृत

- मोटे तौर पर

- कीड़े

- निर्माण

- इमारत

- बनाया गया

- व्यापार

- व्यापार मॉडल

- लेकिन

- खरीददारों

- by

- गणना

- परिकलित

- परिकलन

- कॉल

- कर सकते हैं

- पा सकते हैं

- नही सकता

- क्षमताओं

- क्षमता

- राजधानी

- कार्ड

- पत्ते

- मामला

- मामलों

- कुश्ती

- केंद्र

- केंद्र

- कुछ

- चुनौती

- परिवर्तन

- विशेषताएँ

- अक्षर

- प्रभार

- ChatGPT

- सस्ता

- टुकड़ा

- चिप्स

- विकल्प

- चुनें

- हालत

- कक्षा

- स्पष्ट

- घड़ी

- समापन

- बादल

- बादल कंप्यूटिंग

- क्लाउड प्लेटफॉर्म

- संग्रह

- कैसे

- आता है

- आरामदायक

- प्रतिबद्धता

- प्रतिबद्ध

- करने

- वस्तु

- सामान्य

- कंपनियों

- कंपनी

- तुलना

- की तुलना

- तुलना

- सम्मोहक

- प्रतिस्पर्धा

- प्रतियोगी

- जटिलता

- व्यापक

- गणना

- गणना करना

- कंप्यूटिंग

- संगणन शक्ति

- कनेक्शन

- विचार

- विचार

- निरंतर

- का गठन

- उपभोग

- उपभोक्ता

- खपत

- कंटेनरों

- सामग्री

- प्रसंग

- जारी रखने के

- निरंतर

- विपरीत

- नियंत्रण

- ठंडा

- मूल

- लागत

- प्रभावी लागत

- लागत

- सका

- कोर्स

- बनाना

- बनाना

- मापदंड

- वर्तमान में

- ग्राहक

- ग्राहक सहयोग

- ग्राहक

- अग्रणी

- चक्र

- तिथि

- डाटा केंद्र

- डेटा केन्द्रों

- डेटा संसाधन

- डेटा सेट

- डाटाबेस

- तारीख

- दिन

- दशकों

- तय

- निर्णय

- समर्पित

- Deepmind

- उद्धार

- प्रसव

- मांग

- निर्भरता

- निर्भर

- निर्भर करता है

- निर्भर करता है

- वर्णित

- डेस्कटॉप

- निर्धारित करना

- निर्धारित करने

- विकसित

- डेवलपर्स

- विकास

- अलग

- अंतर

- मतभेद

- प्रसार

- डिजिटल

- डिजिटल आस्तियां

- सीधे

- खुलासा

- छूट

- अलग

- do

- दस्तावेज़ीकरण

- कर देता है

- कर

- डॉलर

- किया

- dont

- नीचे

- स्र्कना

- नाटकीय

- ड्राइव

- ड्राइवर

- ड्राइविंग

- दो

- दौरान

- e

- शीघ्र

- आसान

- आसानी

- पारिस्थितिकी प्रणालियों

- प्रभावी

- प्रभावी रूप से

- प्रभाव

- दक्षता

- कुशल

- भी

- embedding

- कस्र्न पत्थर

- समाप्त

- का समर्थन किया

- टिकाऊ

- लगे हुए

- मनोहन

- अभियांत्रिकी

- इंजीनियर्स

- संपूर्णता

- भेजे

- उद्यमी

- बराबर

- विशेष रूप से

- अनिवार्य

- आकलन

- अनुमानित

- अनुमान

- और भी

- कभी

- विकसित करना

- उदाहरण

- से अधिक

- उत्तेजक

- के सिवा

- निष्पादित

- को क्रियान्वित

- मौजूद

- विस्तार

- उम्मीद

- महंगा

- अनुभव

- समझाना

- घातीय

- घातांकी बढ़त

- व्यक्त

- अत्यंत

- कपड़े

- चेहरा

- कारकों

- निष्पक्ष

- काफी

- परिवार

- फास्ट

- और तेज

- Feature

- विशेषताएं

- फीस

- कुछ

- आर्थिक रूप से

- खोज

- अंत

- प्रथम

- फिट

- तय

- फ्लिप

- चल

- फोकस

- पीछा किया

- के लिए

- पूर्वानुमान

- भाग्यवश

- आगे

- पाया

- बुनियाद

- संस्थापकों

- चार

- अंश

- ढांचा

- से

- ईंधन

- मज़ा

- कोष

- धन

- और भी

- भविष्य

- लाभ

- जुआ

- सामान्य जानकारी

- सृजन

- पीढ़ी

- उत्पादक

- जनरेटिव एआई

- भौगोलिक

- भू राजनीतिक

- मिल

- मिल रहा

- देना

- दी

- देता है

- Go

- अच्छा

- गूगल

- Google मेघ

- Google Cloud Platform

- GPU

- GPUs

- स्नातक

- ग्राफ़िक्स

- रेखांकन

- आगे बढ़ें

- विकास

- मार्गदर्शन

- हाथ

- संभालना

- हैंडलिंग

- होना

- कठिन

- हार्डवेयर

- दोहन

- है

- कर्मचारियों की संख्या

- सुना

- मदद

- सहायक

- यहाँ उत्पन्न करें

- हाई

- उच्च-स्तरीय

- अत्यधिक

- इतिहास

- हुड

- उम्मीद है कि

- Horowitz

- मेजबान

- मेजबानी

- घंटे

- कैसे

- How To

- तथापि

- एचटीएमएल

- HTTPS

- विशाल

- बेहद

- मनुष्य

- i

- विचारों

- if

- की छवि

- तत्काल

- महत्वपूर्ण

- असंभव

- सुधार

- in

- अन्य में

- प्रोत्साहित

- शामिल

- शामिल

- सहित

- बढ़ना

- बढ़ जाती है

- तेजी

- स्वतंत्र रूप से

- संकेत दिया

- व्यक्ति

- उद्योग

- करें-

- सूचना

- इंफ्रास्ट्रक्चर

- नवोन्मेष

- निवेश

- उदाहरण

- बजाय

- निर्देश

- एकीकृत

- बुद्धि

- इंटरैक्टिव

- में

- निवेश करना

- निवेश

- निवेश सलाह

- निवेश

- निवेशक

- जारीकर्ता

- IT

- आईटी इस

- खुद

- नौकरियां

- केवल

- रखना

- बच्चा

- जानना

- लैब्स

- परिदृश्य

- भाषा

- बड़ा

- बड़े पैमाने पर

- बड़ा

- पिछली बार

- विलंब

- कानून

- बिक्रीसूत्र

- सीख रहा हूँ

- कानूनी

- लंबाई

- जीवन

- पसंद

- संभावित

- सूची

- लामा

- एलएलएम

- स्थान

- तार्किक

- लंबा

- लंबे समय तक

- लंबे समय तक

- देखिए

- हमशक्ल

- देख

- लॉट

- निम्न

- कम

- सबसे कम

- मशीनें

- बनाया गया

- प्रमुख

- बहुमत

- बनाना

- बनाता है

- निर्माण

- प्रबंधन

- कामयाब

- प्रबंध

- प्रबंध

- मानवता

- बहुत

- बाजार

- Markets

- विशाल

- सामग्री

- गणित

- मैट्रिक्स

- मैटर्स

- अधिकतम-चौड़ाई

- मई..

- सार्थक

- साधन

- तब तक

- मिलना

- ज्ञापन

- याद

- उल्लेख किया

- तरीकों

- माइक्रोसॉफ्ट

- माइक्रोसॉफ्ट नीला

- दस लाख

- कम से कम

- न्यूनतम

- मिश्रित

- एमएलओपीएस

- आदर्श

- मॉडल

- आधुनिक

- धन

- महीने

- अधिक

- अधिकांश

- सबसे लोकप्रिय

- बहुत

- विभिन्न

- गुणा

- नेविगेट

- निकट

- लगभग

- आवश्यक

- आवश्यकता

- जरूरत

- की जरूरत है

- नेटवर्क

- शुद्ध कार्यशील

- नेटवर्क

- तंत्रिका नेटवर्क

- तंत्रिका जाल

- नया

- नया उत्पाद

- समाचार

- अगला

- नहीं

- नोड

- नोड्स

- सूचना..

- अभी

- संख्या

- संख्या

- Nvidia

- प्राप्त

- प्राप्त

- of

- प्रस्ताव

- की पेशकश

- अक्सर

- on

- ऑन डिमांड

- एक बार

- ONE

- ऑनलाइन

- केवल

- खुला

- खुला स्रोत

- OpenAI

- परिचालन

- आपरेशन

- संचालन

- राय

- अवसर

- इष्टतम

- इष्टतमीकरण

- ऑप्टिमाइज़ करें

- अनुकूलित

- के अनुकूलन के

- or

- आदेश

- मूल

- मौलिक रूप से

- अन्य

- अन्य

- हमारी

- आउट

- उत्पादन

- कहीं बेहतर है

- के ऊपर

- कुल

- अपना

- समानांतर

- प्राचल

- पैरामीटर

- विशेष

- पार्टियों

- भागों

- पास

- अतीत

- पीडीएफ

- निष्पादन

- प्रदर्शन

- अनुमति

- कर्मियों को

- चरण

- चुनना

- उठाया

- जगह

- मंच

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- कृप्या अ

- PoC

- बिन्दु

- पूल

- लोकप्रिय

- संविभाग

- संभवतः

- पद

- बिजली

- शक्तिशाली

- व्यावहारिक

- अभ्यास

- शुद्धता

- प्रीमियम

- पिछला

- मूल्य

- मूल्य

- कीमत निर्धारण

- प्राथमिक

- निजी

- शायद

- मुसीबत

- समस्याओं

- प्रक्रिया

- प्रसंस्करण

- प्रोसेसर

- एस्ट्रो मॉल

- लाभदायक

- अनुमानों

- संपत्ति

- भावी

- संभावना

- साबित

- प्रदान करना

- बशर्ते

- प्रदाता

- प्रदाताओं

- सार्वजनिक

- सार्वजनिक रूप से

- क्रय

- प्रयोजनों

- प्रश्न

- जल्दी से

- अनुसंधान और विकास

- उठाया

- रेंज

- रैंकिंग

- उपवास

- तेजी

- मूल्यांकन करें

- दरें

- कच्चा

- पहुंच

- पढ़ना

- वास्तविक समय

- वास्तविकता

- कारण

- कारण

- सिफारिश

- को कम करने

- कम कर देता है

- संदर्भ

- निर्दिष्ट

- क्षेत्रीय

- संबंध

- अपेक्षाकृत

- और

- प्रासंगिक

- विश्वसनीयता

- विश्वसनीय

- राहत

- रहना

- बाकी है

- प्रतिनिधि

- सम्मानित

- ख्याति

- का अनुरोध

- अनुरोधों

- की आवश्यकता होती है

- अपेक्षित

- आवश्यकता

- आवश्यकताएँ

- की आवश्यकता होती है

- उपयुक्त संसाधन चुनें

- कि

- उत्तरदायी

- परिणाम

- परिणाम

- समीक्षा

- RTX

- आरटीएक्स 3080

- आरटीएक्स 3080 टीआई

- नियम

- रन

- दौड़ना

- कहा

- वही

- सहेजें

- स्केल

- तराजू

- समयबद्धन

- क्षेत्र

- Search

- खोज

- दूसरा

- सेकंड

- अनुभाग

- प्रतिभूतियां

- देखना

- देखा

- चयन

- भावना

- संवेदनशील

- अलग

- अनुक्रम

- सेवा

- सर्वर

- सेवा

- सेवाएँ

- सेट

- व्यवस्था

- कई

- Share

- कम

- कमी

- चाहिए

- दिखाया

- दिखाता है

- पक्ष

- हस्ताक्षर

- समान

- केवल

- के बाद से

- एक

- स्थिति

- आकार

- आकार

- धीमा कर देती है

- छोटा

- छोटे

- So

- अब तक

- सॉफ्टवेयर

- हल करती है

- कुछ

- कुछ

- कुछ हद तक

- स्रोत

- सूत्रों का कहना है

- अंतरिक्ष

- बोल रहा हूँ

- बोलता हे

- विशेषज्ञ

- विशेषीकृत

- विशेषता

- विशिष्ट

- विशेष रूप से

- बिताना

- खर्च

- spikes के

- विभाजित

- स्थिर

- धुआँरा

- प्रारंभ

- शुरू हुआ

- शुरू

- स्टार्टअप

- फिर भी

- भंडारण

- की दुकान

- स्ट्रीमिंग

- संरचना

- विषय

- अंशदान

- पर्याप्त

- सफलता

- ऐसा

- उपयुक्त

- संक्षेप में प्रस्तुत करना

- आपूर्ति

- समर्थन

- प्रणाली

- तालिका

- लेना

- लेता है

- बातचीत

- लक्ष्य

- कार्य

- कार्य

- कर

- टीम

- तकनीकी

- तकनीक

- टेक्नोलॉजीज

- टेक्नोलॉजी

- शर्तों

- परीक्षण

- से

- कि

- RSI

- भविष्य

- जानकारी

- परिदृश्य

- लेकिन हाल ही

- उन

- वहाँ।

- यहां

- इन

- वे

- बात

- सोचना

- विचारधारा

- तीसरा

- तीसरे पक्ष

- तीसरे दल

- इसका

- उन

- हजारों

- तीन

- यहाँ

- बंधा होना

- पहर

- बार

- सेवा मेरे

- आज

- आज का दि

- एक साथ

- टोकन

- tokenization

- टोकन

- भी

- ऊपर का

- कुल

- की ओर

- कर्षण

- कारोबार

- परंपरागत

- यातायात

- रेलगाड़ी

- प्रशिक्षित

- प्रशिक्षण

- ट्रान्सफ़ॉर्मर

- अनुवाद करना

- प्रवृत्ति

- कोशिश

- खरब

- <strong>उद्देश्य</strong>

- दो

- टाइप

- प्रकार

- ठेठ

- आम तौर पर

- ui

- असामान्य

- के अंतर्गत

- आधारभूत

- समझना

- अद्वितीय

- इकाइयों

- अद्यतन

- के ऊपर

- us

- उपयोग

- उदाहरण

- प्रयुक्त

- उपयोगकर्ता

- उपयोगकर्ता अनुभव

- उपयोगकर्ताओं

- का उपयोग

- आमतौर पर

- मूल्यवान

- मूल्य

- महत्वपूर्ण

- मान

- विविधता

- व्यापक

- वाहन

- विक्रेताओं

- सत्यापित

- खड़ी

- बहुत

- व्यवहार्य

- जीवंत

- वीडियो

- विचारों

- संस्करणों

- vs

- प्रतीक्षा

- करना चाहते हैं

- था

- मार्ग..

- तरीके

- we

- वेब

- वेब सेवाओं

- सप्ताह

- भार

- कुंआ

- क्या

- कब

- कौन कौन से

- जब

- कौन

- चौड़ा

- विस्तृत श्रृंखला

- व्यापक रूप से

- विकिपीडिया

- मर्जी

- तैयार

- साथ में

- अंदर

- बिना

- शब्द

- शब्द

- काम

- काम कर रहे

- होगा

- लिख रहे हैं

- वर्ष

- साल

- अभी तक

- आप

- आपका

- जेफिरनेट