आज, हमें यह घोषणा करते हुए खुशी हो रही है कि ओपनएआई व्हिस्पर फाउंडेशन मॉडल उपयोग करने वाले ग्राहकों के लिए उपलब्ध है अमेज़न SageMaker जम्पस्टार्ट. व्हिस्पर स्वचालित वाक् पहचान (एएसआर) और वाक् अनुवाद के लिए एक पूर्व-प्रशिक्षित मॉडल है। 680 हजार घंटों के लेबल किए गए डेटा पर प्रशिक्षित, व्हिस्पर मॉडल फ़ाइन-ट्यूनिंग की आवश्यकता के बिना कई डेटासेट और डोमेन को सामान्यीकृत करने की एक मजबूत क्षमता प्रदर्शित करते हैं। सेजमेकर जंपस्टार्ट, सेजमेकर का मशीन लर्निंग (एमएल) हब है जो आपको एमएल के साथ जल्दी शुरुआत करने में मदद करने के लिए बिल्ट-इन एल्गोरिदम और एंड-टू-एंड सॉल्यूशन टेम्प्लेट के अलावा फाउंडेशन मॉडल तक पहुंच प्रदान करता है।

आप ASR का उपयोग करके भी कर सकते हैं Amazon Transcribe , एक पूरी तरह से प्रबंधित और लगातार प्रशिक्षित स्वचालित वाक् पहचान सेवा।

इस पोस्ट में, हम आपको दिखाते हैं कि इसे कैसे तैनात किया जाए ओपनएआई व्हिस्पर मॉडल बनाएं और ऑडियो को ट्रांसक्राइब और अनुवाद करने के लिए मॉडल का आह्वान करें।

OpenAI व्हिस्पर मॉडल का उपयोग करता है गले लगानाचेहरा-पाइटोरच-अनुमान कंटेनर. सेजमेकर जम्पस्टार्ट मॉडल हब ग्राहक के रूप में, आप सेजमेकर एसडीके के बाहर मॉडल स्क्रिप्ट को बनाए रखने के बिना एएसआर का उपयोग कर सकते हैं। सेजमेकर जंपस्टार्ट मॉडल नेटवर्क अलगाव को सक्षम करने वाले एंडपॉइंट के साथ सुरक्षा स्थिति में भी सुधार करते हैं।

सैजमेकर में फाउंडेशन मॉडल

सेजमेकर जंपस्टार्ट हगिंग फेस, पायटोरच हब और टेन्सरफ्लो हब सहित लोकप्रिय मॉडल हब से मॉडलों की एक श्रृंखला तक पहुंच प्रदान करता है, जिसका उपयोग आप सेजमेकर में अपने एमएल डेवलपमेंट वर्कफ़्लो के भीतर कर सकते हैं। एमएल में हाल की प्रगति ने मॉडलों के एक नए वर्ग को जन्म दिया है जिसे कहा जाता है नींव मॉडल, जिन्हें आम तौर पर अरबों मापदंडों पर प्रशिक्षित किया जाता है और इन्हें पाठ सारांशीकरण, डिजिटल कला उत्पन्न करना और भाषा अनुवाद जैसे उपयोग के मामलों की एक विस्तृत श्रेणी में अनुकूलित किया जा सकता है। क्योंकि इन मॉडलों को प्रशिक्षित करना महंगा है, ग्राहक इन मॉडलों को स्वयं प्रशिक्षित करने के बजाय मौजूदा पूर्व-प्रशिक्षित फाउंडेशन मॉडल का उपयोग करना चाहते हैं और आवश्यकतानुसार उन्हें ठीक करना चाहते हैं। सेजमेकर उन मॉडलों की एक क्यूरेटेड सूची प्रदान करता है जिन्हें आप सेजमेकर कंसोल पर चुन सकते हैं।

अब आप सेजमेकर जम्पस्टार्ट के भीतर विभिन्न मॉडल प्रदाताओं से फाउंडेशन मॉडल पा सकते हैं, जिससे आप फाउंडेशन मॉडल के साथ जल्दी से शुरुआत कर सकेंगे। सेजमेकर जम्पस्टार्ट विभिन्न कार्यों या मॉडल प्रदाताओं के आधार पर फाउंडेशन मॉडल प्रदान करता है, और आप आसानी से मॉडल विशेषताओं और उपयोग की शर्तों की समीक्षा कर सकते हैं। आप परीक्षण यूआई विजेट का उपयोग करके भी इन मॉडलों को आज़मा सकते हैं। जब आप बड़े पैमाने पर फाउंडेशन मॉडल का उपयोग करना चाहते हैं, तो आप मॉडल प्रदाताओं से पूर्व-निर्मित नोटबुक का उपयोग करके सेजमेकर को छोड़े बिना ऐसा कर सकते हैं। क्योंकि मॉडल AWS पर होस्ट और तैनात किए गए हैं, आपको भरोसा है कि आपका डेटा, चाहे मूल्यांकन के लिए या बड़े पैमाने पर मॉडल का उपयोग करने के लिए उपयोग किया जाता है, तीसरे पक्ष के साथ साझा नहीं किया जाएगा।

ओपनएआई व्हिस्पर फाउंडेशन मॉडल

व्हिस्पर एएसआर और वाक् अनुवाद के लिए एक पूर्व-प्रशिक्षित मॉडल है। पेपर में व्हिस्पर का प्रस्ताव रखा गया था बड़े पैमाने पर कमजोर पर्यवेक्षण के माध्यम से मजबूत भाषण पहचान ओपनएआई से एलेक रैडफोर्ड और अन्य द्वारा। मूल कोड पाया जा सकता है इस GitHub रिपॉजिटरी में.

व्हिस्पर एक ट्रांसफार्मर-आधारित एनकोडर-डिकोडर मॉडल है, जिसे ए के रूप में भी जाना जाता है क्रम-दर-क्रम नमूना। इसे बड़े पैमाने पर कमजोर पर्यवेक्षण का उपयोग करके एनोटेट किए गए 680 हजार घंटों के लेबल भाषण डेटा पर प्रशिक्षित किया गया था। व्हिस्पर मॉडल फ़ाइन-ट्यूनिंग की आवश्यकता के बिना कई डेटासेट और डोमेन को सामान्यीकृत करने की एक मजबूत क्षमता प्रदर्शित करते हैं।

मॉडलों को या तो केवल अंग्रेजी डेटा या बहुभाषी डेटा पर प्रशिक्षित किया गया था। केवल अंग्रेजी मॉडलों को वाक् पहचान के कार्य पर प्रशिक्षित किया गया था। बहुभाषी मॉडलों को वाक् पहचान और वाक् अनुवाद पर प्रशिक्षित किया गया। वाक् पहचान के लिए, मॉडल ट्रांसक्रिप्शन की भविष्यवाणी करता है वही ऑडियो के रूप में भाषा. वाक् अनुवाद के लिए, मॉडल प्रतिलेखन की भविष्यवाणी करता है विभिन्न ऑडियो के लिए भाषा.

व्हिस्पर चेकप्वाइंट अलग-अलग मॉडल आकार के पांच कॉन्फ़िगरेशन में आते हैं। सबसे छोटे चार को या तो केवल अंग्रेजी या बहुभाषी डेटा पर प्रशिक्षित किया जाता है। सबसे बड़ी चौकियाँ केवल बहुभाषी हैं। सभी दस पूर्व-प्रशिक्षित चौकियाँ पर उपलब्ध हैं हगिंग फेस हब. हब पर मॉडलों के लिंक के साथ चौकियों को निम्नलिखित तालिका में संक्षेपित किया गया है:

| मॉडल का नाम | पैरामीटरों की संख्या | बहुभाषी |

| फुसफुसाहट-छोटी | 39 एम | हाँ |

| फुसफुसाहट-आधार | 74 एम | हाँ |

| फुसफुसाहट-छोटा | 244 एम | हाँ |

| फुसफुसाहट-मध्यम | 769 एम | हाँ |

| फुसफुसाहट-बड़ा | 1550 एम | हाँ |

| फुसफुसाहट-बड़ा-v2 | 1550 एम | हाँ |

आइए जानें कि आप सेजमेकर जम्पस्टार्ट में व्हिस्पर मॉडल का उपयोग कैसे कर सकते हैं।

ओपनएआई व्हिस्पर फाउंडेशन मॉडल WER और विलंबता तुलना

विभिन्न OpenAI व्हिस्पर मॉडल के लिए शब्द त्रुटि दर (WER) पर आधारित है लिब्रिस्पीच टेस्ट-क्लीन निम्न तालिका में दर्शाया गया है। WER वाक् पहचान या मशीनी अनुवाद प्रणाली के प्रदर्शन के लिए एक सामान्य मीट्रिक है। यह संदर्भ पाठ (जमीनी सच्चाई या सही प्रतिलेखन) और एएसआर सिस्टम के आउटपुट के बीच अंतर को त्रुटियों की संख्या के संदर्भ में मापता है, जिसमें प्रतिस्थापन, सम्मिलन और विलोपन शामिल हैं जो एएसआर आउटपुट को संदर्भ में बदलने के लिए आवश्यक हैं। मूलपाठ। ये नंबर से लिए गए हैं गले लगना वेबसाइट।

| आदर्श | WER (प्रतिशत) |

| फुसफुसाहट-छोटी | 7.54 |

| फुसफुसाहट-आधार | 5.08 |

| फुसफुसाहट-छोटा | 3.43 |

| फुसफुसाहट-मध्यम | 2.9 |

| फुसफुसाहट-बड़ा | 3 |

| फुसफुसाहट-बड़ा-v2 | 3 |

इस ब्लॉग के लिए, हमने नीचे दी गई ऑडियो फ़ाइल ली और विभिन्न व्हिस्पर मॉडलों में वाक् पहचान की विलंबता की तुलना की। विलंबता उस समय की समयावधि है जब कोई उपयोगकर्ता अनुरोध भेजता है जब तक कि आपका एप्लिकेशन यह संकेत नहीं देता कि अनुरोध पूरा हो गया है। निम्न तालिका में संख्याएँ ml.g100xlarge इंस्टेंस पर होस्ट किए गए मॉडल के साथ समान ऑडियो फ़ाइल का उपयोग करके कुल 5.2 अनुरोधों के लिए औसत विलंबता का प्रतिनिधित्व करती हैं।

| आदर्श | औसत विलंबता | मॉडल आउटपुट |

| फुसफुसाहट-छोटी | 0.43 | हम मशीनी प्रकाश व्यवस्था के साथ बहुत ही रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन अगले आने वाले वर्षों में आप उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जहां हमने जीत हासिल की है। जब तक हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

| फुसफुसाहट-आधार | 0.49 | हम मशीन लर्निंग के साथ बहुत रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन अगले आने वाले वर्षों में आप उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जहां हमने जीत हासिल की है। जब तक हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

| फुसफुसाहट-छोटा | 0.84 | हम मशीन लर्निंग के साथ बहुत रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन आप अगले आने वाले वर्षों में उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जो हम चाहते हैं जब तक कि हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

| फुसफुसाहट-मध्यम | 1.5 | हम मशीन लर्निंग के साथ बहुत रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन आप अगले आने वाले वर्षों में उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जो हम चाहते हैं जब तक कि हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

| फुसफुसाहट-बड़ा | 1.96 | हम मशीन लर्निंग के साथ बहुत रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन आप अगले आने वाले वर्षों में उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जो हम चाहते हैं जब तक कि हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

| फुसफुसाहट-बड़ा-v2 | 1.98 | हम मशीन लर्निंग के साथ बहुत रोमांचक समय में रह रहे हैं। एमएल मॉडल विकास की गति वास्तव में बढ़ेगी। लेकिन आप अगले आने वाले वर्षों में उस अंतिम स्थिति तक नहीं पहुंच पाएंगे जो हम चाहते हैं जब तक कि हम वास्तव में इन मॉडलों को हर किसी के लिए अधिक सुलभ नहीं बनाते। |

समाधान वॉकथ्रू

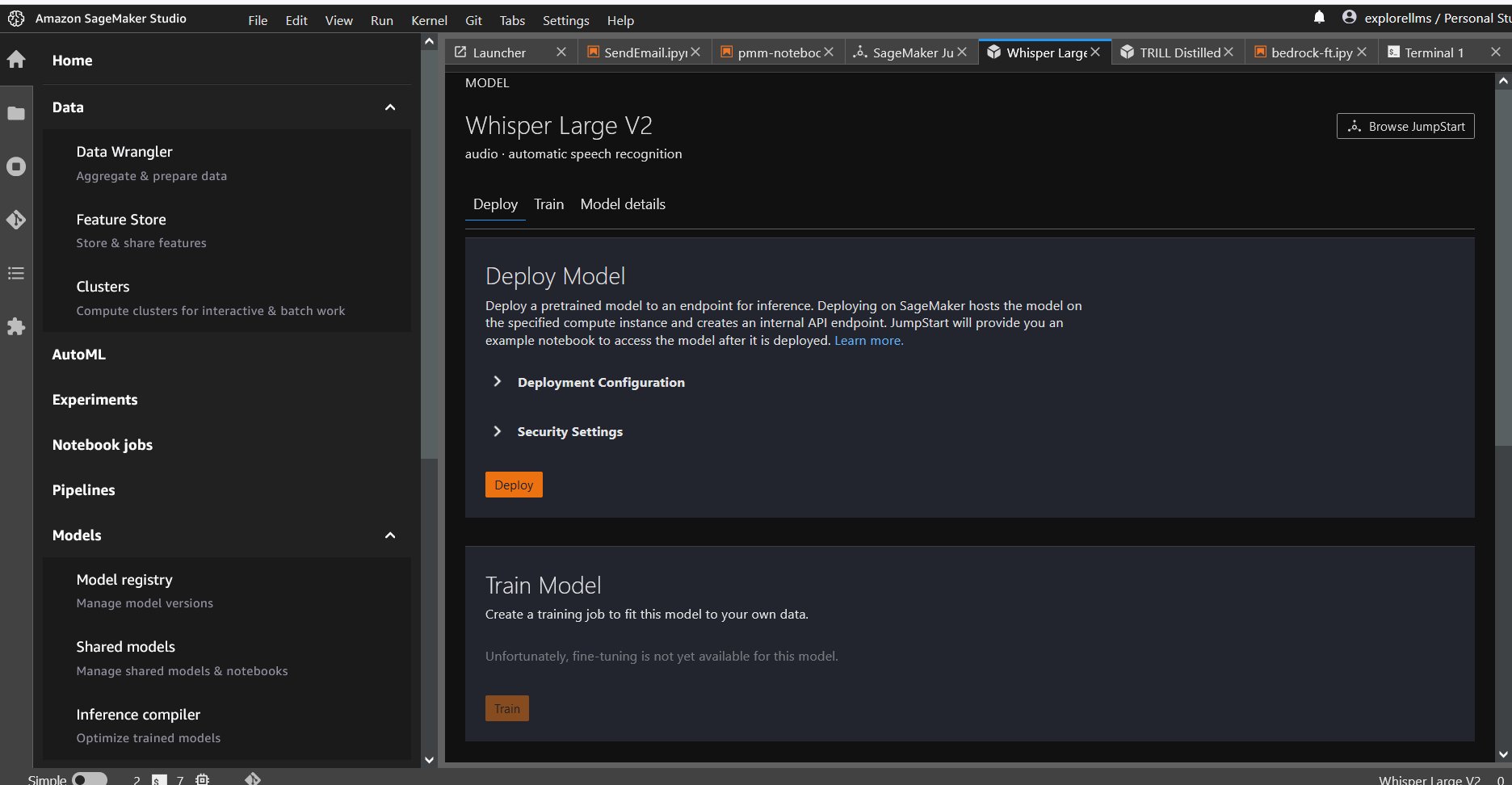

आप अमेज़ॅन सेजमेकर कंसोल का उपयोग करके या अमेज़ॅन सेजमेकर नोटबुक का उपयोग करके व्हिस्पर मॉडल तैनात कर सकते हैं। इस पोस्ट में, हम प्रदर्शित करते हैं कि सेजमेकर स्टूडियो कंसोल या सेजमेकर नोटबुक का उपयोग करके व्हिस्पर एपीआई को कैसे तैनात किया जाए और फिर वाक् पहचान और भाषा अनुवाद के लिए तैनात मॉडल का उपयोग किया जाए। इस पोस्ट में प्रयुक्त कोड यहां पाया जा सकता है यह GitHub नोटबुक.

आइए प्रत्येक चरण का विस्तार से विस्तार करें।

कंसोल से व्हिस्पर तैनात करें

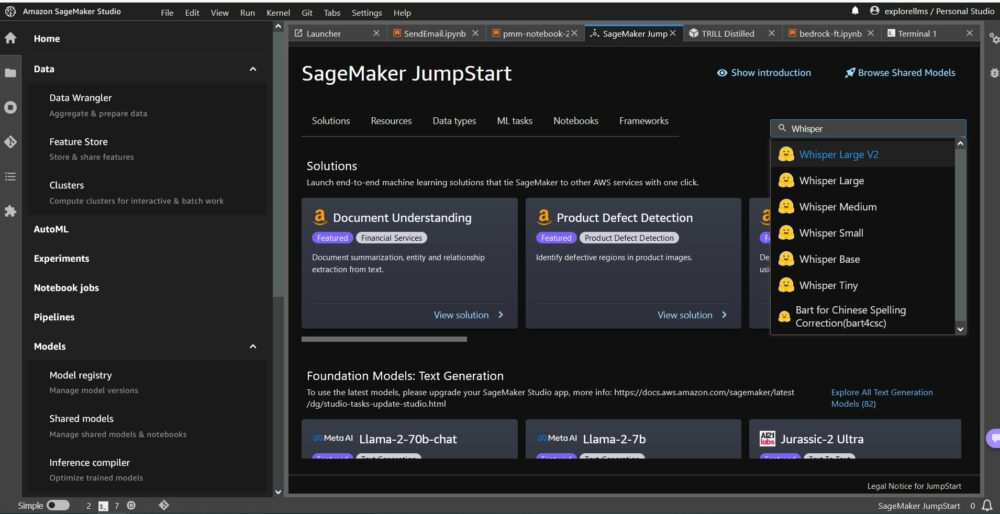

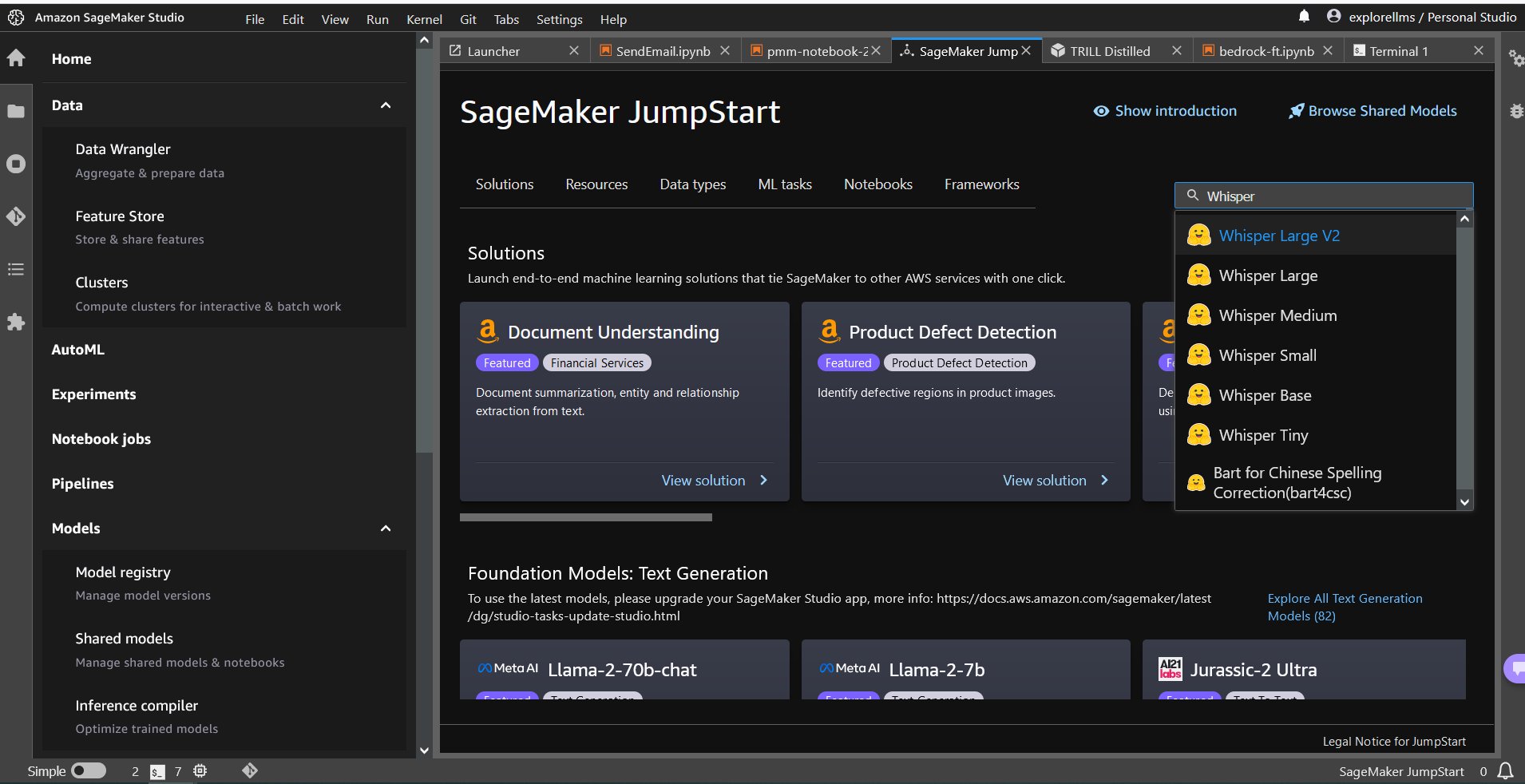

- सेजमेकर जंपस्टार्ट के साथ आरंभ करने के लिए, अमेज़ॅन सेजमेकर स्टूडियो कंसोल खोलें और सेजमेकर जंपस्टार्ट के लॉन्च पेज पर जाएं और चुनें जम्पस्टार्ट के साथ आरंभ करें.

- व्हिस्पर मॉडल चुनने के लिए, आप या तो शीर्ष पर टैब का उपयोग कर सकते हैं या शीर्ष दाईं ओर खोज बॉक्स का उपयोग कर सकते हैं जैसा कि निम्नलिखित स्क्रीनशॉट में दिखाया गया है। इस उदाहरण के लिए, शीर्ष दाईं ओर स्थित खोज बॉक्स का उपयोग करें और दर्ज करें

Whisper, और फिर ड्रॉपडाउन मेनू से उपयुक्त व्हिस्पर मॉडल का चयन करें।

- व्हिस्पर मॉडल का चयन करने के बाद, आप मॉडल को तैनात करने के लिए कंसोल का उपयोग कर सकते हैं। आप परिनियोजन के लिए एक उदाहरण का चयन कर सकते हैं या डिफ़ॉल्ट का उपयोग कर सकते हैं।

सेजमेकर नोटबुक से फाउंडेशन मॉडल तैनात करें

विभिन्न कार्यों को हल करने के लिए पहले तैनात करने और फिर तैनात मॉडल का उपयोग करने के चरण हैं:

- सेट अप

- एक मॉडल चुनें

- कलाकृतियों को पुनः प्राप्त करें और एक समापन बिंदु तैनात करें

- ASR के लिए परिनियोजित मॉडल का उपयोग करें

- भाषा अनुवाद के लिए परिनियोजित मॉडल का उपयोग करें

- समापन बिंदु साफ़ करें

सेट अप

इस नोटबुक का परीक्षण सेजमेकर स्टूडियो में एमएल.टी3.मीडियम इंस्टेंस पर पायथन 3 (डेटा साइंस) कर्नेल के साथ और अमेज़ॅन सेजमेकर नोटबुक इंस्टेंस में किया गया था। conda_python3 गिरी।

एक पूर्व प्रशिक्षित मॉडल का चयन करें

Boto3 का उपयोग करके एक सेजमेकर सत्र सेट करें, और फिर उस मॉडल आईडी का चयन करें जिसे आप तैनात करना चाहते हैं।

कलाकृतियों को पुनः प्राप्त करें और एक समापन बिंदु तैनात करें

सेजमेकर का उपयोग करके, आप पूर्व-प्रशिक्षित मॉडल पर अनुमान लगा सकते हैं, यहां तक कि इसे पहले नए डेटासेट पर ठीक किए बिना भी। पूर्व-प्रशिक्षित मॉडल को होस्ट करने के लिए, इसका एक उदाहरण बनाएं सेजमेकर.मॉडल.मॉडल और इसे तैनात करें. निम्न कोड डिफ़ॉल्ट उदाहरण का उपयोग करता है ml.g5.2xlarge व्हिस्पर-लार्ज-वी2 मॉडल के अनुमान समापन बिंदु के लिए। आप पास करके मॉडल को अन्य इंस्टेंस प्रकारों पर तैनात कर सकते हैं instance_type में JumpStartModel कक्षा। तैनाती में कुछ मिनट लग सकते हैं.

स्वचालित भाषण मान्यता

इसके बाद, आप सेजमेकर जम्पस्टार्ट पब्लिक से नमूना ऑडियो फ़ाइल, नमूना1.wav पढ़ें अमेज़न सरल भंडारण सेवा (अमेज़न S3) स्थान और इसे पास करें भविष्यवक्ता वाक् पहचान के लिए. आप इस नमूना फ़ाइल को किसी अन्य नमूना ऑडियो फ़ाइल से बदल सकते हैं, लेकिन सुनिश्चित करें कि .wav फ़ाइल 16 kHz पर नमूना है क्योंकि स्वचालित वाक् पहचान मॉडल के लिए यह आवश्यक है। इनपुट ऑडियो फ़ाइल 30 सेकंड से कम होनी चाहिए।

अनुमान लगाते समय यह मॉडल कई मापदंडों का समर्थन करता है। वे सम्मिलित करते हैं:

max_length: मॉडल आउटपुट लंबाई तक टेक्स्ट उत्पन्न करता है। यदि निर्दिष्ट किया गया है, तो यह एक धनात्मक पूर्णांक होना चाहिए।- भाषा और कार्य: यहां आउटपुट भाषा और कार्य निर्दिष्ट करें। मॉडल प्रतिलेखन या अनुवाद के कार्य का समर्थन करता है।

max_new_tokens: उत्पन्न करने के लिए टोकन की अधिकतम संख्या।num_return_sequences: लौटाए गए आउटपुट अनुक्रमों की संख्या। यदि निर्दिष्ट किया गया है, तो यह एक धनात्मक पूर्णांक होना चाहिए।num_beams: लालची खोज में प्रयुक्त बीमों की संख्या। यदि निर्दिष्ट किया गया है, तो यह पूर्णांक से बड़ा या उसके बराबर होना चाहिएnum_return_sequences.no_repeat_ngram_size: मॉडल यह सुनिश्चित करता है कि शब्दों का एक क्रम होno_repeat_ngram_sizeआउटपुट अनुक्रम में दोहराया नहीं जाता है। यदि निर्दिष्ट किया गया है, तो यह 1 से बड़ा एक धनात्मक पूर्णांक होना चाहिए।- तापमान: यह आउटपुट में यादृच्छिकता को नियंत्रित करता है। उच्च तापमान के परिणामस्वरूप कम-संभावना वाले शब्दों के साथ आउटपुट अनुक्रम होता है और कम तापमान के परिणामस्वरूप उच्च-संभावना वाले शब्दों के साथ आउटपुट अनुक्रम होता है। यदि तापमान 0 के करीब पहुंचता है, तो इसका परिणाम लालची डिकोडिंग होता है। यदि निर्दिष्ट किया गया है, तो यह एक सकारात्मक फ़्लोट होना चाहिए।

early_stopping: अगरTrue, जब सभी बीम परिकल्पनाएं वाक्य टोकन के अंत तक पहुंच जाती हैं, तो पाठ निर्माण समाप्त हो जाता है। यदि निर्दिष्ट किया गया है, तो यह बूलियन होना चाहिए।do_sample: अगरTrue, संभावना के लिए अगले शब्द का नमूना लें। यदि निर्दिष्ट किया गया है, तो यह बूलियन होना चाहिए।top_k: पाठ निर्माण के प्रत्येक चरण में, केवल से नमूनाtop_kसबसे अधिक संभावना शब्द। यदि निर्दिष्ट किया गया है, तो यह एक धनात्मक पूर्णांक होना चाहिए।top_p: पाठ निर्माण के प्रत्येक चरण में, संचयी संभाव्यता वाले शब्दों के सबसे छोटे संभव सेट से नमूना लेंtop_p. यदि निर्दिष्ट किया गया है, तो यह 0 और 1 के बीच फ़्लोट होना चाहिए।

किसी समापन बिंदु को लागू करते समय आप पूर्ववर्ती मापदंडों का कोई भी सबसेट निर्दिष्ट कर सकते हैं। आगे, हम आपको एक उदाहरण दिखाते हैं कि इन तर्कों के साथ समापन बिंदु कैसे लागू किया जाए।

भाषा का अनुवाद

व्हिस्पर मॉडल का उपयोग करके भाषा अनुवाद दिखाने के लिए, फ्रेंच में निम्नलिखित ऑडियो फ़ाइल का उपयोग करें और इसका अंग्रेजी में अनुवाद करें। फ़ाइल का नमूना 16 किलोहर्ट्ज़ (जैसा कि एएसआर मॉडल द्वारा आवश्यक है) पर होना चाहिए, इसलिए यदि आवश्यक हो तो फ़ाइलों को फिर से नमूना करना सुनिश्चित करें और सुनिश्चित करें कि आपके नमूने 30 सेकंड से अधिक न हों।

- डाउनलोड

sample_french1.wavसार्वजनिक S3 स्थान से SageMaker जम्पस्टार्ट से ताकि इसे व्हिस्पर मॉडल द्वारा अनुवाद के लिए पेलोड में पारित किया जा सके।

- कार्य पैरामीटर को इस प्रकार सेट करें

translateऔर भाषा के रूप मेंFrenchव्हिस्पर मॉडल को वाक् अनुवाद करने के लिए बाध्य करना। - उपयोग भविष्यवक्ता भाषा के अनुवाद की भविष्यवाणी करना। यदि आपको क्लाइंट त्रुटि (त्रुटि 413) प्राप्त होती है, तो पेलोड आकार को अंतिम बिंदु तक जांचें। सेजमेकर के लिए एंडपॉइंट अनुरोधों को लागू करने वाले पेलोड लगभग 5 एमबी तक सीमित हैं।

- फ़्रेंच ऑडियो फ़ाइल से अंग्रेजी में अनुवादित टेक्स्ट आउटपुट इस प्रकार है:

क्लीन अप

समापन बिंदु का परीक्षण करने के बाद, शुल्क लगने से बचने के लिए सेजमेकर अनुमान समापन बिंदु को हटा दें और मॉडल को हटा दें।

निष्कर्ष

इस पोस्ट में, हमने आपको दिखाया कि Amazon SageMaker का उपयोग करके दिलचस्प एप्लिकेशन बनाने के लिए OpenAI व्हिस्पर मॉडल का परीक्षण और उपयोग कैसे करें। आज ही सेजमेकर में फाउंडेशन मॉडल आज़माएं और हमें अपनी प्रतिक्रिया बताएं!

यह मार्गदर्शन केवल सूचनात्मक उद्देश्यों के लिए है। आपको अभी भी अपना स्वतंत्र मूल्यांकन करना चाहिए और यह सुनिश्चित करने के लिए उपाय करना चाहिए कि आप अपनी विशिष्ट गुणवत्ता नियंत्रण प्रथाओं और मानकों, और स्थानीय नियमों, कानूनों, विनियमों, लाइसेंसों और उपयोग की शर्तों का अनुपालन करते हैं जो आप, आपकी सामग्री और पर लागू होते हैं। इस मार्गदर्शन में संदर्भित तृतीय-पक्ष मॉडल। इस मार्गदर्शन में संदर्भित तृतीय-पक्ष मॉडल पर AWS का कोई नियंत्रण या अधिकार नहीं है और यह कोई प्रतिनिधित्व या वारंटी नहीं देता है कि तृतीय-पक्ष मॉडल सुरक्षित, वायरस-मुक्त, परिचालनात्मक या आपके उत्पादन वातावरण और मानकों के अनुकूल है। AWS कोई प्रतिनिधित्व, वारंटी या गारंटी नहीं देता है कि इस मार्गदर्शन में किसी भी जानकारी का कोई विशेष परिणाम या परिणाम होगा।

लेखक के बारे में

हेमंत सिंह अमेज़ॅन सेजमेकर जम्पस्टार्ट में अनुभव के साथ एक एप्लाइड साइंटिस्ट हैं। उन्होंने कूरेंट इंस्टीट्यूट ऑफ मैथमैटिकल साइंसेज से मास्टर डिग्री और आईआईटी दिल्ली से बी.टेक की डिग्री हासिल की। उनके पास प्राकृतिक भाषा प्रसंस्करण, कंप्यूटर दृष्टि और समय श्रृंखला विश्लेषण के क्षेत्र में मशीन सीखने की विभिन्न समस्याओं पर काम करने का अनुभव है।

हेमंत सिंह अमेज़ॅन सेजमेकर जम्पस्टार्ट में अनुभव के साथ एक एप्लाइड साइंटिस्ट हैं। उन्होंने कूरेंट इंस्टीट्यूट ऑफ मैथमैटिकल साइंसेज से मास्टर डिग्री और आईआईटी दिल्ली से बी.टेक की डिग्री हासिल की। उनके पास प्राकृतिक भाषा प्रसंस्करण, कंप्यूटर दृष्टि और समय श्रृंखला विश्लेषण के क्षेत्र में मशीन सीखने की विभिन्न समस्याओं पर काम करने का अनुभव है।

रचना चड्ढा AWS में रणनीतिक खातों में एक प्रमुख समाधान वास्तुकार AI/ML है। रचना एक आशावादी है जो मानती है कि एआई का नैतिक और जिम्मेदार उपयोग भविष्य में समाज को बेहतर बना सकता है और आर्थिक और सामाजिक समृद्धि ला सकता है। अपने खाली समय में रचना को अपने परिवार के साथ समय बिताना, लंबी पैदल यात्रा करना और संगीत सुनना पसंद है।

रचना चड्ढा AWS में रणनीतिक खातों में एक प्रमुख समाधान वास्तुकार AI/ML है। रचना एक आशावादी है जो मानती है कि एआई का नैतिक और जिम्मेदार उपयोग भविष्य में समाज को बेहतर बना सकता है और आर्थिक और सामाजिक समृद्धि ला सकता है। अपने खाली समय में रचना को अपने परिवार के साथ समय बिताना, लंबी पैदल यात्रा करना और संगीत सुनना पसंद है।

डॉ आशीष खेतानी Amazon SageMaker बिल्ट-इन एल्गोरिदम के साथ एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय उरबाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने NeurIPS, ICML, ICLR, JMLR, ACL और EMNLP सम्मेलनों में कई पत्र प्रकाशित किए हैं।

डॉ आशीष खेतानी Amazon SageMaker बिल्ट-इन एल्गोरिदम के साथ एक वरिष्ठ एप्लाइड साइंटिस्ट हैं और मशीन लर्निंग एल्गोरिदम विकसित करने में मदद करते हैं। उन्होंने इलिनोइस विश्वविद्यालय उरबाना-शैंपेन से पीएचडी की उपाधि प्राप्त की। वह मशीन लर्निंग और सांख्यिकीय अनुमान में एक सक्रिय शोधकर्ता हैं, और उन्होंने NeurIPS, ICML, ICLR, JMLR, ACL और EMNLP सम्मेलनों में कई पत्र प्रकाशित किए हैं।

- एसईओ संचालित सामग्री और पीआर वितरण। आज ही प्रवर्धित हो जाओ।

- प्लेटोडेटा.नेटवर्क वर्टिकल जेनरेटिव एआई। स्वयं को शक्तिवान बनाएं। यहां पहुंचें।

- प्लेटोआईस्ट्रीम। Web3 इंटेलिजेंस। ज्ञान प्रवर्धित। यहां पहुंचें।

- प्लेटोईएसजी. कार्बन, क्लीनटेक, ऊर्जा, पर्यावरण, सौर, कचरा प्रबंधन। यहां पहुंचें।

- प्लेटोहेल्थ। बायोटेक और क्लिनिकल परीक्षण इंटेलिजेंस। यहां पहुंचें।

- स्रोत: https://aws.amazon.com/blogs/machine-learning/whisper-models-for-automatic-speech-recognition-now-available-in-amazon-sagemaker-jumpstart/

- :हैस

- :है

- :नहीं

- $यूपी

- 1

- 10

- 100

- 12

- 14

- 15% तक

- 150

- 16

- 30

- 7

- 8

- 9

- a

- क्षमता

- About

- पहुँच

- सुलभ

- अकौन्टस(लेखा)

- के पार

- सक्रिय

- वास्तव में

- इसके अलावा

- अग्रिमों

- AI

- ऐ / एमएल

- एल्गोरिदम

- सब

- भी

- वीरांगना

- अमेज़न SageMaker

- अमेज़न SageMaker जम्पस्टार्ट

- अमेज़ॅन सैजमेकर स्टूडियो

- अमेज़ॅन वेब सेवा

- राशि

- an

- विश्लेषण

- और

- की घोषणा

- कोई

- एपीआई

- आवेदन

- अनुप्रयोगों

- लागू

- लागू करें

- दृष्टिकोण

- उपयुक्त

- हैं

- तर्क

- कला

- AS

- मूल्यांकन

- At

- ऑडियो

- अधिकार

- स्वचालित

- उपलब्ध

- औसत

- से बचने

- एडब्ल्यूएस

- आधारित

- BE

- किरण

- क्योंकि

- किया गया

- का मानना है कि

- नीचे

- के बीच

- अरबों

- ब्लॉग

- मुक्केबाज़ी

- लाना

- निर्माण

- में निर्मित

- लेकिन

- by

- कर सकते हैं

- मामलों

- वर्ग

- विशेषताएँ

- प्रभार

- चेक

- चुनें

- कक्षा

- ग्राहक

- कोड

- कैसे

- अ रहे है

- सामान्य

- तुलना

- संगत

- पूरा

- पालन करना

- कंप्यूटर

- Computer Vision

- सम्मेलनों

- कंसोल

- कंटेनर

- सामग्री

- लगातार

- नियंत्रण

- नियंत्रण

- सही

- बनाना

- क्यूरेट

- ग्राहक

- ग्राहक

- तिथि

- डेटा विज्ञान

- डेटासेट

- डिकोडिंग

- चूक

- दिल्ली

- दिखाना

- तैनात

- तैनात

- तैनाती

- विस्तार

- विकसित करना

- विकसित

- विकास

- अंतर

- विभिन्न

- डिजिटल

- डिजिटल कला

- कई

- do

- कर देता है

- डोमेन

- डोमेन

- dont

- से प्रत्येक

- आसानी

- भी

- कर्मचारियों

- सक्षम

- समर्थकारी

- समाप्त

- शुरू से अंत तक

- endpoint

- अंग्रेज़ी

- सुनिश्चित

- सुनिश्चित

- दर्ज

- वातावरण

- बराबर

- त्रुटि

- त्रुटियाँ

- नैतिक

- का मूल्यांकन

- और भी

- हर

- उदाहरण

- से अधिक

- उत्तेजित

- उत्तेजक

- मौजूदा

- विस्तार

- महंगा

- अनुभव

- का पता लगाने

- चेहरा

- परिवार

- कुछ

- पट्टिका

- फ़ाइलें

- खोज

- प्रथम

- पांच

- नाव

- निम्नलिखित

- इस प्रकार है

- के लिए

- सेना

- पाया

- बुनियाद

- चार

- फ्रेंच

- से

- भविष्य

- उत्पन्न

- उत्पन्न करता है

- सृजन

- पीढ़ी

- मिल

- GitHub

- दी

- Go

- मिला

- अधिक से अधिक

- लालची

- जमीन

- गारंटी देता है

- मार्गदर्शन

- है

- होने

- he

- मदद

- मदद करता है

- उसे

- यहाँ उत्पन्न करें

- उच्चतर

- उसके

- मेजबान

- मेजबानी

- घंटे

- कैसे

- How To

- एचटीएमएल

- HTTPS

- हब

- केन्द्रों

- ID

- if

- इलेनॉइस

- आयात

- में सुधार

- in

- शामिल

- सहित

- बढ़ना

- स्वतंत्र

- इंगित करता है

- करें-

- सूचना

- निवेश

- स्थापित

- उदाहरण

- संस्थान

- दिलचस्प

- में

- अलगाव

- IT

- जेपीजी

- JSON

- जानना

- जानने वाला

- भाषा

- बड़े पैमाने पर

- सबसे बड़ा

- विलंब

- लांच

- कानून

- सीख रहा हूँ

- छोड़ने

- लंबाई

- कम

- चलो

- लाइसेंस

- प्रकाश

- संभावना

- संभावित

- को यह पसंद है

- सीमित

- लिंक

- सूची

- सुनना

- जीवित

- स्थानीय

- स्थान

- कम

- मशीन

- यंत्र अधिगम

- बनाए रखना

- बनाना

- बहुत

- गणितीय

- अधिकतम

- उपायों

- मध्यम

- मेन्यू

- मीट्रिक

- हो सकता है

- मिनटों

- ML

- आदर्श

- मॉडल

- पल

- अधिक

- अधिकांश

- संगीत

- चाहिए

- प्राकृतिक

- प्राकृतिक भाषा संसाधन

- आवश्यकता

- जरूरत

- नेटवर्क

- नया

- अगला

- नहीं

- कोई नहीं

- नोटबुक

- अभी

- संख्या

- संख्या

- of

- ऑफर

- on

- केवल

- खुला

- OpenAI

- परिचालन

- or

- मूल

- अन्य

- अन्य

- आउट

- परिणाम

- उत्पादन

- बाहर

- के ऊपर

- अपना

- पृष्ठ

- कागजात

- प्राचल

- पैरामीटर

- विशेष

- पार्टियों

- पास

- पारित कर दिया

- पेटेंट

- प्रतिशत

- निष्पादन

- प्रदर्शन

- प्रदर्शन

- पीएचडी

- प्लेटो

- प्लेटो डेटा इंटेलिजेंस

- प्लेटोडाटा

- कृप्या अ

- लोकप्रिय

- सकारात्मक

- संभव

- पद

- प्रथाओं

- भविष्यवाणी करना

- Predictor

- भविष्यवाणी

- प्रिंसिपल

- समस्याओं

- प्रसंस्करण

- उत्पादन

- प्रस्तावित

- समृद्धि

- प्रदाताओं

- प्रदान करता है

- सार्वजनिक

- प्रकाशित

- प्रयोजनों

- अजगर

- pytorch

- गुणवत्ता

- जल्दी से

- अनियमितता

- रेंज

- मूल्यांकन करें

- बल्कि

- पहुंच

- पढ़ना

- वास्तव में

- प्राप्त करना

- हाल

- मान्यता

- संदर्भ

- निर्दिष्ट

- नियम

- दोहराया गया

- की जगह

- प्रतिनिधित्व

- का अनुरोध

- अनुरोधों

- अपेक्षित

- शोधकर्ता

- प्रतिक्रिया

- जिम्मेदार

- परिणाम

- परिणाम

- की समीक्षा

- सही

- वृद्धि

- नियम

- s

- sagemaker

- सेजमेकर अनुमान

- विक्रय

- वही

- स्केल

- विज्ञान

- विज्ञान

- वैज्ञानिक

- लिपि

- एसडीके

- Search

- सेकंड

- सुरक्षित

- सुरक्षा

- भेजता

- वरिष्ठ

- वाक्य

- अनुक्रम

- कई

- सेवा

- सेवाएँ

- सत्र

- सेट

- साझा

- चाहिए

- दिखाना

- प्रदर्शन

- पता चला

- दिखाया

- सरल

- आकार

- आकार

- So

- सोशल मीडिया

- समाज

- समाधान

- हल

- विशिष्ट

- विनिर्दिष्ट

- भाषण

- वाक् पहचान

- गति

- खर्च

- मानकों

- शुरू

- राज्य

- सांख्यिकीय

- कदम

- कदम

- फिर भी

- भंडारण

- सामरिक

- मजबूत

- स्टूडियो

- ऐसा

- पर्यवेक्षण

- समर्थन करता है

- निश्चित

- प्रणाली

- तालिका

- लेना

- लिया

- कार्य

- कार्य

- तकनीक

- टेम्पलेट्स

- दस

- tensorflow

- शर्तों

- परीक्षण

- परीक्षण किया

- टेक्स्ट

- से

- कि

- RSI

- केंद्र

- उन

- अपने

- फिर

- इन

- वे

- तीसरा

- तीसरे पक्ष

- तीसरे दल

- इसका

- हज़ार

- पहर

- समय श्रृंखला

- बार

- सेवा मेरे

- आज

- टोकन

- टोकन

- ले गया

- ऊपर का

- कुल

- रेलगाड़ी

- प्रशिक्षित

- बदालना

- अनुवाद करना

- अनुवाद करें

- ट्रस्ट

- सच

- कोशिश

- प्रकार

- आम तौर पर

- ui

- विश्वविद्यालय

- जब तक

- us

- प्रयोग

- उपयोग

- प्रयुक्त

- उपयोगकर्ता

- का उपयोग करता है

- का उपयोग

- मूल्य

- परिवर्तनीय

- बहुत

- के माध्यम से

- दृष्टि

- करना चाहते हैं

- था

- we

- वेब

- वेब सेवाओं

- में आपका स्वागत है

- थे

- कब

- या

- कौन कौन से

- फुसफुसाना

- कौन

- चौड़ा

- मर्जी

- साथ में

- अंदर

- बिना

- जीत लिया

- शब्द

- शब्द

- वर्कफ़्लो

- काम कर रहे

- साल

- आप

- आपका

- जेफिरनेट