Megjegyzés Formálódik a Microsoft azon meghatározása, hogy mi minősül AI PC-nek és mi nem. A Windows legújabb verziójával, egy dedikált másodpilóta kulccsal és egy másodpercenként legalább 40 billió műveletre képes NPU-val hamarosan a Microsoft Copilot helyileg is futtatható lesz a gépén.

Redmondé követelmények A Windows rendszeren futó mesterséges intelligencia modelljét az Intel – az AI PC kategória egyik legerősebb pompomlánya – hivatalossá tette a chipóriás működése során. AI csúcstalálkozó ezen a héten Tajpejben.

Egy nagy nyelvi modell (LLM) helyi futtatása bizonyos előnyökkel jár. A végfelhasználóknak alacsonyabb késleltetéssel és ezáltal jobb válaszidővel kell rendelkezniük, mivel nem kell lekérdezéseket távoli adatközpontba küldeni és onnan elküldeni, és elméletileg nagyobb az adatvédelem. Eközben a Microsoft számára, ha a mesterséges intelligencia munkaterhelésének nagyobb részét az ügyfelek eszközeire helyezi, felszabadítja saját erőforrásait más feladatokra, például a következő OpenAI-modell betanítására vagy felhő API-ként való felkínálására.

A Microsoft azt reméli, hogy a Copilot LLM-jét végül teljes egészében az NPU-kon vagy neurális feldolgozóegységeken fogja futtatni az emberek Windows AI PC-jén. észrevételeket nyilván az Intel vezetői készítettek a csúcson. Elképzelhetjük, hogy az x86-os goliath ezt a vonalat erősíti, hogy mindenkit meggyőzzen arról, hogy a szilícium elég erős ahhoz, hogy otthon vagy az irodában működtesse Redmond cuccait.

Bár a másodpilóta Azure köldökből való leválasztásának ötlete vonzó lehet egyesek számára, úgy tűnik, nem mindenki rajong Clippy megtestesült és legalább bizonyos mennyiségű feldolgozás szinte biztosan a felhőben fog megtörténni a belátható jövőben.

Az Intel vezetői annyit mondtak: a gyorsabb hardver lehetővé teszi a Copilot több „elemének” helyi futtatását. Más szavakkal, továbbra is a hálózati kapcsolatra lesz szüksége legalább a funkciók egy részében, a többit pedig az AI PC maga fogja megoldani.

Az ok nem érhet olyan nagy meglepetést. Ezeknek az AI PC-knek véges erőforrásai vannak, és a Copilotot – az OpenAI GPT-4-ét – működtető modell óriási. Nem tudjuk pontosan, mekkora verziót használ a Microsoft, de becslések a teljes GPT-4 modellt körülbelül 1.7 billió paraméterre állítja. Még a kvantálás vagy a modell INT4-en való futtatása esetén is körülbelül 900 GB memóriára lesz szüksége.

Hogyan gondoljuk, hogy működni fog

A GPT-4 egy úgynevezett vegyes szakértői modell. Dióhéjban ez azt jelenti, hogy valójában számos kisebb, speciális, előre betanított modellből áll össze, amelyekhez a lekérdezéseket továbbítják. Ha több modellt optimalizálunk szöveggenerálásra, összegzésre, kódkészítésre és így tovább, a következtetések teljesítménye javítható, mivel a teljes modellnek nem kell futnia egy feladat elvégzéséhez.

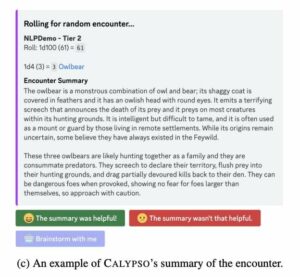

Az Intel által használt „elemek” kifejezés a Copilot funkcióinak helyi leírására azt sugallja, hogy e szakértők némelyike helyettesíthető kisebb, ügyesebb, laptop hardveren futtatható modellekkel. Amint azt korábban feltártuk, a meglévő személyes hardver több mint alkalmas kisebb AI modellek futtatására, mint például a Mistral vagy a Meta.

Véletlenül a Microsoft nemrég szivattyúzott 15 millió euró (16.3 millió dollár) a francia Mistral AI minimodell-készítőjébe, amelynek munkáját az Azure-ügyfelek rendelkezésére bocsátja. A mindössze 7 milliárd paraméteres méretével a Mistral-7B minden bizonnyal elég kicsi ahhoz, hogy kényelmesen elférjen egy mesterséges intelligencia PC memóriájában, és 4 bites kvantálás esetén 4 GB memóriát igényel.

És ez egy általános célú modellre vonatkozik. Elképzelhető, hogy még kisebb, forráskód-generálásra hangolt modellekkel is boldogulhat, amelyek csak akkor töltődnek be a memóriába, amikor az alkalmazás, mondjuk a Visual Studio Code elindul, és aktív Github Copilot előfizetést észlel. Ne feledje, a Copilot több, mint egy chatbot; ez a mesterséges intelligencia-szolgáltatások sorozata, amelyek beépülnek a Microsoft operációs rendszerébe és szoftverkönyvtárába.

Redmond nem mondta el, hogy mennyi memóriát igényel az AI PC specifikációja, de tapasztalataink szerint helyi LLM-ek16 GB gyors DDR5-nek megfelelőnek kell lennie.

Bármilyen utat is választ a Microsoft, a helyi és távoli modellek kombinációja érdekes viselkedéshez vezethet. Egyelőre nem tudjuk, hogy ezek a helyi modellek milyen körülmények között veszik át az irányítást, de a Microsoft Windows Devices vállalati vezérigazgatója, Pavan Davuluri azt javasolta, hogy a keverék dinamikus lehet.

„Szeretnénk betölteni az eltolódást a felhő és a kliens között, hogy a legjobb számítástechnikát biztosíthassuk mindkét világban” – mondta a színpadon az AMD Advancing AI során. esemény decemberben. „Egyesíti a helyi számítástechnika előnyeit, például a fokozott adatvédelmet, válaszkészséget és késleltetést a felhő erejével, a nagy teljesítményű modelleket, a nagy adatkészleteket és a platformok közötti következtetéseket.”

Mint ilyen, láthatunk néhány forgatókönyvet, hogyan használhatja a Microsoft a helyi AI-t. Az első az, hogy a munkát le kell rakni a Microsoft szervereiről, és javítani kell a válaszidőket. A hardver fejlődésével egyre több Copilot-funkció kerülhet ki a felhőből a felhasználói eszközökre.

A második az lenne, ha a hálózati megszakítások esetére visszaesés lenne. Elképzelheti, hogy mesterséges intelligencia számítógépe egyre hülyébb lesz, ahelyett, hogy teljesen leállna, amikor lekapcsolják a hálózatról.

Hardveres korlátok

Mielőtt túlságosan izgalomba jönne az osztott agyú AI PC-k, amelyek off-grid kiáltványokat készítenek, jelenleg nincs olyan gép, amely megfelelne a hardverkövetelményeknek, és ez nem a másodpilóta kulcs hiánya miatt van.

A probléma az, hogy az NPU-k még viszonylag újak az x86-os szilíciumban, és ami létezik, az közel sem elég erős. Az AMD az elsők között volt, aki 2023 elején NPU-val bővítette mobil processzorait Ryzen 7040 sorozat chipek.

Ez a felállás decemberben ütést kapott a House of Zen Advancing AI rendezvényén. Az AMD az asztali számítógépekre is hozta NPU-it az elindításával 8000G APU a CES-en idén januárban.

Az Intel elindította a dedikált AI-gyorsító blokkokat meteor tó mikroprocesszor alkatrészek december végén. Ezek a Core Ultra chipek az Intel Movidius vision feldolgozó egységéből (VPU) származó NPU-val rendelkeznek, amelyet az Intel demózták a tavalyi Innovációs rendezvénye során különféle feladatokat végzett.

Sajnos a chipek csak 10-16 billió (általában INT4) műveletre képesek másodpercenként, ami messze elmarad a Microsoft 40 TOPS specifikációjától. Ez azt jelenti, hogy a piacon lévő úgynevezett mesterséges intelligencia PC-k többsége nem felel meg a követelményeknek – anélkül, hogy a GPU-ra támaszkodna a különbség pótlása érdekében.

Mind az Intel, mind az AMD több képességű chipet tartalmaz Lunar Lake-vel és Strix Point szilíciummal. A közeljövőben azonban úgy tűnik, hogy a Qualcomm sarokba szorítja a piacot.

Notebookok Qualcomm Snapdragon X Elite játékkal mobil processzorok valamikor 2024 közepén jelennek meg, és 45 TOPS-ra képes NPU-val fognak rendelkezni. A 4.6 teraFLOPS FP32 teljesítményre képes Adreno GPU-val kombinálva a Qualcomm azt állítja, hogy az alkatrész akár 13 milliárd AI-modellek futtatására is képes lesz teljes egészében az eszközön, és másodpercenként 30 tokent generál kisebb, 7 milliárd paraméterű LLM-ek futtatásakor.

Ahogy megérkeznek a nagyobb teljesítményű NPU-kkal és nagyobb memóriatárolókkal rendelkező PC-k, és a kis modellek egyre nagyobb teljesítményt nyújtanak, gyanítjuk, hogy a Microsoft több funkcionalitást kezd kirakni a helyi eszközökre – amint a hardver képes lesz rá. ®

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://go.theregister.com/feed/www.theregister.com/2024/03/31/microsoft_copilot_hardware/

- :van

- :is

- :nem

- $ UP

- 1

- 10

- 13

- 16

- 2023

- 30

- 40

- 7

- a

- Képes

- Rólunk

- gázpedál

- át

- aktív

- tulajdonképpen

- hozzá

- megfelelő

- továbbjutó

- AI

- AI modellek

- majdnem

- Is

- AMD

- között

- összeg

- an

- és a

- bármilyen

- api

- Alkalmazás

- VANNAK

- körül

- AS

- összeszerelt

- At

- vonzó

- elérhető

- Égszínkék

- vissza

- BE

- kezdődik

- viselkedés

- lent

- Előnyök

- BEST

- között

- Nagy

- Billió

- Blocks

- mindkét

- Bring

- hozott

- építész

- de

- by

- kéri

- TUD

- képes

- eset

- Kategória

- biztosan

- ces

- chatbot

- csip

- játékpénz

- körülmények

- vásárló

- óra

- felhő

- CO

- kód

- kombináció

- kombinált

- hogyan

- érkező

- teljes

- Kiszámít

- számítástechnika

- kapcsolat

- alkot

- meggyőz

- Mag

- kiszögellő

- Társasági

- tudott

- Pár

- teremtés

- Kereszt

- Jelenleg

- vevő

- Ügyfelek

- vágás

- dátum

- adatkészletek

- Datacenter

- december

- elszánt

- definíció

- Származtatott

- leírni

- asztali

- észlelt

- eszköz

- Eszközök

- különbség

- zavarok

- nem

- nem

- Don

- csinált

- két

- alatt

- dinamikus

- Korai

- elemek

- elit

- lehetővé

- végén

- vége

- fokozott

- hatalmas

- elég

- Egész

- teljesen

- Még

- esemény

- végül is

- mindenki

- pontosan

- izgatott

- vezetőit

- vezetők

- létezik

- létező

- tapasztalat

- szakértők

- feltárt

- Esik

- ventilátor

- messze

- gyorsabb

- Funkció

- Jellemzők

- vezetéknév

- megfelelő

- A

- a belátható

- francia

- ból ből

- Tele

- funkcionalitás

- jövő

- általános

- generál

- generáció

- kap

- szerzés

- óriás

- GitHub

- megy

- GPU

- Nő

- fogantyú

- hardver

- Legyen

- tekintettel

- he

- segít

- Magas

- <p></p>

- Kezdőlap

- reméli,

- Ház

- Hogyan

- azonban

- HTTPS

- ötlet

- kép

- javul

- javított

- javítja

- in

- Más

- Innováció

- Intel

- érdekes

- bele

- belső

- Hát

- kérdés

- IT

- ITS

- maga

- január

- jpg

- éppen

- Kulcs

- Ismer

- Címke

- hiány

- tó

- nyelv

- hordozható számítógép

- nagy

- nagyobb

- keresztnév

- Tavaly

- Késő

- Késleltetés

- legutolsó

- indít

- indított

- vezet

- legkevésbé

- könyvtár

- mint

- Kedvencek

- vonal

- Felsorakozni

- ll

- LLM

- kiszámításának

- helyi

- helyileg

- MEGJELENÉS

- alacsonyabb

- Hold-

- gép

- gép

- készült

- csinál

- piacára

- Lehet..

- eszközök

- Közben

- Találkozik

- Memory design

- meta

- microsoft

- esetleg

- millió

- keverje

- Mobil

- modell

- modellek

- több

- a legtöbb

- sok

- többszörös

- Közel

- közel

- Szükség

- háló

- hálózat

- ideg-

- Új

- következő

- Most

- szám

- dióhéj

- of

- kedvezmény

- felajánlás

- Office

- hivatalos

- on

- egyszer

- ONE

- csak

- -ra

- OpenAI

- Művelet

- optimalizált

- or

- OS

- Más

- mi

- ki

- felett

- saját

- paraméterek

- rész

- alkatrészek

- PC

- PC

- Emberek (People)

- mert

- teljesítmény

- személyes

- tervek

- emelvény

- Plató

- Platón adatintelligencia

- PlatoData

- plusz

- pont

- hatalom

- erős

- Bekapcsolom

- korábban

- magánélet

- feldolgozás

- processzorok

- ad

- cél

- meglökött

- Toló

- tesz

- Qualcomm

- lekérdezések

- Inkább

- RE

- ok

- kapott

- nemrég

- viszonylag

- eszébe jut

- távoli

- követelmények

- Tudástár

- illetőleg

- válasz

- REST

- tekercselt

- Útvonal

- Kontúrmart

- futás

- futás

- s

- Mondott

- azt mondják

- azt mondja,

- forgatókönyvek

- Második

- lát

- Úgy tűnik,

- küldött

- Series of

- Szerverek

- Szettek

- Alak

- váltás

- VÁLTOZÁS

- kellene

- Szilícium

- óta

- Méret

- kicsi

- kisebb

- tátika

- So

- szoftver

- néhány

- nemsokára

- forrás

- forráskód

- specializált

- sport

- Színpad

- Még mindig

- megállítás

- árnyékolók

- legerősebb

- stúdió

- előfizetés

- ilyen

- javasolja,

- kíséret

- Csúcstalálkozó

- meglepetés

- Vesz

- bevétel

- Feladat

- feladatok

- kifejezés

- mint

- hogy

- A

- elmélet

- Ott.

- ebből adódóan

- Ezek

- dolgok

- Szerintem

- ezt

- ezen a héten

- idén

- azok

- alkalommal

- nak nek

- együtt

- tokenek

- is

- Felsők

- Vonat

- Trillió

- hangolt

- jellemzően

- Ultra

- alatt

- egység

- egységek

- használ

- használó

- Felhasználók

- segítségével

- fajta

- Ve

- változat

- látomás

- vizuális

- volt

- we

- hét

- voltak

- Mit

- amikor

- ami

- miért

- lesz

- ablakok

- val vel

- nélkül

- Nyerte

- szavak

- Munka

- világ

- lenne

- X

- év

- még

- te

- A te

- youtube

- Zen

- zephyrnet