Amazon SageMaker Bemutatja az automatikus modellhangolást Hipersáv, egy multi-fidelity technika a hiperparaméterek hangolására az optimális modell megtalálásának gyorsabb és hatékonyabb módjaként. Ebben a bejegyzésben bemutatjuk, hogy a Hyperband funkcióval végzett automatikus modellhangolás miként tud gyorsabb hiperparaméterhangolást elérni – akár háromszor olyan gyorsan.

A Hyperband előnyei

A Hyperband két előnnyel rendelkezik a meglévő black-box hangolási stratégiákhoz képest: hatékony erőforrás-kihasználás és jobb konvergenciaidő.

A gépi tanulási (ML) modellek egyre inkább képzésigényesek, összetett modelleket és nagy adatkészleteket foglalnak magukban, és sok erőfeszítést és erőforrást igényelnek az optimális hiperparaméterek megtalálásához. A hagyományos feketedobozos keresési stratégiák, mint például a Bayes-féle, a véletlenszerű keresés vagy a rácskeresés, hajlamosak lineárisan skálázni az ML probléma összetettségével, ami hosszabb képzési időt igényel.

A hiperparaméter-hangolás felgyorsítása és az edzési költségek optimalizálása érdekében a Hyperband ezt használja Aszinkron egymást követő felezési algoritmus (ASHA), egy olyan stratégia, amely nagymértékben párhuzamosítja a hiperparaméterek hangolását, és automatikusan korán leállítja a betanítási feladatokat azáltal, hogy korábban kiértékelt konfigurációkat használ annak előrejelzésére, hogy egy adott jelölt ígéretes-e vagy sem.

Amint azt ebben a bejegyzésben bemutatjuk, a Hyperband gyorsabban konvergál az optimális célmutatóhoz, mint a legtöbb black-box stratégia, és így edzési időt takarít meg. Ez lehetővé teszi nagyobb léptékű modellek hangolását, ahol az egyes hiperparaméter-konfigurációk kiértékelése költséges képzési ciklust igényel, mint pl. számítógépes látás és természetes nyelvi feldolgozó (NLP) alkalmazások. Ha érdekli a legpontosabb modellek megtalálása, a Hyperband azt is lehetővé teszi, hogy több erőforrással végezze hangolási feladatait, és egy jobb megoldás felé konvergáljon.

Hipersáv SageMakerrel

A hiperparaméterek hangolására megvalósított új hipersávos megközelítés néhány új adatelemet megváltoztatott az AWS API-hívásokon keresztül. Végrehajtás a AWS felügyeleti konzol jelenleg nem elérhető. Nézzünk néhány adatelemet a Hyperband esetében:

- Stratégia – Ez határozza meg a választandó hiperparaméteres megközelítést. Ezzel a változtatással a Hyperband új értéket vezetünk be. Az érvényes értékek a Bayes-féle, a véletlenszerű és a hipersáv.

- MinResource – Meghatározza a képzési munkához használandó időszakok vagy iterációk minimális számát, mielőtt döntés születik a képzés leállításáról.

- MaxResource – Meghatározza a képzési munkához a cél elérése érdekében felhasználható időszakok vagy iterációk maximális számát. Ez a paraméter nem szükséges, ha a hangolási feladatban hiperparaméterként meghatározott számú tanítási korszak van.

Implementáció

A következő mintakód a hangolási feladat konfigurációját és a betanítási feladat meghatározását mutatja:

Az előző kód határozza meg strategy mint Hyperband, és meghatározza az alsó és felső korlátot az erőforrás-korlátozáson belül a stratégiai konfiguráción belül HyperbandStrategyConfig, amely karként szolgál az edzési idő szabályozására. Az automatikus modellhangolás konfigurálásával és futtatásával kapcsolatos további részletekért lásd: Adja meg a Hiperparaméter hangolási feladat beállításait.

Hipersáv a feketedobozos kereséshez képest

Ebben a részben két kísérletet végzünk a Hyperband és a feketedobozos keresés összehasonlítására.

Első kísérlet

Az első kísérletben egy bináris osztályozási feladattal egy 5000 adatpontot tartalmazó szintetikus adathalmazon egy háromrétegű, teljesen összekapcsolt hálózat optimalizálását célozzuk meg. A hálózat hiperparaméterei közé tartozik a rétegenkénti egységek száma, az Adam-optimalizáló tanulási sebessége, az L2-szabályozási paraméter és a kötegméret. Ezen paraméterek tartománya a következő:

- Egységek száma rétegenként – 10-től 1e3-ig

- Tanulási arány – 1e-4-től 0.1-ig

- L2 regularizációs paraméter – 1e-6-től 2-ig

- Csomó méret - 10-200

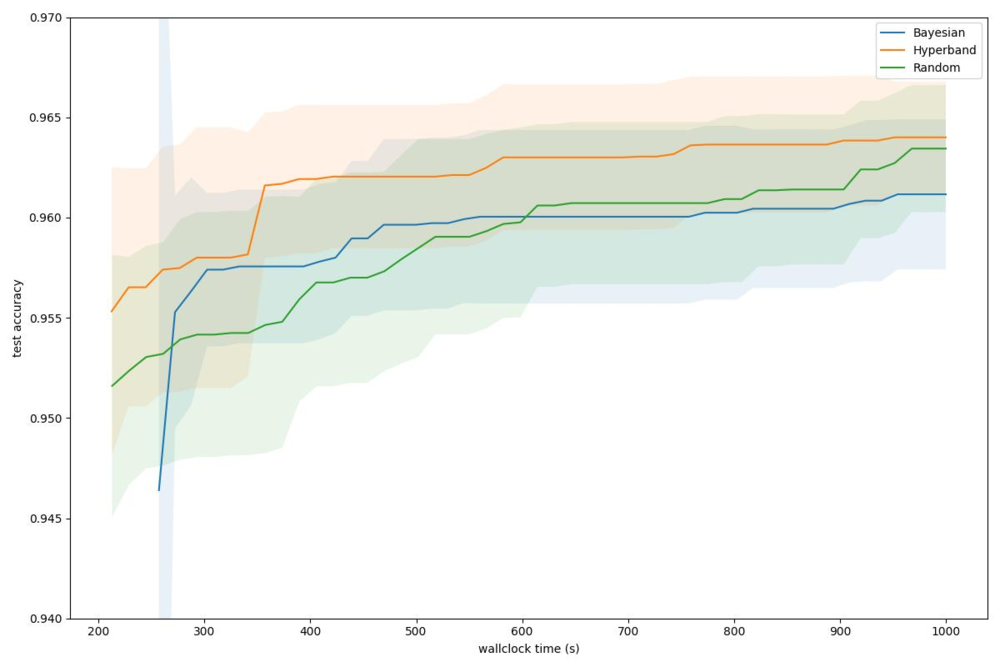

Az alábbi grafikonon az eredményeink láthatók.

A Hyperbandot más stratégiákkal összehasonlítva, 96%-os célpontosság mellett, a Hyperband 357 másodperc alatt képes elérni ezt a célt, míg a Bayes-féle 560 másodperc, a véletlenszerű keresés pedig 614 másodperc alatt. A Hyperband következetesen megtalálja az optimálisabb megoldást az adott falióra időkeret mellett. Ez a többhűségű optimalizálási algoritmus egyértelmű előnyét mutatja.

Második kísérlet

Ebben a második kísérletben figyelembe vesszük a Cifar10 adatkészlet és betanítja a ResNet-20-at, a számítógépes látási feladatok népszerű hálózati architektúráját. Minden kísérletet ml.g4dn.xlarge példányokon futtatunk, és SGD-n keresztül optimalizáljuk a neurális hálózatot. Szokásos képkibővítést is alkalmazunk, beleértve a véletlenszerű megfordítást és véletlenszerű kivágást. A keresési terület a következő paramétereket tartalmazza:

- Mini köteg mérete: 4 és 512 közötti egész szám

- SGD tanulási ráta: 1e-6-tól 1e-1-ig lebeg

- SGD lendülete: lebegés 0.01 és 0.99 között

- Súlycsökkenés: úszó 1e-5-ről 1-re

Az alábbi grafikon szemlélteti megállapításainkat.

A 0.87-es célellenőrzési pontosság mellett a Hyperband kevesebb, mint 2000 másodperc alatt éri el, míg a Random és a Bayes-féle 10000 9000, illetve közel 5 másodpercet igényel. Ez ~4.5-szörös és ~XNUMX-szörös gyorsulási tényezőt jelent a Hyperband esetében ennél a feladatnál a véletlenszerű és bayesi stratégiákhoz képest. Ez egyértelmű előnyt jelent a több hűségű optimalizálási algoritmus számára, amely jelentősen csökkenti a mélytanulási modellek hangolásához szükséges falióra idejét.

Következtetés

A SageMaker automatikus modellhangolása lehetővé teszi, hogy csökkentse a modell hangolásához szükséges időt azáltal, hogy automatikusan megkeresi a legjobb hiperparaméter-konfigurációt a megadott tartományokon belül. A modell legjobb verzióját úgy találhatja meg, ha több keresési stratégiával, például feketedobozos vagy multi-fidelity stratégiákkal oktatási feladatokat futtat az adatkészletén.

Ebben a bejegyzésben megvitattuk, hogyan használhatod most az úgynevezett multi-fidelity stratégiát Hipersáv a SageMakerben, hogy megtalálja a legjobb modellt. A Hyperband támogatása lehetővé teszi a SageMaker Automatic Model Tuning számára, hogy nagyobb léptékű modelleket hangoljon, ahol az egyes hiperparaméter-konfigurációk kiértékelése költséges képzési ciklust igényel, például számítógépes látás és NLP alkalmazásokban.

Végül láttuk, hogy a Hyperband hogyan optimalizálja tovább a futásidőt a korai leállítású black-box stratégiákhoz képest azáltal, hogy korábban kiértékelt konfigurációkat használ annak előrejelzésére, hogy egy adott jelölt ígéretes-e, és ha nem, leállítja az értékelést, hogy csökkentse a teljes időt és a számítási költségeket. A Hyperband használata a SageMakerben lehetővé teszi a minimális és maximális erőforrás megadását is HyperbandStrategyConfig paraméter a további futásidejű vezérlésekhez.

Ha többet szeretne megtudni, látogasson el Végezze el az automatikus modellhangolást a SageMaker segítségével.

A szerzőkről

Doug Mbaya Senior Partner Solution építész, aki az adatokra és az elemzésekre összpontosít. A Doug szorosan együttműködik az AWS-partnerekkel, segítve őket az adatok és az elemzési megoldások felhőbe való integrálásában.

Doug Mbaya Senior Partner Solution építész, aki az adatokra és az elemzésekre összpontosít. A Doug szorosan együttműködik az AWS-partnerekkel, segítve őket az adatok és az elemzési megoldások felhőbe való integrálásában.

Gopi Mudiyala az AWS vezető műszaki ügyfélmenedzsere. Segíti az ügyfeleket a pénzügyi szolgáltatások ágazatában az AWS-ben végzett tevékenységeikben. Gépi tanulási specialistaként a Gopi azon dolgozik, hogy segítse ügyfeleit az ML útjukon.

Gopi Mudiyala az AWS vezető műszaki ügyfélmenedzsere. Segíti az ügyfeleket a pénzügyi szolgáltatások ágazatában az AWS-ben végzett tevékenységeikben. Gépi tanulási specialistaként a Gopi azon dolgozik, hogy segítse ügyfeleit az ML útjukon.

Xingchen Ma az AWS alkalmazott tudósa. A SageMaker Automatic Model Tuning szolgáltatását birtokló csapatban dolgozik.

Xingchen Ma az AWS alkalmazott tudósa. A SageMaker Automatic Model Tuning szolgáltatását birtokló csapatban dolgozik.

- AI

- ai művészet

- ai art generátor

- van egy robotod

- Amazon SageMaker

- mesterséges intelligencia

- mesterséges intelligencia tanúsítás

- mesterséges intelligencia a bankszektorban

- mesterséges intelligencia robot

- mesterséges intelligencia robotok

- mesterséges intelligencia szoftver

- AWS gépi tanulás

- blockchain

- blokklánc konferencia ai

- coingenius

- társalgási mesterséges intelligencia

- kriptokonferencia ai

- dall's

- mély tanulás

- google azt

- gépi tanulás

- Plató

- plato ai

- Platón adatintelligencia

- Platón játék

- PlatoData

- platogaming

- skála ai

- szintaxis

- zephyrnet