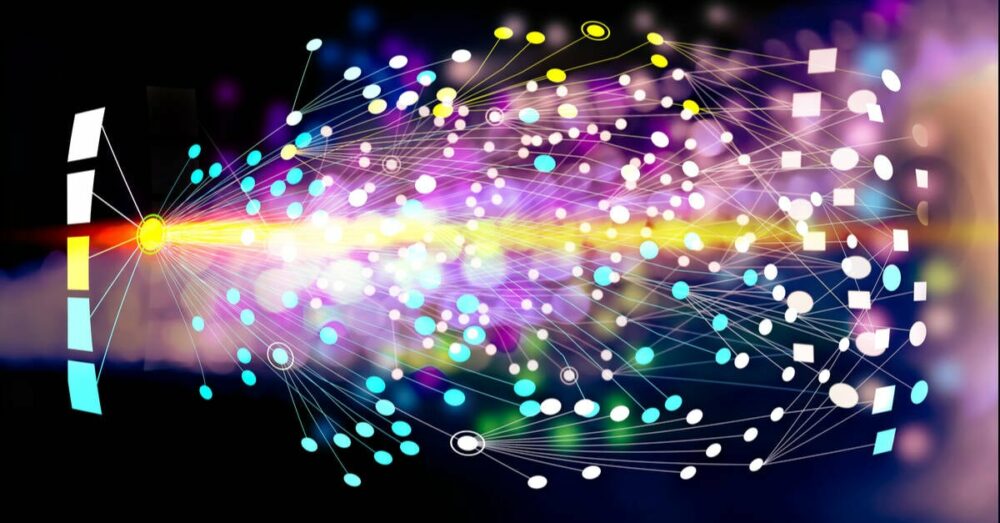

Az Nvidia vezérigazgatója, Jensen Huang úgy véli, hogy a jövőben a vállalati szoftverek csak a chat-botok gyűjteménye lesz, amelyeket a feladat elvégzéséhez összefűzve használnak nagy nyelvi modelleket (LLM) a kódíráshoz.

„Nem valószínű, hogy a semmiből fogod megírni, vagy egy csomó Python kódot vagy bármi hasonlót” – mondta a színpadon a GTC alatt. alaphang Hétfő. "Nagyon valószínű, hogy összeállít egy MI-csapatot."

Ez az AI-csapat, magyarázza Jensen, tartalmazhat egy olyan modellt, amelyet arra terveztek, hogy lebontja és átadja a kéréseket számos más modellnek. E modellek némelyike az üzleti szolgáltatások, például az SAP vagy a Service Now megértésére tanítható, míg mások numerikus elemzést végezhetnek a vektoros adatbázisban tárolt adatokon. Ezek az adatok azután kombinálhatók, és egy másik modell segítségével bemutathatók a végfelhasználónak.

„Minden nap kaphatunk jelentést, vagy az óra tetején, aminek köze van egy építési tervhez, vagy valamilyen előrejelzéshez, vagy valamilyen ügyfélriasztáshoz, vagy valamilyen hibaadatbázishoz vagy bármihez” – magyarázta.

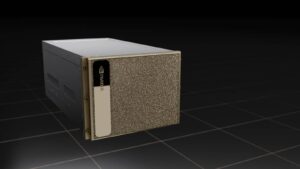

A modellek összekapcsolásához az Nvidia kivesz egy oldalt a Docker könyvéből, és létrehozott egy konténer futtatókörnyezetet az AI számára.

Az Nvidia Inference Microservices-nek vagy röviden NIM-nek nevezett konténerképek, amelyek mindkét modellt tartalmazzák, legyen az nyílt forráskódú vagy szabadalmaztatott, valamint a működéséhez szükséges összes függőséget. Ezek a konténeres modellek ezután tetszőleges számú futási környezetben üzembe helyezhetők, beleértve az Nvidia által gyorsított Kubernetes csomópontokat is.

„Telepítheti a DGX Cloud nevű infrastruktúránkon, vagy üzembe helyezheti prem-en, vagy bárhová telepítheti, ahol csak akarja. Ha egyszer kifejleszted, a tiéd, bárhová elviheted” – mondta Jensen.

Természetesen először elő kell fizetni az Nvidia AI Enterprise csomagjára, ami nem éppen olcsó, GPU-nként évi 4,500 dollár vagy GPU-nként óránként 1 dollár a felhőben. Úgy tűnik, hogy ez az árstratégia általában a sűrűbb, nagyobb teljesítményű rendszereket ösztönzi, mivel ugyanannyiba kerül, függetlenül attól, hogy L40-es vagy B100-asok.

Ha a GPU-gyorsított munkaterhelések konténerbe helyezésének ötlete ismerősen hangzik, ez nem teljesen új ötlet az Nvidia számára. CUDA gyorsulás volt támogatott sokféle konténer-futtatókörnyezetben, például Docker, Podman, Containerd vagy CRI-O évek óta, és nem úgy tűnik, hogy az Nvidia Container Runtime bárhová is vezet.

Úgy tűnik, a NIM mögött meghúzódó értékajánlat az, hogy az Nvidia fogja kezelni ezeknek a modelleknek a csomagolását és optimalizálását, hogy a CUDA, a Triton Inference Server vagy a TensorRT LLM megfelelő verziójával rendelkezzenek, amely szükséges a legjobb teljesítmény eléréséhez.

Az érv az, hogy ha az Nvidia olyan frissítést ad ki, amely drasztikusan megnöveli bizonyos modelltípusok következtetési teljesítményét, akkor ennek a funkciónak a kihasználásához csak a legújabb NIM-kép letöltésére lenne szükség.

A hardverspecifikus modelloptimalizálások mellett az Nvidia azon is dolgozik, hogy lehetővé tegye a konténerek közötti konzisztens kommunikációt, hogy azok API-hívásokon keresztül cseveghessenek egymással.

Értesülésünk szerint a piacon lévő különféle AI-modellek által használt API-hívások nem mindig következetesek, ami azt eredményezi, hogy egyes modelleket könnyebb összefűzni, míg mások további munkát igényelhetnek.

Intézményi ismeretek kölcsönzése általános célú modellekhez

Bárki, aki használt már mesterséges intelligencia csevegőbotot, tudja, hogy bár általában elég jók az általános ismeretekkel kapcsolatos kérdésekben, nem mindig a legmegbízhatóbbak a homályos vagy technikai kérések esetén.

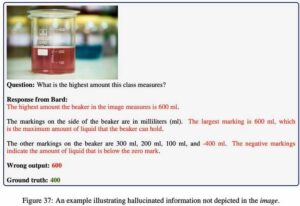

Jensen kiemelte ezt a tényt vitaindítójában. Az Nvidián belül használt belső programra vonatkozó kérdésre a Meta Llama 2 70B nagy nyelvi modellje nem meglepő módon egy nem kapcsolódó kifejezés definícióját adta meg.

Ahelyett, hogy megpróbálná rávenni a vállalatokat saját modelljeik képzésére – ami sok GPU-t adna el, de jelentősen korlátozná a megszólítható piacot – az Nvidia eszközöket fejlesztett ki a NIM-ek finomhangolására az ügyfelek adataival és folyamataival.

„Van egy NeMo Microservices nevű szolgáltatásunk, amely segít összegyűjteni az adatokat, előkészíteni az adatokat, hogy… bekapcsolódhasson az AI-ba. Finomhangolja, majd védőkorlátba helyezi; akkor értékelheti… a teljesítményét más példákkal összehasonlítva” – magyarázta Huang.

Beszélt az Nvidia NeMo Retriever szolgáltatásáról is, amely azon az elgondoláson alapul, hogy a retrieval augmented generation (RAG) segítségével olyan információkat jelenítenek meg, amelyekre a modellt nem képezték ki.

Az ötlet az, hogy dokumentumok, folyamatok és egyéb adatok betölthetők egy vektoros adatbázisba, amely kapcsolódik a modellhez. Egy lekérdezés alapján a modell kereshet az adatbázisban, lekérheti és összefoglalhatja a releváns információkat.

A NIM modellek és a RAG-ok integrálására szolgáló NeMo Retriever már elérhetők, míg a NeMo Microservices korai hozzáférésű. ®

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :van

- :is

- $ UP

- 7

- a

- Rólunk

- felgyorsult

- gyorsulás

- hozzáférés

- át

- mellett

- További

- címezhető

- Előny

- ellen

- AI

- AI chatbot

- AI modellek

- Éber

- Minden termék

- mentén

- Is

- mindig

- an

- elemzés

- és a

- Másik

- bármilyen

- bármi

- bárhol

- api

- Megjelenik

- VANNAK

- érv

- körül

- AS

- At

- bővített

- elérhető

- alapján

- BE

- óta

- mögött

- hogy

- úgy gondolja,

- BEST

- között

- könyv

- növeli

- mindkét

- botok

- szünet

- bogarak

- épít

- Csokor

- üzleti

- de

- by

- hívott

- kéri

- TUD

- Kaphat

- vezérigazgató

- bizonyos

- lánc

- csevegés

- chatbot

- olcsó

- felhő

- CO

- kód

- gyűjtemény

- kombinált

- távközlés

- teljes

- koncepció

- összefüggő

- következetes

- Konténer

- Konténerek

- kiadások

- Tanfolyam

- készítette

- segédlelkész

- vevő

- ügyféladatok

- dátum

- adatbázis

- nap

- definíció

- függőségek

- telepíteni

- telepített

- tervezett

- Fejleszt

- fejlett

- do

- Dokkmunkás

- dokumentumok

- nem

- le-

- drámaian

- alatt

- minden

- Korai

- könnyebb

- lehetővé téve

- végén

- Vállalkozás

- vállalati szoftver

- Vállalatok

- lényegében

- Minden

- pontosan

- példák

- magyarázható

- Elmagyarázza

- tény

- ismerős

- végén

- vezetéknév

- A

- Előrejelzés

- ból ből

- funkcionalitás

- jövő

- általános

- generáció

- kap

- megy

- jó

- GPU

- GPU

- fogantyú

- megtörténik

- hardver

- Legyen

- he

- segít

- segít

- itt

- <p></p>

- Kiemelt

- övé

- óra

- HTTPS

- huang

- ötlet

- if

- kép

- képek

- in

- ösztönzése

- tartalmaz

- Beleértve

- információ

- Infrastruktúra

- szervezeti

- integrálása

- belső

- bele

- Hát

- IT

- ITS

- jensen huang

- jpg

- éppen

- Alaphang

- Ismer

- tudás

- nyelv

- nagy

- legutolsó

- mint

- Valószínű

- LIMIT

- ll

- Láma

- LLM

- néz

- hasonló

- Sok

- piacára

- Lehet..

- meta

- microservices

- esetleg

- modell

- modellek

- hétfő

- a legtöbb

- elengedhetetlen

- Szükség

- Új

- csomópontok

- Most

- szám

- Nvidia

- of

- on

- Fedélzeti

- egyszer

- nyitva

- nyílt forráskódú

- optimalizálás

- optimalizáció

- or

- Más

- Egyéb

- mi

- ki

- saját

- csomagolás

- oldal

- mert

- Teljesít

- teljesítmény

- terv

- Plató

- Platón adatintelligencia

- PlatoData

- prémium

- Készít

- bemutatott

- szép

- árazás

- Folyamatok

- Program

- ajánlat

- szabadalmazott

- feltéve,

- vontatás

- cél

- Piton

- kérdés

- Kérdések

- rongy

- RE

- Tekintet nélkül

- Releases

- megbízható

- jelentést

- kérni

- kéri

- szükség

- kapott

- visszakeresés

- jobb

- futás

- futásidejű

- s

- Mondott

- azonos

- nedv

- kaparni

- Keresés

- látszik

- elad

- szerver

- szolgáltatás

- Szolgáltatások

- rövid

- egyetlen

- So

- szoftver

- néhány

- valami

- hangok

- forrás

- különleges

- kifejezetten

- Színpad

- memorizált

- Stratégia

- Húr

- előfizetés

- kíséret

- összegez

- felületi

- Systems

- Vesz

- bevétel

- Feladat

- csapat

- Műszaki

- kifejezés

- hogy

- A

- A jövő

- azok

- Őket

- akkor

- Ezek

- ők

- ezt

- nak nek

- Ma

- együtt

- szerszámok

- felső

- Vonat

- kiképzett

- Triton

- próbál

- dallam

- típusok

- megért

- valószínűtlen

- Frissítések

- használt

- használó

- segítségével

- rendszerint

- érték

- fajta

- különféle

- változat

- nagyon

- keresztül

- we

- bármi

- vajon

- ami

- míg

- WHO

- egész

- széles

- lesz

- val vel

- belül

- Munka

- dolgozó

- lenne

- ír

- kódot írni

- év

- még

- te

- a tiéd

- youtube

- zephyrnet