A streaming dinamikus világában Amazon Music, minden dal, podcast vagy lejátszási lista keresése tartalmaz egy történetet, egy hangulatot vagy érzelmek áradatát, amelyek bemutatásra várnak. Ezek a keresések kapuként szolgálnak új felfedezésekhez, dédelgetett élményekhez és maradandó emlékekhez. A keresősáv nem csak egy dal megtalálásáról szól; arról szól, hogy aktív felhasználók milliói kezdik meg személyes utazásukat az Amazon Music által kínált gazdag és sokszínű világba.

A felhasználók által keresett zene azonnali megtalálásához kiváló felhasználói élmény biztosításához olyan platformra van szükség, amely egyszerre intelligens és érzékeny. Az Amazon Music az AI erejét használja ennek megvalósítására. A forgalmi csúcsidőszakban azonban nehéz optimalizálni az ügyfélélményt, miközben kezelni kell a képzési költségeket és a keresősáv képességeit – például a valós idejű helyesírás-ellenőrzést és a vektoros keresést – működtető AI-modellek következtetéseit.

Amazon SageMaker teljes körű szolgáltatáskészletet biztosít, amely lehetővé teszi az Amazon Music számára, hogy minimális erőfeszítéssel építsen, tanítson és telepítsen az AWS Cloudon. Azáltal, hogy gondoskodik a differenciálatlan nehézemelésről, a SageMaker lehetővé teszi, hogy a gépi tanulási (ML) modelljeire összpontosítson, és ne aggódjon olyan dolgok miatt, mint például az infrastruktúra. A megosztott felelősségi modell részeként a SageMaker gondoskodik arról, hogy az általuk nyújtott szolgáltatások megbízhatóak, teljesítőképesek és méretezhetők legyenek, miközben Ön gondoskodik arról, hogy az ML modellek alkalmazása a lehető legjobban használja ki a SageMaker által nyújtott lehetőségeket.

Ebben a bejegyzésben végigjárjuk az Amazon Music által megtett utat a teljesítmény és a költségek optimalizálása érdekében a SageMaker és az NVIDIA Triton Inference Server és a TensorRT használatával. Mélyen belemerülünk annak bemutatásába, hogyan működik ez a látszólag egyszerű, mégis bonyolult keresősáv, töretlen utazást biztosítva az Amazon Music univerzumába, csekély-nulláig terjedő frusztráló elírási késedelmekkel és releváns valós idejű keresési eredményekkel.

Amazon SageMaker és NVIDIA: Gyors és pontos vektorkeresési és helyesírás-ellenőrzési lehetőségek

Az Amazon Music több mint 100 millió dalból és több millió podcast-epizódból álló hatalmas könyvtárat kínál. A megfelelő dal vagy podcast megtalálása azonban kihívást jelenthet, különösen, ha nem ismeri a pontos címet, az előadót vagy az album nevét, vagy a keresett lekérdezés nagyon tág, például „hírek podcastok”.

Az Amazon Music kétirányú megközelítést alkalmazott a keresési és visszakeresési folyamat javítására. Az első lépés a vektoros keresés (más néven beágyazás alapú visszakeresés) bevezetése, egy ML technika, amely segíthet a felhasználóknak megtalálni a legrelevánsabb tartalmat, amit keresnek a tartalom szemantikája segítségével. A második lépés egy Transformer-alapú helyesírás-javítási modell bevezetése a keresési verembe. Ez különösen akkor lehet hasznos, ha zenét keres, mert a felhasználók nem mindig ismerik a dal címének vagy az előadó nevének pontos írásmódját. A helyesírás-javítás segíthet a felhasználóknak abban, hogy megtalálják a keresett zenét, még akkor is, ha helyesírási hibát vétenek a keresési lekérdezés során.

A Transformer modellek keresési és visszakeresési folyamatban való bevezetése (a vektorkereséshez szükséges lekérdezés beágyazási generálásában és a generatív Seq2Seq Transformer modellben a helyesírás-javításban) az általános késleltetés jelentős növekedéséhez vezethet, ami negatívan befolyásolja az ügyfelek élményét. Ezért kiemelt fontosságúvá vált számunkra a valós idejű következtetési késleltetés optimalizálása a vektorkereső és a helyesírás-javító modelleknél.

Az Amazon Music és az NVIDIA összefogott, hogy a lehető legjobb vásárlói élményt jelenítse meg a keresősávban, a SageMaker segítségével gyors és pontos helyesírás-ellenőrzési képességeket és valós idejű szemantikus keresési javaslatokat valósítson meg vektoros keresés alapú technikák segítségével. A megoldás magában foglalja az NVIDIA A5G Tensor Core GPU-kat, a SageMaker által támogatott NVIDIA Triton Inference Server Containert és a G10-példányokkal hajtott SageMaker hosting használatát. NVIDIA TensorRT modell formátum. A helyesírás-ellenőrző modell következtetési késleltetésének 25 ezredmásodpercre csökkentésével csúcsforgalomnál, valamint a keresési lekérdezések beágyazási generálási késleltetésének átlagosan 63%-kal, valamint a CPU-alapú következtetéshez képest 73%-kal csökkentett költséggel, az Amazon Music növelte a keresősáv teljesítményét.

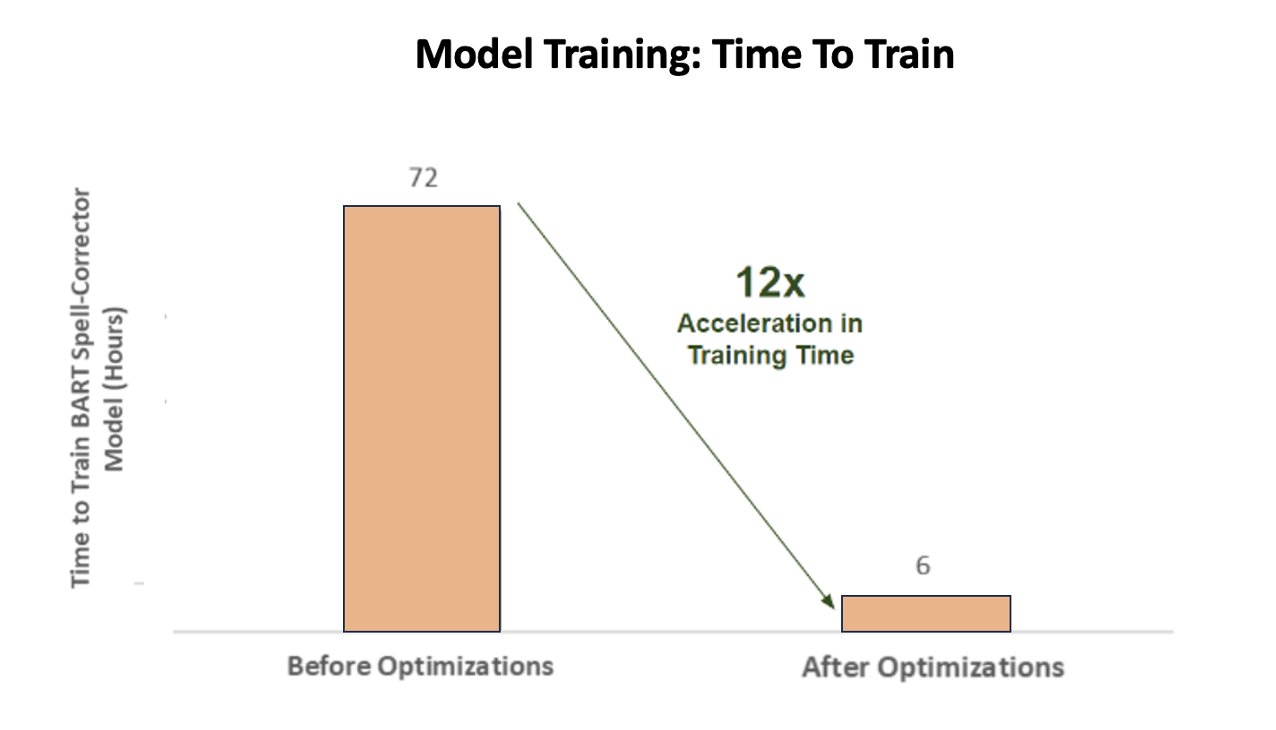

Ezen túlmenően, amikor a mesterséges intelligencia-modellt pontos eredmények elérésére tanította, az Amazon Music 12-szeres gyorsulást ért el a BART szekvenciák közötti helyesírás-javító transzformátormodell edzési idejében, így időt és pénzt is megtakarított a GPU kihasználtságának optimalizálásával.

Az Amazon Music együttműködött az NVIDIA-val, hogy előnyben részesítse az ügyfelek keresési élményét, és jól optimalizált helyesírás-ellenőrző és vektoros keresési funkciókkal rendelkező keresősávot hozzon létre. A következő szakaszokban többet megosztunk arról, hogyan szervezték meg ezeket az optimalizálásokat.

A képzés optimalizálása NVIDIA Tensor Core GPU-kkal

Az NVIDIA Tensor Core GPU-hoz való hozzáférés a nagy nyelvi modellek képzéséhez nem elegendő a valódi potenciál megragadásához. Vannak kulcsfontosságú optimalizálási lépések, amelyeket az edzés során kell végrehajtani a GPU kihasználtságának teljes maximalizálása érdekében. Az alulkihasznált GPU azonban kétségtelenül az erőforrások nem hatékony felhasználásához, a képzési idő meghosszabbításához és a működési költségek növekedéséhez vezet.

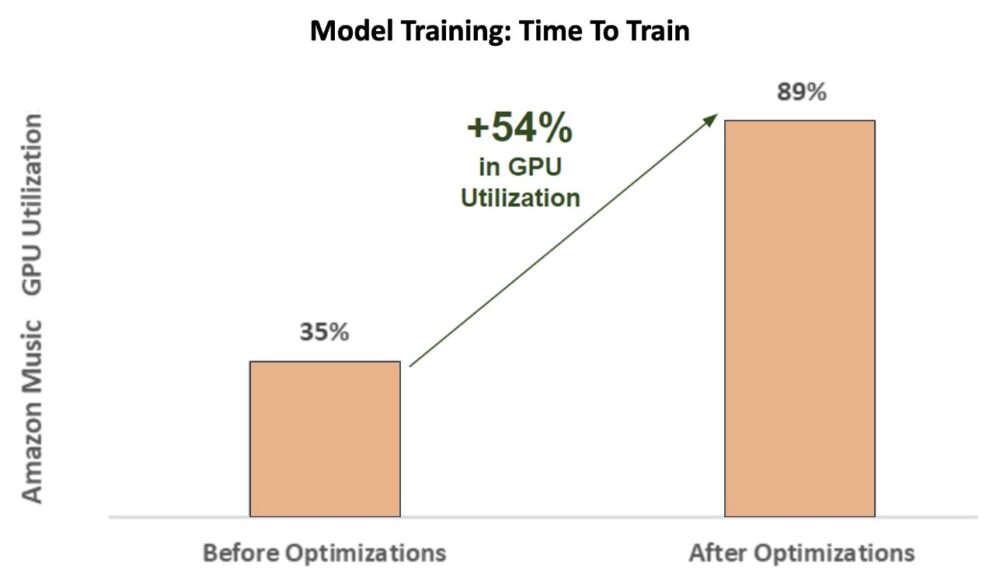

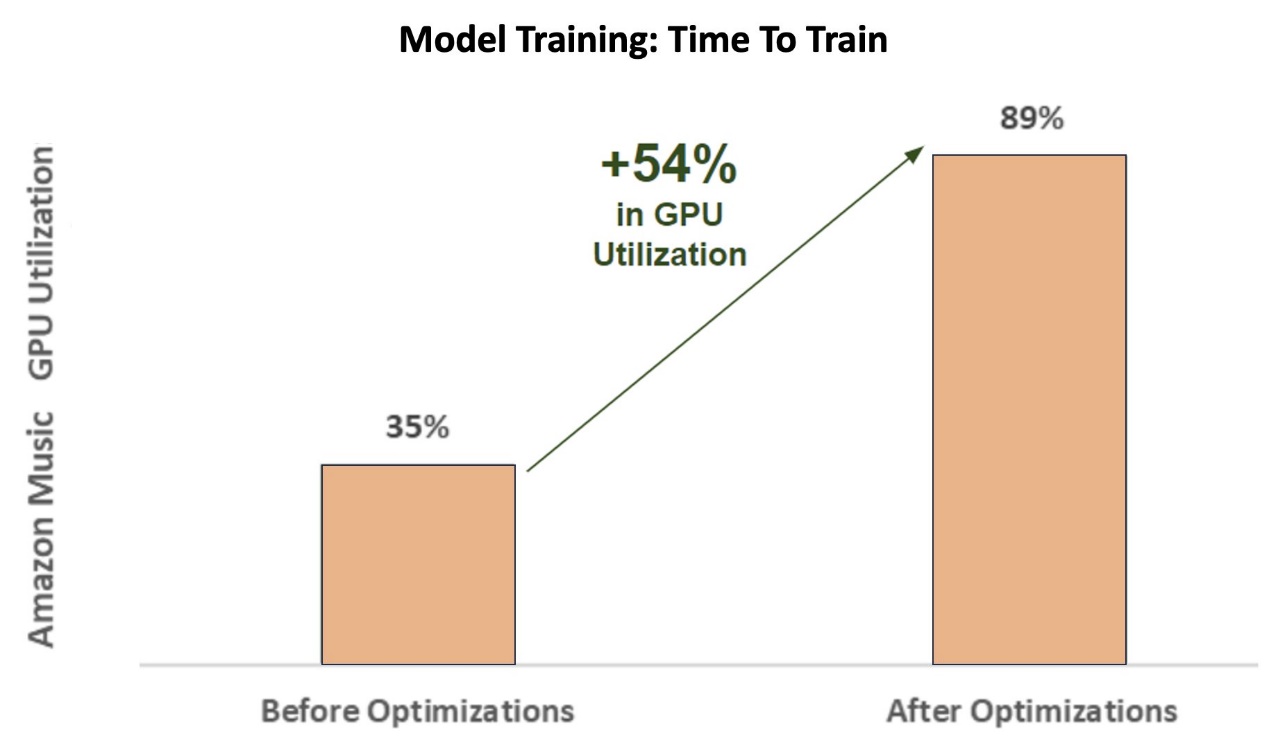

A képzés kezdeti szakaszaiban a helyesírás-javító BART (bart-alap) transzformátormodell SageMaker ml.p3.24xnagy példányon (8 NVIDIA V100 Tensor Core GPU), az Amazon Music GPU kihasználtsága 35% körül volt. Az NVIDIA GPU-gyorsított képzés előnyeinek maximalizálása érdekében az AWS és az NVIDIA megoldástervezői támogatták az Amazon Musicot az optimalizálási területek azonosításában, különösen a kötegméret és a precíziós paraméterek körül. Ez a két döntő paraméter befolyásolja a mély tanulási modellek képzésének hatékonyságát, sebességét és pontosságát.

Az eredményül kapott optimalizálás új és továbbfejlesztett V100 GPU-kihasználást eredményezett, állandóan 89% körül, ami drasztikusan csökkentette az Amazon Music oktatási idejét 3 napról 5-6 órára. A köteg méretének 32-ről 256-ra történő átállításával és olyan optimalizálási technikák használatával, mint a futás automatikus vegyes precíziós edzés Ahelyett, hogy csak az FP32-es precíziót használta volna, az Amazon Music időt és pénzt is tudott megtakarítani.

A következő diagram szemlélteti a GPU kihasználtság 54%-os növekedését az optimalizálás után.

Az alábbi ábra szemlélteti az edzési idő gyorsulását.

A kötegméret növelése lehetővé tette az NVIDIA GPU számára, hogy jelentősen több adatot dolgozzon fel egyidejűleg több Tensor magon keresztül, ami felgyorsította a tanítási időt. Fontos azonban a kényes egyensúly fenntartása a memóriával, mert a nagyobb kötegméretek több memóriát igényelnek. Mind a kötegméret növelése, mind a vegyes precizitás alkalmazása kritikus lehet az NVIDIA Tensor Core GPU-k teljesítményének felszabadításában.

Miután a modellt a konvergenciára betanították, ideje volt optimalizálni az Amazon Music keresősávjában történő következtetések telepítéséhez.

Helyesírás-javítás: BART-modell következtetés

A SageMaker G5 példányok és az NVIDIA Triton Inference Server (nyílt forráskódú következtetéseket kiszolgáló szoftver), valamint az NVIDIA TensorRT, a nagy teljesítményű mélytanulási következtetések SDK-ja, amely következtetésoptimalizálót és futási időt is tartalmaz, az Amazon Music korlátozza a helyesírás-ellenőrző BART-ot. (bart-alap) modellezi a szerver következtetési késleltetését csúcsforgalom esetén mindössze 25 ezredmásodpercre. Ez magában foglalja az olyan általános költségeket, mint a terheléselosztás, az előfeldolgozás, a modellkövetkeztetés és az utófeldolgozási idők.

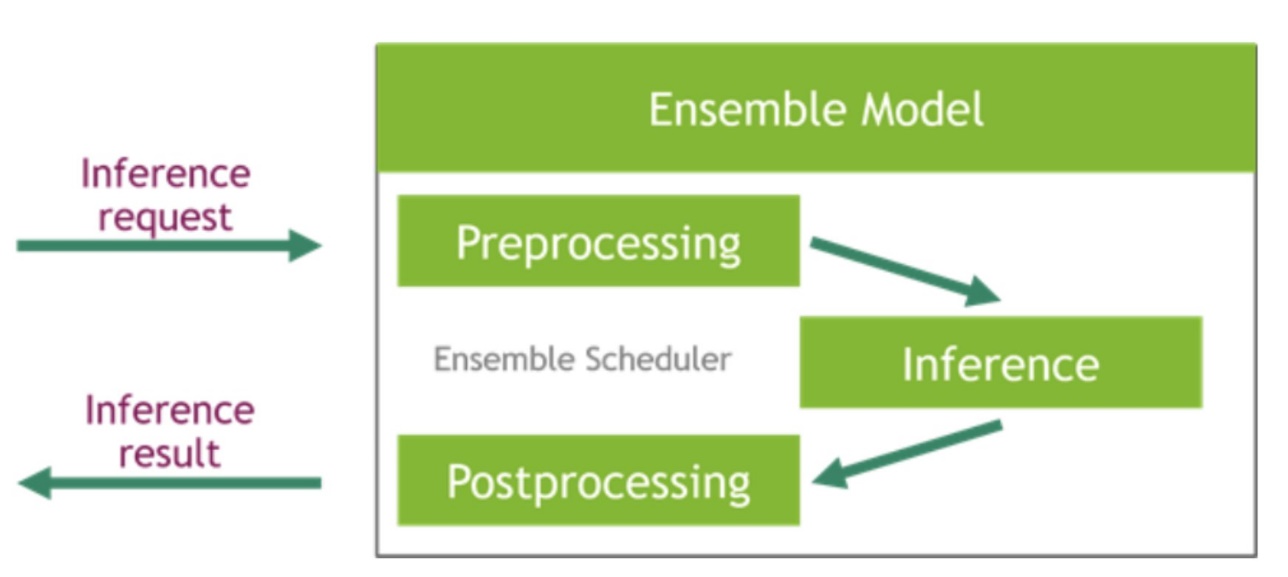

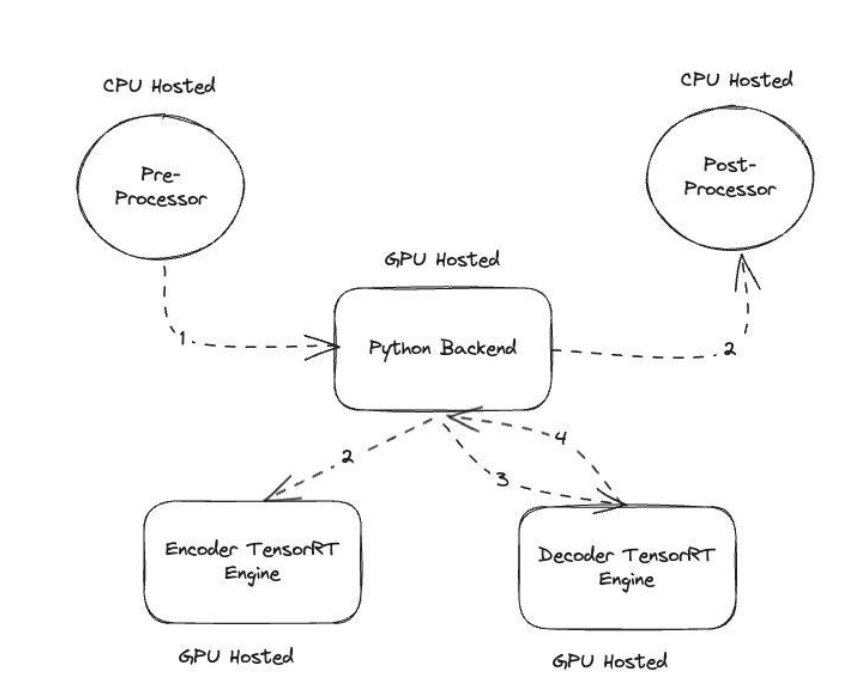

Az NVIDIA Triton Inference Server két különböző típusú háttérrendszert biztosít: az egyiket a modellek GPU-n való tárolására, valamint a Python-háttérrendszert, amelybe saját egyéni kódot hozhat az elő- és utófeldolgozási lépésekben. A következő ábra szemlélteti a modell együttes séma.

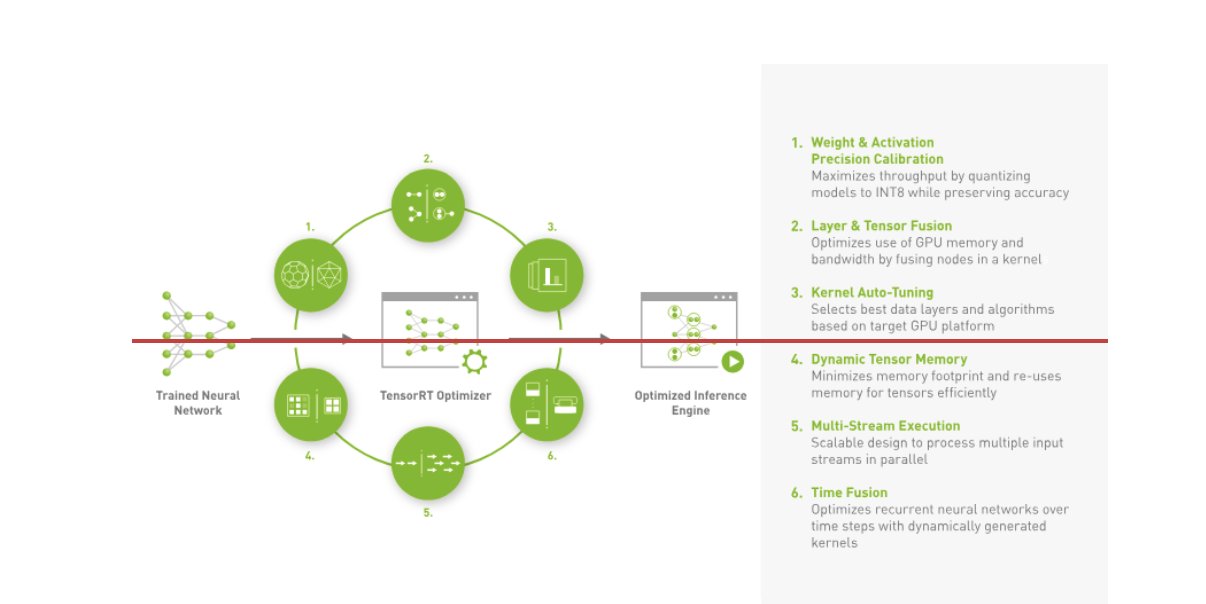

Az Amazon Music megépítette a BART-ját következtetési csővezeték előfeldolgozási (szöveg tokenizálás) és utófeldolgozási (tokenek szöveggé) lépések futtatásával a CPU-kon, míg a modell végrehajtási lépése NVIDIA A10G Tensor Core GPU-k. A Python-háttérrendszer az elő- és utófeldolgozási lépések közepén helyezkedik el, és felelős a TensorRT által konvertált BART-modellekkel, valamint a kódoló/dekódoló hálózatokkal való kommunikációért. TensorRT precíziós kalibrációval, réteg- és tenzorfúzióval, kernel automatikus hangolásával, dinamikus tenzormemóriával, többfolyamos végrehajtással és időfúzióval növeli a következtetési teljesítményt.

A következő ábra a helyesírás-javító BART-modell-következtető folyamatot alkotó kulcsmodulok magas szintű kialakítását mutatja be.

Vektoros keresés: Lekérdezés generálási mondat beágyazása BERT-modell-következtetés

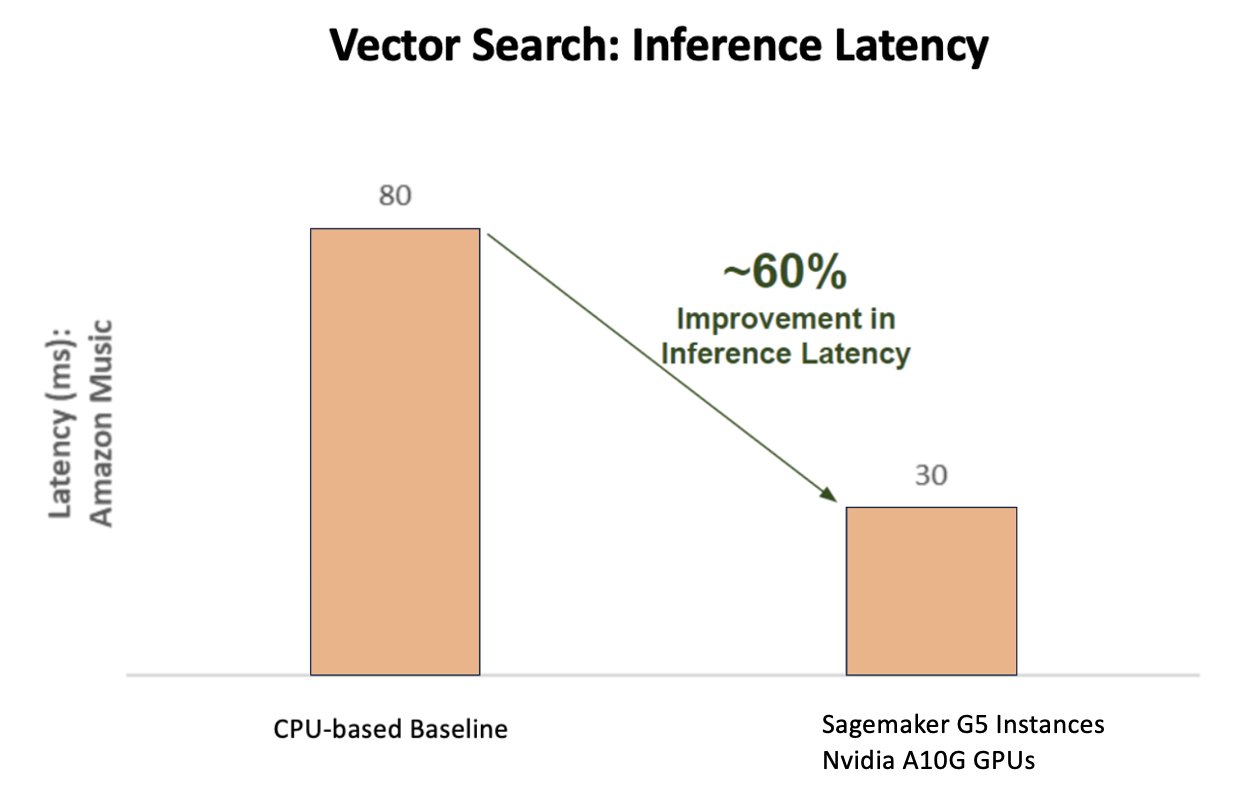

A következő diagram a várakozási idő 60%-os javulását mutatja (p90 800–900 TPS kiszolgálás) az NVIDIA AI Inference Platform használatakor a CPU-alapú alapvonalhoz képest.

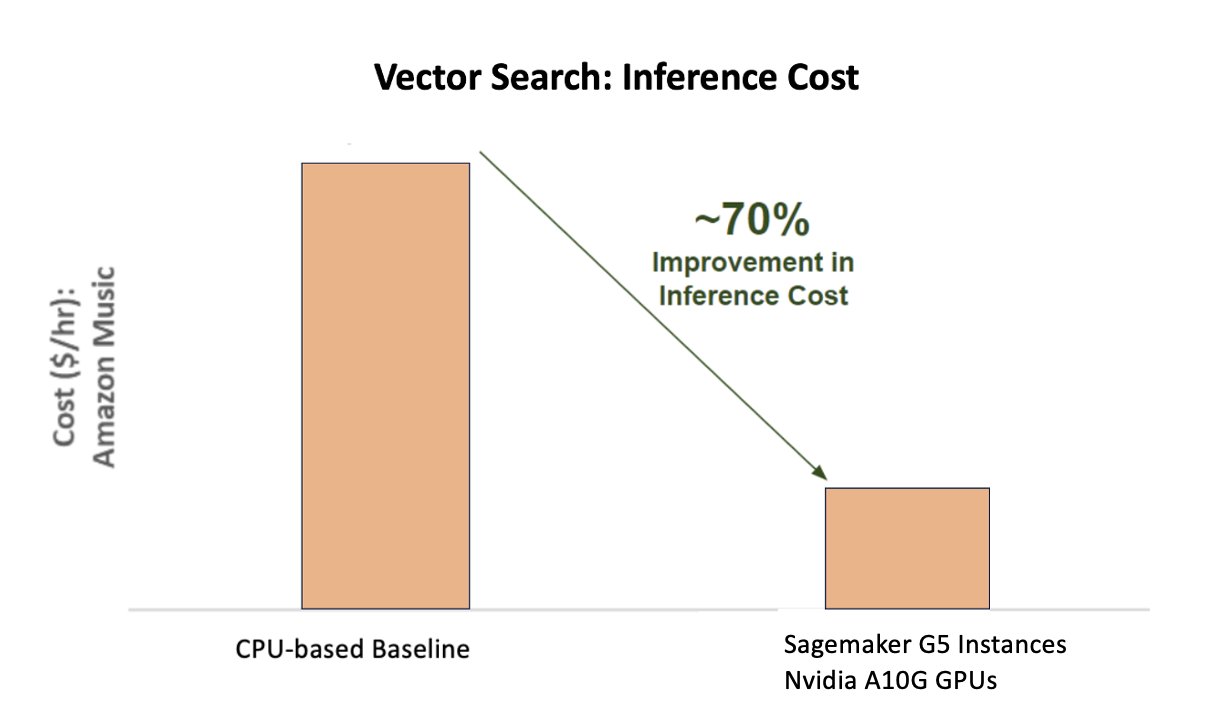

A következő diagram 70%-os költségnövekedést mutat be az NVIDIA AI Inference Platform használatakor a CPU-alapú alapvonalhoz képest.

A következő ábra egy SDK-t mutat be a nagy teljesítményű mélytanulási következtetésekhez. Tartalmaz egy mély tanulási következtetésoptimalizálót és futási időt, amely alacsony késleltetést és nagy átviteli sebességet biztosít a következtetési alkalmazások számára.

Ezen eredmények elérése érdekében az Amazon Music több különböző Triton telepítési paraméterrel kísérletezett Triton modellelemző, egy olyan eszköz, amely segít megtalálni a legjobb NVIDIA Triton modellkonfigurációt a hatékony következtetések telepítéséhez. A modellkövetkeztetés optimalizálása érdekében a Triton olyan funkciókat kínál, mint a dinamikus kötegelés és a párhuzamos modellvégrehajtás, valamint keretrendszer-támogatással rendelkezik más rugalmassági lehetőségekhez. A dinamikus kötegelés összegyűjti a következtetési kéréseket, zökkenőmentesen csoportokba csoportosítva őket az átviteli sebesség maximalizálása érdekében, miközben biztosítja a valós idejű válaszokat az Amazon Music felhasználóinak. A párhuzamos modell-végrehajtási képesség tovább javítja a következtetési teljesítményt azáltal, hogy a modell több példányát ugyanazon a GPU-n tárolja. Végül felhasználásával Triton modellelemző, az Amazon Music gondosan finomhangolni tudta a dinamikus kötegelési és modellezési párhuzamossági következtetések tárolási paramétereit, hogy megtalálja az optimális beállításokat, amelyek a szimulált forgalom segítségével maximalizálják a következtetési teljesítményt.

Következtetés

A konfigurációk optimalizálása a Triton Inference Server és a TensorRT segítségével a SageMakeren lehetővé tette az Amazon Music számára, hogy kiemelkedő eredményeket érjen el mind a képzési, mind a következtetési folyamatok terén. A SageMaker platform a teljes körű nyílt platform az éles mesterséges intelligencia számára, amely gyors időt biztosít az értékteremtésre, és sokoldalúságot biztosít az összes jelentős mesterségesintelligencia-használati eset támogatásához hardveren és szoftveren egyaránt. A V100 GPU kihasználtságának optimalizálásával a képzéshez és a CPU-król G5-példányokra való váltásra NVIDIA A10G Tensor Core GPU-kkal, valamint az optimalizált NVIDIA szoftverek, például a Triton Inference Server és a TensorRT használatával az olyan vállalatok, mint az Amazon Music, időt és pénzt takaríthatnak meg, miközben mindkét esetben növelik a teljesítményt. képzés és következtetés, amely közvetlenül jobb ügyfélélményt és alacsonyabb működési költségeket eredményez.

A SageMaker megbirkózik az ML képzéssel és tárhelyszolgáltatással kapcsolatos differenciálatlan nehéz teherbírással, lehetővé téve az Amazon Music számára, hogy megbízható, méretezhető ML műveleteket biztosítson mind hardveren, mind szoftveren.

Javasoljuk, hogy ellenőrizze, hogy a SageMaker használatával optimalizálták-e a munkaterhelését, és mindig értékelje hardver- és szoftverválasztásait, hogy megtudja, van-e mód arra, hogy alacsonyabb költségek mellett jobb teljesítményt érjen el.

Ha többet szeretne megtudni az NVIDIA AI-ról az AWS-ben, olvassa el a következőket:

A szerzőkről

Siddharth Sharma az Amazon Music Science & Modeling csapatának gépi tanulási technológiai vezetője. Keresés, visszakeresés, rangsorolás és NLP-vel kapcsolatos modellezési problémákra specializálódott. Siddharth gazdag háttérrel rendelkezik, amely a késleltetésre érzékeny nagyszabású gépi tanulási problémákkal foglalkozik, mint például a hirdetések célzása, a több módozatú lekérdezés, a keresési lekérdezés megértése stb. Az Amazon Music-nál végzett munka előtt Siddharth olyan cégeknél dolgozott, mint a Meta, Walmart Labs, Rakuten az e-kereskedelem központú ML problémákról. Siddharth pályafutása elején az öböl környéki reklámtechnológiai induló vállalkozásokkal dolgozott.

Siddharth Sharma az Amazon Music Science & Modeling csapatának gépi tanulási technológiai vezetője. Keresés, visszakeresés, rangsorolás és NLP-vel kapcsolatos modellezési problémákra specializálódott. Siddharth gazdag háttérrel rendelkezik, amely a késleltetésre érzékeny nagyszabású gépi tanulási problémákkal foglalkozik, mint például a hirdetések célzása, a több módozatú lekérdezés, a keresési lekérdezés megértése stb. Az Amazon Music-nál végzett munka előtt Siddharth olyan cégeknél dolgozott, mint a Meta, Walmart Labs, Rakuten az e-kereskedelem központú ML problémákról. Siddharth pályafutása elején az öböl környéki reklámtechnológiai induló vállalkozásokkal dolgozott.

Tarun Sharma egy szoftverfejlesztési menedzser, aki az Amazon Music Search Relevancia terén vezető szerepet tölt be. Tudósokból és ML-mérnökökből álló csapata felelős azért, hogy kontextus szerint releváns és személyre szabott keresési eredményeket biztosítson az Amazon Music ügyfelei számára.

Tarun Sharma egy szoftverfejlesztési menedzser, aki az Amazon Music Search Relevancia terén vezető szerepet tölt be. Tudósokból és ML-mérnökökből álló csapata felelős azért, hogy kontextus szerint releváns és személyre szabott keresési eredményeket biztosítson az Amazon Music ügyfelei számára.

James Parker az Amazon Web Services megoldástervezője. Együttműködik az Amazon.com-tal az AWS technológiai megoldások tervezésében, kiépítésében és üzembe helyezésében, és különösen érdeklődik az AI és a gépi tanulás iránt. Szabadidejében szívesen keres új kultúrákat, új tapasztalatokat, és naprakész marad a legújabb technológiai trendekkel. LinkedIn.

James Parker az Amazon Web Services megoldástervezője. Együttműködik az Amazon.com-tal az AWS technológiai megoldások tervezésében, kiépítésében és üzembe helyezésében, és különösen érdeklődik az AI és a gépi tanulás iránt. Szabadidejében szívesen keres új kultúrákat, új tapasztalatokat, és naprakész marad a legújabb technológiai trendekkel. LinkedIn.

Kshitiz Gupta az NVIDIA megoldástervezője. Szívesen oktatja felhőügyfeleit az NVIDIA által kínált GPU AI-technológiákról, és segít nekik gépi tanulási és mély tanulási alkalmazásaik felgyorsításában. Munkán kívül szeret futni, túrázni és vadvilágot nézni.

Kshitiz Gupta az NVIDIA megoldástervezője. Szívesen oktatja felhőügyfeleit az NVIDIA által kínált GPU AI-technológiákról, és segít nekik gépi tanulási és mély tanulási alkalmazásaik felgyorsításában. Munkán kívül szeret futni, túrázni és vadvilágot nézni.

Jiahong Liu az NVIDIA Cloud Service Provider csapatának megoldástervezője. Segíti az ügyfeleket a gépi tanulási és mesterséges intelligencia-megoldások elfogadásában, amelyek az NVIDIA gyorsított számítástechnikáját használják ki a képzési és következtetési kihívások megoldására. Szabadidejében szereti az origamit, a barkácsprojekteket és a kosárlabdát.

Jiahong Liu az NVIDIA Cloud Service Provider csapatának megoldástervezője. Segíti az ügyfeleket a gépi tanulási és mesterséges intelligencia-megoldások elfogadásában, amelyek az NVIDIA gyorsított számítástechnikáját használják ki a képzési és következtetési kihívások megoldására. Szabadidejében szereti az origamit, a barkácsprojekteket és a kosárlabdát.

Tugrul Konuk az NVIDIA vezető megoldástervezője, aki nagyszabású képzésre, multimodális mély tanulásra és nagy teljesítményű tudományos számítástechnikára szakosodott. Az NVIDIA előtt az energiaiparban dolgozott, és a számítási képalkotás algoritmusainak fejlesztésére összpontosított. Doktori tanulmányának részeként a fizika alapú mélytanuláson dolgozott numerikus szimulációkhoz. Szabadidejében szívesen olvas, gitározik és zongorázik.

Tugrul Konuk az NVIDIA vezető megoldástervezője, aki nagyszabású képzésre, multimodális mély tanulásra és nagy teljesítményű tudományos számítástechnikára szakosodott. Az NVIDIA előtt az energiaiparban dolgozott, és a számítási képalkotás algoritmusainak fejlesztésére összpontosított. Doktori tanulmányának részeként a fizika alapú mélytanuláson dolgozott numerikus szimulációkhoz. Szabadidejében szívesen olvas, gitározik és zongorázik.

Rohil Bhargava az NVIDIA termékmarketing-menedzsere, aki az NVIDIA-alkalmazás-keretrendszerek és SDK-k speciális CSP-platformokon történő telepítésére összpontosít.

Rohil Bhargava az NVIDIA termékmarketing-menedzsere, aki az NVIDIA-alkalmazás-keretrendszerek és SDK-k speciális CSP-platformokon történő telepítésére összpontosít.

Eliuth Triana Isaza az NVIDIA fejlesztői kapcsolatok menedzsere, aki felhatalmazza az Amazon AI MLOps-okat, DevOps-okat, tudósokat és AWS műszaki szakértőket, hogy elsajátítsák az NVIDIA számítástechnikai veremét a Generative AI Foundation modellek felgyorsítása és optimalizálása érdekében, az adatok kezelésétől, a GPU-oktatástól, a modellkövetkeztetéstől és az AWS GPU-példányok éles üzembe helyezésétől. . Emellett Eliuth szenvedélyes hegyikerékpáros, síelő, teniszező és pókerjátékos.

Eliuth Triana Isaza az NVIDIA fejlesztői kapcsolatok menedzsere, aki felhatalmazza az Amazon AI MLOps-okat, DevOps-okat, tudósokat és AWS műszaki szakértőket, hogy elsajátítsák az NVIDIA számítástechnikai veremét a Generative AI Foundation modellek felgyorsítása és optimalizálása érdekében, az adatok kezelésétől, a GPU-oktatástól, a modellkövetkeztetéstől és az AWS GPU-példányok éles üzembe helyezésétől. . Emellett Eliuth szenvedélyes hegyikerékpáros, síelő, teniszező és pókerjátékos.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :van

- :is

- :nem

- :ahol

- $ UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Képes

- Rólunk

- felgyorsult

- gyorsuló

- gyorsulás

- hozzáférés

- elérni

- pontosság

- pontos

- Elérése

- elért

- át

- aktív

- mellett

- cím

- Elfogadása

- hirdetések

- érintő

- Után

- AI

- AI modellek

- ai használati esetek

- Album

- algoritmusok

- Minden termék

- lehetővé

- megengedett

- lehetővé téve

- lehetővé teszi, hogy

- Is

- mindig

- amazon

- Az Amazon Web Services

- Amazon.com

- an

- és a

- Alkalmazás

- alkalmazások

- megközelítés

- építészek

- VANNAK

- TERÜLET

- területek

- körül

- művész

- AS

- segítő

- segítséget nyújt

- At

- átlagos

- AWS

- háttér

- Egyenleg

- kiegyensúlyozó

- bár

- alapján

- kiindulási

- Kosárlabda

- öböl

- BE

- lett

- mert

- Előnyök

- BEST

- Jobb

- fellendítése

- növeli

- mindkét

- hoz

- széles

- épít

- épült

- by

- TUD

- képességek

- képesség

- elfog

- ami

- Karrier

- gondosan

- esetek

- kihívások

- kihívást

- Táblázatos

- ellenőrizze

- dédelgetett

- választás

- ügyfél részére

- felhő

- kód

- COM

- hogyan

- kommunikáció

- Companies

- képest

- számítási

- számítástechnika

- egyidejű

- Configuration

- Konténer

- tartalom

- Konvergencia

- Mag

- Költség

- kiadások

- kézműves

- kritikai

- kritikus

- CSP

- curation

- szokás

- vevő

- Vásárlói élmény

- Ügyfelek

- dátum

- találka

- Nap

- csökkent

- mély

- mély tanulás

- késedelmek

- szállít

- átadó

- szállít

- Kereslet

- telepíteni

- bevezetéséhez

- bevetés

- Design

- Fejlesztő

- fejlesztése

- Fejlesztés

- különböző

- nehéz

- közvetlenül

- merülés

- számos

- diy

- ne

- drasztikusan

- alatt

- dinamikus

- e

- e-commerce

- Korai

- nevelése

- hatékonyság

- hatékony

- erőfeszítés

- emelkedett

- beágyazás

- érzelmek

- foglalkoztatás

- képessé

- engedélyezve

- ösztönzése

- végtől végig

- energia

- Mérnökök

- Javítja

- elég

- biztosítása

- különösen

- stb.

- értékelő

- Még

- Minden

- végrehajtás

- tapasztalat

- Tapasztalatok

- szakértők

- GYORS

- Jellemzők

- Ábra

- Végül

- Találjon

- megtalálása

- vezetéknév

- Rugalmasság

- árvíz

- Összpontosít

- összpontosított

- összpontosítás

- következő

- A

- formátum

- Alapítvány

- Keretrendszer

- keretek

- ból ből

- frusztráló

- teljesen

- funkciós

- további

- magfúzió

- gateway

- generáció

- nemző

- Generatív AI

- GPU

- GPU

- Fogantyúk

- történik

- hardver

- Legyen

- he

- nehéz

- súlyemelés

- segít

- hasznos

- segít

- Magas

- magas szinten

- nagy teljesítményű

- őt

- övé

- tart

- tárhely

- NYITVATARTÁS

- Hogyan

- azonban

- HTML

- HTTPS

- azonosító

- if

- illusztrálja

- Leképezés

- végre

- fontos

- javul

- javított

- javulás

- in

- magában foglalja a

- Növelje

- <p></p>

- növekvő

- ipar

- nem hatékony

- befolyás

- Infrastruktúra

- kezdetben

- példa

- azonnal

- helyette

- kamat

- bele

- bevezet

- bevezetéséről

- IT

- ITS

- utazás

- jpg

- éppen

- Kulcs

- Kedves

- Ismer

- ismert

- Labs

- nyelv

- nagy

- nagyarányú

- nagyobb

- tartós

- Késleltetés

- legutolsó

- réteg

- vezet

- vezető

- TANUL

- tanulás

- Tőkeáttétel

- könyvtár

- emelő

- mint

- határértékek

- kiszámításának

- keres

- Elő/Utó

- alacsonyabb

- gép

- gépi tanulás

- fenntartása

- fontos

- csinál

- KÉSZÍT

- menedzser

- kezelése

- Marketing

- mester

- Maximize

- Lehet..

- Memories

- Memory design

- meta

- Középső

- millió

- Több millió

- ezredmásodperc

- minimális

- hiba

- vegyes

- ML

- MLOps

- modell

- modellezés

- modellek

- Modulok

- pénz

- több

- a legtöbb

- hegy

- több

- többszörös

- zene

- kell

- név

- szükséges

- negatívan

- hálózatok

- Új

- NLP

- Nvidia

- of

- ajánlat

- Ajánlatok

- on

- ONE

- csak

- nyitva

- nyílt forráskódú

- üzemeltetési

- operatív

- Művelet

- optimálisan

- optimalizálás

- Optimalizálja

- optimalizált

- optimalizálása

- or

- hangszerelt

- érdekében

- Más

- ki

- kívül

- kiemelkedő

- felett

- átfogó

- saját

- paraméterek

- rész

- különös

- különösen

- társult

- szenvedélyes

- Csúcs

- százalék

- teljesítmény

- személyes

- Személyre

- phd

- csővezeték

- emelvény

- Platformok

- Plató

- Platón adatintelligencia

- PlatoData

- játékos

- játék

- podcast

- Podcastek

- pont

- póker

- lehetséges

- állás

- potenciális

- hatalom

- powered

- Pontosság

- Előzetes

- Fontossági sorrendet

- prioritás

- problémák

- folyamat

- Termékek

- Termelés

- projektek

- ad

- ellátó

- biztosít

- amely

- Piton

- Quick

- Ranking

- Olvasás

- real-time

- csökkentő

- utal

- összefüggő

- kapcsolatok

- relevancia

- megbízható

- kéri

- megköveteli,

- Tudástár

- válaszok

- felelősség

- felelős

- fogékony

- kapott

- Eredmények

- Gazdag

- jobb

- futás

- fut

- futásidejű

- sagemaker

- azonos

- Megtakarítás

- megtakarítás

- skálázható

- Skála

- Tudomány

- tudományos

- tudósok

- sdk

- sdks

- zökkenőmentesen

- Keresés

- keresések

- keres

- Második

- szakaszok

- lát

- keres

- látszólag

- szemantika

- idősebb

- érzékeny

- mondat

- szolgál

- szerver

- szolgáltatás

- Szolgáltató

- Szolgáltatások

- szolgáló

- készlet

- beállítások

- számos

- Megosztás

- megosztott

- Műsorok

- jelentős

- jelentősen

- Egyszerű

- ül

- Méret

- méretek

- okos

- szoftver

- szoftverfejlesztés

- megoldások

- Megoldások

- dal

- forrás

- feszültség

- specializálódott

- szakosodott

- különleges

- sebesség

- VARÁZSLAT

- helyesírás

- költött

- verem

- Kezdve

- Startups

- tartózkodás

- állandó

- Lépés

- Lépései

- Történet

- folyó

- ilyen

- felettes

- támogatás

- Támogatott

- biztos

- meghozott

- bevétel

- célzás

- csapat

- tech

- Műszaki

- technika

- technikák

- Technologies

- Technológia

- szöveg

- hogy

- A

- azok

- Őket

- Ott.

- ebből adódóan

- Ezek

- ők

- dolgok

- ezt

- Keresztül

- áteresztőképesség

- idő

- alkalommal

- Cím

- nak nek

- együtt

- tokenizálás

- tokenek

- vett

- szerszám

- felső

- idő

- forgalom

- Vonat

- kiképzett

- Képzések

- transzformátor

- Trends

- Triton

- igaz

- kettő

- megértés

- kétségtelenül

- Világegyetem

- kinyitó

- bemutatta

- us

- használ

- használt

- Felhasználók

- használ

- segítségével

- kihasználva

- érték

- Hatalmas

- sokoldalúság

- nagyon

- Várakozás

- séta

- Walmart

- volt

- őrzés

- módon

- we

- háló

- webes szolgáltatások

- JÓL

- voltak

- amikor

- mivel

- míg

- lesz

- val vel

- Munka

- dolgozott

- dolgozó

- művek

- világ

- aggódik

- még

- engedett

- te

- A te

- zephyrnet