A mesterséges intelligencia (AI) egy gyorsan fejlődő terület, amely a társadalom számos aspektusát javíthatja és átalakíthatja. 2023-ban az AI-technológiák elterjedésének üteme tovább gyorsult a hatékony alapmodellek (FM-ek) kifejlesztésével, és ennek eredményeként a generatív AI-képességek fejlődésével.

Az Amazonnál több generatív AI szolgáltatást indítottunk el, mint pl Amazon alapkőzet és a Amazon Code Whisperer, és számos nagy teljesítményű generatív modellt tettek elérhetővé ezen keresztül Amazon SageMaker JumpStart. Ezek a szolgáltatások célja, hogy támogassák ügyfeleinket a generatív mesterséges intelligencia feltörekvő képességeinek felszabadításában, beleértve a fokozott kreativitást, a személyre szabott és dinamikus tartalomkészítést és az innovatív tervezést. Lehetővé tehetik azt is, hogy a mesterséges intelligencia gyakorlói minden eddiginél jobban megértsék a világot – kezelve a nyelvi akadályokat, az éghajlatváltozást, a tudományos felfedezések felgyorsítását és még sok mást.

A generatív mesterséges intelligencia teljes potenciáljának kiaknázásához azonban fontos, hogy alaposan átgondoljuk a lehetséges kockázatokat. Ez mindenekelőtt az AI-rendszer érdekelt felei számára előnyös, mivel elősegíti a felelősségteljes és biztonságos fejlesztést és telepítést, valamint a lehetséges hatások kezelésére irányuló proaktív intézkedések elfogadását. Következésképpen a kockázatértékelési és -kezelési mechanizmusok létrehozása fontos folyamat a mesterséges intelligencia gyakorlói számára, és számos, kialakulóban lévő mesterségesintelligencia-ipari szabvány központi elemévé vált (pl. ISO 42001, ISO 23894és NIST RMF) és jogszabályok (pl EU AI törvény).

Ebben a bejegyzésben megvitatjuk, hogyan lehet felmérni a mesterséges intelligencia rendszerének lehetséges kockázatait.

Melyek a különböző kockázati szintek?

Bár egyszerűbb lehet elkezdeni egy egyedi gépi tanulási (ML) modellt és a kapcsolódó kockázatokat elszigetelten megvizsgálni, fontos, hogy egy ilyen modell konkrét alkalmazásának részleteit és a megfelelő használati esetet egy teljes mesterségesintelligencia-rendszer részeként figyelembe vegyük. . Valójában egy tipikus AI-rendszer valószínűleg több különböző ML-modellre épül, amelyek együtt dolgoznak, és egy szervezet több különböző mesterségesintelligencia-rendszert szeretne felépíteni. Következésképpen a kockázatok minden használati esetre és különböző szinteken értékelhetők, nevezetesen a modellkockázat, az AI-rendszer kockázata és a vállalati kockázat.

A vállalati kockázat a kockázatok széles spektrumát öleli fel, amelyekkel egy szervezet szembesülhet, beleértve a pénzügyi, működési és stratégiai kockázatokat. A mesterséges intelligencia rendszerkockázata az AI-rendszerek megvalósításával és működésével kapcsolatos hatásokra összpontosít, míg az ML modell kockázata kifejezetten az ML modellekben rejlő sebezhetőségekre és bizonytalanságokra vonatkozik.

Ebben a bejegyzésben elsősorban az AI-rendszer kockázatára összpontosítunk. Fontos azonban megjegyezni, hogy a szervezeten belüli kockázatkezelés minden különböző szintjét figyelembe kell venni és össze kell hangolni.

Hogyan határozható meg az AI-rendszer kockázata?

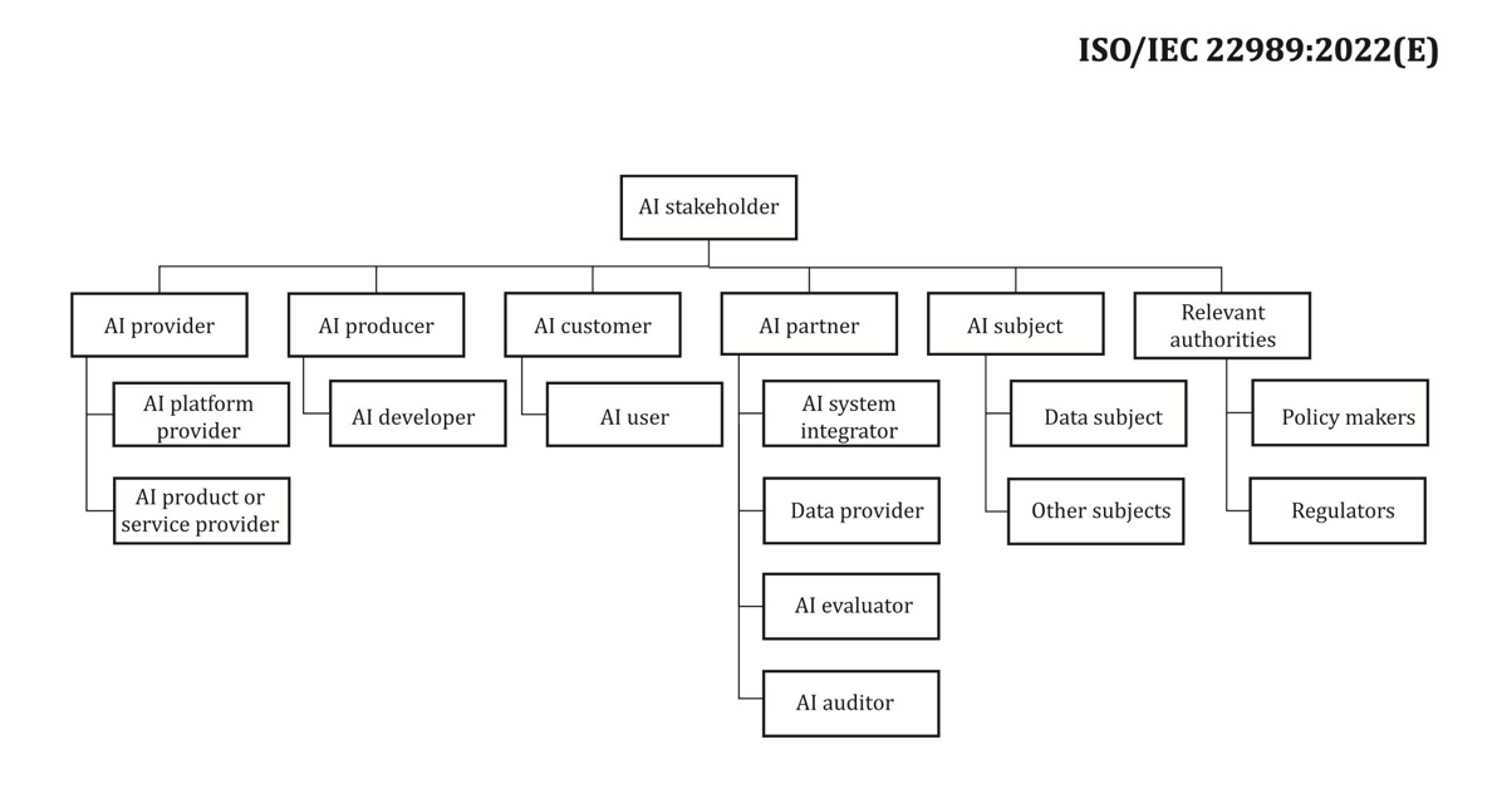

A kockázatkezelés egy mesterséges intelligencia rendszerrel összefüggésben a bizonytalanság vagy a potenciális negatív hatások hatásának minimalizálására szolgáló út lehet, ugyanakkor lehetőséget kínál a pozitív hatások maximalizálására. Maga a kockázat nem potenciális kár, hanem a bizonytalanság hatása a célokra. Szerint a NIST kockázatkezelési keretrendszer (NIST RMF), a kockázat megbecsülhető egy esemény bekövetkezési valószínűségének multiplikatív mértékeként, a megfelelő esemény következményeinek mértéke szerint időzítve.

A kockázatnak két aspektusa van: az eredendő kockázat és a fennmaradó kockázat. Az inherens kockázat azt a kockázatot jelenti, amelyet a mesterséges intelligencia rendszer mutat mérséklések vagy ellenőrzések hiányában. A fennmaradó kockázat a mérséklési stratégiák figyelembevétele után a fennmaradó kockázatokat rögzíti.

Mindig tartsa szem előtt, hogy a kockázatértékelés emberközpontú tevékenység, amely a szervezet egészére kiterjedő erőfeszítéseket igényel; ezek az erőfeszítések az összes érintett érdekelt bevonásának biztosításától az értékelési folyamatban (például termék-, mérnöki, tudományos, értékesítési és biztonsági csapatok) egészen annak felméréséig terjednek, hogy a társadalmi perspektívák és normák hogyan befolyásolják bizonyos események vélt valószínűségét és következményeit.

Miért kell az Ön szervezetének törődnie a kockázatértékeléssel?

A mesterséges intelligenciarendszerek kockázatkezelési kereteinek létrehozása a társadalom egészének hasznára válhat az AI-rendszerek biztonságos és felelős tervezésének, fejlesztésének és működtetésének előmozdítása révén. A kockázatkezelési keretrendszerek a következők révén is előnyösek lehetnek a szervezetek számára:

- Jobb döntéshozatal – Az AI-rendszerekkel kapcsolatos kockázatok megértésével a szervezetek jobb döntéseket hozhatnak e kockázatok csökkentésére és az AI-rendszerek biztonságos és felelős módon történő használatára vonatkozóan.

- Fokozott megfelelőségi tervezés – A kockázatértékelési keretrendszer segítheti a szervezeteket abban, hogy felkészüljenek a vonatkozó törvények és rendeletek kockázatértékelési követelményeire

- Bizalomépítés – Azzal, hogy bebizonyítják, hogy lépéseket tesznek az AI-rendszerek kockázatainak mérséklésére, a szervezetek megmutathatják ügyfeleiknek és érdekelt feleknek, hogy elkötelezettek a mesterséges intelligencia biztonságos és felelősségteljes használata iránt.

Hogyan értékeljük a kockázatot?

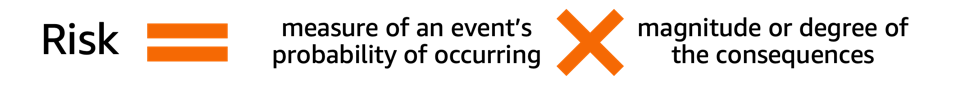

Első lépésként a szervezetnek fontolóra kell vennie az értékelendő mesterséges intelligencia használati esetének leírását, és meg kell határoznia az összes releváns érdekelt felet. A használati eset egy adott forgatókönyv vagy helyzet, amely leírja, hogy a felhasználók hogyan lépnek kapcsolatba egy mesterséges intelligencia-rendszerrel egy adott cél elérése érdekében. A használati esetleírás létrehozásakor hasznos lehet a megoldandó üzleti probléma megadása, az érintett érdekelt felek felsorolása, a munkafolyamat jellemzése, valamint a rendszer kulcsfontosságú bemeneteire és kimeneteire vonatkozó részletek megadása.

Ha az érdekelt felekről van szó, könnyű néhányat figyelmen kívül hagyni. Az alábbi ábra jó kiindulópont az AI érdekelt felek szerepének feltérképezéséhez.

Forrás: „Információtechnológia – Mesterséges intelligencia – Mesterséges intelligencia fogalmak és terminológia”.

Az AI-rendszer kockázatértékelésének következő fontos lépése a használati esettel kapcsolatos potenciálisan káros események azonosítása. Ezen események mérlegelésekor hasznos lehet a felelős mesterséges intelligencia különböző dimenzióira gondolni, mint például a méltányosság és a robusztusság. A különböző érdekelt felek különböző dimenziók mentén eltérő mértékben lehetnek érintettek. Például a végfelhasználó alacsony robusztussági kockázata annak az eredménye lehet, hogy egy mesterséges intelligencia rendszer kisebb megszakításokat mutat, míg az alacsony méltányossági kockázatot az okozhatja, hogy egy mesterséges intelligencia rendszer elhanyagolhatóan eltérő teljesítményt produkál a különböző demográfiai csoportok számára.

Egy esemény kockázatának becsléséhez használhat egy valószínűségi skálát egy súlyossági skálával kombinálva az előfordulás valószínűségének, valamint a következmények mértékének mérésére. Hasznos kiindulópont lehet ezeknek a skáláknak a kidolgozásához a NIST RMF, amely minőségi, nem numerikus kategóriák használatát javasolja a nagyon alacsonytól a nagyon magas kockázatig terjedő vagy a félkvantitatív értékelési elvek, például a skálák (például 1-10), a tartályok vagy más módon történő alkalmazását. reprezentatív számok. Miután az összes releváns dimenzióhoz meghatározta a valószínűségi és súlyossági skálát, egy kockázati mátrix sémát használhat az érintettek szerinti teljes kockázat számszerűsítésére az egyes releváns dimenziók mentén. A következő ábra egy példa kockázati mátrixot mutat be.

Ezt a kockázati mátrixot használva egy alacsony súlyosságú és ritka valószínűségű eseményt nagyon alacsony kockázatúnak tekinthetünk. Ne feledje, hogy a kezdeti értékelés az eredendő kockázat becslése, és a kockázatcsökkentő stratégiák segíthetnek a kockázati szint további csökkentésében. A folyamat ezután megismételhető az eseményenkénti fennmaradó fennmaradó kockázat értékeléséhez. Ha több eseményt azonosítottak ugyanazon dimenzió mentén, hasznos lehet kiválasztani a legmagasabb kockázati szintet a végső értékelési összefoglaló elkészítéséhez.

A végső értékelési összefoglaló felhasználásával a szervezeteknek meg kell határozniuk, hogy milyen kockázati szintek elfogadhatók mesterséges intelligencia-rendszereik számára, valamint figyelembe kell venniük a vonatkozó szabályozásokat és irányelveket.

AWS elkötelezettség

Elkötelezettségek révén a Fehér Ház és a UN, többek között elkötelezettek vagyunk tudásunk és szakértelmünk megosztása mellett az AI felelős és biztonságos használatának előmozdítása érdekében. Ezen a vonalon az Amazon Adam Selipsky képviselte az AWS-t a közelmúltban AI biztonsági csúcstalálkozó államfők és iparági vezetők részvételével, ezzel is bizonyítva elkötelezettségünket a mesterséges intelligencia felelős fejlesztésében való együttműködés iránt.

Következtetés

Ahogy a mesterséges intelligencia folyamatosan fejlődik, a kockázatértékelés egyre fontosabbá és hasznosabbá válik azon szervezetek számára, amelyek felelősen kívánnak MI-t építeni és telepíteni. Kockázatértékelési keretrendszer és kockázatcsökkentési terv létrehozásával a szervezetek csökkenthetik a lehetséges mesterséges intelligenciával kapcsolatos incidensek kockázatát, kivívhatják ügyfeleik bizalmát, valamint olyan előnyöket élvezhetnek, mint például a nagyobb megbízhatóság, a különböző demográfiai csoportok méltányossága stb.

Kezdje el a kockázatértékelési keretrendszer kidolgozását a szervezetben, és ossza meg gondolatait a megjegyzésekben.

Tekintse meg az Amazon Science oldalon közzétett generatív mesterséges intelligencia kockázatok áttekintését is: Felelős mesterséges intelligencia a generatív korszakban, és fedezze fel az AWS-szolgáltatások körét, amelyek támogathatják Önt a kockázatértékelési és -csökkentési úton: Amazon SageMaker Clarify, Amazon SageMaker Model Monitor, AWS CloudTrail, Valamint a modell irányítási keretrendszer.

A szerzőkről

Mia C. Mayer az AWS Machine Learning University alkalmazott tudósa és ML oktatója; ahol a Machine Learning és az AI rendszerek biztonságát, magyarázhatóságát és tisztességességét kutatja és tanítja. Pályafutása során Mia számos egyetemi ismeretterjesztő programot hozott létre, vendégelőadóként és főelőadóként működött, és számos nagy tanulási konferencián prezentált. Segít a belső csapatoknak és az AWS-ügyfeleknek is, hogy elinduljanak felelősségteljes mesterséges intelligencia útján.

Mia C. Mayer az AWS Machine Learning University alkalmazott tudósa és ML oktatója; ahol a Machine Learning és az AI rendszerek biztonságát, magyarázhatóságát és tisztességességét kutatja és tanítja. Pályafutása során Mia számos egyetemi ismeretterjesztő programot hozott létre, vendégelőadóként és főelőadóként működött, és számos nagy tanulási konferencián prezentált. Segít a belső csapatoknak és az AWS-ügyfeleknek is, hogy elinduljanak felelősségteljes mesterséges intelligencia útján.

Denis V. Batalov Denis 17 éves Amazon-veterán és a gépi tanulás területén doktorált. Denis olyan izgalmas projekteken dolgozott, mint a Search Inside the Book, az Amazon Mobile Apps és a Kindle Direct Publishing. 2013 óta megoldástervezőként segítette az AWS ügyfeleit az AI/ML technológia alkalmazásában. Jelenleg Denis az AI/ML világszintű műszaki vezetője, aki az AWS ML Specialist Solutions Architects globális működéséért felelős. Denis gyakori felszólaló, követheti őt a Twitteren @dbatalov.

Denis V. Batalov Denis 17 éves Amazon-veterán és a gépi tanulás területén doktorált. Denis olyan izgalmas projekteken dolgozott, mint a Search Inside the Book, az Amazon Mobile Apps és a Kindle Direct Publishing. 2013 óta megoldástervezőként segítette az AWS ügyfeleit az AI/ML technológia alkalmazásában. Jelenleg Denis az AI/ML világszintű műszaki vezetője, aki az AWS ML Specialist Solutions Architects globális működéséért felelős. Denis gyakori felszólaló, követheti őt a Twitteren @dbatalov.

Dr. Sara Liu az AWS Responsible AI csapatának vezető műszaki programmenedzsere. Tudósokból, adatkészlet-vezetőkből, ML-mérnökökből, kutatókból és más, több funkciót is betöltő csapatokkal dolgozik együtt, hogy megemelje a felelős AI-lécet az AWS AI-szolgáltatásai között. Jelenlegi projektjei közé tartozik a mesterséges intelligencia szolgáltatási kártyáinak fejlesztése, a felelős mesterséges intelligencia kockázatelemzése, a kiváló minőségű értékelési adatkészletek létrehozása és a minőségi programok megvalósítása. Emellett segít a belső csapatoknak és ügyfeleknek megfelelni a fejlődő AI iparági szabványoknak.

Dr. Sara Liu az AWS Responsible AI csapatának vezető műszaki programmenedzsere. Tudósokból, adatkészlet-vezetőkből, ML-mérnökökből, kutatókból és más, több funkciót is betöltő csapatokkal dolgozik együtt, hogy megemelje a felelős AI-lécet az AWS AI-szolgáltatásai között. Jelenlegi projektjei közé tartozik a mesterséges intelligencia szolgáltatási kártyáinak fejlesztése, a felelős mesterséges intelligencia kockázatelemzése, a kiváló minőségű értékelési adatkészletek létrehozása és a minőségi programok megvalósítása. Emellett segít a belső csapatoknak és ügyfeleknek megfelelni a fejlődő AI iparági szabványoknak.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/learn-how-to-assess-risk-of-ai-systems/

- :van

- :is

- :nem

- :ahol

- 100

- 118

- 150

- 2013

- 2023

- 33

- 7

- a

- Rólunk

- felgyorsult

- gyorsuló

- elfogadható

- Szerint

- Elérése

- át

- tevékenység

- Ádám

- cím

- elfogadja

- Örökbefogadás

- előre

- haladás

- érintett

- Után

- előre

- AI

- AI kockázatok

- AI szolgáltatások

- AI rendszerek

- AI / ML

- igazított

- Minden termék

- mentén

- Is

- amazon

- Az Amazon Web Services

- között

- összeg

- an

- és a

- bármilyen

- Alkalmazás

- alkalmazott

- alkalmazások

- építészek

- VANNAK

- mesterséges

- mesterséges intelligencia

- AS

- szempontok

- értékeli

- értékelni

- értékelése

- értékelés

- értékelések

- társult

- At

- részvétel

- elérhető

- AWS

- AWS gépi tanulás

- bár

- akadályok

- alapján

- BE

- válik

- egyre

- hogy

- haszon

- Előnyök

- Jobb

- kukák

- könyv

- széles

- épít

- üzleti

- de

- by

- TUD

- képességek

- képes

- fogások

- Kártyák

- ami

- Karrier

- gondosan

- eset

- kategóriák

- okozott

- bizonyos

- változik

- jellemez

- ellenőrizze

- Klíma

- Klímaváltozás

- együttműködő

- kombináció

- jön

- Hozzászólások

- elkötelezett

- teljes

- teljesítés

- összetevő

- fogalmak

- vezető

- konferenciák

- Következmények

- Következésképpen

- Fontolja

- figyelembe vett

- figyelembe véve

- tartalom

- tartalomalkotás

- kontextus

- tovább

- ellenőrzések

- Mag

- Megfelelő

- tudott

- teremt

- létrehozása

- teremtés

- kreativitás

- többfunkciós csapatok

- Jelenlegi

- Jelenleg

- Ügyfelek

- adatkészletek

- határozatok

- ajánlás

- meghatározott

- meghatározott

- Fok

- demográfiai

- Demográfiai

- bemutatását,

- telepíteni

- bevetés

- leíró

- leírás

- Design

- tervezett

- részletek

- fejlesztése

- Fejlesztés

- különböző

- Dimenzió

- méretek

- közvetlen

- megvitatni

- zavarok

- dinamikus

- minden

- pénzt keres

- könnyebb

- könnyű

- hatás

- erőfeszítések

- csiszolókő

- lehetővé

- felöleli

- bátorító

- engagements

- Mérnöki

- Mérnökök

- fokozott

- biztosítása

- Vállalkozás

- megalapozott

- létrehozó

- becslés

- becsült

- értékelték

- értékelés

- esemény

- események

- fejlődik

- példa

- izgalmas

- kiállító

- kiállítási

- szakvélemény

- feltárása

- Arc

- tény

- faktoring

- méltányosság

- mező

- Ábra

- utolsó

- pénzügyi

- vezetéknév

- Összpontosít

- koncentrál

- következik

- következő

- A

- legelső

- Alapítvány

- Keretrendszer

- keretek

- gyakori

- ból ből

- Tele

- működése

- további

- generál

- nemző

- Generatív AI

- kap

- globálisan

- cél

- jó

- kormányzás

- Csoportok

- Vendég

- kárt

- káros

- Legyen

- he

- fejek

- segít

- segített

- hasznos

- segít

- neki

- Magas

- jó minőségű

- legnagyobb

- nagyon

- őt

- Hogyan

- How To

- azonban

- HTML

- HTTPS

- azonosított

- azonosítani

- if

- Hatás

- Hatások

- végrehajtás

- végrehajtási

- fontos

- javul

- javított

- in

- beleértve

- Beleértve

- egyre inkább

- egyéni

- ipar

- ipari szabványok

- befolyás

- velejáró

- kezdetben

- újító

- bemenet

- belső

- Intelligencia

- kölcsönhatásba

- belső

- vonja

- részt

- ISO

- szigetelés

- IT

- maga

- utazás

- jpg

- Tart

- Kulcs

- Alaphang

- Keynote Speaker

- tudás

- nyelv

- nagy

- indított

- törvények

- vezető

- vezetők

- vezetékek

- TANUL

- tanulás

- Jogalkotás

- szint

- szintek

- valószínűség

- Valószínű

- vonalak

- Lista

- keres

- Elő/Utó

- alacsonyabb

- gép

- gépi tanulás

- készült

- csinál

- kezelése

- vezetés

- menedzser

- sok

- térkép

- Mátrix

- Maximize

- Lehet..

- intézkedés

- intézkedések

- mechanizmusok

- Találkozik

- esetleg

- bánja

- kisebb

- Enyhít

- enyhítés

- ML

- Mobil

- mobil-alkalmazásokat

- modell

- modellek

- több

- többszörös

- ugyanis

- igények

- negatív

- soha

- következő

- nst

- normák

- megjegyezni

- számok

- számos

- célok

- esemény

- előforduló

- of

- on

- működés

- operatív

- Lehetőségek

- or

- szervezet

- szervezetek

- Más

- Egyéb

- másképp

- mi

- ki

- kimenetek

- megkereső

- átfogó

- áttekintés

- Béke

- rész

- különös

- ösvény

- mert

- érzékelt

- Személyre

- perspektívák

- phd

- vedd

- terv

- Plató

- Platón adatintelligencia

- PlatoData

- pont

- Politikák

- pozitív

- állás

- potenciális

- potenciálisan

- erős

- Készít

- bemutatott

- elsősorban

- elvek

- proaktív

- Probléma

- folyamat

- termelő

- Termékek

- Program

- Programok

- projektek

- támogatása

- ad

- amely

- nyilvános

- közzétett

- Kiadás

- minőségi

- világítás

- emel

- hatótávolság

- kezdve

- gyorsan

- RITKA

- értékelés

- észre

- arat

- nemrég

- csökkenteni

- tükröznie

- tekintettel

- előírások

- megbízhatóság

- megmaradó

- megismételt

- reprezentatív

- képviselők

- jelentése

- követelmények

- megköveteli,

- kutatók

- kutatások

- felelős

- felelősségteljesen

- eredményez

- kapott

- Kockázat

- kockázatértékelés

- kockázatkezelés

- kockázatok

- robusztusság

- szerepek

- biztonságos

- Biztonság

- sagemaker

- értékesítés

- azonos

- Skála

- Mérleg

- forgatókönyv

- rendszer

- Tudomány

- tudományos

- Tudós

- tudósok

- Keresés

- biztonság

- biztonság

- idősebb

- értelemben

- szolgáltatás

- Szolgáltatások

- számos

- Megosztás

- megosztás

- ő

- kellene

- előadás

- Műsorok

- óta

- helyzet

- Közösség

- Társadalom

- Megoldások

- néhány

- Hangszóró

- szakember

- különleges

- kifejezetten

- Spektrum

- érdekeltek

- érdekeltek

- szabványok

- kezdet

- kezdődött

- Kezdve

- Állami

- Lépés

- Lépései

- Stratégiai

- stratégiák

- ilyen

- javasolja,

- ÖSSZEFOGLALÓ

- támogatás

- rendszer

- Systems

- bevétel

- csapat

- csapat

- tech

- Műszaki

- Technologies

- Technológia

- hogy

- A

- a világ

- azok

- akkor

- Ott.

- Ezek

- ők

- ezt

- azok

- Keresztül

- egész

- időzített

- nak nek

- együtt

- Átalakítás

- Bízzon

- kettő

- tipikus

- bizonytalanságok

- Bizonytalanság

- megértés

- egyetemi

- kinyitó

- használ

- használati eset

- Felhasználók

- segítségével

- nagyon

- veterán

- sérülékenységek

- we

- háló

- webes szolgáltatások

- JÓL

- Mit

- amikor

- mivel

- ami

- míg

- lesz

- val vel

- belül

- dolgozott

- munkafolyamat

- dolgozó

- művek

- világ

- világszerte

- te

- A te

- zephyrnet