Örömmel jelentjük be Amazon SageMaker JumpStart immár nagy nyelvi modell (LLM) következtetési válaszokat sugározhat. A token streaming lehetővé teszi, hogy megtekinthesse a modellválasz kimenetét, amint az generálás alatt áll, ahelyett, hogy megvárná, amíg az LLM-ek befejezik a válaszgenerálást, mielőtt az elérhetővé válna az Ön számára. A SageMaker JumpStart streaming képessége segíthet jobb felhasználói élményt nyújtó alkalmazások létrehozásában azáltal, hogy a végfelhasználó számára alacsony késleltetési időt kelt.

Ebben a bejegyzésben bemutatjuk, hogyan telepíthető és streamelhető a válasz a Falcon 7B Instruct modell végpont.

Az írás idején a SageMaker JumpStartban elérhető következő LLM-ek támogatják a streamelést:

- Mistral AI 7B, Mistral AI 7B utasítás

- Falcon 180B, Falcon 180B Chat

- Falcon 40B, Falcon 40B utasítás

- Falcon 7B, Falcon 7B utasítás

- Rinna japán GPT NeoX 4B utasítás PPO

- Rinna japán GPT NeoX 3.6B utasítás PPO

A SageMaker JumpStart streamelést támogató modellek listájának frissítéséhez keressen rá a „huggingface-llm” kifejezésre itt: Beépített algoritmusok előre betanított modelltáblázattal.

Vegye figyelembe, hogy használhatja a streaming funkció of Amazon SageMaker a SageMaker TGI Deep Learning Container (DLC) használatával üzembe helyezett bármely modellhez, a leírás szerint. Bejelentjük az új Hugging Face LLM Inference konténerek elindítását az Amazon SageMakeren.

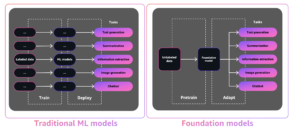

Alapozó modellek a SageMakerben

A SageMaker JumpStart számos modellhez biztosít hozzáférést a népszerű modellközpontokból, beleértve a Hugging Face-t, a PyTorch Hub-ot és a TensorFlow Hub-ot, amelyeket a SageMaker ML-fejlesztési munkafolyamataiban használhat fel. Az ML közelmúltbeli fejlődése a modellek új osztályát eredményezte alapozó modellek, amelyek jellemzően több milliárd paraméterre vannak kiképezve, és a felhasználási esetek széles kategóriájához illeszthetők, mint például a szövegösszegzés, a digitális művészet generálása és a nyelvi fordítás. Mivel ezeknek a modelleknek a betanítása költséges, az ügyfelek a meglévő, előre betanított alapozómodelleket szeretnék használni, és szükség szerint finomhangolni őket, ahelyett, hogy maguk képeznék ki ezeket a modelleket. A SageMaker a modellek válogatott listáját kínálja, amelyek közül választhat a SageMaker konzolon.

Mostantól a SageMaker JumpStartban különböző modellszolgáltatóktól származó alapozó modelleket találhat, így gyorsan elkezdheti az alapozó modelleket. A SageMaker JumpStart különböző feladatokon vagy modellszolgáltatókon alapuló alapmodelleket kínál, és könnyen áttekintheti a modell jellemzőit és használati feltételeit. Ezeket a modelleket egy teszt UI widget segítségével is kipróbálhatja. Ha nagyszabású alapmodellt szeretne használni, a SageMaker elhagyása nélkül megteheti a modellszolgáltatók előre elkészített notebookjainak használatával. Mivel a modelleket az AWS-ben tárolják és telepítik, Ön bízik abban, hogy adatait – akár a modell kiértékeléséhez, akár nagyszabású használatához használják – nem osztják meg harmadik felekkel.

Token streaming

A token adatfolyam lehetővé teszi a következtetési válasz visszaadását, ahogy azt a modell generálja. Így láthatja a fokozatosan generált választ, ahelyett, hogy megvárná a modell befejezését, mielőtt a teljes választ adná. A streamelés elősegítheti a jobb felhasználói élmény biztosítását, mivel csökkenti a végfelhasználó várakozási idejét. Elkezdheti látni a kimenetet generálás közben, és ezért korán leállíthatja a generálást, ha a kimenet nem tűnik hasznosnak az Ön céljaira. A streamelés nagy különbséget jelenthet, különösen a hosszan futó lekérdezések esetében, mivel a kimenetek generálása közben megjelennek, ami alacsonyabb késleltetést eredményezhet, még akkor is, ha a végpontok közötti késleltetés változatlan marad.

Az írás pillanatában a Hugging Face LLM-et használó modelleknél használhatod a streamelést a SageMaker JumpStartban. Szöveggenerálási következtetés DLC.

| Válasz: Nincs gőzölés | Válasz a streameléssel |

Megoldás áttekintése

Ebben a bejegyzésben a Falcon 7B Instruct modellt használjuk a SageMaker JumpStart streaming képességének bemutatására.

A következő kóddal kereshet más modelleket a SageMaker JumpStartban, amelyek támogatják a streamelést:

A következő modellazonosítókat kapjuk, amelyek támogatják a streamelést:

Előfeltételek

A notebook futtatása előtt néhány kezdeti lépés szükséges a beállításhoz. Futtassa a következő parancsokat:

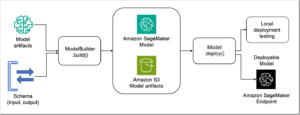

Telepítse a modellt

Első lépésként a SageMaker JumpStart segítségével telepítse a Falcon 7B Instruct modellt. A teljes útmutatásért lásd: A TII Falcon 180B alapozó modellje már elérhető az Amazon SageMaker JumpStart szolgáltatáson keresztül. Használja a következő kódot:

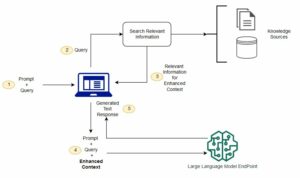

Kérdezze le a végpontot és az adatfolyam-választ

Ezután hozzon létre egy hasznos adatot a telepített végpont meghívásához. Fontos, hogy a hasznos adatnak tartalmaznia kell a kulcs/érték párt "stream": True. Ez jelzi a szöveggeneráló következtetési kiszolgálónak, hogy generáljon adatfolyam-választ.

A végpont lekérdezése előtt létre kell hoznia egy iterátort, amely képes elemezni a bájtfolyam-választ a végponttól. Az egyes jogkivonatok adatai külön sorként jelennek meg a válaszban, így ez az iterátor minden alkalommal egy tokent ad vissza, amikor új sort azonosítanak a streaming pufferben. Ezt az iterátort minimálisan tervezték, és érdemes lehet a viselkedését az Ön használati esetéhez igazítani; Például míg ez az iterátor jogkivonat-karakterláncokat ad vissza, a soradatok olyan egyéb információkat is tartalmaznak, mint például a jogkivonat naplójának valószínűsége, amelyek érdekesek lehetnek.

Most már használhatja a Boto3-at invoke_endpoint_with_response_stream API-t a létrehozott végponton, és engedélyezze az adatfolyamot az a feletti iterációval TokenIterator példa:

Üres megadása end paraméter a print funkció lehetővé teszi a vizuális adatfolyamot új sorkarakterek beszúrása nélkül. Ez a következő kimenetet eredményezi:

Használhatja ezt a kódot egy notebookban vagy más alkalmazásokban, például a Streamlitben vagy a Gradioban, hogy megtekinthesse a streamelést működés közben és az általa nyújtott élményt ügyfelei számára.

Tisztítsuk meg

Végül ne felejtse el megtisztítani a telepített modellt és végpontot, hogy elkerülje a további költségeket:

Következtetés

Ebben a bejegyzésben megmutattuk, hogyan használhatja a SageMaker JumpStart újonnan elindított streaming funkcióját. Reméljük, hogy a token streaming képességet használja majd olyan interaktív alkalmazások létrehozására, amelyek alacsony késleltetést igényelnek a jobb felhasználói élmény érdekében.

A szerzőkről

Rachna Chadha az AWS stratégiai számláinak fő megoldástervezője, az AI/ML. Rachna optimista, aki hisz abban, hogy az AI etikus és felelős használata javíthatja a társadalmat a jövőben, és gazdasági és társadalmi jólétet hozhat. Szabadidejében Rachna szereti a családjával tölteni az idejét, kirándulni és zenét hallgatni.

Rachna Chadha az AWS stratégiai számláinak fő megoldástervezője, az AI/ML. Rachna optimista, aki hisz abban, hogy az AI etikus és felelős használata javíthatja a társadalmat a jövőben, és gazdasági és társadalmi jólétet hozhat. Szabadidejében Rachna szereti a családjával tölteni az idejét, kirándulni és zenét hallgatni.

Dr. Kyle Ulrich egy alkalmazott tudós a Amazon SageMaker beépített algoritmusok csapat. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Kyle Ulrich egy alkalmazott tudós a Amazon SageMaker beépített algoritmusok csapat. Kutatási területei közé tartoznak a skálázható gépi tanulási algoritmusok, a számítógépes látás, az idősorok, a Bayes-féle nem-paraméterek és a Gauss-folyamatok. Doktori fokozatát a Duke Egyetemen szerezte, és publikációkat publikált a NeurIPS-ben, a Cell-ben és a Neuron-ban.

Dr. Ashish Khetan vezető alkalmazott tudós az Amazon SageMaker beépített algoritmusaival, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

Dr. Ashish Khetan vezető alkalmazott tudós az Amazon SageMaker beépített algoritmusaival, és segít gépi tanulási algoritmusok fejlesztésében. PhD fokozatát az Illinois Urbana-Champaign Egyetemen szerezte. A gépi tanulás és a statisztikai következtetések aktív kutatója, és számos közleményt publikált NeurIPS, ICML, ICLR, JMLR, ACL és EMNLP konferenciákon.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/stream-large-language-model-responses-in-amazon-sagemaker-jumpstart/

- :van

- :is

- $ UP

- 1

- 10

- 100

- 12

- 13

- 14

- 19

- 7

- 8

- a

- Rólunk

- hozzáférés

- Fiókok

- Akció

- aktív

- hozzá

- További

- előlegek

- tanács

- AI

- AI / ML

- algoritmusok

- lehetővé teszi, hogy

- Is

- amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- an

- és a

- bejelent

- bármilyen

- api

- alkalmazások

- alkalmazott

- VANNAK

- Művészet

- AS

- At

- elérhető

- elkerülése érdekében

- AWS

- alapján

- bayesi

- BE

- mert

- előtt

- viselkedés

- hogy

- úgy gondolja,

- Jobb

- Nagy

- milliárd

- test

- Doboz

- hoz

- ütköző

- épít

- beépített

- de

- by

- TUD

- képesség

- eset

- esetek

- Kategória

- jellemzők

- karakter

- ellenőrizze

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- osztály

- ragadozó ölyv

- vásárló

- kód

- teljes

- bonyolult

- számítógép

- Számítógépes látás

- konferenciák

- Konzol

- konstrukció

- tartalmaz

- Konténer

- Konténerek

- tartalmaz

- tartalom

- kiadások

- tudott

- teremt

- készítette

- létrehozása

- CSS

- a válogatott

- Ügyfelek

- dátum

- csökken

- mély

- mély tanulás

- telepíteni

- telepített

- leírt

- Design

- tervezett

- Tervező

- Határozzuk meg

- Fejleszt

- Fejlesztő

- Fejlesztés

- különbség

- különböző

- digitális

- digitális művészet

- kijelző

- do

- domain

- Domain név

- Herceg

- herceg egyetem

- minden

- Korai

- könnyen

- Gazdasági

- lehetővé

- lehetővé téve

- végtől végig

- Endpoint

- Motorok

- biztosítására

- különösen

- etikai

- értékelő

- Még

- példa

- izgatott

- létező

- drága

- tapasztalat

- Arc

- család

- Funkció

- Szűrők

- Találjon

- befejezni

- vezetéknév

- következő

- A

- Alapítvány

- Keretrendszer

- ból ből

- Tele

- funkció

- jövő

- általában

- generál

- generált

- generáló

- generáció

- kap

- adott

- Célok

- kapott

- útmutató

- Legyen

- he

- segít

- hasznos

- segít

- neki

- övé

- remény

- házigazdája

- tárhely

- Hogyan

- How To

- HTML

- HTTPS

- Kerékagy

- csomópontok

- HuggingFace

- i

- azonosított

- ids

- if

- Illinois

- importál

- ami fontos

- javul

- in

- tartalmaz

- Beleértve

- jelzi

- információ

- kezdetben

- bemenet

- telepíteni

- példa

- helyette

- utasítás

- interaktív

- kamat

- érdekek

- IT

- ITS

- japán

- JavaScript

- json

- Tart

- ismert

- Kyle

- nyelv

- nagy

- Késleltetés

- indít

- indított

- tanulás

- kilépő

- mint

- Kedvencek

- vonal

- Lista

- Kihallgatás

- LLM

- log

- keres

- Elő/Utó

- alacsonyabb

- gép

- gépi tanulás

- készült

- fenntartása

- csinál

- sok

- Lehet..

- esetleg

- ML

- modell

- modellek

- zene

- név

- Szükség

- szükséges

- Új

- újonnan

- nem

- jegyzetfüzet

- Most

- of

- Ajánlatok

- on

- online

- Optimalizálja

- or

- Más

- ki

- teljesítmény

- kimenetek

- felett

- pár

- papírok

- paraméter

- paraméterek

- fél

- észlelés

- phd

- Plató

- Platón adatintelligencia

- PlatoData

- Népszerű

- állás

- Predictor

- Fő

- folyamat

- Folyamatok

- termel

- megfelelően

- jólét

- feltéve,

- ellátó

- szolgáltatók

- biztosít

- amely

- közzétett

- cél

- célokra

- pytorch

- lekérdezések

- gyorsan

- hatótávolság

- Inkább

- új

- utal

- rendszeresen

- eszébe jut

- kötelező

- kutatás

- kutató

- Tudástár

- válasz

- válaszok

- felelős

- visszatérés

- Visszatér

- Kritika

- Emelkedik

- futás

- futás

- sagemaker

- azonos

- skálázható

- Skála

- Tudós

- Keresés

- Keresők

- lát

- látás

- Keresnek

- MAGA

- idősebb

- különálló

- Series of

- szerver

- Szolgáltatások

- felépítés

- megosztott

- kellene

- kirakat

- kimutatta,

- simán

- So

- Közösség

- Társadalom

- megoldások

- néhány

- Költési

- kezdet

- kezdődött

- statisztikai

- Lépés

- Lépései

- megáll

- Stratégiai

- folyam

- folyó

- ilyen

- támogatás

- Támogató

- Feladat

- feladatok

- csapat

- sablonok

- tensorflow

- feltételek

- teszt

- szöveg

- mint

- hogy

- A

- A vonal

- Őket

- maguk

- Ott.

- ebből adódóan

- Ezek

- Harmadik

- harmadik felek

- ezt

- bár?

- Keresztül

- idő

- Idősorok

- nak nek

- jelképes

- Vonat

- kiképzett

- Fordítás

- igaz

- Bízzon

- megpróbál

- oktatóanyagok

- jellemzően

- ui

- egyetemi

- Frissítések

- Frissítés

- Használat

- használ

- használati eset

- használt

- használó

- User Experience

- segítségével

- hasznosít

- keresztül

- látomás

- várjon

- Várakozás

- séta

- akar

- Út..

- we

- háló

- webes szolgáltatások

- weboldal

- amikor

- vajon

- ami

- míg

- WHO

- széles

- lesz

- val vel

- belül

- nélkül

- munkafolyamat

- dolgozó

- írás

- te

- A te

- zephyrnet