A pénzügyi szolgáltatási ágazat (FinServ) egyedi generatív mesterségesintelligencia-követelményekkel rendelkezik a tartományspecifikus adatokkal, az adatbiztonsággal, a szabályozási ellenőrzésekkel és az iparági megfelelőségi szabványokkal kapcsolatban. Ezenkívül az ügyfelek olyan lehetőségeket keresnek, amelyek segítségével kiválaszthatják a legteljesítményesebb és legköltséghatékonyabb gépi tanulási (ML) modellt, valamint az üzleti felhasználási eseteikhez igazodó szükséges testreszabási (finomhangolási) lehetőségeket. Amazon SageMaker JumpStart ideális a generatív mesterséges intelligencia felhasználási esetekre a FinServ ügyfelek számára, mivel biztosítja a szükséges adatbiztonsági ellenőrzéseket és megfelel a megfelelőségi szabványok követelményeinek.

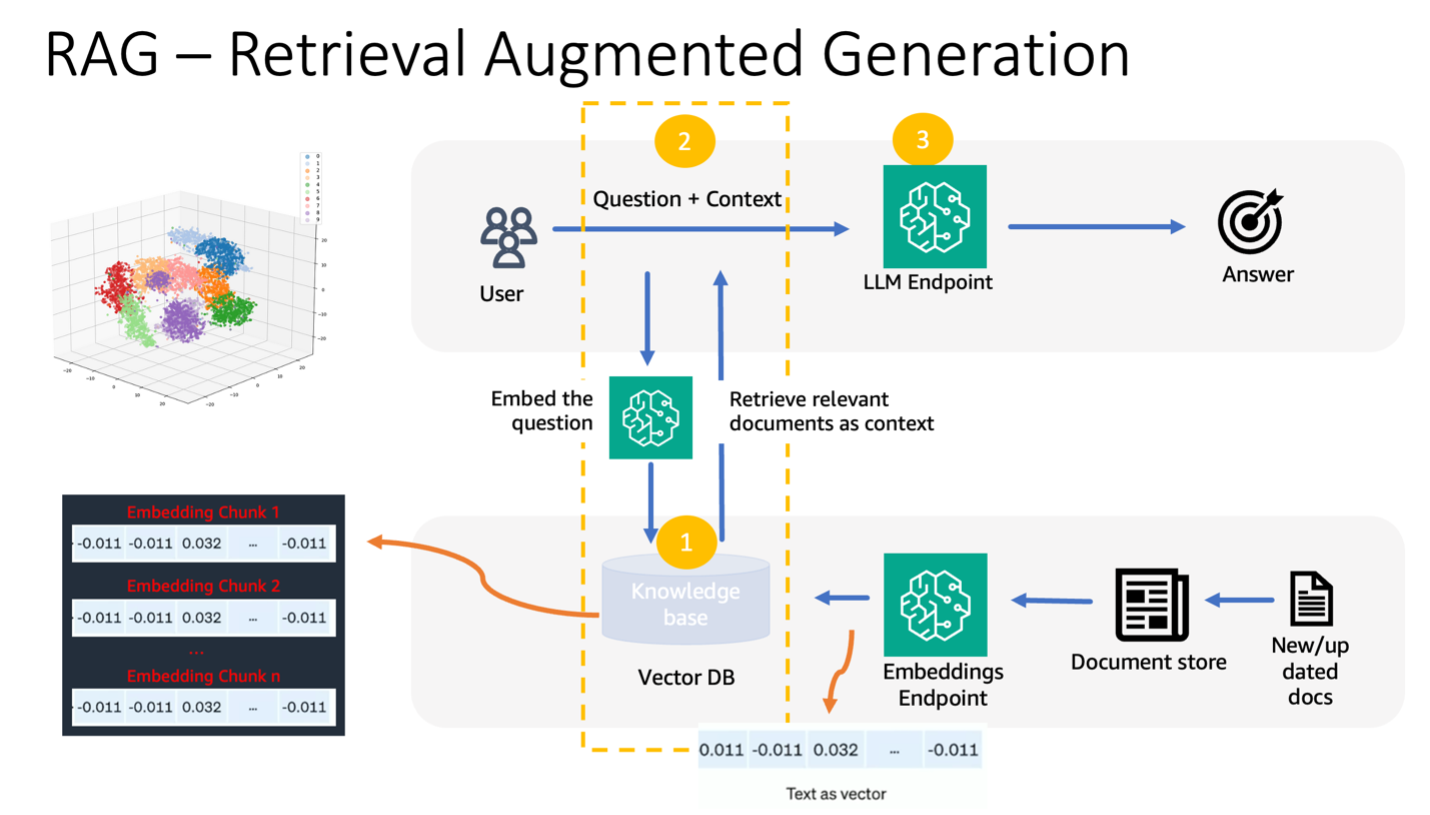

Ebben a bejegyzésben a Retrieval Augmented Generation (RAG) alapú megközelítést és a SageMaker JumpStart nagy nyelvi modelljeit (LLM) használó kérdésmegválaszolási feladatokat mutatjuk be egy egyszerű pénzügyi tartomány használati esetével. A RAG egy keretrendszer a szöveggenerálás minőségének javítására az LLM és az információvisszakereső (IR) rendszer kombinálásával. Az LLM generált szöveget, és az IR rendszer a releváns információkat egy tudásbázisból kéri le. A visszakeresett információkat azután az LLM bemenetének kiegészítésére használják, ami segíthet a modell által generált szöveg pontosságának és relevanciájának javításában. A RAG hatékonynak bizonyult számos szöveggenerálási feladatnál, mint például a kérdések megválaszolása és az összegzés. Ígéretes megközelítés a szöveggeneráló modellek minőségének és pontosságának javítására.

A SageMaker JumpStart használatának előnyei

A SageMaker JumpStart segítségével az ML szakemberek a legmodernebb modellek széles választékából válogathatnak olyan felhasználási esetekre, mint a tartalomírás, képgenerálás, kódgenerálás, kérdések megválaszolása, szövegírás, összegzés, osztályozás, információkeresés stb. Az ML gyakorlói alapmodelleket telepíthetnek dedikált Amazon SageMaker példányokat egy hálózattól elszigetelt környezetből, és testreszabhatja a modelleket a SageMaker segítségével a modell betanítására és telepítésére.

A SageMaker JumpStart ideálisan alkalmas a FinServ ügyfelek generatív mesterséges intelligencia felhasználási eseteire, mivel a következőket kínálja:

- Testreszabási lehetőségek – A SageMaker JumpStart példajegyzetfüzeteket és részletes bejegyzéseket kínál az alapmodellek tartományi adaptációjához lépésről lépésre. Ezeket az erőforrásokat követheti az alapmodellek finomhangolásához, tartomány-adaptációjához és utasításaihoz, illetve RAG-alapú alkalmazások létrehozásához.

- Adatbiztonság – A következtetési hasznos adatok biztonságának biztosítása a legfontosabb. A SageMaker JumpStart segítségével a modelleket hálózati elszigeteltségben telepítheti, egyetlen bérlési végpont biztosításával. Ezenkívül kezelheti a kiválasztott modellekhez való hozzáférés-szabályozást a privát modellközpont funkción keresztül, igazodva az egyéni biztonsági követelményekhez.

- Szabályozási ellenőrzések és megfelelés – Az olyan szabványoknak való megfelelés, mint a HIPAA BAA, SOC123, PCI és HITRUST CSF, a SageMaker alapvető jellemzője, amely biztosítja a pénzügyi szektor szigorú szabályozási környezetéhez való igazodást.

- Modell választások – A SageMaker JumpStart a legkorszerűbb ML modellek választékát kínálja, amelyek folyamatosan a legjobbak közé tartoznak az iparágban elismert HELM-benchmarkok között. Ide tartoznak többek között a Llama 2, Falcon 40B, AI21 J2 Ultra, AI21 Summarize, Hugging Face MiniLM és BGE modellek.

Ebben a bejegyzésben egy kontextuális chatbot felépítését vizsgáljuk pénzügyi szolgáltató szervezetek számára, amelyek RAG architektúrát használnak a Llama 2 alapmodell és a Átölelhető arc GPTJ-6B-FP16 beágyazási modell, mindkettő elérhető a SageMaker JumpStartban. Mi is használjuk Vector motor mert Amazon OpenSearch kiszolgáló nélküli (jelenleg előnézetben), mint a vektoros adattár a beágyazások tárolására.

A nagy nyelvi modellek korlátai

Az LLM-eket hatalmas mennyiségű strukturálatlan adatra képezték ki, és kiválóak az általános szöveggenerálásban. Ezen a képzésen keresztül az LLM-ek tényszerű ismereteket szereznek és tárolnak. A kész LLM-ek azonban korlátozásokat tartalmaznak:

- Offline képzésük miatt nem vesznek tudomást a naprakész információkról.

- A túlnyomórészt általánosított adatokra vonatkozó képzésük csökkenti a szakterület-specifikus feladatokban való hatékonyságukat. Például egy pénzügyi cég előnyben részesítheti a Q&A botját, hogy a válaszokat a legújabb belső dokumentumaiból szerezze be, biztosítva ezzel a pontosságot és az üzleti szabályainak való megfelelést.

- A beágyazott információkra való támaszkodásuk veszélyezteti az értelmezhetőséget.

Konkrét adatok LLM-ekben való felhasználásához három elterjedt módszer létezik:

- Az adatok modellbe való beágyazása kéri, lehetővé téve a kontextus felhasználását a kimenet generálása során. Ez lehet zero-shot (nincs példa), néhány lövés (korlátozott példák) vagy sok lövés (bőséges példa). Az ilyen kontextuális felszólítás árnyaltabb eredmények felé tereli a modelleket.

- A modell finomhangolása promptok és kiegészítések páros használatával.

- RAG, amely lekéri a külső adatokat (nem paraméteres), és integrálja ezeket az adatokat a promptokba, gazdagítva a kontextust.

Az első módszer azonban megbirkózik a kontextusmérettel kapcsolatos modellkorlátokkal, ami megnehezíti a hosszadalmas dokumentumok bevitelét, és esetleg megnöveli a költségeket. A finomhangolási megközelítés, bár hatékony, erőforrás-igényes, különösen az állandóan változó külső adatok miatt, ami késleltetett telepítésekhez és megnövekedett költségekhez vezet. A RAG az LLM-ekkel kombinálva megoldást kínál a korábban említett korlátokra.

Visszakeresés kiterjesztett generáció

A RAG lekéri a külső adatokat (nem paraméteres), és ezeket az adatokat ML promptokba integrálja, gazdagítva a kontextust. Lewis et al. 2020-ban bevezette a RAG-modelleket, egy előre betanított szekvencia-szekvencia modell (paraméteres memória) és egy neurális retrieveren keresztül elérhető Wikipédia sűrű vektorindexének (nem-paraméteres memória) fúziójaként képzelve el őket.

A RAG működése a következő:

- Adatforrások – A RAG különféle adatforrásokból meríthet, beleértve a dokumentumtárakat, adatbázisokat vagy API-kat.

- Adatformázás – Mind a felhasználói lekérdezés, mind a dokumentumok a relevancia-összehasonlításra alkalmas formátumba kerülnek.

- embeddings – Az összehasonlítás megkönnyítése érdekében a lekérdezést és a dokumentumgyűjteményt (vagy tudástárat) nyelvi modellek segítségével numerikus beágyazásokká alakítják. Ezek a beágyazások numerikusan magukba foglalják a szöveges fogalmakat.

- Relevancia keresés – A felhasználói lekérdezés beágyazását a rendszer összehasonlítja a dokumentumgyűjtemény beágyazásaival, és a beágyazási területen végzett hasonlósági kereséssel azonosítja a releváns szöveget.

- Kontextus gazdagítása – Az azonosított releváns szöveget a felhasználó eredeti promptjához fűzi, javítva ezzel annak kontextusát.

- LLM feldolgozás – A kibővített kontextussal a prompt az LLM-be kerül, amely a releváns külső adatok bevonásával releváns és pontos kimeneteket produkál.

- Aszinkron frissítések – Annak érdekében, hogy a referenciadokumentumok naprakészek maradjanak, aszinkron módon frissíthetők a beágyazott ábrázolásaikkal együtt. Ez biztosítja, hogy a jövőbeli modellválaszok a legfrissebb információkon alapuljanak, garantálva a pontosságot.

Lényegében a RAG egy dinamikus módszert kínál az LLM-ek valós idejű, releváns információkkal való feltöltésére, biztosítva a pontos és időszerű kimenetek generálását.

A következő diagram bemutatja a RAG és az LLM-ekkel való használat fogalmi folyamatát.

Megoldás áttekintése

A következő lépések szükségesek ahhoz, hogy egy pénzügyi szolgáltatási alkalmazáshoz kontextuális kérdést megválaszoló chatbotot hozzon létre:

- A SageMaker JumpStart GPT-J-6B beágyazási modell használatával hozzon létre beágyazást minden egyes PDF dokumentumhoz a Amazon egyszerű tárolási szolgáltatás (Amazon S3) feltöltési könyvtár.

- Azonosítsa a releváns dokumentumokat a következő lépésekkel:

- Hozzon létre beágyazást a felhasználó lekérdezéséhez ugyanazzal a modellel.

- Használja az OpenSearch Serverless-t a vektormotor funkcióval, hogy megkeresse a K legfontosabb dokumentumindexet a beágyazási területen.

- Keresse le a megfelelő dokumentumokat az azonosított indexek segítségével.

- Kombinálja a letöltött dokumentumokat kontextusként a felhasználó kérdésével és kérdésével. Továbbítsa ezt a SageMaker LLM-nek válaszgenerálás céljából.

Ennek a folyamatnak a lebonyolítására a LangChaint, egy népszerű keretrendszert alkalmazzuk. A LangChaint kifejezetten az LLM-ek által működtetett alkalmazások támogatására tervezték, és univerzális interfészt kínál a különböző LLM-ek számára. Leegyszerűsíti a több LLM integrációját, biztosítva a zökkenőmentes állapot-megmaradást a hívások között. Ezenkívül olyan funkciókkal növeli a fejlesztők hatékonyságát, mint a testreszabható prompt sablonok, átfogó alkalmazásépítő ügynökök, valamint a kereséshez és visszakereséshez szükséges speciális indexek. A mélyreható megértéshez tekintse meg a LangChain dokumentáció.

Előfeltételek

A környezettudatos chatbotunk elkészítéséhez a következő előfeltételekre van szüksége:

Az OpenSearch kiszolgáló nélküli vektormotor beállításához lásd: Bemutatjuk az Amazon OpenSearch Serverless vektormotorját, most előnézetben.

A következő megoldás átfogó áttekintéséhez klónozza a GitHub repo és utaljon a Jupyter notebook.

Telepítse az ML modelleket a SageMaker JumpStart segítségével

Az ML modellek üzembe helyezéséhez hajtsa végre a következő lépéseket:

- Telepítse a Llama 2 LLM-et a SageMaker JumpStartból:

- Telepítse a GPT-J beágyazási modellt:

Csoportosítsa az adatokat, és hozzon létre egy dokumentumbeágyazási objektumot

Ebben a szakaszban az adatokat kisebb dokumentumokra bonthatja. A darabolás a nagy szövegek kisebb darabokra bontásának módszere. Ez elengedhetetlen lépés, mert optimalizálja a keresési lekérdezés relevanciáját a RAG modellünkhöz, ami viszont javítja a chatbot minőségét. A darab mérete olyan tényezőktől függ, mint a dokumentum típusa és a használt modell. A darab chunk_size=1600 lett kiválasztva, mert ez egy bekezdés hozzávetőleges mérete. Ahogy a modellek javulnak, a kontextusablak mérete növekszik, ami nagyobb darabméreteket tesz lehetővé.

Utal Jupyter jegyzetfüzet a GitHub repóban a teljes megoldásért.

- Hosszabbítsa meg a LangChaint

SageMakerEndpointEmbeddingsosztályt egy egyéni beágyazási függvény létrehozásához, amely a korábban létrehozott gpt-j-6b-fp16 SageMaker végpontot használja (a beágyazási modell alkalmazásának részeként): - Hozd létre a beágyazási objektumot, és kötegesítse a dokumentumbeágyazások létrehozását:

- Ezek a beágyazások a vektormotorban tárolódnak a LangChain segítségével

OpenSearchVectorSearch. Ezeket a beágyazásokat a következő részben tárolja. Tárolja a dokumentumbeágyazást az OpenSearch Serverlessben. Most már készen áll arra, hogy végigfusson a csonkolt dokumentumokon, létrehozza a beágyazásokat, és tárolja ezeket a beágyazásokat a vektorkereső gyűjteményekben létrehozott OpenSearch Serverless vektorindexben. Lásd a következő kódot:

Kérdések és válaszok dokumentumokon keresztül

Eddig egy nagy dokumentumot kisebbekre darabolt, vektoros beágyazásokat hozott létre, és tárolt egy vektormotorban. Most már válaszolhat a dokumentumadatokkal kapcsolatos kérdésekre. Mivel az adatok fölé indexet hozott létre, szemantikai keresést végezhet; így csak a kérdés megválaszolásához szükséges legrelevánsabb dokumentumok kerülnek a prompton keresztül az LLM-hez. Ezzel időt és pénzt takaríthat meg azzal, hogy csak a releváns dokumentumokat továbbítja az LLM-nek. A dokumentumláncok használatával kapcsolatos további részletekért lásd: dokumentumok.

A dokumentumok segítségével a kérdések megválaszolásához hajtsa végre az alábbi lépéseket:

- A SageMaker LLM végpont LangChainnel való használatához használja

langchain.llms.sagemaker_endpoint.SagemakerEndpoint, amely a SageMaker LLM végpontot absztrahálja. Transzformációt hajt végre a kérés és a válasz hasznos adata számára, a LangChain SageMaker integráció következő kódjában látható módon. Vegye figyelembe, hogy előfordulhat, hogy módosítania kell a kódot a ContentHandlerben a content_type és a használni kívánt LLM-modell elfogadási formátuma alapján.

Most készen áll a pénzügyi dokumentummal való interakcióra.

- A dokumentummal kapcsolatos kérdések feltevéséhez használja a következő lekérdezést és prompt sablont:

Razzia

A jövőbeni költségek elkerülése érdekében törölje a SageMaker következtetési végpontokat, amelyeket ebben a jegyzetfüzetben hozott létre. Ezt úgy teheti meg, hogy futtassa a következőket a SageMaker Studio jegyzetfüzetében:

Ha létrehozott egy OpenSearch Serverless gyűjteményt ehhez a példához, és már nincs rá szüksége, törölheti az OpenSearch Serverless konzolon keresztül.

Következtetés

Ebben a bejegyzésben azt tárgyaltuk, hogy a RAG-t olyan megközelítésként használjuk, amellyel tartomány-specifikus kontextust biztosítunk az LLM-eknek. Megmutattuk, hogyan lehet a SageMaker JumpStart segítségével létrehozni egy RAG-alapú kontextuális chatbotot egy pénzügyi szolgáltató szervezet számára, amely Llama 2-t és OpenSearch Serverless-t használ, vektoros adattárolóként vektormotorral. Ez a módszer finomítja a szöveggenerálást a Llama 2 használatával a releváns kontextus dinamikus beszerzésével. Örömmel látjuk, hogy elhozza egyéni adatait, és újít a SageMaker JumpStart RAG-alapú stratégiájával!

A szerzőkről

Sunil Padmanabhan az AWS Startup Solutions építésze. Korábbi startup-alapítóként és technológiai igazgatóként szenvedélyesen rajong a gépi tanulásért, és arra összpontosít, hogy segítse az induló vállalkozásokat az AI/ML-nek az üzleti eredményeik hasznosításában, valamint az ML/AI-megoldások széles körű tervezésében és bevezetésében.

Sunil Padmanabhan az AWS Startup Solutions építésze. Korábbi startup-alapítóként és technológiai igazgatóként szenvedélyesen rajong a gépi tanulásért, és arra összpontosít, hogy segítse az induló vállalkozásokat az AI/ML-nek az üzleti eredményeik hasznosításában, valamint az ML/AI-megoldások széles körű tervezésében és bevezetésében.

Suleman Patel az Amazon Web Services (AWS) vezető megoldástervezője, különös tekintettel a gépi tanulásra és modernizációra. Az üzleti és technológiai szakértelmét kihasználva Suleman segít ügyfeleinek olyan megoldások tervezésében és kivitelezésében, amelyek a valós üzleti világ problémáit kezelik. Amikor nem merül el a munkájában, Suleman szereti felfedezni a szabadban, kirándulásokat tenni, és finom ételeket főzni a konyhában.

Suleman Patel az Amazon Web Services (AWS) vezető megoldástervezője, különös tekintettel a gépi tanulásra és modernizációra. Az üzleti és technológiai szakértelmét kihasználva Suleman segít ügyfeleinek olyan megoldások tervezésében és kivitelezésében, amelyek a valós üzleti világ problémáit kezelik. Amikor nem merül el a munkájában, Suleman szereti felfedezni a szabadban, kirándulásokat tenni, és finom ételeket főzni a konyhában.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- PlatoData.Network Vertical Generative Ai. Erősítse meg magát. Hozzáférés itt.

- PlatoAiStream. Web3 Intelligence. Felerősített tudás. Hozzáférés itt.

- PlatoESG. Carbon, CleanTech, Energia, Környezet, Nap, Hulladékgazdálkodás. Hozzáférés itt.

- PlatoHealth. Biotechnológiai és klinikai vizsgálatok intelligencia. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/build-a-contextual-chatbot-for-financial-services-using-amazon-sagemaker-jumpstart-llama-2-and-amazon-opensearch-serverless-with-vector-engine/

- :van

- :is

- :nem

- $ UP

- 1

- 100

- 13

- 2020

- 26%

- 30

- 7

- 8

- 9

- a

- képesség

- Rólunk

- absztraktokat

- bőséges

- elfogadja

- hozzáférés

- igénybe vett

- pontosság

- szerez

- alkalmazkodás

- mellett

- szerek

- AI

- ai használati esetek

- AI / ML

- AL

- igazítás

- igazítás

- lehetővé téve

- lehetővé teszi, hogy

- mentén

- Is

- amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- Amazon Web Services (AWS)

- között

- an

- és a

- válasz

- válaszok

- API-k

- Alkalmazás

- alkalmazások

- megközelítés

- hozzávetőleges

- építészet

- VANNAK

- AS

- kérdez

- At

- fokozza

- bővített

- elérhető

- elkerülése érdekében

- AWS

- bázis

- alapján

- BE

- mert

- óta

- referenciaértékek

- között

- párna

- növeli

- Bot

- mindkét

- hoz

- széles

- épít

- Épület

- üzleti

- de

- by

- kéri

- TUD

- képesség

- eset

- esetek

- lánc

- láncok

- chatbot

- választás

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- osztály

- besorolás

- kód

- gyűjtemény

- gyűjtemény

- kombinált

- kombinálása

- képest

- összehasonlítás

- összehasonlítások

- teljes

- teljesítés

- átfogó

- Kiszámít

- fogalmak

- fogalmi

- következetesen

- Konzol

- korlátok

- tartalom

- Tartalomírás

- kontextus

- szövegre vonatkozó

- ellenőrzés

- ellenőrzések

- szövegírás

- Mag

- Megfelelő

- költséghatékony

- kiadások

- teremt

- készítette

- teremtés

- CTO

- Jelenlegi

- Jelenleg

- szokás

- Ügyfelek

- szabható

- testreszabás

- testre

- dátum

- adatbiztonság

- adatbázisok

- elszánt

- Annak meghatározása,

- Késik

- bizonyítani

- függ

- telepíteni

- bevetés

- bevetések

- Design

- tervezett

- részletes

- részletek

- Fejlesztő

- DICT

- tárgyalt

- do

- dokumentum

- dokumentumok

- domain

- húz

- két

- alatt

- dinamikus

- dinamikusan

- E&T

- minden

- Korábban

- Kereset

- bevételi jelentés

- Hatékony

- hatékonyság

- hatékonyság

- más

- Beágyaz

- beágyazott

- beágyazás

- foglalkoztatás

- végén

- Endpoint

- Motor

- fokozása

- dúsított

- gazdagító

- biztosítására

- biztosítja

- biztosítása

- Környezet

- lényeg

- alapvető

- példa

- példák

- Excel

- izgatott

- létezik

- szakvélemény

- feltárása

- Feltárása

- terjed

- külső

- Arc

- megkönnyítése

- tényezők

- messze

- Funkció

- Jellemzők

- Fed

- pénzügyi

- Pénzügyi szektor

- pénzügyi szolgáltatás

- pénzügyi szolgáltatások

- FinServ

- Cég

- vezetéknév

- megfelelő

- Úszó

- áramlási

- Összpontosít

- koncentrál

- következik

- következő

- A

- formátum

- Korábbi

- Előre

- Alapítvány

- alapító

- Keretrendszer

- ból ből

- funkció

- Továbbá

- magfúzió

- jövő

- általános

- generál

- generált

- generáció

- nemző

- Generatív AI

- GitHub

- kapott

- útmutatást

- Legyen

- he

- segít

- segít

- segít

- övé

- vendéglátó

- Hogyan

- How To

- azonban

- http

- HTTPS

- Kerékagy

- i

- ideálisan

- azonosított

- azonosító

- if

- kép

- elmerült

- importál

- javul

- javítja

- javuló

- in

- mélyreható

- tartalmaz

- Beleértve

- befogadás

- Növelje

- <p></p>

- növekvő

- index

- indexek

- egyéni

- ipar

- információ

- újít

- bemenet

- bemenet

- példa

- utasítás

- integrál

- integráció

- kölcsönhatásba

- Felület

- belső

- bele

- Bevezetett

- izolált

- szigetelés

- IT

- ITS

- jpg

- json

- tudás

- táj

- nyelv

- nagy

- nagyobb

- legutolsó

- vezető

- tanulás

- Hossz

- Tőkeáttétel

- erőfölény

- Lajos

- könyvtár

- mint

- korlátozások

- Korlátozott

- Lista

- Láma

- LLM

- fakitermelés

- hosszabb

- keres

- szeret

- gép

- gépi tanulás

- Gyártás

- kezelése

- sok

- Lehet..

- Megfelel

- Memory design

- említett

- módszer

- mód

- esetleg

- ML

- modell

- modellek

- pénz

- több

- Ráadásul

- a legtöbb

- többszörös

- elengedhetetlen

- Szükség

- hálózat

- ideg-

- következő

- nem

- Egyik sem

- jegyzetfüzet

- Most

- tárgy

- of

- felajánlás

- Ajánlatok

- Nem elérhető

- on

- ONE

- azok

- csak

- működik

- Optimalizálja

- or

- szervezet

- szervezetek

- eredeti

- mi

- eredmények

- szabadban

- teljesítmény

- kimenetek

- felett

- párok

- paraméterek

- Legfőbb

- rész

- különösen

- Elmúlt

- Múló

- szenvedélyes

- Teljesít

- kitartás

- Plató

- Platón adatintelligencia

- PlatoData

- Népszerű

- esetleg

- állás

- Hozzászólások

- erős

- powered

- pontos

- Főleg

- jobban szeret

- előfeltételek

- be

- uralkodó

- Preview

- korábban

- magán

- problémák

- folyamat

- termel

- biztató

- ad

- biztosít

- ellátás

- Kérdések és válaszok

- világítás

- kérdés

- Kérdések

- rangsorban

- kész

- való Világ

- real-time

- utal

- referencia

- tekintettel

- szabályozók

- szabályozási táj

- összefüggő

- relevancia

- bizalom

- marad

- vakolatok

- jelentést

- kérni

- szükség

- kötelező

- követelmények

- erőforrás-igényes

- Tudástár

- válasz

- válaszok

- Eredmények

- visszatérés

- Visszatér

- szigorú

- út

- Szerep

- szabályok

- futás

- sagemaker

- SageMaker következtetés

- azonos

- Megtakarítás

- Skála

- zökkenőmentes

- Keresés

- Rész

- szektor

- biztonság

- lát

- válasszuk

- kiválasztott

- kiválasztás

- MAGA

- idősebb

- vagy szerver

- szolgáltatás

- Szolgáltatások

- készlet

- kimutatta,

- mutatott

- Műsorok

- Egyszerű

- Méret

- méretek

- kisebb

- So

- megoldások

- Megoldások

- forrás

- Források

- Sourcing

- Hely

- speciális

- specializált

- különleges

- kifejezetten

- meghatározott

- szabványok

- indítás

- Startups

- Állami

- csúcs-

- Lépés

- Lépései

- tárolás

- tárolni

- memorizált

- Stratégia

- egyszerűsíti

- stúdió

- ilyen

- megfelelő

- összegez

- rendszer

- felszerelés

- bevétel

- feladatok

- technika

- Technológia

- sablon

- sablonok

- szöveg

- szövegi

- hogy

- A

- azok

- Őket

- akkor

- ezáltal

- Ezek

- ők

- ezt

- három

- Keresztül

- idő

- időszerű

- nak nek

- együtt

- felső

- kemény

- felé

- kiképzett

- Képzések

- Átalakítás

- át

- igaz

- FORDULAT

- típus

- Ultra

- megértés

- egyedi

- Egyetemes

- up-to-date

- frissítve

- használ

- használati eset

- használt

- használó

- használ

- segítségével

- hasznosít

- változatos

- fajta

- különféle

- Hatalmas

- keresztül

- kötetek

- végigjátszás

- Út..

- we

- háló

- webes szolgáltatások

- Mit

- amikor

- ami

- míg

- Wikipedia

- lesz

- ablak

- val vel

- belül

- Munka

- írás

- év

- te

- A te

- zephyrnet