A több milliárd paramétert tartalmazó nagy nyelvi modellek (LLM-ek) jelenleg a természetes nyelvi feldolgozás (NLP) élvonalába tartoznak. Ezek a modellek felrázzák a terepet hihetetlen képességeikkel szöveggenerálásra, érzelmek elemzésére, nyelvek fordítására és még sok másra. A hatalmas mennyiségű adathoz való hozzáférés révén az LLM-ek forradalmasíthatják a nyelvvel való interakciót. Bár az LLM-ek képesek különféle NLP-feladatok elvégzésére, általánosnak tekintik őket, és nem specialistáknak. Ahhoz, hogy egy LLM-et egy adott területen szakértővé képezzen, általában finomhangolásra van szükség.

A több milliárd paraméterrel rendelkező LLM-ek képzése és telepítése során az egyik legnagyobb kihívás a méretük, ami megnehezítheti, hogy egyetlen GPU-ba, a mély tanuláshoz általánosan használt hardverbe illeszkedjenek. Ezeknek a modelleknek a puszta méretei nagy teljesítményű számítási erőforrásokat igényelnek, például nagy mennyiségű memóriával rendelkező speciális GPU-kat. Ezenkívül ezeknek a modelleknek a mérete számításilag költségessé teheti őket, ami jelentősen megnövelheti a képzési és következtetési időt.

Ebben a bejegyzésben bemutatjuk, hogyan használhatjuk Amazon SageMaker JumpStart a nagy nyelvű szöveggenerálási modell egyszerű finomhangolása egy tartományspecifikus adatkészleten, ugyanúgy, ahogyan bármilyen modellt betanítana és telepítene Amazon SageMaker. Konkrétan bemutatjuk, hogyan lehet finomhangolni a GPT-J 6B nyelvi modellt pénzügyi szöveggeneráláshoz a JumpStart SDK és a Amazon SageMaker Studio UI a SEC-bejelentések nyilvánosan elérhető adatkészletén.

A JumpStart segít gyorsan és egyszerűen elkezdeni a gépi tanulást (ML), és olyan megoldásokat kínál a leggyakoribb használati esetekre, amelyek néhány lépéssel könnyen betaníthatók és üzembe helyezhetők. A bemutató összes lépése megtalálható a mellékelt notebookban Szöveggeneráló GPT-J 6B modell finomhangolása egy tartományspecifikus adatkészleten.

Megoldás áttekintése

A következő szakaszokban lépésről lépésre bemutatjuk az LLM finomhangolását szöveggenerálási feladatokhoz a JumpStart Studio felhasználói felületén és a Python SDK-n keresztül. Különösen a következő témákat tárgyaljuk:

- A SEC-nyilvántartási adatok áttekintése a pénzügyi területen, amelyre a modell finomhangolásra került

- Az általunk finomhangolásra kiválasztott LLM GPT-J 6B modell áttekintése

- Az LLM finomhangolásának két különböző módja a JumpStart segítségével:

- A JumpStart programozott használata a SageMaker Python SDK-val

- Hozzáférés a JumpStarthoz a Studio UI használatával

- A finomhangolt modell értékelése az előre betanított, finomhangolás nélküli modellel történő összehasonlítással

A finomhangolás egy előre betanított nyelvi modell felvételének folyamatát jelenti, és meghatározott adatok felhasználásával egy eltérő, de kapcsolódó feladatra betanítja. Ez a megközelítés más néven transzfer tanulás, amely magában foglalja a tanult ismeretek egyik feladatból a másikba való átvitelét. Az LLM-ek, mint például a GPT-J 6B, hatalmas mennyiségű címkézetlen adatra vannak kiképezve, és finomhangolhatók kisebb adatkészleteken, így a modell jobban teljesít egy adott tartományban.

Példaként arra, hogyan javul a teljesítmény a modell finomhangolásakor, tegye fel neki a következő kérdést:

„Mi mozgatja az eladások növekedését az Amazonnál?”

Finomhangolás nélkül a válasz a következő lenne:

„Az Amazon a világ legnagyobb online kiskereskedője. Ez egyben a világ legnagyobb online piactere is. Ez is a világ”

Finomhangolással a válasz a következő:

„Az Amazon eladásainak növekedését elsősorban a megnövekedett vásárlói használat vezérli, beleértve a megnövekedett választékot, az alacsonyabb árakat és a megnövekedett kényelmet, valamint a webhelyeinken más eladók általi megnövekedett eladásokat.”

A finomhangolásból származó javulás nyilvánvaló.

A SEC-bejelentésekből származó pénzügyi szöveget használjuk a GPT-J 6B LLM pénzügyi alkalmazásokhoz való finomhangolására. A következő részekben bemutatjuk az adatokat és a finomhangolásra kerülő LLM-et.

SEC iktatási adatkészlet

A SEC-bejelentések kritikusak a pénzügyi szabályozás és közzététel szempontjából. A bejelentések tájékoztatják a befektetői közösséget a vállalatok üzleti feltételeiről és a társaságok jövőbeli kilátásairól. A SEC-bejelentések szövege lefedi a vállalat működésének és üzleti feltételeinek teljes skáláját. Potenciális előrejelző értékük miatt ezek a bejelentések jó információforrást jelentenek a befektetők számára. Bár ezek a SEC beadványok nyílvánosan elérhető bárki számára időigényes feladat az elemzett fájlok letöltése és egy tiszta adatkészlet létrehozása hozzáadott szolgáltatásokkal. Ezt néhány API-hívással lehetővé tesszük a JumpStartban Ipari SDK.

A SageMaker API segítségével éves jelentéseket töltöttünk le (10-K bejelentések; lát Hogyan olvassunk el egy 10-K további információkért) számos vállalat számára. A GPT-J 2021B modell finomhangolásához az Amazon SEC-nyilvántartási jelentéseit választjuk ki a 2022–6-es évekre vonatkozóan. Különösen a vállalat különböző évekre vonatkozó SEC-nyilvántartási jelentéseit fűzzük egyetlen szöveges fájlba, kivéve a „Vezetői megbeszélés és elemzés” részt, amely a vállalat vezetőségének előretekintő nyilatkozatait tartalmazza, és érvényesítési adatként szolgál.

Az elvárás az, hogy a GPT-J 6B szöveggenerálási modell pénzügyi SEC dokumentumokon történő finomhangolása után a modell képes legyen áttekinthető pénzügyi vonatkozású szöveges kimenetet generálni, így több tartomány-specifikus NLP feladat megoldására is használható.

GPT-J 6B nagy nyelvű modell

GPT-J 6B egy nyílt forráskódú, 6 milliárd paraméteres modell, amelyet az Eleuther AI adott ki. A GPT-J 6B szöveges adatok nagy tömegére lett kiképezve, és képes különféle NLP-feladatok elvégzésére, például szöveggenerálásra, szövegosztályozásra és szövegösszegzésre. Bár ez a modell lenyűgöző számos NLP-feladatnál anélkül, hogy bármilyen finomhangolásra lenne szükség, sok esetben finomhangolnia kell a modellt egy adott adatkészleten és NLP-feladatokon, amelyeket meg akar oldani. A használati esetek közé tartoznak az egyéni chatbotok, az ötletgenerálás, az entitások kinyerése, az osztályozás és a hangulatelemzés.

Hozzáférés az LLM-ekhez a SageMakeren

Most, hogy azonosítottuk az adatkészletet és a modellt, amelyen finomhangolni fogunk, a JumpStart két lehetőséget kínál a szöveggenerálás finomhangolásának megkezdéséhez: a SageMaker SDK-t és a Studio-t.

A JumpStart programozott használata a SageMaker SDK-val

Most áttekintünk egy példát arra vonatkozóan, hogyan használhatja a SageMaker JumpStart SDK-t egy LLM (GPT-J 6B) eléréséhez, és finomhangolhatja azt a SEC fájladatkészleten. A finomhangolás befejeztével bevezetjük a finomhangolt modellt, és következtetéseket vonunk le belőle. A bejegyzés összes lépése elérhető a mellékelt jegyzetfüzetben: Szöveggeneráló GPT-J 6B modell finomhangolása tartományspecifikus adatkészleten.

Ebben a példában a JumpStart a SageMaker átölelő arc mély tanulási tartály (DLC) és DeepSpeed könyvtárat a modell finomhangolásához. A DeepSpeed könyvtárat úgy tervezték, hogy csökkentse a számítási teljesítményt és a memóriahasználatot, és hogy a meglévő számítógépes hardvereken nagyobb párhuzamosságot biztosító nagy elosztott modelleket tanítson. Támogatja az egy csomóponton elosztott betanítást, gradiens-ellenőrzési pontozást és modellpárhuzamot használva nagy modellek betanításához egyetlen SageMaker oktatópéldányon, több GPU-val. A JumpStart segítségével integráljuk a DeepSpeed könyvtárat a SageMaker Hugging Face DLC-vel, és gondoskodunk mindenről a motorháztető alatt. Könnyedén finomhangolhatja a modellt a domain-specifikus adatkészletén anélkül, hogy manuálisan beállítaná.

Finomhangolja az előre betanított modellt a tartományspecifikus adatokon

A kiválasztott modell finomhangolásához meg kell szereznünk a modell URI-ját, valamint a betanítási parancsfájlt és a betanításhoz használt tárolóképet. A dolgok megkönnyítése érdekében ez a három bemenet kizárólag a modell nevétől és verziójától függ (az elérhető modellek listáját lásd: Beépített algoritmusok előre betanított modelltáblázattal), és a példány típusát, amelyen oktatni szeretne. Ezt a következő kódrészlet szemlélteti:

Visszaszerezzük a model_id ugyanazon modellnek felel meg, amelyet használni szeretnénk. Ebben az esetben finomhangoljuk huggingface-textgeneration1-gpt-j-6b.

A hiperparaméterek meghatározása magában foglalja az ML modell betanítási folyamata során használt különféle paraméterek értékeinek beállítását. Ezek a paraméterek befolyásolhatják a modell teljesítményét és pontosságát. A következő lépésben létrehozzuk a hiperparamétereket az alapértelmezett beállítások felhasználásával és egyedi értékek megadásával olyan paraméterekhez, mint pl. epochs és a learning_rate:

A JumpStart a hangolható hiperparaméterek széles listáját kínálja. Az alábbi lista áttekintést nyújt a modell finomhangolása során használt kulcsfontosságú hiperparaméterek egy részéről. A hiperparaméterek teljes listáját lásd a notebookban Szöveggeneráló GPT-J 6B modell finomhangolása tartományspecifikus adatkészleten.

- korszakok – Megadja, hogy az eredeti adatkészlet legfeljebb hány korszaka kerüljön ismétlésre.

- tanulási_ráta – Szabályozza az optimalizáló algoritmus lépésméretét vagy tanulási sebességét edzés közben.

- eval_steps – Meghatározza, hogy hány lépést kell futtatni, mielőtt kiértékelné a modellt az érvényesítési halmazon a képzés során. Az érvényesítési halmaz az adatok egy részhalmaza, amelyet nem használnak a betanításhoz, hanem a modell teljesítményének ellenőrzésére szolgál nem látott adatokon.

- súly_romlás – Szabályozza a rendszerezési erőt a modelledzés során. A szabályosítás egy olyan technika, amely segít megakadályozni, hogy a modell túlillessze a képzési adatokat, ami jobb teljesítményt eredményezhet a nem látott adatokon.

- fp16 – Szabályozza, hogy az fp16 16 bites (vegyes) precíziós oktatást használja-e a 32 bites oktatás helyett.

- értékelési_stratégia – A képzés során alkalmazott értékelési stratégia.

- gradiens_accumulation_steps – A frissítési lépések száma a színátmenetek felhalmozásához, mielőtt visszafelé/frissítést hajtana végre.

A hiperparaméterekkel kapcsolatos további részletekért forduljon a hivatalos személyhez Hugging Face Trainer dokumentáció.

Most már finomhangolhatja ezt a JumpStart modellt saját egyéni adatkészletén a SageMaker SDK segítségével. A korábban ismertetett SEC nyilvántartási adatokat használjuk. A vonat és az érvényesítési adatok a következő helyen találhatók: train_dataset_s3_path és a validation_dataset_s3_path. Az adatok támogatott formátuma a CSV, a JSON és a TXT. A CSV- és JSON-adatokhoz a szöveges adatok a megnevezett oszlopból kerülnek felhasználásra text vagy az első oszlopot, ha nem található szöveg nevű oszlop. Mivel ez szöveggenerálási finomhangolásra szolgál, nincs szükség alapvető igazságcímkékre. A következő kód egy SDK-példa a modell finomhangolására:

Miután beállítottuk a SageMaker becslést a szükséges hiperparaméterekkel, példányosítunk egy SageMaker becslést, és meghívjuk a .fit módszerrel kezdjük el a modellünk finomhangolását, átadva a Amazon egyszerű tárolási szolgáltatás (Amazon S3) URI az edzési adatainkhoz. Mint látható, a entry_point a megadott script neve transfer_learning.py (ugyanez más feladatoknál és modelleknél is), és a bemeneti adatcsatorna átadta .fit vonatnak és érvényesítésnek kell nevezni.

A JumpStart támogatja a hiperparaméter-optimalizálást is SageMaker automatikus modelltuning. A részletekért lásd a példát jegyzetfüzet.

Telepítse a finomhangolt modellt

A képzés befejeztével üzembe helyezheti a finomhangolt modellt. Ehhez mindössze a következtetési parancsfájl URI-ját (a kódot, amely meghatározza, hogy a modellt a telepítés után miként használjuk következtetésekhez) és a következtetéstároló kép URI-ját kell megszereznünk, amely egy megfelelő modellkiszolgálót tartalmaz az általunk választott modell hosztolásához. Lásd a következő kódot:

Néhány perc múlva a modellünk bevetésre kerül, és valós időben kaphatunk előrejelzéseket belőle!

A JumpStart elérése a Studio felhasználói felületén keresztül

A JumpStart modellek finomhangolásának és üzembe helyezésének másik módja a Studio UI. Ez a felhasználói felület alacsony kódú/kód nélküli megoldást kínál az LLM-ek finomhangolásához.

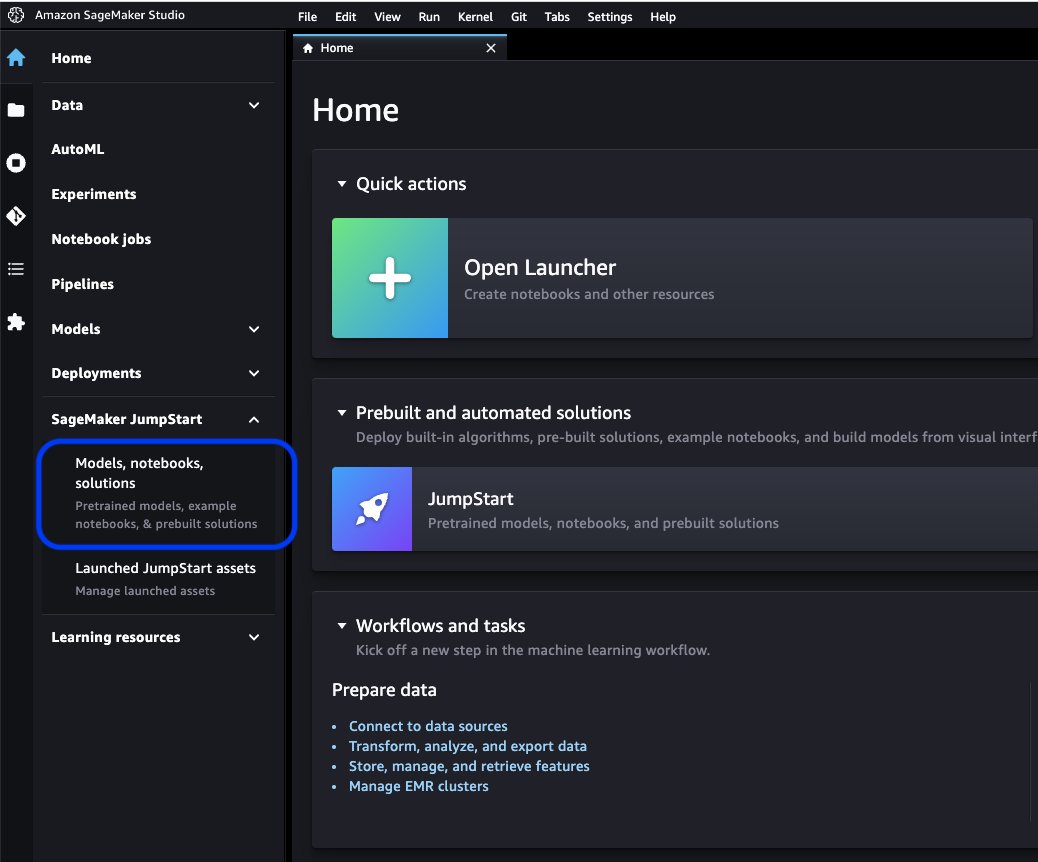

A Studio konzolon válassza a lehetőséget Modellek, notebookok, megoldások alatt SageMaker JumpStart a navigációs ablaktáblában.

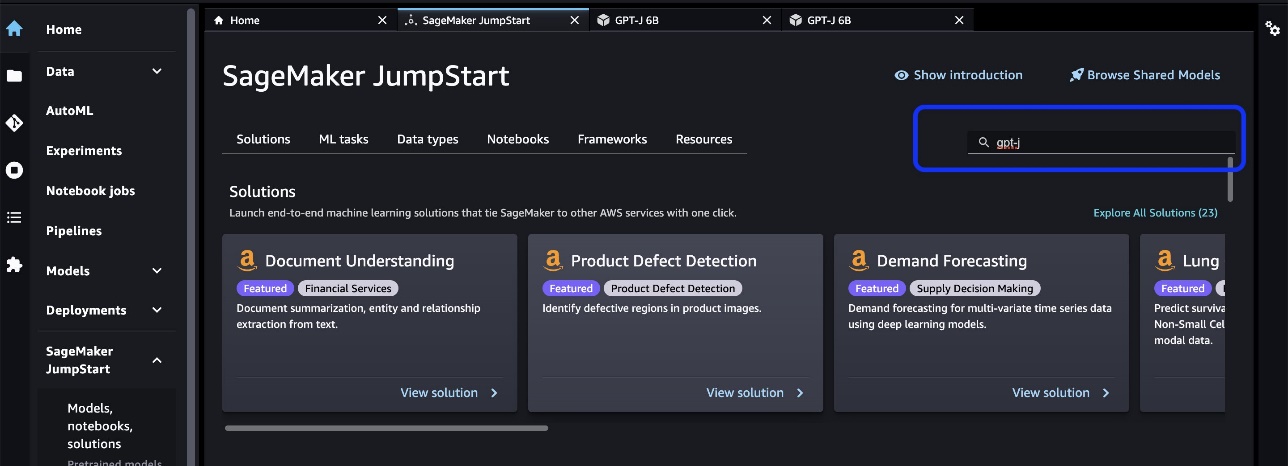

A keresősávban keresse meg a finomhangolni és telepíteni kívánt modellt.

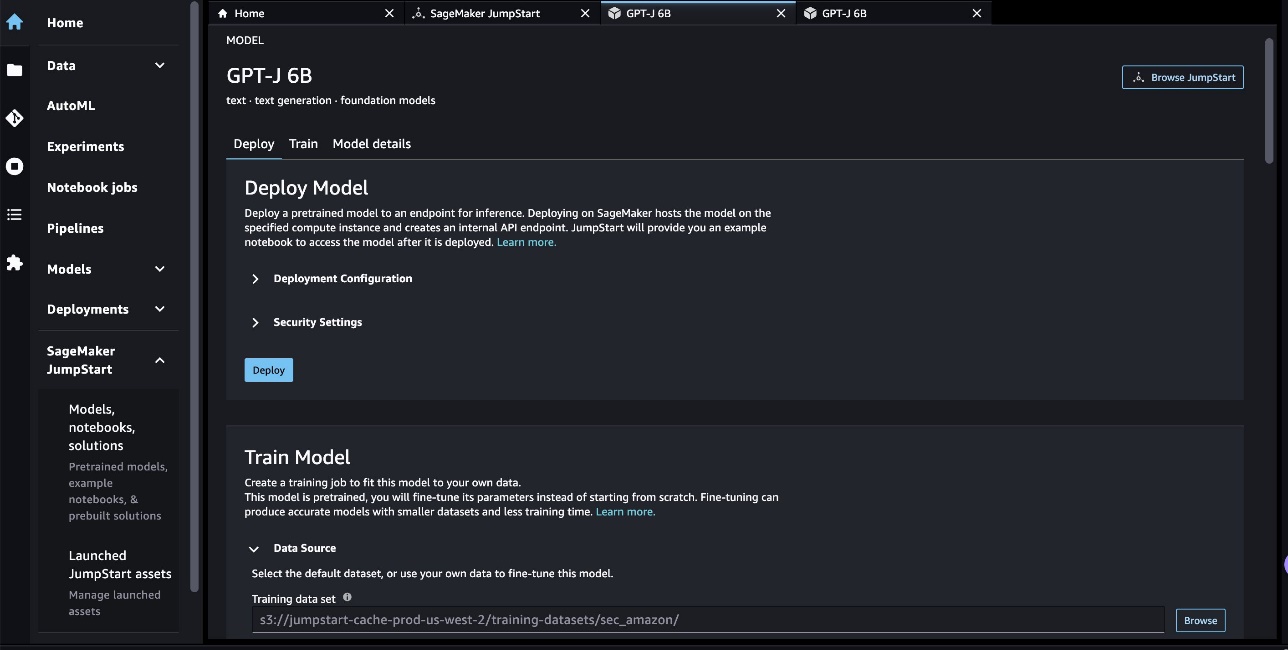

Esetünkben a GPT-J 6B modellkártyát választottuk. Itt közvetlenül finomhangolhatjuk vagy telepíthetjük az LLM-et.

Modell értékelés

Egy LLM kiértékelésénél használhatjuk a perplexitást (PPL). A PPL annak általános mértéke, hogy egy nyelvi modell mennyire képes megjósolni a sorozat következő szavát. Egyszerűbben fogalmazva, ez egy módszer annak mérésére, hogy a modell mennyire képes megérteni és létrehozni az emberhez hasonló nyelvet.

Az alacsonyabb zavarossági pontszám azt jelenti, hogy a modell jobban teljesít a következő szó előrejelzésében. Gyakorlatilag a perplexitás segítségével összehasonlíthatjuk a különböző nyelvi modelleket, és meghatározhatjuk, hogy melyik teljesít jobban egy adott feladatban. Segítségével nyomon követhetjük egyetlen modell teljesítményét az idő múlásával. További részletekért lásd: Fix hosszúságú modellek zavarossága.

A modell teljesítményét a finomhangolás előtti és utáni teljesítményének összehasonlításával értékeljük. A PPL-t a képzési munkakörben bocsátják ki amazonfelhőóra rönkök. Ezenkívül megvizsgáljuk a modell által generált kimenetet az adott tesztkérdésekre válaszul.

| Az érvényesítési adatok értékelési mutatója | A finomhangolás előtt | Finomhangolás után |

| Perplexity (PPL) | 8.147 | 1.437 |

A modell megnövelt teljesítményét két kísérlet demonstrálja:

- Szöveggenerálás – Megmutatjuk, hogy a finomhangolt GPT-J kimenete olyan szöveget generál, amely hasonlít a SEC adatkészletre, jelezve, hogy megtanulta emulálni a pénzügyi szabályozási tartomány nyelvi mintáit és konvencióit.

- Zero-shot tanulás – Bemutatjuk, hogy a finomhangolt GPT-J szignifikánsan jobb teljesítményt mutat, mint a nem finomhangolt GPT-J nullapontos kérdésválaszolásnál

A szöveggenerálási kísérlethez a következő következtetési paramétereket használjuk az eredmények eléréséhez: max_length 400-ból (a visszaküldött tokenek száma), num_return_sequences 1-ből (válaszszöveg-példák száma), top_k 250-ből (válasszon a legjobb 250 lehetséges folytatás közül), top_p 0.8 (csak olyan folytatások közül válasszon, amelyek legalább 80%-ban valószínűek), do_sample is True (mintavétel), és temperature 1 (a magas hőmérséklet nagyobb véletlenszerűséget jelent a válaszokban). A paraméterekkel kapcsolatos további részletekért lásd: GenerationConfig. A következő táblázat összehasonlítja a finomhangolt GPT-J és a nem finomhangolt GPT-J-t egy szövegkiegészítő feladaton.

| Következtetési példa | Kimenet a GPT-J 6B-ből a finomhangolás előtt | Kimenet a GPT-J 6B-ről finomhangolás után |

| Ez a Form 10-K jelentés ezt mutatja |

Ez a Form 10-K jelentés azt mutatja, hogy: A Társaságnak a Társaságnak tulajdonítható nettó bevétel a 31. december 2016-én végződő évben 3,923,000 0.21 3,818,000 USD, azaz 0.21 USD/hígított részvény volt, szemben a 31. december 2015-én végződő év XNUMX XNUMX XNUMX USD-vel, azaz XNUMX USD/hígított részvényenkénti bevétellel. A Társaságnak a Társaságnak tulajdonítható nettó bevétel a 31. december 2016-én végződő évben 4,816,000 0.28 4,726,000 USD, azaz 0.27 USD/hígított részvény volt, szemben a 31. december 2015-én végződő év XNUMX XNUMX XNUMX USD-vel, azaz XNUMX USD/hígított részvényenkénti bevétellel. A Társaságnak a Társaságnak tulajdonítható nettó bevétel a 31. december 2016-én végződő évben 5,828,000 0.34 5,716,000 USD, azaz 0.33 USD/hígított részvény volt, szemben a 31. december 2015-én végződő év XNUMX XNUMX XNUMX USD-vel, azaz XNUMX USD/hígított részvényenkénti bevétellel. 21. augusztus 2009-én a Társaság benyújtott egy 10-Q űrlapot a 31. december 2008-én végződő negyedévre vonatkozóan. 21. augusztus 2009-én a Társaság benyújtott egy 10-Q űrlapot a 30. szeptember 2008-án végződő negyedévre vonatkozóan. 21. augusztus 2009-én a Társaság benyújtott egy 10-Q űrlapot a 31. március 2009-én végződő negyedévre vonatkozóan. |

Ez a Form 10-K jelentés azt mutatja, hogy:(1) A regisztráló neve, címe és telefonszáma a következő: Amazon.com, Inc. c/o Ernst & Young LLPSeattle, Washington Figyelem: Vállalati titkár (2) A Az 1934. évi értékpapír-tőzsdei törvény III. cikkének céljaira a regisztráló neve és címe a következő: (3) A regisztráló tőzsdetörvény szerinti jelentési időszaka 1. január 2020-jétől napjainkig tart. (4) A regisztráló szubjektív értékelése hogy a pénzügyi kimutatások és a jelen jelentésben szereplő egyéb pénzügyi információk minden lényeges vonatkozásban tisztességesen bemutatják a regisztráló pénzügyi helyzetét, működési eredményeit és cash flow-it a jelen jelentésben bemutatott időszakokra vonatkozóan.(5) A regisztráló vezetősége Az értékelés szerint a pénzügyi kimutatások és a jelentésben szereplő egyéb pénzügyi információk minden lényeges vonatkozásban méltányosan bemutatják a regisztráló pénzügyi helyzetét, működési eredményeit és cash flow-it a jelen jelentésben bemutatott időszakokra vonatkozóan./s/ Ernst & Young LLPSeattle, Washington 29. január 2020. EX-31.1 5 amzn-20201231xex311.htm EX-31.1 DocumentExhibit 31.1 TANÚSÍTVÁNYSI, Andrew R. Jassy, igazolja, hogy:1. Áttekintettem az Amazon.com, Inc. 10-K űrlapját;2. Tudomásom szerint ez a jelentés nem tartalmaz valótlan állítást lényeges tényről, illetve nem hagy ki olyan lényeges tény közlését, amely az állítások megtételéhez szükséges, a nyilatkozattétel körülményeire tekintettel nem félrevezető a jelen időszakra vonatkozóan. jelentés; |

| keresztül szolgáljuk ki a fogyasztókat |

Fogyasztóinkat az alábbi módon szolgáljuk ki: A Blog Ön vállalkozás tulajdonosa, aki szeretné vállalkozását bővíteni? Hatékonyabb és hatékonyabb vállalkozást szeretne létrehozni? Szeretnéd megtanulni, hogyan növeld vállalkozásodat? Ha ezek közül a kérdések közül bármelyikre igennel válaszolt, akkor el kell olvasnia ezt a cikket. Vállalkozása növekedésének első lépése a vállalkozás megértése. Meg kell tudnia válaszolni a következő kérdéseket a vállalkozásával kapcsolatban: Kik az Ön ügyfelei? Mi az Ön terméke vagy szolgáltatása? Mi az egyedi eladási ajánlata? Mi a marketing stratégiája? Mi az értékesítési előrejelzése? Mi az értékesítési előrejelzése? Mi az értékesítési előrejelzése? Mi az értékesítési előrejelzése? Mi az értékesítési előrejelzése? |

A fogyasztókat a következőkön keresztül szolgáljuk ki: Amazon.com, a fizikai és digitális termékek kiskereskedője; Amazon Web Services, amely technológiai infrastruktúra-szolgáltatásokat nyújt, amelyek gyakorlatilag bármilyen típusú vállalkozást lehetővé tesznek; Amazon Enterprise Solutions, amely a vállalatok számára egyedi technológiát és szolgáltatásokat biztosít jobb üzleti folyamatok, valamint a hatékonyság és a termelékenység javítása érdekében; és az Audible digitális hangoskönyv-kiadó. Bármilyen méretű fejlesztőt és vállalkozást szolgálunk ki az AWS-en keresztül, amely a globális számítási, tárolási, adatbázis- és egyéb szolgáltatások széles skáláját kínálja. Elektronikai eszközöket is gyártunk és forgalmazunk. Működésünket két fő szegmensre szerveztük: Észak-Amerika és Nemzetközi. Lásd a II. rész 8. pontját: „Pénzügyi kimutatások és kiegészítő adatok – 12. megjegyzés – szegmensinformáció.” Lásd a II. rész 7. pontját, „A vezetés megvitatása és elemzése a pénzügyi helyzetről és a műveletek eredményeiről – A műveletek eredményei – Kiegészítő információk” ” a nettó eladásainkkal kapcsolatos kiegészítő információkért. Fogyasztók Online és fizikai üzleteinken keresztül szolgáljuk ki a fogyasztókat, és a választékra, az árakra és a kényelemre összpontosítunk. Üzleteinket úgy alakítjuk ki, hogy több száz millió egyedi terméket tudjunk értékesíteni mi és harmadik felek tucatnyi termékkategóriában. Az ügyfelek webhelyeinken, mobilalkalmazásainkon, Alexán keresztül, valamint üzleteink fizikai látogatása révén érhetik el kínálatunkat. Kindledevice-eket is gyártunk és értékesítünk. Arra törekszünk, hogy ügyfeleinknek a lehető legalacsonyabb árakat kínáljuk a mindennapi termékárak és szállítási ajánlatok révén, és javítsuk működési hatékonyságunkat, hogy továbbra is csökkenthessük vásárlóink árait. Könnyen használható funkcionalitást, gyors és megbízható teljesítést, valamint időszerű ügyfélszolgálatot is biztosítunk. Ezen kívül kínáljuk az Amazon Prime tagsági programot, amely több mint 100 millió termék korlátlan ingyenes kiszállítását, hozzáférést több tízezer film korlátlan streameléséhez és TV-epizódok és egyéb előnyök. |

| Ebben az évben különösen nagy hangsúlyt fektetünk |

Ebben az évben kiemelten foglalkozunk: Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében Az egészségügyi ellátórendszer szerepe az elhízás és a cukorbetegség megelőzésében |

Ebben az évben kiemelt figyelmet fordítunk a következőkre: - Folyamatos nemzetközi terjeszkedés, beleértve a meglévő nemzetközi piaci szegmensekben új vállalkozások fejlesztését, valamint új nemzetközi piaci szegmensek fejlesztését; - Ügyfélbázisunk bővítése, beleértve a meglévő ügyfelek felé történő értékesítés növelését és új ügyfelek vonzását; -Új üzleti lehetőségek kidolgozása és kereskedelmi megállapodások kötése, beleértve az engedélyezési és egyéb megállapodásokat más társaságokkal, vagy más társaságok felvásárlásával; - Olyan technológia fejlesztése, amely fokozott ügyfélszolgálatot biztosít, és hatékonyan szállítja termékeinket és szolgáltatásainkat; -Új termék- és szolgáltatásajánlatok kidolgozása és ezek beépítése a meglévő és új termék- és szolgáltatáskínálatba; - Hatékony és eredményes rendszerek kidolgozása üzletünk támogatására; és -Egyéb üzleti és stratégiai kezdeményezések. Hiszünk abban, hogy jövőbeli sikerünk alapvető feltétele, hogy ügyfeleinknek alacsony árakat kínáljunk. Az alacsonyabb árak egyik módja az ingyenes szállítási ajánlatok, amelyek nettó költségeket jelentenek számunkra a termékek kiszállításával kapcsolatban, valamint az Amazon Prime-tagság, amely több millió tétel ingyenes kiszállítását, valamint filmekhez és egyéb tartalmakhoz való hozzáférést biztosít. Egyéb akciókat is kínálunk, amelyek lehetővé teszik az értékesítés nettó költségének csökkentését. Működésünket két fő szegmensre szerveztük: Észak-Amerika és Nemzetközi. Lásd a II. rész 8. pontját, „Pénzügyi kimutatások és kiegészítő adatok – 12. szegmensinformáció.” Lásd a II. rész 7. pontját, „A menedzsment megbeszélése és elemzése a pénzügyi helyzetről és a műveletek eredményeiről – Műveletek eredményei – Kiegészítő információk”” a nettó eladásainkkal kapcsolatos kiegészítő információkért. Fogyasztók Kiskereskedelmi webhelyeinken és fizikai üzleteinken keresztül szolgáljuk ki a fogyasztókat, és a választékra, az árakra és a kényelemre összpontosítunk. |

A második kísérlethez egy nulla lövésű kérdésmegválaszoló feladattal beállítottuk a max_length hogy más érték legyen (40, 200 és 40) az egyes kérdésektől elvárt kimenet alapján. A paraméterei top_k, top_p, do_sample, temperature 250, 0.8, False, illetve 0. 0 közeli hőmérsékletet állítunk be a kimenet véletlenszerűségének szabályozására, míg a szöveggenerálási feladatnál 1 közelébe állítjuk, hogy kreatívabbá tegyük a modellt. Az alábbi táblázat összehasonlítja az eredményeket. Minden kérdésnél a finomhangolt GPT-J kimenete pontosabb, mint a nem finomhangolté.

| Bemenet | Kimenet a GPT-J 6B-ből a finomhangolás előtt | Kimenet a GPT-J 6B-ről finomhangolás után |

| Miről szól a 7-K SEC bejelentés 10. pontja?: |

Miről szól a 7-K SEC bejelentés 10. pontja?: A 7-K SEC bejelentés 10. pontja a következő: „A Társaság nem kapott lényeges hátrányt |

7. tétel: A vezetőség megvitatása és elemzése a pénzügyi helyzetről és a műveletek eredményeiről Előretekintő nyilatkozatok |

| Hogyan hatott a COVID-19 világjárvány az Amazon üzletére?: |

Hogyan hatott a COVID-19 világjárvány az Amazon üzletére?: Az Amazon üzletét a COVID-19 világjárvány számos módon érinti. A vállalatnál csökken a Prime-tagságok száma, ami az üzletmenet nagy részét képezi. A vállalatnál a Prime-tagságok száma is csökken. Az Amazon a weboldalán leadott rendelések számában is csökken. A cég azt is tapasztalja, hogy csökken azoknak a száma, akik a honlapján vásárolnak. Az Amazon azt is tapasztalja, hogy csökken azoknak a száma, akik a webhelyén vásárolnak. Az Amazon azt is tapasztalja, hogy csökken azoknak a száma, akik a webhelyén vásárolnak. Az Amazon azt is tapasztalja, hogy csökken azoknak a száma, akik a webhelyén vásárolnak. Az Amazonon is csökken a vásárlók száma |

Hogyan hatott a COVID-19 világjárvány az Amazon üzletére?: A COVID-19 világjárvány több szempontból is hatással volt üzletünkre. Először is, ez megzavarta az ellátási láncunkat, és hatással volt a vásárlói keresletre, ami viszont hatással volt értékesítésünkre és működési eredményeinkre. Másodszor, növelte a reklámra és marketingre fordított kiadásainkat, amelyek hosszú távon nem biztos, hogy hatékonyak. Harmadszor, megnövelte a technológiai infrastruktúrára és a számítási kapacitásra fordított kiadásainkat, amelyek hosszú távon nem biztos, hogy hatékonyak. Negyedszer, megnövelte a teljesítésre és az ügyfélszolgálatra fordított kiadásainkat, ami hosszú távon nem biztos, hogy hatékony. Végül pedig növelte a tartalomra fordított kiadásainkat, ami hosszú távon nem biztos, hogy hatékony. Lásd a II. rész 8. tételét, „Pénzügyi kimutatások és kiegészítő adatok – 1. megjegyzés – Üzleti és számviteli politika leírása. |

| Mi hajtja az eladások növekedését az Amazonnál?: | Az Amazon a világ legnagyobb online kiskereskedője. Ez egyben a világ legnagyobb online piactere is. Ez is a világ' | Az Amazon eladásainak növekedését elsősorban a megnövekedett vásárlói használat, ideértve a megnövekedett választékot, az alacsonyabb árakat és a megnövekedett kényelmet, valamint a webhelyeinken más eladók általi megnövekedett eladásokat eredményezi. |

Tisztítsuk meg

A folyamatos költségek elkerülése érdekében törölje a SageMaker következtetési végpontokat. A végpontokat a SageMaker konzolon vagy a notebookból törölheti a következő parancsokkal:

Következtetés

A JumpStart a SageMaker olyan képessége, amely lehetővé teszi az ML gyors elkezdését. A JumpStart nyílt forráskódú, előre betanított modelleket használ az olyan gyakori ML-problémák megoldására, mint a képosztályozás, az objektumészlelés, a szövegosztályozás, a mondatpárok osztályozása és a kérdések megválaszolása.

Ebben a bejegyzésben megmutattuk, hogyan lehet finomhangolni és telepíteni egy előre betanított LLM-et (GPT-J 6B) a szöveggeneráláshoz a SEC kitöltési adatkészlet alapján. A vállalat mindössze két éves jelentésén mutattuk be, hogy a modell hogyan alakult át pénzügyi terület szakértőjévé a finomhangolási folyamat során. Ez a finomhangolás lehetővé tette a modell számára, hogy tartalmat generáljon a pénzügyi témák megértésével és nagyobb pontossággal. Próbálja ki a megoldást saját maga, és tudassa velünk, hogyan működik a megjegyzésekben.

Fontos: Ez a bejegyzés csak demonstrációs célokat szolgál. Ez nem pénzügyi tanács, és nem szabad pénzügyi vagy befektetési tanácsként támaszkodni rá. A poszt során a SEC EDGAR adatbázisból nyert adatok alapján előre betanított modelleket használtak. Ön felelős az EDGAR hozzáférési feltételeinek betartásáért, ha SEC-adatokat használ.

Ha többet szeretne megtudni a JumpStartról, tekintse meg a következő bejegyzéseket:

A szerzőkről

Dr. Xin Huang az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusainak vezető alkalmazott tudósa. A skálázható gépi tanulási algoritmusok fejlesztésére összpontosít. Kutatási területe a természetes nyelvi feldolgozás, a táblázatos adatok magyarázható mély tanulása és a nem-paraméteres tér-idő klaszterezés robusztus elemzése. Számos közleményt publikált az ACL-ben, az ICDM-ben, a KDD konferenciákon és a Royal Statistical Society: A sorozatban.

Dr. Xin Huang az Amazon SageMaker JumpStart és az Amazon SageMaker beépített algoritmusainak vezető alkalmazott tudósa. A skálázható gépi tanulási algoritmusok fejlesztésére összpontosít. Kutatási területe a természetes nyelvi feldolgozás, a táblázatos adatok magyarázható mély tanulása és a nem-paraméteres tér-idő klaszterezés robusztus elemzése. Számos közleményt publikált az ACL-ben, az ICDM-ben, a KDD konferenciákon és a Royal Statistical Society: A sorozatban.

Marc Karp ML építész az Amazon SageMaker Service csapatánál. Arra összpontosít, hogy segítse az ügyfeleket az ML-munkaterhelések nagyszabású tervezésében, telepítésében és kezelésében. Szabadidejében szívesen utazik és új helyeket fedez fel.

Marc Karp ML építész az Amazon SageMaker Service csapatánál. Arra összpontosít, hogy segítse az ügyfeleket az ML-munkaterhelések nagyszabású tervezésében, telepítésében és kezelésében. Szabadidejében szívesen utazik és új helyeket fedez fel.

Dr. Sanjiv Das Amazon Scholar, a Santa Clara Egyetem pénzügy- és adattudományi Terry professzora. Posztgraduális diplomát szerzett pénzügyből (M. Phil és PhD a New York Egyetemen) és számítástechnikából (MS a Berkeley Egyetemen), valamint MBA fokozatot az Indiai Menedzsment Intézetben, Ahmedabadban. Mielőtt akadémikus lett volna, az ázsiai-csendes-óceáni térség származékos üzletágában dolgozott, a Citibank alelnökeként. A multimodális gépi tanulással foglalkozik a pénzügyi alkalmazások területén.

Dr. Sanjiv Das Amazon Scholar, a Santa Clara Egyetem pénzügy- és adattudományi Terry professzora. Posztgraduális diplomát szerzett pénzügyből (M. Phil és PhD a New York Egyetemen) és számítástechnikából (MS a Berkeley Egyetemen), valamint MBA fokozatot az Indiai Menedzsment Intézetben, Ahmedabadban. Mielőtt akadémikus lett volna, az ázsiai-csendes-óceáni térség származékos üzletágában dolgozott, a Citibank alelnökeként. A multimodális gépi tanulással foglalkozik a pénzügyi alkalmazások területén.

Arun Kumar Lokanatha az Amazon SageMaker Service csapatának vezető ML Solutions Architect. Arra összpontosít, hogy segítse az ügyfeleket az ML gyártási munkaterhelések felépítésében, betanításában és a SageMakerre való nagyszabású migrációban. A mély tanulásra specializálódott, különösen az NLP és az önéletrajz területén. A munkán kívül szeret futni és túrázni.

Arun Kumar Lokanatha az Amazon SageMaker Service csapatának vezető ML Solutions Architect. Arra összpontosít, hogy segítse az ügyfeleket az ML gyártási munkaterhelések felépítésében, betanításában és a SageMakerre való nagyszabású migrációban. A mély tanulásra specializálódott, különösen az NLP és az önéletrajz területén. A munkán kívül szeret futni és túrázni.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- A jövő pénzverése – Adryenn Ashley. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/machine-learning/domain-adaptation-fine-tuning-of-foundation-models-in-amazon-sagemaker-jumpstart-on-financial-data/

- :van

- :is

- :nem

- $3

- $ UP

- 000

- 1

- 100

- 11

- 20

- 200

- 2016

- 2020

- 28

- 7

- 8

- 9

- a

- képességek

- Képes

- Rólunk

- egyetemi

- hozzáférés

- számvitel

- felhalmozásra

- pontosság

- pontos

- Elérése

- beszerzés

- át

- törvény

- hozzáadott

- Hozzáadott funkciók

- mellett

- Ezen kívül

- cím

- Hirdetés

- tanács

- érint

- Után

- ellen

- AI

- Alexa

- algoritmus

- algoritmusok

- Minden termék

- lehetővé teszi, hogy

- Is

- Bár

- amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Az Amazon Web Services

- Amazon.com

- Amerika

- Összegek

- an

- elemzés

- elemez

- és a

- Andrew

- évi

- Másik

- válasz

- bármilyen

- bárki

- api

- alkalmazások

- alkalmazott

- megközelítés

- megfelelő

- alkalmazások

- VANNAK

- TERÜLET

- cikkben

- AS

- értékelés

- At

- figyelem

- vonzása

- Augusztus

- Automatikus

- elérhető

- AWS

- bár

- bázis

- alapján

- BE

- mert

- válik

- óta

- előtt

- hogy

- Hisz

- Előnyök

- Berkeley

- Jobb

- Nagy

- milliárd

- mindkét

- széles

- épít

- beépített

- üzleti

- de

- by

- hívás

- hívott

- kéri

- TUD

- Kaphat

- képes

- Kapacitás

- kártya

- ami

- eset

- esetek

- igazolja,

- lánc

- kihívások

- csatorna

- díjak

- chatbots

- ellenőrizze

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- választotta

- választott

- körülmények

- Citibank

- Clara

- besorolás

- közel

- csoportosítás

- kód

- Oszlop

- COM

- Hozzászólások

- Közös

- általában

- közösség

- Companies

- vállalat

- Társaságé

- összehasonlítani

- képest

- összehasonlítva

- összehasonlítás

- teljes

- befejezés

- Kiszámít

- számítógép

- Computer Science

- számítástechnika

- számítási teljesítmény

- feltétel

- Körülmények

- konferenciák

- Fontolja

- figyelembe vett

- Konzol

- építése

- Fogyasztók

- tartalmaz

- Konténer

- tartalmaz

- tartalom

- folytatódik

- ellenőrzés

- ellenőrzések

- kényelem

- Társasági

- Megfelelő

- Költség

- fedett

- Covers

- Covid-19

- COVID-19 járvány

- teremt

- Kreatív

- kritikai

- Jelenleg

- szokás

- vevő

- Vevőszolgálat

- Ügyfelek

- dátum

- adat-tudomány

- adatbázis

- adatkészletek

- december

- Elutasítása

- mély

- mély tanulás

- alapértelmezett

- átadó

- szállít

- Kereslet

- bizonyítani

- igazolták

- telepíteni

- telepített

- bevezetéséhez

- Származékok

- leírt

- leírás

- Design

- tervezett

- részletek

- Érzékelés

- Határozzuk meg

- meghatározza

- fejlesztők

- fejlesztése

- Fejlesztés

- Eszközök

- DID

- különböző

- nehéz

- digitális

- közvetlenül

- közzététel

- megvitatni

- vita

- megosztott

- elosztott képzés

- Dokkmunkás

- dokumentumok

- domain

- tucat

- hajtott

- alatt

- minden

- Korábban

- könnyen

- könnyen használható

- Hatékony

- hatékonyság

- hatékonyság

- hatékony

- Elektronikus

- lehetővé

- engedélyezve

- Endpoint

- fokozott

- Vállalkozás

- Vállalatok

- Egész

- egység

- korszakok

- Ernst & Young

- különösen

- létrehozni

- értékelni

- értékelő

- értékelés

- mindennapi

- minden

- példa

- példák

- Kivéve

- csere

- Gyakorol

- létező

- terjeszkedés

- vár

- várakozás

- drága

- kísérlet

- szakértő

- Feltárása

- kiterjedt

- Arc

- GYORS

- Jellemzők

- kevés

- mező

- filé

- Benyújtás

- Végül

- finanszíroz

- pénzügyi

- pénzügyi tanácsadás

- pénzügyi adat

- pénzügyi információ

- végén

- vezetéknév

- megfelelő

- Összpontosít

- koncentrál

- következő

- következik

- A

- A befektetők számára

- Előrejelzés

- Forefront

- forma

- formátum

- előretekintő

- talált

- Alapítvány

- Negyedik

- ból ből

- Tele

- funkcionalitás

- alapvető

- további

- jövő

- generál

- generált

- generál

- generáció

- kap

- adott

- Globális

- Go

- Goes

- megy

- jó

- GPU

- színátmenetek

- nagyobb

- Földi

- Nő

- Növekvő

- Növekedés

- hardver

- Legyen

- he

- Egészség

- Egészségügyi ellátás

- segít

- segít

- itt

- Magas

- nagy teljesítményű

- tart

- motorháztető

- vendéglátó

- házigazdája

- Hogyan

- How To

- HTML

- http

- HTTPS

- HuggingFace

- Több száz

- több száz millió

- Hiperparaméter optimalizálás

- i

- ötlet

- azonosított

- kép

- Képosztályozás

- Hatás

- befolyásolta

- importál

- hatásos

- javul

- javulás

- in

- Inc.

- tartalmaz

- beleértve

- magában foglalja a

- Beleértve

- Jövedelem

- amely magában foglalja

- Növelje

- <p></p>

- növekvő

- hihetetlen

- indián

- információ

- Infrastruktúra

- kezdeményezések

- bemenet

- példa

- helyette

- Intézet

- integrálni

- kölcsönhatásba

- érdekek

- Nemzetközi

- bele

- bevezet

- beruházás

- Investopedia

- befektető

- Befektetők

- IT

- tételek

- ITS

- Munka

- jpg

- json

- éppen

- Kulcs

- Ismer

- tudás

- ismert

- Címkék

- nyelv

- Nyelvek

- nagy

- legnagyobb

- indít

- TANUL

- tanult

- tanulás

- könyvtár

- Engedélyezés

- fény

- mint

- Lista

- LLM

- Hosszú

- néz

- keres

- le

- Elő/Utó

- alacsony árak

- gép

- gépi tanulás

- készült

- fontos

- csinál

- Gyártás

- kezelése

- vezetés

- kézzel

- sok

- március

- piacára

- Marketing

- piactér

- tömeges

- anyag

- Lehet..

- eszközök

- intézkedés

- tagság

- tagságok

- Memory design

- módszer

- metrikus

- vándorol

- millió

- Több millió

- Perc

- vegyes

- ML

- Mobil

- mobil-alkalmazásokat

- modell

- modellek

- több

- a legtöbb

- Filmek

- MS

- többszörös

- név

- Nevezett

- Természetes

- Természetes nyelvi feldolgozás

- Navigáció

- elengedhetetlen

- Szükség

- háló

- Új

- új termék

- New York

- következő

- NLP

- csomópont

- Északi

- Észak Amerika

- jegyzetfüzet

- Most

- szám

- Elhízottság

- tárgy

- Objektumfelismerés

- szerez

- kapott

- of

- ajánlat

- felajánlás

- Ajánlat

- Ajánlatok

- on

- ONE

- folyamatban lévő

- online

- online piactér

- online kiskereskedő

- csak

- nyílt forráskódú

- üzemeltetési

- Művelet

- Lehetőségek

- optimalizálás

- or

- érdekében

- rendelés

- Szervezett

- eredeti

- Más

- mi

- Outlook

- teljesítmény

- kívül

- felett

- felülírás

- áttekintés

- saját

- tulajdonos

- járvány

- üvegtábla

- papírok

- paraméterek

- rész

- különös

- különösen

- fél

- elhalad

- Elmúlt

- Múló

- ösvény

- minták

- Emberek (People)

- Teljesít

- teljesítmény

- előadó

- Előadja

- időszak

- időszakok

- PHIL

- fizikai

- fizikailag

- vedd

- Helyek

- Plató

- Platón adatintelligencia

- PlatoData

- Politikák

- lehetséges

- állás

- Hozzászólások

- potenciális

- hatalom

- Gyakorlati

- Pontosság

- előre

- előrejelzésére

- Tippek

- Predictor

- be

- bemutatott

- elnök

- megakadályozása

- Megelőzés

- előző

- ár

- Áraink

- árazás

- elsősorban

- Első

- Fő

- Előzetes

- problémák

- folyamat

- Folyamatok

- feldolgozás

- Termékek

- Termelés

- termelékenység

- Termékek

- Egyetemi tanár

- Program

- akciók

- ajánlat

- ad

- feltéve,

- biztosít

- nyilvánosan

- közzétett

- kiadó

- cél

- célokra

- Piton

- Negyed

- kérdés

- Kérdések

- gyorsan

- véletlenszerűség

- Arány

- Olvass

- igazi

- kapott

- csökkenteni

- kifejezés

- tekintettel

- regex

- vidék

- Szabályozás

- szabályozók

- összefüggő

- felszabaduló

- jelentést

- Jelentések

- kötelező

- megköveteli,

- kutatás

- Tudástár

- tisztelet

- válasz

- felelős

- eredményez

- Eredmények

- kiskereskedelem

- kiskereskedő

- felül

- forradalmasítani

- erős

- Szerep

- királyi

- futás

- futás

- sagemaker

- SageMaker következtetés

- értékesítés

- azonos

- Télapó

- skálázható

- Skála

- Tudomány

- Tudós

- pontszám

- sdk

- Keresés

- SEC

- SEC bejelentés

- Második

- titkár

- Rész

- szakaszok

- Értékpapír

- látás

- szegmensek

- kiválasztott

- kiválasztás

- elad

- Sellers

- Eladási

- idősebb

- mondat

- érzés

- szeptember

- Sorozat

- Series of

- A sorozat

- szolgál

- szolgáltatás

- Szolgáltatások

- készlet

- beállítás

- beállítások

- számos

- Megosztás

- Szállítás

- Bevásárlás

- kellene

- előadás

- mutatott

- Műsorok

- jelentősen

- Egyszerű

- egyetlen

- Méret

- méretek

- kisebb

- So

- Társadalom

- eladott

- megoldások

- Megoldások

- SOLVE

- Források

- szakemberek

- specializált

- specializálódott

- különleges

- Költési

- kezdet

- kezdődött

- Állami

- nyilatkozatok

- statisztikai

- Lépés

- Lépései

- tárolás

- árnyékolók

- Stratégiai

- Stratégia

- folyó

- erő

- törekszünk

- stúdió

- siker

- ilyen

- kínálat

- ellátási lánc

- Támogatott

- Támogató

- Támogatja

- rendszer

- Systems

- táblázat

- Vesz

- bevétel

- Feladat

- feladatok

- csapat

- Technológia

- feltételek

- Felhasználási feltételeket

- teszt

- Szöveg osztályozása

- mint

- hogy

- A

- A terület

- A jövő

- azok

- Őket

- ebből adódóan

- Ezek

- ők

- dolgok

- Harmadik

- harmadik felek

- ezt

- három

- Keresztül

- idő

- időigényes

- alkalommal

- nak nek

- tokenek

- felső

- Témakörök

- vágány

- Vonat

- kiképzett

- Képzések

- Átadó

- át

- fordít

- Utazó

- igazság

- FORDULAT

- tv

- ui

- alatt

- megért

- megértés

- egyedi

- egyetemi

- korlátlan

- Frissítés

- us

- Használat

- használ

- használt

- segítségével

- rendszerint

- hasznosított

- kihasználva

- érvényesítés

- érték

- Értékek

- különféle

- változat

- keresztül

- Alelnök

- gyakorlatilag

- volt

- washington

- Út..

- módon

- we

- háló

- webes szolgáltatások

- weboldal

- honlapok

- JÓL

- vajon

- ami

- WHO

- lesz

- val vel

- nélkül

- szó

- Munka

- dolgozott

- művek

- világ

- lenne

- év

- év

- te

- fiatal

- A te

- zephyrnet