Jika seseorang memberi tahu Anda fakta yang sudah Anda ketahui, pada dasarnya mereka tidak memberi tahu Anda sama sekali. Sedangkan jika mereka menyampaikan rahasia, wajar jika dikatakan bahwa sesuatu benar-benar telah dikomunikasikan.

Perbedaan ini merupakan inti dari teori informasi Claude Shannon. Diperkenalkan dalam sebuah makalah zaman 1948, “Teori Komunikasi Matematika”, ini memberikan kerangka matematika yang ketat untuk mengukur jumlah informasi yang diperlukan untuk mengirim dan menerima pesan secara akurat, sebagaimana ditentukan oleh tingkat ketidakpastian seputar apa yang dapat dikatakan oleh pesan yang dimaksud.

Artinya, sudah waktunya untuk contoh.

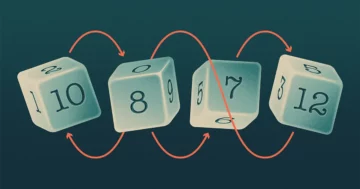

Dalam satu skenario, saya memiliki koin trik — ada di kedua sisi. Aku akan membaliknya dua kali. Berapa banyak informasi yang diperlukan untuk mengomunikasikan hasilnya? Tidak ada sama sekali, karena sebelum menerima pesan, Anda memiliki kepastian penuh bahwa kedua flip akan muncul.

Dalam skenario kedua, saya melakukan dua lemparan dengan koin biasa — kepala di satu sisi, ekor di sisi lain. Kita dapat mengomunikasikan hasilnya menggunakan kode biner: 0 untuk kepala, 1 untuk ekor. Ada empat kemungkinan pesan — 00, 11, 01, 10 — dan masing-masing membutuhkan dua bit informasi.

Jadi, apa gunanya? Dalam skenario pertama Anda memiliki kepastian penuh tentang isi pesan, dan butuh nol bit untuk mengirimkannya. Di detik Anda memiliki peluang 1-in-4 untuk menebak jawaban yang benar — kepastian 25% — dan pesan tersebut membutuhkan dua bit informasi untuk menyelesaikan ambiguitas itu. Secara umum, semakin sedikit Anda tahu tentang apa yang akan dikatakan pesan, semakin banyak informasi yang diperlukan untuk disampaikan.

Shannon adalah orang pertama yang membuat hubungan ini tepat secara matematis. Dia menangkapnya dalam formula yang menghitung jumlah bit minimum — ambang batas yang kemudian disebut entropi Shannon — yang diperlukan untuk mengomunikasikan pesan. Dia juga menunjukkan bahwa jika pengirim menggunakan bit lebih sedikit dari minimum, pesan pasti akan terdistorsi.

"Dia memiliki intuisi yang hebat bahwa informasi dimaksimalkan ketika Anda paling terkejut tentang belajar tentang sesuatu," kata Tara Javidi, seorang ahli teori informasi di University of California, San Diego.

Istilah "entropi" dipinjam dari fisika, di mana: entropi adalah ukuran ketidakteraturan. Awan memiliki entropi yang lebih tinggi daripada es batu, karena awan memungkinkan lebih banyak cara untuk mengatur molekul air daripada struktur kristal kubus. Dengan cara yang analog, pesan acak memiliki entropi Shannon yang tinggi — ada begitu banyak kemungkinan bagaimana informasinya dapat diatur — sedangkan pesan yang mematuhi pola ketat memiliki entropi rendah. Ada juga kesamaan formal dalam cara entropi dihitung dalam fisika dan teori informasi. Dalam fisika, rumus entropi melibatkan pengambilan logaritma dari kemungkinan keadaan fisik. Dalam teori informasi, ini adalah logaritma dari kemungkinan hasil peristiwa.

Rumus logaritmik untuk entropi Shannon memungkiri kesederhanaan dari apa yang ditangkapnya — karena cara lain untuk memikirkan entropi Shannon adalah sebagai jumlah pertanyaan ya atau tidak yang dibutuhkan, rata-rata, untuk memastikan isi pesan.

Misalnya, bayangkan dua stasiun cuaca, satu di San Diego, yang lain di St. Louis. Masing-masing ingin mengirim ramalan tujuh hari untuk kotanya ke kota lain. San Diego hampir selalu cerah, artinya Anda memiliki keyakinan tinggi tentang apa yang akan dikatakan ramalan cuaca. Cuaca di St. Louis lebih tidak pasti — kemungkinan hari yang cerah mendekati 50-50.

Berapa banyak pertanyaan ya atau tidak yang diperlukan untuk mengirimkan setiap ramalan tujuh hari? Untuk San Diego, pertanyaan pertama yang menguntungkan mungkin adalah: Apakah semua tujuh hari dari ramalan cuaca cerah? Jika jawabannya adalah ya (dan ada kemungkinan yang layak), Anda telah menentukan seluruh perkiraan dalam satu pertanyaan. Tetapi dengan St. Louis Anda hampir harus mengerjakan ramalan hari demi hari: Apakah hari pertama cerah? Bagaimana dengan yang kedua?

Semakin banyak kepastian seputar isi pesan, semakin sedikit pertanyaan ya-atau-tidak yang Anda perlukan, rata-rata, untuk menentukannya.

Untuk mengambil contoh lain, pertimbangkan dua versi permainan alfabet. Pada bagian pertama, saya telah memilih sebuah huruf secara acak dari alfabet bahasa Inggris dan saya ingin Anda menebaknya. Jika Anda menggunakan strategi tebakan terbaik, Anda akan membutuhkan rata-rata 4.7 pertanyaan untuk mendapatkannya. (Pertanyaan pertama yang berguna adalah, "Apakah huruf itu ada di paruh pertama alfabet?")

Di versi kedua permainan, alih-alih menebak nilai huruf acak, Anda mencoba menebak huruf dengan kata bahasa Inggris yang sebenarnya. Sekarang Anda dapat menyesuaikan tebakan Anda untuk memanfaatkan fakta bahwa beberapa huruf muncul lebih sering daripada yang lain ("Apakah itu vokal?") Dan mengetahui nilai satu huruf membantu Anda menebak nilai berikutnya (q hampir selalu diikuti oleh Anda). Shannon menghitung bahwa entropi bahasa Inggris adalah 2.62 bit per huruf (atau 2.62 pertanyaan ya-atau-tidak), jauh lebih kecil dari 4.7 yang Anda perlukan jika setiap huruf muncul secara acak. Dengan kata lain, pola mengurangi ketidakpastian, yang memungkinkan untuk banyak berkomunikasi menggunakan informasi yang relatif sedikit.

Perhatikan bahwa dalam contoh seperti ini, Anda dapat mengajukan pertanyaan yang lebih baik atau lebih buruk. Entropi Shannon menetapkan dasar yang tidak dapat diganggu gugat: Ini adalah jumlah bit minimum absolut, atau pertanyaan ya-atau-tidak, yang diperlukan untuk menyampaikan pesan.

"Shannon menunjukkan ada sesuatu seperti kecepatan cahaya, batas fundamental," kata Javidi. “Dia menunjukkan bahwa entropi Shannon adalah batas mendasar untuk seberapa banyak kita dapat mengompresi sumber, tanpa risiko distorsi atau kehilangan.”

Saat ini, entropi Shannon berfungsi sebagai tolok ukur dalam banyak pengaturan yang diterapkan, termasuk teknologi kompresi informasi. Bahwa Anda dapat meng-zip file film besar, misalnya, disebabkan oleh fakta bahwa warna piksel memiliki pola statistik, seperti yang dilakukan kata-kata dalam bahasa Inggris. Insinyur dapat membangun model probabilistik untuk pola warna piksel dari satu bingkai ke bingkai berikutnya. Model memungkinkan untuk menghitung entropi Shannon dengan menetapkan bobot pada pola dan kemudian mengambil logaritma bobot untuk semua kemungkinan cara piksel dapat muncul. Nilai itu memberi tahu Anda batas kompresi "lossless" — yang paling mutlak film dapat dikompresi sebelum Anda mulai kehilangan informasi tentang isinya.

Kinerja algoritma kompresi apa pun dapat dibandingkan dengan batas ini. Jika Anda jauh dari itu, Anda memiliki insentif untuk bekerja lebih keras untuk menemukan algoritma yang lebih baik. Tetapi jika Anda mendekatinya, Anda tahu bahwa hukum informasi alam semesta mencegah Anda melakukan jauh lebih baik.