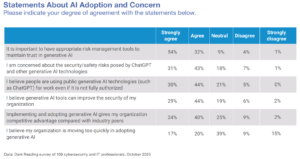

Organisasi di seluruh dunia sedang berlomba untuk mengadopsi teknologi AI ke dalam program dan alat keamanan siber mereka. A mayoritas (65%) pengembang gunakan atau rencanakan menggunakan AI dalam upaya pengujian dalam tiga tahun ke depan. Ada banyak aplikasi keamanan yang akan mendapat manfaat dari AI generatif, tetapi apakah memperbaiki kode salah satunya?

Bagi banyak tim DevSecOps, AI generatif mewakili cawan suci untuk membersihkan backlog kerentanan mereka yang semakin meningkat. Lebih dari setengah (66%) organisasi mengatakan simpanan mereka terdiri dari lebih dari 100,000 kerentanan, dan lebih dari dua pertiga pengujian keamanan aplikasi statis (SAST) melaporkan temuan tetap terbuka tiga bulan setelah deteksi, dengan 50% tersisa buka setelah 363 hari. Mimpinya adalah bahwa pengembang dapat dengan mudah meminta ChatGPT untuk "memperbaiki kerentanan ini", dan berjam-jam dan berhari-hari yang dihabiskan sebelumnya untuk memulihkan kerentanan akan menjadi masa lalu.

Ini bukan ide yang sepenuhnya gila, secara teori. Lagi pula, pembelajaran mesin telah digunakan secara efektif dalam alat keamanan siber selama bertahun-tahun untuk mengotomatiskan proses dan menghemat waktu — AI sangat bermanfaat saat diterapkan pada tugas sederhana dan berulang. Tetapi menerapkan AI generatif ke aplikasi kode kompleks memiliki beberapa kekurangan, dalam praktiknya. Tanpa pengawasan manusia dan perintah cepat, tim DevSecOps dapat menciptakan lebih banyak masalah daripada yang mereka selesaikan.

Keuntungan dan Keterbatasan Generatif AI Terkait Memperbaiki Kode

Alat AI dapat menjadi alat yang sangat ampuh untuk analisis, pemantauan, atau bahkan kebutuhan perbaikan keamanan siber yang sederhana dan berisiko rendah. Kekhawatiran muncul ketika taruhan menjadi konsekuensial. Ini pada akhirnya adalah masalah kepercayaan.

Peneliti dan pengembang masih menentukan kemampuan teknologi AI generatif baru menghasilkan perbaikan kode yang kompleks. AI generatif bergantung pada informasi yang ada dan tersedia untuk membuat keputusan. Ini dapat berguna untuk hal-hal seperti menerjemahkan kode dari satu bahasa ke bahasa lain, atau memperbaiki kelemahan umum. Misalnya, jika Anda meminta ChatGPT untuk "menulis kode JavaScript ini dengan Python", kemungkinan besar Anda akan mendapatkan hasil yang bagus. Menggunakannya untuk memperbaiki konfigurasi keamanan cloud akan sangat membantu karena dokumentasi yang relevan untuk melakukannya tersedia untuk umum dan mudah ditemukan, dan AI dapat mengikuti instruksi sederhana.

Namun, memperbaiki sebagian besar kerentanan kode memerlukan tindakan pada serangkaian keadaan dan detail unik, memperkenalkan skenario yang lebih kompleks untuk dinavigasi oleh AI. AI mungkin memberikan "perbaikan", tetapi tanpa verifikasi, itu tidak boleh dipercaya. AI generatif, menurut definisi, tidak dapat membuat sesuatu yang belum diketahui, dan dapat mengalami halusinasi yang menghasilkan keluaran palsu.

Dalam contoh baru-baru ini, seorang pengacara menghadapi konsekuensi serius setelah menggunakan ChatGPT untuk membantu menulis pengajuan pengadilan yang mengutip enam kasus yang tidak ada yang ditemukan oleh alat AI. Jika AI berhalusinasi metode yang tidak ada dan kemudian menerapkan metode tersebut untuk menulis kode, itu akan membuang waktu untuk "perbaikan" yang tidak dapat dikompilasi. Selain itu, menurut OpenAI's Laporan resmi GPT-4, eksploitasi baru, jailbreak, dan perilaku yang muncul akan ditemukan seiring waktu dan sulit dicegah. Jadi pertimbangan yang cermat diperlukan untuk memastikan alat keamanan AI dan solusi pihak ketiga diperiksa dan diperbarui secara berkala untuk memastikan mereka tidak menjadi pintu belakang yang tidak diinginkan ke dalam sistem.

Percaya atau Tidak Percaya?

Ini adalah dinamika yang menarik untuk melihat adopsi cepat AI generatif yang dimainkan di puncak gerakan tanpa kepercayaan. Sebagian besar alat keamanan siber dibangun berdasarkan gagasan bahwa organisasi tidak boleh percaya, selalu verifikasi. AI generatif dibangun berdasarkan prinsip kepercayaan yang melekat pada informasi yang disediakan oleh sumber yang diketahui dan tidak dikenal. Benturan prinsip ini tampaknya merupakan metafora yang cocok untuk perjuangan gigih yang dihadapi organisasi dalam menemukan keseimbangan yang tepat antara keamanan dan produktivitas, yang terasa semakin parah saat ini.

Meskipun AI generatif mungkin belum menjadi tujuan yang diharapkan oleh tim DevSecOps, ini akan membantu membuat kemajuan bertahap dalam mengurangi simpanan kerentanan. Untuk saat ini, dapat diterapkan untuk melakukan perbaikan sederhana. Untuk perbaikan yang lebih kompleks, mereka harus mengadopsi metodologi verifikasi-ke-percaya yang memanfaatkan kekuatan AI yang dipandu oleh pengetahuan pengembang yang menulis dan memiliki kode.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://www.darkreading.com/application-security/can-generative-ai-be-trusted-to-fix-your-code-

- :memiliki

- :adalah

- :bukan

- $NAIK

- 000

- 100

- 7

- a

- Menurut

- akting

- Selain itu

- mengambil

- Adopsi

- keuntungan

- Setelah

- AI

- Semua

- sudah

- selalu

- an

- analisis

- dan

- Lain

- Aplikasi

- keamanan aplikasi

- aplikasi

- terapan

- Mendaftar

- Menerapkan

- ADALAH

- At

- mengotomatisasikan

- tersedia

- backdoors

- Saldo

- BE

- karena

- menjadi

- menjadi

- bermanfaat

- manfaat

- antara

- dibangun di

- tapi

- by

- CAN

- kemampuan

- hati-hati

- kasus

- ChatGPT

- keadaan

- dikutip

- Bentrokan

- Pembukaan hutan

- awan

- Cloud Security

- kode

- kompleks

- Terdiri dari

- Perhatian

- konfigurasi

- Konsekuensi

- konsekuensial

- pertimbangan

- bisa

- Pengadilan

- Pengajuan Pengadilan

- gila

- membuat

- membuat

- Keamanan cyber

- Hari

- keputusan

- definisi

- rincian

- Deteksi

- menentukan

- Pengembang

- pengembang

- sulit

- ditemukan

- do

- dokumentasi

- mimpi

- dinamis

- mudah

- efektif

- akhir

- memastikan

- sepenuhnya

- Bahkan

- contoh

- ada

- ada

- pengalaman

- eksploitasi

- ekspres

- Menghadapi

- menghadapi

- gadungan

- pengajuan

- temuan

- Temuan

- sesuai

- Memperbaiki

- kekurangan

- mengikuti

- Untuk

- ditemukan

- dari

- generatif

- AI generatif

- mendapatkan

- baik

- Setengah

- tinggi

- membantu

- bermanfaat

- berharap

- JAM

- HTML

- HTTPS

- Sangat

- manusia

- ide

- if

- in

- meningkatkan

- luar biasa

- informasi

- inheren

- instruksi

- menarik

- ke

- memperkenalkan

- Jadian

- isu

- IT

- JavaScript

- jpg

- pengetahuan

- dikenal

- bahasa

- pengacara

- pengetahuan

- 'like'

- Mungkin

- keterbatasan

- ll

- Resiko rendah

- mesin

- Mesin belajar

- terbuat

- Mayoritas

- membuat

- banyak

- Metodologi

- metode

- mungkin

- saat

- pemantauan

- bulan

- lebih

- paling

- gerakan

- Arahkan

- Perlu

- kebutuhan

- tak pernah

- New

- berikutnya

- tidak ada

- sekarang

- of

- on

- ONE

- Buka

- OpenAI

- or

- urutan

- organisasi

- di luar

- lebih

- Kelalaian

- sendiri

- khususnya

- lalu

- rencana

- plato

- Kecerdasan Data Plato

- Data Plato

- Bermain

- kekuasaan

- kuat

- praktek

- mencegah

- sebelumnya

- prinsip

- prinsip-prinsip

- masalah

- proses

- produktifitas

- program

- Kemajuan

- memberikan

- di depan umum

- Ular sanca

- Ras

- cepat

- baru

- mengurangi

- secara teratur

- terkait

- relevan

- tinggal

- yang tersisa

- berulang-ulang

- Dilaporkan

- merupakan

- wajib

- membutuhkan

- mengakibatkan

- benar

- s

- Save

- mengatakan

- skenario

- keamanan

- melihat

- tampaknya

- serius

- set

- harus

- Sederhana

- hanya

- ENAM

- So

- Solusi

- MEMECAHKAN

- beberapa

- sesuatu

- sumber

- menghabiskan

- Masih

- Perjuangan

- sistem

- tugas

- tim

- Teknologi

- Teknologi

- pengujian

- dari

- bahwa

- Grafik

- informasi

- mereka

- Mereka

- kemudian

- teori

- Sana.

- mereka

- hal

- hal

- pihak ketiga

- ini

- itu

- tiga

- waktu

- untuk

- alat

- alat

- Kepercayaan

- Terpercaya

- dua pertiga

- Akhirnya

- unik

- tidak dikenal

- diperbarui

- menggunakan

- bekas

- menggunakan

- Verifikasi

- memeriksa

- diperiksa

- Kerentanan

- kerentanan

- terkenal

- adalah

- ketika

- yang

- SIAPA

- akan

- dengan

- tanpa

- industri udang di seluruh dunia.

- akan

- menulis

- penulisan

- tahun

- namun

- Kamu

- Anda

- zephyrnet.dll