Kebijakan pengendalian yang efisien memungkinkan perusahaan industri meningkatkan profitabilitas mereka dengan memaksimalkan produktivitas sekaligus mengurangi waktu henti yang tidak terjadwal dan konsumsi energi. Menemukan kebijakan pengendalian yang optimal merupakan tugas yang kompleks karena sistem fisik, seperti reaktor kimia dan turbin angin, seringkali sulit untuk dimodelkan dan karena penyimpangan dalam dinamika proses dapat menyebabkan kinerja menurun seiring berjalannya waktu. Pembelajaran penguatan offline adalah strategi pengendalian yang memungkinkan perusahaan industri membangun kebijakan pengendalian sepenuhnya dari data historis tanpa memerlukan model proses yang eksplisit. Pendekatan ini tidak memerlukan interaksi dengan proses secara langsung dalam tahap eksplorasi, sehingga menghilangkan salah satu hambatan penerapan pembelajaran penguatan dalam aplikasi yang kritis terhadap keselamatan. Dalam postingan ini, kami akan membangun solusi end-to-end untuk menemukan kebijakan kontrol optimal hanya dengan menggunakan data historis Amazon SageMaker menggunakan Ray RLlib perpustakaan. Untuk mempelajari lebih lanjut tentang pembelajaran penguatan, lihat Gunakan Pembelajaran Penguatan dengan Amazon SageMaker.

Gunakan kasus

Pengendalian industri melibatkan pengelolaan sistem yang kompleks, seperti jalur produksi, jaringan energi, dan pabrik kimia, untuk memastikan operasi yang efisien dan andal. Banyak strategi pengendalian tradisional didasarkan pada aturan dan model yang telah ditentukan sebelumnya, yang seringkali memerlukan optimasi manual. Merupakan praktik standar di beberapa industri untuk memantau kinerja dan menyesuaikan kebijakan pengendalian ketika, misalnya, peralatan mulai rusak atau kondisi lingkungan berubah. Penyetelan ulang dapat memakan waktu berminggu-minggu dan mungkin memerlukan memasukkan rangsangan eksternal ke dalam sistem untuk mencatat responsnya dalam pendekatan coba-coba.

Pembelajaran penguatan telah muncul sebagai paradigma baru dalam pengendalian proses untuk mempelajari kebijakan pengendalian yang optimal melalui interaksi dengan lingkungan. Proses ini memerlukan pengelompokan data menjadi tiga kategori: 1) pengukuran yang tersedia dari sistem fisik, 2) serangkaian tindakan yang dapat diambil pada sistem, dan 3) metrik numerik (imbalan) kinerja peralatan. Sebuah kebijakan dilatih untuk menemukan tindakan, pada pengamatan tertentu, yang kemungkinan besar akan menghasilkan imbalan tertinggi di masa depan.

Dalam pembelajaran penguatan offline, seseorang dapat melatih kebijakan pada data historis sebelum menerapkannya ke dalam produksi. Algoritme yang dilatih dalam postingan blog ini disebut “Pembelajaran Q Konservatif” (CQL). CQL berisi model “aktor” dan model “kritikus” dan dirancang untuk memprediksi kinerjanya secara konservatif setelah mengambil tindakan yang direkomendasikan. Dalam postingan ini, prosesnya didemonstrasikan dengan ilustrasi masalah kendali tiang kereta. Tujuannya adalah untuk melatih agen untuk menyeimbangkan tiang di gerobak sekaligus menggerakkan gerobak menuju lokasi tujuan yang ditentukan. Prosedur pelatihan menggunakan data offline, memungkinkan agen belajar dari informasi yang sudah ada sebelumnya. Studi kasus ini menunjukkan proses pelatihan dan efektivitasnya dalam penerapan potensial di dunia nyata.

Ikhtisar solusi

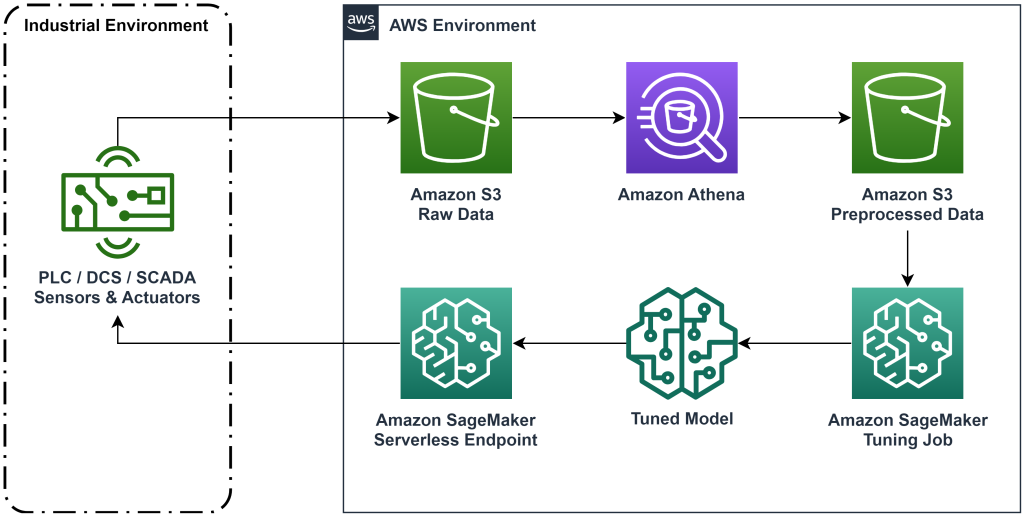

Solusi yang disajikan dalam postingan ini mengotomatiskan penerapan alur kerja ujung ke ujung untuk pembelajaran penguatan offline dengan data historis. Diagram berikut menjelaskan arsitektur yang digunakan dalam alur kerja ini. Data pengukuran dihasilkan di tepian oleh peralatan industri (di sini disimulasikan oleh sebuah AWS Lambda fungsi). Data dimasukkan ke dalam Amazon Kinesis Data Firehose, yang menyimpannya di Layanan Penyimpanan Sederhana Amazon (Amazon S3). Amazon S3 adalah solusi penyimpanan yang tahan lama, berperforma tinggi, dan berbiaya rendah yang memungkinkan Anda menyajikan data dalam jumlah besar ke proses pelatihan pembelajaran mesin.

Lem AWS mengkatalogkan data dan membuatnya dapat dikueri menggunakan Amazon Athena. Athena mengubah data pengukuran menjadi bentuk yang dapat diserap oleh algoritma pembelajaran penguatan dan kemudian mengeluarkannya kembali ke Amazon S3. Amazon SageMaker memuat data ini ke dalam tugas pelatihan dan menghasilkan model terlatih. SageMaker kemudian menyajikan model tersebut di titik akhir SageMaker. Peralatan industri kemudian dapat menanyakan titik akhir tersebut untuk menerima rekomendasi tindakan.

Gambar 1: Diagram arsitektur yang menunjukkan alur kerja pembelajaran penguatan ujung ke ujung.

Dalam posting ini, kami akan membagi alur kerja dalam langkah-langkah berikut:

- Rumuskan masalahnya. Putuskan tindakan apa yang dapat diambil, pengukuran apa yang menjadi dasar rekomendasi, dan tentukan secara numerik seberapa baik setiap tindakan dilakukan.

- Siapkan datanya. Ubah tabel pengukuran menjadi format yang dapat digunakan oleh algoritma pembelajaran mesin.

- Latih algoritme pada data itu.

- Pilih pelaksanaan pelatihan terbaik berdasarkan metrik pelatihan.

- Terapkan model ke titik akhir SageMaker.

- Evaluasi kinerja model dalam produksi.

Prasyarat

Untuk menyelesaikan panduan ini, Anda perlu memiliki Akun AWS dan antarmuka baris perintah dengan AWS SAM diinstal. Ikuti langkah-langkah berikut untuk menerapkan templat AWS SAM untuk menjalankan alur kerja ini dan menghasilkan data pelatihan:

- Unduh repositori kode dengan perintah

- Ubah direktori ke repo:

- Bangun repo:

- Terapkan repo

- Gunakan perintah berikut untuk memanggil skrip bash, yang menghasilkan data tiruan menggunakan fungsi AWS Lambda.

sudo yum install jqcd utilssh generate_mock_data.sh

Panduan solusi

Merumuskan masalah

Sistem kami dalam postingan blog ini adalah gerobak dengan tiang seimbang di atasnya. Sistem bekerja dengan baik bila tiangnya tegak, dan posisi kereta dekat dengan posisi gawang. Pada langkah prasyarat, kami menghasilkan data historis dari sistem ini.

Tabel berikut menunjukkan data historis yang dikumpulkan dari sistem.

| Posisi gerobak | Kecepatan gerobak | Sudut tiang | Kecepatan sudut kutub | Posisi tujuan | Kekuatan eksternal | Pahala | Waktu |

| 0.53 | -0.79 | -0.08 | 0.16 | 0.50 | -0.04 | 11.5 | 5: 37: 54 PM |

| 0.51 | -0.82 | -0.07 | 0.17 | 0.50 | -0.04 | 11.9 | 5: 37: 55 PM |

| 0.50 | -0.84 | -0.07 | 0.18 | 0.50 | -0.03 | 12.2 | 5: 37: 56 PM |

| 0.48 | -0.85 | -0.07 | 0.18 | 0.50 | -0.03 | 10.5 | 5: 37: 57 PM |

| 0.46 | -0.87 | -0.06 | 0.19 | 0.50 | -0.03 | 10.3 | 5: 37: 58 PM |

Anda dapat menanyakan informasi sistem historis menggunakan Amazon Athena dengan kueri berikut:

Keadaan sistem ini ditentukan oleh posisi kereta, kecepatan kereta, sudut tiang, kecepatan sudut tiang, dan posisi gawang. Tindakan yang dilakukan pada setiap langkah waktu merupakan gaya luar yang diterapkan pada kereta. Lingkungan simulasi menghasilkan nilai reward yang lebih tinggi ketika gerobak lebih dekat ke posisi gawang dan tiang lebih tegak.

Siapkan data

Untuk menyajikan informasi sistem ke model pembelajaran penguatan, ubahlah menjadi objek JSON dengan kunci yang mengkategorikan nilai ke dalam kategori status (juga disebut observasi), tindakan, dan penghargaan. Simpan objek ini di Amazon S3. Berikut contoh objek JSON yang dihasilkan dari langkah waktu pada tabel sebelumnya.

|

{“obs”:[[0.53,-0.79,-0.08,0.16,0.5]], “action”:[[-0.04]], “reward”:[11.5] ,”next_obs”:[[0.51,-0.82,-0.07,0.17,0.5]]} |

|

{“obs”:[[0.51,-0.82,-0.07,0.17,0.5]], “action”:[[-0.04]], “reward”:[11.9], “next_obs”:[[0.50,-0.84,-0.07,0.18,0.5]]} |

|

{“obs”:[[0.50,-0.84,-0.07,0.18,0.5]], “action”:[[-0.03]], “reward”:[12.2], “next_obs”:[[0.48,-0.85,-0.07,0.18,0.5]]} |

Tumpukan AWS CloudFormation berisi output yang disebut AthenaQueryToCreateJsonFormatedData. Jalankan kueri ini di Amazon Athena untuk melakukan transformasi dan menyimpan objek JSON di Amazon S3. Algoritme pembelajaran penguatan menggunakan struktur objek JSON ini untuk memahami nilai mana yang menjadi dasar rekomendasi dan hasil dari pengambilan tindakan dalam data historis.

Agen kereta api

Sekarang kita dapat memulai tugas pelatihan untuk menghasilkan model rekomendasi tindakan yang terlatih. Amazon SageMaker memungkinkan Anda meluncurkan beberapa tugas pelatihan dengan cepat untuk melihat bagaimana berbagai konfigurasi memengaruhi model terlatih yang dihasilkan. Panggil fungsi Lambda dengan nama TuningJobLauncherFunction untuk memulai tugas penyetelan hyperparameter yang bereksperimen dengan empat set hyperparameter berbeda saat melatih algoritme.

Pilih latihan terbaik yang dijalankan

Untuk menemukan tugas pelatihan mana yang menghasilkan model terbaik, periksa kurva kerugian yang dihasilkan selama pelatihan. Model kritik CQL memperkirakan kinerja aktor (disebut nilai Q) setelah mengambil tindakan yang direkomendasikan. Bagian dari fungsi kerugian kritikus mencakup kesalahan perbedaan temporal. Metrik ini mengukur akurasi nilai Q kritikus. Carilah pelatihan yang dijalankan dengan nilai Q rata-rata yang tinggi dan kesalahan perbedaan temporal yang rendah. Makalah ini, Alur Kerja untuk Pembelajaran Penguatan Robot Tanpa Model Offline, merinci cara memilih latihan terbaik. Repositori kode memiliki file, /utils/investigate_training.py, yang membuat gambar html plot yang menjelaskan pekerjaan pelatihan terbaru. Jalankan file ini dan gunakan hasilnya untuk memilih proses pelatihan terbaik.

Kita dapat menggunakan nilai mean Q untuk memprediksi performa model yang dilatih. Nilai Q dilatih untuk memprediksi secara konservatif jumlah diskon nilai imbalan di masa depan. Untuk proses yang berjalan lama, kita dapat mengonversi angka ini menjadi rata-rata tertimbang secara eksponensial dengan mengalikan nilai Q dengan (1- “tingkat diskonto”). Pelatihan terbaik yang dijalankan dalam rangkaian ini mencapai nilai rata-rata Q sebesar 539. Tingkat diskon kami adalah 0.99, sehingga model memperkirakan setidaknya 5.39 imbalan rata-rata per langkah waktu. Anda dapat membandingkan nilai ini dengan kinerja sistem historis untuk mengetahui apakah model baru akan mengungguli kebijakan kontrol historis. Dalam eksperimen ini, rata-rata imbalan per langkah waktu dari data historis adalah 4.3, sehingga model CQL memperkirakan kinerja 25 persen lebih baik daripada yang dicapai sistem secara historis.

Terapkan model

Titik akhir Amazon SageMaker memungkinkan Anda menyajikan model pembelajaran mesin dalam beberapa cara berbeda untuk memenuhi berbagai kasus penggunaan. Dalam postingan ini, kami akan menggunakan tipe titik akhir tanpa server sehingga titik akhir kami secara otomatis diskalakan sesuai permintaan, dan kami hanya membayar penggunaan komputasi saat titik akhir menghasilkan inferensi. Untuk menyebarkan titik akhir tanpa server, sertakan a ProductionVariantServerlessConfig dalam varian produksi dari SageMaker konfigurasi titik akhir. Cuplikan kode berikut menunjukkan bagaimana titik akhir tanpa server dalam contoh ini diterapkan menggunakan kit pengembangan perangkat lunak Amazon SageMaker untuk Python. Temukan kode sampel yang digunakan untuk menerapkan model di sagemaker-offline-penguatan-pembelajaran-ray-cql.

File model yang dilatih terletak di artefak model S3 untuk setiap pelatihan yang dijalankan. Untuk menerapkan model pembelajaran mesin, temukan file model dari proses pelatihan terbaik, dan panggil fungsi Lambda bernama “ModelDeployerFunction” dengan peristiwa yang berisi data model ini. Fungsi Lambda akan meluncurkan titik akhir tanpa server SageMaker untuk melayani model yang dilatih. Contoh acara yang akan digunakan saat memanggil “ModelDeployerFunction"

Evaluasi kinerja model yang dilatih

Saatnya melihat performa model terlatih kita dalam produksi! Untuk memeriksa performa model baru, panggil fungsi Lambda bernama “RunPhysicsSimulationFunction” dengan nama titik akhir SageMaker di acara tersebut. Ini akan menjalankan simulasi menggunakan tindakan yang direkomendasikan oleh titik akhir. Contoh acara yang akan digunakan saat memanggil RunPhysicsSimulatorFunction:

Gunakan kueri Athena berikut untuk membandingkan performa model yang dilatih dengan performa sistem historis.

| Sumber tindakan | Imbalan rata-rata per langkah waktu |

trained_model |

10.8 |

historic_data |

4.3 |

Animasi berikut menunjukkan perbedaan antara episode sampel dari data pelatihan dan episode saat model terlatih digunakan untuk memilih tindakan yang akan diambil. Dalam animasinya, kotak biru adalah gerobak, garis biru adalah tiang, dan persegi panjang hijau adalah lokasi tujuan. Panah merah menunjukkan gaya yang diterapkan pada kereta pada setiap langkah waktu. Panah merah pada data pelatihan cukup melompat maju mundur karena data dihasilkan menggunakan 50 persen tindakan ahli dan 50 persen tindakan acak. Model yang dilatih mempelajari kebijakan pengendalian yang menggerakkan kereta dengan cepat ke posisi tujuan, dengan tetap menjaga stabilitas, sepenuhnya dari pengamatan demonstrasi yang tidak ahli.

|

|

Membersihkan

Untuk menghapus sumber daya yang digunakan dalam alur kerja ini, navigasikan ke bagian sumber daya tumpukan Amazon CloudFormation dan hapus bucket S3 dan IAM role. Kemudian hapus tumpukan CloudFormation itu sendiri.

Kesimpulan

Pembelajaran penguatan offline dapat membantu perusahaan industri mengotomatiskan pencarian kebijakan optimal tanpa mengorbankan keselamatan dengan menggunakan data historis. Untuk menerapkan pendekatan ini dalam operasi Anda, mulailah dengan mengidentifikasi pengukuran yang membentuk sistem yang ditentukan negara, tindakan yang dapat Anda kendalikan, dan metrik yang menunjukkan kinerja yang diinginkan. Lalu, akses repositori GitHub ini untuk implementasi solusi end-to-end otomatis menggunakan Ray dan Amazon SageMaker.

Postingan ini hanya menjelaskan sekilas tentang apa yang dapat Anda lakukan dengan Amazon SageMaker RL. Cobalah, dan kirimkan masukan kepada kami, baik di Forum diskusi Amazon SageMaker atau melalui kontak AWS biasa Anda.

Tentang Penulis

Walt Mayfield adalah Arsitek Solusi di AWS dan membantu perusahaan energi beroperasi dengan lebih aman dan efisien. Sebelum bergabung dengan AWS, Walt bekerja sebagai Insinyur Operasi di Hilcorp Energy Company. Dia suka berkebun dan menerbangkan ikan di waktu luangnya.

Walt Mayfield adalah Arsitek Solusi di AWS dan membantu perusahaan energi beroperasi dengan lebih aman dan efisien. Sebelum bergabung dengan AWS, Walt bekerja sebagai Insinyur Operasi di Hilcorp Energy Company. Dia suka berkebun dan menerbangkan ikan di waktu luangnya.

Felipe Lopez adalah Arsitek Solusi Senior di AWS dengan konsentrasi Operasi Produksi Minyak & Gas. Sebelum bergabung dengan AWS, Felipe bekerja dengan GE Digital dan Schlumberger, di mana ia berfokus pada pemodelan dan pengoptimalan produk untuk aplikasi industri.

Felipe Lopez adalah Arsitek Solusi Senior di AWS dengan konsentrasi Operasi Produksi Minyak & Gas. Sebelum bergabung dengan AWS, Felipe bekerja dengan GE Digital dan Schlumberger, di mana ia berfokus pada pemodelan dan pengoptimalan produk untuk aplikasi industri.

Yingwei Yu adalah Ilmuwan Terapan di Generative AI Incubator, AWS. Dia memiliki pengalaman bekerja dengan beberapa organisasi di berbagai industri dalam berbagai pembuktian konsep dalam pembelajaran mesin, termasuk pemrosesan bahasa alami, analisis deret waktu, dan pemeliharaan prediktif. Di waktu luangnya, ia menikmati berenang, melukis, mendaki gunung, serta menghabiskan waktu bersama keluarga dan teman.

Yingwei Yu adalah Ilmuwan Terapan di Generative AI Incubator, AWS. Dia memiliki pengalaman bekerja dengan beberapa organisasi di berbagai industri dalam berbagai pembuktian konsep dalam pembelajaran mesin, termasuk pemrosesan bahasa alami, analisis deret waktu, dan pemeliharaan prediktif. Di waktu luangnya, ia menikmati berenang, melukis, mendaki gunung, serta menghabiskan waktu bersama keluarga dan teman.

Haozu Wang adalah seorang ilmuwan riset di Amazon Bedrock yang berfokus pada pembuatan model fondasi Titan Amazon. Sebelumnya dia bekerja di Amazon ML Solutions Lab sebagai salah satu pimpinan Reinforcement Learning Vertical dan membantu pelanggan membangun solusi ML tingkat lanjut dengan penelitian terbaru tentang pembelajaran penguatan, pemrosesan bahasa alami, dan pembelajaran grafik. Haozhu menerima gelar PhD di bidang Teknik Listrik dan Komputer dari Universitas Michigan.

Haozu Wang adalah seorang ilmuwan riset di Amazon Bedrock yang berfokus pada pembuatan model fondasi Titan Amazon. Sebelumnya dia bekerja di Amazon ML Solutions Lab sebagai salah satu pimpinan Reinforcement Learning Vertical dan membantu pelanggan membangun solusi ML tingkat lanjut dengan penelitian terbaru tentang pembelajaran penguatan, pemrosesan bahasa alami, dan pembelajaran grafik. Haozhu menerima gelar PhD di bidang Teknik Listrik dan Komputer dari Universitas Michigan.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Otomotif / EV, Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- ChartPrime. Tingkatkan Game Trading Anda dengan ChartPrime. Akses Di Sini.

- BlockOffset. Modernisasi Kepemilikan Offset Lingkungan. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/optimize-equipment-performance-with-historical-data-ray-and-amazon-sagemaker/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 07

- 08

- 1

- 10

- 100

- 11

- 12

- 13

- 14

- 16

- 17

- 25

- 32

- 39

- 50

- 51

- 54

- 7

- 8

- 84

- 9

- a

- Tentang Kami

- mengakses

- ketepatan

- dicapai

- di seluruh

- Tindakan

- tindakan

- Selain itu

- Adopsi

- maju

- mempengaruhi

- Setelah

- Agen

- AI

- algoritma

- Membiarkan

- memungkinkan

- juga

- Amazon

- Amazon Athena

- Lab Solusi Amazon ML

- Amazon SageMaker

- Amazon Web Services

- an

- analisis

- dan

- Kaku

- animasi

- aplikasi

- terapan

- pendekatan

- arsitektur

- ADALAH

- AS

- At

- mengotomatisasikan

- mengotomatiskan

- secara otomatis

- secara otomatis

- tersedia

- rata-rata

- AWS

- Formasi AWS Cloud

- AWS Lambda

- kembali

- Saldo

- hambatan

- mendasarkan

- berdasarkan

- menampar

- BE

- karena

- sebelum

- TERBAIK

- Lebih baik

- antara

- Bit

- Blog

- Biru

- Kotak

- Istirahat

- Melanggar

- membangun

- Bangunan

- by

- panggilan

- bernama

- panggilan

- CAN

- kasus

- studi kasus

- kasus

- katalog

- kategori

- Menyebabkan

- perubahan

- memeriksa

- kimia

- Penyelesaian

- lebih dekat

- kode

- Perusahaan

- perusahaan

- membandingkan

- lengkap

- kompleks

- kompromi

- menghitung

- komputer

- Teknik Komputer

- konsentrasi

- konsep

- Kondisi

- konservatif

- memakan

- konsumsi

- kontak

- mengandung

- kontrol

- mengubah

- menciptakan

- Pengkritik

- pelanggan

- data

- memutuskan

- didefinisikan

- Permintaan

- menunjukkan

- menunjukkan

- menyebarkan

- dikerahkan

- penggelaran

- penyebaran

- ditunjuk

- dirancang

- diinginkan

- rincian

- Menentukan

- Pengembangan

- perbedaan

- berbeda

- digital

- langsung

- Diskon

- diskon

- diskusi

- do

- tidak

- melakukan

- turun

- penghentian

- selama

- dinamika

- setiap

- Tepi

- efektivitas

- efisien

- efisien

- antara

- muncul

- aktif

- ujung ke ujung

- Titik akhir

- energi

- Konsumsi Energi

- insinyur

- Teknik

- memastikan

- sepenuhnya

- Lingkungan Hidup

- lingkungan

- episode

- peralatan

- kesalahan

- perkiraan

- Acara

- memeriksa

- contoh

- pengalaman

- eksperimen

- eksperimen

- ahli

- eksplorasi

- eksponensial

- luar

- keluarga

- umpan balik

- Angka

- File

- File

- Menemukan

- temuan

- Ikan

- terfokus

- berfokus

- mengikuti

- berikut

- Untuk

- kekuatan

- bentuk

- format

- sebagainya

- Prinsip Dasar

- empat

- teman

- dari

- fungsi

- masa depan

- Taman

- GAS

- dikumpulkan

- ge

- menghasilkan

- dihasilkan

- menghasilkan

- menghasilkan

- generatif

- AI generatif

- gif

- GitHub

- Memberikan

- diberikan

- tujuan

- grafik

- Hijau

- Kelompok

- Sulit

- Memiliki

- he

- membantu

- membantu

- membantu

- di sini

- High

- lebih tinggi

- paling tinggi

- -nya

- historis

- secara historis

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- HTML

- HTTPS

- Penyesuaian Hyperparameter

- mengidentifikasi

- if

- melaksanakan

- implementasi

- in

- memasukkan

- termasuk

- Termasuk

- Meningkatkan

- inkubator

- menunjukkan

- indikasi

- industri

- industri

- informasi

- install

- berinteraksi

- interaksi

- Antarmuka

- ke

- IT

- NYA

- Diri

- Pekerjaan

- Jobs

- bergabung

- jpg

- json

- melompat

- hanya

- kunci-kunci

- laboratorium

- bahasa

- besar

- Terbaru

- jalankan

- BELAJAR

- belajar

- pengetahuan

- paling sedikit

- membiarkan

- Lets

- Perpustakaan

- Mungkin

- 'like

- MEMBATASI

- baris

- baris

- beban

- terletak

- tempat

- melihat

- lepas

- Rendah

- murah

- mesin

- Mesin belajar

- mempertahankan

- pemeliharaan

- membuat

- MEMBUAT

- pengelolaan

- panduan

- pabrik

- banyak

- memaksimalkan

- Mungkin..

- berarti

- pengukuran

- pengukuran

- ukuran

- Pelajari

- metrik

- Metrik

- Michigan

- ML

- model

- pemodelan

- model

- Memantau

- lebih

- bergerak

- bergerak

- beberapa

- mengalikan

- nama

- Bernama

- Alam

- Pengolahan Bahasa alami

- Arahkan

- Perlu

- New

- jumlah

- objek

- of

- Pengunjung

- sering

- Minyak

- on

- ONE

- hanya

- beroperasi

- operasi

- Operasi

- optimal

- optimasi

- Optimize

- or

- urutan

- organisasi

- kami

- Hasil

- Mengungguli

- keluaran

- lebih

- sendiri

- lukisan

- kertas

- pola pikir

- bagian

- Membayar

- untuk

- persen

- Melakukan

- prestasi

- dilakukan

- melakukan

- phd

- fisik

- memilih

- bagian

- tanaman

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Kebijakan

- kebijaksanaan

- posisi

- Pos

- potensi

- praktek

- meramalkan

- memprediksi

- ramalan

- menyajikan

- disajikan

- sebelumnya

- sebelumnya

- Sebelumnya

- Masalah

- Prosedur

- proses

- proses

- pengolahan

- menghasilkan

- Diproduksi

- menghasilkan

- Produksi

- produktifitas

- Produk

- profitabilitas

- bukti

- menempatkan

- Ular sanca

- segera

- acak

- Penilaian

- RAY

- dunia nyata

- menerima

- diterima

- Rekomendasi

- rekomendasi

- direkomendasikan

- catatan

- Merah

- mengurangi

- dapat diandalkan

- gudang

- membutuhkan

- membutuhkan

- penelitian

- Sumber

- tanggapan

- dihasilkan

- Hasil

- Pahala

- Hadiah

- peran

- aturan

- Run

- berjalan

- aman

- Safety/keselamatan

- pembuat bijak

- Universitas

- sisik

- ilmuwan

- naskah

- Pencarian

- Bagian

- melihat

- mengirim

- senior

- Seri

- melayani

- Tanpa Server

- melayani

- Layanan

- set

- set

- beberapa

- Menunjukkan

- Pertunjukkan

- Sederhana

- simulasi

- serentak

- potongan

- So

- Perangkat lunak

- pengembangan perangkat lunak

- kit pengembangan perangkat lunak

- larutan

- Solusi

- beberapa

- Pengeluaran

- Stabilitas

- tumpukan

- Tahap

- standar

- awal

- dimulai

- Negara

- Langkah

- Tangga

- penyimpanan

- menyimpan

- toko

- strategi

- Penyelarasan

- struktur

- Belajar

- seperti itu

- Permukaan

- sistem

- sistem

- tabel

- Mengambil

- diambil

- pengambilan

- tugas

- Template

- dari

- bahwa

- Grafik

- Negara

- mereka

- kemudian

- Ini

- ini

- tiga

- Melalui

- waktu

- Seri waktu

- titan

- untuk

- puncak

- terhadap

- tradisional

- Pelatihan VE

- terlatih

- Pelatihan

- Mengubah

- Transformasi

- transformasi

- benar

- mencoba

- mengetik

- memahami

- universitas

- atas

- us

- penggunaan

- menggunakan

- bekas

- kegunaan

- menggunakan

- nilai

- Nilai - Nilai

- variasi

- berbagai

- Kecepatan

- vertikal

- volume

- walkthrough

- adalah

- cara

- we

- jaringan

- layanan web

- minggu

- BAIK

- Apa

- ketika

- yang

- sementara

- akan

- angin

- dengan

- tanpa

- bekerja

- alur kerja

- kerja

- Kamu

- Anda

- zephyrnet.dll