Rekayasa cepat telah menjadi keterampilan penting bagi siapa pun yang bekerja dengan model bahasa besar (LLM) untuk menghasilkan teks berkualitas tinggi dan relevan. Meskipun rekayasa teks cepat telah banyak dibahas, rekayasa cepat visual adalah bidang baru yang memerlukan perhatian. Perintah visual dapat mencakup kotak pembatas atau masker yang memandu model visi dalam menghasilkan keluaran yang relevan dan akurat. Dalam postingan ini, kami mengeksplorasi dasar-dasar rekayasa visual prompt, manfaatnya, dan cara menggunakannya untuk menyelesaikan kasus penggunaan tertentu: segmentasi gambar untuk mengemudi otonom.

Dalam beberapa tahun terakhir, bidang visi komputer telah menyaksikan kemajuan signifikan dalam bidang segmentasi gambar. Salah satu terobosan tersebut adalah Segmen Model Apapun (SAM) oleh Meta AI, yang berpotensi merevolusi segmentasi tingkat objek dengan pelatihan zero-shot atau beberapa-shot. Dalam postingan ini, kami menggunakan model SAM sebagai contoh model visi dasar dan mengeksplorasi penerapannya pada Kumpulan data BDD100K, kumpulan data mengemudi otonom yang beragam untuk pembelajaran multitask yang heterogen. Dengan menggabungkan kekuatan SAM dengan kekayaan data yang disediakan oleh BDD100K, kami menampilkan potensi rekayasa visual cepat dengan versi SAM yang berbeda. Terinspirasi oleh LangChain kerangka kerja untuk model bahasa, kami mengusulkan rantai visual untuk melakukan dorongan visual dengan menggabungkan model deteksi objek dengan SAM.

Meskipun postingan ini berfokus pada mengemudi otonom, konsep yang dibahas dapat diterapkan secara luas pada domain yang memiliki aplikasi berbasis visi yang kaya seperti layanan kesehatan dan ilmu hayati, serta media dan hiburan. Mari kita mulai dengan mempelajari lebih lanjut tentang apa yang ada di balik model visi dasar seperti SAM. Kami menggunakan Studio Amazon SageMaker pada contoh ml.g5.16xlarge untuk posting ini.

Segmen Model Apapun (SAM)

Model dasar adalah model pembelajaran mesin (ML) besar yang dilatih pada data dalam jumlah besar dan dapat diminta atau disesuaikan untuk kasus penggunaan tugas tertentu. Di sini, kami mengeksplorasi Segment Anything Model (SAM), yang merupakan model dasar visi, khususnya segmentasi gambar. Ini telah dilatih sebelumnya pada kumpulan data besar yang terdiri dari 11 juta gambar dan 1.1 miliar masker, menjadikannya kumpulan data segmentasi terbesar saat penulisan. Kumpulan data ekstensif ini mencakup berbagai objek dan kategori, memberikan SAM sumber data pelatihan yang beragam dan berskala besar.

Model SAM dilatih untuk memahami objek dan dapat menghasilkan masker segmentasi untuk objek apa pun dalam gambar atau bingkai video. Model ini memungkinkan rekayasa cepat visual, memungkinkan Anda memberikan masukan seperti teks, titik, kotak pembatas, atau masker untuk menghasilkan label tanpa mengubah gambar asli. SAM tersedia dalam tiga ukuran: dasar (ViT-B, 91 juta parameter), besar (ViT-L, 308 juta parameter), dan besar (ViT-H, 636 juta parameter), yang memenuhi kebutuhan komputasi dan kasus penggunaan yang berbeda.

Motivasi utama di balik SAM adalah untuk meningkatkan segmentasi tingkat objek dengan sampel pelatihan dan periode waktu yang minimal untuk objek apa pun yang diminati. Kekuatan SAM terletak pada kemampuannya untuk beradaptasi dengan distribusi gambar dan tugas baru tanpa sepengetahuan sebelumnya, sebuah fitur yang dikenal sebagai transfer tanpa tembakan. Kemampuan beradaptasi ini dicapai melalui pelatihan pada kumpulan data SA-1B yang luas, yang telah menunjukkan kinerja zero-shot yang mengesankan, melampaui banyak hasil yang diawasi sepenuhnya sebelumnya.

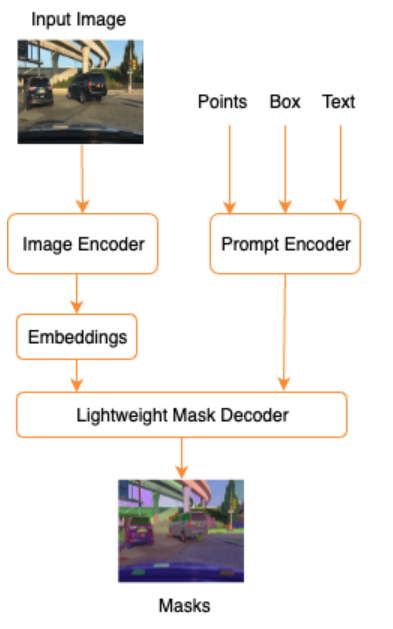

Seperti yang ditunjukkan dalam arsitektur SAM berikut, proses pembuatan masker segmentasi melibatkan tiga langkah:

- Encoder gambar menghasilkan penyematan satu kali untuk gambar.

- Encoder prompt mengubah prompt apa pun menjadi vektor penyematan untuk prompt tersebut.

- Decoder ringan menggabungkan informasi dari encoder gambar dan encoder cepat untuk memprediksi masker segmentasi.

Sebagai contoh, kita dapat memberikan masukan berupa gambar dan kotak pembatas di sekitar objek yang diinginkan dalam gambar tersebut (misalnya mobil Silver atau jalur mengemudi) dan model SAM akan menghasilkan masker segmentasi untuk objek tersebut.

Rekayasa cepat visual

Rekayasa cepat mengacu pada penataan masukan ke model yang membuat model memahami maksud dan menghasilkan hasil yang diinginkan. Dengan rekayasa cepat tekstual, Anda dapat menyusun teks masukan melalui modifikasi seperti pilihan kata, pemformatan, pengurutan, dan lainnya untuk mendapatkan keluaran yang diinginkan. Rekayasa cepat visual mengasumsikan bahwa pengguna bekerja dalam modalitas visual (gambar atau video), dan memberikan masukan. Berikut ini adalah daftar lengkap cara-cara potensial untuk memberikan masukan pada model AI generatif dalam domain visual:

- Titik – Titik koordinat tunggal (x, y) pada bidang gambar

- Titik – Beberapa titik koordinat (x, y), belum tentu berhubungan satu sama lain

- Kotak pembatas – Satu set empat nilai (x, y, w, h) yang menentukan wilayah persegi panjang pada bidang gambar

- Kontur – Sekumpulan titik koordinat (x, y) pada bidang gambar yang membentuk bangun tertutup

- Mask – Array berukuran sama dengan gambar dengan sebagian mask dari objek yang diinginkan

Dengan mempertimbangkan teknik visual prompt engineering, mari kita jelajahi bagaimana hal ini dapat diterapkan pada model terlatih SAM. Kami telah menggunakan versi dasar dari model terlatih.

Perintah zero-shot dengan model SAM terlatih

Untuk memulainya, mari kita jelajahi pendekatan zero-shot. Berikut ini contoh gambar dataset pelatihan yang diambil dari kamera depan kendaraan.

Kita bisa mendapatkan masker segmentasi untuk semua objek dari gambar tanpa dorongan visual apa pun secara eksplisit secara otomatis menghasilkan masker hanya dengan gambar masukan. Pada gambar berikut, kita melihat bagian-bagian mobil, jalan, rambu lalu lintas, pelat nomor, jalan layang, pilar, rambu, dan lainnya tersegmentasi.

Namun, keluaran ini tidak langsung berguna karena alasan berikut:

- Mobil-mobil tersebut tidak disegmentasi secara keseluruhan, melainkan sebagian. Untuk sebagian besar model persepsi, misalnya, kami tidak terlalu peduli jika setiap ban memiliki masker keluaran terpisah. Hal ini juga berlaku ketika mencari objek menarik lainnya, seperti jalan, tumbuh-tumbuhan, rambu, dan sebagainya.

- Bagian gambar yang berguna untuk tugas hilir seperti area yang dapat dilalui kendaraan dipisahkan, tanpa penjelasan. Di sisi lain, instance serupa diidentifikasi secara terpisah, dan kami mungkin tertarik untuk mengelompokkan objek serupa (segmentasi panoptik vs. instance).

Rekayasa visual cepat dengan model SAM terlatih

Untungnya, SAM mendukung penyediaan perintah masukan, dan kita dapat menggunakan titik, larik titik, dan kotak pembatas sebagai masukan. Dengan instruksi khusus ini, kami berharap SAM dapat bekerja lebih baik dalam segmentasi yang berfokus pada titik atau area tertentu. Ini dapat dibandingkan dengan template prompt bahasa"What is a good name for a company that makes {product}?"

dimana masukan beserta template prompt ini dari pengguna adalah {product}. {product} adalah slot masukan. Dalam bisikan visual, kotak pembatas, titik, atau masker adalah slot masukan.

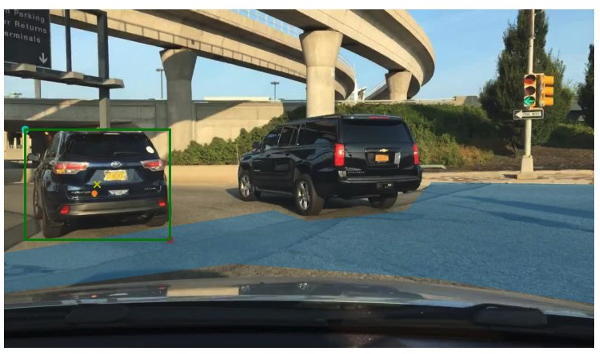

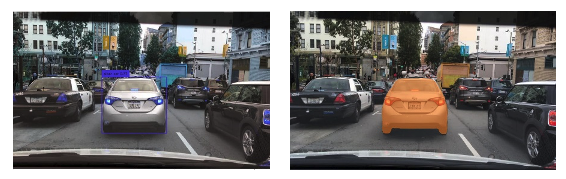

Gambar berikut menunjukkan kotak pembatas kebenaran dasar asli di sekitar kendaraan, dan patch area yang dapat dilalui dari data kebenaran dasar BDD100K. Gambar juga menunjukkan titik masukan (tanda X kuning) di tengah kotak pembatas hijau yang akan kita rujuk di beberapa bagian berikutnya.

Mari kita coba membuat mask untuk mobil di sebelah kiri dengan kotak pembatas berwarna hijau sebagai masukan ke SAM. Seperti yang ditunjukkan pada contoh berikut, model dasar SAM tidak menemukan apa pun. Hal ini juga terlihat pada rendahnya skor segmentasi. Ketika kita melihat masker segmentasi lebih dekat, kita melihat bahwa ada wilayah kecil yang dikembalikan sebagai masker (ditunjukkan menggunakan panah merah) yang tidak benar-benar dapat digunakan untuk aplikasi hilir apa pun.

Mari kita coba kombinasi kotak pembatas dan titik sebagai input visual prompt. Tanda silang kuning pada gambar sebelumnya adalah bagian tengah kotak pembatas. Memberikan koordinat titik ini (x,y) sebagai prompt bersama dengan batasan kotak pembatas akan memberi kita mask berikut dan skor yang sedikit lebih tinggi. Ini masih belum dapat digunakan dengan cara apa pun.

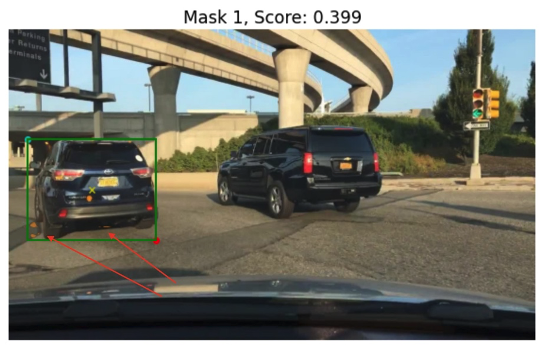

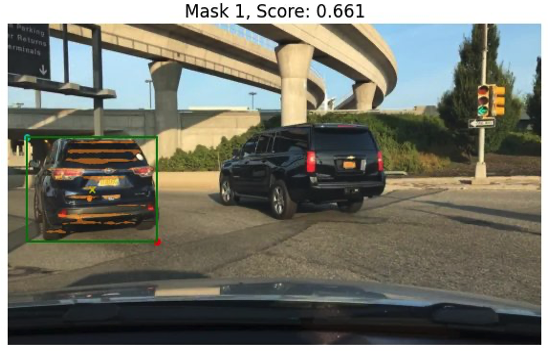

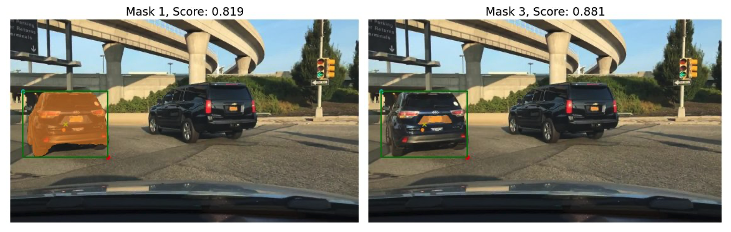

Terakhir, dengan model dasar yang telah dilatih sebelumnya, kita hanya dapat memberikan titik masukan sebagai prompt (tanpa kotak pembatas). Gambar berikut menunjukkan dua dari tiga topeng teratas yang menurut kami menarik.

Mask 1 membagi seluruh mobil, sedangkan Mask 3 membagi area yang memegang plat nomor mobil di dekat tanda silang kuning (input prompt). Masker 1 masih belum merupakan masker yang rapat dan bersih di sekitar mobil; Hal ini menunjukkan kualitas model, yang dapat kita asumsikan meningkat seiring dengan ukuran model.

Kita dapat mencoba model terlatih yang lebih besar dengan perintah masukan yang sama. Gambar berikut menunjukkan hasil kami. Saat menggunakan model terlatih SAM yang besar, Topeng 3 adalah keseluruhan mobil, sedangkan Topeng 1 dan 2 dapat digunakan untuk mengekstrak pelat nomor.

Model SAM versi besar juga memberikan keluaran serupa.

Proses yang kami lalui di sini mirip dengan rekayasa prompt manual untuk prompt teks yang mungkin sudah Anda kenal. Perhatikan bahwa perbaikan terbaru dalam model SAM untuk mensegmentasi apa pun dengan kualitas tinggi memberikan keluaran spesifik objek dan konteks yang jauh lebih baik. Dalam kasus kami, kami menemukan bahwa perintah zero-shot dengan perintah teks dan visual (input titik, kotak, dan titik dan kotak) tidak meningkatkan hasil secara drastis seperti yang kita lihat di atas.

Templat cepat dan rantai visual

Seperti yang bisa kita lihat dari contoh zero-shot sebelumnya, SAM kesulitan mengidentifikasi semua objek dalam pemandangan. Ini adalah contoh bagus di mana kita dapat memanfaatkan template cepat dan rantai visual. Rantai visual terinspirasi oleh konsep rantai dalam kerangka LangChain yang populer untuk aplikasi bahasa. Ini membantu menghubungkan sumber data dan LLM untuk menghasilkan keluaran. Misalnya, kita dapat menggunakan rantai API untuk memanggil API dan memanggil LLM untuk menjawab pertanyaan berdasarkan respons API.

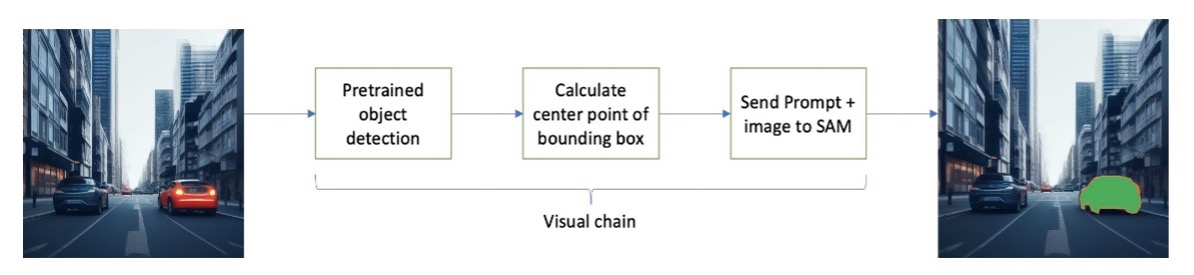

Terinspirasi oleh LangChain, kami mengusulkan rantai visual berurutan yang terlihat seperti gambar berikut. Kami menggunakan alat (seperti model deteksi objek terlatih) untuk mendapatkan kotak pembatas awal, menghitung titik di tengah kotak pembatas, dan menggunakannya untuk meminta model SAM dengan gambar masukan.

Misalnya, gambar berikut menunjukkan masker segmentasi sebagai hasil dari menjalankan rantai ini.

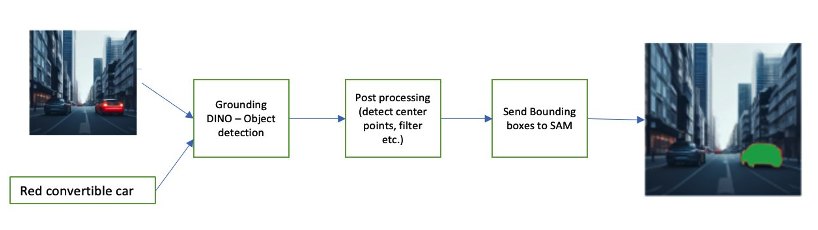

Contoh rantai lainnya dapat melibatkan input teks dari objek yang ingin diidentifikasi oleh pengguna. Untuk mengimplementasikan ini, kami membangun saluran pipa menggunakan Membumikan DINO, model deteksi objek untuk meminta SAM melakukan segmentasi.

Grounding DINO adalah model deteksi objek zero-shot yang dapat melakukan deteksi objek dengan teks yang memberikan nama kategori (seperti “lampu lalu lintas” atau “truk”) dan ekspresi (seperti “truk kuning”). Ia menerima pasangan teks dan gambar untuk melakukan deteksi objek. Ini didasarkan pada arsitektur transformator dan memungkinkan lintas modalitas dengan data teks dan gambar. Untuk mempelajari lebih lanjut tentang Grounding DINO, lihat Grounding DINO: Menggabungkan DINO dengan Pra-Pelatihan Grounded untuk Deteksi Objek Open-Set. Ini menghasilkan kotak pembatas dan label dan dapat diproses lebih lanjut untuk menghasilkan titik pusat, memfilter berdasarkan label, ambang batas, dan banyak lagi. Ini digunakan (kotak atau titik) sebagai perintah ke SAM untuk segmentasi, yang menghasilkan masker.

Berikut adalah beberapa contoh yang memperlihatkan teks masukan, keluaran DINO (kotak pembatas), dan keluaran akhir SAM (masker segmentasi).

Gambar berikut menunjukkan keluaran untuk “truk kuning”.

Gambar berikut menunjukkan keluaran untuk “mobil perak”.

Gambar berikut menunjukkan keluaran untuk “jalur mengemudi”.

Kita dapat menggunakan saluran ini untuk membangun rantai visual. Cuplikan kode berikut menjelaskan konsep ini:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Meskipun ini adalah contoh sederhana, konsep ini dapat diperluas untuk memproses umpan dari kamera pada kendaraan untuk melakukan pelacakan objek, redaksi data informasi identitas pribadi (PII), dan banyak lagi. Kita juga bisa mendapatkan kotak pembatas dari model yang lebih kecil, atau dalam beberapa kasus, menggunakan alat visi komputer standar. Cukup mudah untuk menggunakan model terlatih atau layanan seperti Amazon Rekognition untuk mendapatkan label awal (visual) untuk permintaan Anda. Pada saat penulisan ini, ada lebih dari 70 model yang tersedia di Amazon SageMaker Jumpstart untuk deteksi objek, dan Rekognisi Amazon sudah mengidentifikasi beberapa kategori objek yang berguna dalam gambar, termasuk mobil, pejalan kaki, dan kendaraan lainnya.

Selanjutnya, kita melihat beberapa hasil kuantitatif terkait performa model SAM dengan subset data BDD100K.

Hasil kuantitatif

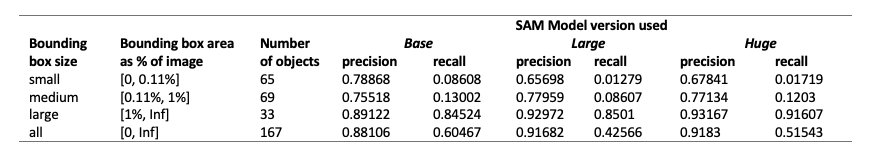

Tujuan kami adalah membandingkan performa tiga model terlatih saat diberikan perintah visual yang sama. Dalam hal ini, kita menggunakan titik pusat lokasi objek sebagai masukan visual. Kami membandingkan performa berdasarkan ukuran objek (sebanding dengan ukuran gambar)— kecil (luas <0.11%), sedang (0.11% < luas < 1%), dan besar (luas > 1%). Ambang batas area kotak pembatas ditentukan oleh Common Objects in Context (COCO) metrik evaluasi [Lin dkk., 2014].

Evaluasinya berada pada tingkat piksel dan kami menggunakan metrik evaluasi berikut:

- Presisi = (jumlah instance yang relevan dan diambil) / (jumlah total instance yang diambil)

- Recall = (jumlah instance yang relevan dan pengambilan) / (jumlah total instance yang relevan)

- Contoh di sini adalah setiap piksel dalam kotak pembatas objek yang diinginkan

Tabel berikut melaporkan performa tiga versi model SAM yang berbeda (dasar, besar, dan besar). Versi ini memiliki tiga encoder berbeda: ViT-B (basis), ViT-L (besar), ViT-H (besar). Pembuat enkode memiliki jumlah parameter yang berbeda, dengan model dasar memiliki parameter yang lebih sedikit dibandingkan model besar, dan model dasar memiliki parameter yang lebih kecil dari model besar. Meskipun peningkatan jumlah parameter menunjukkan peningkatan kinerja dengan objek yang lebih besar, hal ini tidak berlaku untuk objek yang lebih kecil.

Menyempurnakan SAM untuk kasus penggunaan Anda

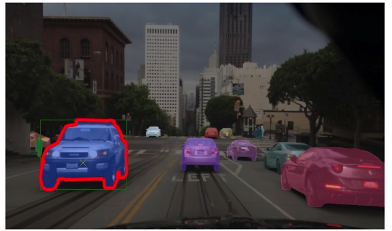

Dalam banyak kasus, penggunaan model SAM terlatih secara langsung mungkin tidak terlalu berguna. Misalnya, mari kita lihat pemandangan umum di lalu lintas—gambar berikut adalah keluaran dari model SAM dengan titik perintah yang diambil sampelnya secara acak sebagai masukan di sebelah kiri, dan label sebenarnya dari tugas segmentasi semantik dari BDD100K di sebelah kanan. Ini jelas sangat berbeda.

Tumpukan persepsi di AV dapat dengan mudah menggunakan gambar kedua, tetapi bukan gambar pertama. Di sisi lain, ada beberapa keluaran berguna dari gambar pertama yang dapat digunakan, dan model tersebut tidak dilatih secara eksplisit, misalnya marka jalan, segmentasi trotoar, masker pelat nomor, dan sebagainya. Kami dapat menyempurnakan model SAM untuk meningkatkan hasil segmentasi. Untuk melakukan penyesuaian ini, kami membuat kumpulan data pelatihan menggunakan subset segmentasi instans (500 gambar) dari kumpulan data BDD10K. Ini adalah bagian gambar yang sangat kecil, namun tujuan kami adalah membuktikan bahwa model visi dasar (seperti LLM) dapat bekerja dengan baik untuk kasus penggunaan Anda dengan jumlah gambar yang sangat sedikit. Gambar berikut menunjukkan gambar masukan, topeng keluaran (berwarna biru, dengan batas merah untuk mobil di sebelah kiri), dan kemungkinan petunjuknya (kotak pembatas berwarna hijau dan titik tengah X berwarna kuning).

Kami melakukan penyesuaian menggunakan perpustakaan Hugging Face Studio Amazon SageMaker. Kami menggunakan instance ml.g4dn.xlarge untuk pengujian model dasar SAM, dan ml.g4dn.2xlarge untuk pengujian model besar SAM. Dalam percobaan awal kami, kami mengamati bahwa menyempurnakan model dasar hanya dengan kotak pembatas tidak berhasil. Model yang telah disempurnakan dan dilatih sebelumnya tidak dapat mempelajari topeng kebenaran spesifik mobil dari kumpulan data asli. Menambahkan poin kueri ke penyesuaian juga tidak meningkatkan pelatihan.

Selanjutnya, kita dapat mencoba menyempurnakan model besar SAM selama 30 epoch, dengan kumpulan data yang sangat kecil (500 gambar). Masker kebenaran dasar yang asli terlihat seperti gambar berikut untuk jenis label mobil.

Seperti yang ditunjukkan dalam gambar berikut, versi asli model besar yang telah dilatih sebelumnya dengan prompt kotak pembatas tertentu (berwarna hijau) tidak memberikan keluaran, sedangkan versi yang disempurnakan memberikan keluaran (masih tidak akurat tetapi penyesuaian telah dipotong mati setelah 40 zaman, dan dengan kumpulan data pelatihan yang sangat kecil yaitu 500 gambar). Model besar asli yang telah dilatih sebelumnya tidak dapat memprediksi masker untuk gambar mana pun yang kami uji. Sebagai contoh aplikasi hilir, model yang disempurnakan dapat digunakan dalam alur kerja pra-pelabelan seperti yang dijelaskan dalam Modul pelabelan otomatis untuk Sistem Bantuan Pengemudi Tingkat Lanjut berbasis pembelajaran mendalam di AWS.

Kesimpulan

Dalam postingan kali ini, kita membahas model visi dasar yang dikenal sebagai Segment Anything Model (SAM) dan arsitekturnya. Kami menggunakan model SAM untuk mendiskusikan dorongan visual dan berbagai masukan untuk rekayasa dorongan visual. Kami menjelajahi bagaimana kinerja perintah visual yang berbeda dan keterbatasannya. Kami juga menjelaskan bagaimana rantai visual meningkatkan kinerja dibandingkan hanya menggunakan satu perintah, mirip dengan API LangChain. Selanjutnya, kami memberikan evaluasi kuantitatif terhadap tiga model terlatih. Terakhir, kita membahas model SAM yang telah disempurnakan dan hasilnya dibandingkan dengan model dasar aslinya. Penyempurnaan model dasar membantu meningkatkan performa model untuk tugas tertentu seperti segmentasi. Perlu dicatat bahwa model SAM karena kebutuhan sumber dayanya, membatasi penggunaan untuk kasus penggunaan real-time dan melakukan inferensi pada edge dalam kondisi saat ini. Kami berharap dengan iterasi di masa depan dan peningkatan teknik, akan mengurangi kebutuhan komputasi dan meningkatkan latensi.

Kami berharap postingan ini mendorong Anda untuk mengeksplorasi dorongan visual untuk kasus penggunaan Anda. Karena ini masih merupakan bentuk rekayasa cepat yang masih baru, ada banyak hal yang dapat ditemukan dalam hal perintah visual, rantai visual, dan kinerja alat-alat ini. Amazon SageMaker adalah platform ML yang dikelola sepenuhnya yang memungkinkan pembangun menjelajahi model bahasa dan visual yang besar serta membangun aplikasi AI generatif. Mulailah membangun masa depan dengan AWS sekarang.

Tentang penulis

Gopi Krishnamurti adalah Arsitek Solusi AI/ML Senior di Amazon Web Services yang berbasis di New York City. Dia bekerja dengan pelanggan Otomotif besar sebagai penasihat tepercaya mereka untuk mengubah beban kerja Machine Learning mereka dan bermigrasi ke cloud. Minat utamanya meliputi pembelajaran mendalam dan teknologi tanpa server. Di luar pekerjaan, ia suka menghabiskan waktu bersama keluarganya dan menjelajahi berbagai macam musik.

Gopi Krishnamurti adalah Arsitek Solusi AI/ML Senior di Amazon Web Services yang berbasis di New York City. Dia bekerja dengan pelanggan Otomotif besar sebagai penasihat tepercaya mereka untuk mengubah beban kerja Machine Learning mereka dan bermigrasi ke cloud. Minat utamanya meliputi pembelajaran mendalam dan teknologi tanpa server. Di luar pekerjaan, ia suka menghabiskan waktu bersama keluarganya dan menjelajahi berbagai macam musik.

Shreyas Subramanian adalah Arsitek Solusi spesialis AI/ML Utama, dan membantu pelanggan dengan menggunakan Machine Learning untuk memecahkan tantangan bisnis mereka menggunakan platform AWS. Shreyas memiliki latar belakang dalam pengoptimalan skala besar dan Pembelajaran Mesin, dan dalam penggunaan Pembelajaran Mesin dan Pembelajaran Penguatan untuk mempercepat tugas pengoptimalan.

Shreyas Subramanian adalah Arsitek Solusi spesialis AI/ML Utama, dan membantu pelanggan dengan menggunakan Machine Learning untuk memecahkan tantangan bisnis mereka menggunakan platform AWS. Shreyas memiliki latar belakang dalam pengoptimalan skala besar dan Pembelajaran Mesin, dan dalam penggunaan Pembelajaran Mesin dan Pembelajaran Penguatan untuk mempercepat tugas pengoptimalan.

Sujitha Martin adalah Ilmuwan Terapan di Generative AI Innovation Center (GAIIC). Keahliannya adalah dalam membangun solusi pembelajaran mesin yang melibatkan visi komputer dan pemrosesan bahasa alami untuk berbagai vertikal industri. Secara khusus, ia memiliki pengalaman luas bekerja pada kesadaran situasional yang berpusat pada manusia dan pembelajaran yang ditanamkan pengetahuan untuk sistem yang sangat otonom.

Sujitha Martin adalah Ilmuwan Terapan di Generative AI Innovation Center (GAIIC). Keahliannya adalah dalam membangun solusi pembelajaran mesin yang melibatkan visi komputer dan pemrosesan bahasa alami untuk berbagai vertikal industri. Secara khusus, ia memiliki pengalaman luas bekerja pada kesadaran situasional yang berpusat pada manusia dan pembelajaran yang ditanamkan pengetahuan untuk sistem yang sangat otonom.

Francisco Calderon adalah Ilmuwan Data di Generative AI Innovation Center (GAIIC). Sebagai anggota GAIIC, dia membantu menemukan seni dari berbagai kemungkinan bersama pelanggan AWS menggunakan teknologi AI Generatif. Di waktu luangnya, Francisco suka bermain musik dan gitar, bermain sepak bola bersama putri-putrinya, dan menikmati waktu bersama keluarga.

Francisco Calderon adalah Ilmuwan Data di Generative AI Innovation Center (GAIIC). Sebagai anggota GAIIC, dia membantu menemukan seni dari berbagai kemungkinan bersama pelanggan AWS menggunakan teknologi AI Generatif. Di waktu luangnya, Francisco suka bermain musik dan gitar, bermain sepak bola bersama putri-putrinya, dan menikmati waktu bersama keluarga.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- PlatoData.Jaringan Vertikal Generatif Ai. Berdayakan Diri Anda. Akses Di Sini.

- PlatoAiStream. Intelijen Web3. Pengetahuan Diperkuat. Akses Di Sini.

- PlatoESG. Karbon, teknologi bersih, energi, Lingkungan Hidup, Tenaga surya, Penanganan limbah. Akses Di Sini.

- PlatoHealth. Kecerdasan Uji Coba Biotek dan Klinis. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :memiliki

- :adalah

- :bukan

- :Di mana

- $NAIK

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- kemampuan

- Sanggup

- Tentang Kami

- atas

- mempercepat

- Menerima

- tepat

- dicapai

- sebenarnya

- menyesuaikan

- menambahkan

- maju

- kemajuan

- Keuntungan

- penasihat

- Setelah

- AI

- AI / ML

- AL

- Semua

- memungkinkan

- sepanjang

- sudah

- juga

- Meskipun

- Amazon

- Rekognisi Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- Amazon Web Services

- an

- dan

- menjawab

- Apa pun

- siapapun

- apa saja

- api

- berlaku

- Aplikasi

- aplikasi

- terapan

- pendekatan

- arsitektur

- ADALAH

- DAERAH

- daerah

- sekitar

- susunan

- Seni

- AS

- Bantuan

- menganggap

- mengasumsikan

- At

- perhatian

- otomotif

- otonom

- tersedia

- kesadaran

- AWS

- latar belakang

- mendasarkan

- berdasarkan

- Dasar-dasar

- BE

- karena

- menjadi

- menjadi

- mulai

- di belakang

- Manfaat

- Lebih baik

- Milyar

- Biru

- batas

- Kotak

- kotak

- terobosan

- secara luas

- membangun

- pembangun

- Bangunan

- dibangun di

- bisnis

- tapi

- by

- menghitung

- panggilan

- kamar

- kamera

- CAN

- Bisa Dapatkan

- mobil

- yang

- mobil

- kasus

- kasus

- kategori

- Kategori

- katering

- pusat

- rantai

- rantai

- tantangan

- pilihan

- Kota

- membersihkan

- Penyelesaian

- tertutup

- rapat

- awan

- kelapa

- kode

- kombinasi

- menggabungkan

- menggabungkan

- Umum

- perusahaan

- membandingkan

- dibandingkan

- komputasi

- menghitung

- komputer

- Visi Komputer

- konsep

- konsep

- konteks

- mengkoordinasikan

- Core

- Meliputi

- dibuat

- Cross

- terbaru

- Kondisi saat ini

- pelanggan

- Memotong

- data

- ilmuwan data

- kumpulan data

- mendalam

- belajar mendalam

- menetapkan

- didefinisikan

- menunjukkan

- dijelaskan

- diinginkan

- Deteksi

- berbeda

- dino

- langsung

- menemukan

- membahas

- dibahas

- distribusi

- beberapa

- do

- Tidak

- domain

- domain

- Dont

- secara drastis

- pengemudi

- penggerak

- dua

- e

- E&T

- setiap

- mudah

- Tepi

- embedding

- muncul

- memungkinkan

- memungkinkan

- mendorong

- Teknik

- Menghibur

- Seluruh

- zaman

- penting

- evaluasi

- contoh

- contoh

- ekspansif

- mengharapkan

- pengalaman

- eksperimen

- keahlian

- Menjelaskan

- penjelasan

- secara eksplisit

- menyelidiki

- Dieksplorasi

- ekspresi

- luas

- Pengalaman yang luas

- ekstrak

- Menghadapi

- hampir

- akrab

- keluarga

- Fitur

- beberapa

- bidang

- Angka

- menyaring

- terakhir

- Menemukan

- Pertama

- berfokus

- berfokus

- berikut

- Untuk

- bentuk

- Prinsip Dasar

- dasar

- empat

- Kerangka

- Francisco

- dari

- depan

- penuh

- sepenuhnya

- lebih lanjut

- masa depan

- menghasilkan

- menghasilkan

- menghasilkan

- generatif

- AI generatif

- mendapatkan

- diberikan

- memberikan

- baik

- Hijau

- Tanah

- membimbing

- tangan

- Memiliki

- memiliki

- he

- kesehatan

- membantu

- dia

- di sini

- High

- berkualitas tinggi

- lebih tinggi

- sangat

- -nya

- memegang

- kap

- berharap

- Seterpercayaapakah Olymp Trade? Kesimpulan

- HTML

- HTTPS

- besar

- diidentifikasi

- mengidentifikasi

- mengenali

- mengidentifikasi

- gambar

- gambar

- segera

- melaksanakan

- impresif

- memperbaiki

- ditingkatkan

- perbaikan

- in

- memasukkan

- Termasuk

- Meningkatkan

- Meningkatkan

- meningkatkan

- industri

- informasi

- diresapi

- mulanya

- Innovation

- memasukkan

- input

- terinspirasi

- contoh

- Segmentasi Instance

- instruksi

- maksud

- bunga

- tertarik

- menarik

- kepentingan

- ke

- melibatkan

- melibatkan

- IT

- iterasi

- NYA

- jpg

- hanya

- hanya satu

- pengetahuan

- dikenal

- label

- Label

- Jalur

- bahasa

- besar

- besar-besaran

- lebih besar

- terbesar

- akhirnya

- Latensi

- BELAJAR

- pengetahuan

- meninggalkan

- kurang

- Tingkat

- Perpustakaan

- Lisensi

- terletak

- Hidup

- Biologi

- ringan

- 'like'

- 'like

- keterbatasan

- batas

- lin

- Daftar

- sedikit

- LLM

- tempat

- melihat

- mencari

- TERLIHAT

- Rendah

- mesin

- Mesin belajar

- MEMBUAT

- Membuat

- berhasil

- panduan

- banyak

- menikah

- masker

- masker

- besar-besaran

- Mungkin..

- cara

- Media

- medium

- anggota

- meta

- Metrik

- bermigrasi

- juta

- keberatan

- minimal

- ML

- model

- model

- Modifikasi

- Modul

- lebih

- paling

- Motivasi

- banyak

- beberapa

- musik

- nama

- nama

- Alam

- Pengolahan Bahasa alami

- perlu

- New

- NY

- new york city

- berikutnya

- tidak

- terkenal

- jumlah

- obyek

- Deteksi Objek

- tujuan

- objek

- of

- lepas

- on

- ONE

- optimasi

- or

- asli

- Lainnya

- kami

- di luar

- Hasil

- keluaran

- output

- di luar

- lebih

- pasang

- parameter

- parameter

- tertentu

- bagian

- tambalan

- persepsi

- Melakukan

- prestasi

- dilakukan

- Sendiri

- gambar

- pilar

- pipa saluran

- pixel

- pesawat

- Platform

- plato

- Kecerdasan Data Plato

- Data Plato

- Bermain

- bermain

- Titik

- poin

- Populer

- mungkin

- Pos

- potensi

- kekuasaan

- meramalkan

- primer

- Utama

- Sebelumnya

- proses

- Diproses

- pengolahan

- menghasilkan

- menghasilkan

- proporsi

- mengusulkan

- Rasakan itu

- memberikan

- disediakan

- menyediakan

- menyediakan

- tujuan

- kualitas

- kuantitatif

- kuantitas

- pertanyaan

- jarak

- real-time

- benar-benar

- alasan

- baru

- Merah

- menurunkan

- lihat

- mengacu

- wilayah

- daerah

- terkait

- relevan

- laporan

- Persyaratan

- membutuhkan

- sumber

- menghormati

- tanggapan

- mengakibatkan

- Hasil

- merevolusionerkan

- Kaya

- benar

- jalan

- berjalan

- pembuat bijak

- Universitas

- sama

- melihat

- Skala

- adegan

- ILMU PENGETAHUAN

- ilmuwan

- skor

- Kedua

- bagian

- melihat

- terlihat

- ruas

- segmentasi

- segmen

- senior

- terpisah

- Tanpa Server

- layanan

- Layanan

- set

- beberapa

- dia

- harus

- Menunjukkan

- menampilkan

- ditunjukkan

- Pertunjukkan

- menandatangani

- penting

- Tanda

- Silver

- mirip

- Sederhana

- tunggal

- Ukuran

- ukuran

- ketrampilan

- celah

- slot

- kecil

- lebih kecil

- potongan

- So

- Sepak bola

- Solusi

- MEMECAHKAN

- beberapa

- sumber

- sumber

- spesialis

- tertentu

- Secara khusus

- menghabiskan

- membagi

- Tumpukan

- standar

- awal

- Negara

- Tangga

- Masih

- mudah

- kekuatan

- struktur

- penataan

- Perjuangan

- sukses

- seperti itu

- Mendukung

- melebihi

- sistem

- tabel

- Mengambil

- diambil

- tugas

- tugas

- teknik

- Teknologi

- Template

- template

- istilah

- diuji

- tes

- teks

- tekstual

- dari

- bahwa

- Grafik

- Daerah

- Dasar-dasar

- Masa depan

- informasi

- mereka

- Sana.

- Ini

- ini

- pikir

- tiga

- Melalui

- waktu

- ban

- untuk

- hari ini

- alat

- alat

- puncak

- Total

- Pelacakan

- lalu lintas

- terlatih

- Pelatihan

- Mengubah

- transformator

- truk

- benar

- Terpercaya

- kebenaran

- mencoba

- dua

- mengetik

- khas

- bawah

- memahami

- us

- dapat digunakan

- penggunaan

- menggunakan

- gunakan case

- kasus penggunaan

- bekas

- Pengguna

- menggunakan

- Nilai - Nilai

- berbagai

- Luas

- tumbuh-tumbuhan

- Kendaraan

- versi

- Versi

- vertikal

- sangat

- Video

- penglihatan

- visual

- vs

- W

- adalah

- cara

- we

- jaringan

- layanan web

- BAIK

- pergi

- adalah

- Apa

- Apa itu

- ketika

- sedangkan

- yang

- seluruh

- lebar

- Rentang luas

- sangat

- akan

- dengan

- dalam

- tanpa

- disaksikan

- kata

- Kerja

- Alur kerja

- kerja

- bekerja

- akan

- penulisan

- X

- tahun

- York

- Kamu

- Anda

- zephyrnet.dll